基于隐式对称生成对抗网络的图像隐写与提取方案

屈梦楠 靳宇浩 邬 江

(中电长城网际安全技术研究院(北京)有限公司 北京 100097)

随着科学技术的发展,深度学习技术在越来越多领域取得了显著的成果,基于深度学习的图像隐写技术逐渐成为研究热点,其中基于生成对抗网络(generative adversarial network, GAN)[1]的图像隐写技术已经得到广泛关注.

GAN是一种深度学习模型,在图像生成、图像修复、图像超分辨率等领域取得令人惊叹的成果[2-3].在GAN应用领域的研究中有诸多优秀的模型研究,如DCGAN[4],WGAN[5],PGGAN[7]等,这些模型都具有强大的生成能力和学习能力,能够生成高质量的图像[2],这些模型通过改写还能够实现对秘密信息的有效嵌入和提取.

相较于传统的图像隐写技术[7],基于GAN的图像隐写技术具有更强的鲁棒性和安全性,因为其嵌入的方式更加复杂、隐蔽,很难被攻击者发现并破解[8].此外,基于GAN的图像隐写技术还具有较好的可扩展性,可以适用于不同领域的图像隐写问题[9].

虽然基于GAN的图像隐写技术能够得到很好的结果,但是在实际应用中仍然存在一些明显的问题[8],例如,如何保证嵌入的秘密信息不会影响载体图像的质量,如何防止攻击者通过某些方法识别出秘密信息,如何降低训练成本还能够保证拥有相同的图像质量等,因此,现有基于GAN的图像隐写技术仍需要在图像质量与安全性方面进行探索与优化.

同时,基于深度学习如何将一张图像隐写到另一张图像中的研究还很欠缺.该领域的研究有着更大的研究价值,仍然需要更多的研究与探索.

本文所提出的方案是使用一种隐式对称生成对抗网络,旨在提高图像质量和隐蔽性,同时保证嵌入率和鲁棒性.本文的主要贡献包括:

1) 通过将图像隐写与提取任务抽象为一个数学优化问题,简化了任务难度,为建立隐式对称生成对抗模型奠定了理论基础.

2) 根据优化问题提出一个隐式对称生成对抗网络模型,该模型通过2个生成对抗子网络相互博弈、互相优化的方式进行学习,提高生成图像的隐秘性与鲁棒性.

3) 设计适用于该模型的损失函数,损失函数引入了内容损失和对抗损失,使模型学习速度提升,使生成图像的质量得到提高.

1 相关研究

1.1 传统图像隐写技术

图像隐写作为一种重要的信息隐藏技术,在过去几十年中得到广泛的研究和应用.传统的图像隐写方法主要包括空域方法和变换域方法[10].其中,空域方法将秘密信息直接嵌入到原始图像像素中,而变换域方法则通过对图像进行变换来实现秘密信息的嵌入[11].然而,这些传统方法存在一些局限性,如嵌入率低、易受攻击等[12].

1.2 基于深度学习的图像隐写技术

近年来,基于深度学习的图像隐写方法逐渐成为研究热点[13].其中,生成对抗网络已经被广泛应用于图像隐写领域[14-15].GAN中的生成器将随机向量转换为逼真的图像,而鉴别器负责区分生成图像和真实图像的差异,从而不断优化生成器[1].

2017年 Volkhonskiy等人[10]提出了一种称为隐写生成对抗网络(steganographic generative adversarial network, SGAN)的模型,可以生成高质量的隐写图像,并且可以在保持图像质量的同时隐藏更多的信息.2018年SSGAN[16],将载体图像的生成网络替换成 Wasserstein GAN[5]生成更加符合真实分布的载体图像.StegNet将深度卷积神经网络方法与图像隐写术相结合,成功地隐藏了相同大小的图像[17].Yang等人[18]提出了一种使用对抗训练的安全隐写算法,使用了一种基于 U-NET[19]的生成器.

然而,现有的基于GAN图像隐写方法仍然存在一些局限性[8],如图像质量下降、颜色失真等,而目前生成对抗网络研究的趋势不断向大型网络偏移,造成算法对机器性能的依赖性增强[4].

1.3 基于深度学习的“以图藏图”

“以图藏图”意指将一张图片隐藏在另一张图片中,其方式包括图像融合、图像隐写等多种方式,目前图像隐写方面的研究仍然较少,Baluja[20]与Zhang等人[21-22]首先将基于深度学习的图像隐写算法应用于“以图藏图”领域,成功将一幅全彩色图像放置在另一幅相同尺寸的图像中.这些方法虽然很好地将隐秘图像隐写入载体图像,但是仍然具有图像质量下降、颜色失真的问题.

综合上述问题,本文提出的基于隐式对称生成对抗网络的图像隐写与提取方案通过引入隐式对称特征提取、2个生成对抗子网络相互博弈机制来提高图像质量和隐蔽性,并通过优化特定的损失函数提高嵌入率和安全性.与当前的其他方法相比,本文方法具有更好的鲁棒性和可靠性,能够在不影响图像质量的情况下有效地隐藏秘密信息.

2 图像隐写与提取方案设计

2.1 图像隐写任务的描述

2.2 隐式对称生成对抗网络

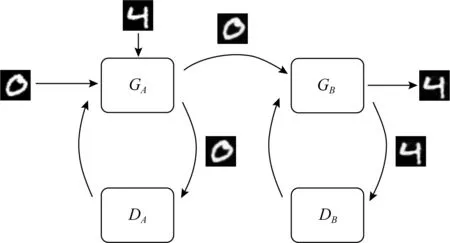

总体网络结构框架设计如图1所示,生成器GA用于接收载体图像与隐秘图像,生成1张包含隐写信息的新图像,判别器DA用于判断生成器GA生成的包含隐写信息的新图像是否与载体图像相同;生成器GB用于从生成器GA生成的包含隐写信息的新图像中提取出隐秘图像,判别器DB用于判断生成器GB提取出的隐秘图像与原始隐秘图像是否相同.

图1 双重交互生成对抗网络结构

判别器DA和判别器DB的结构相同,用来提取图像的特征,因为生成的图像中包含隐写信息,所以从像素层面比较2张图像是否相等是不正确的,在这里认为当2张图像通过判别器提取出的特征相同,则认为这2张图像相同.

该判别器网络结构为全卷积网络,由4层带有LeakyReLU激活函数的卷积层和1层Sigmod激活函数的卷积层.

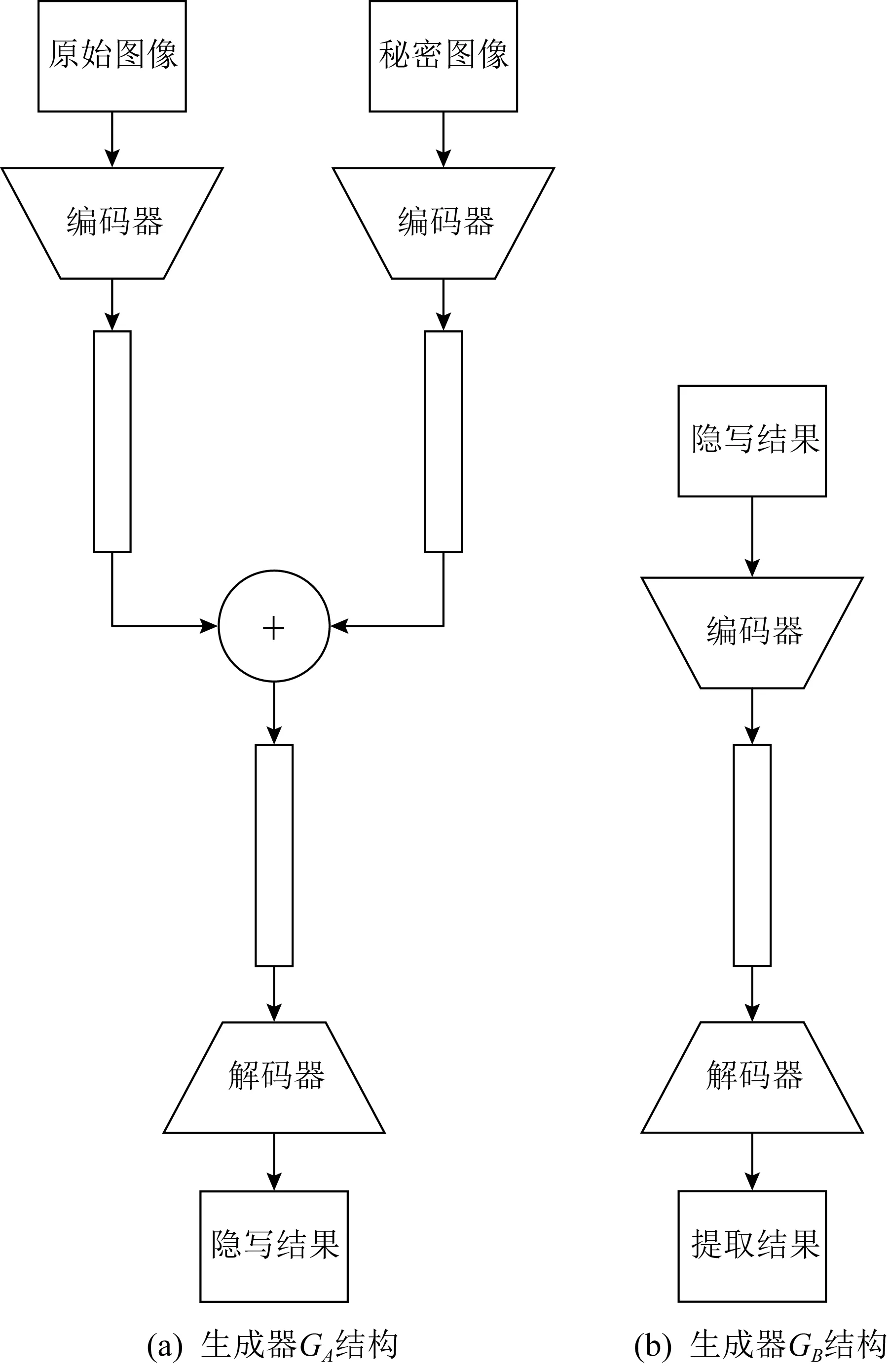

图2 隐式对称生成对抗网络生成器GA与GB结构

2.3 损失函数

生成器GA损失函数由2部分组成:内容损失和对抗损失,其中,内容损失用于衡量生成的图像与原始输入图像之间的距离,对抗损失用于评估生成图像的真实性,并鼓励生成器生成更加真实的图像.内容损失的计算如式(1)所示,对抗损失的计算如式(2)所示.

(1)

(2)

其中,x表示输入图像,D(G(x))表示判别器对生成器生成的隐写图像与原始图像相似的概率值.

生成器GB损失函数也由内容损失和对抗损失2部分组成,内容损失的计算如式(3)所示,对抗损失的计算如式(4)所示.

(3)

(4)

设LGA为对生成器GA定义的损失函数,如式(5)所示LGB为对生成器GB定义的损失函数,如式(6)所示.

LGA=LAcontent+LAadversarial,

(5)

LGB=LBcontent+LBadversarial.

(6)

判别器的损失函数只包括对抗损失,用于评估输入图像的真实性和质量,并指导优化过程,LDA为对判别器DA定义的损失函数,如式(7)所示:

(7)

LDB为对判别器DB定义的损失函数,如式(8)所示:

(8)

3 实验及结果分析

3.1 数据集准备

本文实验过程评估了隐式对称生成对抗网络的性能,并选择了适合该模型的数据集进行训练和测试.由于隐式对称生成对抗网络的特殊网络结构,其具有不需要标注数据、可使用任意图像数据组成成对数据等特点,因此本文实验采用了常用的图像数据集Celeb-A[23]和MNIST[24]作为实验数据集.

Celeb-A数据集包含超过20万张名人面部图像,并涵盖了多种年龄、种族和性别.该数据集广泛应用于人脸识别、人脸检测和人脸属性分析等领域.MNIST数据集是一个手写数字图像数据集,包含6万张训练图像和1万张测试图像.该数据集广泛应用于数字识别和基于图像的机器学习任务.

实验中,将Celeb-A和MNIST数据集随机划分成训练集和测试集,并使用训练集训练隐式对称生成对抗网络模型,用测试集验证模型训练结果.采用常见的数据增强技术,如随机旋转、翻转和缩放等,以扩充数据集并提高模型的鲁棒性.

3.2 训练模型

本文使用Python和PyTorch框架进行实验,并在GeForce RTX 1050Ti GPU上运行.将数据集分为训练集、验证集和测试集,其中训练集用于模型的训练,验证集用于调整模型参数和提前终止策略,测试集用于评估模型性能.

采用Adam优化器对判别器的损失函数LDA和LDB分别进行优化,对生成器的损失函数LGA和LGB分别进行优化,并使用学习率衰减技术逐步降低学习率以避免过拟合.

3.3 评估实验结果

实验评估的关键指标包括图像质量和安全性,实验结果与文献[19]方法和文献[20]方法2种方法进行了比较.

1) 图像质量评估.

在图像质量方面,采用峰值信噪比PSNR(peak signal-to-noise ratio)和结构相似性指数SSIM(structural similarity index)[25]等常用指标来评估生成图像与原始图像之间的相似度.

PSNR用于衡量原始图像和隐写图像之间的相似度,计算公式为式(9):

(9)

其中,MSE(mean squared error)表示均方误差,计算公式为式(10):

(10)

其中,IA和IB分别表示原始图像和隐写图像,m和n分别表示图像的宽度和高度.

SSIM用于比较2个图像的结构相似性,计算公式为式(11):

SSIM(x,y)=

[I(x,y)]α[c(x,y)]β[s(x,y)]γ,

(11)

其中,I(x,y),c(x,y)和s(x,y)分别表示亮度、对比度和结构相似度,α,β和γ是权重系数.

实验结果表明,本文方法在图像质量方面表现出色,PSNR值平均为32.67dB,SSIM值平均为0.99,与其他先进方法相比具有显著优势,对比结果如表1所示:

表1 图像质量评估表

2) 隐写鲁棒性与安全性评估.

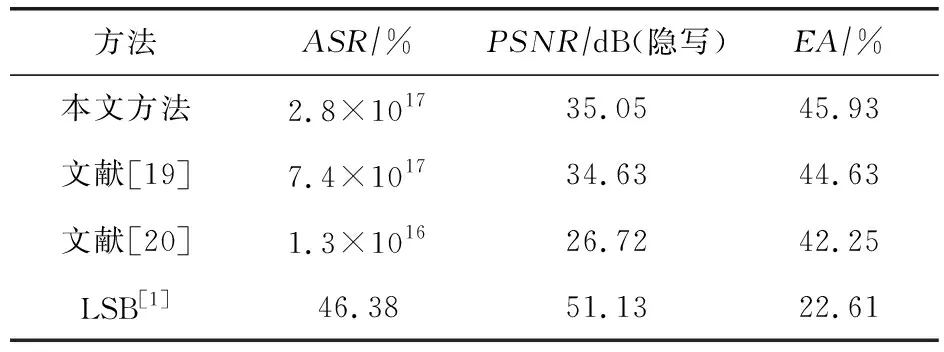

在鲁棒性与安全性方面,采用攻击成功率ASR(attack success rate)、隐写后图像质量和提取准确度EA(extraction accuracy)等多个指标来评估模型的安全性.

实验以最常见的攻击方法之一直方图攻击进行仿真攻击实验,通过计算攻击成功次数与攻击总次数的比值,计算攻击成功率,以研究模型的抵抗攻击能力.

EA是衡量隐写算法从隐写图像中提取信息的精度指标,假设隐写算法从隐写图像中提取的信息为S′,而原始信息为S,则图像提取准确度可以表示为式(12):

(12)

其中,∩表示2个集合的交集,|S′|和|S|分别表示提取的信息和原始信息的大小.

实验结果表明,本文方法在直方图攻击下保持较高的安全性,攻击成功率只有2.8×1017%,与对比模型相比攻击成功率较低;提取准确度达到45.93%,相比现有模型高出1.3%.对比结果如表2所示:

表2 图像安全性评估表

3) 视觉效果评估.

隐写后的图像与提取的隐秘图像视觉感知效果良好,与原始载体图像和原始隐秘图像相比不易分辨,对比结果如图3所示:

图3 DI-GAN模型在MNIST数据集上实现的效果

4 结 论

基于隐式对称生成对抗网络的图像隐写技术是一种非常有效的信息隐藏手段.该技术利用生成对抗网络将秘密图像嵌入到载体图像中,并能够在不影响图像质量和隐蔽性的情况下实现信息隐藏和提取.与先前的基于深度学习的图像隐写技术相比,在基于隐式对称生成对抗网络的图像隐写方案中,训练方式更加科学,数据隐藏更加隐秘,很难被攻击者发现并破解,具有更好的鲁棒性和安全性.下一步将继续完善和优化基于隐式对称生成对抗网络的图像隐写方案,同时,对基于神经网络的隐写技术隐写与提取过程中如何减少信息损失进行深入探究.

致谢本文的实验环境由中电长城网际安全技术研究院(北京)有限公司提供,并提供技术支持.