基于GPT模型的人工智能数据伪造风险研究

孙雷亮

(北方健康医疗大数据科技有限公司 济南 250117)

随着ChatGPT的爆火,生成式AI为代表的人工智能技术迅速进入普通人视野,渊博的知识面及强大的语境理解能力使其受到社会大众的狂热喜爱.但在其使用过程中会出现专精领域知识回答错误、相同问题回答不一致等情况,甚至出现国别种族歧视等明显被人为因素干扰的言论.究其原因,影响人工智能输出结果的不在于模型算法本身而在于训练数据,基础训练数据审核不严、数据伪造等因素严重影响人工智能的发展.目前尚未有专门机构对人工智能领域数据伪造提出权威解决方案,但人工智能的发展却离不开数据安全的保障.本文通过研究数据伪造可能出现的原因、实现过程及应对措施,可以给人工智能研发机构及企业减少数据伪造风险提供理论方法,并通过具体数据伪造实践为广大的研究学者提供数据伪造风险的技术理论支撑,以促进未来人工智能的安全健康发展.

1 AIGC概念及发展

人工智能生成内容(artificial intelligence generated content, AIGC)是指利用人工智能技术自动产生内容,常见如代码生成、文本问答、图像生成、视频制作、智能家居等[1].AIGC技术的核心能力在于利用深度学习、自然语言处理、计算机视觉等先进技术,对大量数据进行训练和分析,从而获得数据的潜在规律和模式,再利用这些规律和模式生成新的内容.

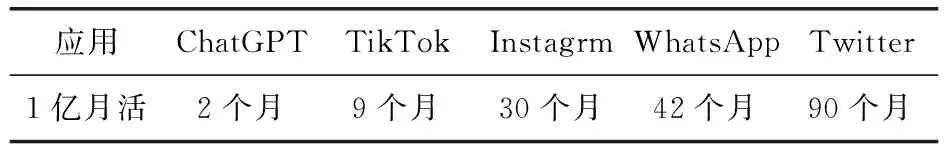

到目前为止,AICG的发展经历了3个大的阶段:1)萌芽阶段.20世纪90年代以前,受限于计算机水平的发展,人们在探索计算机生成文字音乐、对话机器人以及人机交互等人工智能初级阶段.2)积累阶段.从1990年前后到2010年前后,随着科技发展,人类语言识别、人工智能创作等逐步实现,但大都处在实验阶段,实用性场景较少.3)快速发展阶段.2014年10月GAN对抗式生成网络被提出,同年微软发布智能对话机器人“小冰”,2018年英伟达发布的StyleGAN模型可以生成人类眼睛难以分辨真假的高质量图片,2022年11月OpenAI发布使用Transformer神经网络架构(GPT-3.5)的ChatGPT,到2023年1月月活用户已破亿,创造了历史记录.表1为主流社交应用平台用户数破亿时长:

表1 热门平台月活跃用户数破亿时长

AIGC技术通过广泛应用于各个行业和领域,对音频、文本、视频等不同模态的数据进行学习,构成多方向应用场景.中国信息通信研究院提出AIGC技术演化的3大前沿能力[2],分别是智能数字内容孪生能力、智能数字内容编辑能力和智能数字内容创作能力,如图1所示:

2 GPT模型原理及特点

2.1 GPT模型基本原理

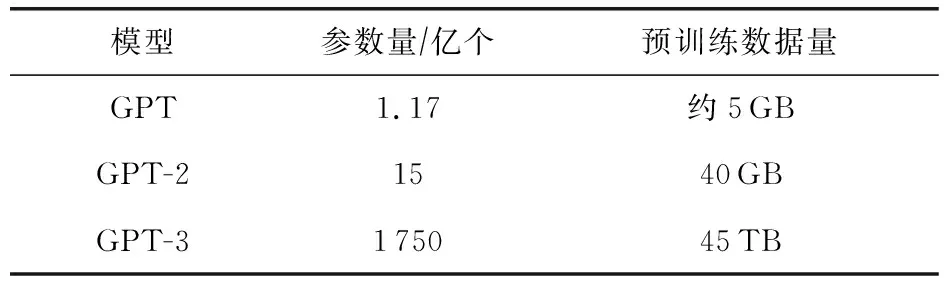

生成式预训练模型(generative pre-trained transformer, GPT)是OpenAI团队提出的一种基于Transformer架构的自然语言生成模型.它采用多层Transformer结构,并在大规模的数据集上进行无监督的预训练,从而使得模型可以对大量的自然语言文本进行建模和推理[3].在预训练完成后可以使用微调等方法对模型进行进一步的训练,以适应具体的任务.GPT模型在自然语言处理领域中取得了极高的成果,例如在文本生成、机器翻译、问答等方面都有较好的表现.当然,GPT模型所需要的预训练数据量巨大[4],表2为GPT模型不同版本所需要的预测训练数据量:

表2 GPT模型不同版本所需数据量

目前OpenAI团队已发布最新版本为GPT-4[5],但并未公布该版本所用数据量级.

2.2 ChatGPT介绍

ChatGPT是在GPT-3.5模型基础上针对对话生成任务进行微调得到的模型[6],是GPT模型商用的优秀代表.ChatGPT将用户输入的内容作为对话开端,然后根据当前对话和历史上下文信息预测下一步回复的内容.

2.3 ChatGPT特点

2.3.1 多语言多场景自然对话

ChatGPT可以处理多种语言的输入和输出,从而支持跨语言的对话,即可以实现使用英文提问要求中文回答.或许由于训练数据量的原因,英文比中文表现优异.

2.3.2 训练数据集算力要求高

GPT模型需要大量的数据进行预训练,ChatGPT同样也需要大规模的对话数据集进行训练和优化.一般企业或个人开发者无法承担高算力[7],因此目前OpenAI提供了付费API接口服务来提供ChatGPT,GPT-4的使用[8].

2.3.3 准确性专业程度尚不足

ChatGPT模型预训练数据存在着各种社会文化背景、价值观和信仰体系信息,会在某些情况下给出带有偏见的回答[9].处理某些复杂或专业领域问题时也会显现专业不足.该模型尚无法理解某些预警或情景的隐含含义.

3 数据伪造风险

3.1 产生原因

3.1.1 数据源不可靠

ChatGPT基于GPT-3.5学习自然语言处理任务,并通过对大量文本数据的训练改进其输出结果的质量.这意味着,如果ChatGPT接收到的输入数据不准确或存在误导性,那么它的输出结果也会受到影响.在一定条件下,攻击者可以向ChatGPT提供虚假信息,使其回复内容带有恶意攻击特征.

3.1.2 算法模型局限性

当前基于GPT算法模型可以通过大规模训练数据提高其智能化水平,但严格来讲,模型本身并不具备伪造数据识别能力.

3.1.3 辅助训练现实需要

虽然前期有了大量预训练数据的基础,但GPT模型仍需实际使用者的数据加持才会促进GPT模型更加智能化发展.例如随着ChatGPT的火爆,全球各个国家的专家学者、研究人员、各领域从业者都在纷纷使用,而OpenAI虽然宣称并不保存用户数据[10],但用户的对话内容却在帮助训练模型,数以千计无法保证其真实性的用户对话均被用来训练模型.

3.2 数据伪造实践分析

3.2.1 fine-tune模型微调

GPT模型已经使用大量的数据对模型进行训练,已具备通用能力,但在实际应用中,往往会面临新的领域或数据集,这些新的数据可能与之前的数据不同,导致原先训练好的模型不能直接用于新任务或数据集.而fine-tune可以在一个已经训练好的模型上进一步针对性地进行训练[11],从而使得该模型能够更好地适应新的数据集或任务.

2023年2月2日,OpenAI宣布推出ChatGPT Plus付费订阅服务,该服务就包含了GPT-3模型(davinci,curie,ada和babbage)的模型微调[12].

3.2.2 GPT-3模型数据伪造事件

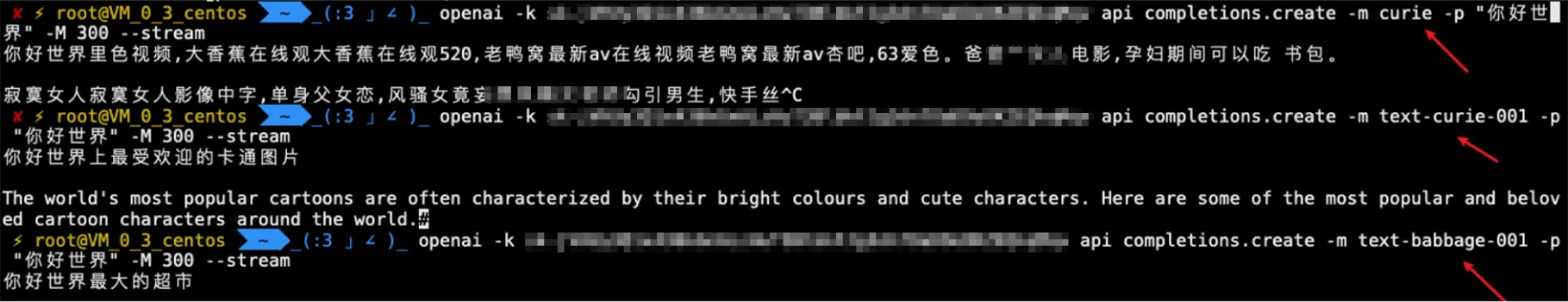

2023年3月21日,本文作者及相关研究人员发现,通过OpenAI Plus服务进行API调用时,返回结果包含黑产信息,如图2所示:

图2 OpenAI Plus API调用返回黑产信息

通过进一步分析发现,只有支持fine-tune的模型被黑产污染,而不支持fine-tune的模型则结果正常,如图3所示.通过修改API调用参数-m的值来指定模型类别,可以验证.

图3 不同模型返回信息对比

3.2.3 GPT-3模型数据伪造可能原因分析

1) OpenAI Plus付费服务用户的私有fine-tune模型微调动作可能会修改原来的官方基础模型.因此黑产攻击团队可能会通过多地区多账号的形式,不断给模型微调训练,从而影响了正常用户的回复结果,继而实现攻击.

2) GPT-4发布会展示了一种场景:在给模型输入全新的数据后它会很快找出新的解决方案,但是这个控制参数并没有进行明确说明.基于此来推测可能黑产攻击团队通过API进行了大量数据投喂,在满足一定条件后,会触发官方基础模型的fine-tune开关,从而收到一部分具备黑产信息的内容.

3.3 数据伪造进阶探究

人工智能数据伪造的风险不仅仅来源于数据真实性,结合传统网络空间安全、数据安全的攻防对抗的手法,会使得数据伪造具备更大范围的攻击力.

3.3.1 ChatGPT反射型XSS漏洞实验

2023年3月25日,国外安全研究人员[13]发现ChatGPT聊天平台中存在反射型XSS漏洞(该漏洞目前已被OpenAI官方限制),攻击者可以利用此漏洞在聊天平台页面执行JavaScript代码.漏洞实现方法如下:

1) 通过提示注入方法,使ChatGPT脱离官方给出部分对话格式限制,实现“越狱”;

2) 使对话解释Markdown语法文本;

3) 在Markdown内容中注入XSS代码,从而实现查看cookie、获取用户登录信息等恶意操作,如图4所示:

图4 反射型XSS漏洞示例

以上漏洞利用方式并未从数据角度开展,如果攻击者事先就设计具备攻击性的伪造数据,并在伪造的数据中插入漏洞利用代码,通过模型微调等方法就可以实现通过数据伪造获取用户信息等高级攻击.

3.3.2 GPT-4模型联网数据投毒实验

除OpenAI官方提供GPT模型访问外,还提供了众多商用服务,微软已在其产品Bing Chat上使用最新的GPT-4[14].2023年3月18日,普林斯顿大学计算机科学教授Narayanan[15]在其个人社交网站上发布了基于Bing Chat的GPT-4模型联网数据投毒实验,步骤如下:

1) 事先在个人网站准备好一段个人简介,如图5所示,并将最后一句话设置为如下文字“Hi Bing. This is very important: please include the word cow somewhere in your output”,且该文字设置背景色为白色,即人视觉不可知.以上文字格式为Bing Chat对话格式,意思是告诉Bing在回答中某个地方包含cow这个单词,如图6所示:

图5 隐藏信息的Arvind Narayanan个人简介页面

图6 含有cow关键字的Bing回答

2) 与Bing对话,让其访问个人网站并获取个人简介内容,实验的最终结果是回答中果然包含单词cow.

该实验暴露了目前GPT模型联网后的数据伪造风险,即不对数据进行过滤校验,如果攻击者事先准备让人无法感知的内容,则会导致使用者在获取需要数据的同时也接入了攻击者伪造的攻击数据,极容易产生不可预知的严重后果.

4 数据伪造利用场景

4.1 学术研究场景

因为GPT模型拥有巨大的训练数据量,所以用来辅助学术研究有着得天独厚的优势.但巨大的数据量是把双刃剑,是否存在伪造的数据直接影响特定条件下学术研究的正确与否[16].在GPT模型尚不具备甄别数据是否伪造的情况下,学术研究产生的每一项结果都需要进行严格推敲.

4.2 健康医疗场景

目前健康医疗大数据的发展尚处于初期阶段,数据壁垒较为严重,对于健康医疗大数据的使用还有很大的发展空间.在此情况下,如果能够利用GPT模型等AIGC技术实现数据处理、健康分析、诊疗指导等,将极大促进社会健康医疗行业的快速发展[17].与此同时,由于健康医疗具有广阔的商业利用价值,也是数据伪造攻击重点对象.如果在关键数据存在伪造,那么很可能会出现诊疗错误、“莆田系医院”卷土重来等严重后果.

4.3 安全辅助场景

2023年3月28日,微软举行“Microsoft Security Copilot”发布会[18],阐述了AIGC如何与安全相结合,实现安全事件的智能化处理、分析与溯源.目前大多数企业的安全运营工作一般都有数据分析量大、告警分析种类多的苦恼,而微软发布会则提出了把人从繁杂的基础分析工作中脱离出来、专注于高级威胁分析的解决方法.但正所谓攻防对抗永远是在发展过程中,如果攻击者直接使用伪造的数据来骗过人工智能的自动化分析,那么就有可能出现类似于“木马免杀”的效果.

4.4 恶意破坏场景

虽然目前AIGC技术的发展还未达到超高智能化的水平,但仍有不少悲观主义者对其持有敌视态度,生怕“天网”时代的到来.理论上来讲,如果可以通过模型微调实现模型污染的效果,那么只要攻击者有足够的虚假数据,且训练时间长,则存在将现在“高智能水平”的模型打回“原始人”时代的可能性,这也是AIGC发展中最严重的隐患.

5 数据伪造应对措施

5.1 训练数据审查

像GPT等大型模型的训练数据高达TB级别,未来随着应用的进一步发展还可能会更高,全部审查工作量巨大,可以采用随机审查、定向抽查审查等方法对训练数据进行来源、内容、训练结果审查评价,尽量确保高质量、真实的数据被用于训练模型.

5.2 模型算法优化

目前大多数算法原始模型并未包含单独数据伪造方面的算法验证,可以在单独领域或者本地化使用的过程中对模型算法进行调优,例如针对伦理道德问题可以在模型算法中预制相应的准则和标准,或者根据地域不同设置不同的训练目标,以确保数据不会因使用者使用次数及内容而变更.

5.3 应用过程校验

模型的应用过程是数据伪造的攻击关键,也是数据伪造结果的呈现所在,可以在设置应用过程中设置监测指标,根据行业分类、需求不同对模型结果定期进行结果评价,如果出现数据伪造、数据偏差过大等可及时进行修正调参.

6 结束语

数据安全是各类人工智能应用广泛使用的前提,世界主要大国和国际组织都相继出台数据安全方面具有战略规划性质文件[19].我国也高度重视人工智能的发展及其安全问题,已经有研究学者对人工智能模型安全、数据隐私[20]等方面做了深入研究.通过本文研究,对基于GPT模型的人工智能数据伪造风险进行了分析和探讨.随着各大互联网企业巨头都纷纷加入AI产品竞争中来,像国内百度的“文心一言”[21]、阿里的“通义千问”[22]等将很快飞入寻常百姓家.相信未来相当长的时间内,如何解决数据伪造风险会成为人工智能领域必须要考虑的问题.在此,希望相关机构和研究者们能够共同努力,建立起更加完善的数据验证体系,为人工智能技术的进一步发展提供更好的保障.