结合GAN和风格迁移的太阳斑点图重建方法

黄亚群,罗 俊*,蒋慕蓉,杨 磊,郑培煜

(1.云南大学 信息学院,云南 昆明 650500;2.中国科学院云南天文台,云南 昆明 650011)

0 引 言

太阳活动会影响无线电短波通讯,太阳喷射出的高能电磁辐射会对无电磁保护的电力设备造成巨大影响。使用地基望远镜对太阳表面进行实时观测和分析,从而提前预警、降低损失。由于大气湍流扰动的影响,地基望远镜得到的太阳图片是模糊的,这些低分辨率图片难以直接分析,因此需要进行图像超分辨率重建处理。传统的太阳斑点图重建方法主要有斑点成像术、斑点掩模法[1]、多帧盲反卷积法和选帧位移叠加法(Level1+)[2],这些方法需要大气统计特性、大气视宁度等较多的先验知识,以及较多的图像帧数,以致重建过程计算量大、耗时长,不能满足太阳观测的实时需求。

现有深度学习超分辨率重建方法对细节模糊、特征单一的低分辨率太阳斑点图的重建效果较差,重建结果会出现伪影、部分高频信息丢失等问题。为解决这些问题,崔雯昊等[3]在Cycle-GAN的基础上加入VGG对图像进行深度特征提取,然后使用改进的Cycle-GAN对低分辨率太阳斑点图进行重建,并对重建结果进行图像融合;李福海等[4]同样使用GAN并结合梯度引导对太阳斑点图进行重建,使用梯度引导有效地还原了图像细节,防止重建图像发生几何变形。二者都有较好的重建效果,由于他们采用的都是有监督深度学习方法,所以数据集中高分辨率图像的质量决定了重建图像的质量,重建结果的上限被数据集所限制。然而现有Level1+数据集中的高分辨率太阳斑点图的分辨率并不高,同时理想的高分辨率太阳斑点图原图数量极少,无法作为有效的数据集,不能用于网络训练。因此,要使重建结果达到理想效果,就应该合理使用分辨率不是最高但可以直接用于网络训练的Level1+数据集,以及因数量极少且没有与之对应的低分辨率图而不能用于网络训练的太阳斑点图原图。

基于对上述问题的分析,该文在NICE-GAN[5](没有独立编码器的生成对抗网络)的基础上结合风格迁移网络[6],提出一种太阳斑点图超分辨率重建网络STYLE-NICE-GAN,恢复全局轮廓与高频信息,提高图片分辨率。首先,将低分辨率太阳斑点图和Level1+高分辨率太阳斑点图作为数据集,用于训练NICE-GAN,使NICE-GAN的重建结果达到数据集Level1+的效果,恢复全局轮廓与部分细节;其次,考虑到太阳斑点图特征单一、图片间相似度极高的特点,利用图片质量比Level1+数据集更好的太阳斑点图原图[2],对NICE-GAN的重建结果进行风格迁移,提高局部细节的清晰度及整体的对比度。实验结果表明:相较Level1+法和现有深度学习超分辨率重建方法,该方法重建得到的高分辨率太阳斑点图,具有细节清晰、伪影较少、高频信息明显等优点。

1 网络模型

STYLE-NICE-GAN网络由两部分组成,一部分是NICE-GAN网络,另一部分是风格迁移网络,为更好地描述STYLE-NICE-GAN网络结构,先分别介绍两个子网络,然后给出整体网络结构。

1.1 对NICE-GAN的改进

NICE-GAN[5]是一种实现图像转换的生成对抗网络,可以实现猫狗和斑马与马等的转换,在有成对的Level1+数据集的情况下,使用NICE-GAN捕捉低分辨率太阳斑点图到高分辨率太阳斑点图的映射关系,恢复出太阳斑点图全局轮廓和部分细节。NICE-GAN网络结构如图1所示,包括G、F两个生成器以及DX、DY两个鉴别器,其中生成器G生成Y领域的高分辨率图,生成器F生成X领域的低分辨率图,鉴别器DX鉴别图像是X领域的图像,鉴别器DY鉴别图像是Y领域的图像,G(x)、F(y)是生成的重建图像,x、y是参考图像。

图1 NICE-GAN网络结构

由于NICE-GAN网络最初是为现实生活中的图像转换而设计的,这些图与太阳斑点图存在区别,因此,该文改进了NICE-GAN的损失函数,使它有利于太阳斑点图的重建。

(1)重建损失。

基于深度学习的超分辨率重建方法为了矫正重建图像的颜色和纹理特征,一般使用均方差损失函数,但这样会使重建图像的局部细节过于平滑,违背该文的重建目标。因此,该文使用绝对值损失作为重建损失函数,在保证重建图像与目标图像具有相似轮廓的同时,使重建图像的局部细节不会过于平滑。

X领域图像生成Y领域图像的重建损失公式如式(1)所示:

(1)

Y领域图像生成X领域图像的重建损失公式如式(2)所示:

(2)

其中,Ey~Y代表目标(高分辨率)分布,Ex~X代表重建(低分辨率)分布,下同。

重建损失公式如式(3)所示:

(3)

(2)对抗损失。

为了使训练更加稳定以及得到高质量的重建结果,该文使用相对性最小二乘对抗损失[7],它能够获取质量更高的感知效果与更加逼真的高频信息。

X领域图像生成Y领域图像的对抗损失公式如式(4)所示:

Ex~X[(1-Dy(Gx→y(x)))2]

(4)

Y领域图像生成X领域图像的对抗损失公式如式(5)所示:

Ey~Y[(1-Dx(Fy→x(y)))2]

(5)

对抗损失公式如式(6)所示:

(6)

由于使用相对性对抗损失,此处鉴别器的目标为鉴别一张图片比另一张图片更加真实的概率,随着训练迭代次数的增加,Dy(Gx→y(x))和Dx(Fy→x(y))将会提高,而D(x)和D(y)则会下降,最终两者达到平衡。

(3)循环一致性损失。

仅仅是重建损失和对抗损失并不能保证所学习的映射函数将单个输入的X领域图像映射到所需的Y领域输出图像。为了避免网络把部分X(或Y)领域图像转换为Y(或X)领域图像中的同一张图像,并进一步减少可能存在的映射函数空间,所学习的映射函数应该是循环一致的,如图1所示。

对X领域的每张图像x,图像生成周期应该能够将x带回到原始图像,x≈Fy→x(Gx→y(x));类似地,对Y领域的每张图像y,应满足y≈Gx→y(Fy→x(y))。为了达到以上目的,该文使用循环一致性损失[8],为避免重建结果过于平滑,循环一致性损失使用绝对值损失函数。

X领域图像生成Y领域图像的循环一致性损失公式如式(7)所示:

(7)

Y领域图像生成X领域图像的循环一致性损失公式如式(8)所示:

(8)

循环一致性损失公式如式(9)所示:

(9)

(4)总损失函数。

训练过程总损失由式(3)、式(6)、式(9)所述的三类损失加权构成,其中重建损失和循环一致性损失解决了不可识别性问题,NICE-GAN网络的总损失函数如式(10)所示:

Lall=λ1Lrec+λ2Lgan+λ3Lcyc

(10)

其中,λ1、λ2、λ3是三类损失函数的权重值。

1.2 风格迁移

虽然低分辨率太阳斑点图经过NICE-GAN的重建后,重建结果已经恢复了全局轮廓和部分细节,但重建结果的分辨率依然不高,还有模糊的部分,与理想的太阳斑点图原图还存在一定距离,重建结果还有上升空间,然而现有Level1+数据集已经是分辨率最高的数据集,同时太阳斑点图原图数量极少且没有与之对应的低分辨率图,所以无法作为数据集参与网络训练。

Gatys L A等[6]在2015年首次提出使用卷积神经网络对图片进行风格迁移,文中提出卷积神经网络的低层特征一般是输入图像的位置信息,高层特征一般是输入图像的像素信息,对不同图像进行位置信息与像素信息的融合,即可实现图像的风格迁移。用于训练风格迁移网络的数据集是不成对的,而且风格图和内容图的风格特征和内容特征都差异明显,同时迁移后的结果图很好地保留了风格图的风格特征和内容图的内容特征。

因此,可以使用公开数据集去训练风格迁移网络,使之可以保证内容特征不丢失和风格特征完整体现,然后使用风格迁移网络结合少量的太阳斑点图原图对NICE-GAN的重建结果进行无监督二次重建,这样可以规避因太阳斑点图原图数量极少且没有与之对应的低分辨率图而无法作为数据集参与网络训练但在实际重建过程中又要参考它们的难点。

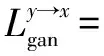

文中风格迁移网络采用基于特征计算的思想,与AdaIN[9]/WCT[10]类似,使用自动编码器和解码器的结构,如图2所示。风格图和内容图二者的风格特征及内容特征一般是完全不同的,如果二者的风格特征和内容特征高度相似,只是分辨率有差异,此时对二者进行风格迁移,可以作为图像重建的一种方法。文中方法基于此想法并借鉴Level1+多帧重和图像融合[3]而提出。

图2 风格迁移网络结构

1.2.1 编码器和解码器

文中风格迁移网络使用编码器提取内容图和风格图各自的特征矩阵Fc(内容特征矩阵)和Fs(风格特征矩阵),将内容图的特征矩阵Fc进行压缩后,与风格迁移矩阵T进行矩阵相乘,再进行解压,得到迁移后的特征矩阵Fd,对Fd进行解码,得到风格迁移后的图像。

编码器和解码器都是预训练好的,编码器的结构和VGG19网络的前几层一样,解码器的结构与编码器的结构是对称的,编码和解码的部分过程如图3所示。图2中风格迁移网络部分的压缩步骤C和解压步骤U是需要学习的,压缩和解压保证使用编码器的不同层的特征时,解码器能接收到维度相同的特征,这两个步骤均采用普通的卷积实现。

图3 风格迁移网络的编码、解码过程

在编码过程中,通过卷积层提取内容图和风格图的特征,再利用池化层进行下采样,降低图像的尺寸,使得后续卷积层提取维度更小的内容图和风格图的特征。解码过程中,通过卷积层不断融合及还原内容图和风格图的特征,再利用池化层进行上采样,提高图像的尺寸,确保生成图与内容图的尺寸一致。

1.2.2 风格迁移矩阵

为实现任意图像的风格迁移,使在公共数据集上能较好融合内容特征和风格特征的风格迁移网络,在太阳斑点图上也有好的迁移效果,该文使用风格迁移矩阵T[11]融合内容图和风格图的特征。由于该文重点关注内容特征的不丢失,所以使用风格迁移矩阵T和内容特征矩阵Fc的乘积作为最终的融合结果Fd。Fd是风格迁移后的特征矩阵,如式(11)所示:

Fd=TFc

(11)

其中,风格迁移矩阵T是Li X等[11]在19年提出的快速风格迁移模块,只使用内容特征Fc和风格特征Fs即可计算出,使网络可以对任意的图像和风格进行迁移。

1.2.3 风格迁移网络的损失函数

风格迁移网络的损失函数由内容损失和风格损失加权求和得到,为矫正生成图的颜色和纹理特征,二者都以均方差损失作为损失函数,内容损失是生成图与内容图的内容特征Fd和Fc做均方差,风格损失由风格图和生成图的不同层Gram矩阵的均方差损失加权求和得到,内容损失Lc和风格损失Ls分别如式(12)、式(13)所示:

Lc=(Fd-Fc)2

(12)

(13)

其中,wl为第l层网络的权重,El为第l层的风格损失,El如式(14)所示:

(14)

风格迁移网络的总损失如式(15)所示:

Lall=αLc+βLs

(15)

其中,α、β是分别调节内容特征和风格特征的损失函数的权重。

1.3 STYLE-NICE-GAN

由于该文的研究目的是太阳斑点图高分辨率重建,所以在实际应用中只用到了NICE-GAN的生成器G模块,该模块捕捉了低分辨率太阳斑点图到高分辨率太阳斑点图的映射关系并生成高分辨率图片,所以将NICE-GAN的生成器G与风格迁移网络结合成STYLE-NICE-GAN网络,结构如图4所示。

图4 STYLE-NICE-GAN网络结构

2 实验分析

由于NICE-GAN网络和风格迁移网络的训练目标有所不同,所以二者的训练数据集是不同的,因此二者需要分开训练,在训练完成后,再组成STYLE-NICE-GAN网络,对太阳斑点图进行重建。

2.1 数据集

NICE-GAN网络是有监督学习,风格迁移网络是无监督学习,二者的训练目标有所不同,NICE-GAN网络使重建结果尽可能与Level1+一致,风格迁移网络使重建结果内容不丢失和风格完整表现,所以分别构造两个网络所需要的数据集。

该文使用云南天文台提供的数据作为训练NICE-GAN网络的数据集,使用MS-COCO[12]数据集和WikiArt[13]数据集作为训练风格迁移网络的数据集。NICE-GAN网络的数据集包括重建选帧算法得到的22 000张模糊图blur和使用Level1+算法得到对应的22 000张清晰图Level1+。在训练风格迁移网络的数据集中,MS-COCO数据集作为内容图,该文使用约4万张图;WikiArt数据集作为风格图,该文使用约4万张图。

考虑到以下因素,风格迁移网络使用公共数据集:已有的Level1+数据集不够清晰,训练效果不好,同时又没有足以形成数据集的高清太阳斑点图原图;公共数据集中图像的纹理复杂、类别众多,如果在公共数据集上,内容和风格能取得很好的平衡,那么在纹理和种类都比较单一的太阳斑点图也能取得一定效果。

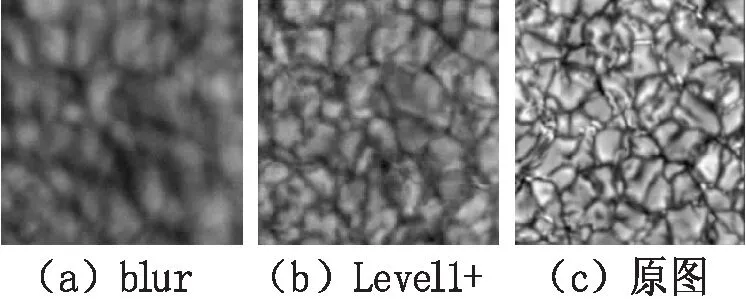

不同分辨率的太阳斑点图如图5所示,其中blur、Level1+组成数据对,用于训练NICE-GAN网络,原图由于数量极少且没有与之对应的低分辨率图,故只作为风格迁移过程中的风格图,不参与任何网络的训练。

图5 不同分辨率的太阳斑点图

2.2 网络训练

2.2.1 NICE-GAN网络训练

该文使用Adam作为NICE-GAN网络的参数优化算法,生成器和鉴别器的初始学习率均设置为0.000 1,训练迭代100 000次,重建损失、对抗损失和循环一致性损失的权重值λ1、λ2、λ3分别设置为10、1、10。

训练时将数据集blur和数据集Level1+输入NICE-GAN网络,网络在初始训练时学习率保持不变,经过反复训练,学习率呈线性下降趋势,最终趋于0;当学习率达到预设值时,停止训练,最终得到两个数据集之间的映射关系,即数据集blur中的低分辨率太阳斑点图经过NICE-GAN网络重建后与数据集Level1+中对应的高分辨率太阳斑点图一致。

2.2.2 风格迁移网络训练

该文使用Adam作为风格迁移网络的参数优化算法,初始学习率设置为0.000 1,训练迭代100 000次,用于调节内容特征和风格特征损失函数权重的α和β,一般设为0.5和0.5,因为该文强调内容特征的不丢失,所以设置为1和0.01。

训练时将数据集MS-COCO和数据集WikiArt输入到风格迁移网络,网络训练方法为最小化损失函数,当损失函数值达到理想值时,停止训练,最终重建图达到内容和风格的完美平衡,即在重建图中内容特征不丢失和风格特征完整表现。

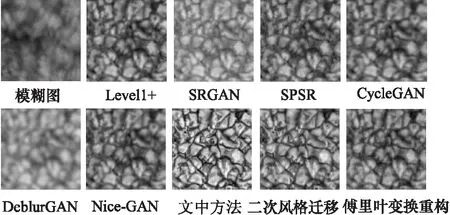

2.3 太阳斑点图重建结果

将NICE-GAN的重建结果作为风格迁移网络的内容图,少量太阳斑点图原图作为风格图,这样的重建结果包含了太阳斑点图的全局特征和局部细节,同时图片整体得到了增强,清晰度和对比度都有所提高。为了验证文中方法的有效性,将其与当前几种用于太阳斑点图超分辨率重建的方法SRGAN[14]、SPSR[15]、CycleGAN[16]、DeblurGAN[17]进行比较,并使用有参考图像质量评价标准SSIM、PSNR和无参考图像质量评价标准BRISQUE、NIQE、PIQE对重建结果进行客观评价。

由于缺少真正的太阳斑点图原图,所以文中方法和对比方法重建结果的参照对象是Level1+方法重建结果,这也导致文中方法重建结果的客观评价并不占优;因为SSIM是从亮度、结构和对比度这三个维度去评价两幅图片的相似度,而太阳斑点图更侧重于后两个维度,亮度的影响可以忽略不计,所以SSIM不能很好地评价文中方法的重建结果。

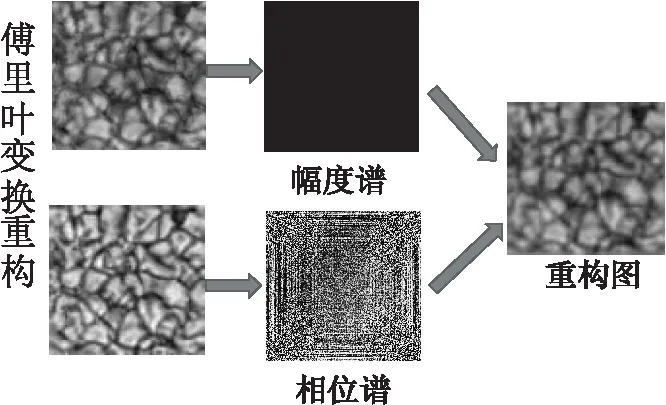

为了更好地对文中方法进行评价以及解决该方法重建结果的亮度与对应Level1+图不同的问题,使用傅里叶变换对文中方法的重建结果进行重构,处理过程如图6所示。

图6 傅里叶变换重构

由图6可知,对文中方法的重建结果进行傅里叶变换重构:使用傅里叶变换将Level1+方法和文中方法的重建结果在空域中的信息映射至频域空间,得到二者的幅度谱以及相位谱,其中幅度谱代表的是图像各像素点的亮度信息,即该像素应该显示什么颜色,但是幅度谱不包含每一点在原图像中的具体位置;相位谱记录的是所有点的相位信息,看起来相位谱是一团噪声,但它非常重要,因为相位信息中携带着图像的位置信息,结合图像的幅度谱和相位谱即可得到图像原本的信息,结合文中方法重建结果的相位谱与Level1+方法重建结果的幅度谱重构图像,即结合文中方法重建结果的位置信息和Level1+方法重建结果的颜色信息。

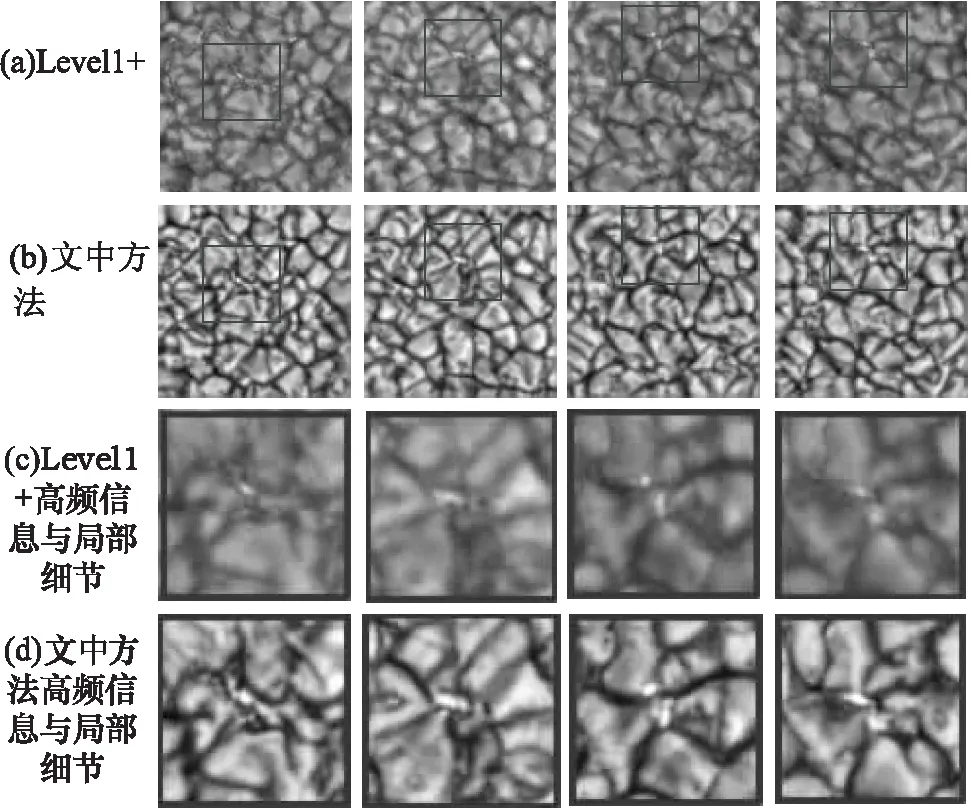

使用SSIM和PSNR进行有参考评价时,参考图像为Level1+方法得到的重建图像,因为它具有良好的可解释性,是目前主流的太阳图像重建方法。不同方法的重建结果、有参考评价结果、无参考评价结果分别由图7、表1、表2所示。

图7 不同方法的重建结果对比

由图7和表1可知,虽然文中方法在未经傅里叶变换重构处理前,评价数值比其他方法低,但经过处理后,评价数值明显提高,重建结果与Level1+方法重建结果非常接近,SSIM和PSNR均有不错的评价值,超过了大部分方法,与最优秀的方法处于同一水平。由此可以判断,文中方法保留了太阳斑点图的局部细节和高频信息,不会影响后续的科学分析。

表1 不同方法的有参考评价结果

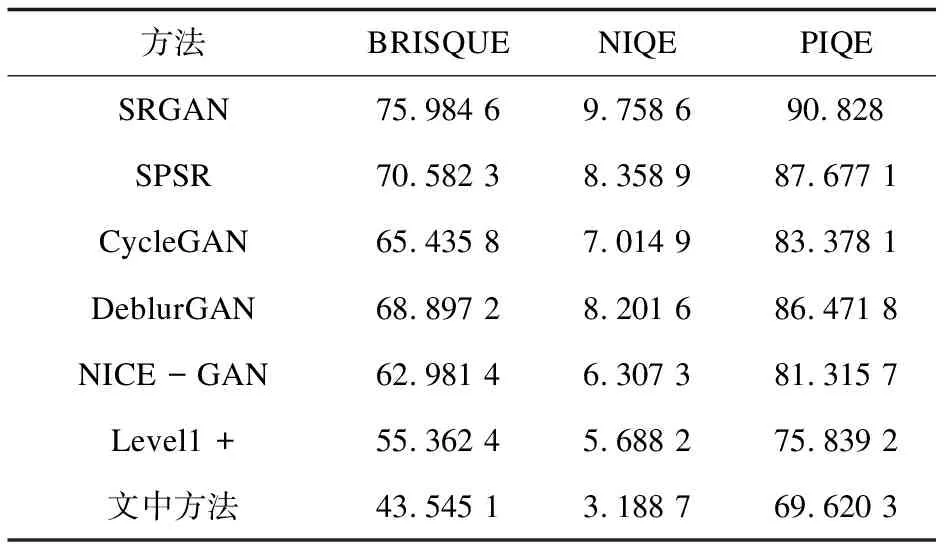

表2 不同方法的无参考评价结果

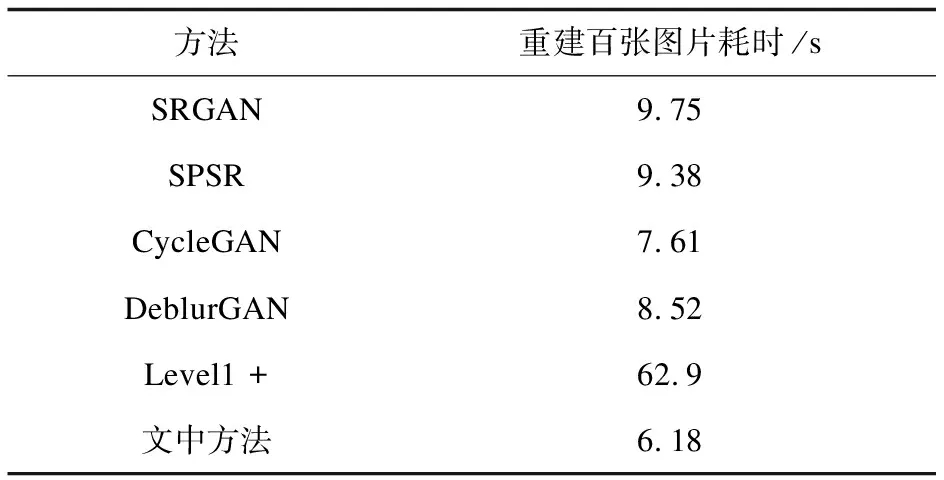

由表2可知,文中方法在三种无参考评价指标(这三种评价指标数值越小表明图像质量越高)上的评价值均优于其他方法,包括Level1+方法,这说明文中方法在一定程度上优于目前最好的Level1+方法。文中方法和Level1+方法重建结果的对比如图8所示。

图8 文中方法与Level1+方法结果对比

由图8可知,文中方法与目前最优秀的Level1+方法的重建结果相比,整体轮廓不变,同时保留了太阳斑点图最重要的局部细节和高频信息,如图8(c)、图8(d)两行所示,经过傅里叶变换重构的文中方法重建结果在SSIM和PSNR上的评价也证明了这一点,这使得后续的分析不受影响,而且图片整体得到了增强,重建结果的清晰度和对比度都有所提高,视觉效果得到改善。不同方法的效率比较如表3所示,由表3可知,与其他方法相比,文中方法重建每百张图片耗时最少,效率最高。

表3 不同方法的效率比较

3 结束语

该文提出一种结合生成对抗网络和风格迁移网络的太阳斑点图超分辨率重建方法STYLE-NICE-GAN,使用NICE-GAN网络,在有监督学习下,重建高分辨率太阳斑点图;使用风格迁移网络,在无监督学习下,对NICE-GAN网络的重建结果进行二次重建。实验结果表明,该方法对于太阳斑点图有很强的超分辨率重建能力,在不影响后续分析的前提下,视觉效果优于作为参考图的Level1+方法,评价指标也优于其他深度学习方法。

该方法虽然取得一定成果,但在数据预处理和风格迁移网络方面仍有改进空间。对于前者,使用图像融合并结合多张低分辨率图,生成具有更多信息的低分辨率图,减少伪影的生成;对于后者,尝试使用无偏风格迁移网络[18]减少内容损失。