基于深度学习的焊缝图像识别方法研究

杭小虎 王海

摘要:隨着工业技术的发展,焊接机器人被广泛应用于现代工业中的焊接工作,使焊接作业更加自动化和智能化。然而,受焊接环境、材料属性和技术的限制,焊接机器人作业后产生的焊缝存在各种隐患和问题。为了准确识别焊缝类型并加以改进,研究人员利用人工智能算法和技术进行处理,特别是深度学习模型使视觉识别方面的准确度不断提高,成为了主流方法。基于深度学习,文章研究焊缝识别方法,选用卷积系列网络、自注意力网络和Transformer模型进行焊缝识别工作,为焊缝识别问题提供了新的解决方案。

关键词:深度学习;焊缝图像识别;卷积神经网络;注意力机制;工业智能

中图分类号:TP311.1 文献标志码:A

0 引言

自动化的普及使得焊接作业变成了以机器人为主,人工为辅的新型焊接作业模式,大大提高了现实工作中的焊接效率,减轻了人工的工作负担,提高了生产效率。但是,这种由机器人进行焊接的方式同样存在着不足和隐患。

实际上,焊接机器人和工人一样,焊接机器人作业后产生的焊缝往往受到焊接所处环境、焊接材料属性以及焊接机器人技术的限制,产生各种隐患和问题。这些问题是引发事故的重大隐患。因此,工业界和学术界正在专注于解决关于如何准确识别焊缝类型的问题,并有针对性地进行改进。

基于深度学习的焊接缝隙识别是利用深度学习技术,结合目标检测、图像识别等视觉领域的主流方法进行焊缝的质量识别,进而辅助进行质量评估。本文首先从图像分类的技术发展路线出发,对图像识别领域,尤其是对焊缝进行处理中涉及的基础理论进行了详细陈述,进而梳理了焊缝识别的相关工作。之后介绍了焊缝识别中的数据形式和数据集特点,为实验部分提供了参考。最后,通过复现焊缝识别中的关键技术,在自有数据集上进行充足的实验,对比了不同方法的异同之处以及存在的问题和改进的方向,为后续焊缝识别问题的不断优化提供了科学的基础和方向。

1 相关工作

1.1 图像分类模型与方法

1.1.1 基于统计与机器学习的图像识别

基于统计学习的图像识别主要是利用传统机器学习方法,如贝叶斯决策、SVM以及K近邻等有监督分类算法,以及聚类、马尔科夫链、条件随机场等无监督分类算法对视觉图像进行分类。对焊缝识别而言,有许多学者将机器学习算法与深度学习相结合,利用深度学习的特征学习能力学习更好的特征,再利用机器学习分类算法完成分类。

1.1.2 基于深度学习的图像分类

基于深度学习的分类方法主要为卷积和注意力2个分支。对于卷积方法而言,从ALexNet到如今广受欢迎的ResNet,卷积主要对图像的二维信息进行分级建模,提供调整感受野的大小来学习不同尺度的信息。

基于注意力机制的方法是近几年来新兴的具有更加出色性能的分类方法。其中,ViT是Transformer模型在视觉中应用的第一个实例,也是焊缝识别目前常用的方法之一。

1.2 工业焊缝数据集与技术应用

本文采用的焊缝数据集是经过实际焊接过程中激光跟踪记录得到的,采样频率一般为50 Hz,能够检测到宽度在55 mm以内的焊缝。

采集得到的图像原始分辨率为1 024×1 024,如图1所示。原始图像往往具有较多的噪声和干扰像素。对于数据集的处理也聚焦在前期的去噪和调整像素等方面。

图1 焊缝图像

将采集到的焊缝图像先经过归一化处理,得到归一化图像数据,再调整图像分辨率,使其降低至224×224和380×380,如图2所示[1]。

对数据集的划分,采取5折交叉验证的策略,划分为3部分。

图2 焊缝图像与标注图像

2 理论与技术基础

2.1 图像数据稀疏表征

图像数据稀疏表征是指将二维多通道的图像数据进行向量量化,在特征空间中寻找一个最能代表图像特征的目标向量,作为该图像的表征,以此进行分类或者执行其他任务。

图像的稀疏表征通常具有以下几个过程:(1)将图像的样本进行归一化处理;(2)应用聚类算法对样本进行聚类分析,得到聚类中心;(3)寻找所有样本的最近邻聚类中心。

稀疏表示的公式为:

minU,V∑Nn=1‖xn-unV‖2(1)

2.2 主成分分析法

主成分分析法(Principle Component Analysis,PCA)是经典的机器学习算法,其原理是在原始数据的N维空间中寻找数据分布的最大分布量和分布方向,以此来进行后续分类或者其他机器学习任务。

焊缝识别的主成分分析法的基本原理是:将焊缝图像进行预处理,将像素进行归一化和去中心化,得到具有特定分布的数据;随后,将图像数据集合应用主成分分析法,经优化得到分析结果;最后将结果结合分类问题优化函数进行优化求解,得到类别预测结果。

2.3 自编码器

自编码器是一种对称式的神经网络结构,自编码器具有相同的输入和输出内容,是一种基于无监督学习方式训练的网络类型。

自编码器的优化方式为预测其输入内容,也就是将模型优化到能够输出自身的输入,即可完成目标。在这个过程中,自编码器学习到了输入图像的各级特征,如语义、纹理、形状等,自编码器的结构如图3所示。

图3 自编码器结构

自编码器的构成一般有以下3部分。(1)编码模块:负责对输入图像进行图像编码,以进行抽象表示。(2)隐藏层模块:学习图像的最小单位表示;(3)解码器模块:重建输入。

2.4 手工特征与大数据方法

手工特征阶段指的是基于SIFT特征的图像识别方法,在进行实际应用中,由于卷积神经网络的普及和强大能力,手工特征如今正在逐渐退出主流任务中。

大数据方法指利用海量数据的规律性对模型进行鲁棒性提升,以提高模型的分类精准度,常用的大数据方法包括数据增广、模型集成以及模型微调。

2.5 深度神经网络

2.5.1 卷积神经网络

2012年,AlexNet横空出世,首次证明了学习到的特征可以超越手工设计的特征,并一举打破了计算机视觉研究的现状。AlexNet使用了8层卷积神经网络,如图4所示[2]。

图4 AlexNet结构

虽然AlexNet证明深层神经网络卓有成效,但它没有提供一个通用的模板来指导后续的研究人员设计新的网络。使用块的想法首先出现在牛津大学的视觉几何组(Visual Geometry Group,VGG)的网络中。通过使用循环和子程序,可以很容易地在任何现代深度学习框架的代码中实现这些重复的架构。

但是,随着卷积神经网络的层数不断增加,由于新模型可能得出更优的解来拟合训练数据集,因此添加层似乎更容易降低训练误差。针对这一问题,李昱[3]的研究中提到的残差网络(ResNet)在2015年的ImageNet图像识别挑战赛夺魁,并深刻影响了后来的深度神经网络的设计。残差网络的核心思想是:每个附加层都应该更容易地包含原始函数作为其元素之一。于是,残差块(Residual Blocks)便诞生了,这个设计对如何建立深层神经网络产生了深远的影响。

2.5.2 自注意力和Vision Transformer

注意力(Attention)是指人们对于外界不同事物的关注程度。随着科技水平的进步,人们能够接触到的外界事物和信息越来越多,注意力也开始成为一种稀缺资源。在“注意力时代”,人们需要对外来的信息进行选择性地接收,这一过程需要注意力的密切参与。

作为模仿人脑神经工作原理的神经网络,在面对诸多信息和数据时,也需要提高注意力水平,才能更好地发掘和学习到关键的内在联系。因此,注意力机制应运而生。

注意力机制的思想并非近些年才有的。早在1964年,就有统计学家提出了类似的技术。当时的方法叫做Nadaraya-Watson核回归。对于回归问题,传统方法往往使用平均汇聚来计算训练集上的输出值,以此做平均得到真实值。实际上,这种处理方式会有很大的误差,当数据特征关系较为复杂时,仅仅使用平均汇聚难以突出关键因素的影响,反而平滑了关键因素的作用。

Nadaraya[4]和Watson[5]提出了更好的方法:根据输入数据的关系对输出进行加权,从而使影响力大的特征占据更大权重。

f(x)=∑ni=1K(x-xi)∑nj=1K(x-xj)yi(2)

对于函数K,使用高斯核进行计算。故Nadaraya-Watson核回归也叫注意力汇聚函数。

Nadaraya-Watson核回归是基于统计学和经典机器学习思想的注意力机制,以神经网络和深度学习思想为根据的注意力机制是在2017年提出的。

Vaswani等[6]提出了真正的注意力机制,

首先定义了3个向量:Q(Query)查询、K(Key)键、V(Value)值。注意力就是通过Q、K、V 3个向量的计算体现的。

其思想是,对于给定的K = [k1,k2,…,km]和V=[v1,v2,…,vm],使用Q = [q1,q2,…,qn]对K进行匹配,经Softmax层得到各维的相关性大小,记为α(Q,K),也叫注意力分数。计算结果时,将注意力分数与V进行加权求和即可。

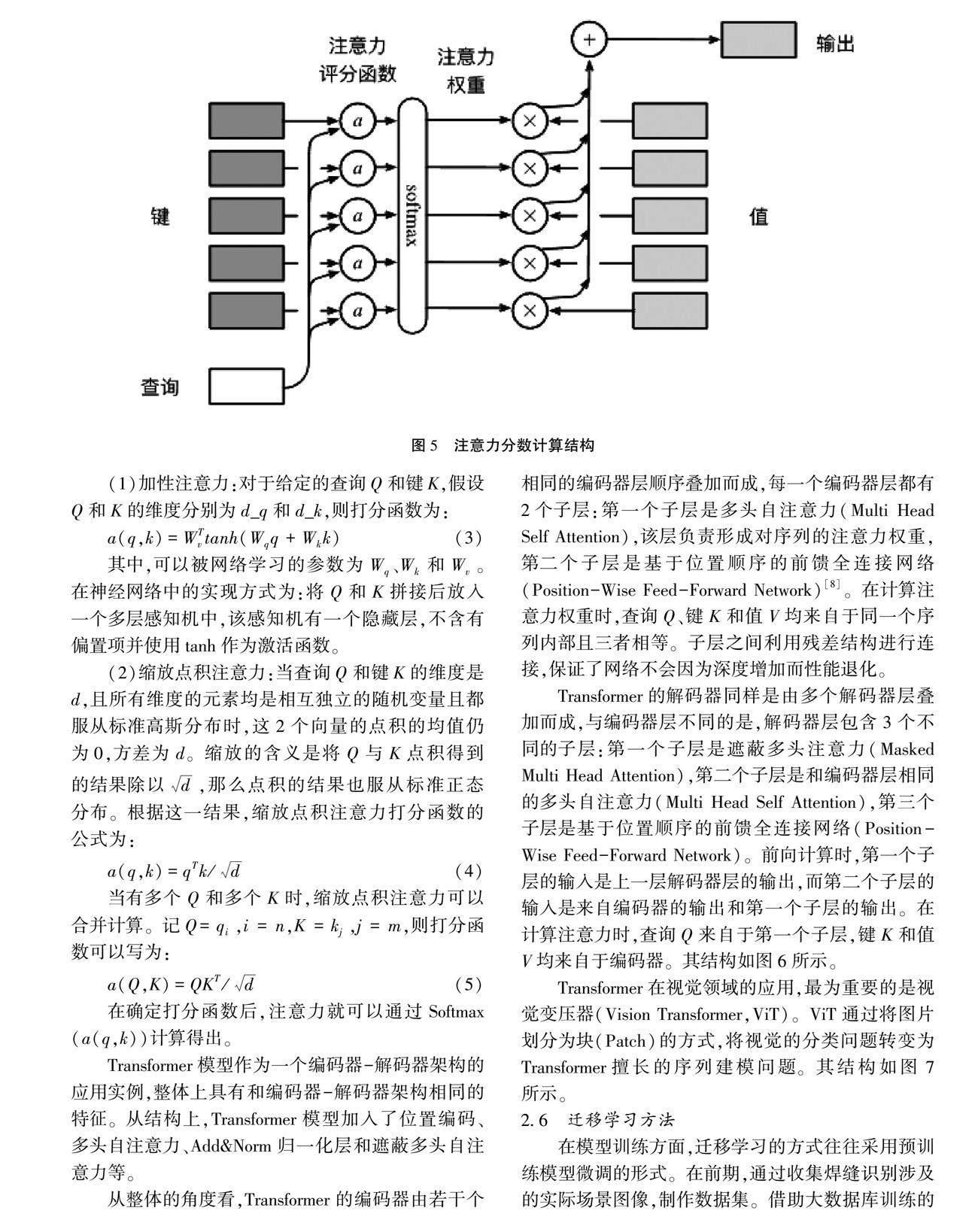

注意力分数的计算过程如图5所示。

注意力的计算分为2类:加性注意力(Additive Attention)和缩放点积注意力(Scaled Dot-Product Attention)[7]。二者的区别在于计算Q与K的相关性时采用不同的函数操作。当查询Q和键K的維度不相同时,使用加性注意力函数更加方便;当查询Q与键K维度相同时,使用缩放点积注意力函数计算效率更高。以下是2种打分函数的计算公式:

(1)加性注意力:对于给定的查询Q和键K,假设Q和K的维度分别为d_q和d_k,则打分函数为:

a(q,k)=WTvtanh(Wqq+Wkk)(3)

其中,可以被网络学习的参数为Wq、Wk和Wv。在神经网络中的实现方式为:将Q和K拼接后放入一个多层感知机中,该感知机有一个隐藏层,不含有偏置项并使用tanh作为激活函数。

(2)缩放点积注意力:当查询Q和键K的维度是d,且所有维度的元素均是相互独立的随机变量且都服从标准高斯分布时,这2个向量的点积的均值仍为0,方差为d。缩放的含义是将Q与K点积得到的结果除以d,那么点积的结果也服从标准正态分布。根据这一结果,缩放点积注意力打分函数的公式为:

a(q,k)=qTk/d(4)

当有多个Q和多个K时,缩放点积注意力可以合并计算。记Q=qi,i = n,K = kj,j = m,则打分函数可以写为:

a(Q,K)=QKT/d(5)

在确定打分函数后,注意力就可以通过Softmax(a(q,k))计算得出。

Transformer模型作为一个编码器-解码器架构的应用实例,整体上具有和编码器-解码器架构相同的特征。从结构上,Transformer模型加入了位置编码、多头自注意力、Add&Norm归一化层和遮蔽多头自注意力等。

从整体的角度看,Transformer的编码器由若干个相同的编码器层顺序叠加而成,每一个编码器层都有2个子层:第一个子层是多头自注意力(Multi Head Self Attention),该层负责形成对序列的注意力权重,第二个子层是基于位置顺序的前馈全连接网络(Position-Wise Feed-Forward Network)[8]。在计算注意力权重时,查询Q、键K和值V均来自于同一个序列内部且三者相等。子层之间利用残差结构进行连接,保证了网络不会因为深度增加而性能退化。

Transformer的解码器同样是由多个解码器层叠加而成,与编码器层不同的是,解码器层包含3个不同的子层:第一个子层是遮蔽多头注意力(Masked Multi Head Attention),第二个子层是和编码器层相同的多头自注意力(Multi Head Self Attention),第三个子层是基于位置顺序的前馈全连接网络(Position-Wise Feed-Forward Network)。前向计算时,第一个子层的输入是上一层解码器层的输出,而第二个子层的输入是来自编码器的输出和第一个子层的输出。在计算注意力时,查询Q来自于第一个子层,键K和值V均来自于编码器。其结构如图6所示。

图6 Transformer结构

Transformer在视觉领域的应用,最为重要的是视觉变压器(Vision Transformer,ViT)。ViT通过将图片划分为块(Patch)的方式,将视觉的分类问题转变为Transformer擅长的序列建模问题。其结构如图7所示。

图7 ViT patch结构

2.6 迁移学习方法

在模型训练方面,迁移学习的方式往往采用预训练模型微调的形式。在前期,通过收集焊缝识别涉及的实际场景图像,制作数据集。借助大数据库训练的大型视觉模型,结合项目自建数据集进行微调训练,使得模型能够通过参数的微调支持新数据集的建模和识别[9]。

3 实验与分析

3.1 实验环境与配置

本文的实验内容为基于卷积神经网络(ResNet网络、VGGNet网络以及GoogleNet网络)和基于自注意力机制(CNN网络+自注意力机制、Vision Transformer)的焊缝识别实验。在数据集上,使用本文第二章中介绍的自有数据集进行实验。

本文使用的软硬件环境如表1所示。

本文的实验环境是基于Anaconda配置的虚拟Python环境,项目中使用的部分依赖库如表2所示。

3.2 实验结果

最终实验结果如表3所示。

3.3 实验分析

对于基于卷积的模型而言,其分类准确度往往在0.9以下,而基于自注意力机制的模型准确度一般在0.9以上。这一规律证明了注意力机制的强大建模能力也是可以应用到焊缝识别中的。

对于ViT而言,其具有最好的R@1指标,即预测的候选类别中,第一个就为目标类别的能力最强,这也体现了ViT的视觉建模能力是远超其他模型的。

3.4 实验总结

(1)本文的数据集划分方式为简单分割,例如将数据集按照7∶3的比例分为训练集和验证集。后续可以考虑使用K折交叉验证等方式划分数据集,验证不同策略对于预测结果的影响。(2)本文使用的模型训练基于传统方式的卷积结构,使用交叉熵损失作为损失函数,使用Adam优化算法对参数进行更新,并加入了验证集。使用早停的思想进行训练。后续可以考虑验证不同损失函数的效果,使用不同的优化算法进行训练,并改进早停的机制,真正实现早些停止训练。

4 讨论与展望

本文在模型方面进行了对比和实验,后期可以考虑在原有Transformer模型的基础上,通过修改注意力计算公式或特征传递方式来提高模型的性能。目前已有学者对此做了许多研究,并设计了若干改进模型。对于焊缝识别问题,仍需要分析其在CNN模型及经典Transformer模型中的问题,对模型有针对性地进行改进以达到预期的结果。

在焊缝识别这个问题上,主流的方法仍是基于卷积神经网络或者融合了卷积层或注意力层的神经网络,本质上并没有改变。虽然目前的模型可以得到较为不错的结果,但是从特征关系的表征和学习上看,这些工作仍有不足之处。最近几年Transformer模型火遍深度学习整个领域,而且越来越多的问题被证实可以使用Transformer进行解决。与此同时,深度学习在工业领域的应用仍处于相对初级的阶段。因此,对Transformer模型加以改进,并应用到焊缝识别这个问题中是开创性的,也是具有研究价值的。

5 结语

本文所做的主要工作是使用不同的深度学习模型对焊缝识别数据进行预测,实现了利用深度学习进行焊缝识别的功能。具体的工作有如下几个方面:(1)总结了焊缝识别领域使用的经典算法和模型;(2)实现了CNN系列模型以及简化的Transformer模型,并使用焊缝识别数据集进行了训练测试;(3)总结了实验过程中的问题和不足,并思考了其中的解决方向。

参考文献

[1]周思羽,刘帅师,杨宏韬,等.基于融入注意力机制的改进U-Net鲁棒焊缝识别算法[EB/OL].(2023-01-04)[2023-11-02].http://kns.cnki.net/kcms/detail/11.5946.TP.20230104.1212.011.html.

[2]雷錚强,颜元.环焊缝缺陷漏磁内检测图像识别技术研究[J].石油管材与仪器,2022(5):32-36.

[3]李昱.基于结构光的焊接机器人焊缝图像识别算法研究[D].长春:长春工业大学,2022.

[4]NADARAYA E A.On estimating regression[J].Theory of Probability & Its Applications,1964(1):141-142.

[5]WATSON G S.Smooth regression analysis[J].Sankhy:The Indian Journal of Statistics(Series A),1964(2):359-372.

[6]VASWANI A,SHAZEER N,PARMAR N,et al.Attention is all you need[C].California:Conference and Workshop on Neural Information Processing Systems,2017.

[7]郭文強.基于磁光成像的铁磁性构件焊缝重构和裂纹识别方法研究[D].成都:电子科技大学,2022.

[8]刘霞,金忠庆.基于改进卷积神经网络的飞机桁架焊缝缺陷识别与测试[J].航空制造技术,2021(增刊2):34-38.

[9]李元.焊缝激光识别传感系统鲁棒性分析[D].沈阳:沈阳工业大学,2021.

(编辑 沈 强编辑)

Research on weld image recognition method based on deep learning

Hang Xiaohu, Wang Hai

(School of Intelligent Manufacturing and Information Institute, Jiangsu Shipping College, Nantong 226010, China)

Abstract: With the development of industrial technology, welding robots have become the main force of welding work in modern industry, turning welding operation into an automatic and intelligent process. However, welding seams produced by welding robots are often limited by the welding environment, welding material properties and welding process parameters. Therefore, it is necessary to use image processing technology to identify welds accurately. Based on this starting point, this paper conducts an in-depth study of deep learning-based weld identification methods, such as convolutional series network, self-attention network and the current hot Transformer model for weld identification work, to obtain ideal results and provide a new solution to the problem of weld identification.

Key words: deep learning; weld image identification; convolutional neural network; attention mechanism; industrial intelligence