加权双Q学习算法优化的PHEV能量管理策略研究

郭玉帆,沈世全,刘冠颖,2,古鸿吉,高 顺

(1.昆明理工大学 交通工程学院, 昆明 650500;2.云南开放大学 公共基础教学部, 昆明 650500)

0 引言

随着传统燃油车保有量逐年增长,能源危机与环境污染两大问题日趋严重。为了解决这些问题,车辆转型势在必行[1]。由于纯电动汽车受限于电能存储技术,无法满足长距离出行需求,燃料电池汽车成本昂贵且具有一定的安全隐患,在短期内无法推广应用,而插电式混合动力汽车(plug-in hybrid electric vehicles,PHEV)作为汽车电动化转型的过渡产物,相较于传统燃油车,具有更好的节油效果,并且弥补了纯电动汽车续航里程较短的难题,深受各车企的青睐[2]。

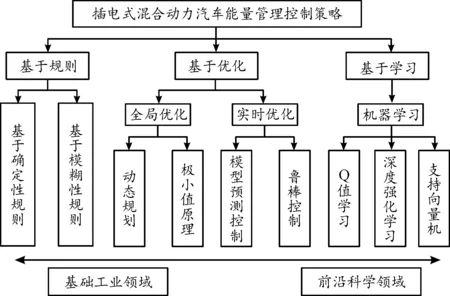

能量管理技术是根据混合动力系统各部件的状态反馈和能量管理策略(energy management strategy,EMS),实现PHEV不同的动力源的最优能量分配,满足动力性的同时降低车辆的消耗,是影响PHEV系统性能的关键因素之一。因此,设计一个具有良好工况适应性的EMS是改善PHEV燃油经济性的核心任务[3]。如图1所示,目前PHEV能量管理策略的研究主要分为三大类:基于规则、基于优化和基于学习[4]。其中基于规则的能量管理策略,主要通过设定相关参数阈值来实现对PHEV的有效控制,由于计算量小、复杂度适中、实时性强等优点,在PHEV中得到了广泛的应用[5]。基于规则的策略主要依据专家经验制定,很难保证按照预先定义的规则获得全局最优策略。为解决上述问题,出现了基于优化的方法,根据优化能力大体可以分为全局优化和实时优化两大类,极小值原理、动态规划、模型预测控制和鲁棒控制都是极具代表性的优化策略[6]。全局优化策略,虽可得出理论上最优的控制效果,但需要获取工况全局信息且计算负担大,难以满足PHEV的实时控制需求。实时优化策略虽然弥补了这一缺点,但是没有办法达到全局最优,同时由于计算量大、适应性较差限制了算法的实际应用[7]。

图1 能量管理控制策略分类框图

自人工智能应用于最优控制领域以来,强化学习(reinforcement learning,RL)作为一种重要的智能算法,被广泛用于PHEV能量管理优化问题。Liu等[8]通过对几种不同驾驶工况数值进行模拟,证明了基于RL的能量管理的适应性、优化性和学习能力。Yang等[9]设计了一种基于双重深度Q-learning(QL)的EMS,在不同初始值下都取得了良好的燃油经济性和令人满意的电池荷电状态保持性能。Ma等[10]通过使用深度确定性策略梯度算法为混合动力电动履带车开发了一个在线EMS,其燃油经济性几乎达到动态规划的90%,同时显著减少了计算时间。Tang等[11]开发了一种新颖的基于双深度Q网络学习(double-DQN)的EMS,结合基于规则的发动机启停策略,控制车辆换挡和发动机节气门的开度,实现混合动力汽车的多目标优化。Chen等[12]以一款功率分流式PHEV为研究对象,提出了一种基于双Q学习(double-QL)能量管理策略,与其他策略相比,double-QL策略可以更好地限制电池的最大输出功率,从而帮助PHEV获得了更好的经济性能。

基于QL的能量管理策略兼顾了基于规则和基于优化策略的优点,被广泛用于混合动力汽车的能量管理问题求解。然而,由于传统的QL在更新Q函数时使用最大动作值作为最大期望动作值的近似值,造成了动作值的高估,导致QL在随机环境中变现不佳。受此启发,双Q学习算法对传统QL算法进行了改进,对每一个状态使用2个Q函数,并将Q函数的动作与其值解耦,避免传统Q学习的高估问题;但是双Q学习并不是完全无偏的,依旧存在低估偏差[13],因此又引入加权函数,使2个Q函数之间存在一个线性关系,减少双Q学习动作值低估发生的概率。在此基础上,本文以一款PHEV为研究对象,设计了一种基于加权双Q学习(weighted double Q-learning,WDQL)的能量管理控制策略,在PHEV的多个动力源之间进行功率分配。最后,在Autonomie平台上通过Matlab/Simulink搭建整车仿真模型,验证了所提策略的燃油经济性和工况适应性。

1 插电式混合动力汽车动力系统建模

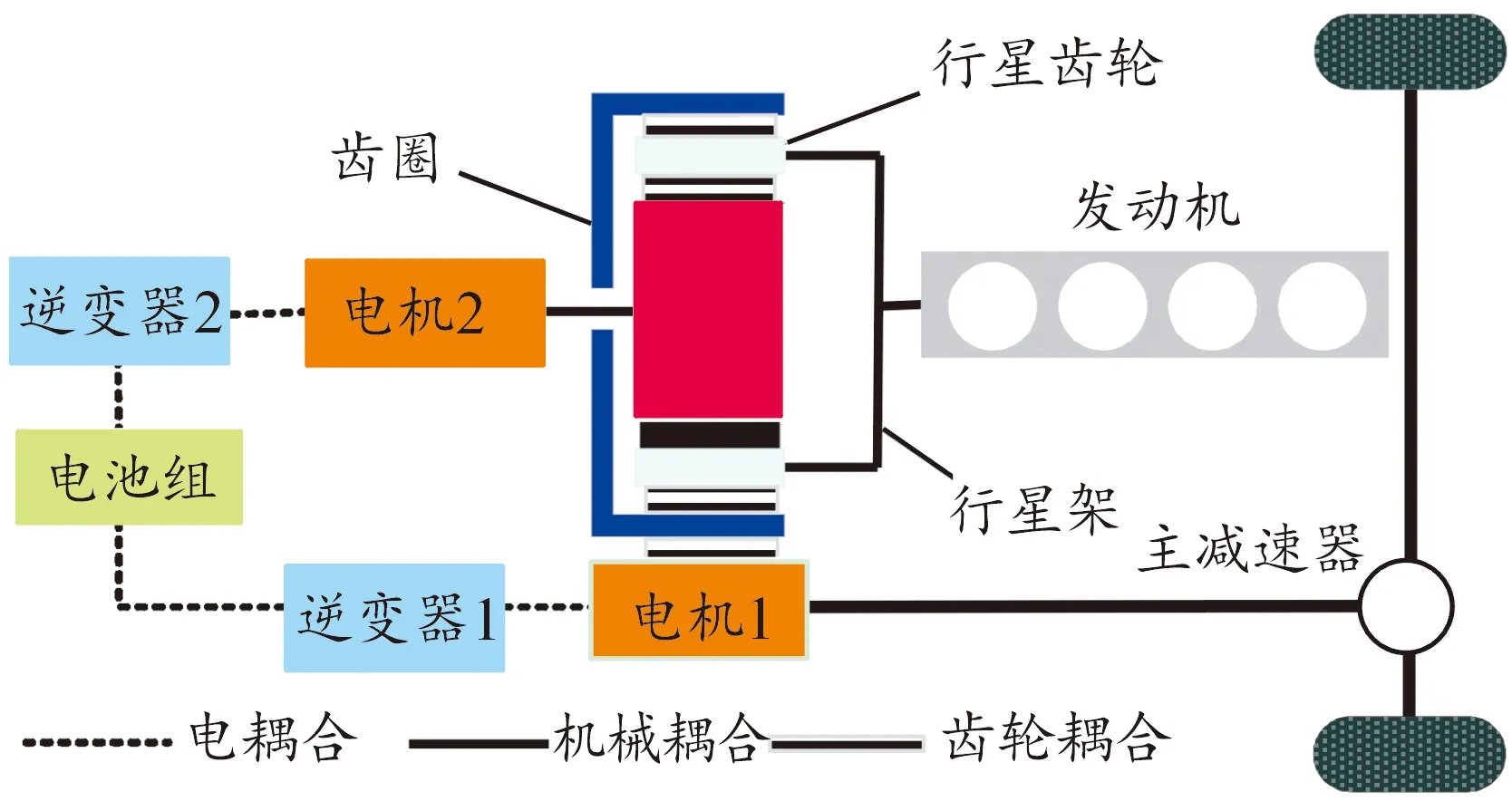

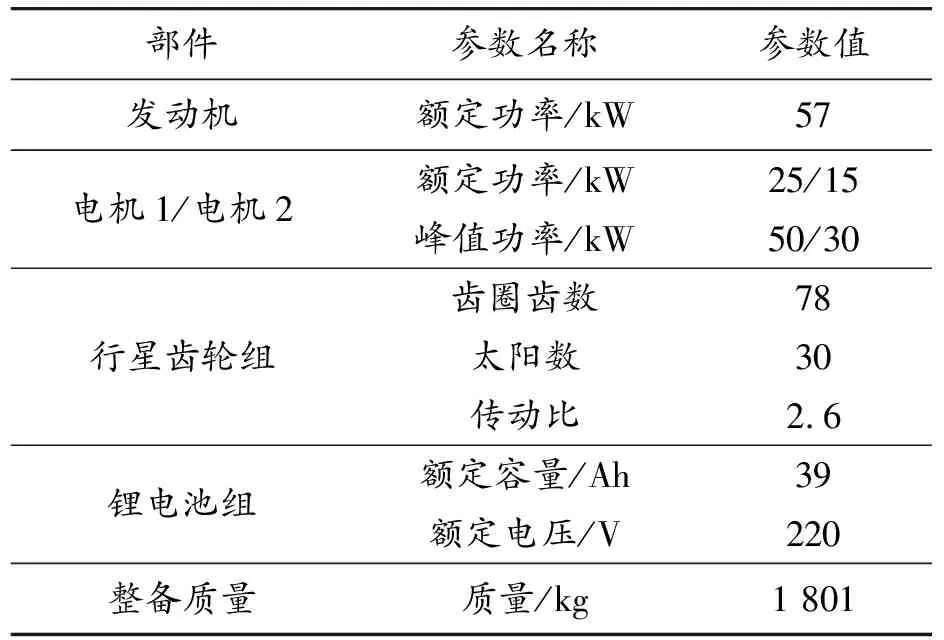

本文以丰田Prius功率分流式PHEV为研究对象,其结构如图2所示,整车主要部件包括2个电机、发动机、电池组、2个逆变器和行星齿轮组构成,其中发动机与行星齿轮组中的行星架机械连接,电机2与太阳轮机械耦合,电池组与逆变器电连接,电机1与齿圈齿轮啮合,关键部件的主要参数见表1所示。

图2 功率分流PHEV的系统结构示意图

表1 整车关键部件主要参数

1.1 动力总成模型

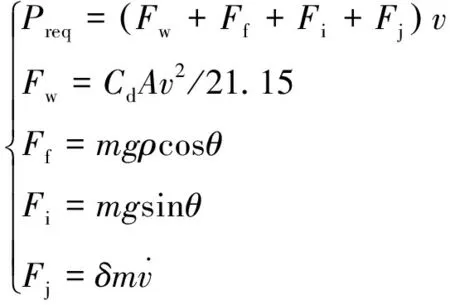

本文侧重于对PHEV的经济性的研究,对整车的稳定性和舒适性不做过多分析,因此当行驶工况(v)已知时,需求功率Preq可以根据所克服的空气阻力Fw、坡道阻力Fi、滚动阻力Ff和加速阻力Fj通过整车纵向动力学公式求得:

(1)

(2)

式中:Preq、Pbat、Peng和Pm分别为主减速器、电池组、发动机和电机的输出功率;ηf、ηg和ηm分别表示主减速器、齿轮组和电机的传递效率;α1∈{-1,1} ,当电机作为电动机为PHEV提供行驶动力时α1=-1,当电机作为发电机给动力电池充电时α1=-1。

1.2 发动机模型

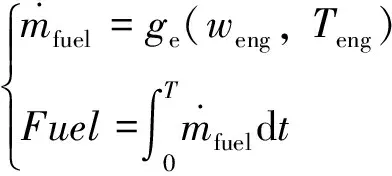

本文重点考虑发动机油耗的计算,在忽略发动机模糊的非线性时变动态特性的情况下,将发动机的瞬时油耗描述为一个映射关系,即发动机油耗模型是关于其转速与扭矩的相关函数:

(3)

(4)

当发动机转速和转矩已知时,每t时刻的燃油消耗率可以通过图4所示获得。

图3 发动机最优工作曲线

图4 发动机油耗MAP图

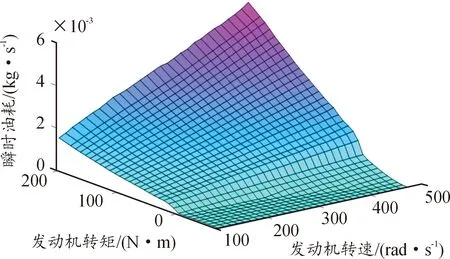

1.3 电机模型

电机作为PHEV的直接动力部件,具有至关重要的作用。当电机作为电动机使用时,可以作为动力源为车辆提供前进动力;当汽车制动作为发电机使用时,能够将发动机剩余的能量和制动回收的能量存储至电池组,从而为电池组补充电能。类似于发动机,电机的转矩、转速和效率可以构成电机效率MAP图,如图5所示。本文在进行电机建模时,为了减少计算负担,没有考虑热效应等因素对电机性能影响,电机的效率ηm、功率Pm和转矩Tmot、转速wmot之间的关系Ψm可以表示为:

(5)

图5 电机效率MAPs

1.4 锂离子电池模型

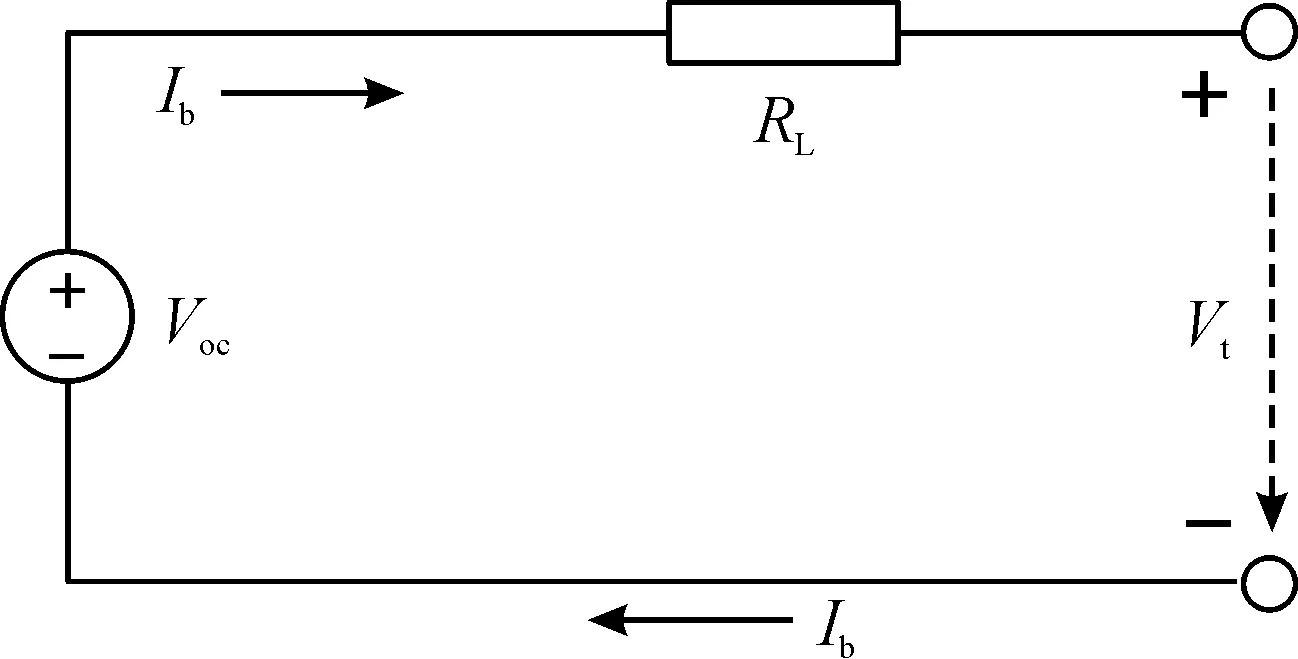

电池组在PHEV中充当着能量存储系统的角色,既可以回收来自电机转动产生的能量,又可以输出能量驱动汽车行驶。本文为了简化分析,采用一阶等效内阻模型来描述电池组工作工程中的充放电特性,其电路如图6所示。

图6 电池组一阶等效电路

根据等效电路模型,若忽略开路电压动态变化,PHEV的电路关系可描述成电池功率的函数:

Pbat(t)=Voc·Ibat(t)-rintIbat(t)2

(6)

式中:Pbat、Ibat、Voc分别为电池功率、电流和开路电压;rint为电池内阻。

从而得到电池组的电流函数:

(7)

电池的荷电状态(state of charge,SOC)作为EMS的主要控制参数,既反映了电池电量使用情况,又影响着电池的内阻,电压和工作效率,本文通过安时积分法对电池SOC进行估算:

(8)

式中:SOC0表示初始的荷电指数;Qbat指电池总容量(Ah);若忽略温度变化和电池老化的影响,Voc和rint随电池SOC变化,如图7所示。

图7 电池开路电压和内阻变化曲线

2 加权双Q学习算法的最优EMS

2.1 插电式混合动力汽车能量管理模型

PHEV的整车能量主要源于电池组提供的电能和发动机提供的燃油,已知行驶工况,在确保动力性的同时合理分配电池组和发动机之间的功率,使PHEV在行驶过程中的燃油消耗和电池电量消耗在一定程度维持均衡是PHEV能量管理控制策略的控制目标[14]。PHEV的能量管理问题作为多目标优化问题,一般将其EMS简化为非线性的离散系统,其状态方程f为:

x(t+1)=f(x(t),u(t),t)

t=0,1,2,…,T

(9)

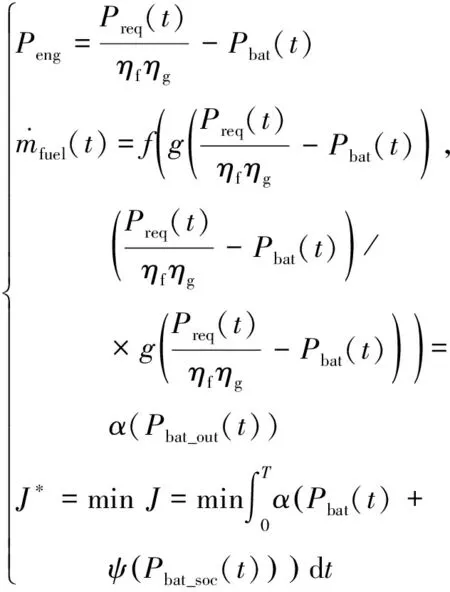

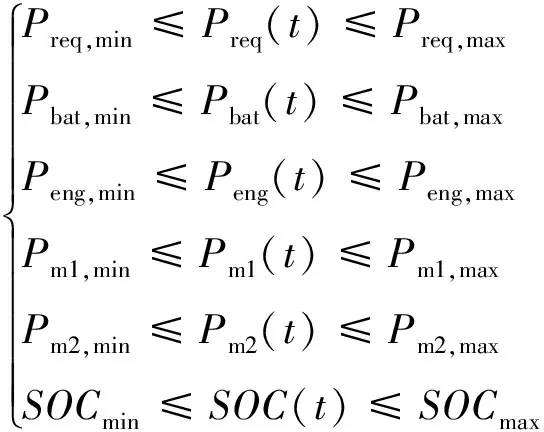

式中:x(t)和u(t)分别为状态变量和控制变量;T为行驶周期内持续采样时间。则WDQL策略中的性能优化目标函数J定义为:

ψ(ΔSOC(t)2]dt

(10)

式中:α和ψ是2个权重因子,通过调整2个参数,EMS实现发动机和电池之间的最优功率分配。根据PHEV的功率流关系,当需求功率已知,电池组的功率输出与发动机输出功率相关,因此可以把发动机瞬时油耗函数转化为电池功率相关的函数:

(11)

通过上述分析,在已知行驶工况的需求功率和车速的情况下,可以把电池组的输出功率作为目标函数的唯一控制量。此外,为了确保PHEV的正常运行,系统状态必须满足以下限制条件:

(12)

式中:下标min和max表示各部件参数取值的系统临界值,并且为了保持较小的电阻,电池的SOC维持在[0.3,0.9]。

2.2 加权双Q学习算法优化的能量管理控制策略

加权双Q学习算法是传统QL的一种改进算法,平衡了常规Q学习算法高估和双Q学习算法的低估问题[13]。与传统QL算法相比,WDQL算法使用2个Q函数(QU和QV)来选择和评估动作,可以避免Q学习中动作值的高估;同时引入加权函数β,使2个Q函数之间存在某种线性关系,降低双Q学习算法的低估偏差。与传统的QL算法工作流程相似,如图8所示,WDQL算法也是智能系统与所在环境连续交互,通过不断地试错,收集不同状态下各种可能动作的奖励。在学习过程中,首先智能体根据环境传递来的即时奖励值的大小评估所选动作的优劣,然后根据状态-动作对更新Q函数(QU和QV),最后通过ε-贪婪算法选择动作以获得最大期望奖励值。

图8 加权双Q学习策略控制过程框图

本文设计一种基于WDQL算法的EMS,实现PHEV中电池和发动机之间最优功率分配,减少PHEV燃油消耗。因此,本文选取需求功率Preq和电池SOC作为状态变量,电池功率Pbat作为控制变量,将WDQL能量管理策略的变量空间设置为:

(13)

(14)

式中:α和ψ分别表示当前时刻瞬时燃油和电池SOC的权重因子。加权双Q学习在ε-贪婪算法作用下,WDQL有(1-ε)100%的概率会在QU(s,a)和QV(s,a)中选择已知并且具有最大动作值的动作,以ε×100%的概率随机选择动作。通常ε设置成一个很小的值,在ε-贪婪算法的作用下加强了智能体的动作探索,避免了算法陷入局部最优。

(15)

在WDQL算法中引入决定变量d和随机变量b,其中,d=0.5、b∈(0,1),并使用2个变量的比较结果来选择更新2个Q函数中的其中1个,Q函数更新规则如下:

(16)

在确定更新Q函数后,引入加权函数β使得WDQL在更新QU(s,a)和QV(s,a)时使用不同的δ值,加权参数β和最优QU,WDQL函数表示为:

(17)

式中:a*和aL分别表示在下一个状态s′下,值函数QU能取的最大价值函数值和最小价值函数值对应的动作值;c是常数;σ是学习率;γ是折价因子,用于平衡即时奖励和延迟奖励的重要性。从式(17)可以看出,WDQL使用一个QU(s,a)和QV(s,a)的线性组合来求取最优QU,WDQL函数值。因此,QU,WDQL代表了对Q学习的高估和对双Q学习的低估之间的权衡,这样可以被认为是对Q函数的无偏估计[13],类似的更新用于QV(s,a)。加权双Q学习算法详细的计算流程如下:

加权双Q学习算法

1.初始化QU(s,a),QV(s,a),s,r,β(s,a)

2.设置学习率σ

3.For episode =1,Mdo

4.Fort=1,2,3,…,Tdo

5.运用ε-贪婪算法根据QU和QV选择控制动作a

6.执行动作a获得即时奖励r和下一状态s′

7.选择随机数b来决定更新QU或者QV

8.ifb>0.5 then

9.a*=argmaxaQU(s′, ∶)

10.aL=arg minaQU(s′,∶)

12.δ(s,a)=r+γ[βUQU(s′,a*)+

(1-βU)QV(s′,a*)]-QU(s,a)

13.QU(s,a)=QU(s,a)+δ(s,a)σ

14.else ifb≤0.5 then

15.a*=argmaxaQV(s′,∶)

16.aL=argminaQV(s′,∶)

18.δ(s,a)=r+γ[βVQV(s′,a*)+

(1-βV)QU(s′,a*)]-QV(s,a)

19.QV(s,a)=QV(s,a)+δ(s,a)σ

20.end

21.s=s′

22.End

23.End

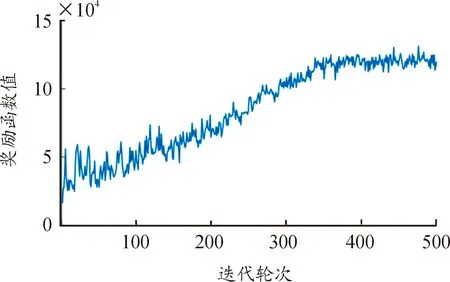

在PHEV的能量管理问题中,若想获得良好的控制效果,检测算法有效,需要验证WDQL算法的收敛性。图9为WDQL策略在以JC08、US06、LA92、RP05、SC03和WLTC 6个标准工况作为训练数据下的奖励函数变化曲线。可以发现,随着迭代次数的增加,单轮奖励函数值也迅速增大,直到趋于稳定,这说明基于WDQL的PHEV能量管理控制策略能够以较快的速度收敛。

图9 WDQL算法的奖励函数曲线

3 仿真与分析

为了评估所提控制策略的效果,将基于随机动态规划和基于规则的能量管理策略在工况HWFET、UDDS、NEDC和KM1下的效果与其作对比。测试工况对应的速度曲线如图10。

图10 验证工况车速曲线

3.1 SDP和CD/CS算法优化的PHEV能量管理策略

随机动态规划(stochastic dynamic programming,SDP)是动态规划和马尔科夫决策的结合体,既有动态规划解决全局最优问题的优点,又具备马尔科夫求解随机问题的优势。Lin等[15]针对一款并联式混合动力汽车,提出了一种基于SDP策略的能量管理策略,仿真结果表明,SDP策略是一种仅次于动态规划的全局次优的能量管理策略。对于基于SDP算法的PHEV能量管理问题,依旧选取电池功率Pbat作为控制变量,最小累计油耗作为目标函数:

(18)

基于规则的能量管理策略是如今使用最普遍的EMS,本文选取一种放电-维持策略(charge depletion /chare sustaining,CD/CS)作为基准策略。CD/CS策略是一种典型确定性规则策略,不需要提前预知未来工况,可以充分利用电池电能实现在线计算[16]。CD/CS策略由CD模式和CS模式2种模式组成,在CD阶段,电池电量充足,电池是主要供能装置,只有当电池最大功率无法满足汽车行驶所需功率时,发动机才会短暂启动;当电池SOC下降到预设阈值则进入CS阶段,发动机作为主要供能装置,并对电池进行补充充电,使电池SOC维持在阈值附近。CD/CS策略用数学公式描述为:

(19)

3.2 能量管理策略效果的对比分析

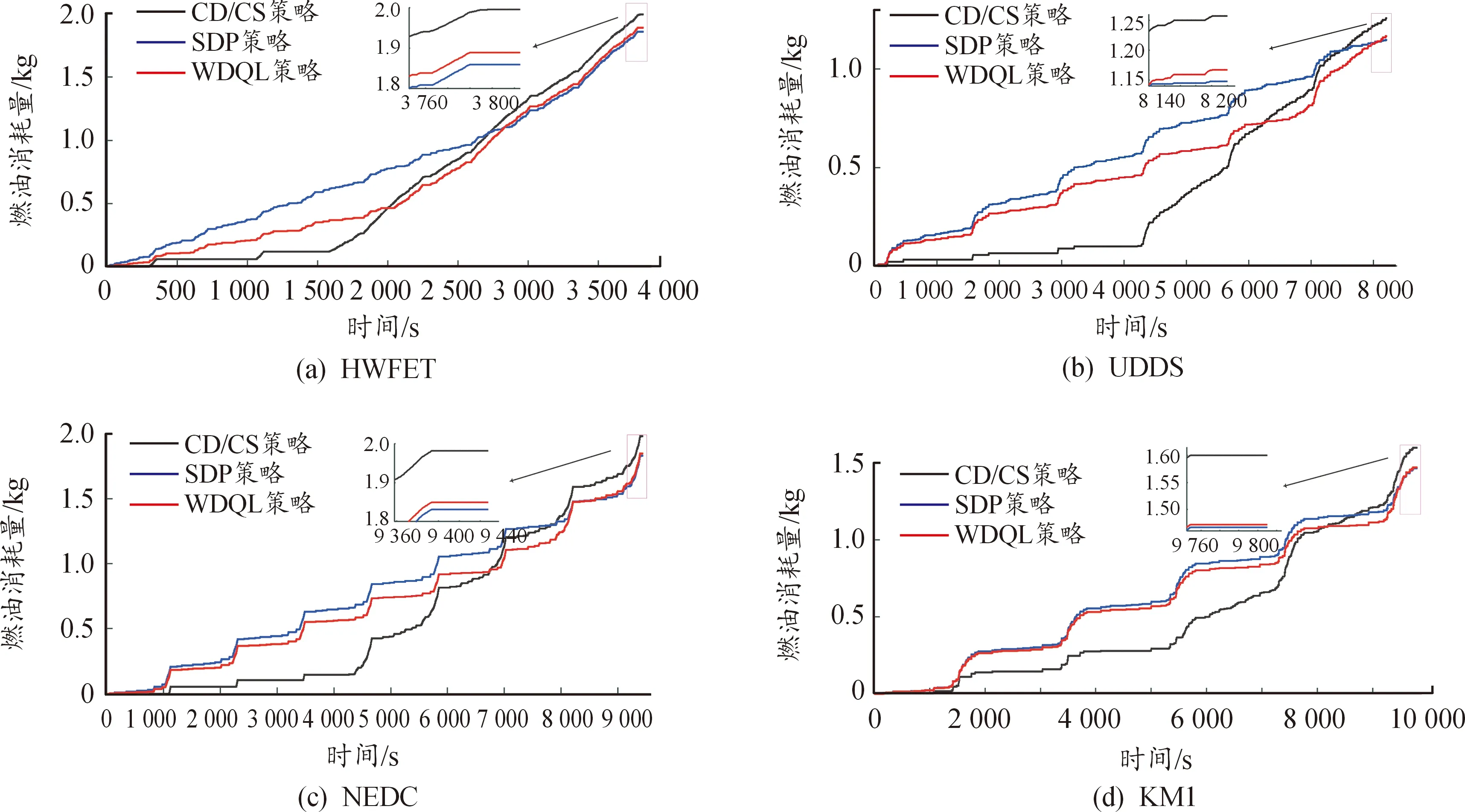

建立好各种控制策略以后,通过Autonomie对测试工况进行仿真分析。图11为3种控制策略在不同工况下的油耗表现,可以看出,相比较于CD/CS策略,WDQL策略在各个工况下的油耗都呈现出不同程度的下降趋势,且与SDP策略下的油耗相差不大。

图12为不同策略在不同复合行驶工况下的SOC的变化曲线,可以看出,相比CD/CS策略,基于WDQL策略的工作状态不再单纯由电池SOC决定,而是控制策略根据最优目标函数来控制PHEV的发动机工作状态,频繁调用发动机介入工作,辅助动力电池来共同驱动车辆,延迟了电池SOC下降到预设阈值的时间,使电池电量下降速率明显降低,更好地控制电池的功率输出,表明WDQL策略能够将电池的SOC维持在一定范围,从而降低汽车燃油消耗并减少尾气排放。

图11 复合工况的油耗曲线

图12 SOC变化曲线

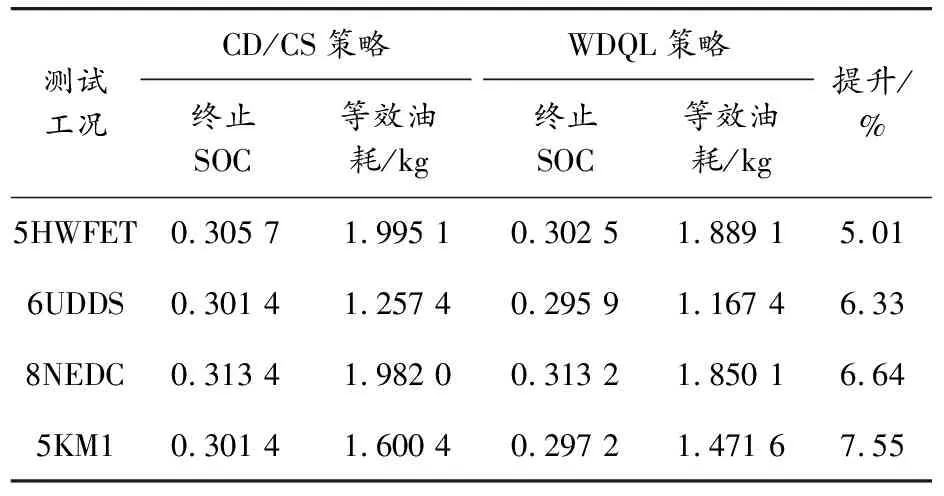

基于WDQL策略中的奖励函数仅仅影响瞬时控制动作的选择,使得在该策略下最终电池SOC具有相应的偏差,为了使所提策略下的燃油经济性更有说服力,存在的SOC偏差将以能量守恒原则等效为燃油消耗量[6]。表3为CD/CS策略和WDQL策略在不同组合工况下的能耗。对比CD/CS策略,数据直观地显示出WDQL策略燃油经济性分别提高了5.66%、6.70%、6.99%和5.51%,证明了所提策略的有效性。SDP策略作为全局优化策略,可以实现PHEV整车的最优燃油经济性,由表4可以看出,基于WDQL的能量管理策略可以实现SDP策略的98%以上的燃油经济性,证明了所提策略的次优性和对不同的驾驶循环工况具有良好的燃油经济性。

表3 CD/CS策略与WDQL策略燃油经济性

表4 SDP策略与WDQL策略燃油经济性

不同工况下各控制策略的发动机工作点如图13所示。可以发现SDP策略下,发动机的工作点几乎完全在最优工作曲线上,CD/CS策略由于发动机的频繁启动,工作点主要集中在低功率和较低功率的区间,而本文所提策略相比CD/CS策略,发动机的工作点轨迹明显沿着最优曲线上移,和SDP策略下发动机工作点轨迹接近,且由于WDQL策略的学习能力,发动机的启停频率明显小于其他策略。这说明,所提策略能够合理地分配发动机和电池的功率,缓解发动机工作在低转矩、低效率工作区间的概率,从而提高了PHEV的燃油经济性。

图13 发动机工作点在效率MAP上的对比

4 结论

本文以PHEV为研究对象,提出了一种基于加权双Q学习算法能量管理策略,该策略不仅可以平衡常规Q学习算法高估和双Q学习算法的低估问题,还能提高PHEV燃油经济性。通过仿真分析,得出以下结论:

1) 基于加权双Q学习的PHEV能量管理策略可以平衡常规Q学习算法高估和双Q学习算法的低估问题,减少了随机性的影响,在不同的工况下具良好的适应性并可以实现较好的燃油经济性。

2) 基于加权双Q学习的PHEV能量管理策略能够使发动机避免在低效率区域工作,而更多工作在发动机高效率区,从而有效提升发动机工作效率,降低了PHEV在运行过程中的燃油消耗。

3) 基于加权双Q学习的PHEV能量管理策略可以延迟电池SOC下降到预定阈值的速度,更好地控制电池功率输出,提高PHEV的燃油经济性。