基于改进YOLOv5的茶叶杂质检测算法

黄少华,梁喜凤

基于改进YOLOv5的茶叶杂质检测算法

黄少华,梁喜凤※

(中国计量大学机电工程学院,杭州 310018)

针对现有目标检测算法检测茶叶杂质精度低、速度慢的问题,该研究提出了一种基于改进YOLOv5的茶叶杂质检测算法。采用K-Means聚类算法对杂质真实框聚类,以获取适合茶叶杂质特征的锚框尺寸;通过在主干特征提取网络CSPDarkNet中引入前馈卷积注意力机制(Convolutional Block Attention Module,CBAM),将茶叶杂质输入特征图依次经过通道注意力模块和空间注意力模块,获得特征图通道维度和空间维度的关键特征;在颈部网络中添加空间金字塔池化(Spatial Pyramid Pooling,SPP)模块,融合并提取不同感受野的关键特征信息;将普通卷积替换成深度可分离卷积,增大小目标预测特征图的置信度损失权重,构建了轻量化的改进YOLOv5网络结构模型;分别制作了铁观音茶叶中混合有稻谷、瓜子壳、竹枝和茶梗4种杂质的数据集并进行茶叶杂质检测试验。结果表明,改进的YOLOv5比常规YOLOv5在茶叶杂质检测中具有更高的置信度分数,且定位更为准确,未出现漏检现象。改进YOLOv5的多类别平均精度(Mean Average Precision,mAP)和每秒传输帧数(Frame Per Second,FPS)达到96.05%和62帧/s,均优于主流的目标检测算法,验证了改进算法的高效性和鲁棒性。该研究成果可为提升茶叶制作过程中小目标杂质检测精度与检测速度奠定基础。

深度学习;算法;目标检测;YOLOv5;茶叶杂质

0 引 言

茶叶具有很高的商业价值和药用价值,在中国具有庞大的消费市场。茶叶分拣是茶叶制作工序中重要环节。茶叶采集过程中,通常会混入树枝、谷物等杂质,影响茶叶的口感和品质[1-4]。为提升茶叶成品质量,对采摘收集到的新茶炒制成成品茶叶后还需进一步分拣,剔除掉多余的杂质。传统的茶叶分拣方式采用人工手动分拣剔除杂质,需要消耗大量人力,耗时长,效率低。近年来,机器视觉逐渐应用于茶叶杂质分拣,识别精准高,有助于实现茶叶自动化分拣,对茶叶分拣技术的产量化具有较高的应用价值[5]。

基于深度学习的目标检测算法通过强大的卷积神经网络学习茶叶杂质的特征信息,并使用回归器和分类器对杂质进行定位和分类,能够实现复杂场景下的茶叶杂质检测。常见的基于深度学习目标检测算法根据是否使用区域建议网络(Region Proposal Network,RPN)[6-7]可分为双阶段目标检测和单阶段目标检测。双阶段检测精度较高但训练复杂,检测耗时较长[8]。常见的单阶段检测算法有SSD网络[9-10]和YOLO系列网络[11]。单阶段检测省去了候选框生成的工作,精简了模型参数量,在牺牲了部分检测精度的前提下,检测速度显著快于双阶段目标检测。目前大部分检测任务为了追求实时性原则,均以单阶段检测为主。其中,以YOLOv5为代表的单阶段轻量级网络在综合汇聚了前几代YOLO系列网络的基础上,改良了对小目标的检测速度和精度,具有较好的检测效果。基于此,胡根生等[12]以YOLOv5为基线,利用卷积核组进行了复杂背景下茶尺蠖的检测。尚钰莹等[13]提出了一种基于YOLOv5s深度学习的草果花朵的检测方法。Bochkovskiy等[14]在YOLOv5的基础上融合多种策略,以适应不同场景下的目标检测任务。吕禾丰等[15]在通过替换YOLOv5中损失函数的方法,提高了交通标志识别精度和准确率。吕军等[16]提出在YOLOv5模型采用CSPDarknet53 特征提取网络进行茶叶嫩芽检测,改进了自然光照条件检测的鲁棒性。Zhu等[17]构建了TPH-YOLOv5网络,在原始YOLOv5基础上增添了Transformer模块和CBAM卷积注意力模块,提升了网络模型对小尺度目标的检测性能。徐凤如等[18]通过采用改进型YOLOv4-Dense算法,研究了茶树芽叶采摘点的定位方法,具有良好的识别率。以上研究对YOLOv4或YOLOv5目标检测网络进行了改进和优化。然而在茶叶杂质检测任务中,茶叶簇杂乱无章,背景较为复杂,且杂质目标较小,混入在茶叶中检测难度大,树枝等杂质和茶叶颜色相近,增加了检测难度,目前的YOLOv5网络提取杂质特征能力不足,检测精度较低,预测框定位不准确,检测重叠的小目标杂质容易出现漏检等,不能满足小目标茶叶杂质检测需求。

因此,针对以上存在问题,本文提出了一种基于改进YOLOv5的茶叶杂质检测算法。采用K-Means聚类锚框尺寸,主干网络CSPDarkNet引入卷积注意力机制(Convolutional Block Attention Module,CBAM),颈部网络中添加空间金字塔池化(Spatial Pyramid Pooling,SPP)模块,利用深度可分离卷积代替普通卷积,增大小目标预测特征图的置信度损失权重等方面对YOLOv5模型进行改进,并对多种茶叶杂质数据集进行试验,验证改进算法的高效性和鲁棒性,以提高茶叶制作中杂质检测的精度与速度。

1 改进的YOLOv5网络结构

YOLOv5模型参数量最少,检测速度快,广泛应用在实际场景中。因此选取YOLOv5作为茶叶杂质检测的基础模型。但是,茶叶杂质一般较小,种类复杂,且树枝等杂质颜色与茶叶相近,混入茶叶簇,因此需要在锚框尺寸、关键特性关注度、检测精度等方面进行YOLOv5网络改进,从而适应茶叶杂质检测需求。

1.1 先验锚框选取

初始的先验锚框尺寸影响网络训练速度和定位准确性,常规YOLOv5锚框针对COCO(Microsoft Common Objects in Context)和VOC(Visual Object Classes)数据集,而茶叶杂质均为小目标,基于初始锚框的训练不适用于茶叶杂质。如果数据集标注信息针对默认锚框的最佳召回率小于0.98时,则需要重新计算符合此数据集的锚框[19]。YOLOv5的重新自适应锚框计算采用K-means[20-22]重新定义锚框尺寸的聚类算法,实现步骤如下:

1)取出茶叶杂质真实框的宽高值作为坐标点集合,在所有坐标点中随机抽取个初始簇心。

2)计算剩余坐标点与簇心的欧氏距离,将剩余坐标点与最近簇归为同一种类,当所有坐标点归类完成后,根据每个簇中所有坐标点的平均值重新计算每个簇心。

3)反复迭代上述步骤2,直至簇心不再改变。

由于YOLOv5头部网络输出3种尺度预测特征图,每个预测特征图均具有大、中、小三种尺度锚框,因此取9,此时茶叶杂质锚框被分为9种不同尺寸的簇。

聚类试验达到稳定后的9种锚框尺寸参数如表1所示,聚类后的锚框尺寸更符合茶叶杂质的尺寸和宽高比例特征。

表1 改进的YOLOv5锚框尺寸

1.2 注意力机制

针对茶叶杂质的目标检测任务,除了需要考虑杂质的语义特征外,同时还需考虑茶叶杂质的空间位置,在YOLOv5主干网络中引入注意力机制,能够自适应学习茶叶杂质的关键特征。根据训练获得的注意力权重可增加网络对关键特征的注意力,降低干扰特征的关注度。

CBAM将通道维度和空间维度相结合[23],最终权衡得到特征图通道维度和空间维度的关键特征。通道注意力模块对输入茶叶杂质特征图矩阵按照宽高方向进行一次全局平均池化(AvgPool)和全局最大池化(MaxPool),输出2个与通道数相等、大小为1×1的池化层。然后将2个池化层输入多层感知机(Multilayer Perceptron,MLP)分别通过两次共享全连接层,最后将输出的2个通道权重层融合后进行非线性激活,得到充分权衡通道维度上的权重层M,计算式如下:

M=Sigmoid(MLP(AvgPool())+MLP(MaxPool()))(1)

将M权重参数与输入的茶叶杂质特征图矩阵在通道上相乘,实现在通道上施加注意力机制,大幅提升特征图通道维度的关键特征利用率。

空间注意力模块对上述通道注意力模块提炼的茶叶杂质特征图矩阵′通道维度上分别进行最大池化和平均池化,获得2个通道数为1、尺寸为′大小的池化层后进行堆叠,利用一次卷积降维至单通道特征图,最后经过非线性激活,增加非线性因素,得到充分权衡空间维度上的权重层M,计算式如下:

M=Sigmoid(7×7(Concat(AvgPool(),(MaxPool())))(2)

式中7×7表示滤波器尺寸为 7×7 的卷积运算。

将M权重参数与′逐像素相乘,实现在空间维度上施加注意力机制,以提升特征图空间维度的关键特征利用率。因此,将CBAM模块引入YOLOv5主干网络中能够提升茶叶杂质特征信息的关注度。

1.3 YOLOv5主干网络改进策略

为验证YOLOv5引入注意力机制对茶叶杂质检测性能的影响,在主干网络的CSP1_1、CSP1_3与CSP2_1 3个跨阶段局部网络(Cross Stage Partial Network,CSPNet)模块后分别添加CBAM注意力机制。通过将原图输入不同策略下改进主干网络的最终预测结果图,采用热力图可视化[24]的方式,直观展示网络更加关注的区域。图1对比了常规YOLOv5和3种改进策略的热力图,其中区域颜色越深代表网络越感兴趣。

从图1中可看出,主干网络中引入注意力机制有助于茶叶杂质特征提取效果,且引入3个注意力机制CBAM的改进策略关注的特征区域最为准确。

1.4 目标检测评价指标

目标检测指标通常有以下4种:

1)单类别精确率:

2)单类别召回率:

3)单类别曲线下面积:

AP=(,)(5)

4)多类别平均精度:

式中P表示精确率;R表示召回率;Tc表示当前茶叶杂质种类被预测正确的数量;FC表示其他茶叶杂质种类但被预测为当前茶叶杂质种类的数量;FN表示当前茶叶杂质种类被预测为其他茶叶杂质种类的数量;AP表示单类别检测结果,AP值越大,单类别检测性能越好;AP反映多类别检测精度;c表示所有类别数量。

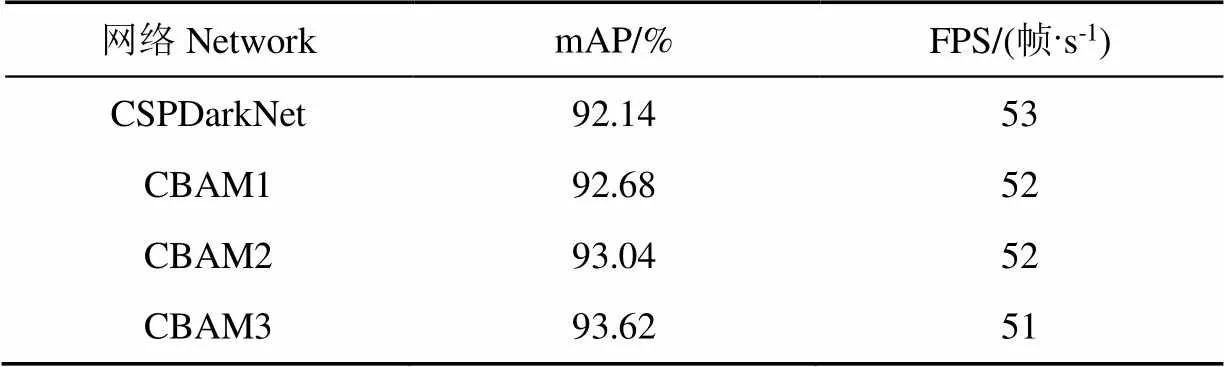

1.5 改进的主干网络测试

利用改进的主干网络策略,对茶叶杂质数据集进行试验,保持颈部网络(Feature Pyramid Network,FPN)和头部网络YoloHead不变,共训练500代数,试验结果如表2所示。

表2 不同策略试验结果

注:mAP为多类别平均精度,FPS为每秒传输帧数。下同。

Note: mAP refers to mean average precision of multiple categories, and FPS refers to frame per second. Same below.

从表2中可看出,检测精度随着引入CBAM模块数的增加而提高,加入1个CBAM、2个CBAM和3个CBAM的多类别平均精度mAP分别提升了0.54、0.9和1.48个百分点,优于常规YOLOv5,最终选取加入3个CBAM策略下的主干网络改进方法。但同时FPS略有降低,表明网络检测速度有所降低,需要进一步优化YOLOv5网络结构。

2 网络结构优化

2.1 优化方法

在常规YOLOv5的颈部网络(FPN)内添加空间金字塔池化(Spatial Pyramid Pool,SPP)模块[25],有助于聚合茶叶杂质的不同感受视野特征信息,提取多尺度的关键特征,提升网络的检测精度。因此,在不影响特征图上下采样和通道拼接的前提下,对颈部网络FPN中的每一个CSP模块后添加SPP模块。同时考虑到检测的实时性,对网络参数需要进一步优化,将FPN内的普通卷积Conv替换成深度可分离卷积Dwise[26],能够保证在精度不降低的前提下,大幅减少网络运算量,提升检测速度。

在改进主干网络加入3个CBAM策略基础上,改进并优化的网络整体结构如图2。

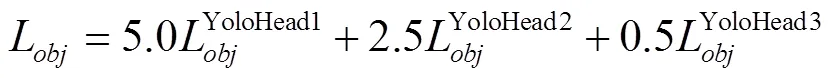

2.2 平衡不同尺度损失

YOLOv5的头部网络YoloHead共输出3个不同尺度大小的预测特征图,其中YoloHead1、YoloHead2和YoloHead3分别为80×80、40×40和20×20(像素)的特征图,对输入图像的感受野逐渐增大,分别用于预测小目标物体、中等目标物体和大目标物体。由于茶叶杂质均为小目标,增大YoloHead1的损失权重,能够提高YOLOv5检测小目标的精度。因此,经过训练试验,对3个预测特征图(YoloHead1、YoloHead2和YoloHead3)的置信度损失设置不同的权重,获得总置信度损失如下:

式中L为茶叶杂质检测网络的总置信度损失,其上标表示不同预测特征图。

3 茶叶杂质检测试验

3.1 茶叶杂质数据集制作

茶叶在采摘和炒制过程中通常会混有一些杂质,例如谷物、茶梗、树枝等,因此本次试验以市场购买的铁观音茶叶为研究对象,在茶叶中掺杂现实场景中容易混入稻谷、瓜子壳、竹枝和茶梗4种杂质,制作了具有杂质的茶叶杂质检测数据集。采用分辨率为150 dpi的超低畸变相机,拍摄了4×500共2 000张包含4种茶叶杂质的图像。通过水平镜像、上下翻转、亮度变换和随机对比度等数据增强方式将茶叶杂质数据集扩充至4 000张图像,按照8∶1∶1的比例随机划分训练集、验证集和测试集。利用Labelimg软件对其进行标注,生成杂质真实框坐标和种类信息的标签文件。

注:FPN为特征图金字塔网络结构;CBAM为前馈卷积注意力机制;SPP 为空间金字塔池化结构;CSP为跨阶段局部网络。

3.2 试验环境

试验环境配置:深度学习框架Pytorch-GPU V1.7.1,显卡Nvidia GeForce GTX 1660,显存6 GB,处理器Inter Core i7-9700k 3.60 GHz八核,内存16 GB,神经网络加速库CUDNN7.6.4和CUDA10.1,所用到的相关库Pillow8.0.1、Opencv4.4.0、numpy1.19.4和matplotlib3.3.3;操作系统为Windows10,编程语言为Python3.7;光照环境为1 000 lx光源;茶叶随机铺设一层。

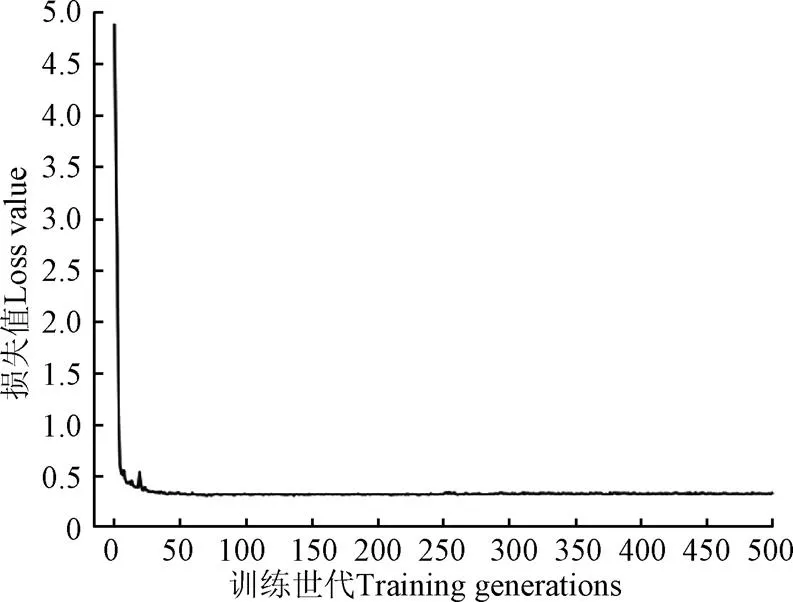

3.3 网络训练

将改进后的YOLOv5网络在图形处理器 (Graphics Processing Unit,GPU)上进行训练,采用随机梯度下降优化器(Stochastic Gradient Descent,SGD)更新参数,初始学习率设置成0.001,学习率衰减系数为0.000 1,批尺寸(Batch_size)为8,共训练500个世代,损失值变化如图3所示。从图3中可以看出,随着训练代数的增加,改进YOLOv5的损失值逐渐降低,整体趋于稳定,最终损失值收敛于0.3附近,证明改进的网络达到了较优的训练结果。

图3 损失值变化曲线

3.4 检测试验对比

将常规YOLOv5和改进的YOLOv5在测试集上进行试验对比,且保证光照环境相等,每种杂质采样1 000张图像,各自随机选择1张检测结果展示,如图4所示。其中,Ⅰ、Ⅱ、Ⅲ和Ⅳ分别代表茶叶中含有稻谷、瓜子壳、竹枝和茶梗杂质图像。

注:图中锚框代表检测出的杂质。

从图4可以看出,由于稻谷杂质目标较小,混入茶叶中不易发现,常规YOLOv5对于部分被遮挡的稻谷出现了漏检现象,而改进的YOLOv5只是置信度略有降低。对于有茶叶遮挡的竹枝,常规YOLOv5的置信度分数大大低于改进的YOLOv5。由于茶梗和茶叶特征相似,且颜色相近,常规YOLOv5中出现了漏检现象。从4种图像检测结果对比图中可看出,改进的YOLOv5相较于常规YOLOv5具有更高的置信度分数,且定位更为准确,没有出现漏检现象,尤其对于有遮挡情况的杂质表现更为明显。同时可以发现,目标检测杂质被遮挡部分越多,则检测的置信度值越低。

通过视觉检测的定性分析后,还需对YOLOv5改进的每个策略进行消融试验对比的定量分析,如表3所示。

表3 不同策略消融试验结果

注:方法1表示常规YOLOv5,方法2表示改进锚框尺寸,方法3表示改进锚框尺寸并引入注意力机制,方法4表示改进锚框尺寸、引入注意力机制并对网络整体结构进行改进,方法5表示改进锚框尺寸、引入注意力机制、改进网络整体结构和平衡不同尺度损失。

Notes: Method 1 represents Regular YOLOv5. Method 2 indicates improved anchor frame size. Method 3 means to improve the size of anchor frame and introduce attention mechanism. Method 4 means to improve the size of anchor frame, introduce attention mechanism and improve the overall network structure. Method 5 represents improving the size of anchor frame, introducing attention mechanism, improving the overall network structure and balancing losses of different scales.

从表3可知,方法2比方法1检测精度略有提升,表明利用K-means聚类得到的锚框尺寸更符合茶叶杂质数据集特征。方法3检测精度优于常规YOLOv5,但检测速度略有减慢,表明引入注意力机制有利于网络提取茶叶杂质的关键特征,但同时也增加了少量的模型复杂度。方法4的检测精度和速度都有一定提升,表明在FPN中添加空间金字塔池化(SPP)模块有助于提取多尺度的特征,检测精度得到提升,且深度可分离卷积的引入节省了网络运算量,实现网络轻量化,提升了检测速度。本文采用的方法5的mAP和FPS达到了96.05%和62帧/s,优于以上方法,针对稻谷和瓜子壳小目标的mAP得到较大提升,表明增大小目标损失权重,对于提高小目标检测精度有很大帮助。

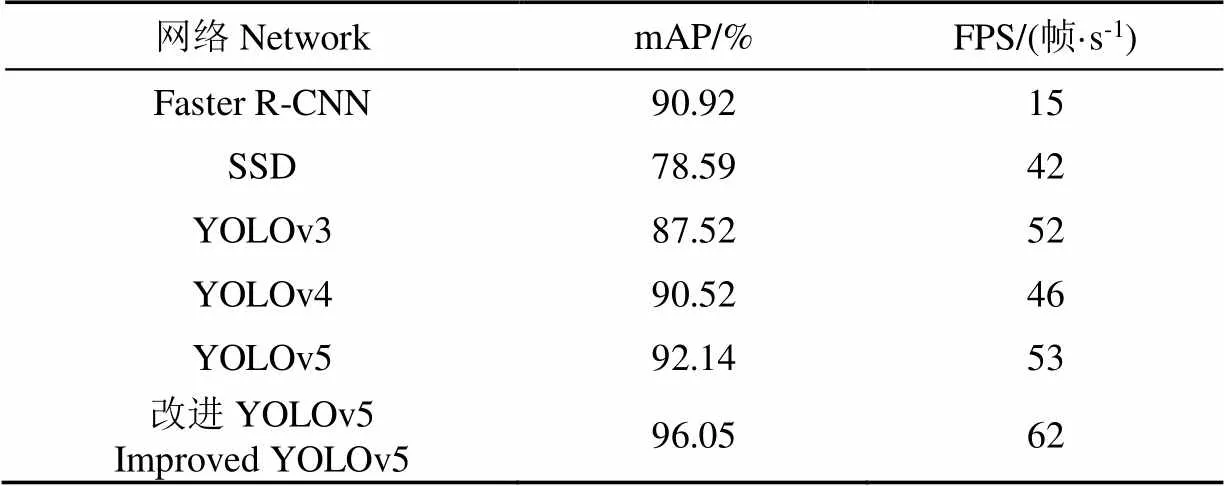

3.5 不同目标检测网络试验对比

选用Faster R-CNN、SSD、YOLOv3、YOLOv4、YOLOv5等主流目标检测网络和改进YOLOv5进行试验对比,结果如表4所示。

表4 不同网络试验结果

Table 5 Experimental results based on different network

可以看出,Faster R-CNN的检测精度较高,但其采用双阶段检测方式,结构复杂且网络参数多,检测速度最慢,无法满足实时性要求。SSD参数量较少,检测速度较快,但特征提取能力弱于YOLO系列算法,mAP最低。YOLOv3和YOLOv4检测效果都低于常规YOLOv5。改进后的YOLOv5相对于Faster R-CNN、SSD、YOLOv3、YOLOv4和常规YOLOv5检测精度和速度均最优。

4 结 论

以常规YOLOv5网络为基础进行改进,更高效地实现茶叶杂质检测。使用K-Means聚类获得适合茶叶杂质特征的锚框,引入注意力机制,提高主干网络特征提取能力,添加空间金字塔池化(Spatial Pyramid Pooling,SPP)模块,融合不同感受野多尺度特征,提升检测精度,采用深度可分离卷积降低网络复杂度,加快检测速度,平衡不同尺度损失,提高对小目标检测精度。通过定性和定量试验结果对比,验证了改进YOLOv5网络的有效性。改进YOLOv5的多类别平均精度mAP和每秒传输帧数(Frame Per Second,FPS)分别达到96.05%和62帧/s,满足茶叶杂质检测的需求,并且对小目标检测领域提供了一定的参考。

对于不同的背景、光照条件、茶叶平铺厚度以及图像分辨率等复杂条件对改进YOLOv5模型在茶叶杂质检测精度等方面产生的影响,仍需要进一步的研究与试验。

[1] 鹿瑶,王伟,钟斌,等. 融合光电色选的皮带筛式油茶果壳籽分选机设计与试验[J]. 农业机械学报,2020,51(S1):429-439.

Lu Yao, Wang Wei, Zhong Bin, et al. Design and experiment of belt screen seed sorter forfused with photoelectric color sorting technology[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(S1): 429-439. (in Chinese with English abstract)

[2] 李仿舟. 茶叶色选机的技术创新和发展趋势[J]. 农机质量与监督,2018,27(12):18-19.

[3] 丁勇,徐奕鼎,王烨军. 工夫红茶精制中色选技术应用研究[J]. 中国茶叶加工,2009,26(3):22-23,27.

[4] 黄留锁,宋艳. 茶叶茶梗的计算机在线识别技术及其应用[J]. 福建茶叶,2016,38(7):161-162.

[5] 陈培俊. 基于图像处理和模式分类的茶叶杂质识别研究[D]. 南京:南京航空航天大学,2014:1-2.

Chen Peijun. Research on Recognizing Tea-Leaves and Impurities Based on Image Processing and Pattern Classification[D]. Nanjing: Nanjing University of Aeronautics and Astronautics, 2014: 1-2. (in Chinese with English abstract)

[6] Cao S T, Jiang Y L. Combining attention mechanisms with RPN networks for target tracking[J]. International Core Journal of Engineering, 2021, 7(10): 438-443.

[7] Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Columbus, USA: IEEE, 2014: 580-587.

[8] Ren S, He K M, Girshick R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2017, 39(6): 1137-1149.

[9] 亢洁,刘港,郭国法. 基于多尺度融合模块和特征增强的杂草检测方法[J]. 农业机械学报,2022,53(4):254-260.

Kang Jie, Liu Gang, Guo Guofa. Weed detection based on multi-scale fusion module and feature enhancement[J]. Transactions of the Chinese Society for Agricultural Machinery, 2022, 53(4): 254-260. (in Chinese with English abstract)

[10] Liu W, Anguelov D, Erhan D, et al. SSD: Single shot multibox detector[C]//European Conference on Computer Vision, German: Springer, 2016: 21-37.

[11] Redmon J, Divvala S, Girshick R, et al. You only look once: unified, real-time object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition, Las Vegas, USA: IEEE, 2016: 779-788.

[12] 胡根生,吴继甜,鲍文霞,等. 基于改进YOLOv5网络的复杂背景图像中茶尺蠖检测[J]. 农业工程学报,2021,37(21):191-198.

Hu Gensheng, Wu Jitian, Bao Wenxia, et al. Detection of Ectropics oblique in complex background images using improved YOLOv5[J]. Trasnsations of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(21): 191-198. (in Chinese with English abstract)

[13] 尚钰莹,张倩如,宋怀波,等. 基于YOLOv5s的深度学习在自然场景苹果花朵检测中的应用[J]. 农业工程学报,2022,38(9):222-229.

Shang Yuying, Zhang Qianru, Song Huaibo. Application of deep learning using YOLOv5s to apple flower detection in natural scenes[J]. Trasnsations of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(9): 222-229. (in Chinese with English abstract)

[14] Bochkovskiy A, Wang C Y, Liao H Y M. YOLOv4: Optimal speed and accuracy of object detection[C]//IEEE Conference on Computer Vision and Pattern Recognition, Seattle, USA: IEEE, 2020: 1-17.

[15] 吕禾丰,陆华才. 基于YOLOv5算法的交通标志识别技术研究[J]. 电子测量与仪器学报,2021,35(10):137-144.

Lyu Hefeng, Lu Huacai. Research on traffic sign recognition technology based on YOLOv5 algorithm[J]. Journal of Electronic Measurement and Instrumentation, 2021, 35(10): 137-144. (in Chinese with English abstract)

[16] 吕军,方梦瑞,姚青,等. 基于区域亮度自适应校正的茶叶嫩芽检测模型[J]. 农业工程学报,2021,37(22):278-285.

Lyu Jun, Fang Mengrui, Yao Qing, et al. Detection model for tea buds based on region brightness adaptive correction[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(22): 278-285. (in Chinese with English abstract)

[17] Zhu X, Lyu S, Wang X, et al. TPH-YOLOv5: Improved YOLOv5 Based on Transformer prediction head for object detection on drone-captured scenarios[C]//Proceedings of the IEEE/CVF International Conference on Computer Vision, Montreal, Canada: IEEE, 2021: 2778-2788.

[18] 徐凤如,张昆明,张武,等. 一种基于改进YOLOv4算法的茶树芽叶采摘点识别及定位方法[J]. 复旦学报(自然科学版),2022,61(4):460-471.

Xu Fengru, Zhang Kunming, Zhang Wu, et al. Identification and localization method of tea bud leaf picking point based on improved YOLOv4 algorithm[J]. Journal of Fudan University (Natural Science), 2022, 61(4): 460-471. (in Chinese with English abstract)

[19] 彭成,张乔虹,唐朝晖,等 .基于 YOLOv5增强模型的口罩佩戴检测方法研究[J].计算机工程, 2022, 48 (4): 39-49.

Peng Cheng, Zhang Qiaohong, Tang Zhaohui, et al. Research on mask wearing detection method based on YOLOv5 enhancement model[J]. Computer Engineering, 2022, 48 (4): 39-49. (in Chinese with English abstract)

[20] 杨俊闯,赵超. K-Means聚类算法研究综述[J]. 计算机工程与应用,2019,55(23):7-14.

Yang Junchuang, Zhao Chao. Survey on K- Means clustering algorithm[J]. Computer Engineering and Applications, 2019, 55(23): 7-14. (in Chinese with English abstract)

[21] 安晓飞,王培,罗长海,等. 基于K-means聚类和分区寻优的秸秆覆盖率计算方法[J]. 农业机械学报,2021,52(10):84-89.

An Xiaofei, Wang Pei, Luo Changhai, et al. Corn straw coverage calculation algorithm based on K-means clustering and zoning optimization method[J]. Transactions of the Chinese Society for Agricultural Machinery, 2021, 52(10): 84-89. (in Chinese with English abstract)

[22] Darmawan E, Novantara P J, Suwarto G P, et al. The implementation of K-means algorithm to determine the quality of teak wood in image based on the texture[J]. Journal of Physics: Conference Series, 2021, 1933(1): 1-7.

[23] Woo S, Park J, Lee J Y, et al. CBAM: Convolutional block attention module[C]//Proceedings of the European Conference on Computer Vision, German: Springer, 2018: 3-19.

[24] Selvaraju R R, Cogswell M, Das A, et al. Grad-cam: Visual explanations from deep networks via gradient-based localization[C]//IEEE International Conference on Computer Vision, Venice, Italy: IEEE, 2017: 618-626.

[25] He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[26] Chollet F. Xception: Deep learning with depthwise separable convolutions[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition, Honolulu, USA: IEEE, 2017: 1251-1258.

Detecting the impurities in tea using an improved YOLOv5 model

Huang Shaohua, Liang Xifeng※

(&,,310018,)

Tea sorting has been one of the most important links in tea production. Manual sorting has been often adopted to remove the excess impurities (such as branches and grains) from the collected fresh tea in traditional processing. However, the current sorting cannot fully meet the high requirement of taste and quality in the finished tea products after collection in recent years, due to the labor-intensive and high cost. Fortunately, machine vision has been gradually applied to tea impurity sorting, particularly for fully automatic sorting in the process of tea collection. Among them, the single-stage lightweight network (represented by YOLOv5 deep learning) can perform better performance for small targets with high detection speed and accuracy. However, the conventional YOLOv5 network cannot be used to extract the characteristics of tea impurities, due to the disorderly clusters, the generally small targets, the complex types of impurities, and the similar color to the tea. Particularly, the overlapping small targets can cause an inaccurate prediction box, leading to low accuracy or miss detection of the tea impurities. It is necessary to improve the conventional YOLOv5 network to meet the requirements of tea impurity detection. In this study, an improved YOLOv5 model was proposed to detect the tea impurity with a higher accuracy and detection speed than before. The YOLOv5 was taken as the baseline network. The K-Means clustering was applied to cluster the real boxes of impurities as the anchor frame size suitable for the characteristics of tea impurities. Convolutional Block Attention Module (CBAM) was introduced into the backbone feature extraction network (CSPDarkNet). The key features were obtained using the channel and spatial dimension of feature images. A Spatial Pyramid Pooling (SPP) module was added to the neck network, in order to integrate and extract the multi-scale features of different sensory fields. The deep separable convolution was updated to reduce the number of network parameters for the higher detection speed. The confidence loss weight of the small target prediction in the feature map was improved for the higher detection accuracy of the network for the small targets. The data set was taken as the Tieguanyin tea mixed with the rice, melon seed shell, bamboo branches, and tea stems. The results show that the improved YOLOv5 presented a higher confidence score than the conventional one, where the positioning was much more accurate without missing detection. The mAP and FPS of improved YOLOv5 reached 96.05% and 62 frames/s, respectively. The higher efficiency and robustness of the improved model were achieved to compare the mainstream target detections. The findings can provide a strong reference for the detection accuracy and speed of small target impurities in the tea production process.

deep learning; algorithm; object detection; YOLOv5; tea impurities

10.11975/j.issn.1002-6819.2022.17.036

TP391

A

1002-6819(2022)-17-0329-08

黄少华,梁喜凤. 基于改进YOLOv5的茶叶杂质检测算法[J]. 农业工程学报,2022,38(17):329-336.doi:10.11975/j.issn.1002-6819.2022.17.036 http://www.tcsae.org

Huang Shaohua, Liang Xifeng. Detecting the impurities in tea using an improved YOLOv5 model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2022, 38(17): 329-336. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2022.17.036 http://www.tcsae.org

2022-06-18

2022-08-27

国家自然科学基金项目(31971796)作者简介:黄少华,研究方向为农业智能信息处理。

梁喜凤,教授,研究方向为农业机器人、农业智能信息处理等。Email:lxfcjlu@cjlu.edu.cn