面向可见光—近红外图像融合的植被与天空概率模板生成

童璨,应佳成,沈会良

浙江大学信息与电子工程学院,杭州 310027

0 引 言

可见光(visible,VIS/RGB)图像通常色彩鲜艳、细节清晰,而近红外(near-infrared,NIR)图像虽然清晰度较可见光图像低,但是在透雾和夜视等方面有着更为显著的效果。正因两者各自的优势,RGB-NIR图像联合处理在识别(Singh等,2008)、检测(Han和Bhanu,2007)和监控(Kumar等,2006)等诸多领域得以应用。以结合RGB和NIR图像的优点为目的,图像融合是一种常见而有效的处理方法。例如,Schaul等人(2009)通过多分辨率的图像融合对带雾图像进行去雾;Awad等人(2020)通过图像融合将NIR的细节信息加入RGB图像,实现了细节增强;Süsstrunk等人(2010)通过图像融合实现人脸皮肤的图像质量提升,达到了美颜的效果。

考虑实际的图像融合过程,可能需要根据不同目的对不同图像区域进行差异化处理,以达到更好的效果。例如,在自然场景的图像融合中,需要避免植被因融合而亮度过高,也要避免天空因融合而亮度过低,使图像整体保持良好的自然度。因此,为实现基于区域的融合效果改进,本文提出一种快速鲁棒的RGB-NIR联合图像植被与天空概率模板生成算法。

从研究现状来看,植被检测大多涉及卫星遥感领域,在图像处理上的研究和应用较为欠缺。Fan等人(2016)提出一种适用于高分辨率多光谱卫星图像的植被覆盖检测方法,该方法包括两个阶段,第1阶段采用支持向量回归技术,对每个斑块进行评分,生成粗糙的斑块级植被图;第2阶段进行无监督的像素级植被分类对不确定像素进行重新评分,得到更详细的植被图。在图像处理领域,Li等人(2020)根据RGB-NIR图像光谱差异,使用归一化植被指数(normalized difference vegetation index, NDVI)(Kriegler等,1969)及其延伸计算用于图像融合的权重矩阵,实现了效果良好的RGB-NIR图像融合增强。然而,将NDVI直接用于植被检测效果不佳,原因是NDVI生成结果的对比度不高,且使用单个通道与NIR图像进行差异计算容易受极亮值或极暗值的影响。

天空检测方面的研究则相对更多,一般而言其检测结果可分为二值模板和概率模板。二值模板因其强边界而要求检测方法更加精确,而概率模板则保留图像的大量纹理信息,应用更加灵活。Zafarifar和de With (2008)为了增强视频,提出了一种基于颜色分布模型、局部亮度差异、局部梯度以及像素高度模型的天空检测方法,该方法生成天空的概率模板,得到了较为准确的天空检测结果,但是在边缘过渡及图像整体连续性等方面还有待提高。Salazar-Colores等人(2020)基于暗通道先验(He等,2011)和局部香农熵检测天空区域,生成天空的二值模板,然后用检测到的天空改进大气光图与透射率图,以缓解去雾过程中天空区域的过饱和现象,但是该方法的天空检测容易受到云层的影响而产生杂乱的边缘。

基于深度学习的图像语义分割目前应用较为广泛,且效果较好,分割出的植被、天空语义在一定程度上实现了植被与天空区域的检测。例如张桂梅等人(2020)用生成对抗网络与自适应的学习率进行对抗学习,分割结果包含植被和天空语义,可视为一种类二值模板的区域检测结果。然而,语义分割着眼整体,在边界、缝隙等细节处划分较为粗糙,并且语义分割一般生成二值模板,难以保留图像的纹理信息。

综合考虑现有植被、天空检测的研究,一方面,部分检测算法准确率和召回率不是很高,而部分高精度的算法需要较为复杂的计算或模型训练过程;另一方面,目前的植被、天空检测大多基于单幅RGB图像进行。因此,本文试图提出一种更适用于RGB-NIR联合图像处理并且准确鲁棒的检测算法,以应用于图像融合等具体场景。

RGB-NIR图像融合发展迅速,主要有基于权重矩阵(Li 等,2020)、多尺度变换(Yu 等,2014)、稀疏表示(Wang 等,2014)和神经网络(Xiang等,2015)等理论的实现方式。Awad等人(2020)利用RGB和NIR图像局部对比度的相对差异估计融合图,并从NIR图像中提取非光谱空间细节对融合图进行增强。Connah等人(2014)提出一种梯度域的融合算法,以输入图像的梯度和颜色为约束进行迭代优化,获得了更好的融合结果。Vanmali和Gadre(2017)提出一种多尺度RGB-NIR图像融合算法,采用基于Laplacian-Gaussian金字塔的多分辨率融合过程,以局部熵、局部对比度和可见度作为衡量融合结果的指标来生成权重图。

尽管现有的图像融合算法大多数情况下效果良好,但也存在一些不足。例如,部分算法的融合结果中,植被因受NIR图像影响而亮度过高,天空则因受NIR图像影响而较为昏暗。本文图像融合主要针对现有算法进行基于区域的修正,以使植被、天空获得更为自然和谐的视觉效果。

总体而言,本文着眼于RGB-NIR图像融合,针对实际处理过程中图像的不同区域可能需要进行差异化修正的需求,设计行之有效的检测算法,并以检测结果作为反馈,对图像融合的植被和天空进行修正,达到改进的目的。在流程上,首先根据RGB与NIR图像的光谱差异,以及RGB图像各通道间的亮度差异,提出植被检测的概率模板生成算法。然后引入图像的局部熵特征,以透射率图为引导,以像素高度为修正,提出天空检测的概率模板生成算法。本文算法生成了像素级的概率模板,即预测了每一个像素属于目标的概率。之后,将植被与天空的检测结果应用于现有的图像融合算法,以针对性地提升图像特定区域的融合效果。最后,进行对比实验,验证了本文算法的有效性与鲁棒性。

本文主要贡献点在于:1)提出一种基于RGB图像各通道比值和扩展归一化植被指数(NDVI)的RGB-NIR联合图像植被概率模板生成算法;2)提出了一种基于透射率图引导的局部熵特征和扩展NDVI的RGB-NIR联合图像天空概率模板生成算法;3)将植被和天空检测结果(概率模板)引入图像融合算法,改进了感兴趣区域的图像融合效果,验证了本文提出的检测算法及其结果可使图像融合根据实际需求进行灵活调整,实现了融合效果的提升。

1 本文算法

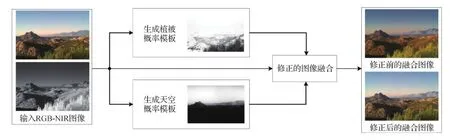

本文算法整体框架如图1所示。首先根据RGB与NIR图像的特征,分别生成植被和天空的概率模板,然后将模板用于修正具体的图像融合算法,以此提升植被与天空的图像融合效果。

图1 本文提出的植被与天空概率模板生成算法及其应用的整体框架Fig.1 Framework of the proposed algorithm for vegetation and sky probability maps generation and its application

1.1 植被检测

本文提出的植被检测算法中,使用了NDVI与比值两种特征,二者分别基于以下先验知识:1)植被区在NIR图像中的亮度大于在RGB图像中的亮度。因为植被对红色通道与蓝色通道吸收较强,对近红外与绿色通道反射较强,采集NIR图像时可以捕获更多光,因此植被在NIR图像中亮度更高。2)植被通常呈现绿色,所以其在RGB三通道的分布更多地集中在G通道,在R和B通道相对较少。

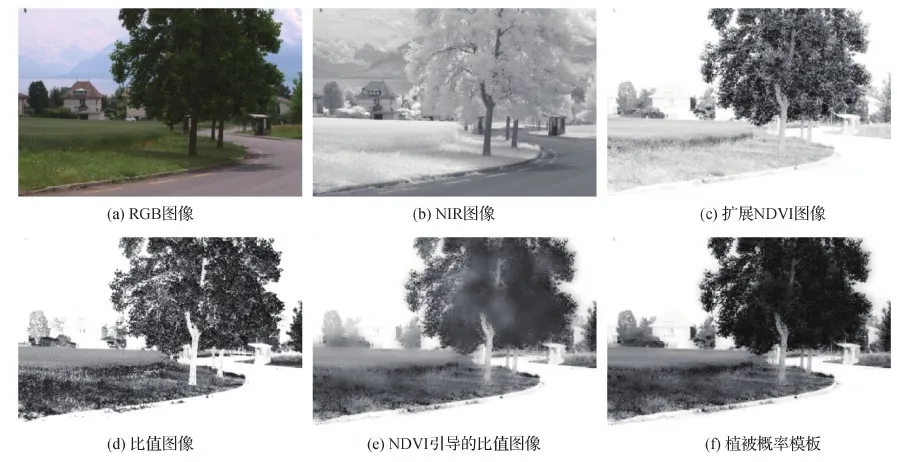

根据上述两项先验,设计了植被概率模板生成流程,如图2所示。

首先,计算RGB图像的灰度图Ig,即

Ig=0.299IR+0.587IG+0.114IB

(1)

式中,IR、IG和IB分别表示RGB图像各通道分量。

其次,根据RGB图像的灰度图和NIR图像计算扩展NDVI。NDVI(Kriegler等,1969)反映RGB图像的R分量与NIR之间的相对关系,主要用以衡量植被的健康状况,计算为

(2)

式中,INIR表示原始NIR图像。

受此启发,本文将亮度关系延伸到可见光全部三通道与近红外之间,用以避免单个通道的灰度为极亮或极暗情况下导致的检测不准确,扩展NDVI定义为

(3)

式中,fn(·)为归一化函数,fb(·)为非线性变换函数,作用是压缩亮区,拉伸暗区,以提升对比度。

fn(·)和fb(·)定义为

(4)

(5)

本文参数取α=10,β=0.5,γ=0.22。扩展NDVI的最终结果如图3(c)所示。

然后,根据上述先验知识2),计算RGB图像三通道比值的模板,具体为

(6)

式中,fd(·)为与fb(·)相关的非线性变换函数,作用是压缩暗区、拉伸亮区。具体为

fd(x)=1-fb(1-x)

(7)

RGB三通道比值的模板如图3(d)所示。观察图3(c)(d)可知,NDVI图对比度较比值图低,但是整体连续性好,有更丰富的细节,比值图则相反。因此,使用NDVI图为引导,对比值图做导向滤波。即

(8)

式中,Fguid表示导向滤波,r为滤波窗口大小,ε为平滑参数,本文取r=32,ε=10-6。导向滤波结果如图3(e)所示,滤波之后的比值模板在保持较高对比度的同时也能提升整体图像的连续性。

最终,将扩展NDVI模板与比值模板进行融合,即

(9)

融合生成的植被概率模板如图3(f)所示。

图3 植被概率模板生成过程展示Fig.3 Illustration of the vegetation probability mask generation process ((a) RGB image; (b) NIR image; (c) extended NDVI image; (d) ratio image; (e) NDVI-guided ratio image; (f) vegetation probability mask)

1.2 天空检测

本文提出的天空检测算法中,使用了NDVI、局部熵和像素高度3种特征,分别基于以下先验知识:1)天空区域在NIR图像中的亮度小于RGB图像中的亮度。因为天空对RGB三通道均呈较强的反射,使得最终采集的RGB图像捕光更多,对比NIR图像亮度更高。2)天空区域的局部熵为较小值。因为天空区域通常平坦而均匀,一定范围内变化不大,因此具有较小的局部熵。3)一幅图像天空有更大的概率出现在顶端,而出现在下部或底端的概率较小。

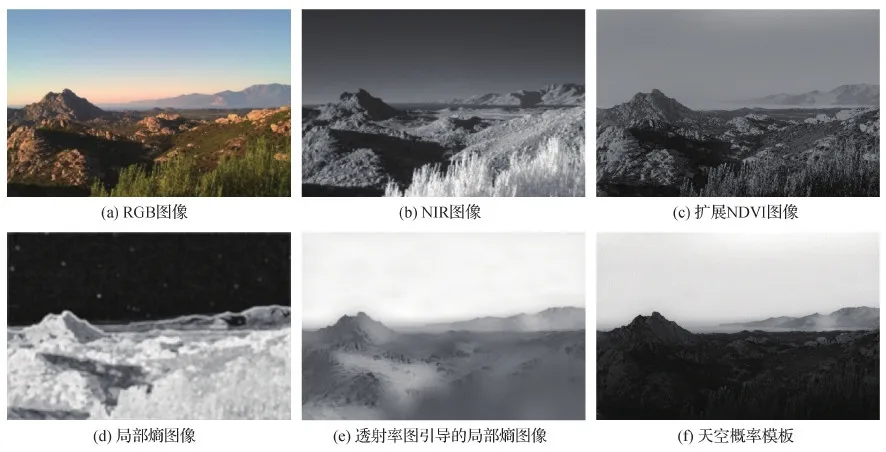

根据上述3项先验,设计了天空概率模板生成流程,如图4所示。

首先,根据式(1)计算RGB图像的灰度图Ig。

与植被检测有所区别,在天空检测中,因为天空更容易受到光照的影响,所以先对RGB和NIR图像进行Retinex增强的预处理。Retinex算法原理是将一幅图像I(x)分解为光照分量L(x)与反射分量R(x)的乘积,即

Ic(x)=Rc(x)Lc(x),c∈{R,G,B,NIR}

(10)

上述光照分量即自然的光线,反射分量则是物体真实的样貌,光线在物体表面发生反射后,两种分量相耦合。为了获得图像的反射分量,需要对光照分量进行估计,一般可以用原始RGB图像的高斯滤波结果作为光照分量的近似,即

(11)

式中,FGauss表示高斯滤波器,本文采用频域高斯滤波;σ表示标准差,取σ=80。

为减少计算量,在对数域计算图像的反射分量,具体为

图4 天空概率模板生成算法流程图Fig.4 Flowchart of sky probability mask generation algorithm

log(Rc(x))=log(Ic(x))-log(Lc(x))

(12)

经过上述计算,获得RGB图像各通道及NIR图像的反射分量,如图5所示。

图5 Retinex算法生成的反射分量Fig.5 Reflectance components produced by the Retinex algorithm ((a) RGB image; (b) NIR image; (c) reflectance component of the NIR image; (d) reflectance component of the red channel; (e) reflectance component of the green channel; (f) reflectance component of the blue channel)

与植被检测类似,通过灰度图与NIR图像的亮度差异计算扩展NDVI模板。此处,灰度图由RGB三通道反射分量加权获得,即

Rg=0.299RR+0.587RG+0.114RB

(13)

(14)

生成的扩展NDVI模板如图6(c)所示。

根据先验知识2)计算天空检测的局部梯度特征。考虑用边缘来表征局部区域的均匀程度,天空通常具有较少的边缘,因此先用Sobel算子获取图像的边缘,即

(15)

式中,fx和fy分别代表水平和垂直方向的Sobel算子,*表示卷积操作。

因边缘密集处局部熵较大,边缘稀疏处局部熵较小,故在边缘图上计算局部熵,具体为

(16)

式中,L表示灰度级,本文取L=256,pi表示灰度值i出现在像素k处的窗口Ωk中的概率,本文窗口大小为7。局部熵模板如图6(d)所示,因为天空区域变化小,因此在局部熵图像中表现为趋向于0。

为了提升图6(d)局部熵的效果,使用Kim等人(2020)提出的透射率图ITM为引导,对局部熵图像做引导滤波,且根据常识性认知,对图像进行反处理,使天空为亮区,即

(17)

引导滤波后的局部熵图像如图6(e)所示。

根据先验知识3),利用像素高度模板对天空检测的结果进行修正,模板计算为

墙夼水库总库容 3.28亿 m3,兴利库容0.85亿 m3,死库容 0.11亿 m3,正常蓄水位98.50m。水库工程防洪标准按百年一遇设计,万年一遇校核。东、西库设计洪水位分别为103.02m、103.16m,校核洪水位分别为106.50 m、106.57m。东西两库共设东库溢洪闸1座,遭遇大洪水时,西库水位高于东库,洪水通过连通沟进入东库,由东库溢洪道泄出。

(18)

图6 天空概率模板生成过程展示Fig.6 Illustration of the sky mask generation process ((a) RGB image; (b) NIR image; (c) extended NDVI map; (d) local entropy map; (e) transmission-map-guided local entropy map; (f) sky probability mask)

式中,r表示像素所在行数,h表示图像总高度。

最终,融合扩展NDVI、局部熵和像素高度3种概率模板,具体为

(19)

融合生成的天空概率模板如图6(f)所示。

1.3 融合算法质量提升

本文提出的植被、天空检测算法在RGB-NIR图像联合处理方面有普适的应用价值,以一种具体的融合算法为例,加入植被、天空检测的概率模板以实现融合效果的提升。

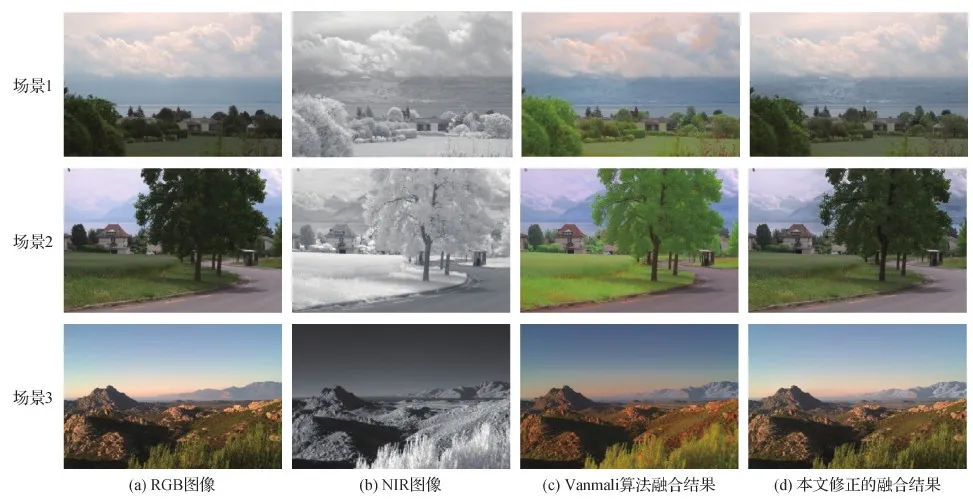

Vanmali和Gadre(2017)提出了一种基于Gaussian-Laplacian金字塔的图像融合算法,但是该算法的融合结果在色彩自然度上存在不足。例如在图7场景1的黄框中,云层出现一些原本不存在的颜色,而红框中植被亮度过大,导致视觉上非常不自然。同样在图7场景2和3中,植被也存在亮度过大的问题。且在图7场景3中,天空因受NIR图像影响过大,导致融合结果中天空较为昏暗。

为了生成颜色更自然的植被与天空,同时保持图像整体细节增强的效果,将本文提出的植被、天空检测的概率模板用于Vanmali和Gadre (2017)提出的图像融合算法。该算法采用加权融合方式,WV(x,y)和WNIR(x,y)分别表示RGB和NIR图像的融合权重。

将本文提出的概率模板加入到NIR图像的权重矩阵WNIR(x,y)中,以使目标区域的融合结果更偏向于RGB图像的颜色,即

(20)

再将融合算法的NIR图像权重替换为式(20)得到的结果,算法其余部分保持不变。

图7 Vanmali和Gadre(2017)提出的图像融合算法存在的不足Fig.7 Problems of Vanmali and Gadre’s(2017) algorithm ((a) RGB images; (b) NIR images; (c) fusion images)

2 实验与分析

2.1 数据集

算法测试采用Brown和Süsstrunk(2011)采集的RGB-NIR场景数据集。该数据集由9类477组RGB和NIR图像对组成。数据集中图像的9类标签分别是country、field、forest、indoor、mountain、old-building、street、urban和water,各类图像数据示例如图8所示。

2.2 植被检测结果与对比

对于植被检测,将本文算法与传统NDVI各自表现的植被概率模板进行对比,实验结果如图9所示。可以看出,受传统NDVI指标的启发,并考虑不足之处,通过改进并引入各通道比值提升了检测效果。

图8 数据集中9类场景图像示例Fig.8 Nine kinds of scene in the dataset

传统NDVI计算为

(21)

该NDVI在计算机视觉领域的植被检测中存在两个明显缺点。一是植被相对于背景对比度不高,如图9(c),植被不能有非常明显的区分;二是存在R通道极亮或极暗的情况,如图9(c)场景2,红框中的天空区域在原RGB图像中R通道值接近0,导致传统NDVI模板中该区域的概率值接近0,与实际不符合。本文算法在上述两个问题上有明显改善,从误检测的角度考虑,本文将传统的NDVI做了延伸,避免了单个通道为极亮或极暗的不利状况,如图9(e)场景2的红框显示该区域检测结果正确。从对比度的角度考虑,在NDVI的基础上引入RGB图像三通道比值,有效提升了植被检测的视觉效果,图9(e)相对于图9(c),在保证检测正确的前提下,对比度有了明显提升。

另外,深度学习在区域分割领域应用广泛且效果较好,本文选取其中一种语义分割方法进行对比,具体为基于ResNet101 + UperNet模型(Xiao等,2018)的语义分割(Zhou等,2019),对比结果如图9所示。分析图9中本文与语义分割的检测结果,本文方法在准确率和纹理细节保留上都占有较大优势。在图9(d)的场景1和场景2中,语义分割结果不能检测出全部植被,场景1中图像左侧远处的植被显示不完整,场景2中地面上较小的植被检测不到。相比而言,本文算法的植被检测更为准确。在细节层面,图9(e)的本文植被检测相对于图9(d)保留了更多的细节信息,特别是在树叶等纹理较多的区域。

图9 植被检测结果对比Fig.9 Comparison of vegetation detection results ((a) RGB images; (b) NIR images; (c) traditional NDVI; (d) semantic segmentation (e) ours)

2.3 天空检测结果与对比

现有天空检测算法的表现形式包括二值模板和概率模板,本文与两种形式的算法均进行对比。其中,Zafarifar和de With(2008)提出的天空检测算法结果为概率模板,形式与本文一致,与其对比更能反映优劣。Salazar-Colores等人(2020)提出的天空检测算法生成二值模板,因生成的天空模板用于优化后续天空区域的去雾,而本文则将模板用于后续图像融合,两者都是作为预处理手段,在目的上有共通之处,故进行天空检测效果的对比。最后,将本文天空检测与基于ResNet101+ UperNet模型(Xiao等,2018)的语义分割(Zhou等,2019)进行对比。

本文天空检测算法与Zafarifar和de With(2008)提出的算法对比的图像结果如图10所示。观察对比图像,在图10场景1中,结果差距主要体现在地平线处,本文算法在地平线处有更精确清晰的划分,同时对远处山脉的检测结果也更加准确。在图10场景2中,天空区域及边缘结果相差不大,但是在非天空区域中,Zafarifar算法(Zafarifar和de With,2008)将白色墙体检测为天空,而本文算法不存在这个问题。在图10场景3中,本文算法在远处山与天空交界处的边缘更加清晰,并且在与天空颜色相近的水面等位置的检测更为准确。

图10 本文算法与Zafarifar算法的天空检测结果对比Fig.10 Comparison of sky detection results by our algorithm and Zafarifar’s algorithm ((a) RGB images; (b) NIR images; (c) Zafarifar’s algorithm; (d) ours)

Salazar-Colores算法(Salazer-Colores等,2020)与基于ResNet101+UperNet模型(Xiao等,2018)的语义分割(Zhou等,2019)最终结果的表现形式都是二值模板,本文算法与这两种算法的对比结果如图11所示。

图11 本文算法与Salazar-Colores算法及语义分割的天空检测结果对比Fig.11 Comparison of sky detection results by our algorithm, Salazar-Colores’ algorithm and semantic segmentation((a) RGB images; (b) NIR images; (c) Salazar-Colores’ algorithm; (d) semantic segmentation; (e) ours)

分析图11中各算法的结果,在通常情况下,本文算法与两种对比算法的结果类似图11场景1,即在边界区分上效果相近,但是本文算法能够保留更多纹理细节信息,一定程度上可以防止细节的减弱,因此实际使用更加灵活可靠。对于图11场景2,Salazar-Colores算法(Salazar-Colores等,2020)与语义分割(Zhou等,2019)虽然能较为准确地检测到天空,但是对红框中植物间隙中的部分则不能细致地划分,二值模板一个共通问题在于不能很好地处理细节。在图11场景3中,当天空的云层较多时,Salazar-Colores算法易受云层影响,产生如红框中杂乱的边缘,使结果准确度下降,本文算法的结果则不存在这种问题。从图11场景4可以看出,Salazar-Colores算法与语义分割(Zhou等,2019)对一些小目标不能正确检测,原图中红框内的鸟在图11(c) (d)中完全消失,而在本文算法图11(e)中则较好地保留。

2.4 图像融合结果与对比

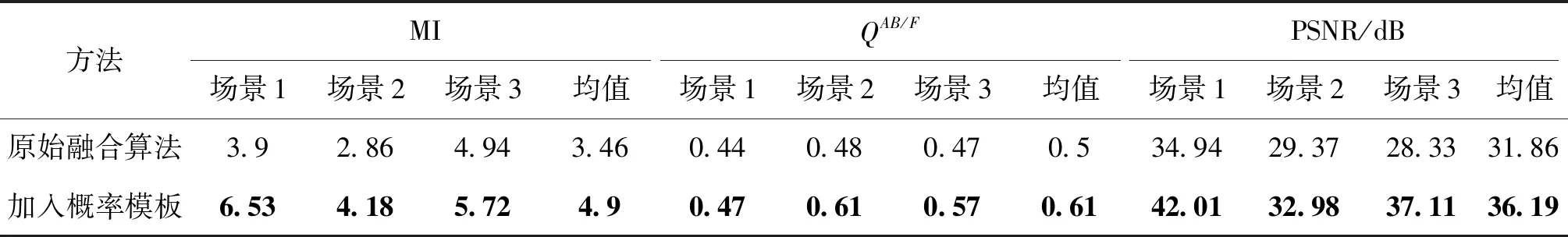

作为植被、天空检测的一个应用,本文将生成的概率模板应用于RGB-NIR图像融合算法:Vanmali算法(Vanmali和Gadre,2017),以实现目标区域视觉效果的提升。图12展示了引入概率模板前后融合效果的对比。

在图12(c)的3个场景中,原始融合算法的植被均会出现颜色过饱和情况,导致植被在视觉上呈现不自然,引入植被概率模板后,在保持融合细节增强的同时,融合结果相对原RGB图像色彩也有所增强,但是又不会出现失真状况。对于天空区域,场景1中云层出现原本不存在的颜色,场景3中融合结果受NIR图像影响过大导致天空颜色较为昏暗,在加入天空概率模板后,既保留了整体融合结果细节的增强,又确保了天空区域在视觉上真实自然。

图12 图像融合结果对比Fig.12 Comparison of image fusion results ((a) RGB images; (b) NIR images; (c) Vanmali’s algorithm; (d) our modified fusion results)

表1 使用概率模板前后融合算法的定量指标对比Table 1 Quantitative metrics of image fusion with and without probability mask

更进一步,为了比较概率模板与二值模板应用于图像融合算法的差异,实验将语义分割(Zhou等,2019)得到的二值模板同样以式(20)来修正Vanmali图像融合算法,对比结果如图13所示。在场景1中,天空中的纹理信息几乎都在NIR图像中,原始算法融合后的细节(图13(c))提升不多,且加入二值模板后的效果(图13(d))几乎不变。而使用本文算法生成的概率模板后的效果(图13(e))则保留了NIR图像中大部分的纹理信息,对于图像融合效果的提升作用更大。在场景2中,两种模板的差异体现在远方的山,此处局部放大图像如图14所示。可以看出,本文的概率模板在此处颜色鲜艳,细节清晰,具有更好的视觉效果。

图13 不同模板修正的图像融合效果对比Fig.13 Comparison of image fusion results with modification by different masks ((a) RGB images; (b) NIR images; (c) original fusion results; (d) modification by binary mask; (e) modification by probability mask)

图14 图13(d)场景2和图13(e)场景2的局部放大图Fig.14 Partial enlarged view of the scene 2 in Fig.13(d) and Fig.13(e) ((a) Fig.13(d); (b) Fig.13(e))

3 结 论

本文考虑RGB-NIR联合图像的不同区域成像特性各异,在实际图像处理过程中可能需要差异化处理,因此以显著性较明显的植被和天空作为感兴趣区域,提出了一种以扩展NDVI引导RGB图像各通道比值的植被概率模板生成算法,以及一种以透射率图引导局部熵图,并与扩展NDVI和像素高度相结合的天空概率模板生成算法。

在RGB-NIR图像数据集上测试,本文算法对植被和天空的检测结果准确无误,且细节清晰、过渡平滑。与现有算法对比,本文植被概率模板的优势在于对比度较高,误检测情况少,并且保留更多的纹理细节信息。本文天空概率模板的优势在于边界更精准,在小物体与间隙等细节处有更好表现。最后与基于深度学习的语义分割相比,本文植被与天空概率模板生成算法更专注,因而划分更准确,且不需要复杂的学习过程,应用更为方便灵活。

将本文的植被、天空的概率模板应用于图像融合以修正融合的权重,与原图相比,结果既保留了图像细节增强的效果,又避免了融合导致的颜色失真,使融合的整体视觉效果得以提升,这种图像质量的提升也通过互信息、边缘情况、峰值信噪比等定量指标进一步得到验证。

本文生成植被与天空概率模板的算法一般更适用于自然场景,应用于城市场景图像有时会出现检测结果错误的情况,例如大区域的白色墙体,图像过曝等因素都可能导致准确率下降。对此,今后拟从两方面开展进一步研究。1)进一步提升算法的鲁棒性,使算法面对上述不利因素仍能保持很好的检测效果;2)探索本文算法在RGB-NIR图像联合处理中更深入的发展与应用。