融合多尺度特征的多监督人脸活体检测算法

陈苏阳,宋晓宁

(江南大学人工智能与计算机学院,江苏无锡 214122)

0 概述

近年来,人脸识别系统因其低成本、易安装等优点,被广泛应用于交通、监控等领域。然而,人脸识别系统存在一定漏洞,攻击者可以利用合法用户的人脸信息进行系统攻击,这对用户的权益造成极大的危害。常用的欺诈攻击手段包括照片、视频和3D Mask 攻击。为了解决这一问题,越来越多的研究人员开始关注人脸活体检测技术[1]。

人脸活体检测是一种识别镜头前人脸是真实的人脸,还是由照片或电子屏幕等设备处理后的欺诈人脸的技术。针对多变的欺诈方式,目前主流的检测方法可以分为传统机器学习和深度神经网络。传统方法侧重于探索活体与欺诈人脸之间如颜色失真、非刚性变形和莫尔图案等纹理差异,然后通过机器学习算法将活体检测转变为二分类问题。但由于手工设计的特征描述算子只能提取低层信息,因此在复杂场景下模型的泛化能力较弱。

随着深度学习的进一步发展,研究人员开始尝试使用神经网络进行人脸活体检测。文献[2]使用金字塔LK 光流和卷积神经网络来区分真实人脸和欺诈人脸。为了提升网络模型的泛化能力,文献[3]提出将人脸深度图作为区分活体与非活体标准的方法,将真实人脸和欺诈人脸描述为三维深度图像和平面图像。文献[4]将欺诈人脸逆分解为欺诈噪声和真实人脸,然后利用欺诈噪声进行活体分类。文献[5-6]运用多帧图像作为网络的输入来提取时间信息,学习人脸图像中含有的时间特征、颜色特征等多维度信息,提升活体检测性能。但是目前的深度学习算法大多注重于神经网络模型的优化,而忽略了传统特征描述算子在特征抽取上的有效性。同时,现有的活体检测模型普遍具有庞大的计算量,当以多帧图像作为输入来提取时序信息时,往往需要更优良的设备,检测活体的时间复杂度也相应增加。

为了减少模型的参数量,充分发挥传统特征描述算子的优势,本文提出一种融合梯度纹理和群感受野特征的轻量网络。对于输入的RGB 图像,通过梯度纹理分支对图像的梯度信息进行抽取,使用群感受野分支获得多尺度空间和语义特征,并将其拼接融合,使得网络学习到更加丰富的特征。此外,为提升活体检测的鲁棒性,本文使用深度图和二值掩模的多监督策略,将深度图生成器和掩模生成器得到的预测结果进行相加,若预测分数高于阈值,则检测为活体,否则为非活体。最后在公开人脸活体数据集OULU-NPU、CASIA-MFSD 和Replay-Attack 上对本文算法的准确性和有效性进行验证。

1 相关工作

卷积神经网络作为深度学习的主流方法,其利用卷积强大的特征提取能力,在计算机视觉领域得到广泛的应用。卷积的作用在于提取图像特征,由卷积核实现卷积过程。卷积核的个数决定卷积操作后特征图的维度,卷积核的大小决定特征感受野的大小,卷积核内每个位置都有对应的参数和偏差量。在进行卷积操作时,卷积核会有规律地扫描特征图,并对卷积核对应的特征做矩阵乘法求和并叠加偏差量。以二维卷积核为例,卷积核w在输入特征图x上采样感受野区域R,进行矩阵运算,输出的特征y可以表示为:

其中:p0表示输入和输出特征图的当前位置;pn表示感受野R上的各个位置。

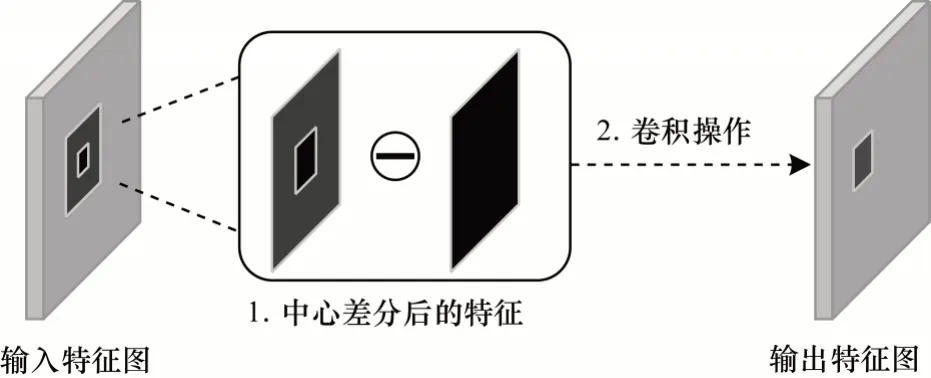

传统的卷积核参数由神经网络计算的代价函数误差进行反向传播而更新得到,但是这种随机性的参数会导致卷积的细节特征提取能力不足。为了提升卷积神经网络的细节表征能力,文献[7]提出了中心差分卷积(Central Difference Convolution,CDC)。中心差分卷积结构如图1 所示,中心差分卷积的扫描过程与标准卷积相同,不同点在于矩阵运算过程中多了感受野周围点对中心点的差值运算,这样卷积操作可以更加专注于提取感受野的中心梯度信息。

图1 中心差分卷积结构Fig.1 Central difference convolution structure

CDC 计算公式表示为:

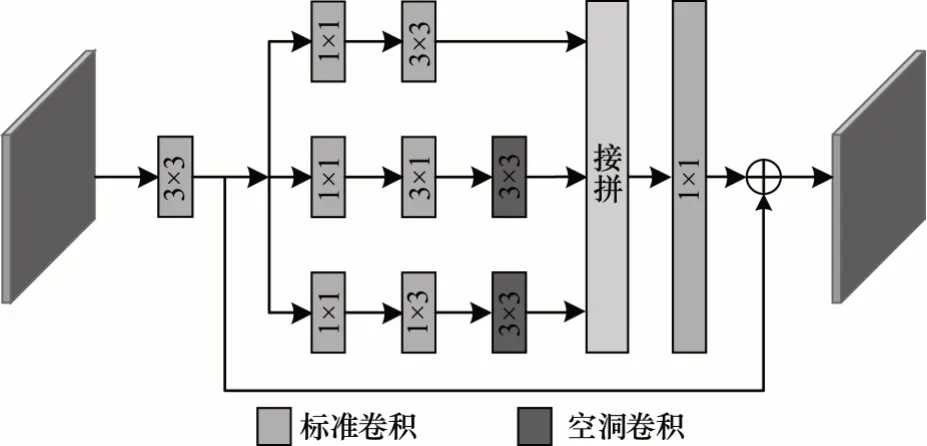

图像的纹理信息、空间和语义信息对于人脸活体检测任务来说都十分重要,所以文献[7]将中心差分卷积与标准卷积结合起来,采用直接相加的方式使卷积具有更好的特征提取能力。修改后的混合卷积计算公式可以表示为:

其中:超参数θ∈[0,1]代表标准卷积和中心差分卷积的贡献权重,θ值越大,表示混合卷积提取的中心差分梯度信息的占比越大。

2 多监督多尺度特征提取算法

2.1 网络结构

目前人脸活体检测多是基于深度学习算法,为了避免网络过拟合,许多工作从模型结构、监督标签和卷积核设计等方面切入提升检测效果。本文结合已有方案,从抽取图像特征和监督方式角度出发,提出多监督特征提取网络(Multi-supervision Feature Extraction Network,MFEN)。

针对标准卷积提取的感受野及纹理信息有限而多尺度信息对活体检测任务十分重要的问题,本文设计多尺度特征融合模块(Multi-scale Feature Fusion Module,MFFM),使用中心差分卷积与群感受野分支提取多维特征,并对其编码融合。该模块使得网络可以在使用较少参数量且特征图大小不变的情况下增加感受野,获得不同尺度的空间和语义信息。之后使用残差结构替代主流的“DepthNet[3]”,减少参数量并提升计算速度。为了提高模型的鲁棒性,使得模型提取到更多人脸深度特征,本文在使用深度图监督的同时,通过二值掩模进行辅助监督。整体网络结构如图2 所示,其中,残差部分的实线代表前后通道数相同,进行直连,虚线代表前后通道数不同,需要1×1 卷积调整维度。

图2 多监督特征提取网络结构Fig.2 Multi-supervision feature extraction network structure

MFEN 框架由多尺度特征融合模块、残差结构和生成器这三部分组成。网络输入的图像尺寸为256×256×3,包含RGB 这3 个通道。MFFM 对图像进行特征提取,该模块主要分为梯度纹理分支和群感受野分支,然后将两个分支的输出进行拼接,得到尺寸为128×128×64 的多尺度特征。残差结构主要对特征进行深层语义学习和编码。在本文中,该部分由4 个残差块构成,每个残差块使用尺寸为3×3 的标准卷积,通过批归一化层加速网络训练,得到尺寸为32×32×128 的特征图。最终,结果输入深度图生成器与掩模生成器,得到两个尺寸为32×32×1 的特征图。综合判断生成的深度图与掩模图,计算得出预测概率,实现端到端的人脸活体检测。

2.2 多尺度特征融合模块

特征提取一直是人脸活体检测的重点研究方向,特征的好坏在一定程度上决定了网络的性能。为了从RGB 图像中提取到具有判别性的特征,本文设计了包含梯度纹理分支和群感受野分支的多尺度特征融合模块。根据中心差分卷积学习细节纹理特征,通过空洞卷积在保持特征图大小不变的情况下学习群感受野特征。与标准卷积模块相比,MFFM可以提取更多包含细节信息、空间信息和语义信息的特征,提高模型的泛化能力。

2.2.1 梯度纹理分支

为了获得细节纹理信息,本文设计了梯度纹理分支。与文献[7]将中心差分卷积和标准卷积直接相加不同,该分支取消标准卷积部分,仅使用中心差分卷积来提取细节信息,防止直接相加造成的纹理特征破坏。分支结构见图2,RGB 图像经过卷积核尺寸为3×3 的中心差分卷积后得到包含丰富纹理信息的特征图,再对其进行一次卷积与池化操作,对特征进一步编码,得到128×128×32 的纹理特征图,之后与群感受野分支进行拼接融合。

2.2.2 群感受野分支

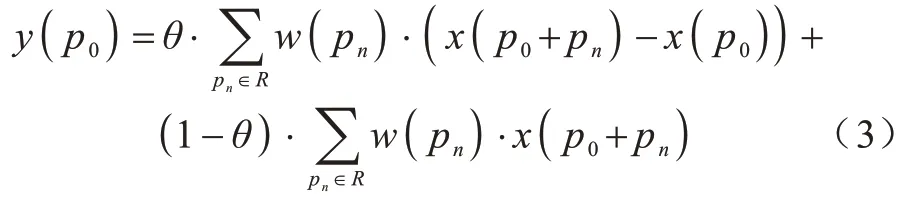

为了获得具有判别性的多尺度特征,融合人脸空间信息和语义信息,本文设计了群感受野分支。如图3 所示,受Inception 结构[8]的启发,采用不同尺寸的卷积核组成多个小分支结构。每个小分支先通过卷积核尺寸为1×1 的卷积学习浅层空间信息,之后分别使用3×3、3×1 和1×3 三种尺寸的卷积核学习多尺度特征信息,同时减少了模型的参数量。Inception 结构的核心是通过多个不同尺寸的卷积核来提取图像不同尺度的特征,从而更好地获得图像表征信息,但是过多的卷积核也会在一定程度上增加模型的复杂度。为了使模型可以在不增加卷积核参数量且保持分辨率的情况下获得更大的感受野,群感受野模块在第二和第三小分支增加扩张率为3、卷积核尺寸为3×3 的空洞卷积。接着将3 个小分支的特征拼接,并使用尺寸为1×1 的卷积核对多尺度的空间及语义信息进行编码,使得不同感受野信息充分融合,增强特征表征能力。最后使用残差结构将多尺度深层信息与浅层空间信息融合,得到尺寸为128×128×32 的群感受野特征图,之后与梯度纹理分支进行拼接融合。

图3 群感受野模块Fig.3 Group receptive field module

2.3 多监督策略

对于监督学习,合适的监督策略对网络的收敛与性能起着至关重要的作用。目前主流活体检测方法可分为二值监督与回归监督。二值监督策略使用0、1 标签来区分真实和欺诈人脸,但是该策略在复杂场景下易对背景、照明等信息产生过拟合现象。为了解决以上问题,文献[3]提出深度图监督策略,该策略认为真实人脸具有深度信息,而通过照片、电子屏幕等设备得到的人脸图像为平面物体,所以通过提取检测对象的深度特征可以有效地抵御照片攻击和视频攻击。

相比单监督策略,多监督可以使网络学习到更加鲁棒性的特征。本文使用深度图作为主要监督,并设计人脸的二值掩模作为辅助监督。掩模监督结合了二值监督与深度图监督的特点,标签人脸部分为1,背景为0,使得网络将学习中心放在人脸部位,起到注意力作用。深度图生成器与掩模生成器都由三层标准卷积组成,输出尺寸为32×32×1 的深度估计图与掩模估计图。损失函数使用均方误差函数,表达式如下:

其中:p代表深度估计图中的像素值;q代表掩模估计图中的像素值;D和M分别代表生成的深度估计图与掩模估计图;GD 和GM 分别代表深度图标签与掩模标签。

loss 表示为:

其中:α1和α2是每一项的正则化系数,为使网络更好地收敛,本文设置系数分别为3 和1。

3 实验结果与分析

3.1 实验数据集

本文采用OULU-NPU[9]、CASIA-MFSD[10]和Replay-Attack[11]这3 个主流公开数据集。

3.1.1 OULU-NPU 数据集

OULU-NPU 数据集由4 950 个活体和欺诈视频组成,这些视频使用6 款不同的手机,在3 种不同的采集场景下录制。每个视频长度为5 s,帧速率为30 Hz,分辨率为1 920×1 080 像素。该数据集通过4 种协议来评估活体检测算法的性能。协议1 主要评估模型在不同照明和背景下的泛化能力。协议2主要评估模型在不同攻击方式下的泛化能力。协议3主要探讨不同的拍摄设备对模型性能的影响。协议4最具有挑战性,评估模型在不同场景、攻击方式及拍摄设备下的通用能力。本文按照上述4 种协议对OULU-NPU 数据集进行详细测试。

3.1.2 CASIA-MFSD 数据集

CASIA-MFSD 数据集由600 个视频组成,其中训练集包含20 个主题,测试集包含30 个主题。每个主题采集12 个视频,包含480×640 像素、640×480 像素、720×1 080 像素3 种图像分辨率和不同照明条件。攻击方式分为照片、图片切割和视频攻击。其中照片攻击指彩色打印人脸照片并弯曲展示,图片切割攻击指将照片的眼睛区域分割出来,然后人脸在照片后进行欺诈攻击,视频攻击指使用高像素视频冒充真实人脸。该数据集具有3 种不同分辨率图像,在复杂背景下模拟多种攻击方式,对模型的泛化能力具有极大的考验。

3.1.3 Replay-Attack 数据集

Replay-Attack 数据集收集了50 个用户在不同条件下的1 300 个人脸视频样本。视频帧速率为25 Hz,分辨率为320×240 像素,在均匀人工照明与复杂自然照明两种光照条件下录制。攻击方式包括照片和视频攻击,支持条件包括手持媒体和固定媒体两种方式。该数据集采集了在不同光照和支持条件下的样本,实验结果更加接近真实情况。

3.2 评价标准

为了进行公平比较,本文依据各个数据集的原始评估指标进行实验。对于OULU-NPU 数据集,使用攻击表示分类错误率(Attack Presentation Classification Error Rate,APCER)、真实表示分类错误率(Bona fide Presentation Classification Error Rate,BPCER)和平均分类错误率(Average Classification Error Rate,ACER)作为评估指标。

对于CASIA-MFSD 和Replay-Attack 数据集,使用等错误率(Equal Error Rate,EER)和半错误率(Half Total Error Rate,HTER)[12]作为评估指标。等错误率是错误接受率(False Accept Rate,FAR)与错误拒绝率(False Reject Rate,FRR)相等时的错误率。其中,FAR 表示模型在所有数据中将欺诈人脸判断成真实人脸的比率,FRR 表示模型在所有数据中把真实人脸判断为欺诈人脸的比率,HTER 表示测试数据中错误接受率与错误拒绝率的均值。

3.3 实验设置

本文实验数据首先使用多任务卷积神经网络(Multi-Task Convolutional Neural Network,MTCNN)[13]进行人脸检测并裁剪对齐,得到256×256 像素大小的人脸图像。之后对训练数据进行重新采样,使真实人脸与欺诈人脸的数量比为1∶1。同时增加随机擦除、剪切和水平翻转操作用于数据增强。在测试阶段,计算深度估计图与掩模估计图中每个像素的均值并求和得到最终预测分数。当分数较低时,输入图像很可能为欺诈图像。

实验采用Adam 优化器[14],初始学习率设置为1E-4,batchsize 设置为32。编程环境为PyTorch,硬件设备为一张NVIDIA RTX 2080Ti 显卡。

3.4 结果分析

3.4.1 消融实验

为了验证本文设计的多尺度特征融合模块与多监督策略的有效性,本文在OULU-NPU 数据集的协议1 上做了三组消融实验来说明不同改进方案对检测性能的影响。

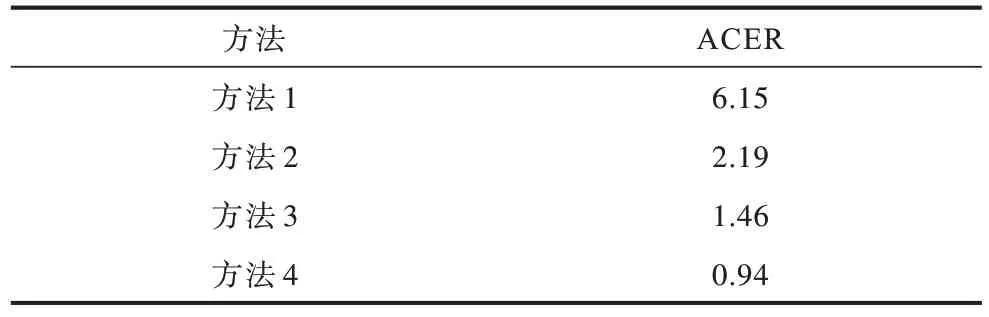

消融实验结果如表1 所示,其中,方法1 表示标准卷积模型,方法2 表示中心差分卷积策略,方法3表示中心差分卷积+群感受野策略,方法4 表示中心差分卷积+群感受野+多监督策略。

表1 在OULU-NPU 数据集协议1 上的消融实验结果Table 1 Results of ablation experiments on the OULU-NPU dataset protocol 1 %

从表1 可以看出,在中心差分卷积替代模型中第一层提取特征标准卷积后,性能得到了明显提升,说明梯度纹理信息对于活体检测任务起着至关重要的作用,同时表明标准卷积的提取能力有限,可能会导致网络缺失捕获细节信息的能力。为了提升图像表征能力,本文设计了中心差分卷积+群感受野的多尺度特征融合模块,使得模型更好地提取多维度特征,提高检测精度。为了提升模型鲁棒性,采用多监督策略,结合深度图与二值掩模,进一步增强检测性能。

3.4.2 不同算法的结果比较

为了验证本文算法的有效性,使用OULUNPU、CASIA-MFSD和Replay-Attack3个公开数据集,与其他主流活体检测算法进行大量对比实验。

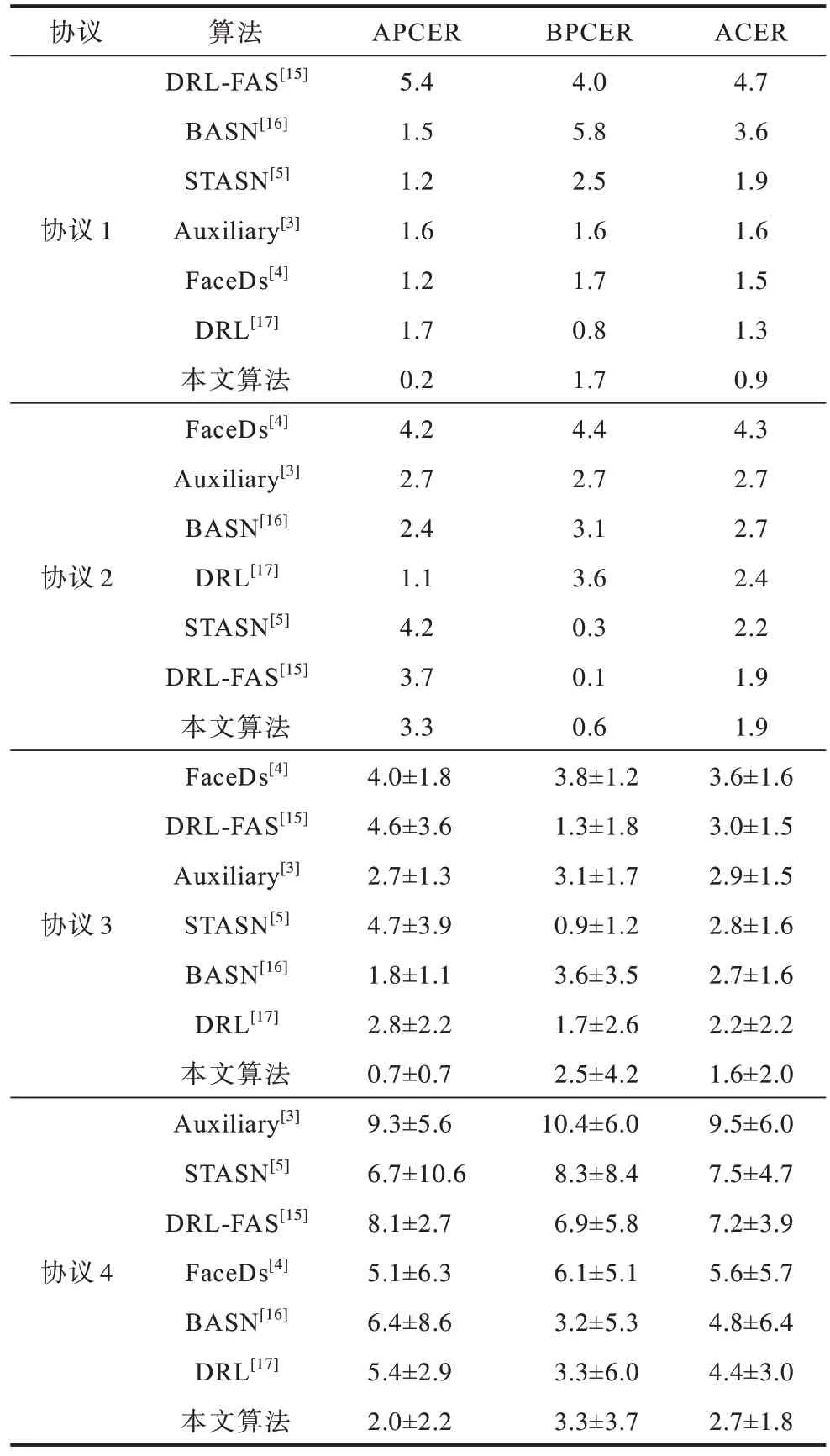

OULU-NPU 是一个具有复杂测试样本的高分辨率数据集。表2所示为OULU-NPU数据集上各主流算法的实验结果。可以看出,本文算法在4个协议中的ACER评价指标分别达到了0.9%、1.9%、1.6%±2.0%、2.7%±1.8%,均优于其他方法。与多帧方法不同,例如Auxiliary[3]和STASN[5]使用多张图像作为网络输入,本文算法仅使用单帧图像进行活体检测,大幅降低了模型的复杂度,模型参数量大小仅为1.1MB。同时,MFEN从特征挖掘角度对细节信息和语义信息进行充分提取,而其他算法如DRLFAS[15]却忽略了这些纹理特征,所以MFEN可以捕获更加丰富的判别信息。最终实验结果也充分证明了提取多尺度特征和多监督策略的有效性。

表2 不同算法在OULU-NPU 数据集上的结果Table 2 Results of different algorithms on the OULU-NPU dataset %

协议1~协议3 分别评估不同场景、攻击方式和拍摄设备对模型性能的影响可以看出,本文算法均优于目前效果最好的算法,说明多尺度特征算法对于多种环境及攻击方式均有较好的鲁棒性。协议4包含上述3 种协议不同的变化因素,更加贴近真实应用场景。在此协议下,本文算法较目前最优算法提升39%,并且取得了最低的标准差,表明该算法在复杂场景下仍然具有较强的泛化能力和稳定性。

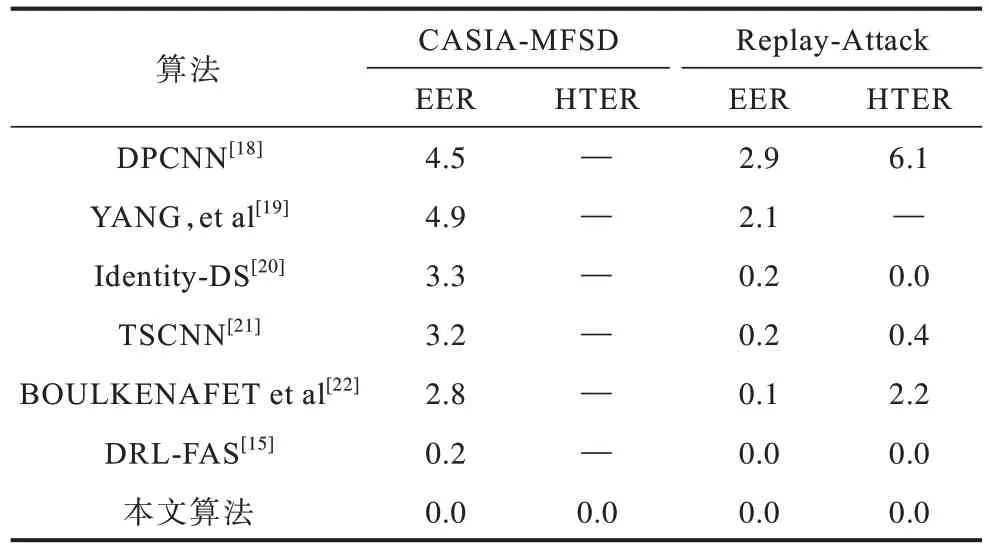

不同算法在CASIA-MFSD 和Replay-Attack 数据集上的结果如表3 所示。两个数据集都包含多种分辨率的视频,可以检测模型在多分辨率和不同光照背景下的鲁棒性。实验的对比算法包括基于手工特征的机器学习算法与深度神经网络算法。可以看出,本文提出的算法在CASIA-MFSD 和Replay-Attack 数据集上的EER 和HTER 都达到0.0%,优于DRL-FAS[15]算法,实现了无误差人脸活体检测,说明MFEN 提取的多尺度特征使算法可以在多种攻击方式和不同光照背景下有效地进行活体检测。同时,对于不同质量的照片和拍摄设备,也具备较好的鲁棒性。

表3 不同算法在CASIA-MFSD 和Replay-Attack 数据集上的结果Table 3 Results of different algorithms on CASIA-MFSD and Replay-Attack datasets %

为了进一步验证提出方法的泛化能力,本文使用CASIA-MFSD 和Replay-Attack 来执行跨数据集评估,即对不同的数据集进行训练和测试评估,评估结果如表4 所示。

表4 CASIA-MFSD and Replay-Attack 的跨数据集评估结果Table 4 Cross-dataset evaluation results of CASIA-MFSD and Replay-Attack %

使用CASIA-MFSD训练、Replay-Attack测试时(CA-Re),本文算法取得最优的HTER。这是因为CASIA-MFSD 数据集比Replay-Attack 数据集具有更高的分辨率,本文提出的多尺度特征融合模块在高分辨率情况下可以比DRL-FAS[15]等算法更好地提取具有判别性的纹理信息,因此取得了更好的检测效果。

使用Replay-Attack训练、CASIA-MFSD测试时(Re-CA),在Replay-Attack 数据集像素值较低,不利于本文算法进行梯度纹理特征提取的情况下,仍取得较为优异的检测效果。结果表明,本文算法在完全不同的场景下具有一定的鲁棒性。

3.5 复杂性分析

在实际应用中,模型的处理效率和复杂程度同样十分重要。为了进一步验证算法的轻量性,以模型参数量(Parameters,Params)、每秒10 亿次的浮点运算数(Giga Floating-point Operations Per Second,GFLOPs)和每秒传输帧数(Frames Per Second,FPS)为指标在OULU-NPU 数据集的协议1 上对网络模型进行复杂性分析。

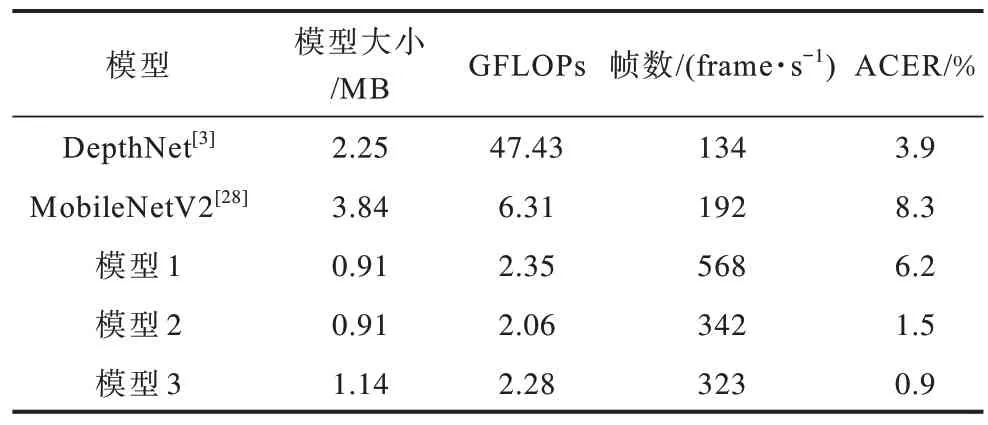

不同模型复杂性分析结果如表5 所示,其中,模型1 表示使用标准卷积的基准模型,模型2 表示使用中心差分卷积和群感受野策略的改进模型,模型3表示使用中心差分卷积、群感受野和多监督策略的最终模型,即本文提出的多监督特征提取网络(MFEN)。

表5 不同模型的复杂性分析Table 5 Complexity analysis of different models

与主流深度监督网络DepthNet 相比,本文提出的MFEN 具有更低的参数量和更快的处理速度,同时需要更少的计算资源。这是因为DepthNet 网络浅层部分下采样较少,导致特征图过大从而需要更多的参数量和算力;而MFEN 具有较少的特征通道数,并且使用空洞卷积来减少参数量,因此模型更加轻量化。对比常规的轻量网络MobileNetV2,MFEN 不仅更加轻量,在性能上也有很大优势。在模型1、模型2 和模型3 的对比中可以看出,本文提出的多尺度特征融合模块和多监督策略,在没有明显增加模型复杂度的情况下显著提高检测精度。综合各项指标可以得出本文提出的算法不仅具有较好的检测性能,并且模型大小仅为1.14 MB,帧率达到323 frame/s,满足实时性的要求。

3.6 结果可视化

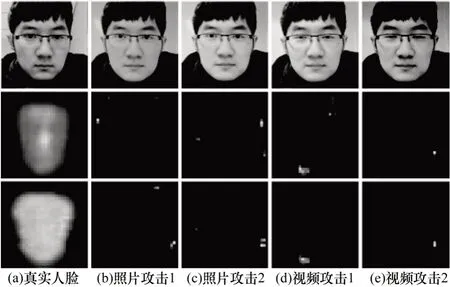

卷积神经网络是一个“黑盒”模型,而可视化方案大幅提高了可解释性。为进一步验证所提方法的有效性,在OULU-NPU 数据集的协议1 上对生成的深度图和掩模图像进行了可视化对比,结果如图4所示,可以看出,本文提出的模型可以很好地生成真实人脸的深度图和二值掩模图。对于照片攻击和视频攻击,模型也可以正确处理,仅生成平面图像,表明了本文方法的有效性。

图4 真实人脸与欺诈人脸的特征图可视化对比Fig.4 Visualization comparison of feature map between real face and spoofing face

4 结束语

针对活体检测任务中细节信息提取不足的问题,本文提出一种融合梯度纹理与群感受野特征的活体检测算法。利用中心差分卷积提取梯度特征,使用空洞卷积获得多尺度空间和语义特征,同时通过深度图与二值掩模进行多监督以提升网络的性能与泛化能力。在多个数据集上的实验结果表明,与现有主流的活体检测算法相比,本文算法检测精度更高,具有更好的鲁棒性。虽然本文算法在高分辨率数据集中获得了较好的检测效果,但是在低分辨率图像上训练模型并在高分辨率图像上测试模型时可能会无法准确地区分真实人脸和欺诈人脸,下一步将重点研究低分辨率情况下鲁棒性特征的提取方案,提升活体检测的通用性和有效性。