语音情感识别研究综述

罗德虎,冉启武,杨 超,豆 旺

陕西理工大学 电气工程学院,陕西 汉中 723001

语音是人与人之间最直接自然的交流方式,随着使用移动设备的人数增加,也成为了人机交互的主要形式。带有情感的语音使得人人、人机交流变得高效和有吸引力。然而现实生活中语音情感多样,往往是混合的,微妙而复杂且是处于变动状态的,所以检测识别语音中的情感就成为了一项比较有挑战性的任务。语音情感识别(speech emotion recognition,SER)是情感智能的一个研究热点,利用计算机分析预处理后的各种情感信息,提取出描述情感的特征,将特征值与情感进行对应,然后对情感信息进行分类,进而推断出情感状态的过程。其流程主要包括预处理、特征提取和情感分类3 部分。传统SER 流程图如图1 所示。SER 经过几十年的发展,取得了丰硕的成果,图2 为SER 的发展示意图。随着深度学习的发展,端到端的深度SER就开始受到了关注,可直接将原始情感语音信号或者手工特征作为深度学习模型的输入,基于深度学习的SER流程图如图3所示。

1 情感描述模型

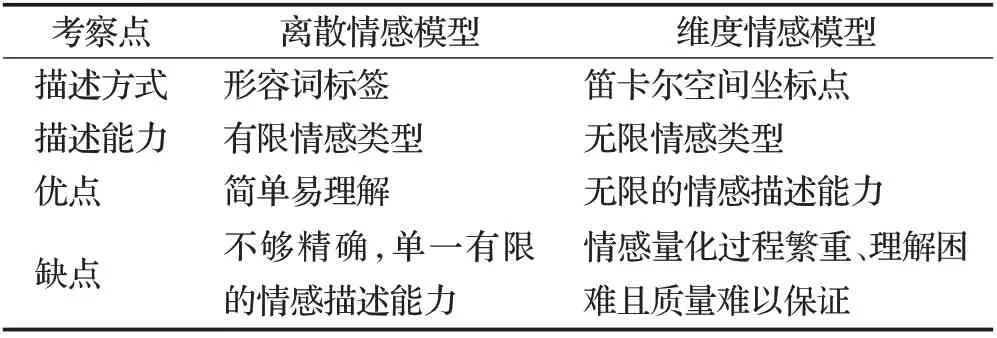

一般从离散标签和连续维度两个角度对情感进行量化描述。离散标签是指使用与情感相关的形容词来描述基本情感的集合。离散情感的描述方式更容易理解,所描述的情感种类单一纯净,但是对生活中常见的细微、复杂和混合的情感就无法表述了。现实生活中人的情感处于连续动态变化中,维度情感描述模型的出现能够实现对该动态过程的建模,提高了计算机对复杂情感的处理能力。维度情感描述模型相比离散方法更具体,从多个维度对情感进行量化,在一定程度上对情绪的强度和波动进行描绘,适合用来描述日常的自发情感,从理论上来讲能完全覆盖现实生活中的情感,但是在某些维度上比较抽象,没有离散情感那么好理解。

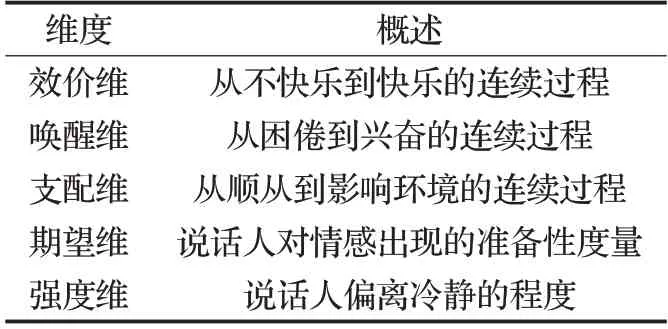

两种情感描述模型的区别如表1所示[1]。维度情感描述模型中常用的维度是效价维(Valence)、唤醒维(Arousal)和支配维(Dominance)。有研究者加入期望维(Expectation)和强度维(Intensity),以使该情感描述模型更全面,该五个维度的介绍如表2所示。

表1 两种情感描述模型的区别Table 1 Difference between two emotion description models

表2 维度概述Table 2 Dimension overview

2 语音情感数据库和情感标注

2.1 语音情感数据库

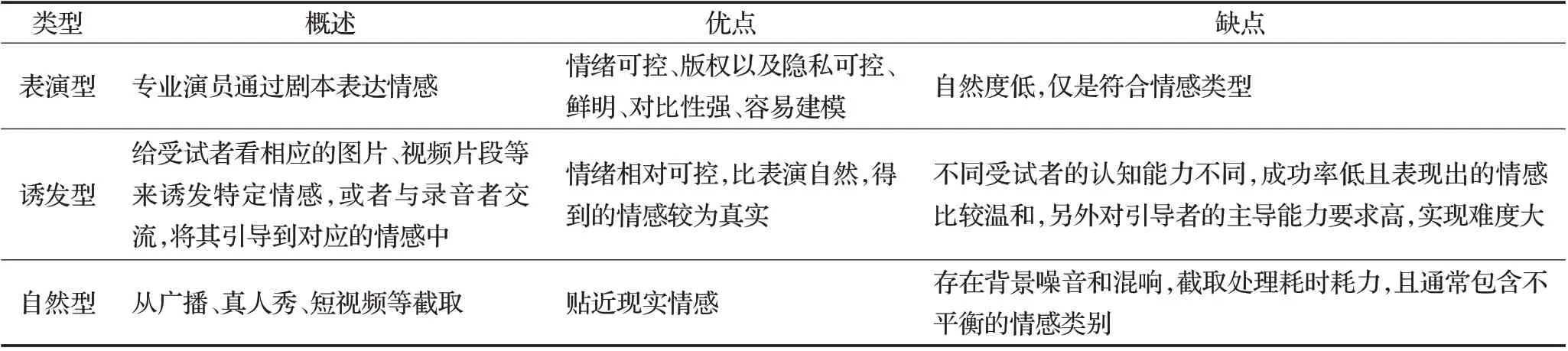

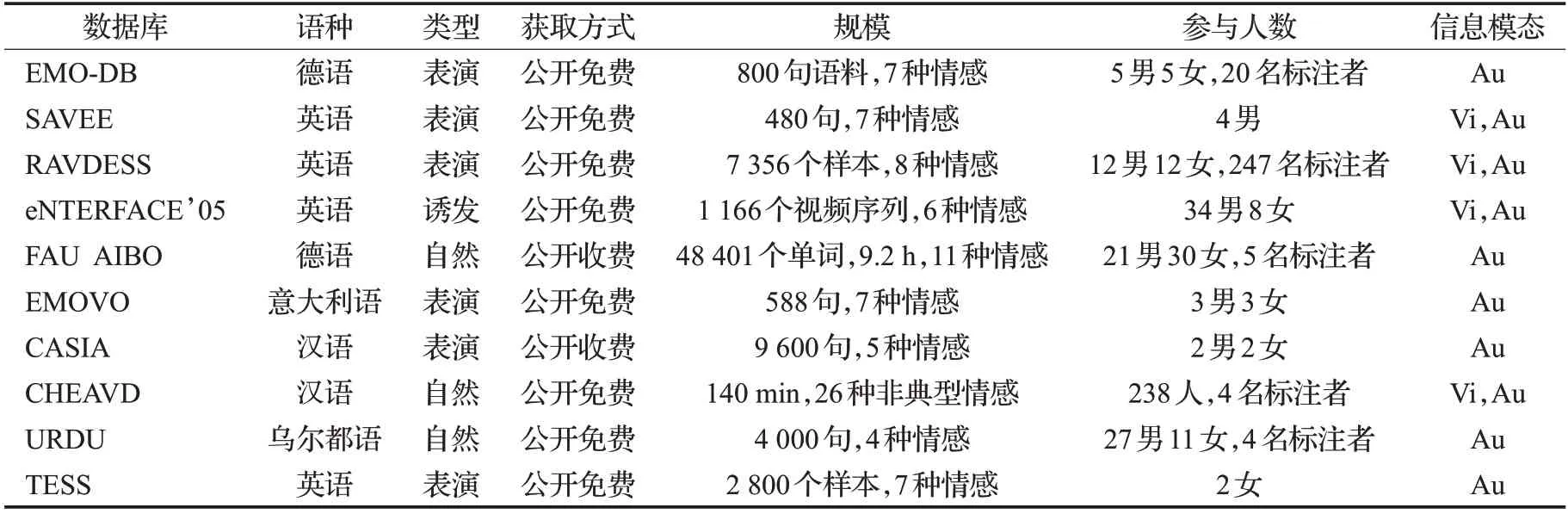

语音情感语料库有多种分类方式,可按语种、类型、自然度和情感描述模型来分。按类型来分如表3所示,按情感描述模型来分,分为维度情感语料库以及离散情感语料库,两种类别中常见的语料库如表4、5所示。广泛使用的表达情感的形式主要有两种,一类是明显的情感线索,另一类是隐含的情感刺激[2]。明显的情感线索是在现实生活中诱导人所产生的包含语音在内的情感信息可以直接观察到并收集的,隐含的情感刺激是来源于多媒体网络用户分享自己的生活和表达自己的观点。从语音情感数据库的建立可知,语音情感语料来源于这两方面,其中收集来源于多媒体网络的语音情感语料具有可行性和吸引力。大规模的情感语料库大部分是来自于外国,中文情感语料库规模较小且通常只包含单一模态如语音,最近出现了大型的中文情感语料库,有中文自然情感视听语料库(CHEAVD)[3]、NTHU-NTUA中文交互式多模态情感语料库(NNIME)[4]和CH-SIMS[5],三者都是包含语音的多模态情感语料库。

表3 不同类型的数据库对比Table 3 Comparison of different types of databases

表4 常见离散情感语音数据库Table 4 Common discrete emotional speech database

随着多媒体的急剧发展以及多模态情感分析成为研究热点,可以看出情感语料库建立的趋势,首先,更多地摘引来自广播、短视频等平台的内容作为语料,如情感语料库ShEMO[6]、OMG[7]、MSP-PODCAST[8]等,其次,语料库更多建立为包含语音的多模态情感数据库,有BAUM-1[9]、CREMA-D[10]等。最后,语料库趋向建立为同时包含离散和维度情感的数据库,有CMU-MOSEI[11]、DEMoS[12]等。除此之外,还出现了合并现有语料库的大型语料库,如Gerczuk等[13]收集来自于26个SER语料库的语料创建情感语音的大型语料库EmoNet。

表5 常见维度语音情感数据库Table 5 Common dimensional speech emotion database

2.2 情感标注

情感注释依赖于标注者,由于标注者在进行情感标注时,存在一定的情感偏见,以及在标注视听数据存在反应时的时间延迟[14]。另外有研究表明说话人自我报告的情感与听者标注出的情感存在很大的差异[15]。为了解决这些问题,通常的做法是多人对同一来源的数据进行评注,并将结果进行融合,但是当有注释者的标注有巨大分歧时,这些方法并不稳定,因此需要建立广泛认可的情感评注标准。可借助标注工具的便利性和结果可对比性来解决上述问题,Stappen 等[16]开发了一个情感标注工具箱MuSe-Toolbox,该工具箱是基于Python的开源工具箱,用于创建离散和连续的情感黄金标准,并可将连续维度转换为离散情感,方便了包括语音在内的多模态情感分析的评注工作。深度学习模型需要更大和更多样化的数据集,于是研究者一方面继续开发高性能的标注工具,另一方面使用半监督方法充分利用已标注数据和未标注数据,来促进深度学习模型在SER中的应用。如Deng等[17]利用半监督自动编码器结合少量的有标记数据和未标记数据提高了SER的性能。

3 语音情感特征

3.1 语音情感特征提取

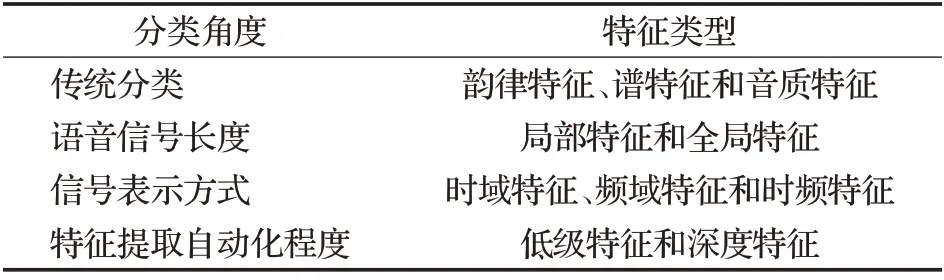

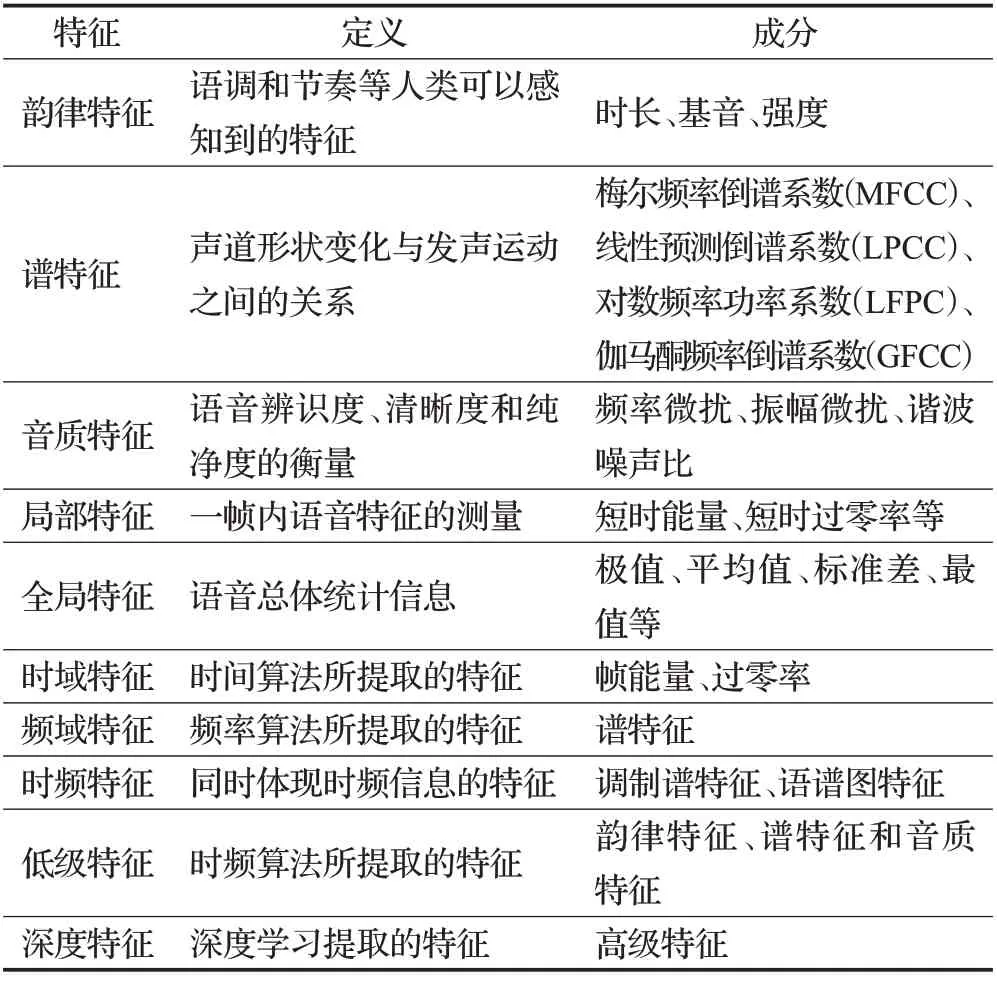

语音情感特征是进行SER研究必不可少的模块,特征提取是任何模式识别系统的重要组成部分,目的是提取表示情感状态的关键信息。声学特征主要分为两类,即低级特征和深度特征,第一类是指使用时间算法和频率算法所提取的特征,通常分为三大类,韵律特征、谱特征和音质特征[18]。第二类是指使用深度学习直接从原始语音信号或者从低级特征中提取的高级特征[19]。声学情感特征根据四个不同的分类角度可分为不同类型,如表6所示。具体的特征描述见表7。

表6 声学情感特征归类Table 6 Acoustic emotional characteristics categorization

表7 声学情感特征描述Table 7 Acoustic emotional characterization

韵律特征在SER领域广受研究者的认可,最常使用的韵律特征为基频、能量和时长。文献[20]使用较少数量的韵律特征达到92.32%的识别率,表明了韵律信息对情感识别非常有用。文献[21]提取语音韵律的统计信息,但特征数量不足以区分七种情绪,只实现了51%的识别率,然而对于高唤醒情绪的识别率达到89.1%,表明了韵律特征能很好地区分具有不同唤醒度的情绪,然而对于有相同唤醒度或效价的情绪区分度较低。

频谱特征是通过傅里叶变换将时域信号变换为频域信号来获得的,广泛使用的谱特征有Mel频率倒谱系数(Mel frequency cepstral coefficients,MFCCs),线性预测倒谱系数(LPCC)和感知线性预测系数等特征(PLP)。近年来有新的谱特征被发现并成功应用于SER,Liu[22]发现伽马酮频率倒谱系数(Gammatone frequency cepstral coefficients,GFCCs)在SER中的表现相比MFCC平均提高了3.6%的准确度。Jiang等[23]提出情感感知谱特征,在三个数据库上做实验,其中最高的识别率为81.5%。Tao等[24]提出GSLHu-PCA特征,在Emo-DB语料库上较HuWSF、PLP 和MFCC 特征分别提高了1.6%、5.53%和12.68%。Peng等[25]提出一种新的基于听觉的特征,称之为多分辨率调制滤波耳蜗图特征,将其用于维度情感识别以获取时间动态信息,实验表明,在效价维和唤醒维上取得了较好的性能。

音质特征主要用于评价语音的干净程度和辨识度等。广泛使用的音质特征有频率微扰,振幅微扰和谐波噪声比等。文献[26]表明了语音质量与情感内容存在很大的相关性。文献[27]利用在不同频段分布的共振峰、谐波噪声比等音质特征,得出音质特征更适合区分具有相同唤醒度和不同效价度情绪的结论。因此,这些特征可以和韵律特征相结合提高情感识别率。文献[28]结合音质特征和韵律特征,与单独使用韵律特征相比提高了约10%。文献[29]研究频率微扰和振幅微扰对印地语SER 的影响,获得了83.3%的识别率。文献[30]在谱特征的基础上加入频率微扰和振幅微扰,在所有实验条件下均得到提高。文献[31]提出傅里叶参数特征,与MFCC相结合比单独使用MFCC性能得到进一步提高,充分表明了音质特征比主特征更具有补充性。

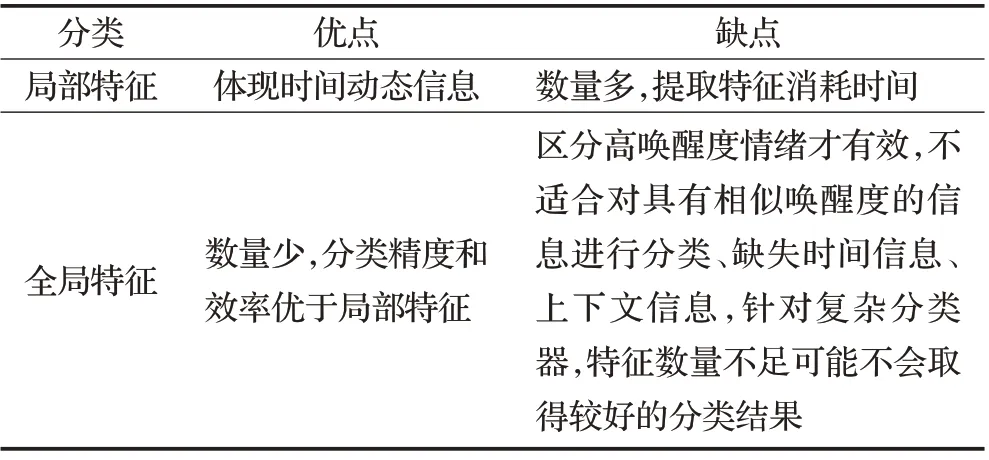

情感随着时间变化,并非均匀分布在语音中所有位置上,研究者根据研究目标选择提取局部特征或全局特征[32]。文献[33]和文献[34]都提取了韵律的局部特征和全局特征,并进行了对比,局部特征的识别率均低于全局特征。文献[35]提取局部序列特征,实验结果优于现有方法,平均准确率提高了9%。文献[36]利用基音轮廓的统计量进行分析,准确率高出对比文献27%。在分类时间、准确度和效率方面,全局特征的性能优于局部特征。然而文献[37]提出全局特征对具有相似唤醒度的情绪并不适用。表8给出两种特征的优缺点对比情况,通常将两者组合用于情感识别。

表8 局部特征vs全局特征Table 8 Local features vs.global features

传统特征要么专注时域信息,要么仅注重频域信息,缺乏结合时域和频域的特征,Wu等[38]提出了长期调制谱特征,用于捕获语音信号的时频信息。唐闺臣等[39]提取语音信号的时域和频域信息,将其组合形成语谱图。如今可以直接应用深度学习技术自动提取特征,如利用卷积神经网络从语谱图中自动提取有用特征,这成为了一种流行趋势,避免了繁复的人工提取特征过程。Han等[40]利用深度神经网络从低级声学特征中提取高级特征,取得了SER研究的巨大进步。为了有效描述情感语音的时间动态信息,Luo 等[41]利用卷积神经网络与递归神经网络相结合的卷积递归神经网络从不同时间尺度的语谱图中提取上下文特征。卷积神经网络(convolutional neural network,CNN)所捕捉的语谱图特征中缺失空间信息,为此Wu 等[42]利用序列胶囊网络提取特征空间信息。

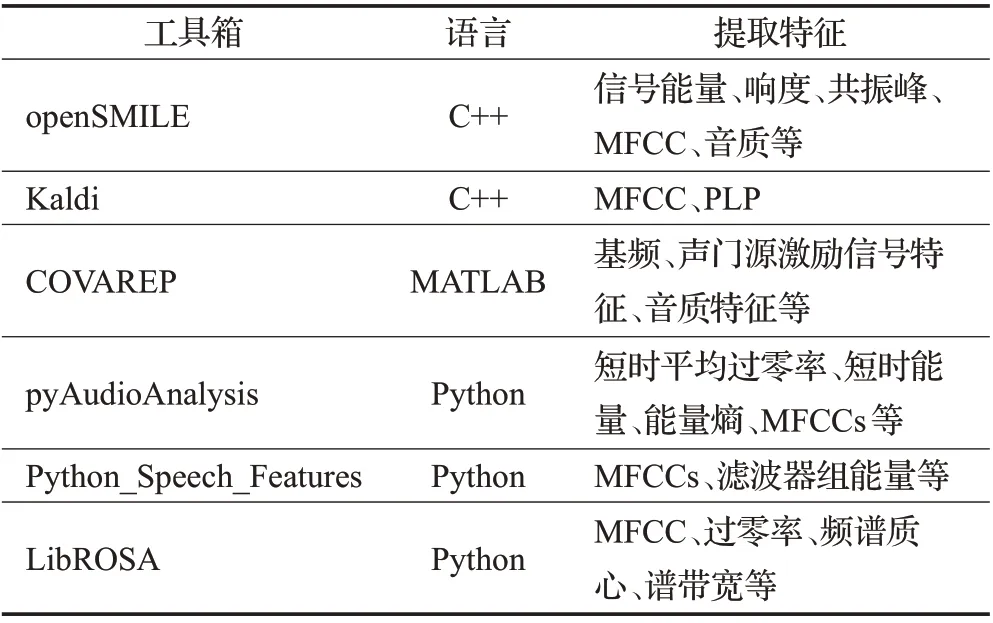

OpenSMILE[43]是较为常用的特征提取工具包,最初为提取语音特征而开发,常用于Interspeech副语言信息提取挑战赛,可提取的语音特征包括信号能量、语音质量、光谱和共振峰等,现在已经开发了2.0 版本,可以提取的特征不仅包含语音特征,还包括音乐特征和视频特征,可以对特征进行联合处理,实现多模态特征提取。其他特征提取工具见表9[44]。

表9 常用语音情感特征提取工具Table 9 Commonly used speech emotion feature extraction tools

3.2 融合特征

融合特征相较于传统特征在不同语种的数据集及不同分类器上的性能较好且识别性能稳定。融合特征包含传统特征之间的融合,Bandela等[45]将Teo能量算子与MFCC 特征相结合,准确率明显高于MFCC。Rao等[46]将全局韵律特征和局部韵律特征结合,准确率高于单一特征。此外融合特征还包括深度特征与传统特征之间的融合以及深度特征之间的结合。传统特征与深度特征的结合结果表明,特征工程可以帮助提高端到端系统的鲁棒性,其中具有区分性的传统特征,相比于复杂的深度学习特征集,拥有更优秀的表现[47]。王怡等[48]将低层次手工特征集、高级统计特征、基于深度神经网络和卷积神经网络所提取的深度特征相融合,相比未融合之前提高了分类性能。Wang等[49]结合手工特征与深度神经网络所提取的特征优点,提高了整体识别效果。对于深度特征之间的结合,Sun 等[50]融合卷积神经网络所提取的深层特征与浅层特征,在大多数测试数据集上取得了很好的结果。

4 语音情感识别方法

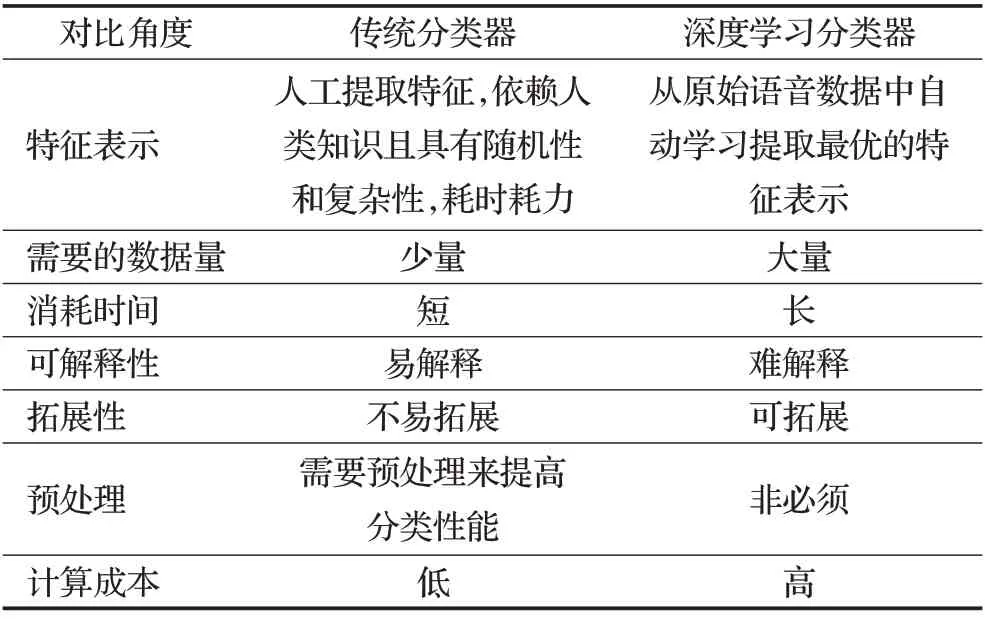

在过去的几十年中,SER研究一直以传统的机器学习算法为主,取得了许多成果,现如今,随着深度学习在SER 领域的发展,许多研究表明,与传统情感识别方法相比,深度学习有更好的表现。每种分类器都有各自的优缺点,然而,由于情感的复杂性和主观性,还没有一个普遍认可的通用分类器可以使用。传统分类器所需要数据量相比深度学习分类器要少,但深度学习分类器可以省去人工提取特征的步骤,表10 简要介绍两大分类器的区别。以下从传统分类器、深度学习分类器以及两者的混合模型三个角度对SER算法分别进行阐述。

表10 传统分类器与深度学习分类器的比较Table 10 Comparison of traditional classifiers and deep learning classifiers

4.1 基于传统分类器的语音情感识别方法

常用的传统分类器有高斯混合模型(Gaussian mixture model,GMM)、支持向量机(support vector machines,SVM)和隐马尔可夫模型(hidden Markov model,HMM)等。

SVM算法使用核函数将样本从原始空间映射到高维空间使其线性可分,因为其泛化能力强,不易受高维特征的影响而在SER 研究中使用广泛。文献[51]将SVM 与线性判别分类器,k近邻分类器和径向基函数神经网络的SER任务性能进行比较,SVM的性能最高,然而只分类了四种情绪。文献[52]利用SVM 确定SER中最优的特征集,提取七种情绪的基频、能量和MFCC特征组合,三个语料库中最低的识别率为89.8%,最高的识别率为98%。文献[53]提出深度SVM,基于单独使用MFCC及使用MFCC与其他特征的融合特征,相比标准SVM分别提高约7%和8%,验证了深度SVM的可行性。

HMM 是关于时序的概率模型,它能够很好地模拟情绪的时间动态。文献[54]使用HMM 和SVM 对五种情感分类,在丹麦情感语音数据库上进行实验,与说话人无关的情况下,HMM 取得了99.5%的最优识别率。文献[37]利用短时对数频率功率系数结合HMM,与使用线性预测倒谱系数和MFCC特征参数的性能做比较,结果表明,该方案达到最好的识别率89%,超过人类评估的65.8%。

GMM 是连续HMM 的特例,它使用混合的高斯分量来捕获每一类的概率分布。文献[55]将GMM、HMM和深度信念网络用于在Emo-DB 与EMOVO 相结合的跨语言语料库上进行二分类和六分类实验对比,结果GMM 的识别率都优于另外两个,在二分类上的识别率为83.4%,在六分类实验上的平均识别率为70.1%。考虑到GMM 对训练数据的依赖性较强,文献[56]提出变分高斯混合模型,在使用20%、50%、80%和100%的原始训练数据的情况下进行与GMM 的对比实验,结果表明了变分GMM 在同样数据量的情况下其表现都优于GMM。

各类分类器各有优缺点,研究表明各分类器集成的表现通常优于单独分类器。分类器的组合方式一般有两种,一种是将数据送入每个分类器,每个分类器的输出结果通过多数投票机制而获得最终结果。另一种方式是分类器以分层的方式进行组合,首个分类器的输出结果再送入其他分类器,然后给出最终结果。文献[57]提出基于维度情感模型的多级分类方案,先进行唤醒维度分类,接下来的分类器进行效价维度分类,在丹麦语情感语料库上取得了81%的识别率,但其训练集和测试集都是来源于同一个语料库,为了挖掘集成分类器的通用性,文献[58]利用集成分类器使用多数投票机制的方式进行跨语料库的多语言SER研究,两组实验分别将乌尔都语作为训练集和测试集,与相应研究文献对比识别率最高增加15%,表明利用集成分类器进行跨语料库的SER研究是比较有效的方法。

4.2 基于深度学习的语音情感识别方法

用于SER 任务具有代表性深度学习技术有CNN、循环神经网络(recurrent neural network,RNN)、胶囊网络(capsulenetworks,CapsNet)、自编码器(autoencoders,AE)等。SER 最近的研究更多的在于对各深度学习模型改进和整合上。

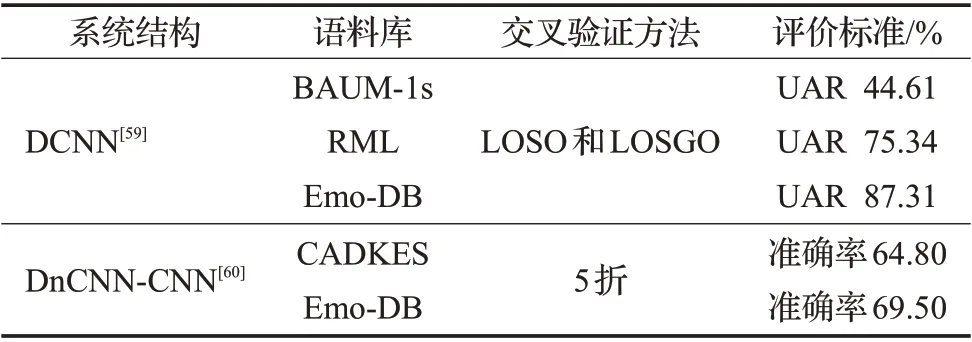

CNN是专门用于处理如时间序列和图像数据这种具有类似网格拓扑结构数据的神经网络,被广泛用作SER的基本框架。深度CNN(deep convolutional neural networks,DCNN)被认为是传统卷积神经网络的扩展,相关研究成果见表11[59-60]。文献[59]受到DCNN在计算机视觉领域较好表现的启发,将其用于建立SER 系统,同时提出了判别时间金字塔匹配算法用于汇集深度特征,实验结果表明了该模型与算法结合的有效性,另外该研究将预先训练好的深度模型用于小型语音情感数据集时进行微调为SER 的研究提供了较好的思路。i-vector[61]与深度学习结合的研究较少,2015 年,文献[62]首次结合RNN与i-vector特征进行SER研究。2019年,文献[63]提出将DCNN与i-vector相结合的情感识别方法,结果显示了该方法的有效性。

表11 基于深度卷积神经网络的SERTable 11 Deep convolutional neural network based SER

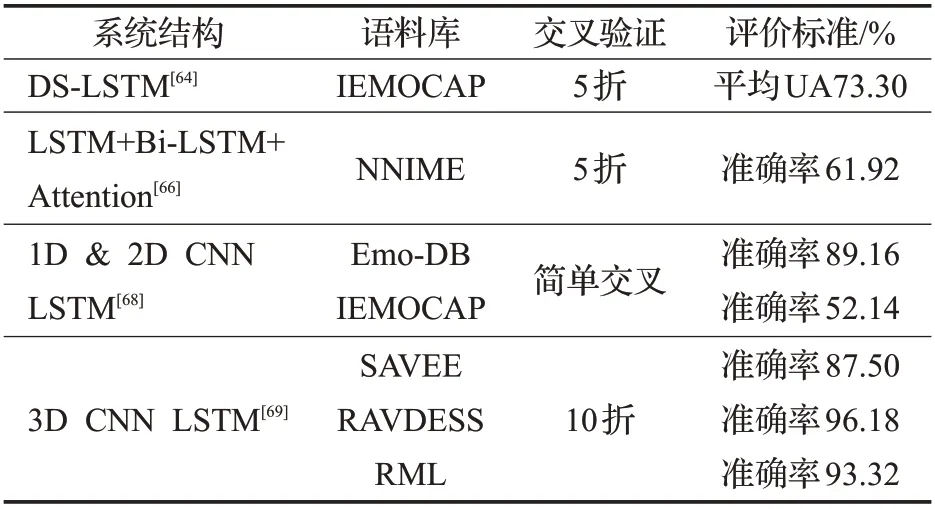

RNN 是专门用于处理序列数据的神经网络,容易出现梯度消失的问题,由于该问题的影响,使得RNN在捕获序列数据的长期依赖关系方面存在局限性,因此开发了长短期记忆网络来解决这个问题。相关研究工作见表12,其中文献[64]提出双序列LSTM 模型,用来同时处理两个Mel 谱图,在IEMOCAP 上的准确率相比目前最优的单模型提高了6%。有研究表明无语义的发声如笑声、叹息声等有助于SER[65]。文献[66]利用SVM检测语音和无语义的发声,使用韵律短语提取器将两种类型的声音进行分离,然后使用深度残差网络提取各自的特征进行决策级融合,之后输入基于注意力机制的LSTM的序列到序列模型进行分类,结果准确率优于基于特征级和模型级的融合方法。

表12 基于循环神经网络的SERTable 12 Recurrent neural network based SER

文献[67]首次将标注者之间的不一致程度即感知不确定性融入SER,可以用来调整情绪预测过程,他们利用BLSTM-RNN回归模型,在效价维和唤醒维对情感进行预测,结果表明感知不确定性可以在一定程度上改善识别性能。LSTM 通常与CNN 结合用于SER 任务,两者的各种组合成为了SER领域的一种流行趋势,其组合结构通常优于单独的模型。文献[68]构建1维和2维的CNN LSTM 学习局部特征和长期上下文关系,2 维CNN LSTM在EMO-DB、IEMOCAP语料库上与说话人相关和无关的实验取得了较好的识别率,优于深度信念网络和CNN 等传统方法。近期文献[69]提出了基于注意力的3维CNN LSTM,将语谱图、MFCC图、耳蜗图和分形图拼接成4 维作为该模型的输入,在SAVEE、RAVDESS 和RML 数据集的实验准确率相较于以往文献在这三个数据集上的实验结果分别改进了2.71%、8.75%和7.81%。

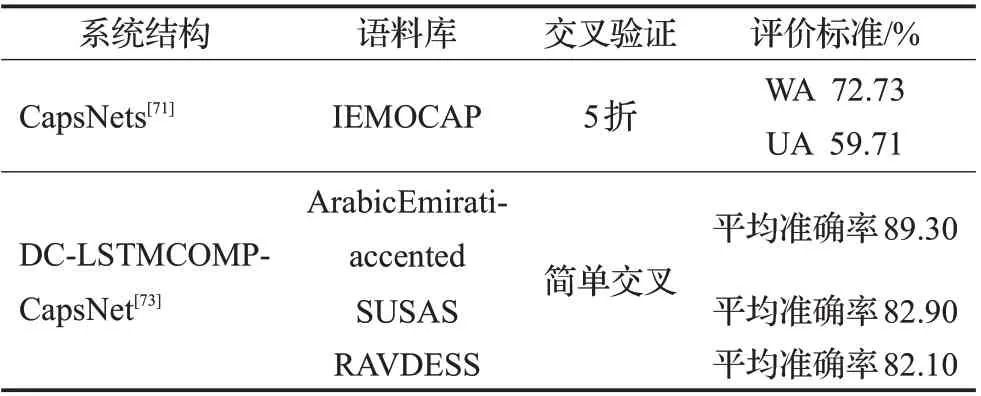

文献[70]提出CapsNet,其每一个胶囊都由许多神经元组成,输入和输出都是向量,而非CNN 的标量,它具有平移同变性,因此其可以克服CNN 捕捉空间信息能力不足的局限性。相关研究工作见表13,有研究人员将其用于提取语谱图空间信息,文献[71]研究了基于CapsNet 的SER,提出有效的汇集方法获得全局特征以及提出循环连接来获取时间信息,与CNN-LSTM 模型基于IEMOCAP语料库在四种情绪下的准确率对比,其准确率达到72.73%。由于CNN的压缩方法不能直接应用于CapsNet[72]。且CapsNet 算法速度较慢,因此文献[73]提出了双通道LSTM 压缩CapsNet 算法,在多个语料库上与多种分类算法进行对比,结果表明该方法优于多种分类算法,但是训练和测试的运行时间相比传统方法要长,特征提取也比所对比方法要复杂。

表13 基于胶囊网络的SERTable 13 Capsule network based SER

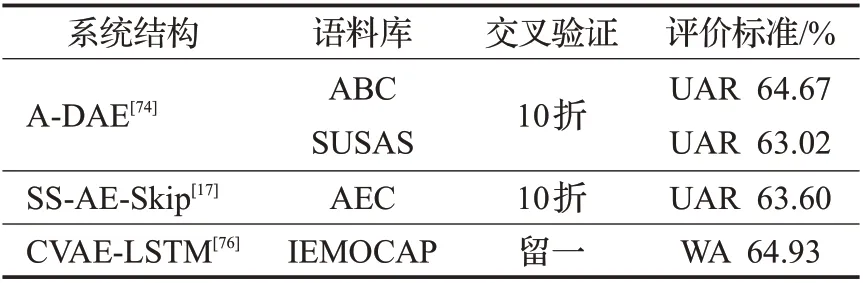

AE 将原始数据重建为输出,包含编码器和解码器两个组件。相关研究工作见表14。针对源域与目标域失配问题,文献[74]提出了基于自适应去噪自动编码器的无监督域自适应方法,在三个公开语料库上的实验结果表明,该方法显著减少了训练集和测试集之间的差异所带来的对情感分类准确率的影响。文献[75]使用去噪自动编码器、变分自动编码器、对抗性自动编码器和对抗性变分贝叶斯作为特征学习器结合CNN作为与说话人无关的SER系统,与没有应用无监督特征学习并使用手工特征作为输入的CNN和SVM进行对比,自动编码器显著改善了SER 的性能。文献[17]提出一种基于半监督自动编码器的语音情感识方法,结合少量标签样本和未标注样本,实验表明,所提出的方法足以取得与监督学习方法竞争性的结果。

表14 基于自编码器的SERTable 14 Autoencoder based SER

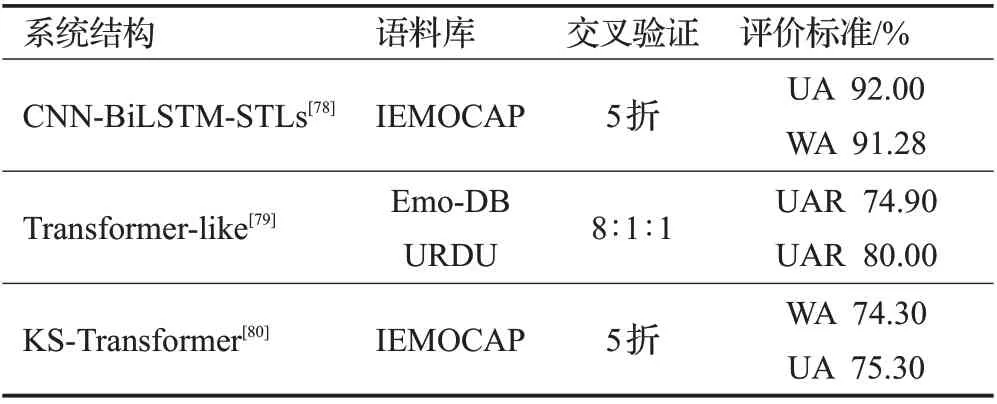

由于Transformer 模型[77]在自然语言处理方面的优异成绩,且在长序列建模方面表现突出,在一定程度上可以替代CNN 和RNN,因此有研究者将其用于SER。相关研究工作见表15,文献[78]提出一种新的端到端的SER 架构,在其中加入了堆叠Transformer 层,与在IEMOCAP上做实验所取得较好结果的各种方法进行对比,取得了相对20%的改进。由于Transformer中多头注意单元的Softmax消耗的时间和内存占用过大,文献[79]提出了类Transformer模型,并提出泰勒线性注意算法,虽与基本方法相对比没有显著差异,但是在内存占用和时间开销上却大大减少。

表15 基于Transformer的SER Table 15 Transformer-based SER

4.3 基于混合模型结构的语音情感识别方法

将传统机器学习方法与深度学习方法相结合而形成混合模型结构也是SER研究的一种有效方式。相关研究工作见表16,其中文献[81]提出了一种基于DNN-HMMs的SER方法,与四个模型分别基于eNTERFACE’05数据库和柏林数据库上进行实验对比,结果表明,该模型在第一个数据库上的准确率都比其他四个模型率提高了10%以上,在第二个数据库上该模型相较于其他模型所提升的识别率整体上没有在第一个数据库上的高,但依旧能取得最好的结果。文献[82]研究了一种基于DNN-决策树SVM 的SER 方法,将多层决策思想与深度学习相结合,通过建立基于情感混淆程度的决策树SVM 框架,使用DNN提取瓶颈特征用于训练SVM分类器。与SVM和DNN-SVM相比,平均识别率分别提高了6.25%和2.91%,一定程度上解决了随着情感类别增加而识别率下降的问题。

表16 基于混合模型结构的SERTable 16 Hybrid model structure based SER

5 跨语料库语音情感识别方法

以往大多数SER研究都是基于同一语料库的,训练数据和测试数据具有相同的分布。为了提高模型的泛化性能,研究者利用不同来源的数据库分别训练和测试模型,然而由于各种数据库的文化背景,语言和分布模式等不同,这不可避免地导致了情感识别率的下降,进而阻碍SER技术的推广。由于需要考虑的因素众多,因此跨语料库SER成为了极具挑战性的研究,众多研究者主要针对如何减小跨库数据分布差异进行了广泛的探索。以下从传统方法和深度学习方法两方面来阐述跨库SER 研究进展和所存在的问题。文献[83]较早研究跨库SER,提出了说话人归一化,数据库归一化以及说话人和数据库都一化来处理数据库之间的差异。迁移学习是跨库研究中常用的方法,将一个语料库获得的信息迁移至另外一个语料库,克服两库失配的困难,其中研究较多的迁移学习方法为域适应方法。文献[84]提出基于特征迁移学习方法,利用最大均值差异和降维算法,旨在寻求源库和目标库之间的邻近低维特征空间。文献[85]提出域适应最小二乘回归模型,结合目标库无标签数据和源库有标签数据共同训练模型,且在损失函数中加入正则化约束来减小两库之间的分布差异。

近年来,由于深度学习的突出表现,研究者利用领域自适应方法结合深度学习进行跨库SER 研究。对于跨库SER,模型的泛化能力尤其重要,由于深度信念网络(deep belief network,DBN)具有较强的泛化能力,文献[86]研究基于DBN 在5 个情感语音数据库上的迁移学习,结果优于稀疏自动编码器和SVM的研究工作,另外还发现将一部分目标领域数据用来扩充训练数据,识别率显著提高。最近,有研究者提出利用领域对抗训练神经网络来提取训练域和测试域的通用表示[87]。文献[88]基于领域对抗神经网络进行跨库维度情感预测,创建了可区分的特征表示,缩小了源域和目标域特征空间的差距。当来自目标领域的标记样本很少时,少样本学习可用作解决方案,因此,文献[89]提出基于少样本学习和无监督域适应的跨库语音情感识别方法,该方法训练从源域样本中学习情感相似性并适应目标域。实验结果表明所提方法可以有效提高跨库SER 的性能。当目标样本较少时,文献[90]研究利用生成对抗网络合成样本作为额外训练数据的效用,然而生成对抗网络难以训练。最近基于Transformer 的SER 研究逐渐增多,但未见将其用于跨库SER的相关研究,与之前的方法相结合研究跨库SER是将来的一个方向。

6 语音情感识别的应用

SER在工作、娱乐和日常生活等场景下的应用较为广泛,以下列举了部分应用领域。

在医疗护理领域,SER系统的应用及时反馈患者和医务人员的情绪状态,可以优化治疗过程改善医患关系[91]。在航空、航天及航海等特殊环境下,航天人员与地面通信中应用SER技术,侦测焦虑与烦躁等应激性情绪苗头,利于地面心理专家及时进行疏导[92]。

在教育领域,对网络课堂学生学习过程中的情绪状态进行跟踪识别,老师根据反馈结果调整教学进度,针对不同的学生形成个性化的教育[93]。在服务领域,检测客服人员以及客户的情感激烈程度并采取相应措施,提升服务效率和服务质量[94]。

在娱乐领域,交互式电影中运用语音情感识别,提升观影者的参与度[95]。云游戏投入市场,运用包括SER在内的多模态情感识别技术来根据玩家的游戏体验情绪对游戏本身进行调整[96]。在影视领域,识别音乐情感与电影的氛围进行匹配以及为动漫电影人物配音[97]。在文化领域,通过识别戏剧情感并结合观众的反应,提升戏剧情感表现力[98]。

在交通领域,对于下一代智能交通[99],自动驾驶车辆的车载SER系统结合5G技术可以根据用户的指示及结合智能交通系统进行安全驾驶,对自动开关窗,导航等方面为乘客和驾驶员提供个性化的体验。在音频信息检索方面[100],可以使用SER 技术对音频内容及某些片段进行所需要情绪信息的检索。在对老人的关注方面,可用陪护机器人与老年人进行交流谈话,关注老年人的身心健康[101]。

7 语音情感识别的结论与展望

SER技术通过几十年的研究发展,拓宽了许多应用场景,从以下几方面可以看出其存在的问题以及发展方向。

第一,缺少通用的情感描述模型。情感定义没能达成共识,现存情感描述模型多样,研究人员只能根据研究目标进行选择,一定程度上限制了结果对比。从不同情感模型的演化过程可以发现,情感的表示一方面从简单地将情感分类为积极和消极到逐步演化为更复杂细微的情感表示方向发展,另一方面,也正在从离散的情感特征标签向连续长期的维度情感度量方向深化。

第二,缺乏规模与质量兼备并能够通用共享的自然情感语音数据库。现存数据库数量多,规模较小,并不通用,研究人员按研究目标各自选择不同的库,为研究成果的比较设下了障碍。首先可以进行跨库、跨语言合并高质量语料库,但各库的建库标准及建库方法不同,将各库进行组建可能会存在问题,因此需要研究一个泛化性的方案。针对跨库SER,迁移学习的研究还不够充分,可将其他模态如文本和视频的知识迁移到跨库研究中,同时研究减小负迁移带来的影响。针对现有高质量语料库,使用数据生成技术,在基础上扩充。另一方面,结合科研人员,心理专家以及标注公司的努力,确立统一泛化性的记录方法、建库标准、标注标准以及数据库质量评价标准。

第三,探索与情感强相关的特征。针对已提出的情感特征,探究优化方式和特征最优数量,融合优化显著特征,构成情感语音最优特征集合。融合同一深度网络不同层信息以及融合不同深度网络学习到的不同深度特征的方法也是值得深入研究的。对于跨语言、跨库研究,找到普适特征,发掘情感特征通用性,是未来的一个研究方向。

第四,缺乏可解释性的深度神经网络。深度学习的出现给SER 的研究带来了很大的变革,加速了其发展,但是深度神经网络作为典型的“黑箱”算法,最终的分类结果是如何得出的,在“黑箱”中发生了什么,网络的具体实现却不易描述,为了更好地理解为SER研究所设计的深度网络,需要探索内部细节,构建解释能力强的深度神经网络来促进SER发展。

第五,SER 研究没有进一步从脑科学、认知科学等学科的研究成果中得到启示。现有的SER 研究只是将其作为模式识别问题,对人脑情感信息内在处理机制深入分析利用的研究还处在初级阶段,情感的复杂性以及心理学,脑科学和认知学等各学科的发展水平还不足以建立起模拟人脑情感处理机制的模型。因此,还需要结合各学科的发展共同致力于这一交叉研究。除此之外,结合脑科学、生理学学科研究表达的情感与经历的情感之间的差异,并建立一个通用模型是未来的一个研究方向。

第六,缺少对语音情感数据隐私保护的研究。现代是万物互联的时代,可将SER 系统集成到物联网中,语音情感处理系统放在云端,但语音数据被上传到服务器并进行处理时,可能会泄露私人敏感信息,而导致收集不同来源的数据受限,对构建有效的SER模型可能造成挑战,为应对该问题,有研究者提出基于联邦学习的隐私保护SER模型[102],但该方面的研究还比较少。