面向电力服务情绪识别的图卷积网络方法研究*

盛 妍朱龙珠丁毛毛刘鲲鹏刘海龙

(国家电网有限公司客户服务中心,天津 300309)

情绪识别(sentiment recognition)是人机交互驱动的电网智能服务平台中的一项基础技术,对于平台的提质提效,降低人工成本有重要意义[1-2]。情绪识别本质上是一项文本/语音序列分类技术,指利用语音分析、文本挖掘等技术对含有主观情绪特征的文本/语音序列进行判断,识别出序列中的情绪状态,并作为后续任务的输入,如智能服务质检、对话生成等[3-4]。在电力语音服务场景中,通过情绪识别,可以根据用户的情绪状态及时区分出需求较为紧急的咨询,特别是具有投诉倾向的用户来访,对系统提供解决方案,如接入人工服务等措施具有重要参考价值,能有效降低人工负担,提升用户满意度。

情绪识别是一类具有强上下文相关特征的典型自然语言处理(natural language processing,NLP)问题[5]。传统的情绪识别技术通常使用循环神经网络(recurrent neural network,RNN)及其各类变体结构如长短期记忆(long short-term memory,LSTM)网络或门控循环单元(gated recurrent unit,GRU)等刻画文本中的上下文关系[6-7]。尽管LSTM 与GRU 等模型在训练效率和处理序列长期依赖等方面对RNN 有所提升,但这类模型本质上依然只能对较简单的线性上下文依赖建模,局限性较为突出。针对这一问题,本文将近年来备受关注的图深度学习技术引入情绪识别问题,提出一种基于图卷积网络(graph convolutional network,GCN)的情绪识别方法。利用图结构更为强大的表示能力,GCN 可以刻画对话中更复杂的上下文结构,提升情绪识别的准确性。

1 相关研究

对话交互过程中的情绪识别一直是自然语言处理领域的热点问题,在语音服务、在线教育、推荐系统等领域有广泛应用。主流的针对文本的情绪识别方法一般基于RNN 处理范式,将对话简单地视为句子的连续序列,通过RNN 神经元依次地传递上下文关系。LSTM和GRU 等RNN 的改进版本本质上依然遵循这一规则,此类模型仅关注语句之间的局部关系,但忽略了对话的全局主题以及对话中更复杂的上下文结构[8]。

随着人机交互方式多样化程度的提升,近年来对这一问题的研究开始关注结合多重特征(语音、文本、视觉特征等)的多模态情绪识别,在视频客服平台中有丰富的适用场景[9]。另一方面,将知识图谱系统,特别是特定领域知识库引入情绪识别技术也具有较大应用潜力,这使得系统能结合领域背景知识,更为精确地判断用户的情绪特征[10]。

2 情绪识别问题

上下文关系模型是情绪识别中的核心问题之一,对话中的上下文通常可分为两种情形:顺序上下文(sequential context),即说话者自身发言的上下文结构,反映说话者自身的情绪依赖;对话上下文(speaker context),即对话双方(或多方)的发言互相产生的影响,反映对话各方之间的情绪依赖[11]。本文将从这两个角度处理对话文本的上下文关系。需要注意的是,由于对话发生的场景是自动语音客服系统,因此对话上下文中实际上只需关注一方。可以预见,将这两种不相同但紧密相关的上下文模型结合起来,可以得到语义信息更为丰富的上下文表示,从而更好地理解对话中的情绪状态。

2.1 问题定义

本文主要研究中文文本分析中的情绪识别问题。情绪识别在电力智能客服平台这类自动情景中较为常见,属于自然语言处理中的文本分类问题,即给出一段文本的语义信息,输出其类别(情绪标签)。将语句S表示为词语序列S={s1,s2,…,sM},其中M表示句子长度,令ei(1 ≤i≤N)为可选的情绪标签集,则情绪识别可以表示为极大似然估计问题

由于对话涉及多个文本,因此(1)式中的条件概率实际上还需考虑上下文,即p(ei|S1,…,S_T)。如上文所述,由于本文研究的场景比较特殊,尽管处理方式基于对话文本,但可以只关注用户一方的情绪识别问题。

3 情绪识别的图卷积网络方法

3.1 词特征提取

为了将文本转换成易被计算机处理的形式,首先在词语级别提取文本的向量特征。本文以常用的文本卷积网络(TextCNN)作为特征提取器[12-13],在历史对话文本数据集上依次使用大小为50,3,4,5 的卷积核,得到词语的100 维向量表示用于后续的情绪识别模型训练。

3.2 上下文编码器

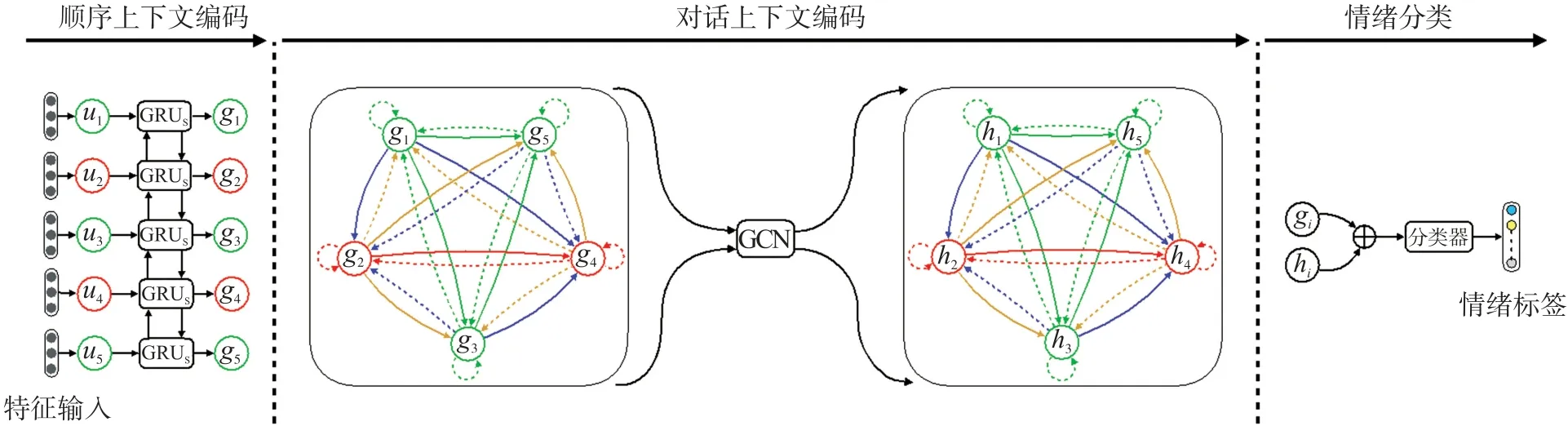

如图1 所示,本文涉及的基于图卷积网络的情绪识别模型分为三个模块:顺序上下文编码器,对话上下文编码器与情绪分类器。

图1 基于图卷积网络的情绪识别模型框架

3.2.1 顺序上下文编码器

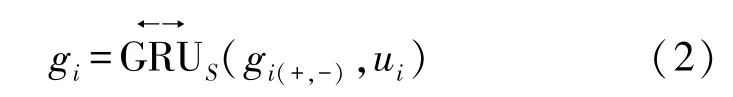

顺序上下文指的是对话中任意一方的发言自身的上下文关系结构。对于对话中的一方来说,所有发言呈简单的线性顺序结构,因此上下文信息也沿该顺序传递。本文用门控循环单元(Gated Recurrent Unit,GRU)来捕获对话中的顺序上下文信息

式中:ui表示句子中上下文无关的基本语言要素(如词汇或短语),gi表示经GRU 提取的蕴含了上下文语义信息的ui特征向量。根据自然语言处理与时间序列分析领域中的常用处理方法,本文使用了双向的GRU 结构,用表示,从而gi的生成同时依赖于前后若干个基本语言要素(用gi(+,-)表示)[14]。

3.2.2 对话上下文编码器

由于对话上下文结构涉及了对话中的不止一方,文本中的上下文关系也不仅仅再局限于简单的线性依赖,而是呈现出更复杂的网络结构,因此本文提出从图的观点对对话上下文结构建模,以同时刻对话中说话方的自我依赖与相互依赖。如图1 所示,对话中任意一方的自我依赖在图中用结点指向自身的自环表示,相互依赖则用结点之间的有向边表示。这里依然采取同时考虑时间上的双向依赖的方式,图1 中用实线边表示后向依赖(即对未来发言的依赖),用虚线边表示前向依赖(即对过往发言的依赖)。

基于图结构建立文本之间的上下文依赖关系后,文本表示gi将通过图卷积网络得到含有图结构信息的新表示向量hi。

3.3 图卷积网络

本文用有向的带权图G=(V,E,W)表示含有N个基本语言要素的图,包括结点vi∈V,表示依赖关系的有向边eij∈E,αij∈W表示边的权值。

3.3.1 结点的表示

对话中的每个ui都对应图中的一个vi,初始状态时,vi直接使用顺序上下文编码器中训练得到的特征向量gi进行初始化。GCN 通过特征变换过程,不断把结点邻域(即一定范围内相邻的结点)的特征与当前结点特征做混合计算,从而使任意结点都能学习到一部分图结构信息[15-16]。

3.3.2 边的表示

边集合E直观地体现了ui之间的依赖关系。假设要考虑任意两个ui之间的依赖,则G将构成完全图,即每两个结点之间都有边连接,此时边的数量为O(N2),当文本量较大时,计算成本将非常昂贵。更具实用性的做法是只考虑当前结点对表示前后固定时间窗口内ui的结点依赖关系,本文将时间窗前后步长都设置为10。

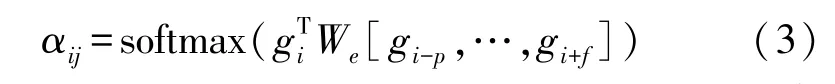

尽管直观上看边的存在性已经足以刻画文本中的上下文依赖,但自然语言处理领域的经验表明,等值依赖在效率和实际效果上都有很大的局限性。因此本文引入注意力机制[17]对图中的边赋予一定权值。对于过往时间窗口p与未来时间窗口f,当前结点连接窗口内各结点的边的权值为

式中:softmax 函数确保αij满足和为1 的内在约束条件。

3.3.3 特征变换

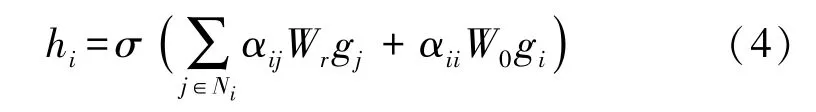

GCN 中基于特征变换过程将图的结构信息引入结点的特征向量。如图1,对于结点vi,通过汇聚局部邻域结点的特征得到hi:

式中:σ表示卷积网络中的激活函数,如sigmoid 或ReLU 函数。Ni表示邻居结点集合,通常取2°或3°内的相邻结点。括号中的两项分别表示根据权值汇聚邻居结点的特征与保留当前结点自身的特征(通过图中该节点上的自环)。Wr与W0是该过程中需要通过训练得到的权值参数,可全部初始化为1/|Ni|。

3.4 情绪分类器

情绪分类器部分接收的输入由顺序上下文编码器输出的特征gi与对话上下文编码器输出的特征hi拼接而成,即gi⊕hi,“⊕”表示向量的拼接。为提升效果,拼接时依然对各个维度乘上注意力权值。分类器的实际结构采用全连接的神经网络,最后根据softmax 函数在各个输出结点(对应不同的情绪标签)的最大值给出分类结果。

4 实验结果与讨论

4.1 实验设置

实验中使用的数据集采集自国网某客服中心基地2019 年内的部分语音对话数据,其中来自人工服务与智能语音服务的样本约为4 ∶1。数据中用户的情绪被划分为7 个级别,表示用户的投诉倾向或满意度。

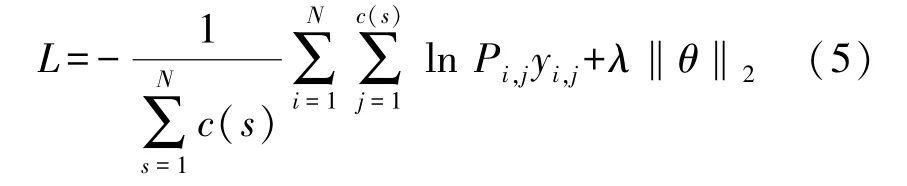

实验在一台搭载一块NVIDIA GeForce RTX 2080Ti 图形处理器的计算机上进行。GCN 的优化基于Adam 优化器,目标函数用带L2正则化项的交叉熵(categorical cross-entropy)损失函数表示为[18-19]

式中:N为样本数,c(s)为第s个样本中的词/短语数,Pi,j与yi,j分别表示第i个样本的第j个词/短语的情绪标签的真实类别与模型预测类别,λθ2为L2正则化项,θ为GCN 的参数集合,λ为正则化系数。实验中用测试集上各个类别的平均F1 指标(F1-measure)值,即精确率(precision)与召回率(recall)的调和平均值来衡量模型的实际效果。

4.2 实验结果

4.2.1 邻域结点范围

图2 给出了随着GCN 中用于汇聚图结构信息的邻域范围增大(用最远结点到中心结点的度数表示),F1 指标值的变化。图中当邻域大小为0 时,说明实际上没有将相邻结点的特征汇聚到当前结点,即忽略了文本的图结构,此时的情绪识别模型是一般的卷积神经网络分类器。根据图相关模型中的经验,一般取2°或3°邻居即可充分地使结点学习到图结构信息,图2 中的结果也符合这一经验。实际上模型在取4°内邻居结点时效果最优,当邻域继续扩大时模型性能反而下降,说明出现了过拟合现象。但需要注意的是,由于数据量较大,即使只增加一度的邻居结点,计算负荷的增长也是非常可观的。综合模型的效率与性能考虑,本文建议离线模型采用3°或4°邻域训练,线上模型采用2°或3°邻域执行。

图2 模型性能随邻域大小的变化曲线

4.2.2 模型性能比较

本文将结合了顺序上下文与对话上下文的GCN 情绪识别模型与几种流行的情绪识别技术进行比较:(1)卷积神经网络(CNN);(2)文本卷积网络(TextCNN);(3)长短期记忆网络(LSTM);(4)结合注意力机制的长短期记忆网络(Att-LSTM);(5)对话记忆网络(conversational memory network,CMN)模型[20];(6)DialogRNN 模型[21]。模型效果对比见表1。显然,本文提出的基于GCN 的情绪识别模型在总体指标上优于其他模型,且在各个类别上的性能都较稳定。

表1 模型性能对比

图3 给出了将本文模型最终训练得到的文本表示gi⊕hi经t-SNE 算法[22]降维并聚类后的效果。图中结点的大小反映了结点的度数,权值较低的边被舍弃。可以直观地看出基于GCN 的模型最终在各个类别上都得到了较好的文本表示,从而将同一类情绪标签的文本聚在一簇。

图3 文本特征向量聚类

5 结束语

针对电力智能服务平台中的情绪识别这一基础问题,本文提出一种基于图卷积网络的情绪识别模型。模型综合考虑了对话中的顺序上下文与对话上下文两类上下文结构,并创新性地提出了使用图模型来表示对话上下文结构中复杂的上下文依赖关系,从而能借助图卷积网络更好地表征文本中的语义信息,实现更为准确的情绪识别。实验结果表明,本文模型在情绪识别任务上相比其他主流模型性能更优,对建设更为智能的电力服务平台有一定实际意义。