数据受限条件下的多模态处理技术综述

王佩瑾,闫志远,容雪娥,李俊希,路晓男,胡会扬,严启炜,孙显

1.中国科学院空天信息创新研究院,北京 100190;2.中国科学院大学电子电气与通信工程学院,北京 100049;3.中国科学院空天信息创新研究院网络信息体系技术科技创新重点实验室,北京 100190

0 引 言

模态是事物的一种表现形式,是对事物某特定角度的描述。多模态通常包含两个或者两个以上的模态形式,是指从多个视角出发对事物进行描述。人们在感知世界时,多种感官总是同时接收外在信息,如看见图像、听见声音、闻到气味和触摸感知等。随着多媒体技术的发展,可获取的媒体数据在种类和量级上都大幅提升。例如,传感器不仅可以生成图像或者视频,还包含与之匹配的深度、温度信息等。为使人工智能技术更好地解译数据,必须使人工智能具有多模态学习的能力。

在人工智能技术的早期研究中,学者通常使用单一模态的数据。受到人类感知方式的启发,研究认为每个模态对事物的描述具有相对独立性,使用多模态数据的互补表述能够使事物呈现更立体、表现更全面(Baltrušaitis等,2019)。近年来,多模态数据的处理和应用成为重点研究方向,在情感分析、机器翻译、自然语言处理和生物医学等前沿方向取得了重要突破。计算机视觉是深度学习的重要应用领域和热点研究问题,本文重点围绕多模态在计算机视觉领域的发展进行介绍。

如图1所示,计算机视觉领域内的多模态学习主要是通过对图像、视频等多模态数据进行分析,学习并互补不同模态间的信息,实现图像检测识别、语义分割和视频动作预测等任务(Liu 和Wang,2015;Eigen和Fergus,2015),并广泛应用于自动驾驶、农业监测、生物医疗、交通管理和灾难预测等领域。如在医学领域,医学影像作为医疗诊断的重要依据,相较于单角度描述病灶特征的图像,多模态医疗影像能有效辅助医生从多个层面联合判断病灶及其周边部分,加快诊断时间;在遥感领域,单传感器依据设备特点从某种固定的角度描述地理目标,独立分析时会受到成像原理限制,而对不同成像方式、不同传感器获取到的多模态遥感影像进行分析,可以有效提取地物目标的综合信息。

图1 多模态数据受限解决方法及应用

尽管多模态数据在描述事物特征时有着明显的优势,但目前仍面临着较大的挑战。1)虽然成像技术层出不穷,但其同步带来的图像、视频数据的处理和标注任务有着不容忽视的工作量,需要耗费较多的时间成本和人力资源。2)传统深度学习模型需要将多模态数据匹配成对用于研究,任一模态的缺失都会造成可用数据的减少。3)由于使用目的是利用多模态互补的特性,因此对数据内部的完整度要求较高,但受到不同成像设备和传感器的限制,数据量少、质量模糊和缺失现象严重,这些现象都会对后续的研究造成不利影响。因此,在数据受限的前提下进行的多模态处理研究具有重要的现实意义。

面对以上的难点问题,根据多模态样本数量、标注信息和样本质量等不同的维度,目前处理多模态数据受限的方法主要分为以下几类:

1)小样本学习方法。在多模态数据不足的情况下,小样本学习方法仅通过学习少量样本就能做出正确判断的认知能力,在数据量匮乏的情况下仍能够有效地学习目标特征。

2)缺乏强监督标注信息的方法。由于数据标注过程会产生高额的成本,较难获取所有模态的全部真值标签对模型进行强监督学习。常见的非完全监督的方法有基于弱监督、无监督、半监督和自监督的学习方法,这些方法可以有效改善模态缺乏标注信息的问题,大大减少人工标注成本。

3)主动学习方法。该类方法通过设计具有自主学习能力的模型,将人类经验与学习规则充分结合,致力于研究如何使用标注尽可能少的样本来获得尽可能较好的效果。通过选择最有用的样本,可以在保持性能的同时有效降低标注成本。

4)数据去噪方法。在多模态数据的获取和处理的过程中,外界环境和设备内部因素都可能会引入噪声。任何模态的数据受到噪声污染都可能会影响多模态数据处理的结果。多模态数据去噪是指减少数据中的噪声,恢复原始数据,进而再提取感兴趣的信息。

5)数据增强。在样本较少的前提下,为进行有限多模态数据的充分利用,数据增强方法通过对原始数据集进行一系列变换操作,扩张数据的可使用性。

本文主要对数据受限下的多模态数据处理方法进行综述。已有研究者对相关领域进行了研究,在多模态学习、小样本学习、弱监督学习、主动学习、数据去噪和增强等方面进行了深入研究。Baltrušaitis等人(2019)从整体的角度探讨了多模态机器学习的进展,并对多模态机器学习方法进行分类,但没有介绍具体的应用场景。Wang等人(2020b)从网络架构的角度介绍了多模态模型,但没有讨论多模态数据本身的特点。Ramachandram和Taylor(2017)对多模态深度学习现状进行了总结,并提出网络体系结构的设计应该考虑融合模式、模态信息和对缺失的数据或模态的处理,但没有详细综述目前处理缺失数据以提高模型的鲁棒性的方法。Gao等人(2020)总结了具有代表性的处理异构数据的深度学习网络架构,并认为一些深度学习模型只关注单模态噪声数据,未来迫切需要解决针对低质量多模态数据的深度学习模型。上述综述缺乏对数据受限条件下多模态数据发展的详细介绍。Wang等人(2021c)综述了近年来小样本学习方法的进展,并进行统一分类。Zhou等人(2019)综述了弱监督学习的一些研究进展。Settles(2011)回顾了将主动学习应用于实践遇到的挑战,并介绍为解决挑战所做的工作。但上述文献都仅基于单模态数据进行总结,并没有关注多模态数据背景问题。

针对在数据受限条件下多模态数据处理面临的各种挑战和难题,已有研究者提供了一些解决思路,但是尚未形成相关的综述文献。因此,本文总结了数据受限条件下多模态分析处理的研究方法和进展,以及多模态数据在不同领域的应用情况。首先阐述了多模态数据在计算机视觉方向的研究现状与数据受限的难题挑战,介绍了对不同数据受限情况的处理方法,展示该研究的背景和目的。然后分类阐明不同数据受限处理方法的现状与研究方法,区分不同的受限情况所面临的困难和挑战。最后对多模态数据的各个应用领域的典型数据集进行介绍,总结目前的研究成果,能够启发未来多模态的应用前景,展望下一步研究方向。

1 多模态数据的应用

首先介绍了多模态数据融合的方法,然后介绍了多模态数据在计算机视觉领域常见的应用场景。

1.1 多模态数据融合处理

多模态数据融合是多模态数据挖掘的一种基本方法,旨在将不同分布、来源和类型的数据整合到一个全局空间中,在这个空间中,多模态和跨模态都以统一的方式表示(Bronstein等,2010;Bramon,2012;Poria等,2017)。

根据融合过程是否直接与模型相关可将多模态数据融合方法总结为两类:基于模型的方法和模型无关的方法。前者利用模型显式地解决多模态融合问题,主要包括图像模型方法(Song等,2012;Yang等,2017)、基于核的方法(Gönen和Alpaydn,2011;Liu等,2014;Wen等,2017;Wang等,2021d)和神经网络方法(Jin等,2017;Plis等,2018;Ortega等,2019;Gao等,2020)等;而后者不直接依赖特定的深度学习方法,因而灵活性更高,并可进一步分为早期融合、晚期融合和混合融合(Tompson等,2015)。模型无关的3种融合方式如图2所示。早期融合方法主要基于特征,包含特征层面和数据层面的融合,在对各个模态提取特征后其立即将得到的特征集成。晚期融合又叫做决策级融合,其集成操作发生在每种模态得到输出结果(如分类或回归)之后,主要采用不同的规则(如平均值融合、集成学习等规则)将不同模态的输出结果进行组合(Morvant等,2014;Liu等,2018)。混合融合(Joze等,2020)是早期融合和晚期融合的一个结合体,虽然综合了两种融合方法的优点,但也带来了如模型结构复杂度高和训练难度大等劣势。

图2 多模态特征融合的3种方式

一些多模态数据融合方法被提出,以探索模态之间的互补和跨模态信息。如Kettenring(1971)提出了用于线性多模态关系以及跨模态泛化信息的多模态典型相关分析。Martínez-Montes等人(2004)提出了多变量的偏最小二乘模型线性关系,从多源数据集中发现变量。Groves等人(2011)提出了一种多模态独立成分分析,这是一个使用贝叶斯框架的概率模型,将每个不同模态的独立变量结合起来。

上述传统的多模态数据融合方法仅限于高容量、高速度、高多样性和高精度的多模态数据,原因是它们基于浅层特征,无法捕捉到多模态数据中的内在内部结构和外部关系(Li等,2019b;Zhang等,2015)。因此,对隐藏在多模态和跨模态中的融合表示进行全面建模,可以进一步提高各种多模态应用的性能。

深度学习作为一种分层计算模型,可学习数据的多级抽象表示(Tompson等,2015),有利于充分挖掘多模态数据中隐藏的有用信息。这些基于深度学习的多模态方法在语言翻译、图像注释和医疗辅助诊断等各个领域都取得了一些进展。例如,Hou等人(2018)提出了一种多模态语音增强框架,用于捕获音频和视觉信号中的多模态特征。Abdulnabi等人(2018)设计了一种多模态循环神经网络(recurrent neural network,RNN)来标记室内场景,其中 RNN和变换层学习了多模态特征和跨模态特征。Narayanan等人(2019)使用多模态传感器数据设计了门循环单元来模拟驾驶员行为。Sano等人(2019)提出了一种多模式BiLSTM(bidirectional long short-term memory)来检测动态睡眠,其中 BiLSTM 用于提取从可穿戴设备收集的数据的特征。Madhuranga 等人(2021)通过从深度序列中提取轮廓,然后将深度信息与音频描述融合以进行日常生活活动识别。

通过利用特定于模态的信息,多模态数据融合可以提供比单一模态更丰富的信息(Biessmann等,2011;Wagner等,2011)。并且通过不同模态之间的互补学习,许多有价值的隐藏信息得到有效挖掘。如何设计合理的模块有效融合多模态数据,如何最大程度地挖掘不同模块互补提供的隐藏宝贵信息,是现阶段多模态数据挖掘关注的一个重点与难点。

1.2 多模态数据检测识别

图像分类指的是计算机可以识别图像所属的“类别”。本质上是为图像分配一个标签,例如,“汽车”、“动物”和“建筑”等。在分类技术的基础上延伸出了目标检测技术,它允许计算机在图像或视频中识别和定位目标。通过这种识别和定位,目标检测可以用来计算场景中的目标数量,确定并跟踪它们的精确位置,同时准确地标记。检测识别技术作为计算机视觉中的重要技术,已经应用到如行人重识别、场景识别和人体动作识别等多模态数据场景下的任务中。

行人重识别(person re-identification,Person Re-ID)是跨设备的特定人员检索问题。目的是确定感兴趣的人是否在不同的时间出现在另一个地方、由不同的摄像机拍摄。RGB—红外跨模态行人重识别作为一个子领域,在24小时智能监视方面取得了很大进展,Wan等人(2021)等最新研究也在不断推进该领域的进步。

场景识别要求机器能识别出给定数据中出现的场景,在机器人领域有着广泛的应用,是计算机视觉研究中的一项基本问题。当RGB和深度图像两种模态被结合分析处理时(Ferreri等,2021),深度图像提供了有用的几何信息,补充了RGB纹理信息,并帮助识别有区别的场景图像特征。

人体姿态识别是指识别图像或视频中人类的动作和姿态,这也是计算机视觉研究领域的一个热门研究方向,它在诸如应用监控、人机交互、健康监控和智能系统等领域都有着重要的作用。采用单模态数据进行人体动作识别往往无法取得很好的效果,在多模态人体动作识别中来自不同传感器的多模态融合(Imran和Raman,2020)能够很好地进行模态间信息互补,从而提升识别的准确度。

1.3 多模态图像语义分割

图像语义分割是指根据图像的语义为其每个像素分配类别标签。具体来说,在进行图像分割的过程中,每个像素归类到某一个标签下,归属于同一标签的像素在视觉特性上具有某些共同点。同样,该技术也在如道路场景分割、医学图像分割和遥感图像分割等多模态数据场景中得到了广泛应用。

道路场景分割在计算机视觉中有着重要的应用,例如自动驾驶和行人检测。与室内场景相比,由于动态和复杂的环境,道路场景分割更具挑战性。室外环境很容易在不同的时段随光线或颜色的变化而变化。现有的室外场景语义分割的数据集和方法大多基于RGB图像,而将深度图像、激光雷达、偏振图像(Zhang等,2019b)等多模态数据的融合能丰富同一场景的互补特征信息,从而更好地完成复杂环境的场景分割任务。

医学图像分割通过对解剖结构和其他感兴趣区域进行提取,在许多医学成像应用中起着至关重要的作用。肿瘤分割是医学图像分割中的一个典型应用。肿瘤分割表示对肿瘤空间位置的正确识别,是放射组学分析中的一个重要步骤,它将原始医学图像转换为可以提取的图像。准确的肿瘤分割模型对于肿瘤的早期诊断和放疗安排至关重要。与基于单模态的方法相比,多模态数据的应用可以使模型获得更好的性能(Li等,2021),原因是不同的成像方法可以捕获更多关于肿瘤的信息。

遥感图像分割的任务主要是利用语义分割技术自动提取对地观测数据中的地物要素信息,例如植被、水体等。遥感数据通常是从各种卫星传感器(如光学、激光雷达和红外等)获取的数据。但对于同一场景,成像方式、分辨率和视角等因素都会使图像中的目标特性产生差异。使用多源的遥感图像可以综合利用不同传感器的特性,更加精准地提取地物要素(Audebert等,2016)。

1.4 多模态数据预测估计

在深度学习领域,预测估计是一个重要的应用方向,经过训练的深度学习模型可以根据输入的数据对当前或未来的某些状态或参数进行估计或预测。在多模态数据预测估计领域,诸如单目深度估计、3维人体姿态估计和路径规划等技术都已经得到了广泛的应用。

单目深度估计是从2维图像推测场景几何结构的关键步骤,其目标是通过RGB图像预测每个像素的深度值。深度估计对于机器人技术和计算机视觉任务中的许多挑战至关重要,包括3维重建、自动驾驶和场景理解等。

3维人体姿态估计是指从图像或视频中估计人体关节点位置,往往需要依赖RGB-D(RGB-Depth)(Zhang等,2019a)、RGB-LiDAR(Fürst等,2021)等多种模态的数据。由于3维人体姿态估计在人体运动分析、人机交互和机器人等诸多领域的广泛应用,近年来在计算机视觉领域引起了越来越多的关注,是一项具有挑战性的任务。

路径规划是机器人自主导航的基本能力。随着深度学习技术的快速发展,基于模仿学习的路径规划方法取得了良好的效果。然而,这些方法有两个缺点:1)训练数据集的准备耗费大量时间和人力;2)现有方法大多只能接收高级命令,如左转/右转。这些命令对于移动机器人的导航不够充分,因为移动机器人需要获取目标更精确的姿态。因此,提出了一些基于自监督的目标导向路径规划方法(Wang等,2021a),通过RGB-D等多源传感器采集多模态数据,并将其应用于路径规划中。

2 多模态数据受限的处理方法

本文根据多模态样本数量、标注信息和样本质量等不同的维度,将目前处理多模态数据受限的方法主要分为小样本学习方法、缺乏强监督信息的方法、主动学习方法、数据去噪和数据增强方法。

2.1 小样本学习方法

小样本学习的目的是从少量标记的样本中学习具备泛化能力的模型。在过去的几年里,针对多模态视觉领域的小样本学习提出了很多方法,大致可以分为基于传统学习的小样本学习方法、基于元学习的小样本学习方法、基于迁移学习的小样本学习方法和基于度量学习的小样本学习方法,如表1所示。

表1 多模态领域不同小样本方法总结

基于传统模型的方法通过应用不需要大量训练数据的传统模型来解决小样本任务,但通常需要特定的手工设计,泛化能力不强。基于元学习的方法将经典的元学习理论加以运用,以小样本任务为基本训练单位学习任务间共有的特性,其对新任务的适应能力强,但通常计算复杂度高。基于迁移学习的方法将在辅助数据集上学习的知识迁移至新的小样本任务中,实现简单但有时迁移效果不佳。基于度量学习的方法则是学习数据间的度量函数,进而完成小样本条件下的匹配问题。

2.1.1 基于传统模型的小样本学习方法

基于传统模型的方法通过引入不需要大量训练样本的传统模型来解决深度学习模型在数据稀缺情况下产生的过拟合问题。

在深度学习发展之前,传统方法在解译多模态数据领域取得先进的进展,主要操作为人为设计提取特征,然后使用支撑向量机、多层感知器、决策树和随机森林等模型对提取的特征进行处理,输出最终判别结果。这些传统模型不需要大量数据进行训练,因此可以在小样本条件下完成多模态数据的处理与分析。为了提升传统方法在小样本学习中的性能,主要在提取特征的设计以及模型算法的改进等方面进行了广泛研究。

Wan等人(2013)提出了一种融合RGB-D数据的3维增强运动尺度不变特征变换(3D enhanced motion scale-invariant feature transform,3D EMoSIFT),该特征具有丰富的视觉表示,并且具备尺度不变性和旋转不变性。在学习判别模型时,从训练样本中提取特征并进行K-Means聚类,利用模拟正交匹配追踪技术将每个特征表示为少量编码的线性组合,实现较小的重构误差。Belgacem等人(2015)提出了手势签名的特征描述,由RGB-D数据的光流推导出手势的全局运动的位置、速度和方向,并结合隐马尔可夫模型的建模能力和条件随机场的判别能力对提取的特征进行判别。Lin等人(2016)提出了一种融合RGB-D数据的自适应局部时空特征(adaptive local spatiotemporal feature,ALSTF),利用灰度和深度信息自适应地提取运动感兴趣区域,提升了手势识别的精度。Lin等人(2019)将深度学习方法与经典的实例分割方法(Lin等,2018)相结合,使用卷积神经网络提取的特征取代传统方法中的人为设计特征,并利用单样本学习的思想解决训练样本容量小的问题。

此外,还有一些工作在模型算法上进行改进。Pang等人(2021)提出了一种基于稀疏RGB-D输入的人体渲染方法,该方法只在关键帧上进行训练,通过双分支模型分别编码RGB图像和深度信息。Wang等人(2021b)使用一个短视频序列RGB-D图像构建相关的手网和目标网,以重建物体形状缺失的部分,并估计重建目标与场景中可见物体之间的相对变换,实现从单一视频序列判断目标与手的相对姿态。

2.1.2 基于元学习的小样本学习方法

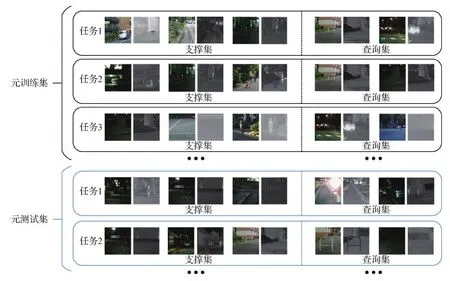

元学习又称为学会学习(Vilalta和Drissi,2002),即利用先前学习的知识指导新任务的学习。基于元学习的小样本学习方法预先在一个数据量比较丰富的基本数据集上定义大量的小样本任务,如图3所示,每个任务都包含支撑集和查询集,并以任务为单位对模型进行训练,使模型能够快速地适应当前的小样本学习任务。

图3 基于元学习的小样本学习方法数据集构建方式

近年在深度学习领域涌现出许多元学习方法理论。Andrychowicz等人(2016)基于循环神经网络提出一个带有可学习参数的优化器,其根据当前模型参数的梯度信息和隐含状态输出需要更新的步长以对模型参数进行优化。Ravi和Larochelle(2017)将深度学习模型的梯度下降优化策略看成是一个长短期记忆网络的状态更新,隐含态是损失函数梯度,输入门和遗忘门为损失函数梯度、损失函数、参数值和先前输入门的函数。MAML(model-agnostic meta-learning)(Finn等,2017)使用支撑集对模型初始参数进行一步或多步更新,然后使用在测试集上的损失更新初始参数,其致力于构建一个适合于许多任务的内部表示作为初始化模型,使得参数的少量变化就可以对新任务带来大幅度的性能提升。针对MAML中二阶导计算复杂度高的问题,Nichol等人(2018)提出一种基于一阶梯度下降的更新算法Reptile,其认为不同的小样本任务的参数梯度方向是相近的,因此跳过了支撑集和查询集的划分过程,直接使用各个小样本任务的数据进行参数更新。

随着元学习方法的不断进步,许多基于元学习的小样本学习方法应用到多模态领域。Shao等人(2020)提出了基于单样本目标检测的学习框架,包含目标检测网络和运动策略网络。前者基于元学习,将视频序列的第1帧和最后1帧作为支撑集,其余序列的RGB图像作为查询集,预测出目标的任务相关语义关键点;后者根据检测出的关键点和深度信息进行运动估计。Yeh等人(2021)提出了基于阶段意识的注意力网络(stage conscious attention network,SCAN),在少量的RGB-D样本中检索知识,使用共享的卷积网络提取支撑集和查询集中的RGB-D数据特征。然后对支撑集特征使用双向长短期记忆网络(long short-term memory,LSTM)融合时间信息,并设计了一个注意力模块识别不同时间戳下的重要帧,将重要帧的特征融合到查询集的特征中,结合末端切片的嵌入特征一起送入后续的解码器输出动作姿态。董阳等人(2020)提出基于U-Net的原型网络PU-Net对多模态图像进行分割,首先使用PU-Net对支撑集数据提取原型特征,然后利用提取的原型对查询集数据进行逐像素分类,并针对类别数量不均衡问题,提出自适应权重交叉熵损失。Bao等人(2021)构建了可见光和热图像(visible and thermal,V-T)的小样本语义分割数据集Tokyo Multi-Spectral-4i,利用可见光和热图像两者的互补信息来提高小样本语义分割的性能。提出边缘相似度融合模块和纹理边缘原型模块,前者利用可见光图像和热图像的边缘相似性融合双模态信息,后者从可见光特征和热图像特征中提取原型用于查询集的语义分割。

2.1.3 基于迁移学习的小样本学习方法

与元学习中构建大量小样本任务进行训练不同,基于迁移学习的小样本学习方法直接在数据量丰富的源域数据集上训练,通过知识迁移技术将在源域数据集学习到的知识迁移至新的小样本任务,提升模型在数据量少的目标域数据集上的性能。

李瑶(2019)认为融合多个模态的数据可以改善由于样本数量少导致的分类精度低的问题。进而提出了融合两种不同分辨率遥感影像的分类方法,使用卷积神经网络提取这两种模态数据的特征,并构建串行和并行融合策略进行特征融合和分类;此外还利用迁移学习技术,将在ImageNet数据集(源域)训练好的模型的前几层参数固定,修改最后的一到两层参数,再用少量目标域的遥感数据进行微调,达到较好的分类效果。Bessadok等人(2021)提出基于图的多轨迹进化网络GmTE-Net来对婴幼儿的脑连接组发育情况进行预测,使用教师—学生范式处理多模态磁共振图像(magnetic resonance image,MRI),教师网络对新生儿MRI脑图进行学习,并使用小样本数据训练以提升泛化性能。学生网络在一组不同时间点采集的模拟脑图上学习。为了提升学生网络的性能,提出局部拓扑感知的蒸馏损失约束学生网络图拓扑与教师网络图拓扑的一致性,从而将教师网络在MRI脑图数据学习的知识迁移至学生网络对模拟脑图的学习。

2.1.4 基于度量学习的小样本学习方法

度量学习是在映射空间中学习适当的距离度量函数,使得相同类别的样本距离更近,不同类别的样本距离更远,如图4所示。这些方法主要使用常见的距离(如曼哈顿距离、欧氏距离等)的倒数或余弦相似度的变体来表示特征之间的相似度。

图4 基于度量学习的小样本学习方法示意图

Kori和Krishnamurthi(2019)提出了一种图像配准方法,使用卷积网络对一组静态的和动态的多模态磁共振图像MRI提取特征,并在特征维进行关键点提取,并使用多种距离度量(如Dice分数、结构相似性和均方误差等)实现多模态图像之间的配准。Zhang等人(2021)扩展了以RGB数据为主流的方法,利用深度信息进行互补,提出一种基于度量学习的双流深度神经网络,分别在RGB和深度空间中学习每个类别特定的原型表示,并计算输入数据和原型的余弦相似度,将得到的RGB和深度信息的概率进行融合得到最终预测结果。Chaudhuri等人(2020)通过一种深度表征学习技术,提出了多流编码器和解码器模型,在彩色图像和素描图像两个模态数据之间学习关系映射函数,解决了彩色图像和素描图像之间的零样本跨模态图像匹配问题。Ao等人(2019)提出了一种零样本手写字符识别的跨模态原型学习方法从打印字符中学习识别手写字符,通过深度网络提取打印字符的特征,同时使用循环神经网络学习手写字符的特征,根据两个特征之间的距离预测识别手写字符。Memmesheimer等人(2021)将RGB-D骨骼运动信号编码成图像,并使用深度残差网络提取特征,利用三元损失学习特征嵌入,将动作识别问题转化为嵌入空间中的最近邻搜索。Yang等人(2020)认为简单地将不同模态的图像(如可见光和热图像、打印字符到手写字符等)映射到均匀空间的过程,未知类的流形特征不可避免地会发生变形,这直接导致了跨模态图像检索性能较差,因此提出双向随机遍历方案,通过遍历每个模态特征空间中的异质流形挖掘图像之间更可靠的关系,从而缓解跨模态特征空间中噪声相似点带来的干扰,实现更准确的度量匹配。

2.2 缺乏强监督标注信息的方法

近年来,人工智能技术发展迅猛,研究人员不再局限于使用单一模态的数据对模型进行训练。通过融合多个模态的信息对模型进行训练将会更准确和更具鲁棒性。但是由于数据标注过程会产生高额的成本,获取所有模态的全部真值标签对模型进行监督学习具有局限性。因此,使用非完全监督学习的深度学习方法具有广泛应用前景。多模态领域中的非完全监督学习指的是使用包含部分/不包含真值标签的两种或多种模态的数据集对模型进行训练,其与多模态领域内的强监督学习的区别如图5所示。圆形和五角星表示两种模态的数据,红色、蓝色和绿色表示具有真值标签的不同类别的数据。灰色表示没有真值标签的数据,带条纹的表示数据具有粗粒度标签,空心的表示无标签数据具有算法自构造的监督信息,实线表示类之间的决策边界。

图5 5种多模态非完全监督深度学习策略

弱监督学习作为机器学习领域的一个分支,其训练数据分为3类(Zhou,2018):不完全标注数据、不确切标注数据和不准确标注数据。不完全标注数据指的是部分数据包含标注,另一部分数据不包含标注的数据集。对于没有标注的数据,若存在一个系统能够给出正确标签,即具备查询功能,则属于主动学习范围;其他对没有标注的数据进行处理的属于半监督学习范围。不确切标注数据指的是训练数据提供图像级的标签、涂鸦级标签或包围框级标签。不准确标注数据指的是样本的标签具有不正确内容。在本节中,多模态领域内的弱监督学习主要对训练数据是不确切标注数据的方法在2.2.1小节进行介绍,多模态领域内的半监督学习在2.2.2小节进行介绍。自监督学习和无监督学习中训练数据都不具备人工标注的标签,分别在2.2.3和2.2.4进行介绍。无监督学习对数据内部的潜在特征进行挖掘;自监督学习通过构建辅助任务,从大量无监督数据中挖掘自身的监督信息,通过这种构造的监督信息对网络进行训练。本节着重于对多模态领域内的弱监督学习、半监督学习、自监督学习和无监督学习进行介绍,多模态领域内的非完全监督学习模型总结如表2所示。

表2 多模态领域内的非强监督学习模型总结

2.2.1 多模态领域内的弱监督学习

随着数据驱动的深度卷积神经网络的发展,减少标注工作量的问题越来越受到关注。弱监督学习指的是模型使用图像级标签、涂鸦级标签或包围框级标签等不确切标签的训练数据对模型进行训练。通过使用不确切的标签对模型进行训练,可以大大减少人工标注成本。多模态领域内的弱监督学习针对于RGB-D、RGB-Lidar、RGB-IR等多种图像模态融合方式进行研究。

多模态学习方法目前广泛应用于RGB-D目标识别领域。这些多模态模型的网络结构通常包括针对于RGB和Depth模态数据的两个网络模型,通过在最后的全连接层进行融合,然后开始联合训练。但是在RGB图像上进行预训练的模型难以很好地学习深度数据,所以大多数方法通过颜色映射将深度模态转换为RGB模态或低级特征,以适应在RGB数据集上预先训练的深度网络模型。Sun等人(2017)提出了一种新颖的弱监督学习架构,网络直接在原始深度图上进行训练,通过使用许多自动生成的合成深度图像来预训练深度,不需要代价高昂的数据转换(从深度到RGB),使得深度信息得到充分利用。然后,该团队继续提出针对于核废料目标检测的神经网络结构,将参数模型(用于RGB和Depth模态的多模态模型)与非参数高斯过程分类相结合(Sun等,2019)。Li等人(2021)通过协调多模态输入,通过迭代细化来维护每个像素的伪标签以实现弱监督RGB-D显著性目标检测。

除了使用RGB-D图像进行融合,Fürst等人(2021)提出了使用RGB和Lidar数据的端到端架构,在3维人体姿态估计任务中取得了较好的成绩。Chen等人(2018)关注于视频中的信息,使用RGB-IR数据,提出学习一个基于记忆网络的策略模型。通过在视频中利用光流提取运动信息,可以提取出对应于人体运动的候选前景运动片段,以图像和运动先验作为模型输入并预测人体分割结果,获得了良好性能。Hu等人(2018)提出多模态变分自编码器,利用专家相乘前向网络和子采样训练,解决多模态推理问题,使用的数据是磁共振(magnetic resonance,MR)图像和术中经直肠超声图像,实现弱监督多模态图像配准。

2.2.2 多模态领域内的半监督学习

多模态领域内的半监督学习指的是通过使用有标签数据和无标签数据混合而成的两种或多种模态的数据对模型进行训练(Zhu和Goldberg,2009)。一般来讲,无标签数据比有标签数据具有更高的比例。本文主要集中于对采用RGB-D两种模态作为训练数据的半监督模型进行介绍。多模态领域内的半监督学习可以分为基于伪标签的半监督学习和基于一致性正则的半监督学习。

由于数据标注成本高,半监督学习是一项具有挑战性但又十分重要的任务。解决这个问题的一种常见方法是给未标记的数据分配伪标签,然后在训练中使用伪标签作为额外的监督,基于伪标签的半监督方法流程如图6所示。

图6 基于伪标签的半监督学习方法流程

通常伪标签是通过对标记数据进行训练的模型获得的,然后使用模型进行自训练。在目标识别领域,Cheng等人(2016)提出了一种半监督多模态深度学习框架,核心是基于一种新颖的多样性保持协同训练算法,通过充分利用目标表示中RGB和深度数据的互补信息,成功地引导扩散图卷积网络(diffu-sion convolutional recurrent neural network,DCNN)从未标记的RGB-D数据中学习。在3维目标检测领域,Tang和Lee(2019)首次提出在没有强监督标注的情况下训练基于点云的可迁移半监督3维目标检测模型。他们使用跨类别半监督学习,其中一组目标类需要3维真值标签,而所有目标类都需要2维真值标签。作者采用重投影损失、检测框先验损失和框对点云拟合网络, 使有用的3维信息在训练过程中有效地从强类传输到弱类,从而在推理过程中检测出弱类中的3维目标。此外,Xiong等人(2021)提出了一种用于视频学习的多视图伪标签方法,这是一种利用外观和运动信息形式的互补视图进行视频半监督学习的新框架。该方法采用RGB、光流和时间梯度的形式,对单个未标记视频片段学习多个互补视图,并使用一个共享模型进行半监督学习。

在遥感领域,大量的多模态对地观测图像,如多光谱图像(multispectral image,MSI)或合成孔径雷达(synthetic aperture radar,SAR)数据,可在全球范围内公开使用,从而能够通过遥感图像对全球城市场景进行智能解译。然而,由于包含噪声的采集环境以及经过高质量标注的训练图像数量有限,多模态数据在地物要素提取方向的发展仍然受限。Hong等人(2020)研究了有限跨模态数据的遥感半监督迁移学习问题,提出了一种新型的跨模态深度学习框架,称为X-ModalNet,包含3个模块:自对抗模块、交互学习模块和标签传播模块,通过学习利用大规模MSI或SAR数据将小尺度高光谱图像中更多的可判别信息转移到分类任务中。作者在两个多模态数据集上进行了大量的实验,表明了提出的X-ModalNet在RS数据分类任务中的有效性和优越性。

2.2.3 多模态领域内的自监督学习

多模态学习主要集中于对多种模态及其复杂的相互作用进行研究,目的是利用多模态数据中出现的互补信息,产生更鲁棒的预测(Wang等,2014;Gao等,2019;Liang等,2019;Xu 等,2017)。研究人员使用自监督学习的方式进行跨模态学习发展迅速(Tian等,2020;Jing等,2020;Meyer等,2020;Shi等,2020;Jiao等,2020)。Mahendran等人(2018)学习像素嵌入,使像素嵌入之间的相似性与它们的光流向量之间的相似性相匹配。Han等人(2020)提出一种新的自监督学习方法,改进了InfoNCE损失函数的训练机制,利用来自RGB和光流的互补信息来学习视频表示,在视频动作识别和视频检索方面取得了优异的性能。Liu等人(2020)提出对比“点像素对”,训练网络能够区分正负样本数据,为了提取有用的特征,模型必须学习模态之间的协同关系。

可行驶区域和道路的分割是实现机器人自主导航的关键能力。Wang等人(2019)提出了一种自监督学习方法,模型以RGB图像和深度图像作为输入,首先生成自监督标签,然后使用这些标签训练基于RGB-D数据的语义分割神经网络。运行时,配备RGB-D摄像机的机器人轮椅可以对可行驶区域和道路进行在线分割。

虽然RGB-IR跨模态行人重识别(RGB-IR ReID)在24 h智能监视方面取得了很大进展,但目前的技术水平仍然主要依赖于对ImageNet预训练网络的微调。Wan等人(2021)提出了一种自监督的预训练替代方案,直接在多模态ReID数据集上从头开始训练模型。MMGL将RGB-IR图像随机全局映射到共享的排列空间中,并通过最大化循环一致的RGB-IR图像块之间的一致性来进一步提高局部可判别性。

现有的基于卷积神经网络的RGB-D显著性目标检测网络都需要在ImageNet上进行预训练,然而,大规模数据集的采集和标注耗时且昂贵。Zhao等人(2021)利用自监督表示学习(self-supervised representation learning, SSL)设计了跨模态自编码和深度轮廓估计任务,只需要少量且未标记的RGB-D数据集进行预处理,这使得网络可以学到丰富的语义上下文信息并减少两种模态特征之间的差距,从而为下游任务提供有效的初始化。

几何特征提取是点云配准的重要组成部分。监督学习方法对真值标签的依赖限制了其可扩展性。El Banani 和 Johnson(2021)提出了一种自监督方法,可以从RGB-D视频中学习视觉和几何特征。BYOC结合了点云配准的经典思想和最新的表示学习方法,与当前最先进的监督方法相比,同样具有竞争力。

场景识别在机器人领域应用前景广泛。深度信息可以为RGB图像补充纹理信息,并帮助识别场景图像特征。基于此,Ferreri等人(2021)首次研究了一个集场景识别、多模态学习和领域适应3个任务于一体的模型,引入了一种新颖的自适应场景识别方法,可以学习模态之间的自监督转换。进而可以在多个相机的数据上联合训练,有助于拟合提取的特征分布之间的差距。

2.2.4 多模态领域内的无监督学习

由于无标注数据获取容易,多模态领域内的无监督学习集中于对领域自适应、语义分割和图像到图像的转换等方向的研究。

Jaritz等人(2020)首次研究自适应在多模态场景的2D/3D语义分割方面的工作。输入多模态数据,即RGB和LiDAR,提出了跨模态无监督域自适应,通过KL(Kullback-Leibler)散度实现模态间的相互模仿,各模态可以互相学习以提高性能。Loghmani等人(2020)提出了一种新的RGB-D 无监督域自适应方法,表明了通过利用RGB和深度模态之间的互补减少合成图像到真实图像的域转移,可以获得更好的结果。在语义分割领域,Chen等人(2019)提出主要由两个神经网络组成的框架:用于风格传递的多模态图像迁移网络和用于图像分割的级联分割网络,实现无监督LGE图像分割。

无监督图像到图像的转换是计算机视觉中一个重要而具有挑战性的问题。给定源域中的一幅图像,目标是学习目标域中对应图像的条件分布。Huang等人(2018)提出了一个多模态无监督图像到图像转换框架,将图像表示分解为域不变的内容编码和目标域特定属性的样式编码。为了将图像转换到另一个域,将其内容编码与从目标域的样式空间中采样的随机样式编码进行重组。通过对不同类型的编码进行采样,模型能够产生不同的、多模态的输出。

2.3 主动学习方法

为了提高对已有的人工标注数据的利用效率、最大程度减少标注工作量并将专家经验与各种学习算法充分结合,除了上述提到的减少对带标注样本依赖的小样本学习和弱监督学习之外,研究者们还通过一些技术手段或者数学方法来降低样本标注的成本,这个方向称为主动学习(active learning, AL)。

小样本学习和弱监督学习相关算法流程的执行不需要跟人类进行交互,通过利用已有标注数据训练得到的具有一定分类性能的网络来实现对无标签样本的自动标注,基于自身对无标签数据加以利用以提高模型的泛化能力。而主动学习的关注点在于如何利用尽可能少的样本来保持跟用大量样本训练得到的分类器相当的性能。更具体地说,主动学习的目标是从无标签样本集中选取出对提升模型性能价值最大的样本,并将其交给相关专家进行标注,以在保持模型性能的同时尽可能地将样本标注成本最小化(Budd等,2021)。这是一种从样本的角度提高数据利用效率的方案,因而应用在标注成本高、标注难度大等任务中,例如医疗图像(Wang等,2020c;Budd等,2021)、异常检测(Zhu和Yang,2019;Russo等,2020)以及基于互联网大数据(Faisal等,2014;Jahan等,2018)的相关问题。主动学习的整体思路为:借助机器学习或深度学习的相关算法来获取有助于提高模型性能但分类器易错分的“困难”样本数据,交由相关专家再次进行审核、确认或标注,然后采用有监督或半监督的学习算法对前一步骤得到的专家标注的有价值数据再次进行训练,通过重复上述过程逐步提升模型性能,从而将专家经验整合到模型的学习中。

早在21世纪初,主动学习就已用于多模态领域。主动学习在多模态领域的应用场景是:针对各个模态存在的大量无标签数据,选择有价值的数据进行标注以节省标注工作量从而使得模型用较小的成本达到满意的性能。

依据每次访问无标签样本的不同,主动学习方法可以划分为两个主要的框架:基于流的选择性采样和基于池的选择性采样。两者主要区别在于,基于池的采样评估整个无标签样本集,然后选择最好的一个;而基于流的采样则逐个查询数据,逐个做出决策。其中,基于池的采样是最常见的场景,并且由于深度学习基于batch训练的机制,使得基于池的方法更容易与其契合;而基于流的选择性采样由于其自身存在的诸如采样效率不高、阈值设置烦琐等缺点,用于多模态数据的研究很少,故本文不再对该方法进行介绍。

在基于池的场景中,首先输入批量的无标签数据,然后根据策略选择某些样本交给专家进行标注。Bonnin等人(2011)提出了一种基于主动学习策略的深度图像中人体部位检测方法。其中,主动学习策略是利用训练数据的分布,从数据集的基于聚类的表示中进行取样。目标是通过减少标记样本的数量来建立一个精确的分类器,以使训练计算成本和图像标记成本最小化。Jalal等人(2017)描述了一种适用于连续RGB-D视频的方法,该方法利用活动的时空信息并结合主动学习方法对活动进行时间分割。然而,在真实环境中采集的视频数据通常是无标签的数据,而这些未标记的数据在无监督的环境中识别率很低,并且人为地向这些数据添加属性标记的成本很高。针对这一问题,Wang等人(2018)提出了一种采用无监督主动学习的方法从RGB-D视频数据中识别人类行为的新方法。Bullard等人(2019)调查了如何使主动学习模型在动态变化的环境中推理其学习目标,使用决策理论的方法进行主动学习,使用RGB-D数据集用于评估。为了创建一个更接近真实世界的学习环境,模拟了多模态特征,这些多模态特征表示从机器人的其他传感器中提取的特征。Zhang等人(2021)提出了第1个通过学习样本数据的标记过程,对RGB-D显著性检测引入不确定性的随机框架。为了评估模型的性能,采用主动学习的流程来生成简单和困难样本。基于池的主动学习方法在多模态数据下的流程可总结为图7所示。

图7 多模态数据下基于池的主动学习事例

在多模态数据下应用主动学习将加快每个模态的标注进程,有利于控制数据标注成本并获得较为理想的训练数据。相较于传统的对多个模态的所有数据都进行标注的方法,主动学习能够挑选有价值的数据进行标注,从而排除一些冗余数据、噪声数据的干扰,有助于在保持甚至提升模型性能的同时减轻多模态数据下对大数据的依赖。

2.4 数据去噪方法

随着计算机视觉技术的不断发展,各种形式的数字图像与人们的生活、工作和学习紧密结合起来。但图像在采集、处理和传输等过程中都极易受到噪声的污染,导致图像的质量受损,重要信息无法准确识别和获取,进而干扰人们后续对图像信息的提取和分析。

随着采集设备逐渐丰富,各种多模态数据来源的涌现和数据处理方法的创新层出不穷,专注于各个领域的多模态任务也都不断取得更好的结果。但目前学者进行的大量研究是基于数据集无噪的理想前提下进行的,实际上,在图像的获取和处理的过程中,外界环境和硬件设备内部都可能会引入噪声。在多模态任务中,任何一方数据受到噪声污染而造成的质量受损都会影响最终结果,因此,对含噪多源数据的处理研究需求十分迫切,具有重大研究价值和实际意义。

图像数据中的噪声一般指妨碍有用信息的孤立像素点,通常以不必要或多余信息的形式出现,对原始图像的视觉效果产生不利影响。在各类图像处理任务中,噪声的存在通常会干扰模型性能,任务实现效果与无噪声的情况相比显著下降。例如,合成孔径雷达对于灾害监测等任务具有良好的观测效果,但受到特殊成像机制的限制,合成孔径雷达观测到的图像会受到相干斑噪声的影响,加大了图像解译的难度。

随着多媒体和计算机技术的兴起,数字图像的获取和采集形式日益丰富。但通过传感器等设备采集到的图像,会受到采集时刻所对应的天气环境、所使用的设备硬件的影响,从而引入噪声。并且图像在正常的传递过程中,也会因一次或多次的压缩、解压进程而降低其本身的清晰度。通常存在于图像中常见的噪声主要包括高斯噪声、泊松噪声和椒盐噪声(脉冲噪声)等,如图8所示。噪声的存在对图像的现实应用造成了不利影响。例如,在医学影像中,医疗设备的成像机理可能导致采集的患者样本图像中存在噪声,而在大多数医学多模态任务中需对多源图像进行配准,图像中的噪声会在一定程度上影响配准效果,使医生不能对患者的病症进行综合评估。在遥感图像中,多传感器会提供相同地区内不同空间和光谱分辨率图像,从不同的成像视角丰富细节信息,但含噪的模糊图像会降低数据的可靠性和可用性,甚至出现图像畸变。图像去噪是旨在对受到噪声干扰的图像进行恢复,使其还原至真实干净的图像,从而有利于提取其重要特征信息的过程。因此,使用恰当的方式对含噪图像进行清洗、重建,将得到的干净图像应用于任务,能够更有效地辅助学者进行相应研究。

图8 3种类型的噪声图

目前,针对多模态异构图像数据的去噪方法在国内外的研究相对较少。自然世界中噪声来源广,对于不同领域、不同设备采集的图像而言,其受噪声干扰的程度也有差异性,图像内部的噪声称为特征噪声。

对于特征噪声的处理研究出现较早,方法较为丰富。常见的去噪方法可归纳为基于滤波的去噪方法、基于偏微分的去噪方法、基于字典和稀疏表示的去噪方法、基于低秩矩阵的去噪方法和基于深度学习的去噪方法等。多模态领域内的去噪方法总结如表3所示。

表3 多模态领域去噪方法总结

由于当更多的研究开始注重将去噪算法用于多模态图像和视频等数据集时,应用于单一图像、特定领域的去噪算法本身已经有了较为成熟的进展和体系,因此在进行多模态数据去噪时,学者更倾向于同时使用多种方法,以将不同算法的优势相结合,获得更优的去噪效果。

2.4.1 基于滤波的去噪方法

域滤波基本上可以划分为空间域和变换域两类。空间域去噪是选择合适的滤波器对图像矩阵中的像素点及其邻域内的点进行计算,直接进行滤波操作。常用方法例如均值滤波、维纳滤波等。这种方法易于理解,运算方便,但由于滤波器固定,每一个像素点进行的处理相同,因此忽略了图像内部的相似性和差异性,重要特征和边缘信息容易被平滑。变换域滤波包含傅里叶变换、小波变换和多尺度变换等方法。变换域滤波能够将原图像转换到另一个域,依据在该域中呈现的内部差异性,使用某种计算方式过滤噪声,再对其进行逆操作恢复至原域图像。

变换域去噪方法具有一定的有效性,但由于变换域的特点,图像边缘易模糊。Lewis等人(2007)采用双树复小波变换对红外和可见光图像进行联合或单独的特征分割,以抑制图像中的不相关部分及噪声。Achim等人(2005)在多尺度小波域中,提出了基于分数低阶矩的方法,应用于磁共振图像和计算机断层扫描(computed tomography,CT)图像。Scheunders和De Backer(2007)使用一种基于贝叶斯小波的多分量图像去噪方法,为遥感领域多传感器生成的图像和医学领域中不同的医疗图像提供了多成分图像的处理和去噪思路。Loza等人(2010)提出了基于小波系数非高斯统计建模,在红外和可见光图像对、高光谱图像对和人脑磁共振两种模态的图像对上进行了测试,其去噪表现优于传统去噪方法。

域滤波主要是针对图像中的每个像素点进行操作,忽略了像素点的周边信息,使图像中的内在关联性不能较好体现。许多学者对图像中的重复区域,即自然图像的非局部自相似性(non-local self-similarity,NSS),进行了相关去噪算法的研究。

2.4.2 基于偏微分的去噪方法

为了改善滤波去噪的过程中同时平滑了边缘信息和重要特征的问题,许多学者对基于偏微分的去噪方法进行了研究,该途径通过数值计算方法对上述问题进行弥补。Wang等人(2008)提出了一种像素域和小波域的变分模型,在多焦点图像集合上进行测试,其中像素域使用全变分模型(total variation,TV)作为降噪的正则化约束方法,全变分模型是图像去噪领域的重要算法之一。Kumar和Dass(2009)也使用了全变分模型,并在医疗领域和飞机导航领域提供的两种模态图像上取得了优秀结果。但为了抑制全变分模型极易产生的阶梯效应(Chan 等,2010),Zhao和Lu(2017)采用变分模型,同时利用多尺度交替序列滤波器,在含有噪声的输入图像中提取有用特征。该方法在CT和MRI多模态医学图像上进行了测试,结果提升了鲁棒性,能够有效地抑制阶梯效应。

2.4.3 基于字典和稀疏表示的去噪方法

稀疏表示(sparse representation, SR)是用基信号来表示图像中的多维信号。使用完备和丰富的字典,具有比传统的图像转换方式更有效揭示图像特征的能力。由于图像基本上都具备一定的稀疏性,稀疏先验是近年来图像领域重要的先验信息之一,并已广泛应用于人脸识别、图像去噪等方向。字典学习可以将图像中有用的信息以合理的稀疏形式表示,近似认为含噪声的图像是由无噪图像和噪声组成,无噪图像可以稀疏表示,而噪声是不可稀疏表示的,因此可以通过稀疏编码的方式对无噪图像进行稀疏重构,将重构图像和原始图像间的残差进行消除就是去噪的过程。

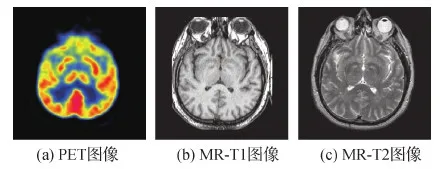

一些研究采用正电子发射型计算机断层显像(positron emission computed tomography,PET)等医学图像对(如图9所示)、红外和可见光图像对以及多焦点图像对作为多模态测试数据,Yang 和Li(2009)首次将稀疏表示引入多模态图像的处理中,提出了使用超完备字典对多焦点图像进行稀疏表示的去噪方法。为了更加关注局部信息,Yang和Li(2012)使用小尺寸字典对图像中重叠区域进行稀疏表示,而不是面向全局。同时为使多源图像分解为相同的字典库子集,使用了同步正交匹配追踪技术(simultaneous orthogonal matching pursuit,SOMP)。Yu等人(2011)提出了一种新的联合稀疏表示对多源图像去噪。Yin等人(2013)基于稀疏表示,提出了一种超分辨率的框架,更完整地重建原始图像。Iqbal和Chen(2012)联合训练低分辨率和高分辨率图像的双字典,更好地保留了图像内的边缘信息并消除伪影。Liu等人(2014)提出基于SR的自适应稀疏域选择(SR with adaptive sparse domain selection, SR-ASDS)方法,大量高质量图像块根据梯度信息分类,按类别训练相应子字典,该方法比单一字典方法更有效和稳定。Liu和Wang(2015b)提出了一种用于同时多模态图像融合和去噪的自适应稀疏表示模型。在该模型中,可以根据源图像的噪声强度调整重建误差。Jiang和Wang(2014)使用了两本不同的词典来表示图像细节。

图9 多模态医学图像

以上方法都是基于图像块的稀疏表示,没有过多考虑图像内在的结构。为了更好地关注全局信息,Li等人(2012)使用了基于组的稀疏表示(group-based sparse representation,GSR)方法,提出组稀疏化和图正则化的字典学习,并将组稀疏表示用于图像去噪。

2.4.4 基于低秩矩阵的去噪方法

低秩矩阵关注整幅图像内部的局部相关性,利用矩阵中的内在关系更好地挖掘图像全局的结构信息,能够有效去除噪声,利于原图的恢复重建。Li等人(2019b)提出了一种基于低秩和稀疏成分分解的方法应用于多模态医学图像,对稀疏分量施加系数约束,增强了粗略尺度上的细节,但模糊了精细尺度的细节。为了改善以上问题,Li等人(2020)将输入的噪声图像分解为粗略尺度和精细尺度两个分量,从损坏的数据中恢复精细尺度的细节,在CT和MRI的医学图像对、红外和可见光图像对和多焦点图像对上进行了测试。

2.4.5 基于深度学习的去噪方法

随着卷积神经网络等深度学习框架不断在图像特征提取等领域取得优秀结果,其学习训练样本的内部特征并做出预测的强大优势得到广泛关注,其在图像去噪方向的研究也有较大优势。Eitel等人(2015)在卷积神经网络的基础上提出改进的双流结构,分别学习颜色和深度信息,并设置人工噪声训练深度学习网络,在RGB-D数据集上有效提高了识别精度。Nobis等人(2019)针对毫米波雷达和电荷耦合器件(charge coupled device,CCD)摄像机两种模态的图像提出了新的网络结构,自动决定最有利的融合方式,并且受Dropout层(Srivastava等,2014)启发,提出新的训练策略BlackIn,提高了传感器存在噪声情况下的目标检测精度。

由于数据集的获取途径日益丰富,对于研究人员来说可用的数据量逐渐庞大,在进行有监督学习任务时,需要与之对等的数据标注工作。无论是通过人工标注还是软件分析,都不可避免地出现样本标注错误的情况,因此,用于训练和测试的数据集中会含有一定数量的标签噪声。与特征噪声不同,一幅图像可以有大量特征,而仅有一个标签,因此,对于需要大规模数据作为输入支撑的深度学习任务来说,准确的标签是保证网络模型鲁棒性的重要支撑。

对于单源图像来说,标签噪声的处理大多基于监督学习方法进行的模型训练,因此可将其对应的去噪方法归纳为对标签本身的处理、对网络结构的处理、对损失函数的处理。但目前在多模态任务中对于标签噪声的专门处理研究较少。如Ye和Yuen(2020)在行人重识别任务中构建了具有鲁棒性的深度网络模型PurifyNet,调整并重用标注错误的标签,采用硬感知实例重加权策略,提升了模型的有效性。

2.5 数据增强

由于某些样本的稀缺性或采集成本过高,并不总能够收集到体量足够的样本集。在样本数足够多的情况下,也可能因为数据质量差的原因影响模型性能,导致模型陷入过拟合的状态。过拟合状态下模型的泛化能力会明显下降。因此,已经有许多正则化技术运用在模型设计中,如Dropout(Srivastava等,2014)、BatchNormalization(Tompson等,2015)等。除了这些基于模型架构的技术之外,还有一项技术从根源出发直接针对数据集本身进行操作,即数据增强。

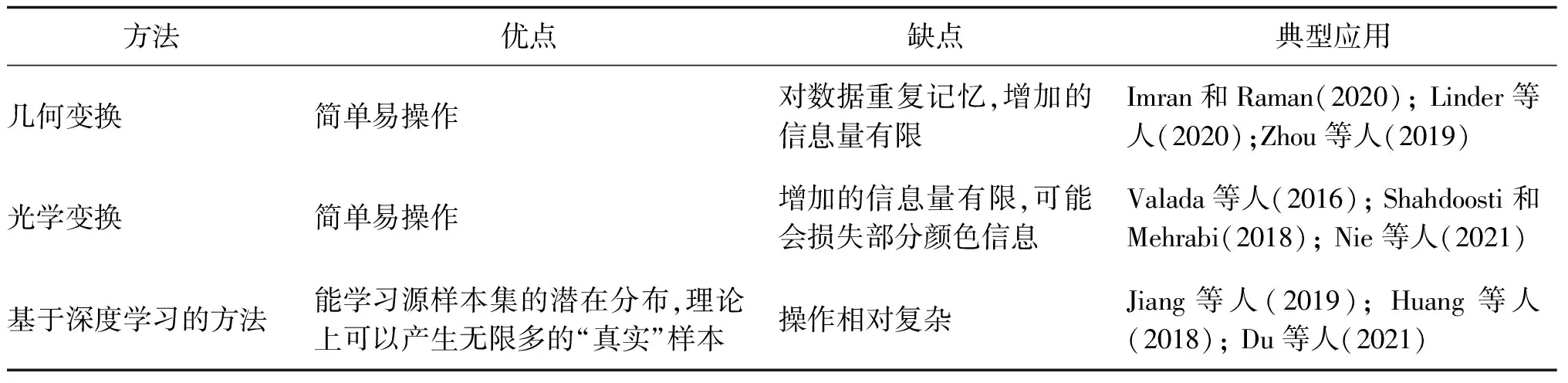

数据增强是一种增加数据丰度的方法,能有效提高模型的泛化能力和解决类不平衡的能力,旨在从现有的有限数据出发,扩展其数量并生成更具多样性的数据。马岽奡等人(2021)和Kaur等人(2021)的两篇综述对数据增强方法进行了较为全面的概述和分类。综合这两篇论文对数据增强方法的概述,并结合多模态图像数据分析处理中数据增强技术的应用,可以将多模态数据下常用的数据增强方法分为3类:几何变换、光学变换和基于深度学习的方法,如表4所示。本文将从以上3个方面对多模态数据分析处理中的数据增强方法进行介绍。常用的几何变换和光学变换样例如图10所示。

图10 常用的几何变换和光学变换样例

表4 多模态领域不同数据增强方法总结

2.5.1 几何变换

几何变换是较为基本的图像操作,同时也得到了广泛的应用,其包括但不限于旋转、缩放、翻转、裁剪、填充、平移和仿射变换等,通过特定规则的映射改变图像中像素点的坐标。假设原图中的像素点坐标为(x1,y1),将其映射到坐标(x2,y2),就能获得一幅新的图像。只要改变基本坐标,就能够获得更多的数据,在这幅图像和类似图像上训练的模型将获得更多的特征,并且可以获得更好的效果。

一类方法采用固定的变换策略。Imran和Raman(2020)结合RGB-D图像和惯性传感器数据进行人体动作识别,并对原始图像采用3种策略分别生成3幅增强图像,其中两种策略使用不同尺寸裁剪并缩放至224×224像素,另一种则直接缩放至224×224像素;Zhang等人(2019b)使用了RGB图像、偏振图像等多种模态融合进行道路场景语义分割,并采用旋转和翻转的方法进行数据增强。

另一类方法根据特定应用场景对基本变换进行改进或设计了新的变换方法。Linder等人(2020)发现标准2D裁剪/扩展增强不适用于深度数据,提出了一种几何上更精确的深度感知裁剪增强算法,用于RGB-D数据的训练,有利于提高3D定位精度;Quintana等人(2019)提出了一种基于光线投射实现的3D-2D投影的方法,用于人脸标志点检测的数据增强;Salehinejad等人(2018)提出了一种基于极坐标系中径向变换的图像增强采样方法,可以生成原始图像中最多像素数的径向变换图像,以增强数据的多样性。Li等人(2019a)针对RGB-D数据提出了两种数据增强策略:复制—转换—粘贴合成策略和原始位置增强策略。第1个策略将RGB-D数据中的前景目标复制出来,对该目标进行2维旋转、缩放、遮挡和截断等变换,然后将变化后的目标融入到背景场景中。Wan等人(2016)基于RGB-D数据提出了一种时空特征,即基于稀疏关键点的混合特征,该特征对尺度、旋转和部分遮挡具有鲁棒性和不变性,并且为了缓解训练样本不足的问题,通过人工合成不同时间尺度的数据来增加训练样本。Wang等人(2018)将拍照姿态改变、光照变化和位置平移等方式让有限数据中的一些属性和特征改变,从而生成具有不同变化的新样本,并通过端到端方法共同训练生成模型和分类算法。

还有一类方法对一系列变换方法进行随机组合选取。Zhou等人(2019)针对RGB-D数据的目标识别任务提出了MSANet(multimodal self-augmentation and adversarial network),并使用了两个阶段的数据增强,在第1个阶段的类无关数据增强中,定义了一系列变换,将变换序列表示为T={t,s,r,c},其中t表示采样块的垂直和水平变换;s是一个用于控制采样块大小的比例因子;r给出了训练样本的旋转角度;c将样本块从RGB颜色空间转换为HSV颜色空间。

2.5.2 光学变换

光学变换主要通过图像光学空间内的调整对图像进行增强。光学变换是基于图像颜色成分的变化对图像的像素值进行修改,而不是改变像素点的坐标。光学变换增强包括更改图像中的亮度、对比度、色调、饱和度和噪声等。Valada等人(2016)对使用多光谱和多模态图像进行语义分割的方法进行了研究,并开发了从RGB、近红外和深度数据中学习的融合体系结构,提出了一种用于室外环境语义分割的结构,并采用色彩增强的方法进行数据增强。Shahdoosti和Mehrabi(2018)将多模态医学图像融合中的系数选择步骤建模为一项模式识别任务,在模型中采用了强度—色调—饱和度变换进行增强,所提出的框架在对比度降低、颜色失真和精细细节丢失等情况下有较好的鲁棒性。Nie等人(2020)提出了一种多模态融合框架,称为集成多模态融合深度神经网络,它可以灵活地完成目标检测和端到端驱动策略,用于预测转向角和速度。Nie等人(2020)使用了随机颜色空间对比度、颜色变化、随机饱和度、随机色调和光照变化等方法来增强训练数据以提升DNN(deep neural network)的鲁棒性和泛化性能。

2.5.3 基于深度学习的方法

上面讨论的几种数据增强技术并不总能取得很好的效果,因为这些技术会改变图像的几何结构或光学信息,从而可能导致丢失原始数据集的部分信息或特征。如今,基于深度学习的数据增强方法可以自动学习原始图像的表征并生成新的“真实”图像用以提升原数据集的数量和质量,从而提高模型的泛化性能,并减少训练过程中的过拟合。以生成式对抗网络(generative adversarial network,GAN)及其变体的深度学习方法已经广泛应用在数据增强领域。典型的GAN主要由生成网络和判别网络两部分组成,可以通过学习输入数据潜在的规律或分布生成合理的图像。基本GAN的结构如图11所示。生成网络G和判别网络D在一个零和博弈中进行对抗性训练,相互对抗并不断调整参数,促使两个网络在训练期间提升性能表现。在理想情况下,这种动态过程将最终达到平衡状态,此时生成网络通过学习目标数据的潜在分布产生新数据,而判别网络无法判断新数据的真伪,从而达到以假乱真的效果。

图11 GAN结构图

Mondal等人(2018)将应用在2维单模态图像数据的生成对抗网络扩展至3维多模态数据生成合成图像,并结合带标注的数据和不带标注的数据一起训练模型。Mehrotra和Dukkipati(2017)提出了生成对抗残差成对网络,用生成器对不可见的数据分布提供有效的正则表示,并用残差成对网络作为判别器来度量成对样本的相似性,进而使得生成器更好的生成伪样本用于模型训练。Li等人(2020)提出了一种新的基于GAN的脑肿瘤图像增强框架TumorGAN。通过结合两个不同患者的脑组织区域图像和肿瘤区域影像,该方法可以通过来自n名患者的图像数据产生n2-n个合成图像数据对。实验结果表明,在多模态和单模态数据集中,TumorGAN产生的合成图像对均可以提升肿瘤分割的效果。Jiang等人(2019)提出了一种新的基于交叉模态先验的深度学习方法,用于从小型专家标记的MR数据集中训练具有高鲁棒性的MR肺肿瘤分割模型。该方法通过跨模态先验模型,利用专家分割CT数据集的信息,克服了通过小数据集学习高鲁棒性模型的难题。该方法在分割精度上取得了突出的表现。Zhang等人(2019c)提出了一个SkrGAN,它能够生成高质量的医学图像。SkrGAN引入了草图先验约束,来指导医学图像的合成,并生成具有真实前景结构的图像。通过对4种医学图像(视网膜彩色眼底、胸部X光、肺部CT和脑部MRI)的实验表明,SkrGAN在医学图像增强方面取得了先进的性能。

在计算机视觉中,很多任务都可以归纳为将一幅输入图像转换成一幅输出图像。在多模态数据分析处理中,也经常使用这种方法产生新模态的数据,并以此进行数据增强。Lin等人(2020)提出了一种多模态AugGAN模型,并引入了循环结构一致性,用于在复杂域(如白天和夜间)之间生成多样且具有结构一致性的图像,用于目标检测器的训练。结果表明,该模型可以生成高可信度且多样化的合成图像。

此外,还有一些其他的深度学习方法。Du等人(2021)提出了一种有效的识别网络(TRecgNet),用于学习场景识别任务中特定模态的RGB-D表示。TRecgNet的核心是跨模态金字塔转换分支,该分支能够生成用于训练数据增强的多模态数据。Chen等人(2021)提出了一个由模态转换器和语义转换器组成的知识引导的数据增强框架,用于跨模态增强和语义增强。该知识引导的框架能够合成多模态图像,其图像质量和特征质量都优于传统的图到图转换机制。大量实验表明,在使用了该增强方法后,使用相同的ResNet18分类器,AUC(area under curve)从84.36%显著提高到86.71%,进一步提高了分类精度。Pesteie等人(2019)提出了一种基于变分自动编码器的生成网络,可以学习输入数据的潜在分布。训练后的模型可用于合成新图像以进行数据增强。Pesteie等人(2019)在两个独立的临床数据集(脊柱超声图像和大脑磁共振图像)上证明了该方法的有效性。

3 多模态数据集

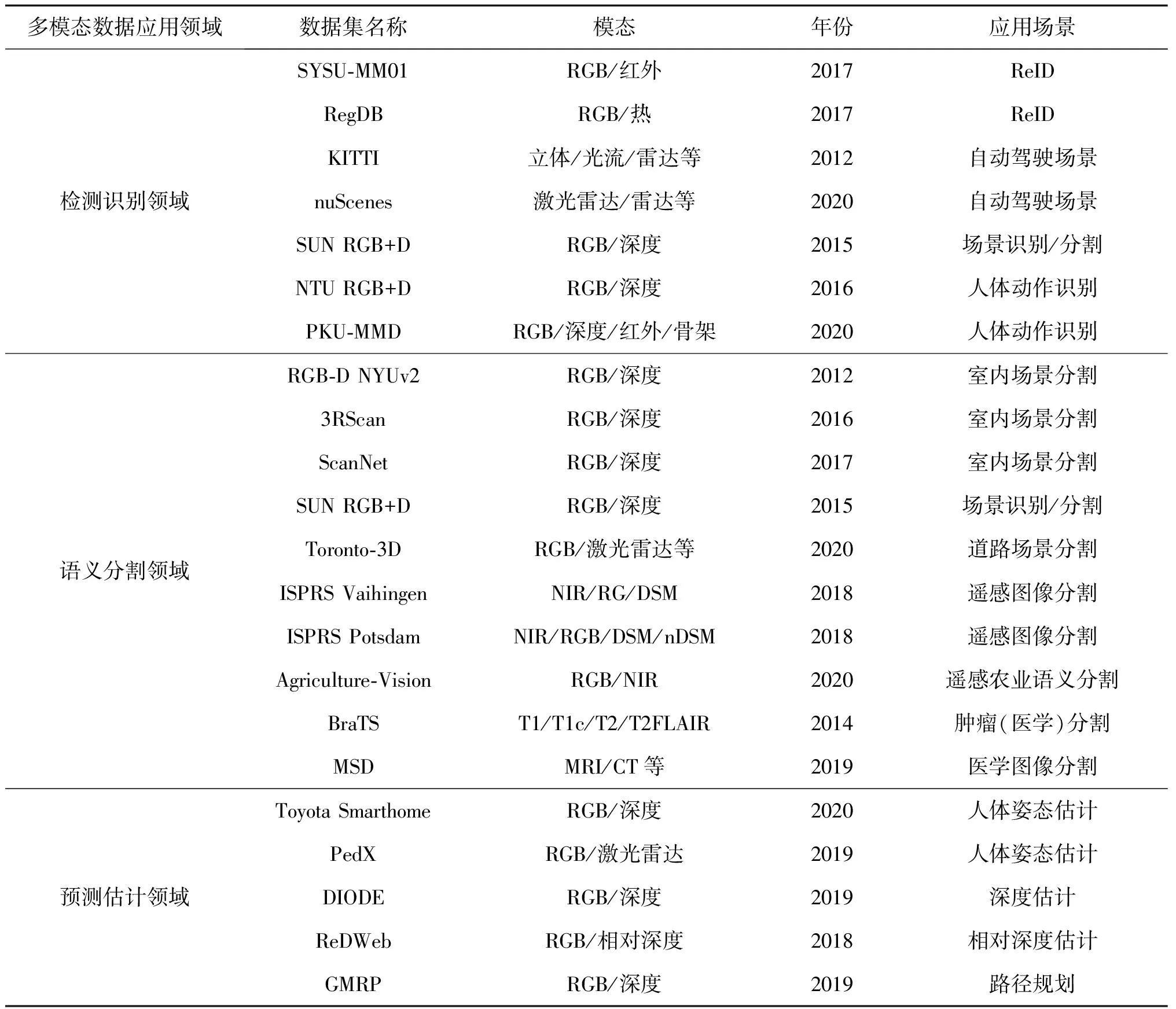

目前,在第1节提到的各个领域下的应用场景对应的多模态数据集种类、数量繁多,本文按照数据集的应用领域、数据集名称、包含的模态、提出的年份和其对应的应用场景等将这些领域常用的数据集总结整理为如表5所示。

表5 不同领域下对应的常用多模态数据集

3.1 检测识别领域

检测识别技术已经广泛应用到如行人重识别、场景识别和人体动作识别等多模态数据场景下的任务当中。因此,本文主要总结了检测识别领域对应于上述应用场景的一些常用数据集。行人重识别的常用数据集主要包括:SYSU-MM01(Wu等,2017)和RegDB(Nguyen等,2017);场景识别的常用数据集主要有:SUN RGB+D(Song等,2015);人体动作识别的常用数据集有:NTU RGB+D(Shahroudy等,2016)和PKU-MMD(Liu等,2020)。

SYSU-MM01(Wu等,2017)是目前最大的 RGB-IR ReID数据集之一,由4个RGB和2个红外(infrared radiation,IR)摄像机收集。从统计上看,训练集包含395个行人的22 258幅RGB和11 909幅红外图像,而测试集由包含3 803幅红外图像的查询集和一个RGB图库(gallery)集(红外和RGB都是96个行人)组成。数据集包含两种模式:在室内搜索模式下,仅由两个室内摄像机参与捕获图像。对于全搜索模式,使用4个RGB摄像头获得的所有图像。

RegDB(Nguyen等,2017)是由双摄像头系统(即配对的RGB和热成像摄像头)获取的跨模态行人重识别数据集。数据集中的采集对象包括412个行人,其中每个行人分别拥有10幅可见光图像和10幅热图像。可以分为两种评估模式,即可见热和热可见,通过交替使用所有可见/热图像作为查询集。

KITTI(Geiger等,2012)由德国卡尔斯鲁厄理工学院和丰田美国技术研究院联合创办,是目前国际上常用的自动驾驶场景下的计算机视觉算法评测数据集。该数据集可用于评测立体图像、光流、视觉测距/SLAM、3D目标检测和3D跟踪等计算机视觉任务在车载环境下的性能。数据采集平台配备了4个高分辨率摄像机、一台Velodyne激光扫描仪以及1个GPS导航系统。KITTI包含市区、乡村和高速公路等场景采集的真实图像数据,每幅图像中最多可见15辆车和30个行人,图像中有各种程度的遮挡与截断。整个数据集由389个立体和光流图像对、39.2 km视觉测距序列以及超过200 k个3D目标标注的图像组成。

nuScenes(Caesar等,2020)是一个大规模的自动驾驶数据集。该数据集包含在波士顿和新加坡收集的1 000个场景的3D边界框,每个场景时长20 s。对23个类别和8个属性的3维边界框进行了标注,标注频率为2 Hz。总共有28 130个训练样本、6 019个验证样本和6 008个测试样本。该数据集具有完整的自动驾驶汽车数据套件:32束激光雷达、6个摄像头和具有完整360°覆盖范围的雷达。

SUN RGB+D(Song等,2015)数据集采集于4个不同的传感器,包含10 335个RGB-D图像,其规模与PASCAL VOC(pattern analysis statitical modeling and computational learning visual object classes)相似。整个数据集经过密集标注,包括146 617个2D多边形和64 595个具有准确目标方向的3D边界框,以及每个图像的3D房间布局和场景类别。该数据集能够为需要大量训练数据的场景识别任务提供数据支撑,避免模型过度拟合小型测试集,还可以研究跨传感器偏差。

NTU RGB+D(Shahroudy等,2016)是用于RGB加深度图像人类动作识别的大规模数据集。该数据集包含从40个不同主题收集的56 578个视频。每个身体有60个动作标签和25个关节点,包括日常的、相互的和与健康有关的动作。

PKU-MMD(Liu等,2020)是多模态人类动作识别的一个大规模基准数据集。它包括大约28 000个动作实例,并提供高质量的多模态数据源,包括RGB、深度、红外和骨架数据。为了使PKU-MMD更加实用,作者将数据集进一步划分为包括两部分不同设置下的动作识别子集。第1部分包含1 076个未经修剪的视频序列,由66名受试者完成51个动作类别;而第2部分包含1 009个未经修剪的视频序列,由13名受试者完成41个动作类别。与第1部分相比,第2部分由于动作间隔短、同时进行的动作和严重的遮挡而更具挑战性。

3.2 语义分割领域

随着传感器技术以及雷达技术的发展,深度信息、红外和近红外等其他模态数据的获取变得日趋容易,多模态数据下的语义分割研究已然成为当下的研究热点之一。目前,多模态数据下分割领域的应用场景主要在如室内场景、道路场景分割、医学图像分割和遥感语义分割等场景中得到了广泛应用。室内场景分割的常用数据集主要包括:RGB-D NYUv2(Silberman等,2012)、3RScan(Wald等,2016)、ScanNet(Dai等,2017)和在检测识别领域已经提及并介绍过的SUN RGB+D(Song等,2015)数据集。道路场景分割常用的数据集有:Toronto-3D(Tan等,2020)。医学图像分割常用的数据集有:BraTS(Menze等,2015)和MSD(Simpson等,2019)。遥感图像分割常用的数据集有:ISPRS Vaihingen(2018)、ISPRS Potsdam(2018)(http://www2.isprs.org/commissions/comm3/wg4/semantic-labeling.html)和Agriculture-Vision(Chiu等,2020)。

RGB-D NYUv2(Silberman等,2012)是一个室内场景数据集,由1 449幅RGB-D图像组成,包含了464个不同的室内场景,每幅图像带有详细的标注。

3RScan(Wald等,2019)是一个大规模的真实室内场景数据集,其特点是在多个时间步骤中对478个环境进行1 482次RGB-D扫描。每个场景包括若干个位置随时间变化的物体,以及物体实例的标注和它们的6 DoF(degree of freedom)映射结果。

ScanNet(Dai等,2017)是一个RGB-D视频数据集,包含1 513个场景中的250万个视图。数据集除了带有语义分割的标注之外,还附有3维室内场景重建和3D相机姿态的标注。

Toronto-3D(Tan等,2020)是通过车载MLS(mobile laser scanning)系统采集的大型城市室外点云数据集。该系统由32线激光雷达传感器、ladybug5全景相机、GNSS(global navigation satellite system)系统和同步定位与建图系统组成。数据集收集于加拿大多伦多,涵盖了大约1 km的点云,由大约7 830万个点组成,有8个标记的物体类别。该数据集分为4个部分,每个部分覆盖的范围约为250 m。

ISPRS Vaihingen(ISPRS,2018)数据集的每幅图像均由近红外(near infrared,NIR)、红色和绿色通道(nir-red-green,按此顺序)组成,空间分辨率为0.9 m,并且还提供了与图像数据配准的数字表面模型(digital surface model,DSM)。数据集由总共33幅图像(平均尺寸为2 494×2 064像素)组成,这些块被密集地分类为6个标签:不透水表面、建筑物、低矮植被、树木、汽车和杂波/背景;其中16幅图像带有可用的标注文件,而其余的则视为测试集的图像,需要提交预测结果才能进行评估。

ISPRS Potsdam(ISPRS,2018)由四通道图像(NIR-RGB)、DSM和标准化的DSM(normalized DSM,nDSM)组成。该数据集包含38个相同大小(6 000×6 000像素)的图像,空间分辨率为0.5 m。其中,有24幅图像有其对应的标注文件(标注的类别与 Vaihingen 数据集的类相同),其余图像则视为测试集,需要提交预测才能进行评估。

Agriculture-Vision(Chiu等,2020)包含从全美3 432个农田收集的94 986幅高质量的航空图像,其中每幅图像由RGB和近红外(NIR)通道组成,每个像素的分辨率高达10 cm。该数据集标注了对农民最重要的9种田间异常模式,可作为航空农业语义分割的试点研究。

BraTS(Menze等,2015)是一个用于脑肿瘤图像分割的数据集。它由220个高级别胶质瘤和54个低级别胶质瘤磁共振成像组成。其中包含4种模态的MRI图像,分别为T1、T2、T1ce和Flair。其分割标注提供了4种肿瘤内分类:水肿、强化肿瘤、非强化肿瘤和坏死。

MSD(Simpson等,2019)是一个包含各种临床相关解剖结构的医学图像数据集,广泛应用于医学图像分割领域。它由2 633幅3维图像构成,其中存在多个解剖结构,并包含了MRI、CT等多种模态的图像数据。具体来说,它包含以下身体器官或部位的数据:大脑、心脏、肝脏、海马、前列腺、肺、胰腺、肝血管、脾脏和结肠。

3.3 预测估计领域

基于深度学习的预测和估计技术已广泛应用在在多模态数据场景中,如人体姿态估计、深度估计和路径规划等。以下介绍一些预测领域中常用的多模态数据集。人体姿态估计的常用数据集主要有:Toyota Smarthome(Das等,2019)和PedX(Kim等,2019)。深度估计的常用数据集有:DIODE(Vasiljevic等,2019)和ReDWeb(Xian等,2018)。路径规划的常用数据集有:GMRP(Wang等,2019)。

Toyota Smarthome(Das等,2019)是用于人体姿态估计的数据集,包含18位年长的受试者在一天中完成的各项活动。该数据集包含31个动作类的16 115个视频,这些视频来自7个不同的相机视点。

PedX(Kim等,2019)是一个用于复杂城市交叉路口行人3维姿态估计的基准数据集,由5 000多对高分辨率立体图像和激光雷达数据组成,并提供行人的2维和3维标签,还提出了一种新的3维模型拟合算法,用于自动3维标记,利用了不同模式的约束以及新的形状和时间先验。

DIODE(Vasiljevic等,2019)是第1个用于单目深度估计的标准数据集,包括使用相同传感器获取的各种室内和室外场景,由高分辨率RGB-D图像构成。训练集包括8 574个室内样本和16 884个室外样本,每个样本来自20次扫描。验证集包含325个室内和446个室外样本,每组样本来自10次不同的扫描,数据集的室内和室外深度距离范围分别为50 m和300 m。

ReDWeb(Xian等,2018)是一个用于单目相对深度估计任务的数据集,由3 600个收集自不同场景的RGB-相对深度图像对组成。该数据集涵盖了广泛的室内外场景,如街道、办公室、山丘、公园、农场和夜景等。

GMRP(Wang等,2019)是一个地面移动机器人可行驶区域和道路异常分割的RGB-D数据集。该数据集包含3 896幅RGB-D图像,涵盖地面移动机器人通常工作的30个常见场景(例如人行道和广场)和地面移动机器人在真实环境中可能遇到的18种不同类型的道路异常情况。

4 结 语

多模态数据的处理和应用成为重点研究方向,在情感分析、机器翻译、自然语言处理和生物医学等前沿方向取得了重要突破。国内外研究学者针对数据受限条件下的多模态学习展开了大量研究。本文深入不同的数据受限形式,总结了计算机视觉领域中数据受限下的多模态数据处理发展现状。此外,基于以上分析,本文简要介绍了多模态数据处理领域未来仍需进一步研究的方向。

1)轻量级的多模态数据处理方法。数据受限条件下的多模态学习仍然存在模型应用于移动式设备的挑战性。现有方法在融合多个模态的信息时,普遍需要使用两个及以上的网络进行特征提取,进而将特征进行融合,因此模型的参数量大、模型结构复杂限制了其应用于移动式设备。在未来工作中,轻量化模型有待进一步研究。

2)通用的多模态智能处理模型。现有多模态数据处理方法多是为不同任务开发的不同算法,需要在特定的任务上进行训练。这种针对特定任务的训练方法很大程度上增加了开发模型的成本,难以满足快速增长的应用场景的需求。因此,针对不同模态的数据,需要提出适合的通用感知模型,学习多模态数据的通用表征,使得在不同的应用场景可以共享通用模型的参数和特征。

3)知识与数据混合驱动的模型。不同模态的数据往往包含不同的特性,本文认为在进行多模态数据处理时,除了使用多模态数据外,可以考虑引入数据特性和知识,建立知识与数据混合驱动的模型,增强模型的性能和可解释性。