用于车辆重识别的视角感知局部注意力网络

代广昭,孙伟,2,徐凡,张小瑞,陈旋,常鹏帅,汤毅,胡亚华

(1.南京信息工程大学自动化学院,南京 210044;2.南京信息工程大学江苏省大气环境与装备技术协同创新中心,南京 210044;3.南京信息工程大学 数字取证教育部工程研究中心,南京 210044;4.南京信息工程大学 无锡研究院,江苏 无锡 214100;5.南京信息工程大学 计算机与软件学院,南京 210044)

0 概述

近年来,车辆重识别技术在智能视频监控系统中的应用越来越广泛,因此受到学术界以及工业界越来越多的关注。车辆重识别的目的是从互不重叠的摄像头捕捉的图库集中找到与查询车辆相同的所有车辆。虽然车牌识别[1]是区分不同车辆最简单直接的方法,但是在很多情况下,受分辨率低、车牌遮挡、视角变化大等因素影响,车牌信息无法被稳定获取。因此,以车辆的外观信息为基础的车辆重识别成为解决上述问题的主要途径,甚至是唯一途径。然而,由于在复杂的交通场景下进行车辆重识别会不可避免地伴随着剧烈视角变化,使得同一车辆在不同视角下要么外观差异巨大,要么不同车辆由于颜色、车型相同在特定视角下外观极为相似,给车辆重识别带来了巨大的挑战。

近年来,一些大规模车辆数据集[2-4]的提出促进了基于深度卷积神经网络(Deep Convolutional Neural Network,DCNN)的车辆重识别的发展。为了解决上述挑战,一些研究人员利用DCNN 从整幅图像中学习车辆的全局特征。文献[2]和文献[3]提出一个由粗到细渐进式的网络框架,将车辆的颜色、车型、纹理、车牌、时空信息等多特征融合进行车辆重识别。文献[4]将整幅车辆图像输入到欧式空间来计算车辆之间的距离,使用车辆ID 和车辆型号对神经网络的训练进行监督,以提升模型对同一车型不同车辆进行重识别的鲁棒性。尽管上述基于全局特征的方法在背景简单的场景下取得了较好的重识别效果,但在复杂交通场景下,由于车辆视角改变引起全局外观剧烈变化,导致车辆出现类内差异大和类间差异小的现象,因此重识别模型很难仅根据车辆的全局特征区分车辆。

考虑到全局特征的不稳定性,研究人员开始关注局部区域以提高模型特征表达能力。为此,许多高性能的车辆重识别方法依赖于预定义的显著性局部区域标注,如车辆关键点区域[5-6]和局部部件区域[7-9],这些都属于强监督局部学习方法。这些方法虽然在一定程度上提高了重识别模型的准确度,但大量的人工手动局部区域标注使得局部特征学习变得主观性强且成本昂贵。为节省标注成本,文献[10]不借助车辆局部标注而通过将车辆图片在空间上划分成若干个子区域获得局部特征。然而,为了对齐车辆图片,无论是采用水平划分还是垂直划分,划分后的子区域特征均会丢失车辆原有的视角信息,使得划分后子区域更容易遭受视角变化的影响。

为获取车辆的视角信息,文献[11]利用预训练后的车辆视角预测网络获取车辆的视角特征,虽然能获取到车辆前、后、左、右的视角信息,但无法学习到每个视角内的所有显著性特征。文献[12]利用GAN[13]生成车辆视角信息以克服类内差异,但由于生成的视角图片仍源自可见视角,本质上未能生成额外的局部信息,而只是简单地学习单一的视角特征,因此无法学习每个具体视角内所有显著性局部特征。此外,这些方法在重识别时,所有视角均直接进行重识别,而未考虑车辆间共同视角特征的重要性。例如,当2 辆车出现外观相似时,除了找到每个具体视角下显著性的局部区域并进行对比,还应该关注共同视角特征以区别车辆,这些共同视角特征往往具有更加丰富和完整的信息。

本文提出一种视角感知局部注意力网络(View-Aware Part Attention Network,VPAN)对车辆进行重识别,将车辆视角和局部部件信息整合到一个统一框架。不同于传统的人工手动局部区域标注方法,本文通过弱监督注意力学习方式生成注意力图来表示视角内所有显著性局部部件位置分布,并基于获得的注意力图自适应学习该视角内显著性局部特征。此外,提出一个共同视角的注意力增强模块,根据视角的相似度匹配车辆视角间的注意力权重,增强共同视角的特征学习。

1 相关工作

1.1 基于局部特征的方法

除了基于全局特征学习的方法之外,为扩大同车型车辆之间的细微差异,一些依赖于人工参与的基于强监督局部特征学习的方法也相继推出。文献[5]通过定义车身的20 个关键点,将车辆方向基于模型提取的关键点信息聚类为前、后、左、右4 个方向,通过模型检测预定义的关键点来提取局部特征。在文献[5]的基础上,文献[6]采用一种双分支的自适应注意力模型,并基于车辆的关键点以及方向进行局部有辨识信息的特征提取。为学习局部特征,受ROI 思想的启发,文献[7-9]首先对车牌、车灯、年检标志、个性装饰等局部部件进行标注,之后利用这些标注信息训练目标检测算法,以获取车辆的局部特征。

然而,这些预定义的局部区域标注方法虽然在一定程度上提高了重识别模型的准确度,但却不可避免地存在一些限制。首先,在车辆跨视角运动时,车辆姿态剧烈变化甚至出现遮挡,导致车辆局部标注的工作很难正常展开。其次,这些局部区域标注不仅标注成本高,还大幅增加了训练成本和训练复杂度,导致其无法适应车辆重识别数据集规模的不断增长。最后,这些预定义局部区域均来自车辆固定位置,无法学习图像中所有视角下有区别性的局部区域。当车辆在跨摄像头运动过程中遭遇剧烈视角变化时,判断2 辆车是否为同一辆车的关键线索可能随机分布在任何视角下车辆上的任何一个区域。而这些问题导致基于强监督的局部区域标注方法难以达到令人满意的效果。

近年来,计算机视觉领域中基于弱监督的学习已经取得了巨大的进步。相比于需要大量人工标注的强监督方法,弱监督仅需少量的标签,甚至只需少量的图像类别标签就能取得和强监督方法相近的识别精度。此外,弱监督方法训练成本低并且能够适用于多种任务中,如目标分割[14]、行人重识别[15]、细粒度图像识别[16]等任务。受上述方法的启发,本文通过弱监督注意力学习方式生成注意力图,以表示视角内所有显著性局部部件的位置分布。相比于传统人工局部区域标注的方法获取到的固定局部信息,本文方法能更加容易地定位视角内更多的局部区域,这不仅降低了标注成本,而且能够根据注意力图更加灵活地学习车辆显著性局部信息。

1.2 基于视角特征的方法

视角信息是车辆重识别的关键因素。在跨摄像头运动时车辆视角遭遇剧烈变化,使得同一车辆在不同视角下遭受类内差异大或不同车辆因颜色、车型相同在特定视角下出现类间差异小的现象,导致车辆重识别面临挑战。图1 所示为车辆重识别面临挑战的样例(彩色效果见《计算机工程》官网HTML 版)。

图1 车辆重识别面临挑战的样例Fig.1 Examples of challenges faced by vehicle re-identification

图1(a)所示的所有车辆均为同一车辆,由于车辆视角剧烈变化导致同一车辆外观差异大,重识别时面临类内差异大的问题。图1 中第2 列~第4 列的每列车均为相同视角下的不同车辆,由于颜色、车型相同,这些车辆在特定视角下的外观却极为相似,红色圈覆盖局部区域为其具体差异。在进行车辆重识别时,与车辆的不同视角部分相比,车辆的共同视角往往具有更加丰富和完整的信息,其有效性已在最近的一些重识别方法[14-16]中成功得到验证。

文献[17]提出视角感知网络(Viewpoint Aware Network,VANet)学习相同视角的特征度量和不同视角的特征度量。文献[18]提出基于解析下视角感知网络(Parsing-Based View-Aware Embedding Network,PVEN),利用预训练后的U-Net[19]网络获取车辆的视角信息。对于获得的视角信息,PVEN 认为在车辆重识别过程,具有相同视角部分的特征比不同视角部分的特征更重要,应该得到更多的关注。类似的,文献[20]提出共现局部注意力距离度量(Co-Occurrence Part-Attentive Distance Metric,CPDM)以更好地利用车辆的视角特征,使相同视角图像的特征在特征学习中得到更多关注。上述这些方法虽然能利用共同视角特征,在一定程度上提高重识别的精度,但仍然存在一些缺陷。例如当2 辆车外观均呈现前-侧-顶视角时,为匹配车辆图片之间每个视角均为共同视角,容易导致每个视角都受到相同程度的关注,使得共同视角注意力模型无法按照识别车辆视角贡献程度的不同进行加权重要特征学习。在此前提下,由于这些方法无法额外自适应地学习到每个视角下所有鉴别力的局部特征,从而辅助模型区分车辆,导致重识别任务依然很难顺利进行。

不同于上述方法,本文方法将车辆视角和局部部件两类信息整合到一个统一的框架中,通过弱监督注意力学习而非人工手动标注车辆局部部件,自适应学习每个视角内所有显著性局部特征。此外,受PVEN[18]等方法中共同视角特征的启发,本文方法在重识别时根据匹配车辆视角的注意力权重增强共同视角的特征学习,从而学习到更加丰富和有鉴别力的特征。

2 视角感知局部注意力网络

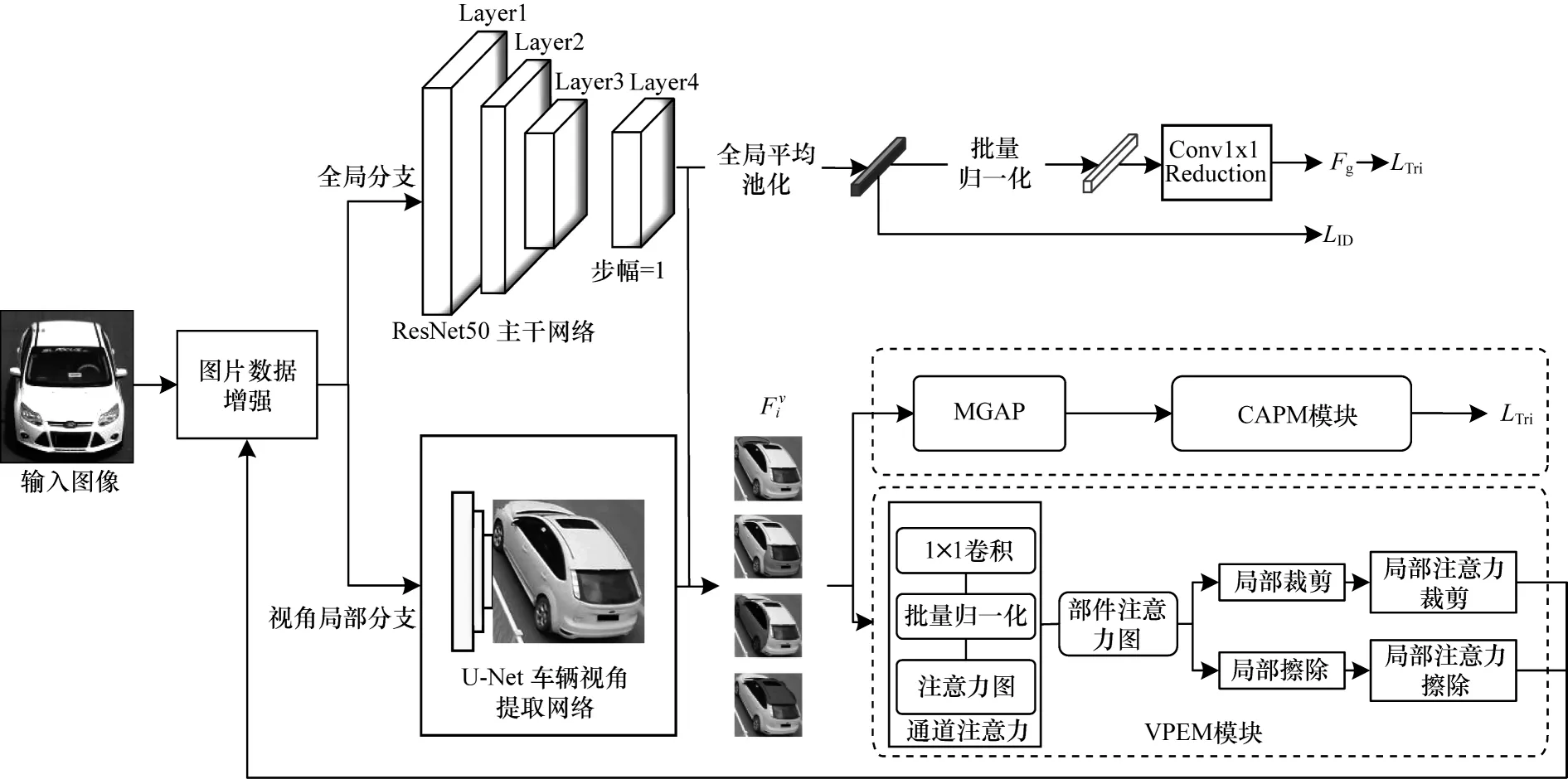

本节将详细介绍视角感知局部注意力网络。如图2 所示,该网络主要由3 个模块组成,分别是车辆视角获取模块、视角感知下局部增强模块以及共同视角注意力增强模块。首先,通过训练车辆视角获取网络,得到车辆前、后、左、右的视角特征。这些车辆视角特征随后将被输入到2 个分支中,并分别学习视角内潜在的显著性局部特征和共同视角特征。为挖掘视角内细粒度的局部信息,本文提出一种视角感知下的局部增强模块(View-Aware Part Enhancement Module,VPEM)以自适应学习视角内潜在的显著性局部特征。最后,为增强视角特征的差异性,本文利用共同视角注意力增强模块(Common-View Attentive Promote Module,CAPM)匹配车辆的视角间注意力权重,使同一视角下的特征学习得到增强,不同视角特征学习受到抑制。

图2 本文网络结构Fig.2 Structure of network in this paper

车辆重识别任务在大多数情况下都是多任务学习,主要分为2 个任务,一个是构建ID loss,通过分类损失学习对应不同ID 的损失,另一个任务是以Triple loss[21]为主的通过特征向量直接构建的损失,主要学习类内的相似性和类间的区分性,让不同特征向量的区分度更高,让相同的特征向量更加趋同。因此,为优化网络结构,本文基于学习到的特征,采用多任务学习思想[3,18]设计损失函数,即采用Triplet loss 和Softmax crossentropy loss(ID Loss)共同优化VPAN。

2.1 车辆视角特征的获取

受PVEN[18]获取车辆视角特征的启发,本文训练U-Net 作为视角获取网络,以提取数据集上车辆的视角信息。该视角获取网络运行步骤主要包含如下两步:

1)从车辆数据集中挑选部分车辆图片并标注它们的视角信息,即前、后、顶和侧4 个视角。然后,利用标注好的车辆图片训练U-Net 视角获取网络,并用训练好的算法分别提取数据集上每个样本的车辆视角掩膜。对于一张车辆图片,本文定义每个视角i覆盖的空间区域为对于每个视角区域i,将视角掩膜区域内的元素赋值为1,区域外元素赋值为0。最终得到一个二元掩模矩阵,其表达式如式(1)所示:

其中:x表示视角掩膜的像素位置。

其中:⊙表示元素的点乘。

2.2 视角感知下局部特征学习

本文采用在ImageNet[22]上预训练后的ResNet[23]作为主干网络用于特征提取。为获得具有更多细节信息及更大尺寸的特征图,本文把最后一个卷积层的stride 设置为1。

如图2 所示,输入车辆图片经过主干网络输出的特征F分别流入2 个分支。在第1 个分支中,F被直接输入到全局平均池化层(Global Average Pooling,GAP),得到大小为2 048×16×16 的全局特征。在第2 个分支中,首先将视角特征Fvi输入到掩膜全局平均池化(Mask Global Average Pooling,MGAP)进行池化,其池化后的特征将被CAPM 模块用于增强视角差异性。然后,将获取到的视角特征Fvi输入到VPEM 模块中,以自适应学习该视角内潜在的显著性局部特征。值得注意的是,不同于传统局部方法依赖人工手动的标注学习车辆的局部位置信息,VPEM 模块通过弱监督注意力学习的方式生成注意力图[24],从而获取每个视角内显著性局部位置信息。

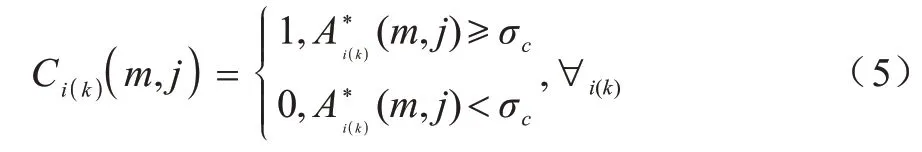

首先,通过视角提取网络U-Net 获取第i视角对应的视角特征,其中:C、H和W分别表示特征通道、特征图高和宽。接着,本文通过式(3)获取视角内显著性部件注意力图,其表示车辆第i视角中共M个局部位置的分布。

其中:f(·)为注意力计算操作,由一个1×1 卷积操作、一个Batch Normalization 层和一个ReLu 激活函数组成;表示中车辆局部部件注意力图,如车灯、车窗和车标等,M表示注意力图的数量(特征通道数量);注意力图中通道特征图响应越高,表示该通道特征越显著,其对应的局部部件注意力图具有更细粒度的信息,因而得到模型较多的关注;低响应区域则表示该通道特征为不重要的特征,具有较少的模型关注。

图3 视角感知下局部增强模块的结构Fig.3 Structure of local enhancement module under view-aware

。

利用一个边 界框Bi(k)覆盖Ci(k)中所有值为1 的区域,裁剪原始图像中Bi(k)覆盖的区域。接着,放大裁剪后的区域尺寸为原图大小后重新送入网络模型中进行训练。由于放大的这部分区域是该视角内最显著的局部区域,存在更多细节,因此可以提取更多的细节特征。

将被标记为0 的区域从原始图像中抹除,通过局部注意力擦除操作使网络提取图像中其他具有识别度区域的特征,进一步增强网络的泛化性能。

2.3 共同视角注意力增强

当2 辆不同车辆的图像中包含相同视角信息时,除了找到每个具体视角下显著性的局部区域进行对比,还应该关注共同可见视角的特征,这些共同可见视角特征往往具有更加丰富和完整的信息,如果给予共同可见视角的图像部分更大关注,模型能够更快、更准地实现车辆重识别。

基于上述发现,本文提出CAPM 模块学习车辆图像中可见视角的相似度,并根据视角的相似度自适应地给每个视角分配不同权重。根据所获取的视角间权重,CAPM 模块能够自适应地给予共同视角更多关注,给予不同视角较少关注。CAPM 模块的计算流程如图4 所示。

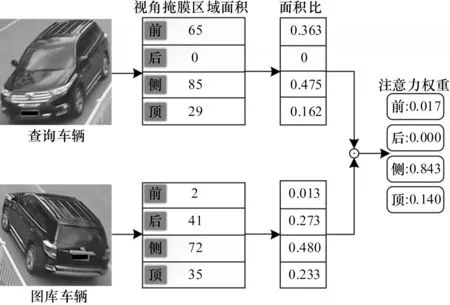

图4 共同视角注意力增强模块的计算流程Fig.4 Calculation procedure of common-view attentive promote module

如图4 所示,当查询车辆和图库车辆图片中对应视角区域面积比越高时,它们的视角相似度越高,即为共同视角,因而这部分区域可以得到更高的注意力权重;当对应区域的相似度低时,则说明它们的视角不同,因而只能得到较少的注意力权重。需要指出的是,在通过注意力机制学习权重ω进行加权特征学习时,采用的是加权平均自适应学习方法,即前、后、顶和侧4 个视角的注意力权重和ω=因而在使共同视角得到更大关注和使其他不同视角得到更少关注的过程是同时进行的,而非单独增强共同视角(保持不同视角关注度不变)或者抑制不同视角(保持共同视角的关注度不变)。CAPM 模块学习注意力权重的具体步骤如下:

1)给定一张查询图像Iq和图库图像Ig;

2)按照式(7)计算图像Iq和Ig的前、后、顶和侧4 个视角掩膜区域的面积;

3)根据获取的掩膜区域面积,通过式(8)计算Iq和Ig视角区域的注意力权重ωk(Iq,Ig),以获取共同视角增强幅度或不同视角抑制的幅度。

本文使用注意力权重来自适应调整特征匹配时所有视角特征的特征距离。Iq和Ig之间的最终特征距离Dv(Iq,Ig)的计算公式如式(9)所示:

2.4 模型的训练和推理

在训练阶段,本文采用ID loss 和Triplet loss 函数共同优化全局特征,将以上2 个函数分别表示为局部特征采用Triplet loss 进行优化,其表示为在特征降维时,全局特征Fg被输入到一个由卷积层、Batch Normalization(BN)层和ReLU 组成的Conv1×1 Reduction 块,用于生成512 维特征向量。受BNNeck[25]方法的启发,为避免损失函数ID loss和Triplet loss 优化同一特征时出现异步收敛的情况发生,在连接ID loss 层优化之前,先将特征输入到一个额外的BN 层进行归一化处理。VPEN 总的损失函数计算公式如式(10)所示:

其中:α、β和ν为3 个损失函数之间的平衡参数。

3 实验结果与分析

3.1 数据集及评价指标

3.1.1 数据集

将本文模型在VehicleID[4]和VeRi-776[2]2个主流数据集上进行评价。VehicleID 为大规模车辆重识别数据集,主要从前、后2 种视角收集了约26 267 辆车的221 763 张图片,其中训练集包含13 134 辆车的110 178 张图片,而测试集包含13 133 辆车111 585 张图片。VehicleID按照数据量将测试集划分为大、中、小3 个子集。在标注车辆属性时,VehicleID 中的每张图像都标注了车辆ID、摄像头位置和车型的详细信息。VeRi-776 也是车辆重识别中一个大规模车辆数据集。VeRi-776数据集包含了776辆车的50 000张图片,这些图片分别由20 个摄像头的不同视角拍摄采集而来。VeRi-776 数据集的标注信息丰富,除了包含边界框、车型、颜色、厂商信息之外,还收集了车牌、时间戳和地理位置的信息,是车辆重识别中目前广泛使用的数据集之一。

3.1.2 评价指标

基于上述2 个数据集,本文使用平均精度值(mean Average Precision,mAP)和累计匹配曲 线(Cumulative Match Curve,CMC)2 个评价标准对提到的模型进行验证。

mAP 指标能度量车辆重识别模型的整体性能。mAP 可由式(11)计算得到:

其中:Q表示查询集中图像总数;A(q)表示每个查询车辆的检索结果平均值。A可由式(14)计算得到:

其中:n为数据集图像总数;N表示目标车辆的图像总数;P(k)表示在匹配序列中第k位的检索精度,如果第k个结果正确匹配,则g(k)为1,否则g(k)为0。

CMC@k表示查询图像q在前k个检索结果中找到正确结果的概率,例如CMC@1 表示查询图像q在前1 个检索结果中找到正确结果的概率。CMC@k可通过式(13)计算得到:

其中:Q表示查询集中图像总数;当图像q的正确匹配目标出现在检索结果序列的第k位之前,等于1。

3.2 实验细节

受PVEN 网络获取车辆视角信息的启发,本文采用U-Net 提取数据集图片的视角信息。在常用车辆数据集中,VehicleID 数据集中的车辆通常包含前和后两种视角,而VeRi-776 数据集则通常包含更多的视角信息。为获取更加丰富的视角信息,本文选择在具有更多视角信息的VeRi-776 数据集上训练U-Net 网络。在VeRi-776 数据集上,本文共标注了2 000 张车辆图片视角信息,其中包括训练集的1 500 张图片和测试集的500 张图片。

在重识别网络训练时,所有输入的图像尺寸被调整为256×256。优化器使用Adam 优化器[26],动量为0.9。为提高收敛速度,本文将基础学习率设为3.75×10-4,其在60 个epoch 和120 个epoch 时分别降为3.75×10-5和3.75×10-6,epoch 的总数为180。采用平衡采样训练策略[27],将网络训练的batch 大小设置为32,即每次随机采样8 辆车,每辆车选取4 张图片。在处理数据时,本文使用随机水平翻转和随机擦除[28]方式进行数据增强。在训练和测试阶段,使用欧式距离来评估查询图像和图库图像之间的特征相似度。在triplet loss 中,间隔参数被设为0.3。

3.3 消融实验

为验证本文方法中各个模块的有效性,本文在VeRi-776 数据集上进行不同设置的消融实验。消融实验的评价指标分别是mAP、CMC@1 和CMC@5。

随机挑选2 个车辆图片,图5 为VPAN 网络与仅基于全局特征的网络(Baseline)按照相似度评分后排名前10的检索结果(彩色效果见《计算机工程》官网HTML版),其中:红色框为正确匹配;蓝色框则为错误匹配。由图5可知,本文网络在重识别精度上明显优于Baseline网络。

图5 排名前10 的检索结果Fig.5 Top 10 search results

3.3.1 基于视角感知下局部特征学习模块的作用

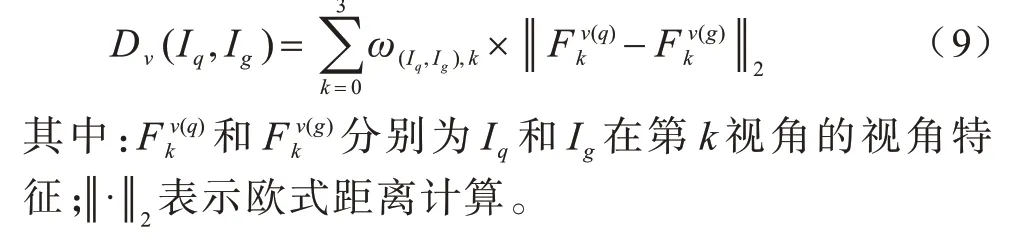

表1 所示为本文网络中各模块作用的对比结果,其中:Baseline 网络表示VPAN 网络去除了所有模块,仅学习车辆的全局特征;VPAN w/o Local 表示VPAN 网络去除了视角下显著性局部部件特征学习模块;VPAN w/o View 表示VPAN 网络去除了视角特征学习模块。

表1 本文网络中各模块作用对比Table 1 Functional comparison of every module of network in this paper

由表1 可知,VPAN 在所有对比网络中取得了最优的重识别效果,这是因为VPAN 网络不仅能够学习视角感知下有区别性的局部特征,而且能够利用注意力机制增强共同视角特征,因此VPAN 网络学习到的车辆特征更具完整性和鉴别性。由表1 还可知,VPAN w/o Local 和VPAN w/o View 由于仅学习单一车辆特征,严重影响了重识别的效果。相比于VPAN,去除视角感知下显著性局部部件特征学习模块的VPAN w/o Local 方法的重识别准确度大幅降低,其mAP、CMC@1 和CMC@5 分别降低了2.9、1.3和0.9 个百分点。这说明在去除局部部件特征学习模块后,不仅降低了所学习到车辆特征的完整性,而且降低了重识别的准确性。与VPAN w/o Local 网络相似,这种现象也出现在去除视角特征学习的VPAN w/o View 上。

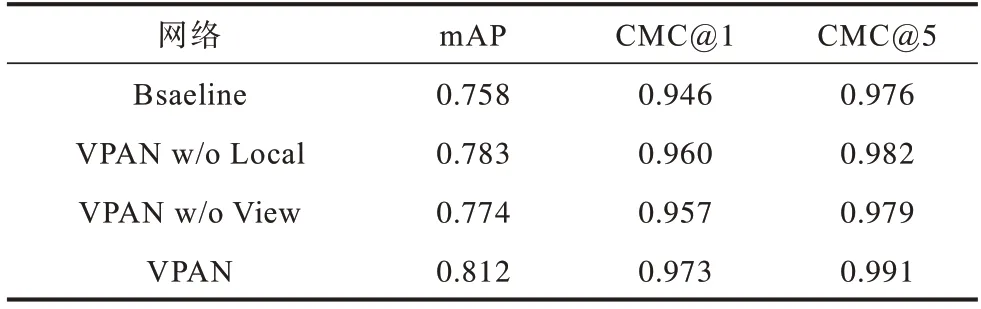

3.3.2 共同视角注意力增强模块的作用

表2 所示为本文网络中共同视角注意力增强模块的作用对比,其中:VPAN w/o CAPM 代表去除了共同视角注意力增强模块后的VPAN 网络。由表2可知,相较于VPAN 网络,去除共同视角注意力增强模块后的VPAN w/o CAPM 网络的重识别精度会降低。这是因为共同视角往往具有更丰富和完整的信息,如果给予共同视角的图像部分更大关注,模型能够更快更准确地实现车辆重识别,否则,模型有可能会关注许多无用的图像区域,降低重识别精度。

表2 本文网络中共同视角注意力增强模块的作用对比Table 2 Functional of common-view attentive promote module of network in this paper

3.3.3 不同视角特征的作用

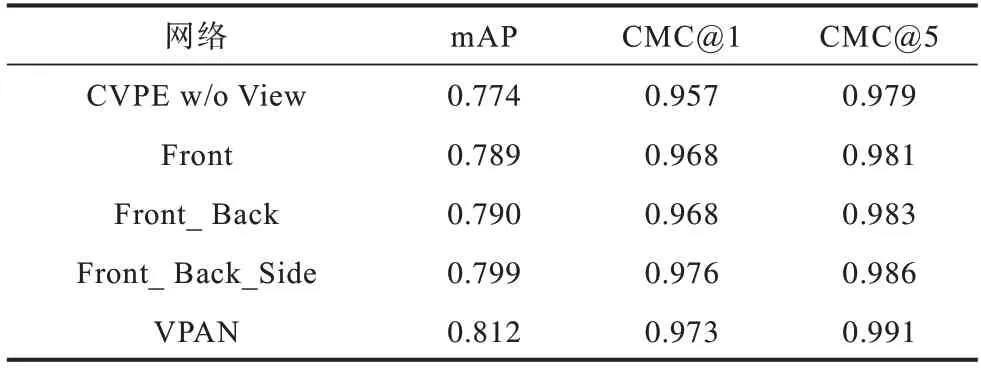

本文通过逐渐增加视角特征的数量并重新训练模型,以验证每个视角特征的有效性,实验结果如表3 所示。其中,VPAN w/o View 表示模型去除了所有的视角特征,Front 表示VPAN 仅使用车辆前视角特征,以此类推。

表3 不同视角数目的实验结果对比Table 3 Comparison of experimental results of different view number

由表3 可知,随着视角特征数量逐渐增加,车辆重识别精度不断提升,当模型利用所有视角特征时,精度达到最高值。具体来说,通过对比Front 和VPAN w/o View,可以看到添加前视角后模型的mAP 得到约1.5个百分点的提升。主要原因是前视角区域在区分车辆时往往包含更多且更显著的关键性线索,如车灯、车挡风玻璃上的年检标志、个性化装饰、车标等,这些信息能够帮助模型区分车辆是否为同一辆车。在添加车辆的侧视角后,mAP 提升了1.3 个百分点,重识别的效果得到了较大的提升。由于拍摄到的车辆图像大多呈现3 个方向,如前-顶-侧或者后-顶-侧,因此,作为共同可见视角侧面往往能够提供区分车辆的有用信息,如个性化涂鸦和贴纸。然而,一些传统的网络[29-31]只关注车辆的前、后和顶3 个视角,忽略了侧视角的信息。不同于这些传统的网络,本文网络不仅学习到更多有用的视角信息(前、后、顶和侧),还在重识别时根据每个视角的注意力权重分配不同程度的关注,使车辆的视角特征得到更好的利用。

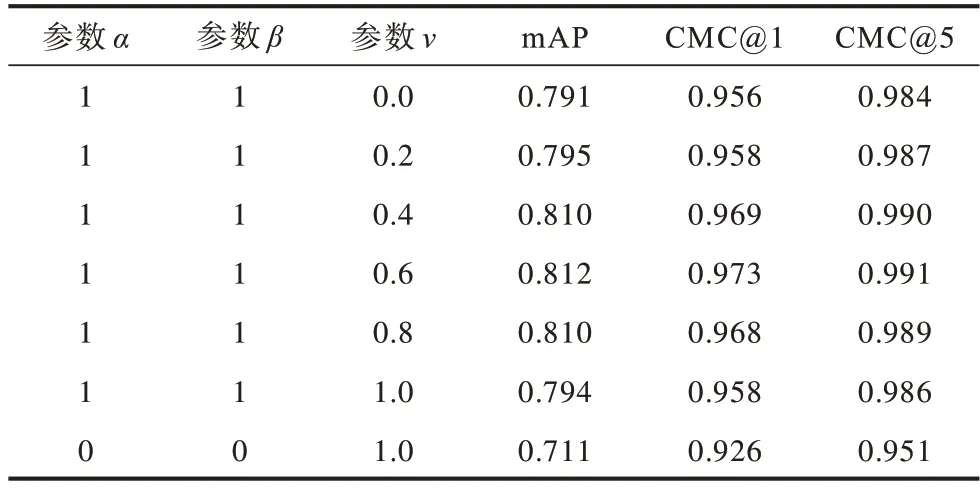

3.3.4 损失函数平衡参数的影响

文献[14]和文献[22]在利用多任务学习思想设计损失函数时,采用的思路是通过固定全局特征的ID Loss 和Triplet loss 不变,改变其他特征(如局部特征)损失函数的参数,从而得到较好的参数值。受上述文献优化多损失函数的启发,本文选择先固定全局特征损失函数参数,改变局部特征参数值,直到找到算法的最优平衡参数。基于此,本文设置消融实验验证损失函数平衡参数选择对重识别的影响,结果如表4 所示。

表4 损失函数中平衡参数的影响Table 4 The effect of balance parameter in loss function

由式(8)可知,参数v越大,重识别结果越依赖于局部特征,而参数α和参数β越大,重识别结果越依赖于全局特征。当参数α和参数β都为0 时,模型仅学习视角局部特征。反之,当参数v为0 时,表示模型仅学习车辆的全局特征而忽略局部特征。因此,本文设置v∈[0,1],每隔0.2 重新训练模型并进行测试。由表4 可知,当α=β=1且v=0.6 时,模型的重识别效果最好。因此,本文在后续实验中均采用v=0.6,α=β=1 的参数设置。

3.3.5 车辆视角内局部注意力图数量的影响

模型学习更多的局部区域特征通常能够带来更好的重识别效果。本文通过设计多组消融实验以验证视角内局部注意力图数量对重识别效果的影响,实验结果如表5 所示。为直观地观察车辆视角内局部注意力图个数与重识别效果的影响,本文可视化了表5 的实验结果,结果如图6 所示。

表5 不同注意力图数目的的实验结果对比Table 5 Comparison of experimental results of different number of attention map

图6 注意力图数目的性能比较Fig.6 Performance of comparison of the number of attention maps

由图6 可知,随着注意力图数量的增加,重识别精度呈现上升后趋于平稳的趋势。其中,当注意力图数量小于6 时,增加注意力图数量能够显著提升重识别的精度。当注意力图数量超过6 时,重识别精度逐渐趋于稳定,最终mAP 值基本稳定在0.812。考虑到模型训练资源和学习效率的因素,本文最终将VPAN 网络中每个视角注意力图数量设置为8。

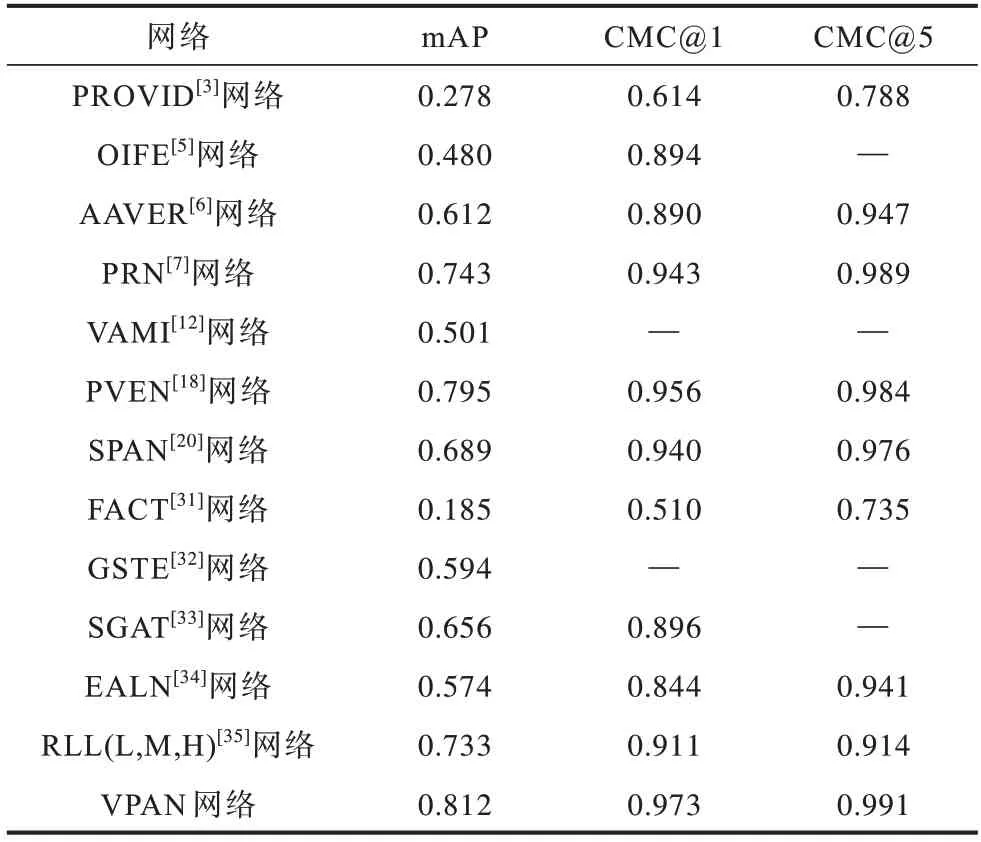

3.4 与其他网络的对比

为验证本文网络的有效性,将VPAN 网络分别在VeRi-776 和VehicleID 这2 个车辆公开数据集上与其他车辆重识别的网络进行对比,结果分别如表6和表7 所示。

表6 不同网络在VeRi-776 数据集下的结果对比Table 6 Comparison of results of different networks under VeRi-776 dataset

表7 不同网络在VehicleID 数据集下的结果对比Table 7 Comparison of results of different networks under VehicleID dataset

由表6 可知,相较于其他重识别网络,VPAN(本文网络)和PVEN 网络在VeRi-776 数据集上的重识别精度均远超其他车辆重识别网络,取得了最高的mAP、CMC@1 和CMC@5。虽然PVEN 网络能够学习车辆视角特征,在一定程度上提高了重识别的精度,但该网络不能学习到每个视角下所有鉴别力的局部特征,而这些细微局部对于区分2 辆外观极其相似的车辆十分重要。不同于PVEN 网络,本文网络不仅能够学习到车辆视角特征,还能够通过视角感知下的局部增强模块自适应学习每个视角下有区别性的局部特征。此外,在共同视角注意力增强模块的帮助下,本文网络增强了共同视角特征学习。

由表7可知,本文网络在VehicleID的小、中和大3个测试子集上均取得了较优的结果。在VehicleID 规模最大的子集上,本文网络的CMC@1、CMC@5 值均比现有较好的PVEN 网络高出了2.3个百分点。VehicleID大规模子集由于包含了更多车辆图片视角变化、背景、遮挡等,因此相比于小和中两个测试子集更难对车辆进行重识别。综上可知,相对于PVEN 等网络,本文网络能够更好地适应车辆视角变化、背景、遮挡等恶劣条件,具有更强的特征表示能力。

4 结束语

本文通过构建一种视角感知局部注意力网络对车辆进行重识别,采用视角感知下的局部增强模块自适应学习视角内潜在的显著性局部特征,通过共同视角注意力增强模块,使重识别车辆共同视角下的特征学习得到增强,不同视角下的特征学习得到抑制。在VeRi-776 和VehicleID 两个数据集上的实验结果表明,本文网络相比于PRN、PVEN、SAVER等网络具有更高的识别精度和更强的泛化能力,在多视角场景下执行重识别任务时的识别效果获得了大幅提升。下一步将利用度量学习的方法设计更适合的损失函数,以建模车辆的视角信息,实现无人工标注下的车辆视角特征学习。