面向网联环境的汽车平视显示器人因测试研究综述与展望

赵晓华,李雪玮,张 钰,李振龙,李海舰,张建华

(交通工程北京市重点实验室(北京工业大学),北京工业大学 城市建设学部,北京 100124,中国)

伴随着智能交通系统从动态感知、主动管理到智能网联的逐步发展[1],网联环境将逐步走向应用。广义网联环境涵盖智能网联车、车联网、主动道路管理系统、网联自动化车辆、自动公路系统等要素,车载设备、路侧装备、全网信息中心以及车辆通信所产生的海量共享信息都将有可能传输给驾驶人[2]。与此同时,智能网联车辆也正在经历自主式驾驶辅助、网联式驾驶辅助、人机共驾至高级别自动和无人驾驶的不同阶段[3],驾驶人角色不断发生转变,车内任务愈加复杂。因此,面对网联环境下愈加丰富的信息供给与复杂多变的车内任务,如何提升其信息传递的高效性和安全性是目前亟待解决的关键问题。

平视显示系统(head up displays,HUD)为网联环境下车内人机交互提供了解决方案。HUD 利用光学反射原理将驾驶相关信息投影至驾驶人的视线前方,降低驾驶人低头频率和视线对焦需求,提高信息读取效率,改善驾驶分心及负荷,可以有效保障驾驶安全。《汽车智能座舱白皮书》[4]和《车路一体化智能网联体系C-V2X 白皮书》[5]指出,HUD 作为网联汽车中重点发展的人车交互技术,已成为智能座舱的重要组成部分,并将为网联自动驾驶技术的发展铺路[6]。据估计,2019—2025 年中国前装HUD 市场渗透率将从7.5%提升至80%[7],到2024 年,大概1/3 的车辆会配备HUD[8]。在市场发展与政策推动的双重影响下,HUD已成为网联环境下车内人机交互的必然趋势。

面对HUD 强大的市场发展潜力与应用前景,设计研发人员旨在努力创造更大的技术突破以获取更远的虚拟图像距离与更大的视角,但开展HUD 人因测试量化其对驾驶人行为绩效和驾驶安全的影响,是网联环境下HUD 发挥预期效益的关键前提和迫切需求[9-10]。本文将从HUD 的分类应用、研究趋势、研究框架及场景测试4 个方面对面向网联环境的HUD人因测试研究进行综述,归纳分析关键研究点及不足之处,并提出未来发展方向,为HUD 设计和研究人员提供参考。

1 平视显示分类及应用

1.1 平视显示器分类

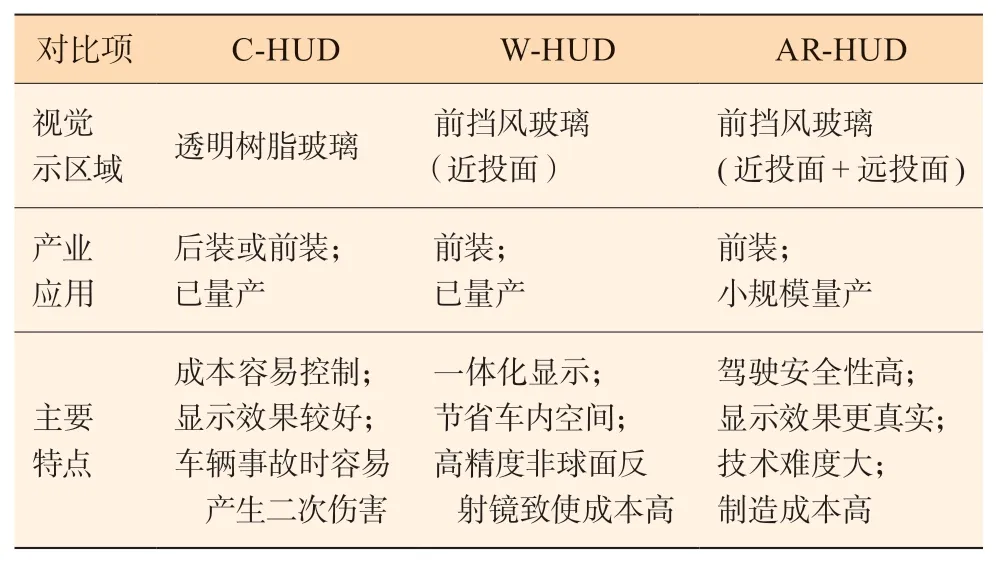

平视显示器的类型分为组合型(combiner HUD,C-HUD),风挡型(windshield HUD,W-HUD)和增强现实型 (augmented reality HUD,AR-HUD),如图1所示,分别来源于车萝卜、宝马和松下。

图1 3 种HUD 分类形式

1.1.1 C-HUD

C-HUD 利用投影装置投射图像到一块透明树脂面板,以后装方式为主。不同的C-HUD 系统投影设备位置有所不同,可放置在仪表板或吸附在挡风玻璃上。C-HUD 通常连接到车载诊断(on-board diagnostic,OBD)接口,以获取车辆状态信息,同时可以联网显示导航类信息及娱乐通信信息。C-HUD 具有成本易控制、灵活性强和普适性高的优点,但车辆发生事故时易对驾驶人造成二次伤害。

1.1.2 W-HUD

W-HUD 通常采用前装方式,信息直接投影在前挡风玻璃上,并且不同的W-HUD 系统在挡风玻璃上投影区域的位置和范围不同。然而,W-HUD 需要根据挡风玻璃的尺寸和曲率进行高精度非球面反射才能清晰显示,因此导致了高成本问题。W-HUD 信息包括车辆状态信息、导航信息、驾驶辅助信息和通信娱乐信息。近年来已逐渐从高端车辆向中端车辆普及,是目前车内HUD 的主流应用产品。

1.1.3 AR-HUD

W-HUD 是直接投射到挡风玻璃上或以固定距离投射到挡风玻璃上的2D 显示器,驾驶人在HUD 与环境间的注意切换导致驾驶人不能同时处理HUD 信息与真实环境信息[11]。AR-HUD利用增强现实技术 (augmented reality,AR)将虚像信息和现实路况实时叠加[12],有效提高驾驶安全并优化驾驶体验。AR-HUD 通常由一个近投面和远投面组成,近投面与W-HUD 相似,远投面则主要显示与道路交通相融合的增强现实型信息,以导航和高级驾驶辅助(advanced driving assistance system,ADAS)信息为主。一方面,AR 线索可以突出显示交通标志、冲突对象等已有信息;另一方面,可以产生虚拟信息与道路环境融合,例如导航虚拟指示箭头等。目前AR-HUD 已成为开发研究重点,研发人员旨在通过改进光学技术提高投影距离和车道覆盖范围,但技术难度大,制造成本高。3 种HUD 的对比如表1 所示[13]。

表1 不同类别HUD 对比

1.2 平视显示器应用

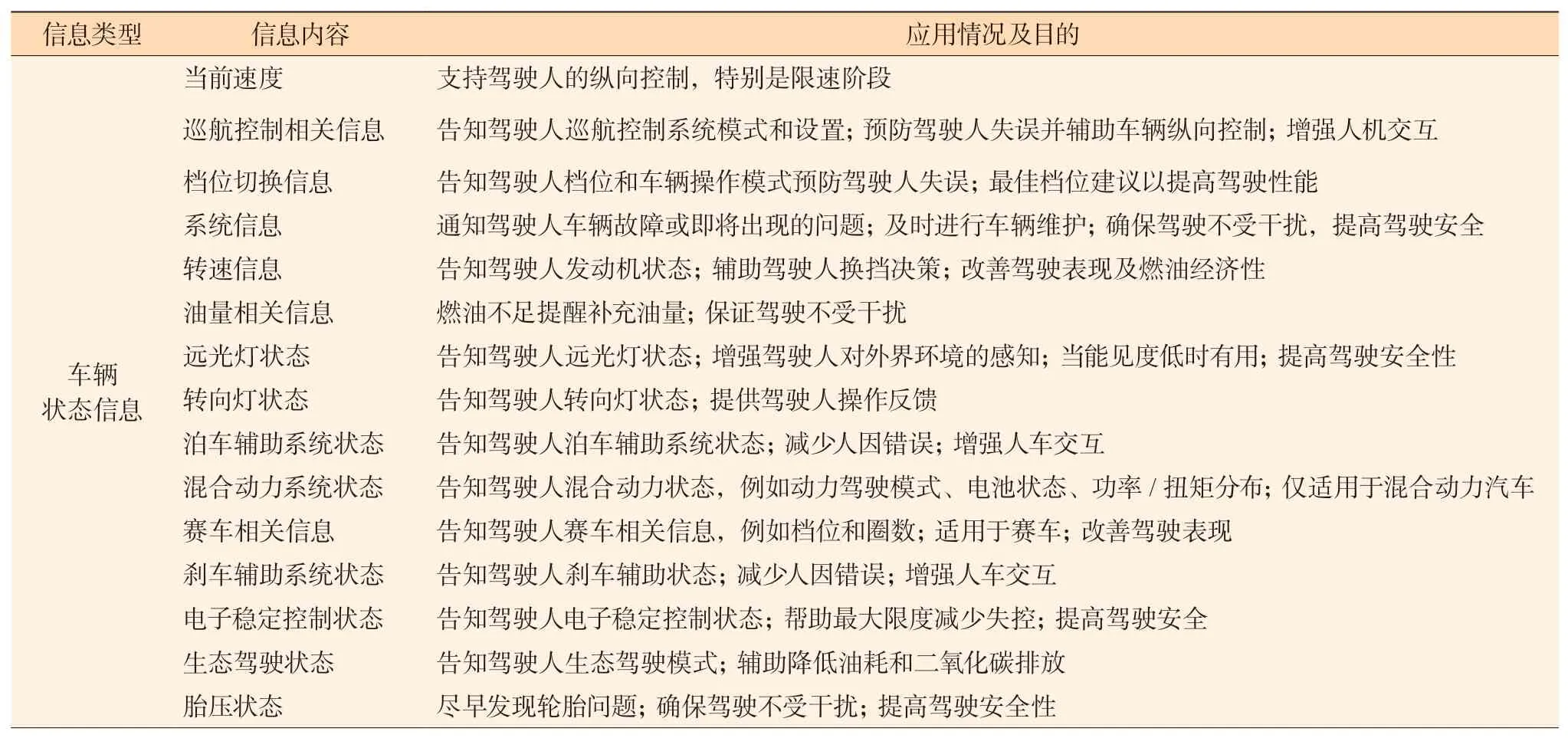

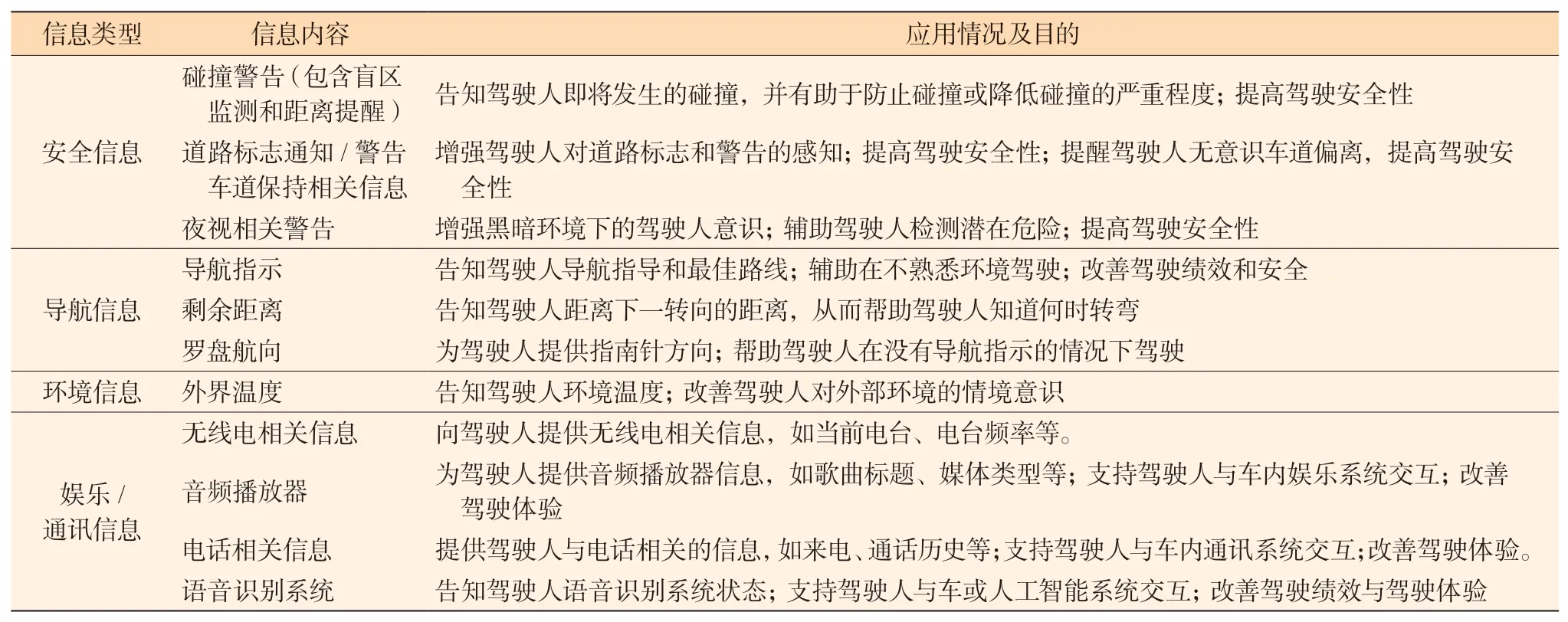

以往研究调研了现有商用HUD 的功能,识别包含车辆状态信息、安全信息、导航信息、通信娱乐信息及环境信息5 类共27 种信息,如表2 所示。然而,上述信息中专门为汽车HUD 创建的并不多,这一点反应了制造商可能将HUD 定位为传统显示器的额外补充[14],存在一定的局限性。

表2 商用HUD 显示的信息类型和应用情况

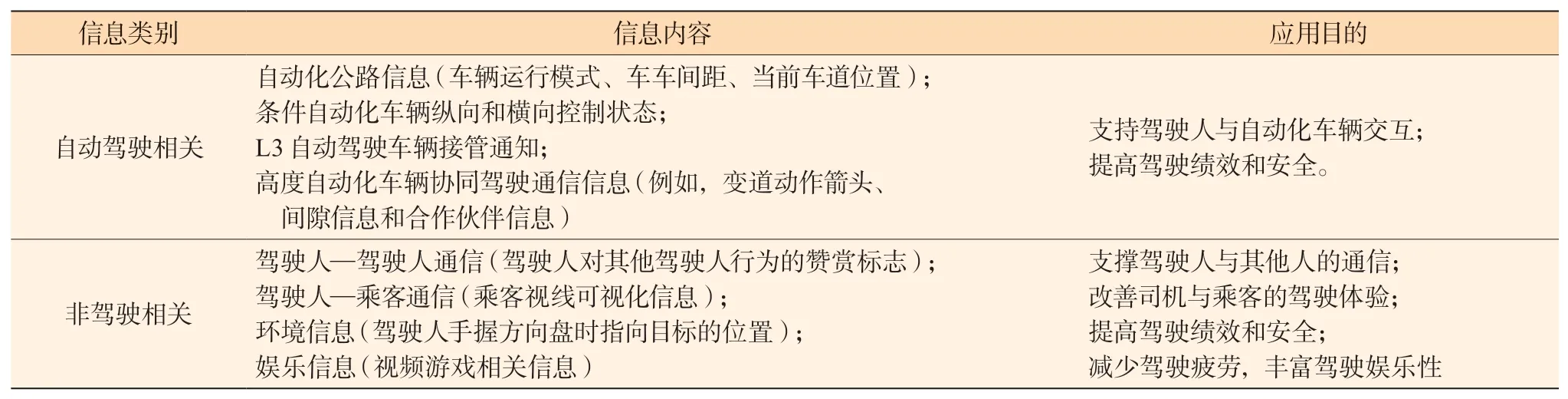

除了上述常规信息外,新兴自动驾驶汽车和车辆通信技术将产生一系列网联环境下新的信息需求和供给。以往研究建议HUD 集成自动驾驶相关信息及非驾驶相关信息,如表3 所示。其中,自动驾驶相关信息包括自动驾驶公路信息、半自动化车辆纵向和横向控制状态信息、L3 级自动驾驶车辆接管通知及高度自动化车辆间协同驾驶的通信信息等;非驾驶相关信息包括支持驾驶人—乘客协作的乘客视线可视化信息及支持视频游戏的娱乐信息等[14]。以上信息将构成网联环境下HUD 的功能模块与应用场景。而学者们面向网联环境的HUD 人因测试研究正是围绕着上述信息功能及应用场景逐步展开,对于其产业化推广应用提供了参考和支撑。

表3 研究建议的非传统HUD 信息类型汇总

?

2 平视显示器人因研究总体趋势

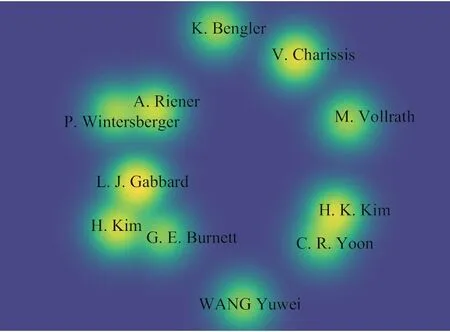

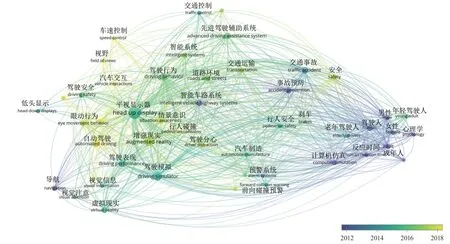

为掌握平视显示器人因研究总体趋势,本研究以“head up display(s)”和“driving”或“driver”为关键词进行Scopus 数据库检索,排除光学、航空、飞机等无关主题,得到256 篇文献,将引文信息、摘要和关键词以csv 格式导出。经过进一步人工筛选,共得到1990—2022 年包含国内外学者发表的英文学术论文及综述类文章共计245 篇。研究采用VOSviewer 软件对文献知识单元进行可视化分析,利用关键词共现矩阵布局生成如图2 所示知识图谱,挖掘研究关键内容及其随时间变化的过程。在此基础上进一步分析主要研究团队的地域分布,如图3 所示。

图3 HUD 人因研究团队

2.1 内容维度

关键词识别结果表明,以往研究中显示器类型主要包含低头显示器、平视显示器和增强现实型;应用场景可划分为导航、驾驶辅助类(先进驾驶辅助系统、前向碰撞预警、预警系统、行人碰撞)和自动驾驶类;测试手段包含驾驶模拟、计算机仿真和虚拟现实技术;测量参数涵盖主观情境意识测量、眼动行为类(视觉信息、眼动行为、视野等)和驾驶行为类(驾驶行为、驾驶绩效、驾驶任务、车速控制、刹车、反应时间等);此外,也考虑驾驶人的性别、年龄等个体因素(男性与女性驾驶人,年轻与老年驾驶人)。

关键词间关联性表明:1)与导航相关的测试关注驾驶人在不同视觉信息给予和驾驶任务下的驾驶表现;2) 驾驶辅助场景中重点考虑低能见度(夜间、雾天)或分心驾驶人在行人、急停车辆等冲突场景下的避撞,分析驾驶人反应时间、刹车决策、车速控制和事故预防等安全指标;3) 自动驾驶则以接管绩效为主。

2.2 时间维度

如图2 时间轴所示,颜色越深代表时间越早。可以看出,早期研究主要基于计算机模拟研究不同属性驾驶人在导航场景中的绩效差异;随后开始基于驾驶模拟技术针对驾驶辅助展开研究,显示器的类型主要是HDD 和HUD;近年来,开始借助驾驶模拟平台和虚拟现实技术对AR-HUD和W-HUD在自动驾驶方面的应用展开研究。

图2 HUD 人因研究关键词知识图谱

2.3 空间维度

利用VOSviewer 软件将作者进行归纳聚类,最终得到发表文献较多的11 位作者信息,并将同一团队的学者进行关联得到3 个较大的团队,分别是:

1) 美国弗吉尼亚理工大学工业与系统工程系L. J.Gabbard、H. Kim 和英国诺丁汉大学的G. E. Burnett等人,团队主要研究关键词为汽车用户界面、AR、人因、认知和感知,检索文献中占比7.7%;

2) 韩国大田市智能机器人研究部电子与电信研究所的H. K. Kim、 C. R. Yoon 等人,团队主要研究关键词为情感识别、特征提取、认知、显示设备、驾驶人信息系统、道路安全、交通工程等,文献占比4.5%;

3) 德国英戈尔施塔特应用技术大学的Prof. Priv.-Doz、 Dr. A. Riener、P. Wintersberger 等人,研究关键词为人机界面、ADAS、人因、人机工程学、自动驾驶等,文献占比2.4%。

同时,检索到与V. Charissis 学者相关文献10 篇,占检索文献的4.1%,该学者来自英国格拉斯哥喀里多尼亚大学计算机通信与交互系统系虚拟现实与仿真实验室(VRS 实验室),研究关键词为人机交互界面、VR、AR、多模态、用户体验等。

另外,来自中国的主要有浙江理工大学心理系的WANG Yuwei、YANG Zhen 等团队,他们研究的关键词为人因、交通安全、驾驶行为、视觉和认知注意。

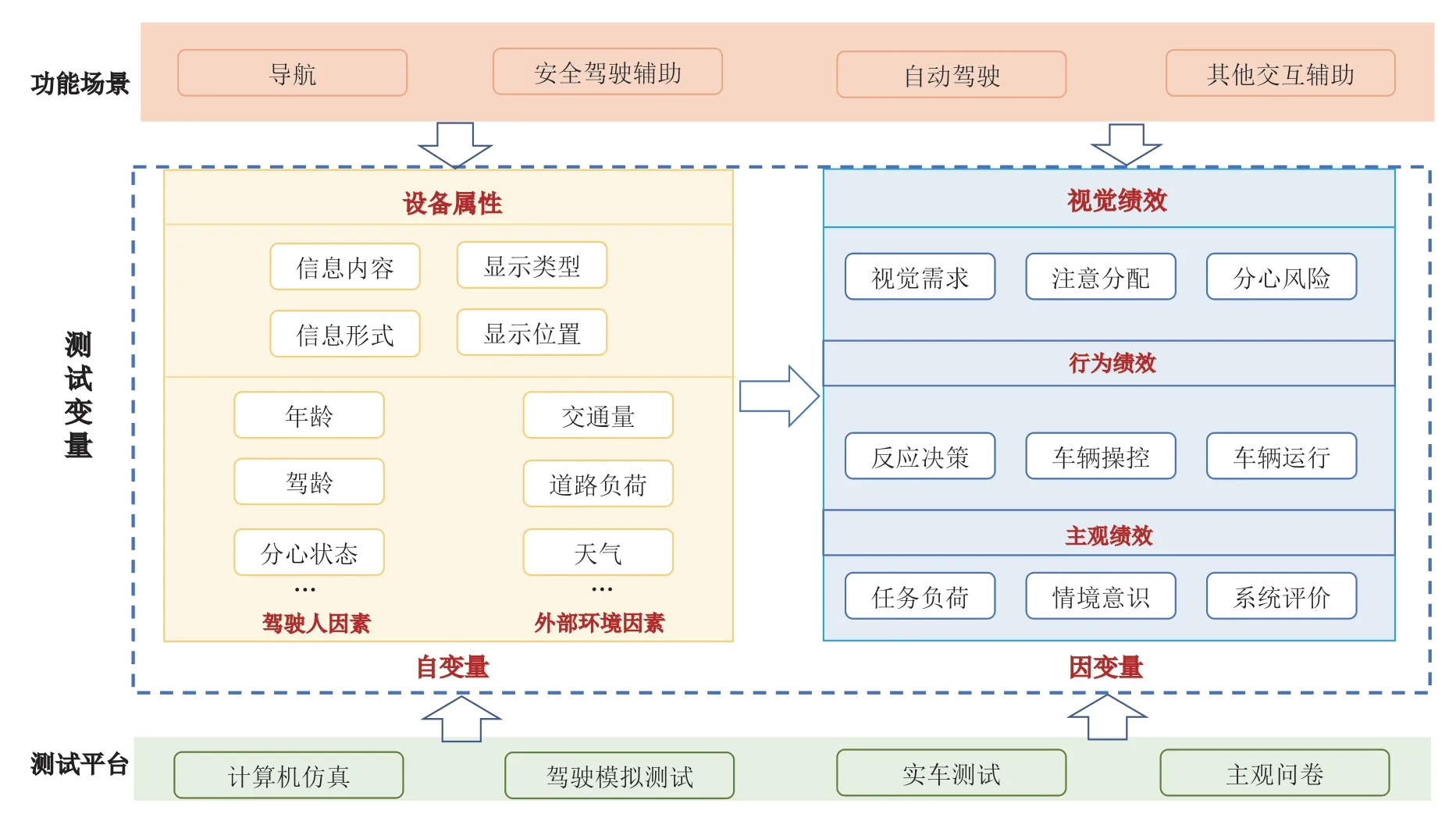

3 网联环境下HUD人因测试框架

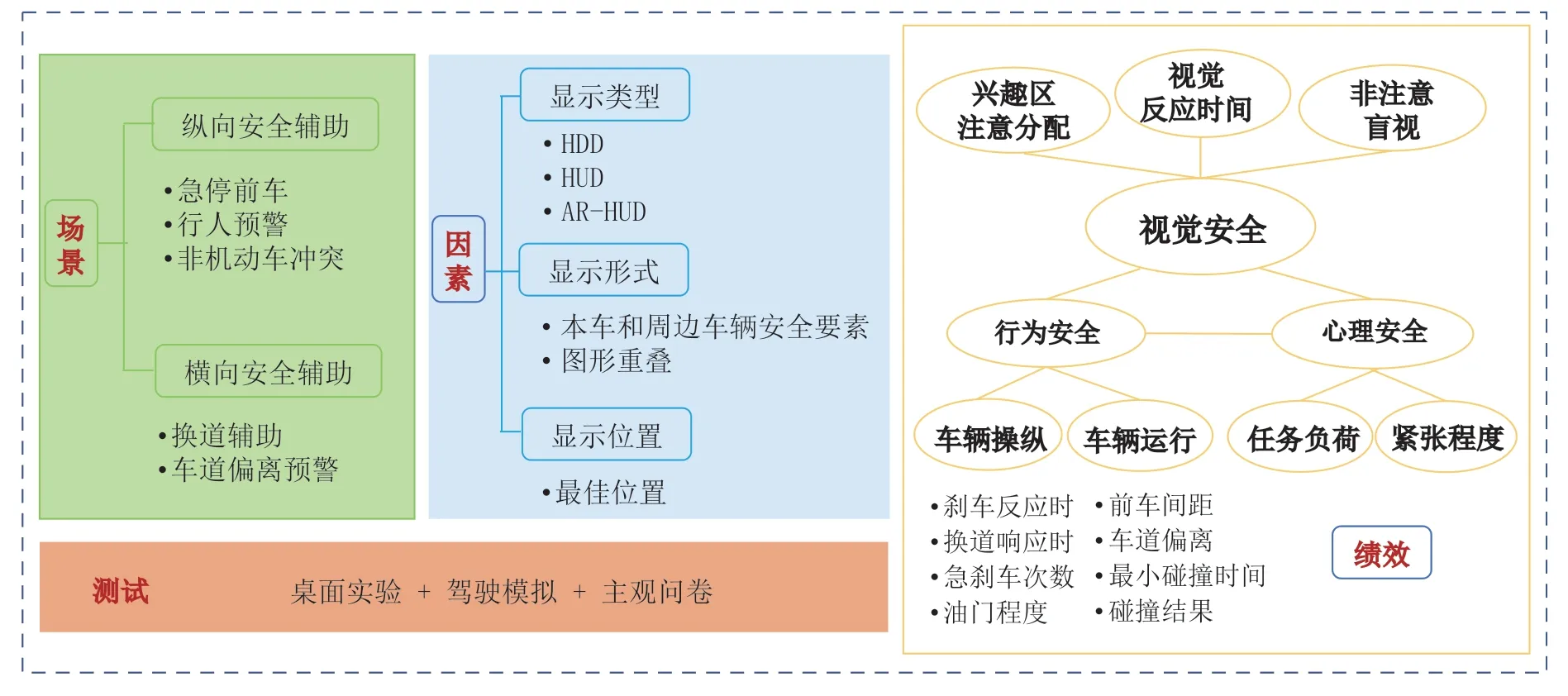

HUD 作为车内信息集成系统,除车辆状态信息外,包含导航、安全驾驶辅助、娱乐通信信息等主要功能模块,并在自动驾驶领域具备极强的应用前景。美国国家公路交通安全管理局 (National Highway Traffic Safety Administration,NHTSA)于2013 年制定了车载设备评估指南[15],但研究表明该指南不适用于汽车HUD 的有效性评估[16]。面向复杂任务场景下的测试需求,本文根据目前研究内容提出了HUD人因测试研究总体框架,如图4 所示。

图4 网联环境下HUD 人因测试框架

首先,人因测试研究以应用场景为驱动,主要涵盖导航、安全辅助、自动驾驶辅助及其他交互辅助4 类。其他交互辅助主要指采用HUD 辅助完成驾驶次任务和非驾驶相关任务。其中,驾驶次任务用于辅助驾驶主任务,例如查看仪表信息、鸣喇叭、切换远近光灯等。非驾驶相关任务指拨打电话、调节空调、音乐播放等。

其次,测试自变量包含设备属性、驾驶人因素及外部环境因素3 大类。设备属性为研究中的主要因素和优化目标参数,主要包括:1) 信息内容;2) 显示类型;3)信息形式;4) 显示位置的单独或组合效应。在此基础上考虑了驾驶人因素和外部环境因素的叠加影响,其中,驾驶人因素指驾驶人年龄、驾龄、分心状态等,外部环境因素包含天气条件、道路条件和交通条件等。

再次,测试因变量可归纳为视觉绩效、行为绩效和主观绩效。视觉绩效考虑设备引发的视觉需求、注意分配及分心风险;行为绩效则主要关注驾驶人反应决策能力、车辆操控能力及车辆运行绩效;主观评估绩效包括任务负荷、情境意识等自我评估及系统效用评价。

最后,测试手段包含主观问卷、计算机仿真(桌面实验)、驾驶模拟测试和实车测试。由于桌面实验数据获取有限性及实车测试的高成本和低可控性,驾驶模拟为目前主要的测试手段,主观问卷常作为数据补充手段。

4 平视显示器的人因测试研究

学者们针对4 类HUD 应用场景在人因测试方面开展了相关研究工作,为HUD 的设计优化及应用推广奠定了基础。

4.1 导航场景测试

即使在网联环境下导航仍是最基本的驾驶任务,驾驶人需在环境中定位并规划路线。针对HUD 的导航信息服务,学者们主要针对信息内容、显示类型、信息形式和显示位置这4 种设备属性开展了相关研究。

4.1.1 导航信息内容

导航信息内容方面,学者们开始探索车车通信和车路通信技术产生的新信息集成于HUD 的可行性。以交通信号灯信息为例,对于信号交叉口,YANG Bo 等分别使用普通显示屏和HUD 为驾驶人提供“当前”模式与“预测”模式的2 种车内交通灯。结果表明,HUD平均浏览时间更短,“预测”模式有助于车辆平稳操作。研究证实了HUD 适用于提供车内交通信号灯信息[17]。对于无信号交叉口,研究表明采用HUD 显示车内虚拟交通信号灯可显著增加后侵入时间和减小最大制动距离,驾驶人对道路中心区域的视觉行为也表明HUD 不会造成不可接受的视觉分心[17]。

另一方面,学者们则考虑如何为驾驶人过滤有效信息。尤其是对于更加吸引驾驶人关注的AR-HUD[18],信息过多会分散驾驶人注意力[19]或导致处理道路信息失败[20]。有效的AR-HUD 系统应该突出或优先显示与当前任务直接相关的信息,保障视觉注意的高效分配,避免驾驶人执行任务时的决策分心。这些研究为如何在增强现实的基础上设计导航系统信息交互提供了重要的方向[21]。

4.1.2 导航显示类型

导航显示类型主要包括语音导航、纸质地图、HDD、HUD 和AR-HUD。早期研究中,R. Srinivasan和P. P. Jovanis 比较了纸质地图、HDD 方向导航、HDD 电子路线图、HUD 方向导航和语音导航系统在模拟路网中的导航效用。结果表明使用语音导航反应最快,纸质地图反应最慢,同时HUD 方向导航比HDD 方向导航反应更快[22]。LIU Yungching 和WEN Minghui 进一步考虑了显示类型与道路负荷的交互作用。驾驶模拟实验结果表明,在高驾驶负荷条件下,HUD 比HDD 产生更好的速度控制和对限速标志、紧急事件的更快反应[23]。然而,这是一项视觉信息研究,仅需驾驶人对警告信息做出刹车响应而非对实际障碍物的避险过程。

随着AR 技术在导航服务中的进一步应用,AR导航与HUD 导航相比可以更直观地理解并简化导航任务[24],从而减少导航错误[25]。Z. Medenica 等提出了一种悬停在车辆上方的AR 导航路线显示方案,与街景导航和标准地图导航相比,AR 导航能更好地保证驾驶人在前方道路的注意分配并得到驾驶人的积极评价[26]。而在模糊导航情况下,相比于HUD 组驾驶人的降速补偿行为,AR 导航能够保证驾驶人在交叉口的进近速度更高,非驾驶相关任务的反应时间更快,精神负荷更低[27]。

4.1.3 导航信息形式

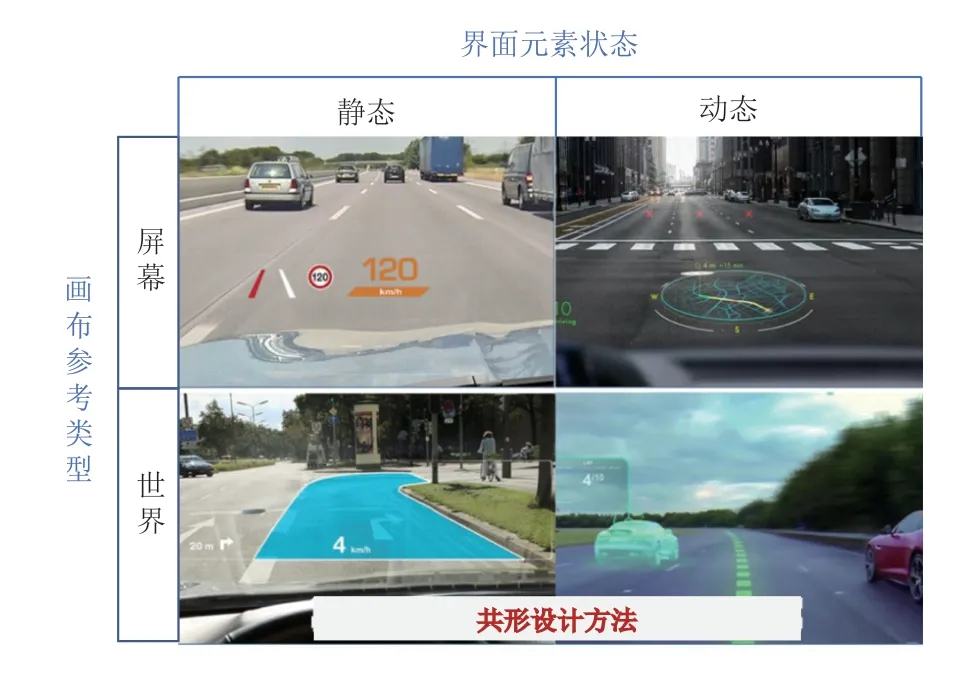

导航信息的AR 可视化是重点研究方向,已有研究从设计方法和应用效用两方面开展了讨论。

从设计方法来看,J. L. Gabbard 等从用户角度概念化汽车AR 界面的设计空间为车内屏幕显示方式(screen-fixed)与周边环境显示方式(world-fixed)2 种。其中,周边环境显示方式又称共形图形,可以将驾驶人注意力引向真实世界参照物[28]。C. Merenda 等人以画布参考类型和界面元素状态进一步将AR 图形进行分类,如图5[29]所示。其中,画布参考类型指以屏幕区域或车辆前方立体空间为参考系;界面元素状态指交互界面中特定位置的静态元素或立体旋转、平移变化的动态元素。然而,真正的共形显示需基于车辆技术实时渲染以地理位置为参考的3D 图形,因此很难在实车研究中开展,目前均依托计算机仿真或驾驶模拟开展测试。

图5 AR-HUD 共形设计方法

从应用效用来看,尽管有研究发现AR 图形与传统HUD 视图相比能提高任务性能[30],加快制动反应时间和平滑制动曲线[31-32],但其他研究也表明AR 图形并不一定在所有情况下都比其他HUD 界面更优。例如,驾驶人使用共形图形时倾向于将更多的视觉注意力分配给HUD,不一定有助于危险扫描,也并未对转弯车辆的安全性产生显著影响[10]。尽管C. Merenda 等提出的屏幕—动态图形能产生最高的判断准确度,但并不能保证响应效率,可能不适用于需要细粒度或严格定位的目标导向任务[29]。因而,在探寻AR 图形设计方法时还应与任务场景相匹配。

4.1.4 导航显示位置

以往研究针对HUD 导航信息显示位置给出了建议和指导。一般来说,HUD 图像应位于驾驶人垂直或水平视线之外,直接放置在驾驶人前方方向盘后侧,或位于第3 扇区方向盘右侧,且不超过驾驶人视野下方30°[33]。NHTSA 指南中建议HUD 位于驾驶人视图中心线右侧5°和下方5°处[34],相关研究也表明随着使用时间的增加用户最偏好的HUD 位置是驾驶人视线下方5°[35]。

然而,研究进一步指出最佳HUD 位置随驾驶任务变化而变化。J. M. Flanagan 和J. A. Harrison 研究了HUD 位置对不同年龄驾驶人路径识别和行人探测能力的影响。当HUD 呈现在视线下方15°时,方向判断任务绩效更好;当HUD 呈现在视线下方4°时,行人探测任务绩效更好。同时,老年驾驶人执行视觉注意分散任务时难度更大,更能从HUD 中受益[36]。

综合来看,由于研究采用的实验任务和方法不尽相同,道路环境、天气状况和其他额外变量都无法得到有效控制,导致以往研究结果并不一致。鉴于此,未来研究需在NHTSA 建议的基础上结合驾驶任务和驾驶人偏好进一步细化,以获取HUD 导航信息最佳位置的指导建议。

HUD 导航研究主要以城市道路场景为主,比较导航信息内容、显示类型、显示形式和显示位置对高效性和安全性的影响,如图6 所示, 其中,新兴信息引入主要考虑了信号灯状态。导航显示形式、AR 可视化设计及HUD 位置均需考虑与任务场景的匹配。另外,驾驶模拟是主要测试手段,实车测试十分稀少。

图6 HUD 导航功能研究总结

鉴于此,关于网联环境下的HUD 导航研究仍然有以下问题需要解决:挖掘网联环境下能够通过HUD 增强导航服务绩效的可用信息;探索HUD 或AR-HUD在不同导航场景下的适用性;有必要从理论和实际测试的角度共同研究AR 导航图像的优化设计及动态交互位置以保证其导航效用。

4.2 安全辅助场景测试

网联环境下HUD 安全辅助包含纵向和横向辅助2类。纵向驾驶辅助以前车、行人、非机动车等典型冲突的碰撞预警为主,是目前研究的重点内容;横向辅助场景主要指换道辅助和车道偏离预警。

4.2.1 预警信息显示类型

采用网联车辆数据的碰撞警告系统可通过增强驾驶人对预期状况的感知,辅助驾驶人及时采取避撞措施,降低追尾事故概率[37]。SAE J2400 建议前向碰撞预警系统不使用常规仪表板位置,因为此类警报可能会分散而不是引导驾驶人对前方碰撞威胁的注意[38]。与仪表板和仪表板上方显示器相比,HUD 更适用于前向碰撞系统信息[39]。因此,网联环境下使用HUD 显示碰撞预警信息可行性已被证实,从视觉绩效、行为绩效和主观感受层面进一步探索其应用效益。

视觉绩效层面,学者们探索了预警显示类型对驾驶人视觉绩效的改善及潜在原因。相关研究表明当驾驶人使用全风挡HUD 获取驾驶任务相关的情景提示时,其注视次数和平均注视持续时间更短,前向视野的停留时间百分比更大,两侧的停留时间百分比更小[40]。同时,HUD 预警能够大幅降低视觉反应时间,并引导驾驶人注意至危险物,减少对预警信息的盲视[41-42]。尤其是在夜间行驶条件下,AR-HUD 碰撞预警系统能提高驾驶人的直觉认知,减少驾驶人的注意力分散[43]。进一步,针对AR-HUD 可能引起的非注意盲视问题,研究发现使用AR-HUD 在意外刺激被增强时会降低被试非注意盲视概率,而在意外刺激未被增强时会提升被试非注意盲视的概率[44]。对于视觉绩效改善的原因,一些研究认为AR 线索可以引导驾驶人注意力更早地定位威胁[45],但其他人认为AR线索只是通过增加注视次数和减少任务特定性来改变视觉注意分配[21]。此外,视觉反应时间还受场景复杂性及目标可见度的影响[46]。

行为绩效层面,学者们探究了HUD 碰撞预警显示类型对低能见度和冲突事件下驾驶人避险行为的影响,反应时间是最常用的指标之一。H. K. Kim 等人证实驾驶人使用HUD 时显著提高前方危险的反应能力,但对左侧和右侧危险无显著影响[47]。对于雾天前车急停预警,HUD 碰撞预警系统可以帮助减少驾驶人反应时间并降低追尾事故概率。然而,听觉警告的显著附加效果并不显著[37]。夜间低能见度条件下,李卓等人采用动态视频法证实AR-HUD 系统可显著提高侧撞、行人以及易受伤害的非机动车这3 种危险场景的反应时间[48]。对于行人预警,AR 线索可以在感知水平、警惕水平和预期水平3 个层面上增强行人感知,驾驶人前车间距更长,油门踏板位置更小,急刹车次数更少[42]。另一项研究则设计了一种自适应行人预警系统,提出在预测驾驶人是否识别行人的前提下给定行人预警,然而在提高行人可见性及引导车辆保持合适距离方面,AR 和自适应AR 的表现无显著性差异[49]。

主观感受层面,研究表明AR-HUD 不仅对驾驶人的视觉安全及行为安全有一定的促进作用,还能够促进驾驶人心理安全驾驶[18]。AR-HUD 具有较高的接受度水平,可以改善驾驶人抗个人焦虑和抗个人愤怒因素与行人反应时间的负相关关系,缓解人际焦虑水平较高的驾驶人的紧张或压力,降低精神负荷[47]。

以上均为纵向驾驶辅助相关研究,关于横向驾驶辅助也针对换道辅助与车道偏离预警开展了相关分析。对于换道辅助,Y. Ali 等使用HUD 提供当前限速、车速、前车速度、前车间距、目标车道的车辆间隔等网联信息,证实了HUD 适用于网联环境下换道辅助[50]。而对于平视显示车道偏离预警(HUD-LDW),研究分别针对老年驾驶人和疲劳驾驶人展开。HUD-LDW 可减少年轻驾驶人和老年驾驶人的车道偏离矫正时间且时间下降幅度相似,但没有减少预警激活次数[51]。对于疲劳驾驶人,方向盘振动和方向盘扭矩比HUD-LDW 更有效,驾驶人反应时间更快,车道偏移更小,接受程度更高[52]。

可见,目前大多研究都围绕纵向驾驶辅助绩效展开,需要进一步挖掘HUD 横向驾驶辅助的潜在效益。

4.2.2 预警信息显示形式

国内外学者对于如何可视化预警信息以提高预警信息效用展开了讨论,包含本车和周边车辆安全要素可视化设计及评价。

针对本车安全要素,研究证实由道路安全标志衍生的安全停车距离被认为更直观有效,可有效辅助驾驶人保持安全车距和车速[53]。学者们进一步研究了如何设计AR 图形将安全停车距离可视化。通过驾驶模拟实验得出以虚拟条指示制动距离的方案能够保证驾驶绩效,不增加脑力负荷,并且更受驾驶人喜爱[54]。

除了本车安全停车距离,也可对潜在冲突的风险要素进行可视化叠加。为了辅助无左转信号交叉口的车辆左转,C. Tran 等人基于情境意识预测水平为驾驶人提供对向左转车辆路径。通过桌面实验和问卷测量从实心路径、V 型路径和线框图案中确定以AR 实心图案路径为最终方案,并建议辅助信息设计需考虑驾驶人的主观态度和偏好等因素[11]。

与此同时,应特别注意图形视觉复杂度对驾驶人视觉造成的不良影响[55]。“HUD 图形”和“道路环境事件”产生连续叠加,同时受自然光线的交互影响,不利于驾驶人辨别图形、感知线索的颜色和含义[56-57]。研究已经证实AR 图像重叠增加会对驾驶人视线持续时间产生负面影响,特别是对老年驾驶人[58]。

4.2.3 预警信息显示位置

预警信息显示位置对驾驶人信息探测、意识保持与注意切换等视觉安全具有重要意义。一方面,合理的预警信息位置有助于驾驶人探测预警信息的同时不干扰观察前方道路的道路物体和事件[35]; 另一方面,有助于支持驾驶人在信息、道路和危险物之间的视觉转移。驾驶人需快速捕捉预警信息,及时将视线返回道路,并采取相应避撞措施。如果驾驶人的视线离开路面超过2 s,发生碰撞事故可能性将会急剧上升[59]。

驾驶人的注意分配和非注意盲视受预警信息位置的显著影响。预警条件下驾驶人处于应激状态,其注意模式和正常情况显著不同[60]。史金磊选取了视线线正中心、视线上方8°、视线下方8°、视线左边8°和视线右边8°共5 个位置分析其对注意分配和驾驶绩效的影响。结果表明,当HUD 预警信息呈现在视线下方8°的位置时,驾驶人的驾驶绩效、注意分配和主观评价都最差,而其他位置在大多数指标上没有显著区别[41]。进一步,针对AR-HUD 的研究表明意外刺激位置和AR 提示框与刺激的相对位置都会影响驾驶人的非注意盲视。当意外刺激出现在道路两侧时,AR 提示框与刺激重叠会导致更多的非注意盲视;当意外刺激出现在道路中央时,AR 提示框与刺激重叠会减少非注意盲视[44]。因此,在设计中应重视预警信息的绝对位置和其与危险刺激间的相对位置。

目前,HUD 安全辅助人因测试研究分为纵向安全辅助和横向安全辅助场景测试2 类,以纵向安全辅助场景为主,如图7 所示。以往研究探讨了显示类型、显示形式和显示位置对驾驶安全性的影响。

图7 HUD 安全辅助功能研究总结

驾驶安全度量包含视觉安全、行为安全和心理安全3 个方面,以视觉安全和行为安全为主。视觉安全包含驾驶人的注意分配、对预警信息或危险物的视觉反应时间以及非注意盲视问题。行为安全包含避险过程中对方向盘、油门、刹车踏板的操纵,以及反映车辆运行状态时的前车间距、车道偏离等车辆横纵向安全性及与碰撞结果有关的指标。心理安全主要衡量驾驶人的任务负荷、精神负荷和紧张程度等。对于绩效指标评估,目前以描述统计为主,需采用精细化模型进一步挖掘驾驶人反应决策机理。

鉴于实车测试中网联环境的稀缺性、安全临界事件的高风险性以及HUD 和AR-HUD 的高成本,驾驶模拟测试是HUD 安全辅助测试的理想手段。然而,中国国内关于HUD 预警系统研究尚处于起步阶段,研究刚开始从桌面实验和问卷量测转向驾驶模拟测试。因此,创建支持网联环境HUD 与AR-HUD 测试的高沉浸度、高仿真度驾驶模拟测试平台也是目前国内科研团队需要解决的问题之一。

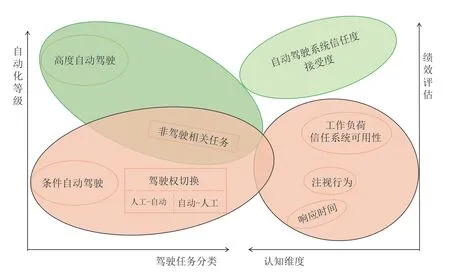

4.3 自动驾驶场景测试

基于驾驶自动化系统能够执行动态驾驶任务的程度,根据执行动态驾驶任务中的角色分配以及有无设计运行范围限制,中国将驾驶自动化分成0 级到5 级,分别为L0 应急辅助、L1 部分驾驶辅助、L2 组合驾驶辅助、L3 有条件自动驾驶、L4 高度自动驾驶和L5 完全自动驾驶[61]。目前研究主要探索有条件自动驾驶 (L3)情况下,驾驶人使用HUD 执行驾驶权切换任务和非驾驶相关活动时的心理、视觉和行为表现;对于完全自动化系统(L5),主要探讨HUD 对于提高驾驶人接受度和信任度方面的潜力。

4.3.1 有条件自动驾驶

驾驶自动化系统未激活时,驾驶人需要确认装备驾驶自动化系统的车辆状态是否可用,决定何时开启驾驶自动化系统将驾驶权移交给驾驶自动化系统。在自动驾驶系统激活后,驾驶人成为动态驾驶任务的后援用户,可以将视线移至非驾驶相关活动,但需监管车辆和环境保持一定的警觉性,在接收介入请求后及时执行接管[61]。可见,在有条件自动驾驶环境下,除了常规的车辆驾驶任务,驾驶人一是需要执行驾驶权切换任务,二是在自动驾驶系统激活后,驾驶人可从事非驾驶相关活动。

(1) 驾驶权切换任务

有条件自动驾驶环境下驾驶人需监管车辆和周围环境自动驾驶系统,并完成人工—自动和自动—人工2种驾驶权切换。

在监管车辆和环境方面,A. Feierle 等研究了城市道路环境跟车、前方障碍物换道、超越自行车、红灯交叉口场景下,驾驶人使用AR-HUD 和HUD 监测自动驾驶系统和外部环境时的主观绩效和视觉表现。视觉分析表明,与HUD 相比,驾驶人使用AR-HUD 时更关注前方道路,显示器注视持续时间比例显著降低,后视镜、左后视镜和右后视镜没有显著影响。主观层面,AR-HUD 显著提高驾驶人信任度,降低主观工作量,但在可用性方面没有显著差异[62]。

在驾驶权切换方面,N. Karatas 等开展驾驶模拟实验,在行人避撞场景下分别使用AR-HUD 和HUD提示自动化干预(人工—自动)视觉线索,结果表明基于AR-HUD 的视觉线索在接受度上更优,而可信度和用户体验上无差异;同时,AR-HUD 视觉线索可以支持更快的响应时间,有助于识别潜在障碍[63]。张艺凡通过实车静止和前方路面投影的方式获得了市区道路场景下如行人过马路、车辆变道等接管事件(自动—人工)的反应时间,也证实了AR-HUD 优于一般接管方式[64]。

(2) 非驾驶相关任务

自动驾驶系统激活后,驾驶人可在监控车辆的同时执行文本阅读等与驾驶无关的任务,以往研究衡量了HUD 完成非驾驶相关任务的绩效和对接管任务的影响。

在非驾驶相关任务条件下,C. Schartmüller 等分析了驾驶L3 自动驾驶车辆分别使用听觉设备和HUD时,执行文本阅读任务的绩效。与听觉设备相比,驾驶人使用HUD 时任务平均响应时间更快,可促进多任务的有序处理,从而减少工作负荷并提高生产率[65]。同时,驾驶人也更倾向于使用HUD 完成非驾驶相关任务[66]。进一步,在非驾驶相关任务条件下执行接管任务时,AR-HUD 具有更好的理解性和有效性,能够辅助驾驶人保持注意力[67]。

然而,有条件自动驾驶环境下,使用HUD 执行非驾驶相关任务的研究内容需进一步扩展,考虑不同任务的适用性和对驾驶绩效的影响。

4.3.2 完全自动驾驶

目前,完全自动驾驶相关的HUD人因测试较为稀少,主要从主观上探讨了HUD 在增强自动驾驶系统信任度和接受度的作用。P. Wintersberger 等针对上述问题开展了驾驶模拟研究。测试中驾驶人驾驶完全自动驾驶车辆(L5)在不可见的雾天下实现超车,结果表明与驾驶场景中交通要素相关的AR 提示可以提高用户信任度及接受度[68]。这也说明,AR-HUD 对于增强驾驶人对自动驾驶车辆的接受度和信任度方面极具潜力。

自动驾驶场景HUD人因测试以有条件自动驾驶下的车辆控制权切换任务和非驾驶相关任务为主,如图8 所示。有条件自动驾驶情况下,主观层面比较了不同显示类型的偏好、可理解性、有用性及任务负荷;视觉层面关注驾驶人对兴趣区域的注视行为;对于驾驶权切换则主要考虑响应时间。高度自动驾驶情况下,主要探讨了AR 信息对于提高驾驶人对自动化驾驶系统的接受度和信任度的潜力。目前来看,HUD 在自动驾驶场景中的测试尚属于起步阶段,对于自动驾驶条件下使用HUD 完成接管任务、驾驶次任务和非驾驶相关任务的潜在作用仍需进一步探索。

图8 HUD 自动驾驶场景应用研究

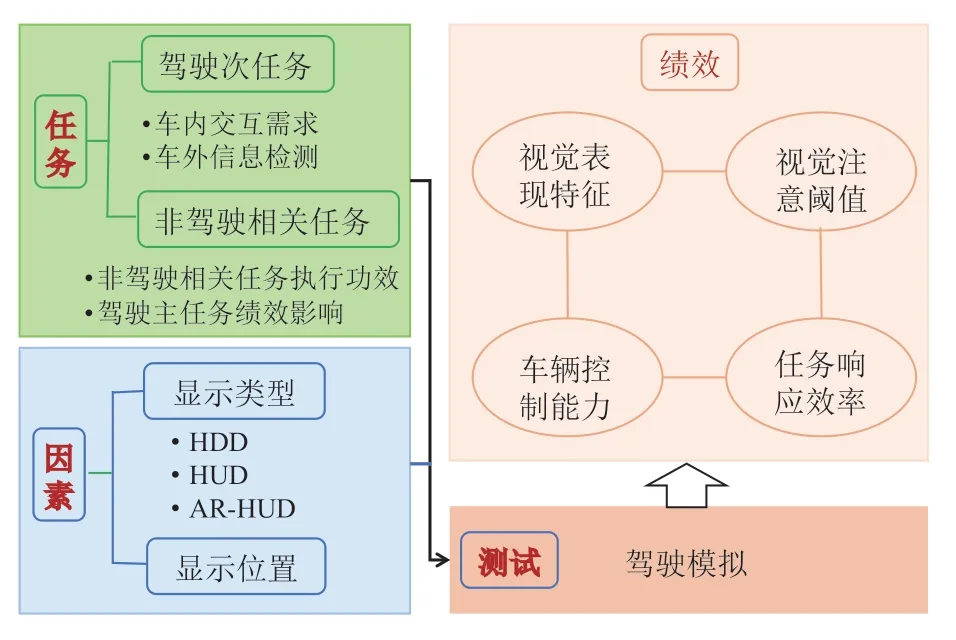

4.4 其他交互辅助测试

网联环境下HUD 已在出行导航、安全辅助及自动驾驶场景中得到广泛应用和深入讨论。除此之外,HUD 也可服务于驾驶次任务和非驾驶相关任务的交互辅助,其任务绩效以及对驾驶主任务造成的影响目前也有相关研究成果。尽管该部分研究尚未在网联环境下展开,但仍可作为综述中的一部分为网联环境下HUD 的推广应用提供参考。

4.4.1 驾驶次任务

在驾驶次任务方面,以往研究讨论了交互模态、显示类型、驾驶人负荷和注意特征等因素对车内交互需求和车外信息识别的影响。其中,车内交互需求包含信息读取和设备调节等任务,车外信息识别指路侧限速等信息的辨识与响应。

对于车内交互需求,研究表明:驾驶人使用听觉信息完成简单任务(如查看油量、电量、车速等)时表现更优;使用视听HUD 完成导航设置等复杂任务时效率更高,用户体验和偏好性更强;使用纯视觉HUD 则会导致感知工作负荷增加[69]。对于车外信息识别,LIU Yungching 等进一步考虑了负荷因素、注意初始位置和注意转移顺序,比较驾驶人使用HUD 完成限速检测和菱形图案检测时驾驶性能的差异, 最终得出HUD 辅助下驾驶人在低负荷和高负荷驾驶任务中均能更快地应对限速检测和响应任务,同时其任务绩效还受驾驶人对HUD 注意特征的影响[70]。

上述研究提供了有关HUD 设计与应用方面的建议:首先,建议采用多模态的视听交互HUD 能允许用户根据环境变化及自身需求选择信息获取通道[69];其次,建议使用前对用户进行培训和适应,减少新奇效应对驾驶绩效的负面影响[70]。

4.4.2 非驾驶相关任务

非驾驶相关任务的测试往往采用文本阅读、数字或字母搜索等替代任务,探讨显示类型、显示位置和任务类型等影响因素下,非驾驶相关任务的执行功效和对驾驶主任务的影响。

首先,对于非驾驶相关任务的执行功效,相关研究表明驾驶人使用特殊设计的透视图形HUD 完成开关空调、调节音乐等任务时比常规HUD 设计更有效[71]。进一步研究表明,驾驶人执行结构化视觉搜索任务任务(例如需遵从特定路径的文本阅读任务等)时,使用HUD 比HDD 响应速度更快。作者建议应该对HUD所适用的任务类型进一步明确[19]。

同时,对于驾驶主任务的影响表现在风险意识保持和车辆控制两方面。研究表明使用AR-HUD 执行字符搜索任务时,能辅助驾驶人对前方道路和领头车辆保持风险意识[72]。当HUD 图像与驾驶人前方视野距离太远时会降低车道保持能力[73],距离接近时可能会降低对意外事件的响应能力[74]。对于不同位置的HUD 图像,不干扰驾驶主任务时的视觉注意阈值高于NHTSA 标准,但仍需进一步评估[75]。

可见,对于非驾驶相关任务的研究应进一步明确HUD 可支持的任务类型和完成任务的视觉注意阈值,以保证驾驶主任务绩效和非驾驶相关任务的执行功效。

整体来看,针对驾驶次任务和非驾驶相关任务,通过对显示类型、显示位置和任务类型对视觉表现特征、视觉注意阈值、任务响应效率及车辆控制能力的影响进行研究探讨,表明应考虑任务敏感性、沉浸程度及最佳交互位置等多种因素的HUD 交互设计优化,如图9 所示。

图9 HUD 自动驾驶场景应用研究

5 现状总结与展望

5.1 现状总结

面向网联环境的HUD人因测试以功能应用场景为驱动,形成导航、安全辅助、自动驾驶以及其他交互辅助4 大版块,并以驾驶模拟为主要测试手段,探讨了设备属性、驾驶人因素和外部环境条件对驾驶人主观绩效、视觉绩效和行为绩效的影响。

从研究内容来看,导航研究考虑导航信息内容、显示类型、信息形式和显示位置对高效性和安全性的影响。安全辅助则分为纵向安全辅助和横向安全辅助2 类,重点考虑预警信息显示类型、显示形式及显示位置对驾驶人视觉安全、行为安全和心理安全的影响。自动驾驶场景下,考虑了有条件自动驾驶和完全自动驾驶场景下,使用HUD 切换驾驶权和执行非驾驶相关任务时的主观评估、视觉表现与任务响应。另外,在其他交互辅助场景中,探究了使用HUD 完成驾驶次任务和非驾驶相关任务时的视觉表现、任务响应和车辆控制能力。然而,针对HUD的人因测试仍然存在一些不足。

一方面,目前研究往往基于单一功能开展,缺乏与实际驾驶情景一致的多信息与多任务状态;同时,测试HUD 界面均为研究者自行设计,功能范围和界面设计与实际产品差异较大,因而对于实际产品的改善缺乏针对性;另外,缺乏关于HUD 可用性、有用性等与接受度有关的主观研究。除此以外,测试场景、指标构建及绩效评估方法均也未形成标准体系,其差异化结论在服务于HUD 设计与优化时难以有效移植。

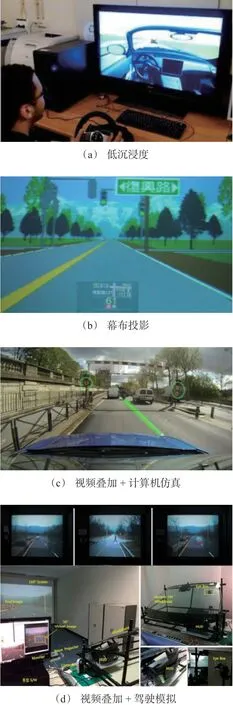

另一方面,研究还发现目前W-HUD 和AR-HUD在驾驶模拟器上的集成并不理想。如图10 所示,研究采取了低成本、低沉浸度的驾驶模拟器[53]、投影方案[45]、视频叠加仿真[21]和视频叠加驾驶模拟[18]等替代方案,在实验沉浸度及数据多样性方面存在很大的局限性。因此,构建高保真的HUD 测试平台也是目前国内研究团队开展HUD人因测试前需要解决的问题之一。

图10 HUD 自动驾驶场景应用研究

5.2 研究展望

根据目前的研究结果及现状总结不足,提出未来汽车HUD 系统设计和测试的研究方向如下:

1) 强化基础理论的支撑性。

· 构建用于指导HUD 设计与测试的理论基础模型。

2) 明确信息服务的适应性。

· 探索新兴多源网联信息的适用性与HUD 相结合的可能性;

· 考虑不同自动化等级车内交互的信息需求;

· 考虑信息需求的动态性、场景敏感性和个人特性;

· 考虑车内HUD 与HDD 的协同匹配;

· 探索娱乐辅助信息的可行性。

3) 确保信息表现的有效性。

· 考虑驾驶人偏好的AR 图形设计;

· 考虑任务差异的AR 信息适用性;

· 真实环境与AR 图形的融合。

4) 提升人因测试的科学性。

· 测试用户的技术可接受水平;

· 搭建高保真的测试平台;

· 开发满足差异化需求的场景库;

· 形成多维度的指标体系;

· 构建定量化评估体系。

6 结 语

作为网联环境下车内人机交互发展的热点方向,平视显示器(HUD)在优化驾驶体验和保障行车安全等方面发挥着重要作用,开展HUD人因测试是保障其预期效益的关键前提。围绕网联环境下HUD人因测试研究,本文综述了HUD 的现状应用和研究趋势,提出了HUD人因测试框架,并针对导航、安全辅助、自动驾驶及其他交互辅助场景下的人因测试分别展开详细论述,最后提出HUD人因测试的未来研究方向。以上研究可为面向网联环境的HUD 设计、改善及应用提供参考。

然而,由于网联环境尚未全面普及,HUD人因测试研究在中国国内也仍处于起步阶段,尚未形成国内HUD 测试研究体系,特别是在特殊复杂场景下基于驾驶人感知、决策、操控、行为、生心理和主观感受的认知过程全链路的综合评价方法有待进一步深入,进而确保HUD 实际应用的科学性。

未来研究需结合中国驾驶人偏好、个人特性等人因因素,依托交通工程、认知心理学等多学科理论基础,探索网联环境下新兴信息集成及信息可视化方法,建立标准化的测试平台及测试方法体系。尤其是需要提升测试装备与测试平台的高保真度,加强测试环境与测试场景的规范性,保障测试规程与测试方法的科学性,注重模拟测试与实车测试的融合联动,进而更好地服务于网联环境下HUD 设计与优化,促进智慧座舱建设、发展及应用。