基于毫米波雷达和机器视觉融合的全息路口感知

摘 要:基于边缘计算设备MEC接入部署在路口的毫米波雷达和摄像头,通过机器视觉深度学习技术和多传感器目标融合技术,实现对路口本地的车辆、行人、路况的精细化、实时性感知,构建路口的泛感知体系,从而实现道路交通多维度、多来源、全要素的全息感知。通过利用这些全息感知数据可以有效提升路口、区域整体通行能力,提高车辆平均速度,带来城市交通管理成效的显著提升。

关键词:边缘计算;机器视觉;深度学习;目标融合;全息感知

中图分类号:TP393 文献标识码:A文章编号:2096-4706(2022)05-0098-03

Holographic Perception at Intersections Based on Fusion of Millimeter-Wave Radar and Machine Vision

CHEN Xinyun

(Zhejiang Hikalllink Technology Co., Ltd., Hangzhou 311100, China)

Abstract: Based on the edge calculation device MEC with millimeter wave radar and camera device deployed on road intersections, this paper realizes the refined and real-time perception on intersection of local vehicles, pedestrians, road refinement through machine vision deep learning technology and multi-sensor target fusion technology, builds intersection general perception system, so as to realize the road traffic multi-dimensional, multi-source, total elements of holographic perception. By using these holographic perception data, it can effectively improve the overall traffic capacity of intersections and regions, improve the average speed of vehicles, and bring a significant improvement in the effectiveness of urban traffic management

Keywords: edge calculation; machine vision; deep learning; target fusion; holographic perception

0 引 言

近年来,国家智能汽车创新发展战略日趋清晰,为促进智能网联汽车和地理信息产业融合发展、抢占全球智能网联汽车发展先机,全国各个省市都力争通过智能交通基础设施建设和自动驾驶测试及应用示范区建设,构建国内自动驾驶和智慧出行的产业集聚区,建成全域城市级自动驾驶与智慧出行示范区。

自动驾驶目前有单车智能和车路协同两种技术路线。其中车路协同是国家统筹管控自动驾驶、提高智能交通管理、提升交通出行大数据分析的重要手段。在城市级智能网联示范区建设过程中,城市交叉口是一个重要的区域,是交通堵塞和事故的多发地,是车辆、行人交通汇集、转向和疏散的必经之处,其交通环境相对复杂。在自动驾驶车辆行驶过程中,在交叉口区域广泛存在因视野遮挡、车辆遮挡等原因造成的交通参与者感知不全等隐患。针对这一系列问题,引入基于毫米波雷达和机器视觉的全息路口融合感知系统、可对交叉口区域所有交通参与者目标类型、实时经纬度、航向角、速度等属性进行全面感知。

此次研究目标是具备实时接入四路视频和四路毫米波雷达数据,实现对毫米波雷达的感知信息进行两两对向融合、视频感知信息与毫米波雷达感知信息的对向融合。基于多传感融合的全息路口感知探索采用毫米波雷达与视频融合,借助毫米波雷达输出的目标结构化数据与视频流数据的深度融合,实现路口目标的厘米级感知精度。运用时空同步技术,再运用深度学习算法,进行交通参与者识别,输出交通参与者速度、方向、航向角、属性等相关数据。

1 基于机器视觉的深度学习

基于机器视觉的深度学习技术主要是实现对视频流中的行人、车辆与骑行目标的检测与跟踪。关键技术实现包含以下两点:(1)采用深度学习目标检测算法,检测场景中存在的目标;(2)采用SORT跟踪算法,对前后两帧的同一检测目标进行关联。

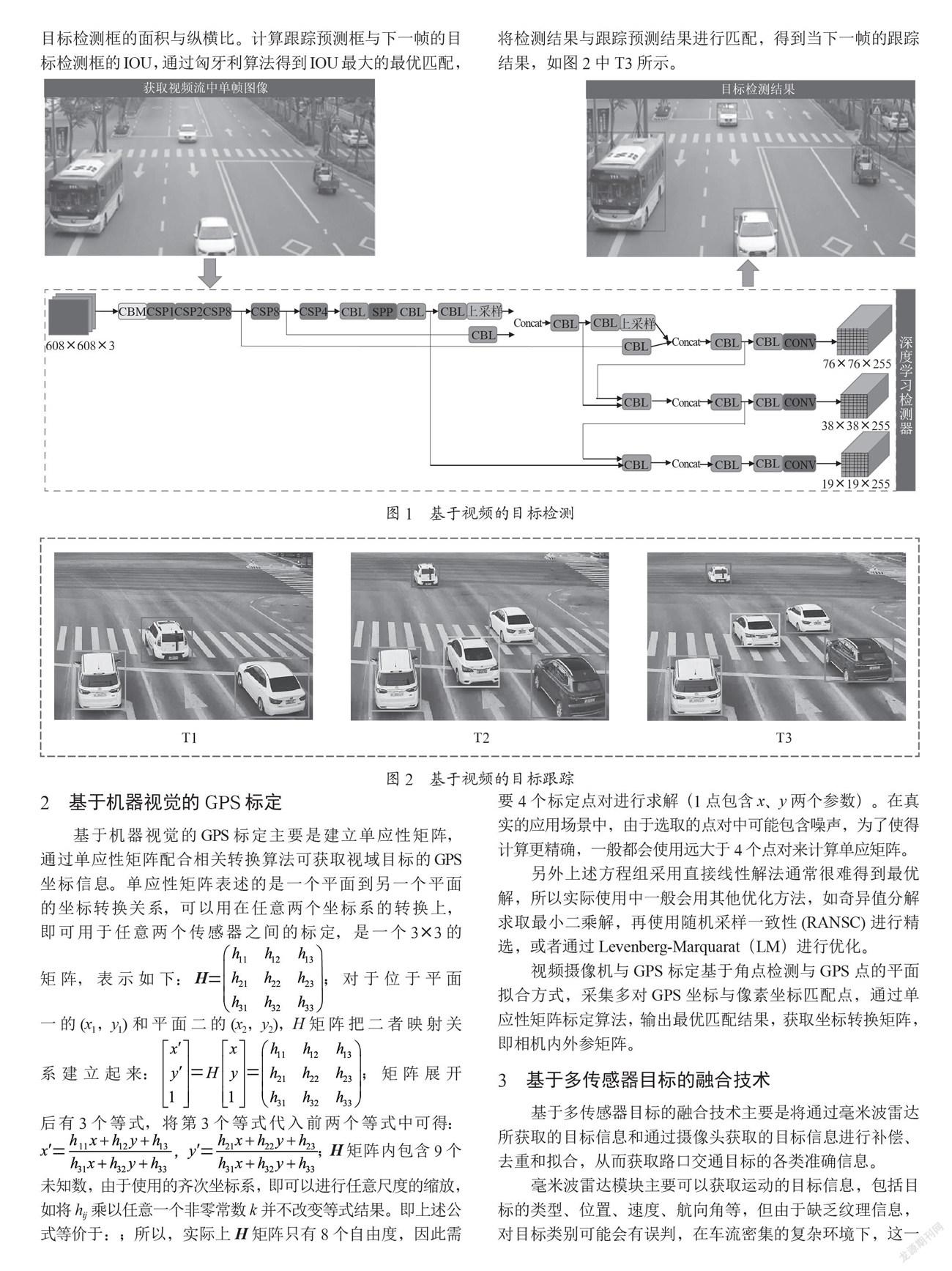

如图1所示,从实时视频流中获取单帧图像,将图像送入到深度学习检测器,检测器通过深度卷积神经网络提取目标特征,并对得到的特征进行分类与边框回归。检测器最终输出图像中存在的目标类别与位置信息。

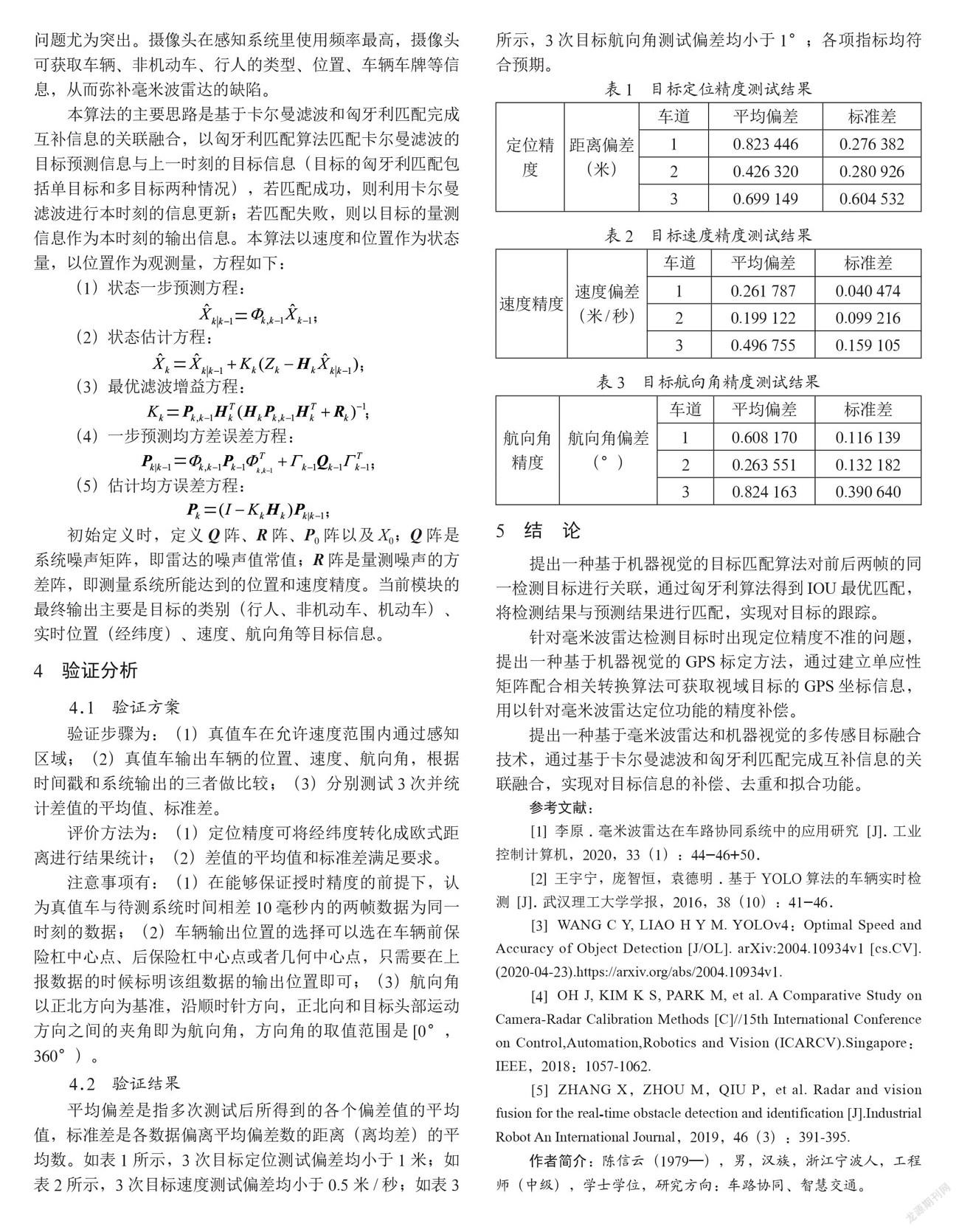

得到目标检测结果后,再通过目标跟踪算法将前后两帧的同一目标进行关联。T1代表某一时刻的目标跟踪结果。通过卡尔曼滤波算法来预测下一帧目标的位置,得到跟踪预测结果,如T2所示。卡尔曼滤波采用线性等速模型,来近似每个目标的帧间位移。每个目标状态建模为:x=[u,v,s,r,u,v,s]′;其中u,v为目标的中心位置坐标,s,r为目标检测框的面积与纵横比。计算跟踪预测框与下一帧的目标检测框的IOU,通过匈牙利算法得到IOU最大的最優匹配,将检测结果与跟踪预测结果进行匹配,得到当下一帧的跟踪结果,如图2中T3所示。

2 基于机器视觉的GPS标定

基于机器视觉的GPS标定主要是建立单应性矩阵,通过单应性矩阵配合相关转换算法可获取视域目标的GPS坐标信息。单应性矩阵表述的是一个平面到另一个平面的坐标转换关系,可以用在任意两个坐标系的转换上,即可用于任意两个传感器之间的标定,是一个3×3的矩阵,表示如下:;对于位于平面一的(x1,y1)和平面二的(x2,y2),H矩阵把二者映射关系建立起来:;矩阵展开后有3个等式,将第3个等式代入前两个等式中可得:;H矩阵内包含9个未知数,由于使用的齐次坐标系,即可以进行任意尺度的缩放,如将hij乘以任意一个非零常数k并不改变等式结果。即上述公式等价于:;所以,实际上H矩阵只有8个自由度,因此需要4个标定点对进行求解(1点包含x、y两个参数)。在真实的应用场景中,由于选取的点对中可能包含噪声,为了使得计算更精确,一般都会使用远大于4个点对来计算单应矩阵。

另外上述方程组采用直接线性解法通常很難得到最优解,所以实际使用中一般会用其他优化方法,如奇异值分解求取最小二乘解,再使用随机采样一致性(RANSC)进行精选,或者通过Levenberg-Marquarat(LM)进行优化。

视频摄像机与GPS标定基于角点检测与GPS点的平面拟合方式,采集多对GPS坐标与像素坐标匹配点,通过单应性矩阵标定算法,输出最优匹配结果,获取坐标转换矩阵,即相机内外参矩阵。

3 基于多传感器目标的融合技术

基于多传感器目标的融合技术主要是将通过毫米波雷达所获取的目标信息和通过摄像头获取的目标信息进行补偿、去重和拟合,从而获取路口交通目标的各类准确信息。

毫米波雷达模块主要可以获取运动的目标信息,包括目标的类型、位置、速度、航向角等,但由于缺乏纹理信息,对目标类别可能会有误判,在车流密集的复杂环境下,这一问题尤为突出。摄像头在感知系统里使用频率最高,摄像头可获取车辆、非机动车、行人的类型、位置、车辆车牌等信息,从而弥补毫米波雷达的缺陷。

本算法的主要思路是基于卡尔曼滤波和匈牙利匹配完成互补信息的关联融合,以匈牙利匹配算法匹配卡尔曼滤波的目标预测信息与上一时刻的目标信息(目标的匈牙利匹配包括单目标和多目标两种情况),若匹配成功,则利用卡尔曼滤波进行本时刻的信息更新;若匹配失败,则以目标的量测信息作为本时刻的输出信息。本算法以速度和位置作为状态量,以位置作为观测量,方程如下:

(1)状态一步预测方程:

;

(2)状态估计方程:

;

(3)最优滤波增益方程:

;

(4)一步预测均方差误差方程:

;

(5)估计均方误差方程:

;

初始定义时,定义Q阵、R阵、P0阵以及X0;Q阵是系统噪声矩阵,即雷达的噪声值常值;R阵是量测噪声的方差阵,即测量系统所能达到的位置和速度精度。当前模块的最终输出主要是目标的类别(行人、非机动车、机动车)、实时位置(经纬度)、速度、航向角等目标信息。

4 验证分析

4.1 验证方案

验证步骤为:(1)真值车在允许速度范围内通过感知区域;(2)真值车输出车辆的位置、速度、航向角,根据时间戳和系统输出的三者做比较;(3)分别测试3次并统计差值的平均值、标准差。

评价方法为:(1)定位精度可将经纬度转化成欧式距离进行结果统计;(2)差值的平均值和标准差满足要求。

注意事项有:(1)在能够保证授时精度的前提下,认为真值车与待测系统时间相差10毫秒内的两帧数据为同一时刻的数据;(2)车辆输出位置的选择可以选在车辆前保险杠中心点、后保险杠中心点或者几何中心点,只需要在上报数据的时候标明该组数据的输出位置即可;(3)航向角以正北方向为基准,沿顺时针方向,正北向和目标头部运动方向之间的夹角即为航向角,方向角的取值范围是[0°,360°)。

4.2 验证结果

平均偏差是指多次测试后所得到的各个偏差值的平均值,标准差是各数据偏离平均偏差数的距离(离均差)的平均数。如表1所示,3次目标定位测试偏差均小于1米;如表2所示,3次目标速度测试偏差均小于0.5米/秒;如表3所示,3次目标航向角测试偏差均小于1°;各项指标均符合预期。

5 结 论

提出一种基于机器视觉的目标匹配算法对前后两帧的同一检测目标进行关联,通过匈牙利算法得到IOU最优匹配,将检测结果与预测结果进行匹配,实现对目标的跟踪。

针对毫米波雷达检测目标时出现定位精度不准的问题,提出一种基于机器视觉的GPS标定方法,通过建立单应性矩阵配合相关转换算法可获取视域目标的GPS坐标信息,用以针对毫米波雷达定位功能的精度补偿。

提出一种基于毫米波雷达和机器视觉的多传感目标融合技术,通过基于卡尔曼滤波和匈牙利匹配完成互补信息的关联融合,实现对目标信息的补偿、去重和拟合功能。

参考文献:

[1] 李原.毫米波雷达在车路协同系统中的应用研究 [J].工业控制计算机,2020,33(1):44-46+50.

[2] 王宇宁,庞智恒,袁德明.基于YOLO算法的车辆实时检测 [J].武汉理工大学学报,2016,38(10):41-46.

[3] WANG C Y, LIAO H Y M. YOLOv4:Optimal Speed and Accuracy of Object Detection [J/OL]. arXiv:2004.10934v1 [cs.CV].(2020-04-23).https://arxiv.org/abs/2004.10934v1.

[4] OH J, KIM K S, PARK M, et al. A Comparative Study on Camera-Radar Calibration Methods [C]//15th International Conference on Control,Automation,Robotics and Vision (ICARCV).Singapore:IEEE,2018:1057-1062.

[5] ZHANG X,ZHOU M,QIU P,et al. Radar and vision fusion for the real⁃time obstacle detection and identification [J].Industrial Robot An International Journal,2019,46(3):391-395.

作者简介:陈信云(1979—),男,汉族,浙江宁波人,工程师(中级),学士学位,研究方向:车路协同、智慧交通。