基于深度学习的频分复用大规模多输入多输出下行信道状态信息获取技术

桂 冠,王 洁,杨 洁,刘 淼,孙金龙

(南京邮电大学通信与信息工程学院,南京 210003)

引 言

大规模多输入多输出(Multiple input multiple output,MIMO)技术在2010 年由Marzetta 教授提出[1],其能够显著提高无线通信系统的频谱效率和系统容量。经过10 余年的研究,大规模MIMO 技术已成功应用在第5 代(The fifth generation,5G)移动通信系统中。通过持续增大天线阵列规模,超大规模MIMO 技术将是未来第6 代(The sixth generation,6G)移动通信系统进一步提升网络性能的关键技术之一[2⁃3]。但是,基站能够获取精确的下行信道状态信息(Channel state information,CSI)是大规模MIMO 技术实现系统增益的前提[4]。目前,大规模MIMO 系统通常工作在时分双工(Time di⁃vision duplexing,TDD)通信模式下,通过利用上下行信道的互易性,可以由上行链路的CSI 估计直接获取下行链路CSI,避免了巨大的下行CSI 获取开销。与TDD 通信模式相比,频分双工(Frequency division duplexing,FDD)通信模式具有传输速率高、可连续通信以及适用于高速移动场景等优势。同时,现有大量通信系统仍采用FDD 通信模式。为利用FDD 通信模式的先天优势并减少更换通信模式所带来的资源浪费和性能损耗,FDD 大规模MIMO 系统近期得到了广泛关注和研究。在FDD模式下,上下行信道不具有严格的互易性,基站获取下行CSI 需要用户进行下行CSI 估计和反馈[5]。由于下行CSI 估计的导频开销和反馈的链路开销与基站端天线数成正比,使FDD 大规模MIMO 系统面临的巨大挑战之一是下行CSI 获取的巨大导频和反馈开销。目前,FDD 系统通常使用基于码本和基于压缩感知的CSI 反馈技术。但随着基站端天线阵列规模不断扩大,码本的设计非常困难,使基于码本的CSI 反馈技术不再适用于FDD 大规模MIMO 系统。高维度CSI 矩阵也使基于压缩感知的CSI反馈技术具有较高的计算复杂度和较低的反馈精度。近年来,深度学习(Deep learning,DL)被应用于各个领域,并表现出了卓越的性能,如零部件缺陷检测[6]、推荐系统[7]等。已有大量工作有效使用DL 解决无线通信问题,包括波束赋形[8]、信道估计[9]等。由此可见,DL 具有学习、处理高维数据的强大能力,能够为解决FDD 大规模MIMO 系统获取高维下行CSI 问题提供了潜在解决方案。

基于DL 的FDD 大规模MIMO 下行CSI 获取技术主要分为两类,分别是基于DL 的下行CSI 反馈技术和基于DL 的下行CSI 预测技术。基于DL 的下行CSI 反馈技术利用神经网络充分学习CSI 矩阵的内在特征,实现对CSI 矩阵的自动压缩与重建,在降低CSI 反馈开销的同时提高CSI 反馈精度。然而,基于DL 的下行CSI 反馈技术无法避免FDD 大规模MIMO 系统中下行CSI 估计开销。针对这一问题,基于DL 的下行CSI 预测技术能够利用DL 强大的学习能力和FDD 系统中上下行链路之间的部分互易性,由上行CSI 直接映射出下行CSI。为促进FDD 大规模MIMO 系统的实际部署及面向6G 的技术演进,本文首先给出了两种基于DL 的FDD 大规模MIMO 下行CSI 获取技术的原理框架,然后对国内外相关研究进展进行了分析比较,最后对基于DL 的FDD 大规模MIMO 下行CSI 获取技术的未来发展做出进一步展望。

1 基于DL 的FDD 大规模MIMO 下行CSI 反馈技术

1.1 基于DL 的CSI 反馈技术框架

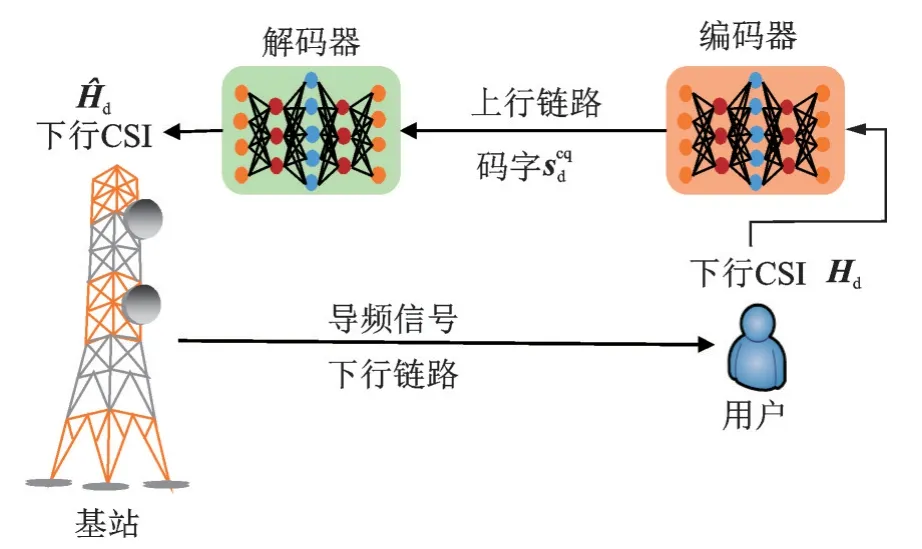

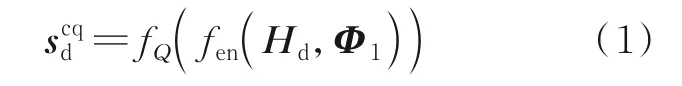

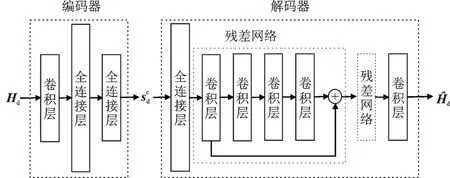

假设用户通过信道估计算法从基站发送的导频信号中已经估计出了下行CSI 矩阵Hd,只关注下行CSI 的反馈过程。如图1 所示,在基于DL 的CSI 反馈技术中,用户和基站分别配备基于神经网络的编码器和解码器。首先,部署在用户端的编码器会实现对CSI 矩阵Hd的压缩,压缩得到的向量将由均匀或非均匀量化器进行量化,得到最终需要反馈的码字。令fen(·)和fQ(·)分别代表压缩函数和量化函数,则经过零误差反馈,基站端接收到的用户反馈的下行CSI 可以表达为

图1 基于DL 的CSI 反馈技术框架Fig.1 Theoretical framework of CSI feedback based on DL

式中Φ1表示编码器中神经网络的权重参数。

当基站接收到后,部署在基站的解码器会对其进行量化译码及重建以恢复出原始的下行CSI。令fde(·)和分别代表重建函数和量化译码函数,则基站端恢复出的下行CSI 可以表示为

式中Φ2表示解码器中神经网络的权重参数。整个基于DL 的CSI 反馈过程可以表示为

编码器和解码器一起进行端到端训练,根据代价函数和梯度下降法训练得到权重参数Φ1和Φ2。

1.2 相关研究进展

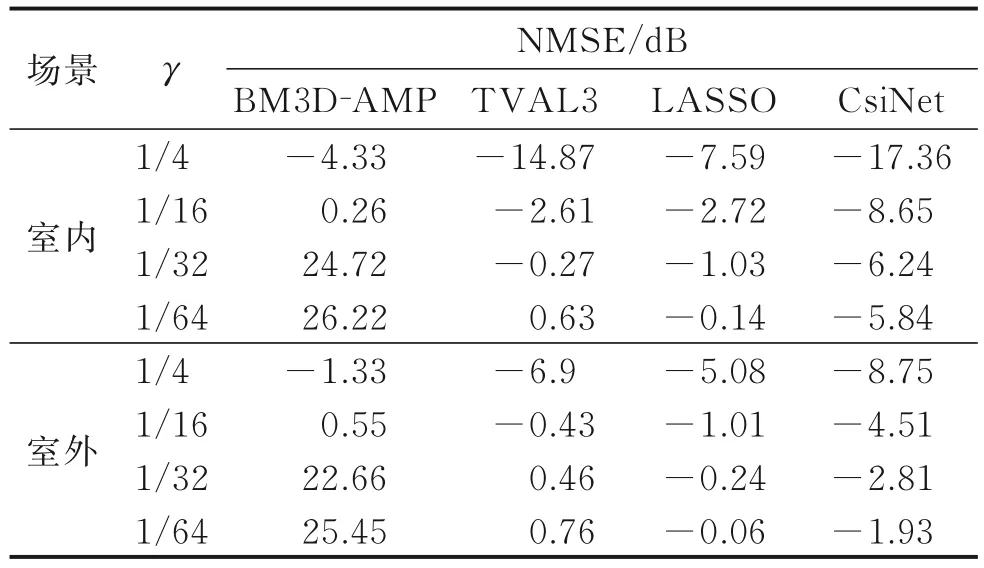

Wen 等[10]首次提出了一种基于DL 的下行CSI 反馈技术(称为CsiNet),其网络结构如图2 所示。在用户端,CsiNet 使用1 个卷积层和2 个全连接层构成编码器,实现对下行CSI 的压缩,输出压缩后未量化的浮点型码字。在基站端,CsiNet 首先利用1 个全连接层恢复出下行CSI 的原始维度,然后利用2个残差网络对初始恢复的下行CSI 进行更精确的恢复,最后再经过1 个卷积层输出下行CSI 的估计。压缩后向量的元素个数与原始CSI 矩阵中元素个数的比值称为压缩率γ。

图2 CsiNet 的网络结构Fig.2 Network structure of CsiNet

CsiNet 在COST 2100 信道模型上进行性能验证,包括频率为5.3 GHz 的室内微蜂窝场景和频率为300 MHz 的乡村户外场景。以归一化均方误差(Normalized mean square error,NMSE)作为衡量下行CSI 反馈精度的性能指标,并与3 个基于压缩感知的CSI 反馈方案(BM3D⁃AMP[11]、TVAL3[12]以及LASSO[13])进行性能比较,各方案的下行CSI 反馈性能如表1 所示。从表1 中可以看出,基于CsiNet 的下行CSI 反馈精度在2 个场景中的所有压缩率下都高于3 个基于压缩感知的CSI 反馈技术。同时,CsiNet 的计算时间远小于上述3 个压缩感知算法的计算时间。上述实验结果证明了基于DL 的CSI 反馈技术的有效性。

表1 CsiNet 与压缩感知算法的NMSE 性能对比Table 1 NMSE performance comparison between Csi‑Net and compressed sensing algorithms

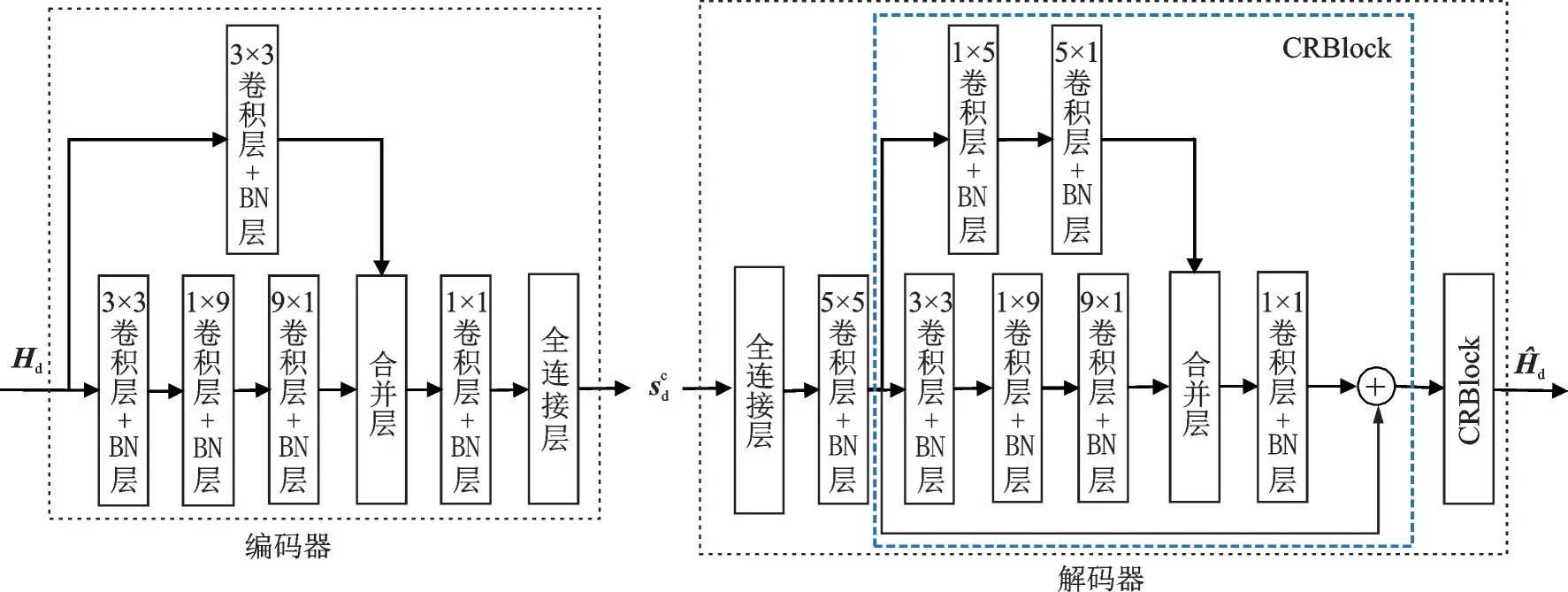

CsiNet 的网络结构相对比较简单,通过设计更复杂、更合理的神经网络结构可以更加充分提取CSI 数据内部特征,进一步提高CSI 反馈精度。Lu 等[14]将多分辨率网络引入到CSI反馈技术中,提出了信道重建网络(Channel reconstruction network,CRNet),取得了比CsiNet 更高的CSI 反馈精度,其网络结构如图3 所示。其中a×b表示卷积层的卷积核大小,每个卷积层后面都连接了1 个批归一化(Batch normaliza⁃tion,BN)层。在用户端,CRNet 用多个具有不同卷积核大小的卷积层学习CSI 数据的内部特征,然后用全连接层将学习到的特征压缩为未量化的浮点型码字。在基站端,CRNet 首先通过1 个全连接层恢复出下行CSI 的原始维度,然后送入1 个卷积层,最后通过2 个信道重建模块(Channel reconstruction block,CRBlock)对下行CSI 进行精确恢复,并输出下行CSI 的估计结果。

图3 CRNet 的网络结构Fig.3 Network structure of CRNET

CRNet 的核心设计是采用了2 个CRBlock,每个CRBlock 各由两路具有不同卷积核大小的卷积层并行组成,然后用1 个卷积核大小为1×1 的卷积层合并两路输出特征。通过给神经网络添加并行的、具有不同卷积核大小的卷积层,可以让神经网络自己学习到合适的不同卷积核大小的组合,提高了神经网络提取数据特征的能力。同时,当CRNet 以动态的学习速率训练神经网络时,它与CsiNet 在COST 2100 信道模型上的NMSE 性能对比如表2所示。从表2 中可以看出,CRNet 在室内、室外两个场景下的所有压缩率上的性能都优于CsiNet,这说明通过设计更复杂、更合理的神经网络结构可以进一步提高基于DL 的CSI反馈精度。

表2 CRNet 与CsiNet 的NMSE 性能对比Table 2 NMSE performance comparison between CRNet and CsiNet dB

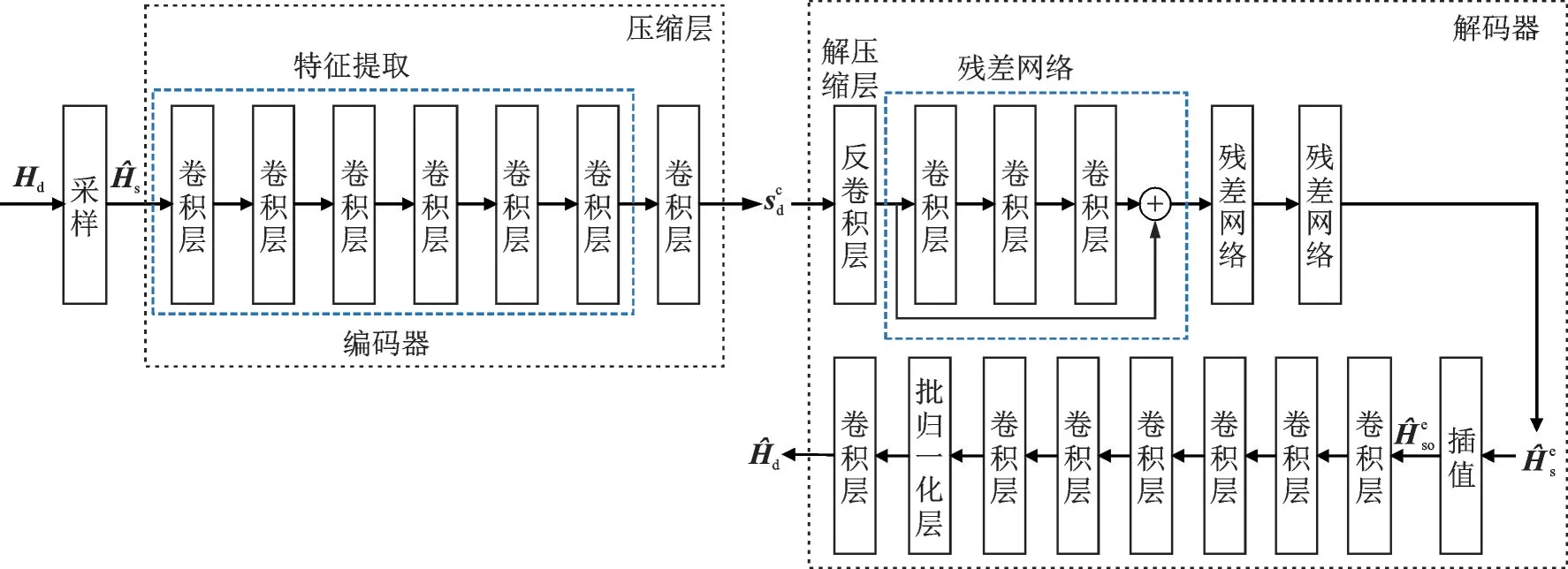

不同于上述基于数据驱动的方案,通过引入其他特定的网络结构,另一类基于DL 的高精度CSI 反馈技术被提出[15⁃17],即将CSI 数据的先验知识引入到基于DL 的CSI 反馈中,通过知识和数据双驱动的神经网络及深度学习实现更高的CSI 反馈精度。基于此,Wang 等[18]提出了基于采样与DL 的CSI 反馈技术(称为SampleDL),通过采样将信道在时间、频率两个维度上具有相关性这一先验知识引入深度学习,在降低神经网络计算复杂度的同时提高了CSI 反馈精度。基于SampleDL 的整个CSI 反馈流程如图4 所示。在用户端,SampleDL 技术首先对下行CSI 的Hd进行采样,得到采样后的CSI 数据,然后将送入编码器中进行特征提取,并用卷积层实现对的压缩,输出压缩后的码字。在SampleDL方案中,CSI 矩阵的总压缩率RT定义为采样压缩率Rs与空间压缩率Rc的乘积,其中Rs为中元素个数与Hd中元素个数的比值,Rc为中元素个数与中元素个数的比值。在基站端,SampleDL 技术首先用一个反卷积层将压缩码字恢复到与一样的维度;然后用3 个残差网络对其精确恢复,并输出对的恢复值,再对进行插值操作,使其恢复到与原始CSIHd一样的维度,记为;最后通过7个卷积层对进行精确恢复,并输出下行CSI 的最终估计值。

图4 SampleDL 技术中整个CSI 反馈流程Fig.4 Entire CSI feedback process in sampleDL

SampleDL 技术在符合3GPP TR 38.901 标准的nrCDLChannel 信道模型[19]上进行性能评估,并与CRNet 的性能进行比较。SampleDL 技术和CRNet 中的卷积层均采用三维卷积层,且均通过卷积层实现对CSI 的压缩与重建,对压缩层和重建层设置不同的卷积步长可实现不同的压缩率。通过结合采样和DL,基于SampleDL 的CSI 反馈技术在提高CSI 反馈精度的同时具有更低的计算复杂度。表3给出了SampleDL 和CRNet 中神经网络的总浮点运算数(Floating point operations,FLOPs)。从表3中可以看出,SampleDL 的FLOPs数比CRNet 的FLOPs数少了6.203 722 6×109次,这将降低整个CSI 反馈过程的计算复杂度与开销。SampleDL 技术具有较低时间复杂度的原理在于,编码器的输入和3个残差网络的输入及输出是采样后的CSI 矩阵,大大减小了编码器和残差网络中各网络层的数据张量维度。文献[18]采用NMSE 作为衡量CSI 反馈精度的评价指标,并对下行CSI 反馈过程中引入量化后的性能进行验证和分析。

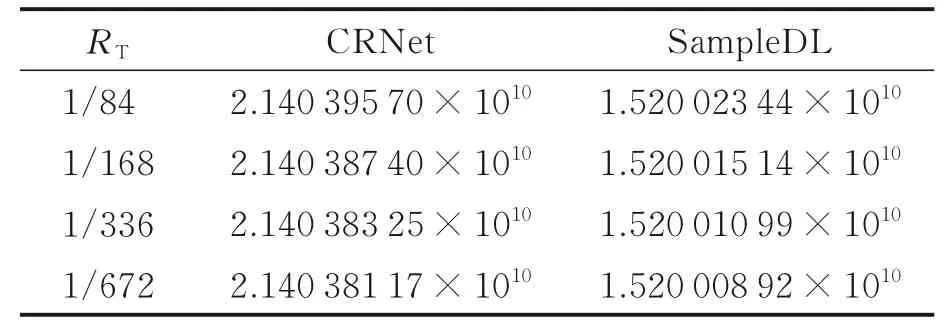

表3 SampleDL 与CRNet 的FLOPs 比 较Table 3 Comparison of FLOPs between SampleDL and CRNet

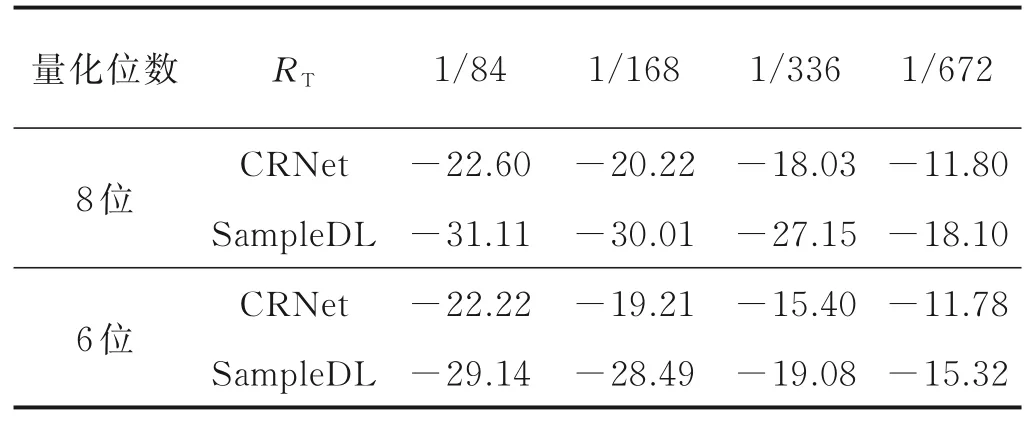

通过采用均匀量化技术,表4 给出了在量化位数为8位和6位时,SampleDL 和CRNet 在不同压缩率下的NMSE 性能对比。从表4中可以得到,SampleDL 的NMSE 性能在不同的量化位数和不同的压缩率下都优于CRNet。SampleDL 的性能增益来自两个方面:一方面是当使用相同结构的神经网络对数据进行相同操作时,小维度数据能够取得比大维度数据更好的性能;另一方面是在时间和频率维度上的采样和插值过程向神经网络引入了信道在时间和频率上具有相关性的先验知识,使得SampleDL 技术在CSI 恢复精度上高于仅仅使用三维卷积层学习CSI 内在结构的性能。

表4 SampleDL 与CRNet 的NMSE 性能比较Table 4 NMSE performance comparison between Sam‑pleDL and CRNet dB

随着研究的深入,在未来实际部署中存在的量化问题、多压缩率问题、安全性问题以及网络轻量化问题也已经开始被提出和研究[20⁃22]。Guo 等[20]首次在基于DL 的端到端CSI 反馈框架中引入量化操作,并提出了2 个在单次训练下可实现多压缩率的编码器框架(SM⁃CsiNet+和PM⁃CsiNet+)。与通过训练不同的编码器实现不同的压缩率相比,SM⁃CsiNet+和PM⁃CsiNet+分别使用户端的参数数量减少了38.0%和46.7%。量化和多压缩率的引入使基于DL 的CSI 反馈技术向实际部署又迈进了一步。通过引入自注意力机制和密集连接,Song 等[21]提出了一种新的多压缩率网络结构,实现了比SM⁃CsiNet+更高反馈精度。Fan 等[22]使用卷积层实现CSI 的压缩与解压缩,在提高CSI 反馈精度的同时大幅度降低了神经网络的训练参数和计算复杂度。针对相对固定的通信场景,Guo 等[23]提出了以用户为中心进行在线学习的端到端CSI 反馈框架,讨论了3 种在线学习方法,仿真结果表明该框架能够在低训练开销下提高特定场景下的CSI 反馈精度。

上述基于DL 的CSI 反馈技术证明了用DL 降低下行CSI 反馈开销、提高反馈精度的有效性。相关研究针对DL 在实际部署中所面临的问题和特定通信场景下CSI 反馈精度提升问题提出了研究方案和性能验证,为FDD 大规模MIMO 系统获取下行CSI 提供了潜在解决方案。

2 基于DL 的FDD 大规模MIMO 下行CSI 预测技术

2.1 基于DL 的CSI 预测技术框架

在基于DL 的下行CSI 预测技术中,通常将CSI 矩阵作为图像数据进行处理。图像数据是具有1 个或多个通道的二维实数矩阵。上行CSI 和下行CSI 均是1 个复数矩阵,其数据形式与图像数据非常相似,可以将复数CSI 矩阵考虑为1 个具有两通道的实数值矩阵,复数矩阵的实部作为第1 通道,复数矩阵的虚部作为第2 通道。如图5 所示,在基于DL 的CSI 预测技术中,将上行CSI 数据作为神经网络的输入,下行CSI 数据作为神经网络的输出,通过学习上下行链路之间的信道相关性,由上行CSI 直接预测出下行CSI 的Hd。用Φpre表示神经网络的权重参数,fpre(·)表示神经网络的拟合函数,则基于DL 的下行CSI 预测过程可以表示为

图5 基于DL 的CSI 预测技术框架Fig.5 Theoretical framework of CSI prediction based on DL

2.2 相关研究进展

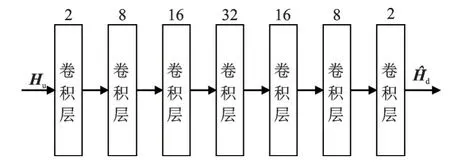

Safari 等[24]首次提出用深度神经网络从上行CSI 直接预测下行CSI 的思想,并提出了基于卷积神经网络(Convolutional neural network,CNN)的下行CSI 预测技术,该技术用7 个卷积层实现了由上行CSI 的Hu预测下行CSI 的,如图6所示,其中每1 层上的数字为该层的卷积核个数。仿真结果证明了该方案的有效性,为未来FDD 大规模MI⁃MO 系统获取下行CSI 提供了可参考的低开销方案。

图6 基于CNN 的下行CSI 预测技术Fig.6 Downlink CSI prediction technology based on CNN

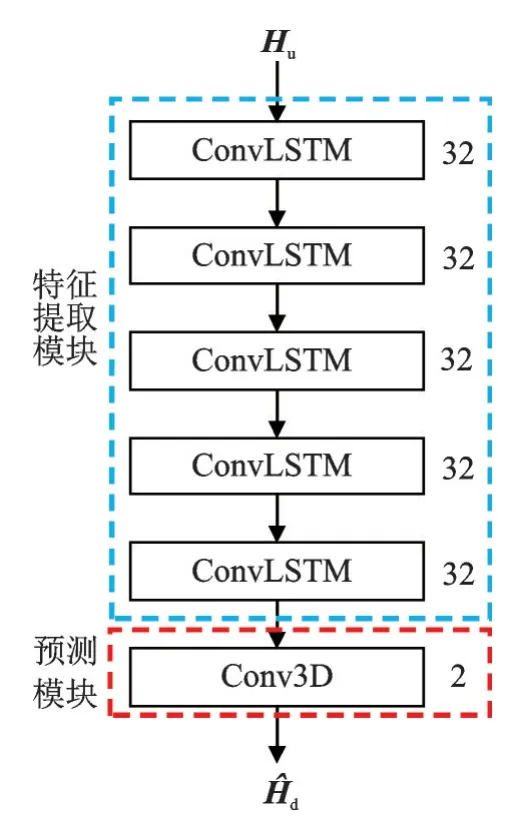

为充分学习上下行CSI 之间在时隙、频率和空间3 个维度上的相关性,提高下行CSI 预测精度,Wang 等[25]将由上行CSI 预测下行CSI建模为一个时空图像预测问题,并用卷积长短期记忆网络(Convolu⁃tional long short term memory network,ConvLSTM⁃Net)解决该 问题。ConvLSTM⁃Net 由5 个卷积长短期记忆(ConvLSTM)层和1个3维卷积层(Conv3D)构成,如图7 所示。其中,每一层旁边的数字为该层的卷积核个数,每一个ConvLSTM 层都使用“tanh”作为激活函数,且都串联一个批归一化层,最后一个Conv3D 层使用线性激活函数。

图7 基于ConvLSTM-Net 的下行CSI 预测技术Fig.7 Downlink CSI prediction technology based on Conv⁃LSTM-Net

基于ConvLSTM⁃Net 的下行CSI 预测技术在扩展车辆(Extended vehicular A,EVA)信道模型上进行性能验证,探索了在频域信道数据和时域信道数据上的性能差异,并与基于CNN 的下行CSI 预测技术进行对比,在不同数据以及不同卷积核大小下NMSE 性能对比如表5 所示。通过表5 可以看出,CNN 在信道的频域数据上具有更好的预测性能,而ConvLSTM⁃Net 在信道的时域数据上具有更好的预测性能,但不同域、不同神经网络以及CSI 预测性能之间的关系仍需要进一步探索和研究。此外,在不同的域和不同的卷积核大小下,ConvLSTM⁃Net 都具有比CNN 更高的预测精度,这是因为ConvLSTM 层将长短期记忆单元中输入与状态之间的全连接操作、状态之间转换的全连接操作全都替换为了卷积操作,使ConvLSTM⁃Net同时具有很强的学习数据空间特征和时间相关性的能力[26]。但是,ConvLSTM⁃Net 具有比CNN 更高的计算复杂度,因此在工程应用中还需要进一步对预测精度和神经网络的计算复杂度进行权衡。

表5 ConvLSTM‑Net 与CNN 在不同域信道数据以及不同卷积核大小下的NMSE 性能对比Table 5 NMSE performance comparison of ConvL‑STM‑Net and CNN under different domain channel data and different convolution ker‑nel sizes

上述两种基于DL 的CSI 预测技术的性能证明了使用DL 直接预测下行CSI 的可行性。针对CSI 矩阵的复数结构,Yang 等[27]和Zhang 等[28]提出基于复数神经网络的下行CSI 预测技术。仿真实验结果表明,复数神经网络在预测精度方面优于实数神经网络,但也具有比实数神经网络更高的计算复杂度。随着研究的深入,针对实际部署中会遇到的神经网络泛化问题,基于迁移学习[29]和联邦学习[30]的下行CSI 技术也开始被研究。针对特定环境下训练的神经网络很难直接应用于新环境下用户的问题,Yang 等[29]提出了基于深度迁移学习的CSI 预测技术,其提出了元学习算法,实验结果表明该算法可在少量标签数据下使网络适应新环境,验证了迁移思想的有效性。针对微基站训练数据少、集中式训练传输开销大问题,Hou 等[30]提出了基于联邦学习的下行CSI 预测框架,并设计了一种新的模型聚合算法,该算法通过考虑局部模型权值和局部梯度对全局模型进行两次更新。实验结果表明,文献[30]提出的联邦学习框架及模型聚合算法能够在大幅度降低传输开销的同时取得接近集中式训练的性能。

此外,针对如何进一步提升下行CSI 预测精度问题,Yang 等[9]引入深度多模态学习技术,提出了多源感知数据辅助的下行CSI 预测技术,并讨论验证了不同模态组合和特征融合方法的性能。实验结果表明,通过融合过去时刻的下行CSI 数据、用户位置数据以及上行CSI 数据,多源感知数据辅助的下行CSI 预测技术能够获得比已有技术更好的CSI 预测精度。在应用场景方面,Yang 等[31]针对混合预编码场景中射频链数目远小于发射天线数目的问题,探索了用部分上行CSI 预测整个下行CSI 的性能,并结合概率抽样理论,提出了对天线选择和下行CSI 预测进行联合优化的端到端训练策略。实验结果表明,基于DL 的下行CSI 预测技术可以在混合预编码场景下取得可观的下行CSI 预测精度。

3 结束语

上述基于DL 的下行CSI 反馈技术能够在较低压缩率下保持较高的CSI 反馈精度,有效降低了CSI反馈开销。而基于DL 的下行CSI 预测技术能够在彻底消除下行CSI 估计和反馈开销的情况下获得可观的下行CSI 预测精度。上述两种方案将在不同场景下为未来FDD 大规模MIMO 系统的部署提供技术支撑,但目前相关研究仍处于初期探索阶段,还面临着许多问题和挑战,需要更深入的研究。

(1)面向特定场景和新技术的深度学习方案设计。一方面,挖掘特定通信场景下的特征,设计个性化深度学习方案将是进一步提升CSI 获取精度、加快部署进程的方向之一。例如,Guo 等[23]针对室内通信环境的稳定性,提出了以用户为中心的在线学习CSI 反馈框架。另一方面,探索新技术应用下的可行性深度学习方案将是基于DL 的下行CSI 获取技术应用于未来通信系统的演进方向之一,比如分布式大规模MIMO、全息MIMO 等。

(2)面向CSI 的原生神经网络设计。目前已有的基于DL 的下行CSI 获取技术均采用通用神经网络,基于数据对神经网络进行训练,这将使该技术在未来应用时面临很多问题,包括大量有效数据集的获取问题、神经网络计算复杂度与性能的平衡问题、不同通信场景下神经网络的再训练与再部署开销问题等。即使文献[18]通过引入信道数据的先验知识,在降低神经网络的复杂度的同时提高CSI 反馈精度,但仍没有克服通用神经网络本身的缺点。轻量化网络、迁移学习以及联邦学习的研究是解决神经网络计算复杂度、泛化性的方案之一,但基于信道固有特性,提出适用于CSI 获取的原生网络是解决上述问题的根本,需要进一步探索和研究。

(3)用于训练的真实化场景分析。目前基于DL 的下行CSI 获取技术的性能验证大部分基于仿真信道数据,且没有考虑量化误差、反馈误差以及信道估计误差等真实场景,无法保证该技术在实际应用场景的适用性和可靠性。因此,需要基于真实场景数据和原型系统对基于DL 的下行CSI 获取技术做进一步的探索和研究。

针对FDD 大规模MIMO 系统面临的下行CSI 获取挑战,本文探讨了基于深度学习的下行CSI 获取技术,具体包括基于深度学习的下行CSI 反馈技术和基于深度学习的下行CSI 预测技术。首先给出了两种基于深度学习的CSI 获取技术的原理,其次分析了相关研究成果,最后对其未来发展做出了展望。通过上述总结分析可以得出,基于深度学习的FDD 大规模MIMO 下行CSI 获取技术有望成为促进FDD 大规模MIMO 系统商业部署及面向6G 演进的强有力支撑,但尚处于初期探索阶段,面临着许多亟待解决的问题,包括原生网络的探索与研究、真实场景下的性能验证等。