遥感图像时空融合综述

杨广奇,刘 慧,钟锡武,陈 龙,钱育蓉

1.新疆维吾尔自治区信号检测与处理重点实验室,乌鲁木齐 830046 2.新疆大学 软件学院,乌鲁木齐 830000 3.新疆大学 信息工程学院,乌鲁木齐 830000 4.新疆大学 软件工程重点实验室,乌鲁木齐 830000

随着计算机的发展,遥感技术取得了很大进步,遥感领域进入了一个更大范围、更高精度、更深层次的阶段[1]。时间密集的高空间分辨率遥感图像在资源调查[2-3]、森林监测[4]、生态系统动态监测[5]、实时灾害[6]等动态监测和变化检测的应用方面都有重要作用。然而,由于技术和预算的限制,目前的遥感卫星还存在着“时空矛盾”的问题[7],即单个卫星传感器不能同时获取高空间、高时间分辨率兼并的遥感图像数据[8]。

一个经济有效的解决方案是时空特征融合方法,该方法的核心思想是将来自多个卫星传感器的不同类型的遥感图像融合在一起,获得具有高空间分辨率和高时间分辨率的遥感图像[9]。例如,高空间分辨率陆地卫星(Landsat)系列传感器获得的遥感卫星图像空间分辨率约为30 m,并且可以用于森林监测、精准农业、生态环境动态监测和土地覆盖分类等领域[10-12]。因为低空间分辨率的图像具有局限性,所以提取到地物的纹理等细节特征受阻。例如低空间分辨率传感器Aqua和Terra卫星上的中分辨率成像光谱仪(MODIS)能够获得高时间分辨率图像,重返周期为一天,但是空间分辨率较低,只有250~1 000 m[13]。时空融合的方法就是将这两种类型的图像融合,使得融合后的图像同时具有高时间分辨率和高空间分辨率,在满足地物快速变化的同时,保留地物细节等特征。

1 相关工作

本文总结了五类时空特征融合方法:基于分解的方法、基于权值函数的方法、基于贝叶斯的方法、基于学习的方法和混合的方法[14]。最先被提出的是基于分解的时空融合算法,例如多传感器多分辨率技术(multisensor multiresolution technique,MMT)[15]、LAC-GAC NDVI Integration[16]等。随后出现大量基于权重的时空融合方法,此类方法包含的模型数量最多,最为代表性的是时空自适应反射融合模型(spatial and temporal adaptive reflectance fusion,STARFM)[17],之后基于STARFM方法衍生出非常多的方法。基于贝叶斯的方法将时空融合视为最大后验概率问题,代表方法有贝叶斯最大熵(Bayesian maximum entropy,BME)[18]、Unified Fusion[19]等。随着机器学习算法的逐渐成熟,时空融合领域也不断涌现出基于学习的算法,如基于稀疏表示的时空反射融合模型(spatiotemporal reflectance fusion,SPSTFM)[20]、One-pair Learning Method[21]等。近年来,神经网络等深度学习模型由于其强大的自动特征表示学习能力,能够从原始数据中自动高效地学习空间邻近性和时间相关性,在各种机器学习任务中都取得了显著的结果[22]。为了结合各类方法,将各类方法最大的优势集中在一起,提出了混合方法,比如灵活时空数据融合(flexible spatiotemporal data fusion,FSDAF)[23]、时空反射分解模型(spatial and temporal reflectance unmixing model,STRUM)[24]等。

本文主要总结了现有的基于深度学习的遥感图像时空融合算法及其评估标准,分析各个模型的特点优势与存在的问题,并对未来的发展方向提出展望。本文的贡献可归纳如下:

(1)对遥感图像时空融合的算法进行分类总结分析。

(2)在AHB、DX、TJ数据集上进行传统和深度学习模型的实验分析。

(3)为后期遥感图像时空融合研究提供理论参考。

2 基于传统遥感图像时空融合

2.1 基于分解的时空融合模型

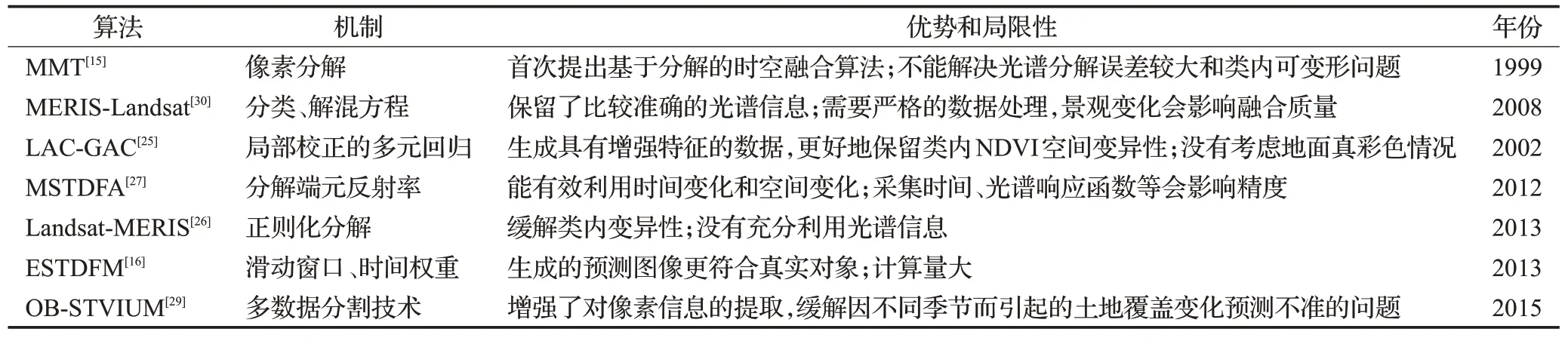

基于分解的方法采用线性光谱混合理论,通过分析粗像素的组成并对其进行分解来估计细像素的值。Zhukov等提出的MMT[15]是一种融合不同时间和不同空间分辨率卫星图像的基于分解的方法。该方法将分解过程中已有的所有信息融合在一起,采用以下四个步骤来预测精细分辨率图像:(1)对输入的高分辨率图像分类得到高分辨率分类图。(2)对低分辨率像素信号的类贡献进行定义。(3)对基于窗口的粗像素进行分解。(4)未混合(锐化)图像的重建。但是MMT仍不能很好地解决光谱分解误差较大和类内可变性问题。为了解决类内变异性问题,Maselli等[25]提出使用局部校正的多元回归模型,通过局部校正的统计量来处理类内NDVI的空间变异性。Landsat-MERIS[26]采用改进的正则化分解方法增加图像土地覆盖类别的光谱可变性。此外,改进的成本函数使处理结果更加稳健。Zhang等[16]在STDFM算法的基础上,引入基于补丁的分类方法和滑动窗口技术,充分考虑了空间异质性,使预测结果更加符合实际地物的变化。Wu等[27-28]通过在一个移动窗口中分解输入和预测日期的端元反射率来估计反射率变化,将估计的反射率变化添加到基础精细分辨率图像中得到预测,又通过自适应窗口大小选取的方法,更精确地分解像素。Lu等[29]采用多数据分割技术,确定最佳分割尺度以此改进像素信息的提取,减缓分解误差较大的问题。Zurita-Milla等[30]利用基于解混的数据融合技术,引入约束条件,成功保留了更多光谱信息。

基于分解的时空融合的这类模型起源最早,算法原理简单并且易于操作,但是由于粗图像分辨率过低而无法准确地分解每一种地物信息,在土地覆盖类型较多的混合区域无法分解出较好的结果。此类方法适用土地覆盖类型较少的场景,具体方法对比分析如表1所示。

表1 基于分解的时空融合模型Table 1 Spatiotemporal fusion models based on decomposition

2.2 基于权函数的时空融合模型

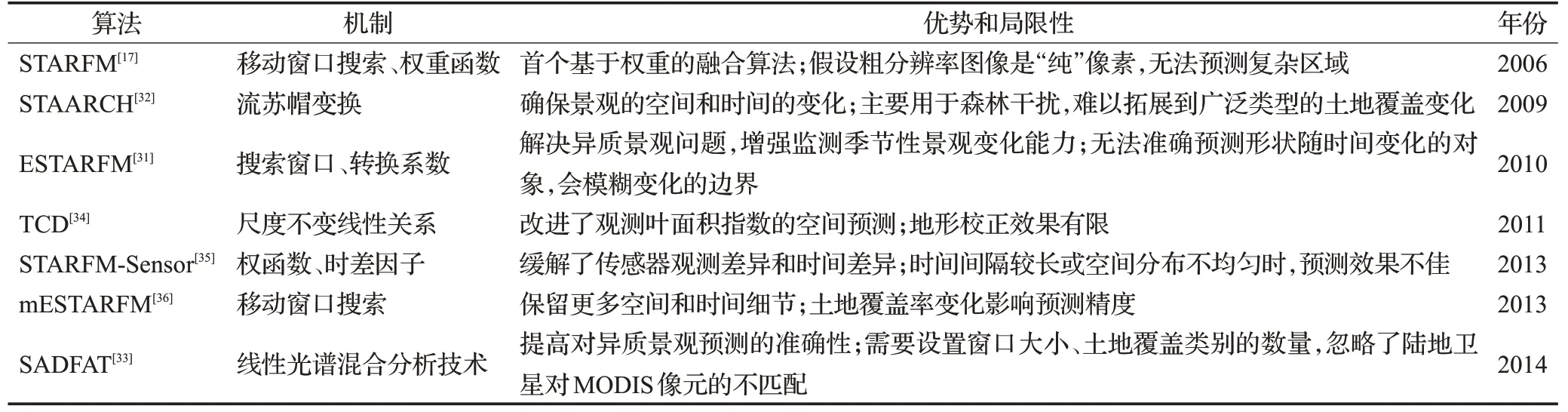

基于权函数的方法通过权函数结合所有输入图像的信息来估计精细像素值。Gao等[17]首次提出基于权函数的时空自适应反射率融合模型STARFM。STARFM采用加权函数来预测像素,加权函数通过数据间的光谱差异和邻近像素的信息计算得出。STARFM存在两个主要问题:在多种土地覆盖类型的异质景观中效果较差,权函数是经验函数。为了提高STARFM在异质景观中的预测效果,Zhu等[31]提出增强自适应反射率融合模型(enhanced STARFM,ESTARFM),使用转换系数更准确地保证了对小对象和线性对象的反射率预测。映射反射变化的时空自适应算法(spatial temporal adaptive algorithm for mapping reflectance change,STAARCH)[32]从粗图像的密集时间序列中监测变化点,以较好的细节水平识别景观的空间和时间变化。SADFAT[33]算法修改了STARFM,通过转换系数将粗细分辨率图像上的热辐射变化联系起来。Hwang等[34]提出基于多时相数据的复杂地形下植被动态降尺度算法,通过降尺度技术将MODIS和Landsat数据融合,并且在降尺度的过程中补偿物候差异,最后缓解了空间异质性问题。Shen等[35]考虑不同传感器的观测差异,改变STARFM中计算像素权重的方式,提高最终的预测精度。Fu等[36]对ESTARFM进行了改进,引入了土地覆盖数据作为光谱相似相邻像素的补充信息,使得在预测图像时能够保留更相似的空间细节。

基于权重函数的时空融合模型理论简单,出现大量基于权重函数的变体算法,但大多属于经验函数,依赖其他输入图像的像素信息,这导致当土地覆盖类型过多或发生土地覆盖突变等异常变化时难以从相邻图像提取精确的信息,反而融合精度较差。此类方法适用于土地覆盖小范围变化的场景,具体方法对比分析如表2所示。

表2 基于权重的时空融合模型Table 2 Spatiotemporal fusion models based on weight

2.3 基于贝叶斯的方法

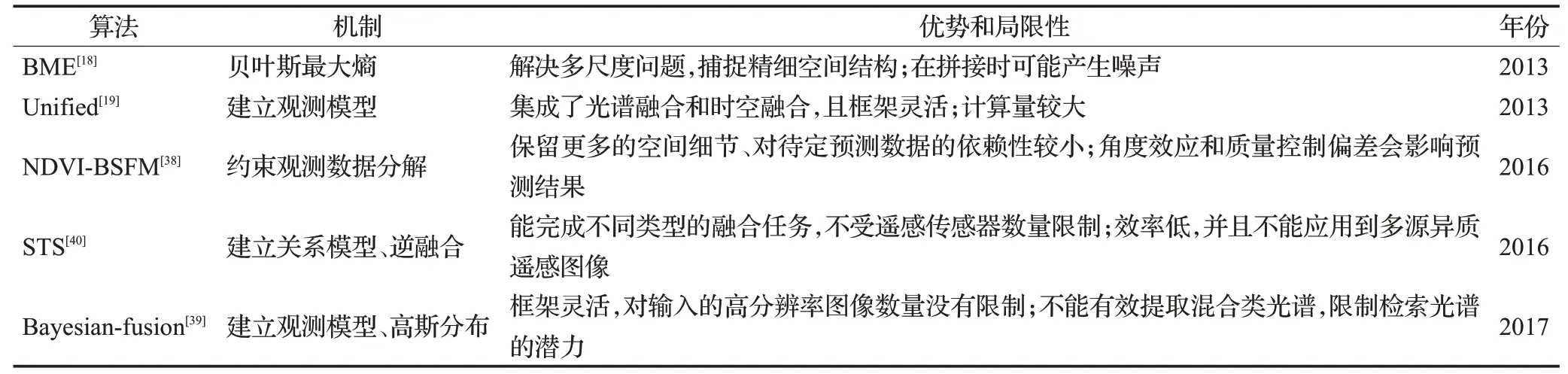

时空贝叶斯数据融合将图像时间序列中的时间相关信息结合起来,将融合问题转化为估计问题[37]。Li等[18]使用贝叶斯最大熵的融合方法避免由缩放造成的复杂性和不确定性。Huang等[19]提出统一模型,通过低通滤波对空间关系进行建模,并使用线性模型对时间关系进行建模。在NDVI-BSFM[38]中,使用线性混合模型对高分辨率图像和低分辨率图像进行建模,同时利用多年NDVI时间序列作为先验信息进行建模。Xue等[39]提出将图像时间序列中的事件信息结合起来,将融合问题转化为估计问题,提高了在异质景观场景中的融合效果。Shen等[40]在所提出的融合框架中,利用最大后验概率理论来描述逆融合问题,建立综合关系模型,利用共轭梯度优化算法完成最终的融合。

基于贝叶斯的融合方法的重点在于对观测图像和待预测图像之间的关系进行建模,当发生土地覆盖类型变化时会导致预测精度降低。此方法适用对模型灵活性要求高的场景,具体方法对比分析如表3所示。

表3 基于贝叶斯的时空融合模型Table 3 Spatiotemporal fusion models based on Bayesian

2.4 基于学习的方法

基于学习的方法使用机器学习对观测到的图像对之间的关系建模,预测未观测到的图像[14]。Huang[20]通过稀疏表示将细图像和粗图像之间的对应关系训练为字典对,利用两对已知粗细图像对之间的变化关系对预测图像进行预测。随后Song等[21]进行了优化,提出基于一对图像对进行预测的融合方法。Wu等[41]对字典扰动的误差界进行正则化,从而达到预测精度。Liu等[42]利用极限学习机技术,建立一个学习差分图像的映射函数,实现快速准确的精细预测。Moosavi等[43]结合小波变换和人工智能方法,构建出一个非线性模型来处理地表温度的非线性特征。Wei等[44]提出结构稀疏和半耦合学习的方法解决稀疏表示降低表达精度的问题。

基于学习的方法根据精细和粗略分辨率图像的结构相似性建立对应关系,可以捕获预测中的主要特征,包括土地覆盖类型变化等,但是由于粗图像与细图像之间的尺度差异较大,无法准确地保持预测对象的形状,尤其是不规则形状的地物对象。此方法适用于对数据样本量大、时间跨度长的场景,具体方法对比分析如表4所示。

表4 基于学习的时空融合模型Table 4 Spatiotemporal fusion models based on learning

2.5 基于混合的方法

一些时空融合方法结合分解方法、贝叶斯理论、权重函数和学习方法的优势来追求更好的融合效果。例如Zhu等提出了将基于分解的方法、基于权重的方法和空间插值思想集中在一起的时空融合方法FSDAF[23],FSDAF能够融合具有挑战性的场景中的图像,即异质景观和突然的土地覆盖变化。时空遥感图像和土地覆盖图融合模型(spatial-temporal remotely sensed images and land cover maps fusion model,STIMFM)[45]结合光谱分解和贝叶斯框架,将多时相粗图像和少量土地覆盖图生成一系列精细时空分辨率的土地覆盖图。时空反射分解模型(spatial and temporal reflectance unmixing model,STRUM)[24]采用贝叶斯的方法分解粗图像中的时间差异,利用STARFM原理将时间差异添加到细图像中得到融合图像。为了生成高空间细节的日精细分辨率地表温度,BLEST[46]将权值函数、时间插值和空间降尺度融合,保留更多的空间细节和时间变化信息。

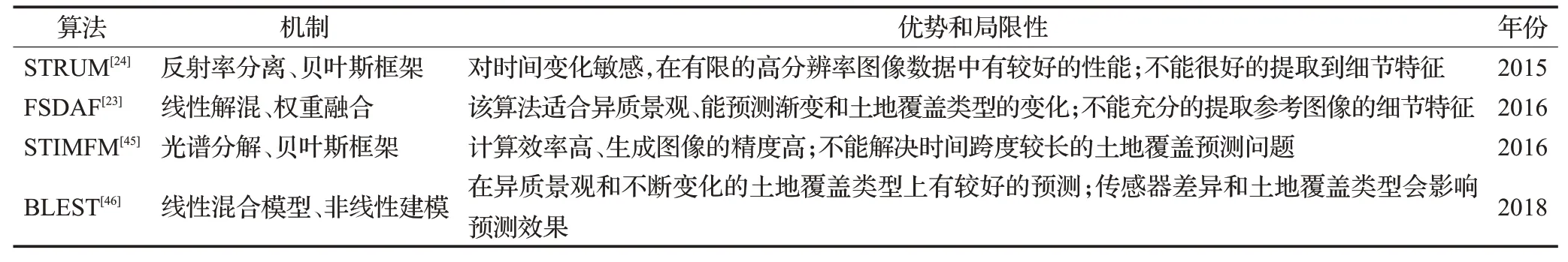

混合的时空融合方法可以通过多种方法的组合来处理不同的土地覆盖类型变化问题,提高了模型的泛化能力,但同时也提高了算法的复杂性,限制了算法的大规模应用。此方法适用于要求预测精度高、模型复杂度没有限制的场景,具体方法对比分析如表5所示。

表5 基于混合的时空融合模型Table 5 Spatiotemporal fusion models based on hybrid

3 基于深度学习的遥感图像时空融合

在基于多层次的遥感图像超分辨率重建中,基于时序和空间特征的融合在近些年取得了突破,尤其是基于深度学习的时空融合为其发展指明了新的方向。

基于深度学习的时空融合算法一般都需要一对到两对先验信息。先验信息表示同一时刻的高空间低时间分辨率和低空间高时间分辨率结合而成的一对信息。目前,在遥感图像时空融合领域,大多数实验中高空间低时间分辨率(HSLT)采用Landsat数据集,低空间高时间分辨率(LSHT)采用MODIS数据集。接下来主要总结了近两年来涌现出的基于深度学习的时空融合算法,分析各个算法的特点,并对基于深度学习的融合算法进行对比,如表6所示。

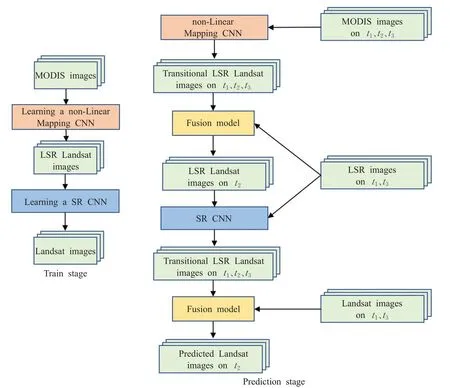

表6 深度学习时空融合模型对比Table 6 Comparison of deep learning spatiotemporal fusion models

3.1 基于普通卷积网络的时空融合算法

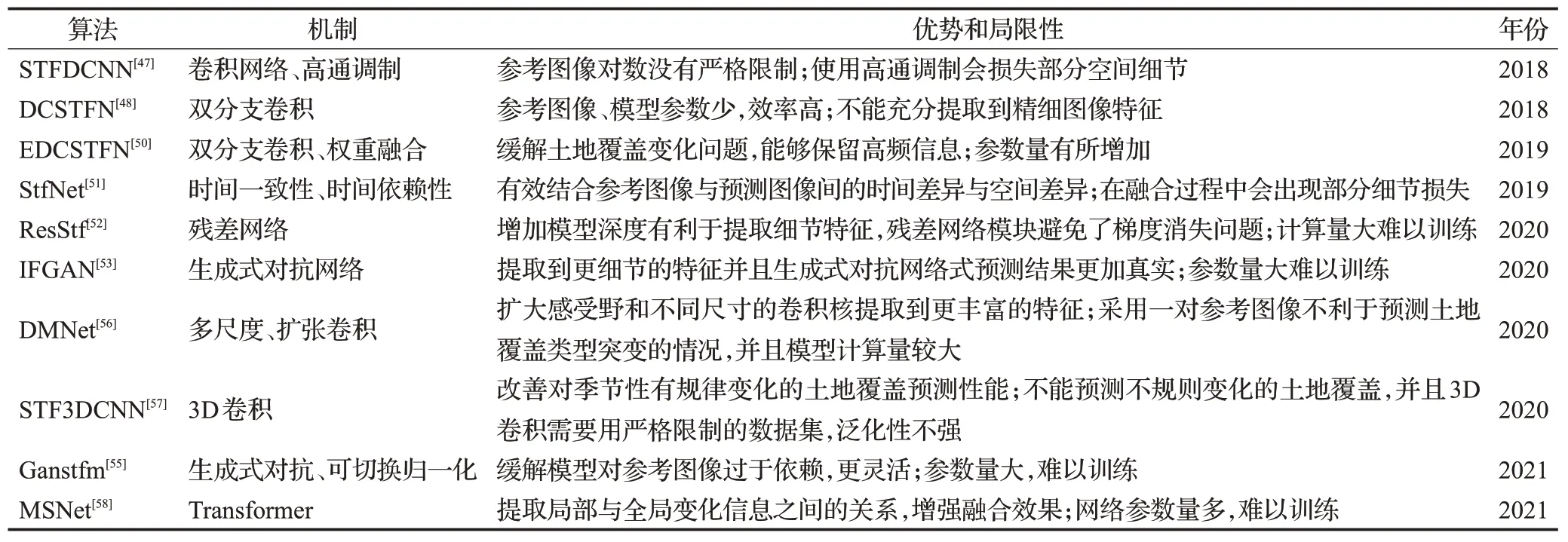

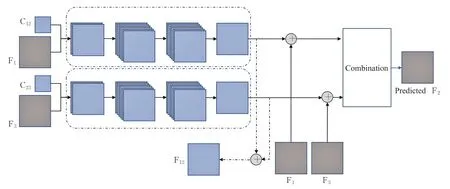

Song等[47]提出了一种基于CNN的时空融合算法(spatiotemporal fusion using deep convolutional neural networks,STFDCNN)。该方法训练阶段分为两部分,这两部分充分利用残差网络的思想,让网络着重于学习高频细节,如图1左图所示。预测阶段,为了利用预测日期前后的两个临近时刻的先验图像的时间变化信息,应用了高通调制方法[48]来预测图像。该方法既可以使用两对先验图像又可以使用一对先验图像来对预测图像进行信息的补充,在先验图像的对数方面没有严格的限制。虽然该方法总体表现良好,但是在预测时由于使用高通调制和权重融合,不可避免地会丢失一些空间细节。

图1 STFDCNN网络结构图Fig.1 STFDCNN network structure diagram

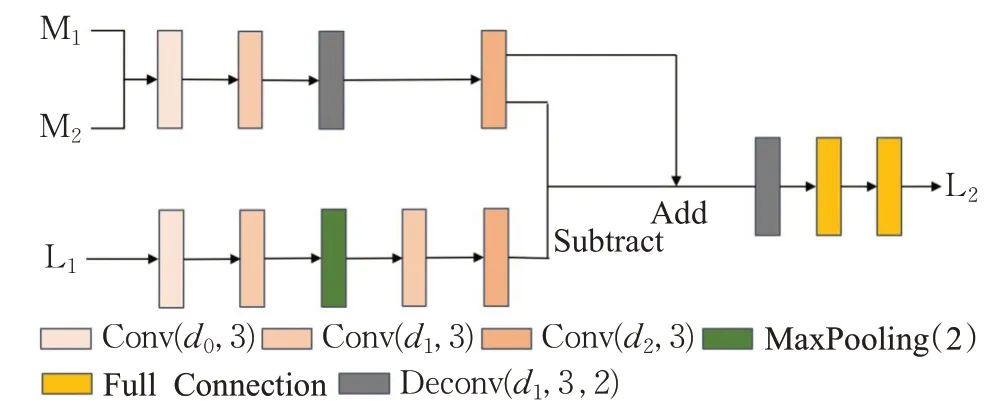

Tan等[49]提出的深度卷积时空融合网络(deep convolutional spatiotemporal fusion network,DCSTFN)找到了低空间分辨率高时间分辨HTLS与低时间分辨率高空间分辨LTHS图像之间的直接非线性映射关系。网络包含两部分,如图2所示,第一部分是一个共享子网络,在提取HTLS和LTHS低频分量特征的同时扩展其尺寸,第二部分对LTHS的先验图像进行高频分量特征的提取,最后,将三张图像得来的特征进行融合。该算法的优点是利用一对先验图像即可进行预测,然而这对先验图像的要求比较高,如果仅有的一对先验图像质量不高,将会极大程度地影响预测结果。另外,随着网络层数的深度加深,引入残差网络也可以解决该算法可能存在的网络退化问题。随后Tan等对DCSTFN算法进行改进,提出增强型深卷积时空融合网络(enhanced deep convolutional spatiotemporal fusion network,EDCSTFN)[50],引入双分支以支持两对参考图像。此外,引入新的复合损失函数,将图像的精度和视觉损失结合起来,能够较好地预测土地覆盖变化问题,并尽可能地保留高频信息,生成清晰的图像。

图2 DCSTFN网络结构图Fig.2 DCSTFN network structure diagram

Liu等[51]基于卷积神经网络提出了双流卷积神经网络(two-stream convolutional neural network,StfNet)。该方法为了缓解在特征提取过程中出现的空间信息丢失问题,引入了时间依赖性和时间一致性原理。网络结构如图3,预测日期的图像分别与前一刻日期和后一刻日期的图像结合,利用时间依赖性得到两个精细图像特征,两个精细图像特征再利用时间一致性获得最终的预测结果。此方法在客观和主观评价方面都取得了非常好的性能。

图3 StfNet网络结构图Fig.3 StfNet network structure diagram

3.2 基于残差网络的时空融合算法

Wang等[52]提出了基于残差网络的时空融合算法,如图4所示,网络建立了一种低空间高时间分辨率图像与高空间低时间分辨率图像之间的非线性映射模型。该方法增加了神经网络的深度,提取到了更多的细节特征,并且利用残差网络避免或减少了梯度消失的问题。但是对数据集的时间信息提取不足,不能精准地预测土地覆盖类型的变化。

图4 基于残差网络的网络结构图Fig.4 Network diagram based on residual network

3.3 基于生成对抗网络的时空融合算法

Zhang等[53]提出了一种基于生成对抗网络的时空融合方法(spatiotemporal fusion method using a GAN,STFGAN),借鉴SRGAN(generative adversarial network for image super resolution)[54]的思想,如图5所示,利用生成对抗网络的优势提高预测效果,并且在生成器中引入残差学习的结构,使深层次结构网络也能获取到更多地物细节以及高级抽象特征的同时避免了梯度消失和梯度爆炸问题。生成器对抗网络的参数量多和难训练是该模型最需要优化的问题。

图5 IFGAN模块结构图Fig.5 IFGAN module structure diagram

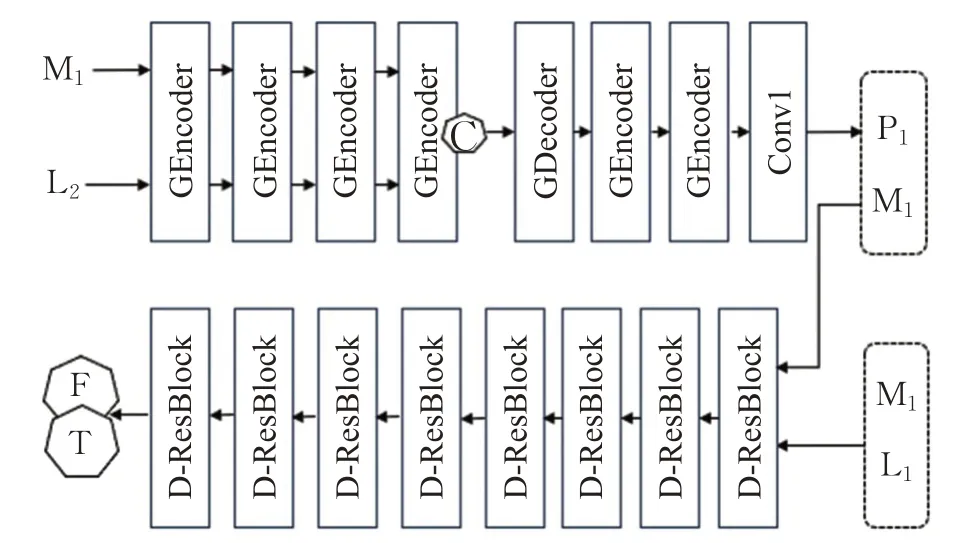

为了缓解模型对参考图像过于依赖的问题,Tan等[55]提出基于生成对抗网络的时空融合模型(GAN-based spatiotemporal fusion model,Ganstfm),如图6所示。在以往模型中,往往需要一对或者两对参考图像,并且必须对参考图像应用严格的约束。为了应对该问题,并且提升模型在恶劣条件下图像的预测精度,采用条件生产对抗网络和可切换归一化模块,缓解了对输入图像的严格限制。

图6 Ganstfm网络结构图Fig.6 Ganstfm network structure diagram

3.4 基于多尺度与扩张卷积的时空融合算法

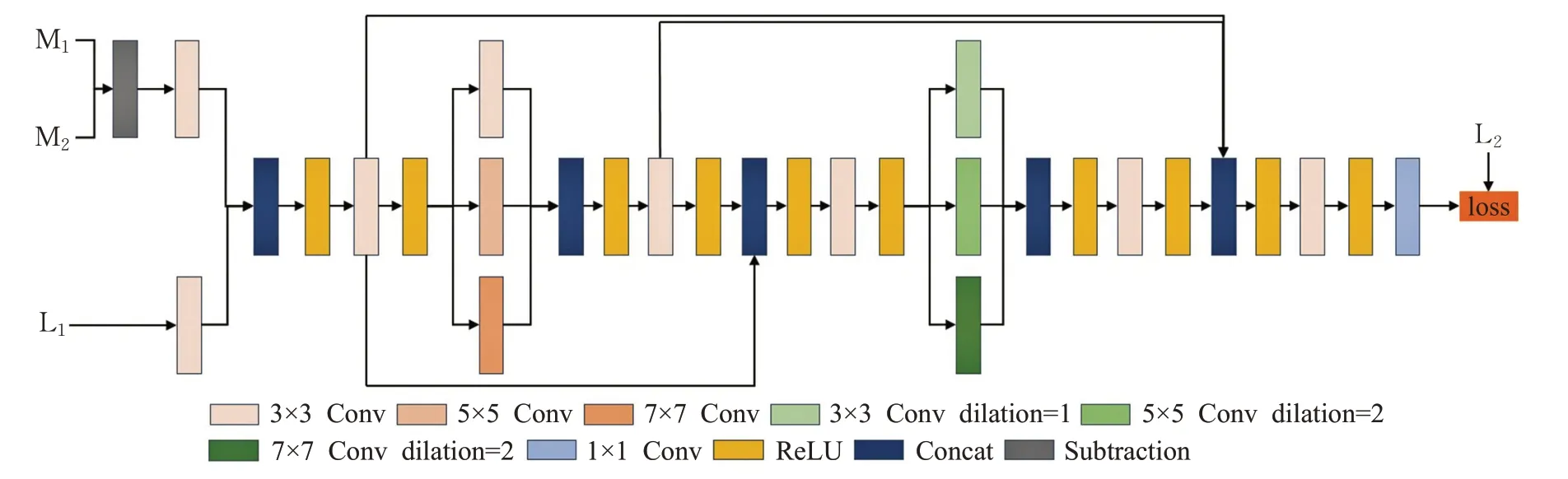

Li等[56]提出基于多尺度机制和扩张卷积的神经网络(network architecture using dilated convolution and multiscale mechanisms,DMNet),网络结构如图7所示,不但避免局部特征冗余,而且获取更多的图像特征,利用多尺度机制采用不同尺度卷积核提取图像的信息,可以更加准确地提取到特征图的时间变化和空间细节。同时引入跳跃连接,避免了多尺度机制造成特征信息的丢失。

图7 DMNet网络结构图Fig.7 DMNet network structure diagram

3.5 基于3D卷积神经网络的时空融合算法

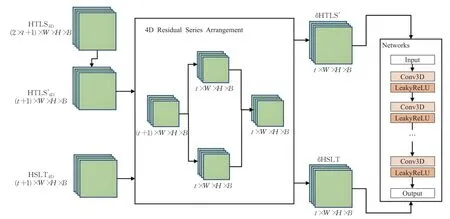

随着遥感技术和传感器的快速发展,目前已经积累了大量的遥感数据,为长时间序列遥感数据的处理奠定基础。Peng等[57]提出了基于三维卷积神经网络的融合方法(fast three-dimensional convolutional neural network,STF3DCNN),结构如图8所示,主要包括剩余序列排序和剩余特征映射网络,根据4D残差规则使数据排列成4D残差序列数据集,将数据集输入到剩余特征映射网络中进行预测。该方法首次使用三维卷积和四维数据进行时空融合,时间权重改善了季节性有规律变化的土地覆盖类型,在保持总体精度的同时显著减少了总运行时间。但该模型对于输入数据要求严格,并且突然不规则的土地覆盖变化没有得到改善。

图8 STF3DCNN网络结构图Fig.8 STF3DCNN network structure diagram

3.6 基于Transformer的时空融合方法

作为注意力机制的一个应用,Transformer引入到视觉领域后取得了良好的效果。为了能够学习全局变换信息,Li等[58]引入ViT(vision Transformer),ViT与卷积结构进行结合设计出双分支网络,分支的结构如图9所示。网络在提取到特征的同时,利用ViT的自我注意机制和位置信息来学习粗图像局部和全局时间变化信息之间的关系,同时使用平均加权的方法对两个分支进行融合,使融合效果更佳精确。

图9 MSNet网络结构图Fig.9 MSNet network structure diagram

4 实验

4.1 数据集

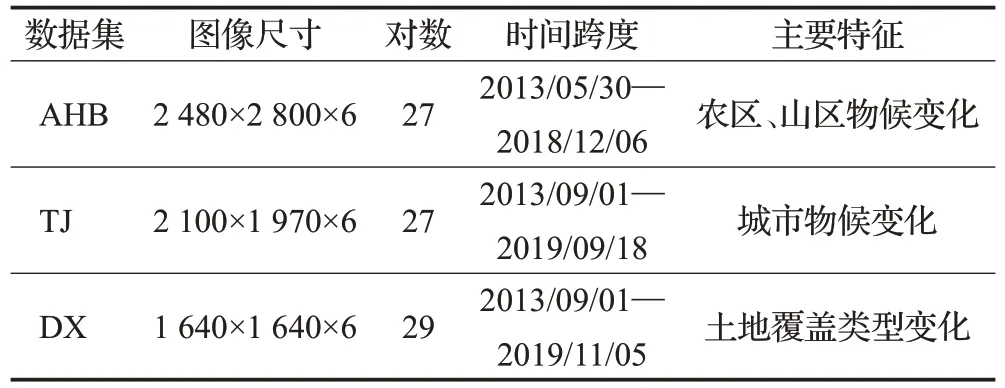

本文选取了AHB数据集、天津数据集(TJ)和大兴数据集(DX),分别收集于内蒙古科尔沁旗、天津市和北京市大兴区。每一幅遥感数据具有6个波段,包括蓝色波段、绿色波段、红色波段、近红外波段、短波红外-1波段、短波红外-2波段[9]。各个数据集总结详细信息见表7所示。

表7 数据集介绍Table 7 Dataset introduction

4.2 实验环境和实现细节

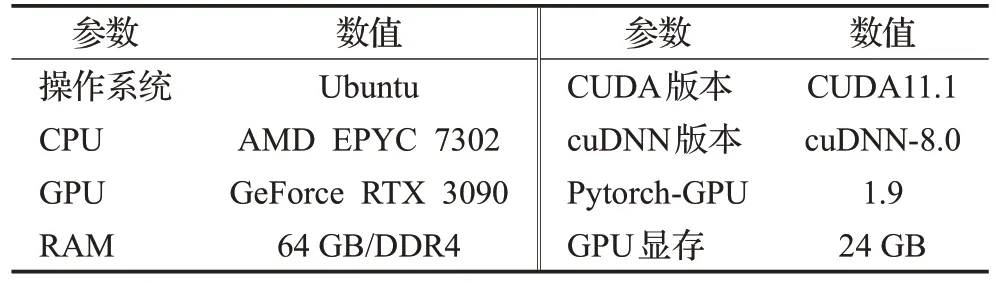

因为在MODIS图像的两个短波红外波段存在着明显的条带噪声,这给训练过程带来了很大的挑战,在实验中只用前四个波段进行训练。粗细图像对(低分辨率和高分辨率图像对),三对组成一组训练数据,分别是t0、t1、t2时刻的图像对。t0和t2是参考图像,为了预测t1时刻的高分辨率图像。数据集的80%用于模型的训练,20%用于模型的验证和测试。由于训练过程中整张输入图像会导致运行显存不足,数据采用分块训练(整张训练需要太大显存),把遥感数据分为80×80。训练细节方面,本模型采用Adam优化方法更新模型的参数,其中初始学习率为0.001,batch_size设置为8,epoch设置为30。本文使用Pytorch实现所有的实验,并在NVIDIA RTX 3090设备上进行测试,具体实验环境配置如表8所示。

表8 实验环境介绍Table 8 Introduction to environment experiment

4.3 评价标准

图像质量评价一直是计算机视觉中的重要问题。本文使用研究人员提出的通用评价指标对不同数据集上的实验结果进行分析。

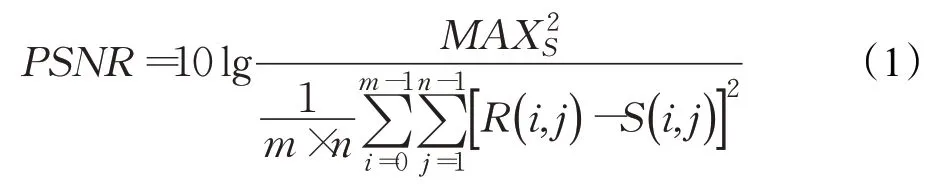

(1)峰值信噪比

峰值信噪比(peak signal to noise ratio,PSNR)[59]是一种十分常用的图像质量评价准则,在图像像素级别反映了待评价图像与真实参考图像间的统计差异性。通过计算对应像元间灰度差异的统计均值来反映相似性与图像质量好坏:

其中,R为真实参考图像,S为重建后的图像,MAX为图像点颜色的最大值,m、n为图像的尺寸。

(2)结构自相似性

结构自相似性(structural similarity,SSIM)[60]是一种评价图像质量的优良准则,主要认为人眼对图像质量的评价是基于图像中的结构信息,因此好的图像质量应该能够较好地保持恢复图像中的结构信息,做到结构失真尽量最低。为此,提出了结构相似性测度:

其中,μx、σx分别为待评价图像x的均值与标差,μy、σy分别为参考图像y的均值与标准差,σxy为二者的协方差。通过式(5)可以看出,SSIM评价准则的取值范围为-1到1,SSIM值越大,图像质量越高。

(3)相对全局综合误差

相对全局综合误差(ERGAS)[61]用来计算所有波段出现的光谱错误率,主要评价融合图像的波段的光谱质量,其公式如下:

其中,h为高分辨率的图片的分辨率,l为低分辨率的图片的分辨率,N为波段数,Bi为多光谱图像,M i为多光谱图像的辐射率的平均值。ERGAS值越小,表明在光谱范围,融合后的图像的光谱质量越好,光谱损失越少。

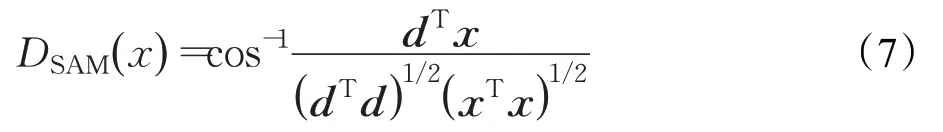

(4)光谱角相似度

普通图像没有光谱角相似度(spectral angle mapper,SAM)[62]这个概念,其只存在于多光谱和高光谱图像,计算的是融合图像的整体光谱扭曲度,用于度量原始高光谱数据与重构高光谱数据之间的光谱相似度,公式如下:

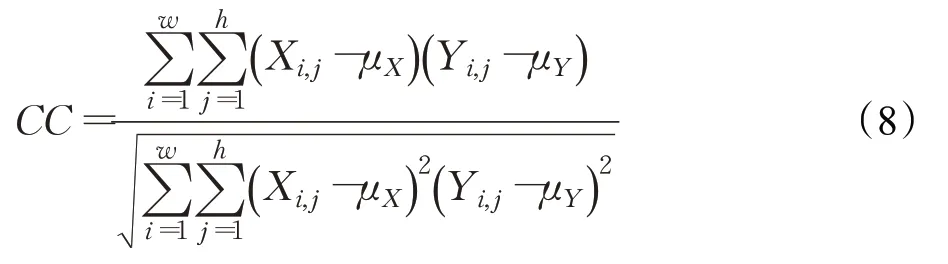

(5)空间相关系数

为了评估融合图像与参考图像空间细节的相似性,利用高通滤波器提取参考图像的高频信息,计算高频信息之间的相关系数(correlation coefficient,CC)[63]。这种数量指标称为空间相关系数。CC越高,说明融合过程中PAN图像的大部分空间信息都被注入。计算融合图像和参考图像之间的CC,最终的CC在MS图像的所有波段上取平均值。

相关系数的计算为:

其中,X为融合图像,Y为参考图像,w和h为图像的宽和高,μ表示图像的平均值。

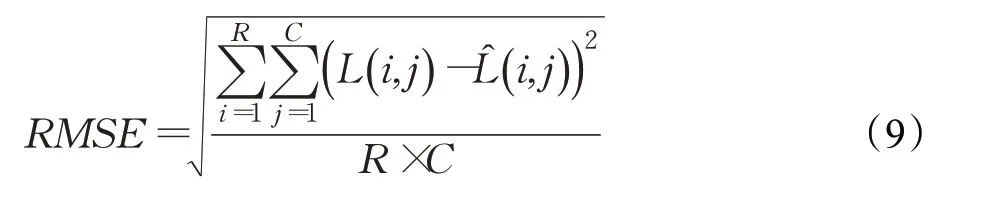

(6)均方根误差

均方根误差(root mean square error,RMSE)[64]表示融合结果与实际观测图像之间的辐射差异的全局描述,通过直接计算像素值的变化来比较融合结果与观测图像的差异。定义如下:

4) 通过小曲拐最大节点应力应变的变化趋势得知3个小曲拐有相似的运动规律与受力状况。符合小曲拐平面四杆机构的运动规律,为小曲拐进一步的优化提供重要的参考。

其中,L和L̂分别表示实际观测图像和融合结果,R和C分别记录图像的宽度和高度。RMSE越小,预测效果越好。

4.4 实验结果分析

4.4.1 定量分析

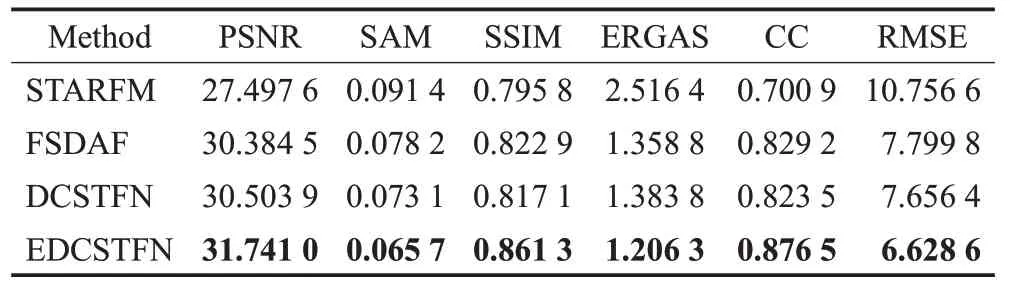

本实验采用STARFM、FSDAF、DCSTFN、EDCSTFN作为基准模型,综合超分辨率重建的评价指标,分别采用PSNR、SAM、SSIM、ERGAS、CC、RMSE评价模型性能。STARFM和FSDAF是传统模型,DCSTFN是单分支的深度学习模型,EDCSTFN是双分支的深度学习模型,并且由DCSTFN改进而来,选择这四个模型可以有效地观察传统模型和深度学习模型的区别,以及单分支模型和双分支模型之间的区别。

表9为基准模型在AHB数据集上的测试结果,传统模型在峰值信噪比(PSNR)、光谱角映射器(SAM)、结构相似性(SSIM)、相对全局综合尺度(ERGAS)、均方根误差(RMSE)指标上都略低于深度学习模型,但在相关系数(CC)指标上要比深度学习的模型高。这是由于AHB数据集地物目标较多,现有的大多数深度学习时空融合模型对于多地物特征的重建有一定的困难。同时深度学习模型在提取特征方面具有独特的优势,使得模型在其他方面有不错的效果。

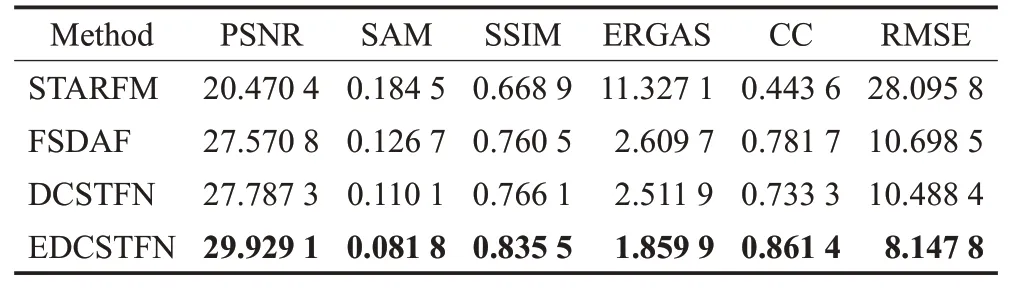

对于DX数据集和TJ数据集,深度学习模型的各方面指标都可以取得最好的效果,如表10和表11所示。在指标方面,部分指标不如AHB数据集上的效果优秀,是因为DX和TJ是城市数据集,城市拥有更多的细节特征需要模型学习。低分辨率图像与高分辨率图像的分辨率比值是1∶16,也给细节特征的提取带来一些困难。

表10 DX数据集实验结果Table 10 Experimental results of DX dataset

表11 TJ数据集实验结果Table 11 Experimental results of TJ dataset

4.4.2 定性分析

本实验选择了一些样本图片进行预测,并展示了它的预测结果。

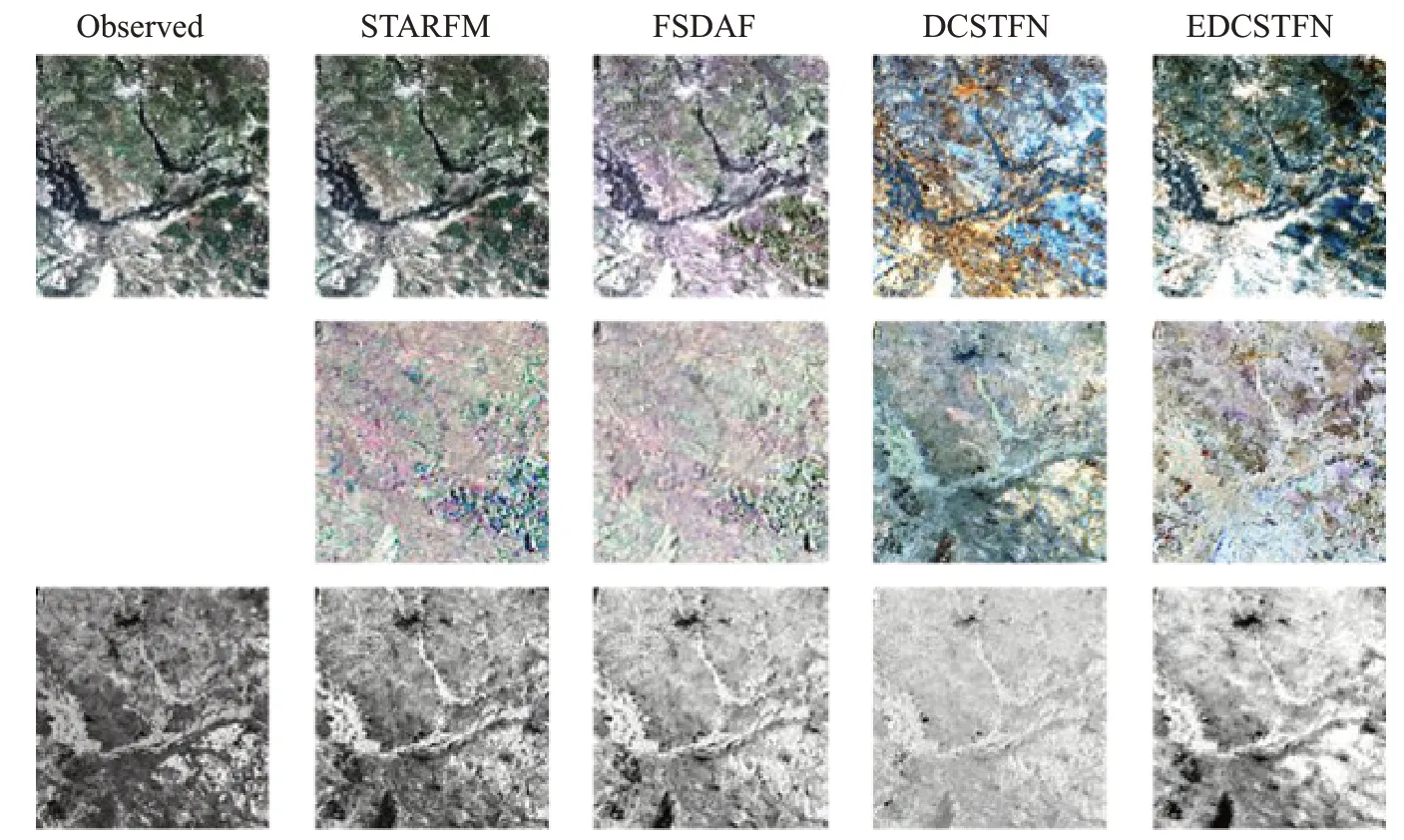

图10 AHB数据集部分样例测试结果Fig.10 Sample test results of AHB dataset

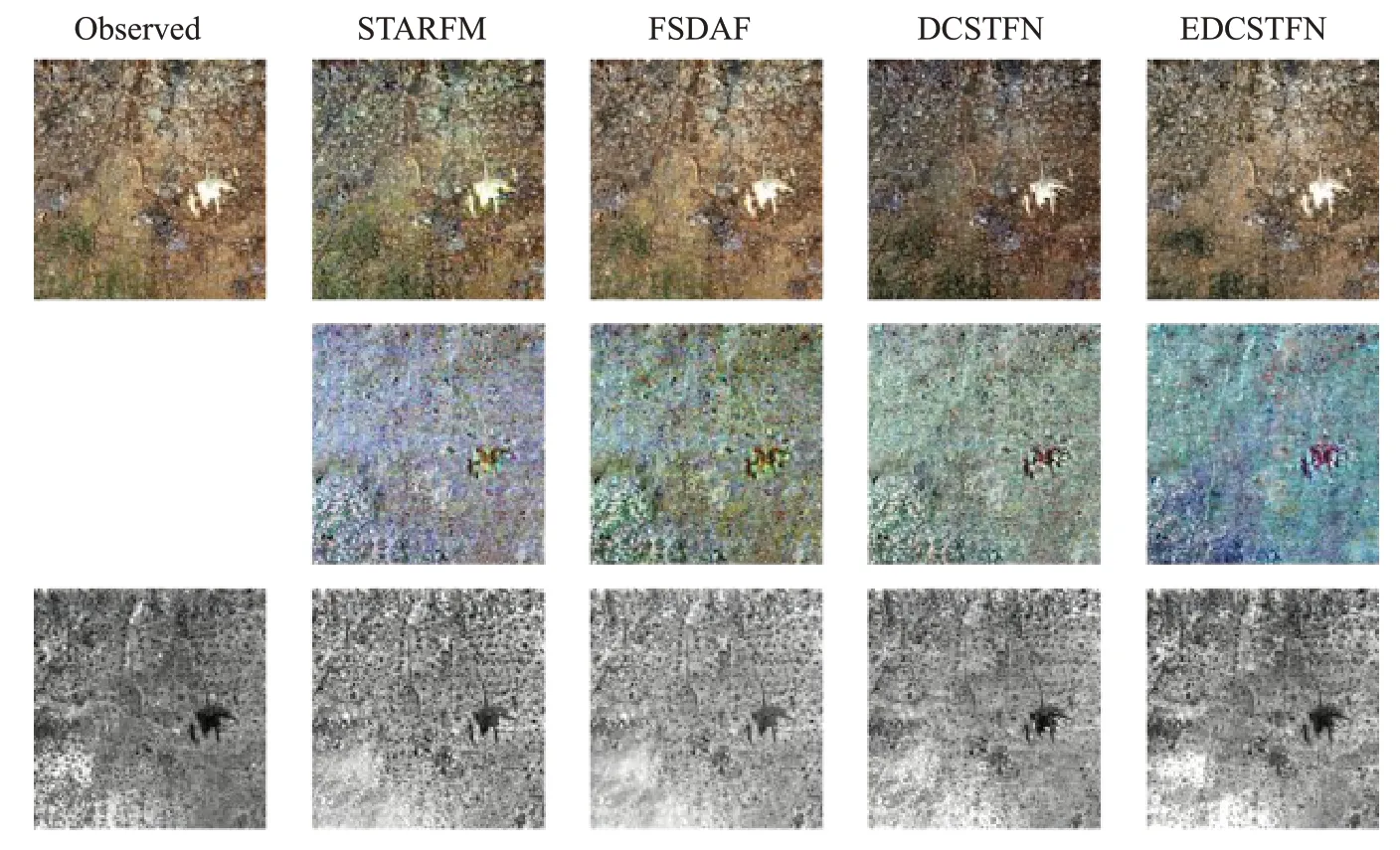

图11显示了在DX数据集上各个模型的预测结果图。在DX数据集中,深度学习模型在每个指标上都要优于传统学习模型,与AHB不同的是,DX数据集中主要是城市和农田,目标种类较少,在图像全局效果方面得到了比较不错的重建。但是也由于城市具有大量的细节特征,部分特征细节难以提取,使得指标略低于AHB数据集。

图11 DX数据集部分样例测试结果Fig.11 Sample test results of DX dataset

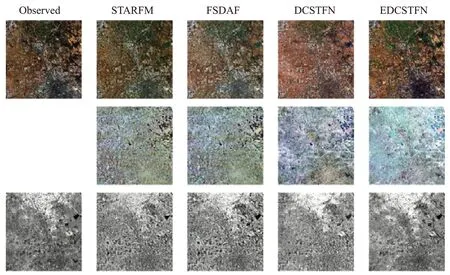

图12显示了在TJ数据集上各个模型的预测结果图。与DX数据集相似,TJ数据集也主要包含城市和农村,目标种类较少,深度学习模型在每个指标上都要优于传统学习模型,在图像全局特征和局部特征细节方面也都有比较不错的重建效果。

图12 TJ数据集部分样例测试结果Fig.12 Sample test results of TJ dataset

5 总结和展望

随着遥感技术的发展,单一的卫星传感器获取到的遥感图像已不能满足实际应用的需求,遥感图像时空融合技术作为解决该问题的有效方法,逐渐得到国内外研究学者的关注,尤其是将深度学习方法引入时空融合领域后,基于深度学习的时空融合算法在与传统的时空融合算法比较中取得了明显的优势。本文总结了各类遥感图像时空融合算法,着重分析了基于深度学习的时空融合模型的优势和不足,并对时空融合模型的数据方面和模型方面做出如下展望。

(1)多源数据融合

在科技快速发展的支持下,已经有越来越多的卫星传感器、无人机和雷达等可以获取到各种类型的遥感图像,而目前大多数时空融合算法使用两种类型的数据进行融合,未来的时空融合方法可以考虑将多种类型的遥感数据结合起来。在融合过程中,来自不同传感器的数据虽然有相似的光谱和空间结构,但它们难免会有差异,比如大气条件、视角以及由位置偏差导致的像素差异。目前已有的大多数研究使用数据预处理等手段消除这种差异,但仍然难以将精度达到精细像素级。未来的研究可以考虑融合两种及两种以上的传感器数据,在充分利用不同来源的数据信息的同时,降低不同传感器数据之间的差异,结合不同数据的优势,提高融合效果。

(2)半监督与无监督学习

在遥感图像时空融合领域,大多是基于深度学习的有监督学习网络,基于半监督和无监督学习的模型很少。在遥感领域,伴随着传感器的增多,数据也不断增多,但能够满足研究时空融合条件的数据量还是较少,而具有标记的数量更是有限,只用有监督学习无法充分利用已有的数据。目前半监督和无监督学习已经在普通图像分类、超分重建等领域逐渐成熟,然而在遥感图像领域的应用很少,未来的研究可以充分考虑使用半监督和无监督学习应对可用数据少的问题。

(3)对时间序列的依赖性

目前的时空融合算法,大多利用一对或者两对参考图像提取到参考图像与预测图像之间的时间信息,将时间信息与空间信息进行融合进而得到预测日期的精细图像。这种方法对参考图像的日期选择具有严格要求,需要预测日期前后两个日期的参考图像,且时间相隔不宜太长,然而在实际的应用中,通常无法满足这种条件限制。目前已有研究使用可切换归一化和生成式对抗网络来降低对输入图像数量的限制,但仍需要在预测时对参考图像进行时间的约束,且在某些复杂区域的预测效果并不如使用两对参考图像。如何利用已有的数据,在打破输入数量限制和时间限制的同时,提升预测效果是使模型更具实用性的研究方向之一。

(4)模型泛化性能与效率

限制遥感图像时空融合算法应用于实际应用的因素主要有以下两点:模型泛化性和模型计算效率。

不同数据集的研究区域以及研究场景所需要考虑的情况不同,比如针对山区、森林的模型在生态环境监测中有较好预测结果,然而无法准确预测城市中具有大量人为因素的土地覆盖变化情况。因此提高模型的泛化性,使一个模型能够在多个不同地区以及不同类型的数据集上有相同的优秀效果至关重要。

另一方面,大多数传统的时空融合方法是基于像素级计算和移动窗口策略,这种策略造成模型具有复杂性。除此之外,近年来基于生成式对抗网络和基于Transformer的网络在遥感图像时空融合领域也取得了不错的效果,然而这些模型也存在参数量大、计算时间长等问题。因此,提高模型计算效率,减少模型参数,减少预测所需要的时间,增强模型的实时性也是一个研究重点,是满足实际应用的需求之一。