AUV 回收对接前景视场立体匹配算法研究*

戴文文 曾庆军 赵 强 朱志宇 刘维亭 郭雨青

(江苏科技大学电子信息学院 镇江 212003)

1 引言

AUV 由于其携带的能源有限,航行时间以及航行距离受到限制,所以AUV 水下回收对接已经成为了世界各国研究的重点。目前美国、英国、德国、日本等国家对于AUV 水下回收对接的研究较为成熟,国内在AUV 方面的研究主要集中于中国科学院沈阳自动化研究所、浙江大学以及哈尔滨工程大学等单位。各国科学家根据不同AUV 的特点以及不同的对接目标,设计了不同的AUV 回收对接系统,大致可分为五类,1)水下箱(笼)式对接;2)机械手或载体辅助式对接;3)绳索或杆类引导对接;4)平台阻拦索式对接;5)喇叭口式引导对接[1]。在AUV 回收对接过程中,对AUV 的前景视场进行三维重建,能够提高末端导航定位的精度,也能为实时路径规划提供环境信息。本文采用双目摄像机作为三维重建的传感器。

目前采用双目作为环境探测器的AUV 不多,在国外,日本东京大学2005年将Twin-Burger2AUV与双目立体视觉结合,检测和识别水中的浮游生物[2]。美国斯坦福大学ARL 实验室与MBARI(Monterey Bay Aquayium Research Institute)联合开发的一个半自治水下机器人OTTER(Ocean Technology Testbed for Engineering Resaeach),可用作各种水下自治技术的开发和验证试验平台[3~4]。澳大利亚国立大学开发的AUV 用于海底探索和监测,它由两个防水舱中安装着两台摄像机,组成一个双目视觉系统[5]。在国内,哈尔滨工程大学水下机器人技术重点实验室研制的WL-3 AUV,采用双目摄像机作为传感器,对接近距离段采用双目视觉导引,实现光视觉导航定位。哈尔滨工程大学的姜言清等人研究了基于双目视觉的AUV 回收对接关键技术,将光视觉用于对接阶段的导航,有效地提高了导航精度,保证了导航信息的平稳输出[1]。AUV三维重建实质是水下三维重建,Brandou V[6]等利用立体视觉系统IRIS,对水下同一物体拍摄多组照片,利用图像分割算法实现三维重建。Yau T[7]等用多个摄像机利用传统PMVS 算法实现了对水下物体的三维重建,取得了很高的精度,但是其成本较高且使用的环境受到限制。R.Ferreira[8]等利用等效焦距的方法来补偿水下折射对水下成像的影响。国内哈尔滨工程大学的吴云峰[9]将空气中的三维重建算法应用于水下,对水下折射以及散射未进行充分考虑,效果不是很理想。哈尔滨工业大学的乔金鹤[10]分析了水下成像的特点,并对角点检测以及三维重建方法进行了研究,由于场景的限制,检测出了很多的无用角点,增加了计算的成本。

本文结合自主研发的全驱动AUV,配备双目摄像机进行水下三维重建,采用改进的CENSUS 变换与最小生成树结合的立体匹配算法实现水下双目图像的立体匹配,利用图像梯度强度以及颜色信息融合的CENSUS 变换计算匹配代价,基于最小生成树算法进行代价聚合,提高匹配效率以及精度,最后配合亚像素精化实现视差优化并通过实验验证算法有效性。

2 AUV回收对接系统总体结构

2.1 AUV回收过程

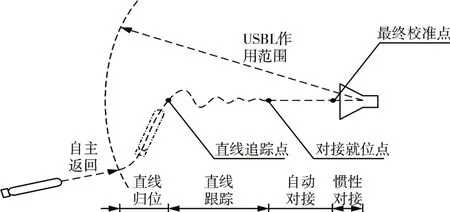

本文使用自主研发的水下自主机器人实现AUV 的水下回收对接。AUV 回收对接过程,包括以下几个阶段,如图1所示。

图1 AUV回收对接过程示意图

第一个阶段为直线归位阶段,这个过程重点在于利用超短基线提供的相对位置、姿态信息来调整AUV 与对接装置的位置,使得在消耗较短对接中轴线距离的情况下,将AUV 航行至中轴线上,同时要考虑到AUV 的姿态尽可能地与中轴线一致,利于进一步实时对接。第二个阶段为直线跟踪阶段,这个阶段是指AUV 重心进入中轴线开始直到距离对接口3m~5m 的阶段。在这个阶段要保证AUV 沿中轴线航行,且艏向角指向对接口。当AUV 到达对接就位点时,进入下一阶段,AUV 根据对接装置口的灯光进行姿态校准,调整艏向指向对接口,保持合适的航姿进行直线运动,直到运动到惯性对接点处,关闭推进器依靠惯性进入对接口。

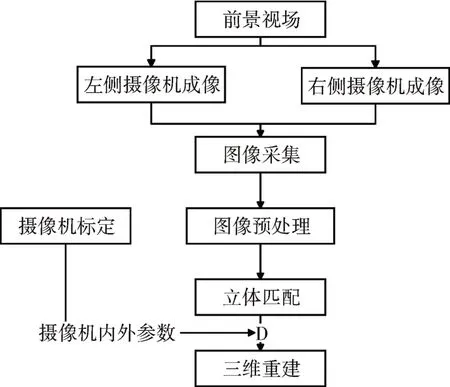

2.2 三维重建过程

本文AUV 前景视场双目三维重建的过程如图2 所示,AUV 在回收对接过程中,左右摄像机分别采集前景图像,通过一系列图像预处理过程消除或缓解水对光成像的影响,接着将左右摄像机拍摄到的对应图像进行匹配,得到对应点的视差,形成视差图,继而根据摄像机标定得到的内外参数算出场景深度D,以及图像中各点的三维坐标[11],最后根据三维坐标进行三维重建。

图2 前景视场双目三维重建过程图

3 立体匹配算法原理

由于本文的研究对象为AUV,其工作环境有其特殊性,在水下AUV 前景视场的三维重建需要考虑水对光成像的影响。本文对水下图像进行预处理将其恢复成空气图像,然后再运用空气中双目处理的方法进行立体匹配以及三维重建。运用此方法使得立体匹配步骤简化,不需考虑水下成像的特殊条件。立体匹配的过程大致分为四个阶段:代价计算、代价聚合、视差计算、视差优化等[12]。针对水下图像弱纹理区域以及重复纹理区域较多的问题,本文采用改进的CENSUS 变换立体匹配代价算法,结合最小生成树代价聚合方法实现视差计算,精度相对较高,运算速度较快,满足AUV 回收对接的要求。

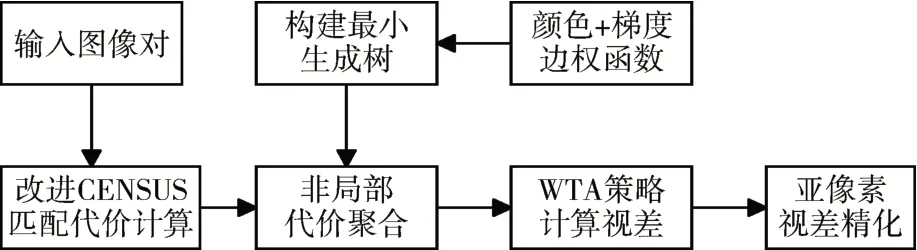

本文算法首先采用改进的CENSUS 变换实现代价计算,实现弱纹理以及重复纹理区域代价更好的计算,再采用基于最小生成树的立体匹配代价聚合算法进行代价聚合,该算法可以在全图建立像素间的关系,使得像素间的关系一目了然,不再受到窗口的约束,可以极大减少代价聚合所花费的时间,使得立体匹配精度得到提高,接着采用优胜者全选(Winner-Takes-All,WTA)算法计算得到代价最小的视差值,最后采用亚像素精化对视差进行平滑优化,实现最终视差图的输出。算法流程图如图3所示。

图3 立体匹配算法流程图

3.1 代价计算

因为水下图像弱纹理以及重复纹理区域较多,这些区域像素值分布均匀,传统的CENSUS 变换极易受中心像素点的影响,在弱纹理及重复纹理区域效果不理想,所以采用改进的CENSUS 变换实现立体匹配代价计算。此方法将某一像素点的梯度强度与颜色信息进行融合后的结果作为该像素点的像素值,改进的CENSUS 变换,对窗口中每一个像素与中心像素进行比较,大于中心像素即为0,否则为1,从而得到一个二进制系列,分别对双目图像的左图和右图计算每个像素的匹配代价。

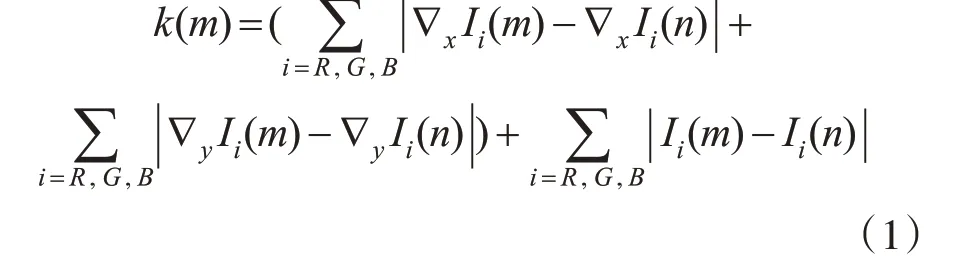

梯度强度与颜色信息融合函数如下式所示:

其中n是m的领域点,∇x,∇y分别表示图像在x和y方向上的梯度,Ii(m),Ii(n)分别表示双目左右图像对应点的i通道值。

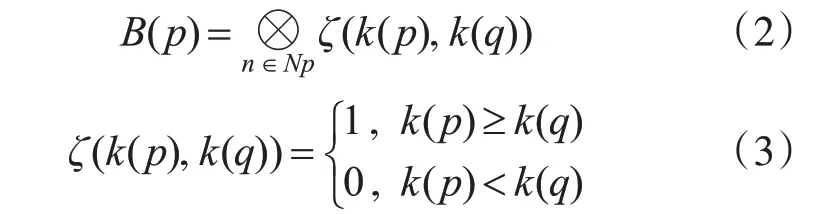

CENSUS变化公式如下:

其中,p为中心像素点,q为窗口内其余像素点,Np为以p为中心的矩形窗口,B(p) 表示改进CENSUS 变换后得到的比特串,ζ表示将各位按位连接,k(p)表示中心像素点梯度强度与颜色信息融合值,k(q)表示窗口内除中心像素点外梯度强度与颜色信息融合值。

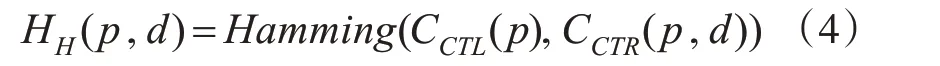

当视差为d时计算汉明距离得到初始立体匹配代价。汉明距离计算公式为

其中,CCTL、CCTR分别为左右图像经改进CENSUS变换后的图像。所以改进CENSUS 变换的匹配代价计算模型为

其中,λ为归一化常数。

3.2 代价聚合

基于最小生成树的匹配代价聚合算法首先将图像表示成无向图G(V,E),其中V是所有图像像素节点,E为连接节点的边,然后通过KRUSKAL算法,生成最小生成树。通过最小生成树中权重的大小定义图像像素之间的联系,经过自顶向下以及自底向上两次遍历就能得到全图所有像素的聚合值,天然建立全图像素间的关系,提高像素代价计算的准确度。采用三通道颜色及梯度特征计算最小生成树的边权值,公式如下:

其中q是p的领域点,Ii(p),Ii(q)分别表示左右图像对应点的i 通道值,∇x,∇y分别表示图像在x和y方向上的梯度。相似度r决定了图像中的一个像素对另一个像素的聚合贡献度权重:

其中α为调节像素相似度的常数。

根据最小生成树的树结构可得像素聚合值为[13]:

3.3 视差计算与优化

然后根据WTA 算法,采用优胜者全选方式,选取对应匹配代价最小的视差作为最终的视差。

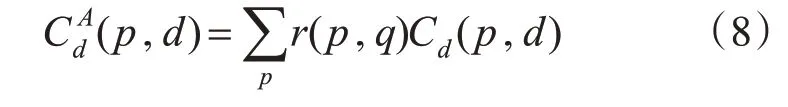

为了减少视差选取过程中引起的视差不连续性,运用了一种基于式(9)二次多项式插值的亚像素估计算法。由于采用WAT 算法选取的视差都为整数,是离散的,导致视差图不连续。为了消除这种影响,本文使用二次多项式逼近三个离散视差候选点之间的视差:d、d_ 和d+ 。d是WTA 算法所选取的视差值,d_=d-1,d+=d+1。

亚像素视差增强采用二次多项式插值。经过亚像素细化将基于改进的CENSUS 变换的算法得到的视差图进行了连续化以及精细化。

4 实验结果与分析

本文在操作系统为Windows10、CPU 为酷睿i5、处理器为2.20GHz,系统内存为8G 的普通PC上,运用VS2017配合OpenCV视觉库实现了立体匹配算法。

4.1 标准图像实验结果

为了验证算法的有效性,本文设置了三组对比实验,采用Middlebury 网站的立体匹配算法评价方法进行测评。采用网站提供的Teddy,Tsukuba以及cones 三对图像进行对比实验,在VS2017 中进行改进的CENSUS 变换与最小生成树结合的立体匹配算法进行实验。图4(a)为三幅图像的左视图,(b)为三对图像的真实视差图,(c)为基于颜色与梯度融合结合高通滤波器算法(GRD+GF)效果图,(d)为最小生成树算法(MST)效果图,(e)为传统CENSUS 变换结合最小生成树算法(CEN+MST)的效果图,(f)为本文算法效果图。

图4 Middlebury网站图像在不同算法下的视差图

由图4 可以看出,本文所提算法在深度不连续的区域以及弱纹理、重复纹理区域均能得到较好的匹配结果,在遮挡处的匹配率也较高,本文算法在视觉效果上效果更好。

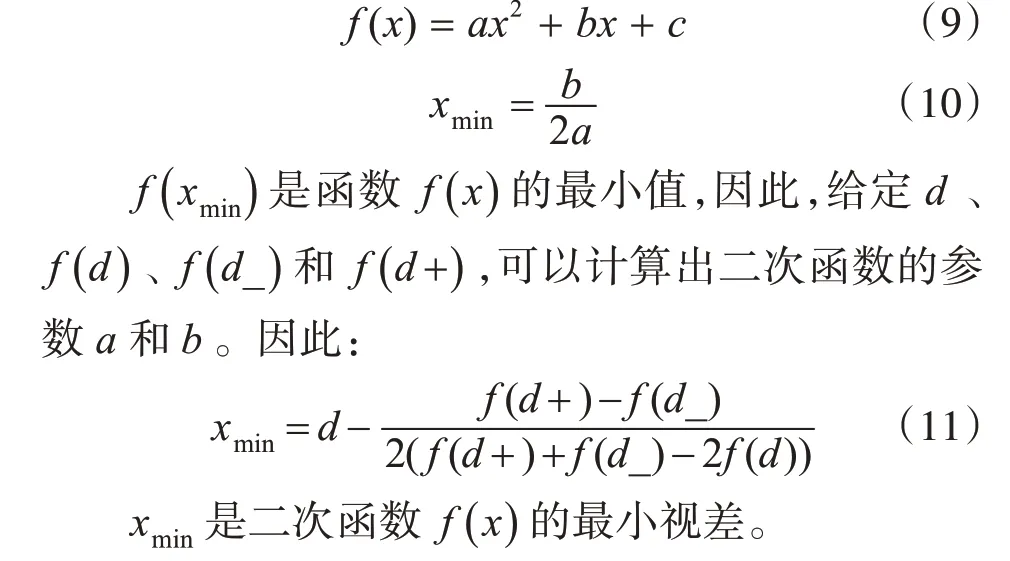

图像匹配质量的好坏采用误差匹配率以及平均误差率进行定量分析,表1 表示非遮挡区域(non)、深度不连续区域(dis)和全部区域(all)的误匹配率。

从表1 数据可知,GRD+GF 算法的平均误差率为8.16%,MST 算法的平均误差率为7.66%,CEN+MST 算法的平均误差率为6.69%,本文算法的平均误差率为6.02%,通过分析可以看出本文算法较GRD+GF 算法、MST 算法和CEN+MST 算法平均误差率分别降低了2.08 个百分点、1.64 个百分点和0.67个百分点。虽然本文算法在处理Teddy图像时误差率增高,但是从整体看,误差匹配率在四种方 法中是最低的。

表1 Middlebury网站图像视差图评价结果(单位:%)

4.2 AUV双目图像实验

4.2.1 图像采集

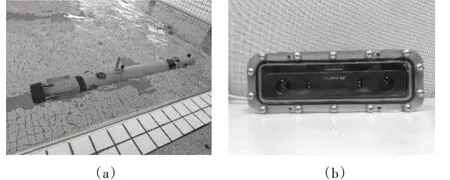

在AUV 前端装载双目摄像机视觉传感器,以实现AUV 前景视场的三维重建。为了验证算法的有效性,在游泳池进行了图像采集实验,图5(a)为在游泳池运行AUV采集2560*720分辨率水下双目图像的实验图,(b)为装载在AUV 前端经过防水密封处理的双目摄像机实物图。表2 为实验所用双目摄像机参数。

图5 泳池实验图

表2 双目摄像机参数

4.2.2 立体匹配算法实验

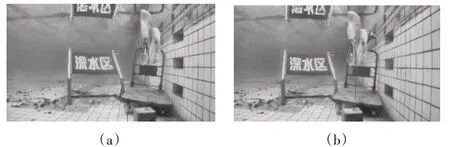

采用上小节拍摄得到的双目图像进行立体匹配算法实验与分析。图6 为经过图像预处理后的2560*720 分辨率的双目水底图像,(a)为左图,(b)为右图。

图6 预处理后双目图像

在VS2017 中对双目图像运行改进的CENSUS变换与最小生成树结合的立体匹配算法进行实验。

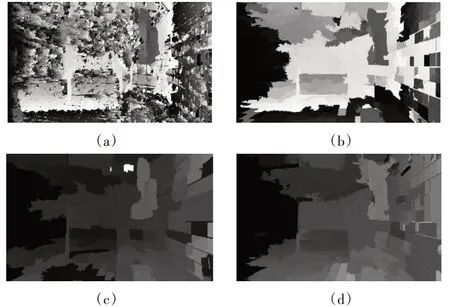

图7 为真实水下图片进行处理后得到的视差图,(a)为GRD+GF 算法效果图,(b)为MST 算法效果图,(c)为CEN+MST 算法效果图(d)为本文算法所运行得到的效果图,由图7 可以看出在真实图片下,无纹理区域以及重复纹理较多的情况下,前两种传统的立体匹配算法无法得到有效的视差图,MST 算法得到的视差图有空洞,不连续,在弱纹理区域精度较差,而本文算法下的视差图中视差连续,在弱纹理区域得到较好结果,有利于后续深度图的计算以及三维重建。视差图中背景部分黑色是因为摄像头有120°视角,导致左图中一部分在右图中无法找到对应点,所以置为最大值。

图7 真实场景图像不同立体匹配算法结果对比

5 结语

前景视场三维重建作为AUV 回收对接中的重要一环,能够提高末端导航定位的精度。本文针对AUV 自主回收对接水下环境,对水下三维重建中的立体匹配步骤进行了研究。采用改进的CENSUS 变换与最小生成树相结合的立体匹配算法对双目图像进行立体匹配,该算法以图像的梯度强度及颜色信息融合作为CENSUS 变换的依据计算匹配代价,解决水下图像弱纹理以及重复纹理较多的问题,结合最小生成树匹配代价聚合算法得到视差图,算法运算量小,运行速度快,效率高。最后运用VS2017 软件对Middlebury 标准图像集进行立体匹配实验,相较于GRD+GF 算法、MST 算法和CEN+MST 算法平均误差率分别降低了2.08 个百分点、1.64个百分点和0.67个百分点,同时还在真实水下双目图像上验证了本文算法针对水下图像弱纹理区域以及重复纹理区域较多问题的有效性。下一步将在本文立体匹配结果基础上实现AUV 前景视场的三维重建。