基于v-SVR的无参考3D点云质量评估模型

刘雨鑫 杨环 苏洪磊 刘祺 陈添鑫 龙春意

摘要:

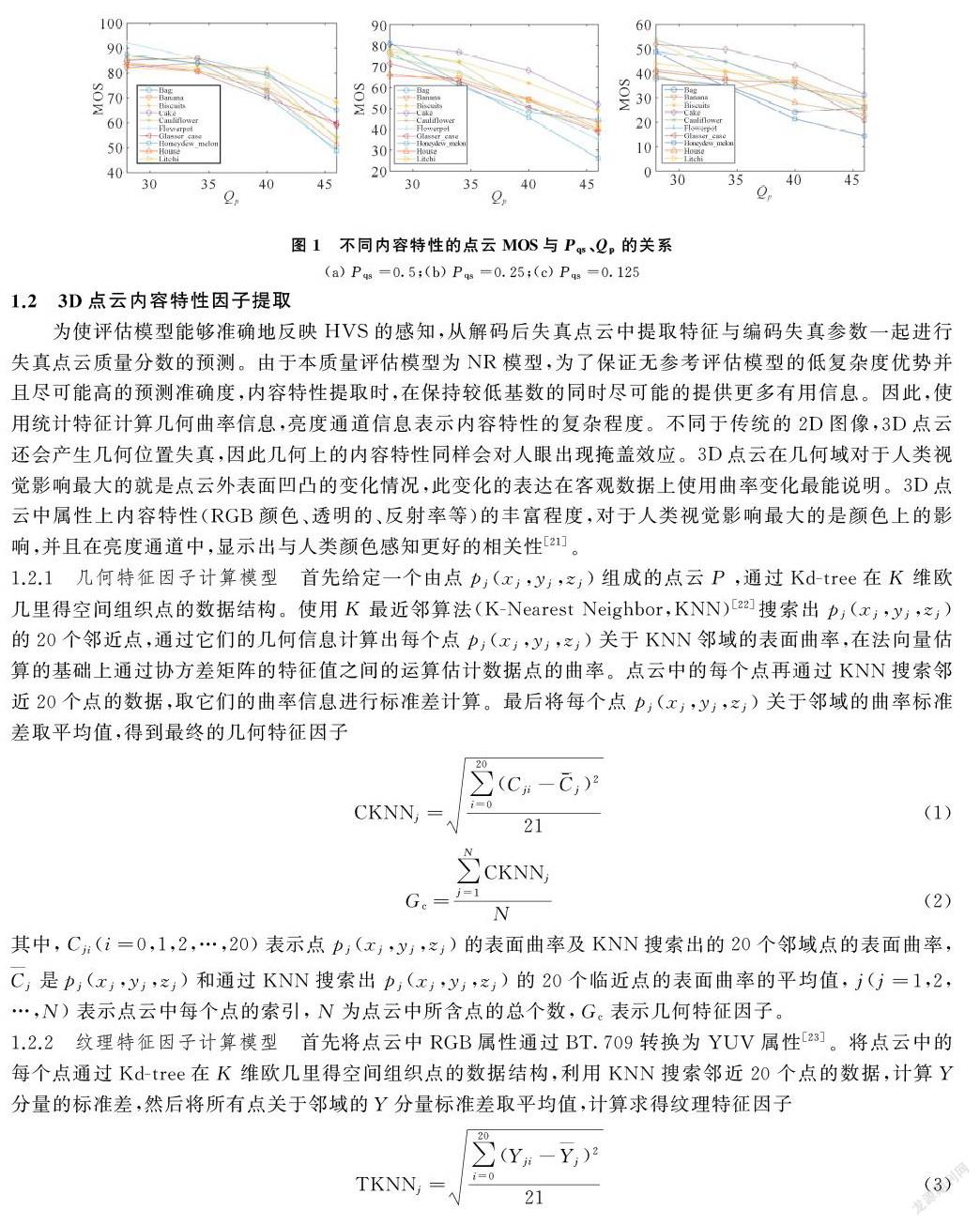

为了实现对3D点云质量有效监控,提出一种基于v-SVR的无参考3D点云质量评估模型。首先,分析失真点云编码相关参数与主观质量之间的关系,确定编码设置对主观质量的影响。其次,分析相同编码设置下不同内容特性对主观质量的影响,并提出了一个能够估计表征点云内容特性的几何特性因子和纹理特性因子的模型。最后,将量化参数、位置量化尺度、纹理特征因子、几何特征因子作为v-SVR的输入参数,主观质量分数作为输出参数,训练并得出一个反映人眼视觉特性的无参考3D点云质量评估模型。实验结果表明,与其他典型点云质量评估模型(Pointssim、PSNR-Y、PCMrr)相比,本文模型得到客观质量分数与主观质量分数的皮尔森相关系数分别提高了03265、01855、01748,均方根误差分别下降了63174、38350、36050。

关键词:

点云质量评估(PCQA);基于几何的点云压缩(G-PCC);无参考;3D点云;支持向量回归(SVR)

中图分类号:TN919.8

文献标志码:A

收稿日期:2020-12-29

基金项目:

山东省重点研发计划(批准号:2019GGX101021)资助;山东省自然科学基金(批准号:ZR2018PF002)资助。

通信作者:

杨环,女,博士,副教授,主要研究方向为图像/视频处理与分析、视觉感知建模及质量评估、机器学习等。E-mail:cathy_yanghuan@hotmail.com。

3D点云是由分散在三维空间中大量非结构化的三维点组成,这些点不仅具有几何信息,还具有相应属性(RGB颜色,表面法向量,不透明度,反射率等)。目前,随着沉浸式媒体通讯的迅速发展,日常生活中出现了越来越多的3D点云应用,如沉浸式通话、智能购物、数字博物馆等。但是,一个典型的高质量点云需要数百万甚至数十亿个点,不仅存储不便,也难以实现实时传输。因此国际标准动态图像专家组(Moving Picture Experts Group, MPEG)提出多种3D点云压缩(Point Cloud Compression,PCC)技术[1],其中对于动态点云压缩通常使用基于视频的点云压缩(Video-based Point Cloud Compression,V-PCC),静态点云压缩通常使用基于几何的点云压缩(Geometry-based Point Cloud Compression,G-PCC)。在G-PCC中几何编码方式分为八叉树(Octree)方式和Trisoup方式,属性编码方式分为区域自适应分层变换( Region Adaptive Hierarchical Transform,RAHT)、基于插值的层次最近邻预测(Predicting Transform,PT)、带有更新和提升步骤的基于插值的层次最近邻预测(Lifting Transform,LT)。G-PCC提供了高编码性能,超越了许多编码方法,成为目前最流行的3D点云压缩方法之一。根据不同的应用场景终端及传输带宽,在编码过程中对3D点云进行不同程度的压缩,会造成3D点云质量的下降,最终影响用户的视觉体验。人眼主观评测是视觉体验的最真实反映,但主观评测耗时耗力且不能实现实时评测及反馈,为了更好地衡量压缩后点云的质量,需开发3D点云质量客观评价模型来模拟人类视觉系统(Human Visual System,HVS)感知机制并进行建模,进而给出量化指标。3D点云客观质量不仅可以作为对比不同点云压缩算法性能的指标,还可以作为压缩算法参数调整的依据,动态调整3D点云压缩的视觉效果,以达到评估和优化的目的。在3D点云客观质量评估中,根据对原始点云信息的利用将质量评估模型分为三类:全参考(Full Reference, FR)、部分参考(Reduced Reference,RR)、无参考(No Reference,NR)。FR模型是3D点云质量评估中现有最多的模型,可以利用来自整个原始点云的信息来估计失真。FR模型主要分为基于点的[2-11]、基于投影的[12-15]以及基于图的[16]质量评估模型。其中,基于点的FR模型中,文献[2]认为访问几何分布取决于欧氏距离或沿法向量的投影误差;文献[3]认为使用颜色直方图和相关图来评估一个失真点云相对于参考点云的损失,以获得一个点云质量评估(Point Cloud Quality Assessment,PCQA)指标。文献[6]提出通过计算局部表面近似相似度来预测几何形变,提出了角相似度度量。文献[7-8]提出了基于颜色分量的点对点PSNR (Peak signal-to-noise Ratio, PSNR-Y)来评价彩色点云的纹理失真。这个度量是PSNR在三维空间的扩展,因此也继承了PSNR评价2D图像的缺点。Alexiou等[9-11]利用相似度[17]的思想分别提出了三种度量指标,其度量准确性在图像质量评价领域得到了证明。从参考点云和失真点云中分别提取几何特征、法线特征、曲率特征和颜色特征,然后評估几何特征和颜色特征的相似性,获得客观评分。除了这些基于点的模型外,还有基于投影的模型,基于投影的PSNR (Peak signal-to-noise Ratio, PSNRp),基于投影的结构相似性(Structual Similarity, SSIMp),基于投影的多尺度结构相似性(Multi-scale Structual Similarity, MS-SSIMp)和基于投影的像素域视觉信息保真度( Visual Information Fidelity Pixel-based, VIFPp) [12-15]。当无法获取原始点云时,使用RR和NR模型评估点云质量更有优势。RR模型利用原始点云提取特征参数作为边带信息传输到解码端,在解码端提取失真点云中的特征参数与原始点云的特征参数进行运算得到失真点云的质量。Viola等[18]提出了一个RR度量,其从给定的参考点云中提取基于几何、基于亮度和基于法线的特征。这些特征作为边带信息随点云信息一起传输,并在接收端与失真点云中提取的特征进行计算,以评估其失真点云的感知质量,并通过线性优化算法找到所提出特征的最佳组合。因为RR模型需要边带信息和完全解码,所以要想实现对网络节点中大规模点云码流质量的实时监控,NR模型成为最佳选择。NR模型不需要原始点云信息的依赖,只需要对编码比特流进行解析及重构点云即可计算失真点云的质量分数。此外,无参考质量评估具有传输数据少、高实时性、计算复杂度低的优点,可以应用于任何3D点云业务相关领域,具有普适性。目前所知道针对点云提出的NR模型只有文献[19],提出基于比特率和观测距离估计质量等级的模型,但并未考虑HVS。本文结合v-SVR提出一种NR模型,考虑HVS在主观实验时产生的空间掩盖效应,即分析相同编码情况下不同内容特性点云的MOS,确定点云纹理和几何内容特性对MOS的影响,并提出分别能够表示点云几何和纹理内容特性的几何特征因子、属性特征因子。在解码端通过解析比特流中的信息和提取重构点云中的特征作为输入变量,点云质量分数作为输出变量,采用v-SVR进行训练,得到一个能够反映人类视觉特性的无参考3D点云质量评估模型,该模型适用于G-PCC编码的无参考3D点云质量评估并能够准确预测“Octree-LT”编码失真的3D点云质量分数,可以准确得到符合人眼视觉系统的客观质量分数,使得客观质量分数与主观视觉效果具有更好的一致性。

3 主观实验

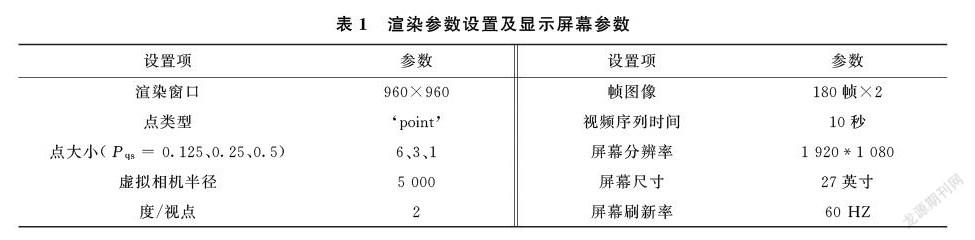

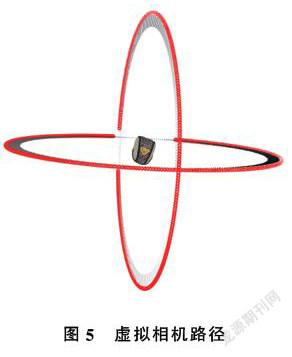

本文选择WPC[15]中20个点云进行G-PCC(Octree-LT,版本V.11)压缩,属性上量化参数选取28、34、40、46,几何上位置量化尺度选取0125、025、05,其余編码参数为缺省值。将解码后得到240个失真点云和20个原始点云使用Pccrenderer (版本V.5)[26]进行渲染,渲染所用的参数设置如表1所示。其中,渲染时将点云的几何中心作为圆的中心,选择水平圆和垂直圆作为虚拟相机路径(如图5所示),连续在这些圆上产生视点,将每个失真点云和原始点云水平的连接生成一个视频序列展示。

主观测试基于BT-50013标准[27]。共30人参与测试,所有测试人员的视力正常或矫正视力正常。为了使测试者在正式测试前了解点云的各种失真情况,在训练环节中向测试者展示了12个不同点云不同编码参数的失真点云。正式测试时每人进行240个失真点云打分,每个测试者的整个测试时间约为1小时20分钟,为防止测试人员长时间看屏幕导致视觉疲劳,测试分为3节,设置每展示80个点云后休息5分钟。最终每个点云对应着30个主观评分,所以一共得到 7 200个主观分数。

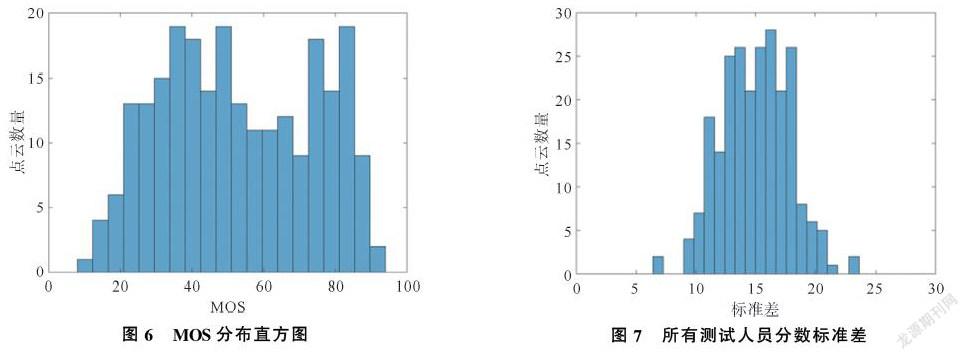

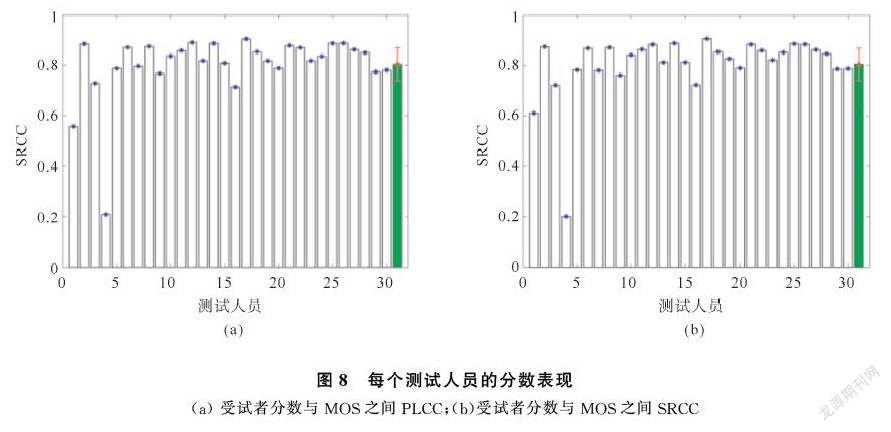

测试结束后将主观分数转化为Z-scores,采用离群值去除方案检测是否有离群值[24]。再将Z-scores线性缩放调整到范围 [0,100]。每个失真点云的MOS通过所有有效的并且已经缩放调整的Z-scores进行平均值计算得到。MOS分布的直方图如图6所示,可知失真点云质量分数分布范围很广。图7所示为所有测试人员对每个失真点云打出分数的标准差,可知标准差较小,说明整体测试人员表现较好。通过计算每个测试人员的分数与MOS之间的皮尔森线性相关系数 (Pearson Linear Correlation Coefficient,PLCC)和斯皮尔曼秩相关系数(Spearman Rank-order Correlation Coefficient,SRCC)来估计个体受试者的表现,在图8中展示计算结果。每个受试者与MOS之间的PLCC和SRCC的平均值分别高达0829 6、0827 6,表明大部分个体之间的表现基本一致。

4 实验结果分析

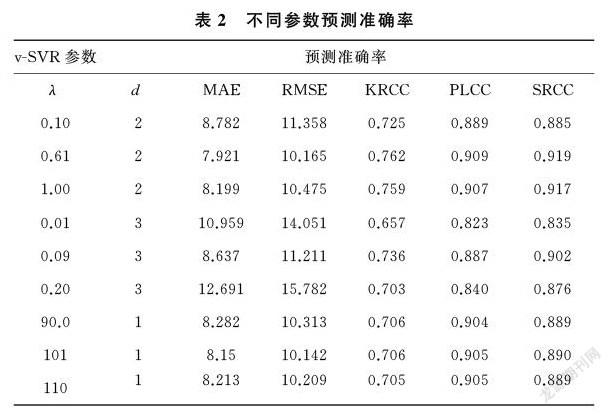

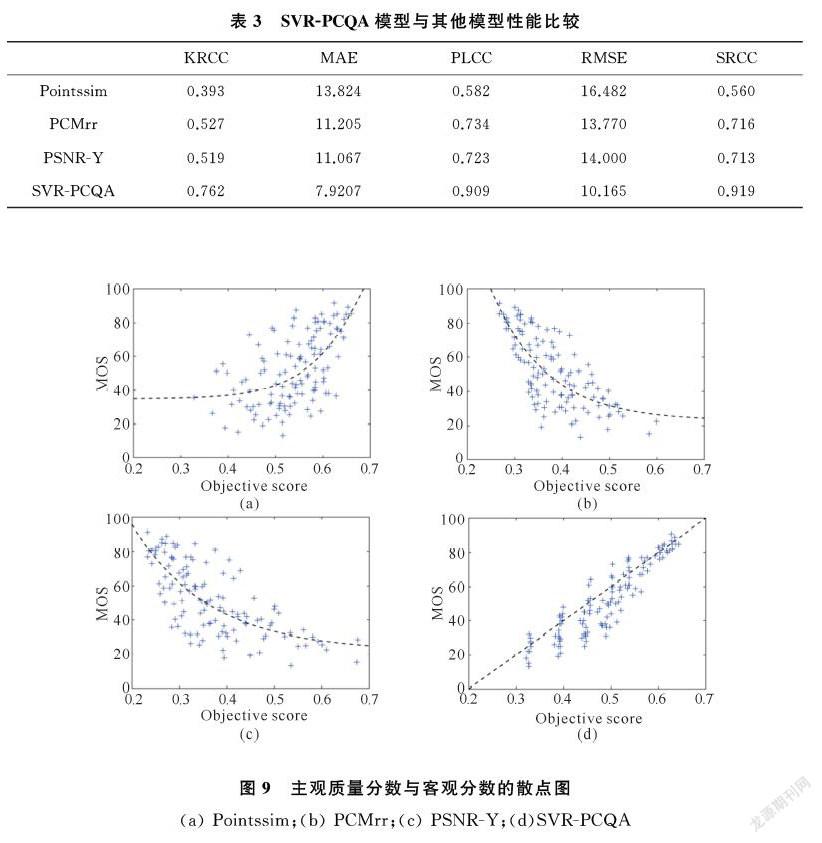

本文软件系统的回归算法主要在台湾大学开发的Mtlab版LIBSVM工具箱的基础上[28]使用v-SVR对点云的质量分数进行回归预测实验。选取WPC中不同内容特性的点云(Bag、Banana、Biscuits、Cake、Cauliflower、Flowerpot、Glasses_case、Honeydew_melon、House、Litchi)作为训练集点云,选择不同内容特性的点云(Mushroom、Pen_container、Pineapple、Ping-pong_bat、Puer_tea、Pumpkin、Ship、Statue、Stone、Tool_box)作为测试集点云。编码选取G-PCC(Octree-LT),量化参数选取28、34、40、46,位置量化尺度选取0125、025、05,其余编码参数为缺省值。将点云训练集数据放入LIBSVM中选用v-SVR进行模型训练,核函数使用多项式核函数。由于核函数参数(λ,d,γ)选取不合适会导致过拟合或者欠拟合现象,所以核参数选择很大程度上关系到整个回归预测结果的精度。由于λ,d影响较大,分别选取不同λ,d的值训练模型而将其他参数设置为默认值,通过比较训练出的模型在测试样本上的表现来选择最佳参数组合。表2给出了使用不同参数组合方式进行模型训练的结果,经过对比选取出最优参数组合(λ=061,d=2,γ=0)。其中λ,d,γ分别对应LIBSVM中的参数(gamma=061,degree=2,coef0=0)。预测准确率使用客观质量分数与主观质量分数之间的均方根误差 ( Root Mean Squard Error,RMSE )、平均绝对误差 (Mean Absolute Error ,MAE )、皮尔森线性相关系数(Pearson Linear Correlation Coefficient,PLCC)、肯德尔等级相关系数(Kendall rank-order correlation coefficient,KRCC)、斯皮尔曼秩相关系数(Spearman Rank-order Correlation Coefficient,SRCC )来表现。其中RMSE和MAE是反映预测值与被预测值之间差异程度的一种度量,表示客观质量分数与主观质量分数之间的差异程度。PLCC描述客观质量分数和主观质量分数之间的线性相关性,KRCC是用来测量两组数据之间的相关性的统计值。PLCC、KRCC的绝对值越大,相关性越强。SRCC 是度量两个组数据之间单调关系强弱的相关系数,如果一个变量是另外一个变量的严格单调函数,则系数为1或-1,表示完全相关(强相关)。表3所示为全参考模型Pointssim[9]、PSNR-Y [8]和部分参考模型PCMrr[18]与本文的模型性能参数比较。可知,SVR-PCQA相比其他模型具有更高的PLCC、SRCC、KRCC,相比其他模型具有更好的预测单调性和相关性;SVR-PCQA所得的RMSE、MAE相比其他模型小,说明SVR-PCQA具有更高的预测精准度。图9给出了主观质量分数分别与4种模型所得的客观分数的散点图,通过比较图中(a)、(b)、(c)、(d),可知本文模型具有更高的预测精准度。

5 结论

本文提出了一种适用于G-PCC(Octree-LT)编码且基于v-SVR的无参考3D点云质量评估模型。通过分析量化参数和位置量化尺度对点云失真的影响,建立模型基本关系。考虑点云的内容特性对于人类视觉评估点云质量时产生的空间掩盖效应,分析几何特性和纹理特性同样是影响点云质量的重要因素,并提出表示点云几何特性和纹理特性的几何特性因子和纹理特性因子。通过比特流的包头解析得到量化参数和位置量化尺度,对于解码端的失真点云进行特征提取得到几何特征因子和纹理特征因子,并利用上述信息结合v-SVR进而建立一个符合人类视觉的无参考3D点云质量评估模型。实验结果表明,本文模型所得客观质量分数与MOS有较好的一致性。

參考文献

[1]SCHWARZ S, PREDA M, BARONCINI V, et al. Emerging MPEG standards for point cloud compression[J]. IEEE Journal on Emerging and Selected Topics in Circuits and Systems, 2018, 9(1): 133-148.

[2]TIAN D, OCHIMIZU H, FENG C, et al. Geometric distortion metrics for point cloud compression[C]//2017 IEEE International Conference on Image Processing (ICIP), Beijing, 2017: 3460-3464.

[3]VIOLA I, SUBRAMANYAM S, CESAR P. A color-based objective quality metric for point cloud contents[C]//12th International Conference on Quality of Multimedia Experience (QoMEX 2020), Athlone, 2020.

[4]TIAN D, OCHIMIZU H, FENG C, et al. Evaluation metrics for point cloud compression[J]. ISO/IEC MPEG2016 M, 2017, 39316.

[5]TIAN D, OCHIMIZU H, FENG C, et al. Updates and integration of evaluation metric software for PCC[J]. ISO/IEC JTC1/SC29/WG11 MPEG2017 M, 2017, 40522.

[6]ALEXIOU E, EBRAHIMI T. Point cloud quality assessment metric based on angular similarity[C]//2018 IEEE International Conference on Multimedia and Expo (ICME), San Diego, 2018: 1-6.

[7]MEKURIA R, BLOM K, CESAR P. Design, implementation, and evaluation of a point cloud codec for tele-immersive video[J]. IEEE Transactions on Circuits and Systems for Video Technology, 2016, 27(4): 828-842.

[8]MEKURIA R N, LI Z, TULVAN C, et al. Evaluation criteria for PCC (point cloud compression)[J]. ISO/IEC JTC1/SC29/WG11 MPEG,N16332, 2016.

[9]ALEXIOU E, EBRAHIMI T. Towards a point cloud structural similarity metric[C]//2020 IEEE International Conference on Multimedia & Expo Workshops (ICMEW), London, 2020: 1-6.

[10] MEYNET G, NEHME Y, DIGNE J, et al. PCQM: A Full-Reference Quality Metric for Colored 3D point Clouds[C]//12th International Conference on Quality of Multimedia Experience (QoMEX 2020), Athlone, 2020.

[11] HUA L, YU M, JIANG G, et al. VQA-CPC: a novel visual quality assessment metric of color point clouds[C]//Optoelectronic Imaging and Multimedia Technology VII. International Society for Optics and Photonics, 2020, 11550: 1155012.

[12] TORLIG E M, ALEXIOU E, FONSECA T A, et al. A novel methodology for quality assessment of voxelized point clouds[C]//Applications of Digital Image Processing XLI. International Society for Optics and Photonics, 2018, 10752: 107520I.

[13] ALEXIOU E, EBRAHIMI T. Exploiting user interactivity in quality assessment of point cloud imaging[C]//2019 Eleventh International Conference on Quality of Multimedia Experience (QoMEX), Berlin, 2019: 1-6.

[14] ALEXIOU E, VIOLA I, BORGES T M, et al. A comprehensive study of the rate-distortion performance in MPEG point cloud compression[J]. APSIPA Transactions on Signal and Information Processing, 2019, 8:e27.

[15] SU H, DUANMU Z, LIU W, et al. Perceptual quality assessment of 3D point clouds[C]//2019 IEEE International Conference on Image Processing (ICIP), Taiwan, 2019: 3182-3186.

[16] YANG Q, MA Z, XU Y, et al. Inferring point cloud quality via graph similarity[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2020,doi:10.1109/TPAMI.2020.3047083.

[17] WANG Z, BOVIK A C, SHEIKH H R, et al. Image quality assessment: From error visibility to structural similarity[J]. IEEE transactions on image processing, 2004, 13(4): 600-612.

[18] VIOLA I, CESAR P. A reduced reference metric for visual quality evaluation of point cloud contents[J]. IEEE Signal Processing Letters, 2020, 27: 1660-1664.

[19] CAO K, XU Y, COSMAN P. Visual quality of compressed mesh and point cloud sequences[J]. IEEE Access, 2020, 8: 171203-171217.

[20] 蘇洪磊. 基于码流的网络视频无参考质量评估研究[D]. 西安:西安电子科技大学, 2014.

[21] WINKLER S, KUNT M, VAN DEN BRANDEN LAMBRECHT C J. Vision and video: Models and applications[M]. Springer, Boston, MA, 2001.

[22] RUSU R B, COUSINS S. 3D is here: Point cloud library (PCL)[C]//2011 IEEE international conference on robotics and automation, Shanghai, 2011: 1-4.

[23] ITU I. Parameter values for the hdtv standards for production and international programme exchange[J]. Recommendation ITU-R BT, 2002: 709-5.

[24] CORTES C, VAPNIK V. Support-vector networks[J]. Machine Learning, 1995, 20(3): 273-297.

[25] HSU C W, CHANG C C, LIN C J. A practical guide to support vector classification[J].[2020-11-12] http://www. csie. ntu. edu. tw/~ cjlin/papers/guide/guide. pdf.

[26] GUEDE C, RICARD J, LASSERRE S, et al. Technicolor point cloud renderer[J]. ISO/IEC JTC1/SC29/WG11 MPEG, M40229, 2017:18.

[27] SERIES B T. Methodology for the subjective assessment of the quality of television pictures[J]. Recommendation ITU-R BT, 2012: 500-13.

[28] CHANG C C. LIBSVM: a library for support vector machines[J]. ACM Transactions on Intelligent Systems and Technology (TIST), 2011, 2(3): 1-27.

Abstract:

In order to effectively monitor the quality of 3D point clouds, a no-reference quality assessment model of 3D point clouds based on v-SVR is proposed. Firstly, the relationship between encoding parameters from the distorted point cloud and the subjective quality is analysed. Then the impact of the encoding settings on the subjective quality can be obtained. Secondly, the impact of content characteristic on the subjective quality can be determined under the same encoding settings. Then two models to estimate the geometric and textural characteristic factors respectively is proposed, both of which can characterize the point cloud content. Finally, quantization parameters, location quantization scales, texture feature factors, and geometric feature factors as the input parameters of v-SVR and the subjective quality scores as the output parameters. As a result, a no-reference quality assessment model of 3D point clouds is got which can reflect human visual characteristics. Experimental results show that compared with other typical point cloud quality evaluation models, Pointssim, PSNR-Y and PCMrr, the Pearson Correlation Coefficient of the proposed model is increased by 03265, 01855 and 01748 respectively, and the Root Mean Square Error is decreased by 63174, 38350, and 36050 respectively.

Keywords:

Point cloud quality assessment; G-PCC; No-reference; 3D point cloud; SVR