深空探测车环境感知与导航定位技术进展与展望

邸凯昌,王 镓,邢 琰,刘召芹,万文辉,彭 嫚,王晔昕,刘 斌,于天一,李立春,刘传凯

1. 中国科学院空天信息创新研究院遥感科学国家重点实验室,北京 100101; 2. 北京航天飞行控制中心,北京 100094; 3. 北京控制工程研究所,北京 100094

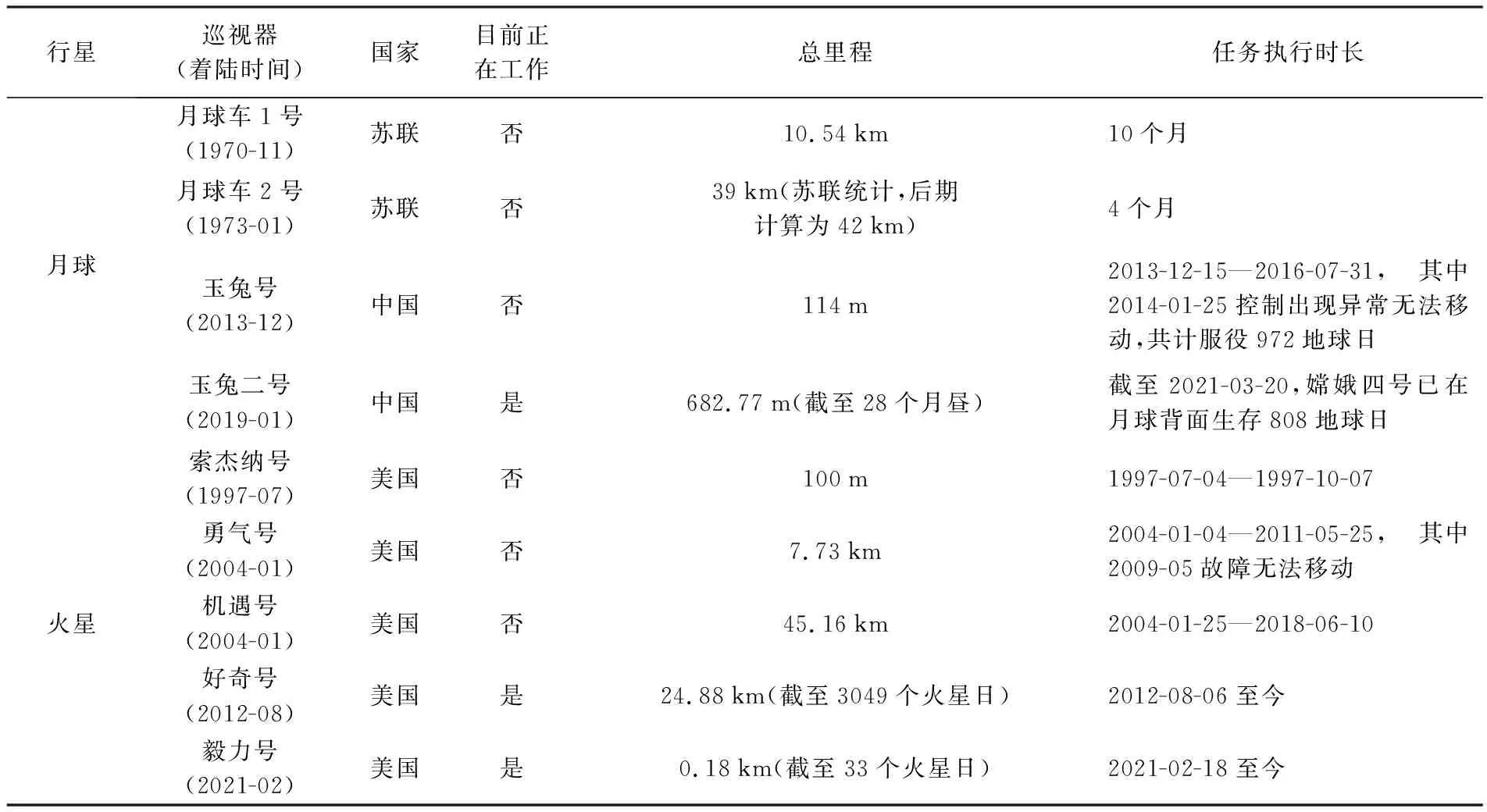

20世纪末至今,世界上主要的航天大国出于航天科技发展和国家战略的考虑,纷纷提出月球、火星、小行星和其他类地行星的探测计划并积极实施,掀起新一轮深空探测热潮[1-2]。相比于轨道器探测,着陆巡视探测能够对行星表面和次表层开展更高分辨率的原位探测,是开展类地行星表面探测和科学研究的重要手段。表1中列出了迄今为止国际国内成功执行的无人驾驶巡视器(探测车)的相关信息,巡视探测任务集中在月球和火星,目前正在工作的探测车包括我国的玉兔二号月球车、美国好奇号和毅力号火星车。我国的天问一号火星探测器已于2021年5月15日安全着陆。

在安全着陆以后,探测车巡视探测和科学研究的前提条件是安全移动,以及有效获取科学载荷数据,因此环境感知与导航定位是深空探测车自动驾驶的核心技术。历史上及目前的探测车行驶尚不能实现全自动的驾驶[2]。苏联的月球车1号和2号依靠地面遥操作方式实现巡视器的探测,具体方式为组建5人驾驶员团队,依靠巡视器携带不同摄像机拍摄并下传的影像完成估算和判断,通过飞控中心的远程控制系统直接“驾驶”月球车实现月面巡视探测(存在地月通讯延时),并无自主导航能力[3]。美国的Mars Exploration Rovers(MER)勇气号和机遇号采用遥操作及半自主的控制方式[4],长距离的行驶一般由盲行驶和自主行驶两种模式混合实现,即首先采用地面遥操作方式确定安全行驶路径进行盲行驶,然后开启自主行驶模式,利用导航和避障软件选择路径自主行驶较短的距离[5-6]。与MER类似,美国的好奇号火星车也采用遥操作及半自主的控制方式,提供3种行驶模式:盲行驶,避障加车轮打滑检查模式,避障加全程视觉测程模式[7]。我国嫦娥三号和嫦娥四号月面巡视探测任务中,月球车采用了遥操作及半自主的控制方式,地面飞控人员可以通过回传图像进行大范围地形重建、定位和探测目标选取;月球车可通过盲行驶、自主避障规划移动、激光探测避障移动和地面直接驱动等多种移动模式实现不同地形下的自主安全巡视,其中自主避障规划移动和激光探测避障移动模式能够自主进行环境感知和避障[8-9]。

深空探测车的自动驾驶与地球上汽车自动驾驶相比,在环境感知与导航定位中的导航基础设施及数据支持、传感器配置、计算机性能等多方面有明显的不同。汽车自动驾驶的环境(即路网)有高精度道路地图的支持和高精度GNSS定位的支持,环境感知普遍使用大量的传感器包括激光雷达、毫米波雷达、超声波雷达、相机等,车载计算机的性能很高。而深空探测车的行驶探测过程中,并没有现成的道路和高精度道路地图,更没有GNSS定位设施,受限于重量和功耗,所使用的环境感知传感器主要为相机,探测车的计算机性能较低。所有这些差异使得深空探测车环境感知与导航定位有其独特的挑战[2]。目前已成功运行的深空探测车有月球车和火星车(表1),其环境感知和导航定位核心技术和应用总体上相同,由于月球日与火星日时长的差别,以及月球和火星与地球通讯的时延不同,其具体应用模式略有不同;另外,火星表面形貌类型比月球表面丰富,环境感知中的地形分类研究针对火星较多、针对月球较少。

表1 成功执行的无人巡视器探测任务

1 深空探测车环境感知技术进展

深空探测车要安全有效地执行科学与工程任务,首先需要用其携带的传感器感知所在环境。探测车的环境感知主要包括三维地形重建和障碍识别。在火星巡视探测中,地形分类对于障碍识别和路径规划有很好的支撑作用,也是环境感知的重要组成部分。下面针对三维地形重建、障碍识别、地形分类分别展开论述,其中包括工程任务中应用的成熟技术以及一些近期的研究进展。

1.1 三维地形重建

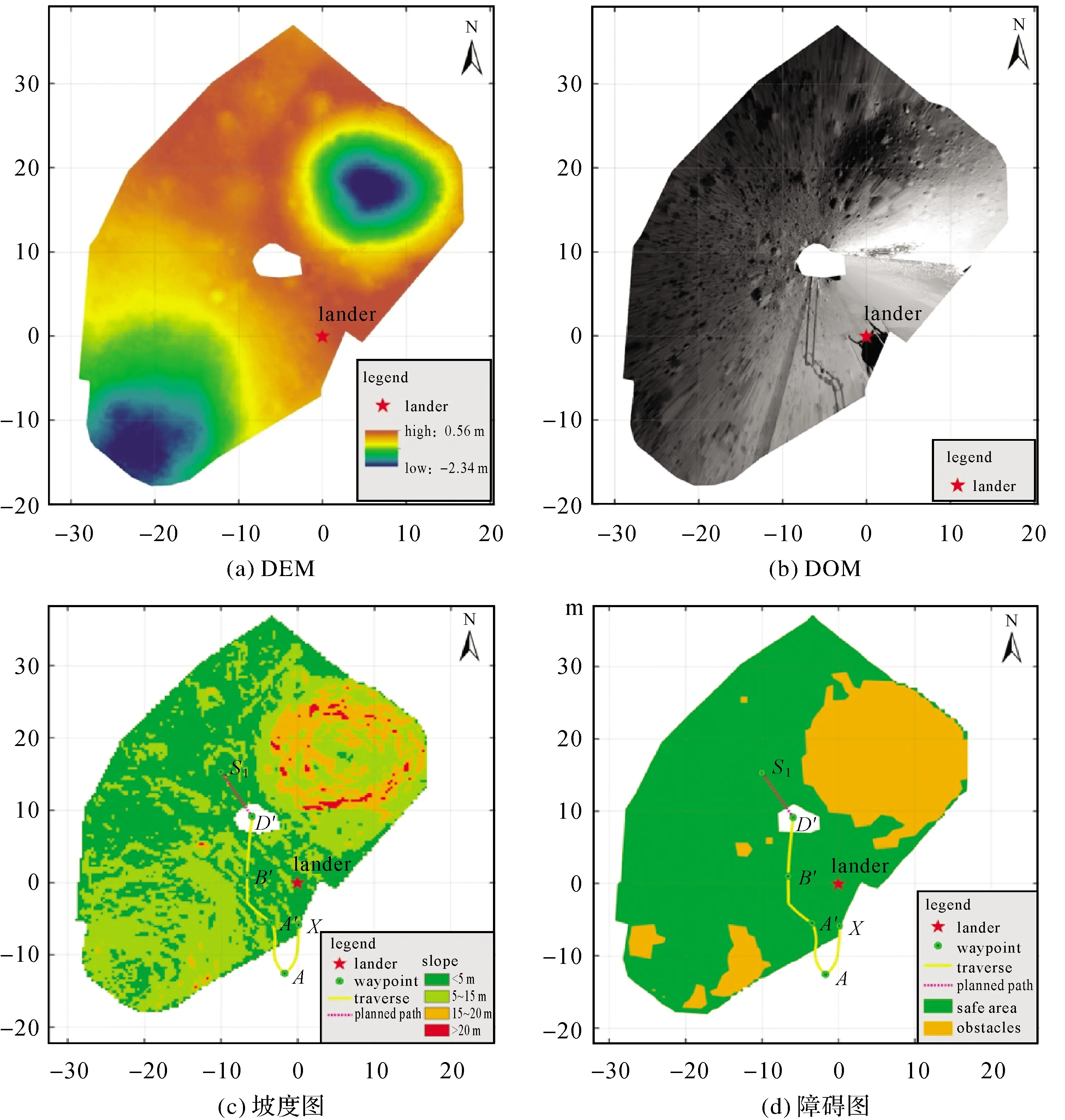

利用探测车获得的影像对着陆区和巡视区进行高精度的三维地形重建,可以获取着陆探测区域精细的形貌特征,为探测车的安全行驶提供最基础的地形三维信息。在MER火星车探测任务中,火星车所携带的导航、全景和避障立体相机提供了对火星表面环境及科学目标精细制图的能力。文献[10]对火星车立体相机的三维测图能力进行了理论分析,在MER任务执行过程中,自动生成了多种类型和规格的地形制图产品,如数字高程模型(DEM)、数字正射影像图(DOM)、坡度图、深度图、表面法向量图、表面粗糙度图等,这些图与火星车定位数据一起直接用于火星车的路径规划,也用于对探测区域和探测目标的科学研究[11-15]。文献[16]研究了面向地形测图的长基线立体视觉方法;文献[17]研究了火星车长基线测图的理论精度,并开发了长基线三维测图的方法。在嫦娥三号任务中,利用着陆器降落相机序列影像生成了着陆区高精度三维制图产品,分辨率高达0.05 m,为玉兔号月球车导航定位提供了比嫦娥二号DOM更精细的底图[18-19];在每一个停泊点,利用月球车导航相机获取的影像自动生成了DEM、DOM、坡度图等地形制图产品,用于支持月球车行驶路径规划[18]。在嫦娥四号任务中,利用玉兔二号月球车的导航相机和全景相机生成了标准化的厘米级分辨率的DEM、DOM和坡度图等产品,支持障碍识别和路径规划[20-21]。

三维地形重建的主要流程包括影像模型的构建和定向、立体匹配、点云生成和DEM内插。其中立体匹配是影响地形产品质量的关键。目前深空探测车地形重建中的立体匹配方法可分为基于特征的匹配和全局匹配。基于特征的匹配首先使用Förstner算子、SIFT算子、SURF算子等提取特征点,然后采用核线约束、从粗到精策略和三角网约束等匹配策略实现密集点匹配。MER任务中的MIPL(multimission image processing laboratory)负责MER图像数据的地面处理,其流水线中使用匹配的特征点作为种子点,结合金字塔影像使用双线性变换在种子点8邻域内扩散获得稠密匹配点,在此基础上生成了一系列地形产品[14,22]。文献[23]研究了不同特征的匹配算子在探测车制图和定位的性能。全局匹配方法是使用不同相似度函数(SSD、SAD、相关系数)计算区域的相似性,建立对应的能量函数,选择能量函数值最小时对应的匹配结果实现像素级的匹配。文献[24]提出了基于平面约束和自适应惩罚参数的半全局立体匹配方法,降低了传统方法的计算复杂度。针对深空探测影像纹理贫乏导致的匹配不确定性,文献[25]提出自适应马尔可夫随机场模型,在实现全局匹配的同时保留了视差不连续的区域特征,匹配精度优于SAD区域匹配法和传统的马尔可夫匹配法。

1.2 障碍识别

障碍识别是保证探测车安全行驶和完成任务的关键技术,深空探测车多使用立体相机影像及其派生产品进行障碍识别,主要包括基于三维信息的方法、基于单张影像的方法和结合二维三维信息的方法。

最基本的基于三维信息的方法是通过探测车立体影像生成的深度图或高程图进行障碍检测,在工程任务中广泛应用。文献[26]使用立体影像获得子像素的距离图,然后使用最小二乘拟合平面计算出坡度图,通过拟合平面中的离群点进行分组确定石块障碍。“玉兔二号”行驶过程中,导航相机在每个站点生成了0.02 m的DEM和DOM,在这些地形产品基础上生成了0.3 m的坡度图,综合考虑地形坡度、高程差和探测车的越障能力生成障碍图[20-21]。图1展示了玉兔二号导航相机在D′站点生成的DEM、DOM、坡度图和障碍图。

基于单张影像的方法主要通过基于边缘、区域或机器学习的方法进行障碍检测,其中石块检测得到了较多的研究。文献[27]对比了7种提取石块的方法,主要包含基于边缘检测、阴影和灰度信息、双目几何信息、基于窗口的Adaboost以及基于像素的SVM等方法。基于边缘的检测方法主要基于纹理和梯度等特征检测障碍,通过不同的边缘检测算子获得图像边缘,然后连接各边缘点获取轮廓线[28]。基于区域的方法主要通过K均值、二维类间方差、超像素分割、水平集等算法将障碍和背景进行区分。文献[29]利用K均值法将灰度影像进行分割,然后通过纹理和灰度进行分类,最终获取障碍图。文献[30]改进了传统二维最大类间方差法实现月面的障碍物识别,优化了搜索最大阈值的时间。超像素分割进行石块检测的方法首先结合影像分割得到的超像元区域,然后比较各个区域的特征值,最终通过阈值算法分割出石块[31-34]。文献[35]将区域信息和梯度信息引入到水平集中,通过能量函数的最小化求解提取石块。机器学习方面,文献[36]建立石块在不同光照条件下的级联模板,通过Adaboost对其进行训练构建级联分类器来快速识别石块[36]。近年的研究中,深度学习方法也被用来提取障碍,例如文献[37]使用卷积神经网络对类似火星车影像进行石块提取,通过对U-net卷积网络进行结构改进,提高了分割影像的速度并取得了较高的精度。

结合二维和三维的方法主要利用影像的灰度信息和三维的高程信息提取障碍。文献[38]首先使用从立体图像的三维点云来拟合可以提取坡度的平面,并使用单张图像根据熵信息提取岩石,然后从拟合的平面残差中得到石块的高度。文献[39]结合勇气号火星车导航相机获取的影像数据mean-shift分割结果和对应的深度点云数据对石块进行了提取。文献[21]提出一种结合单张影像和局部三维点云的障碍提取方法,结合三维点云反投得到的种子点和影像mean-shift分割结果,通过阈值比较得到障碍结果。

图1 玉兔二号导航相机在D′站点生成的地形产品[20]Fig.1 Map generated from Yutu-2 navcam images at waypoint D′[20]

1.3 地形分类

早期的深空探测车在制定行驶路径时,主要基于立体影像重建的三维地形进行可通行性及障碍分析形成代价图,并在此基础上进行路径规划,并未直接定量地考虑地形地貌类别对探测车行驶的影响。由于在探测过程中发现不同的地形对车轮滑移程度的影响不同,且有的地形地貌易造成车体沉陷,这些均会显著增加探测车的安全风险。近年来,面向路径规划的巡视器影像的地形分类开始引起重视并开展了不少研究。

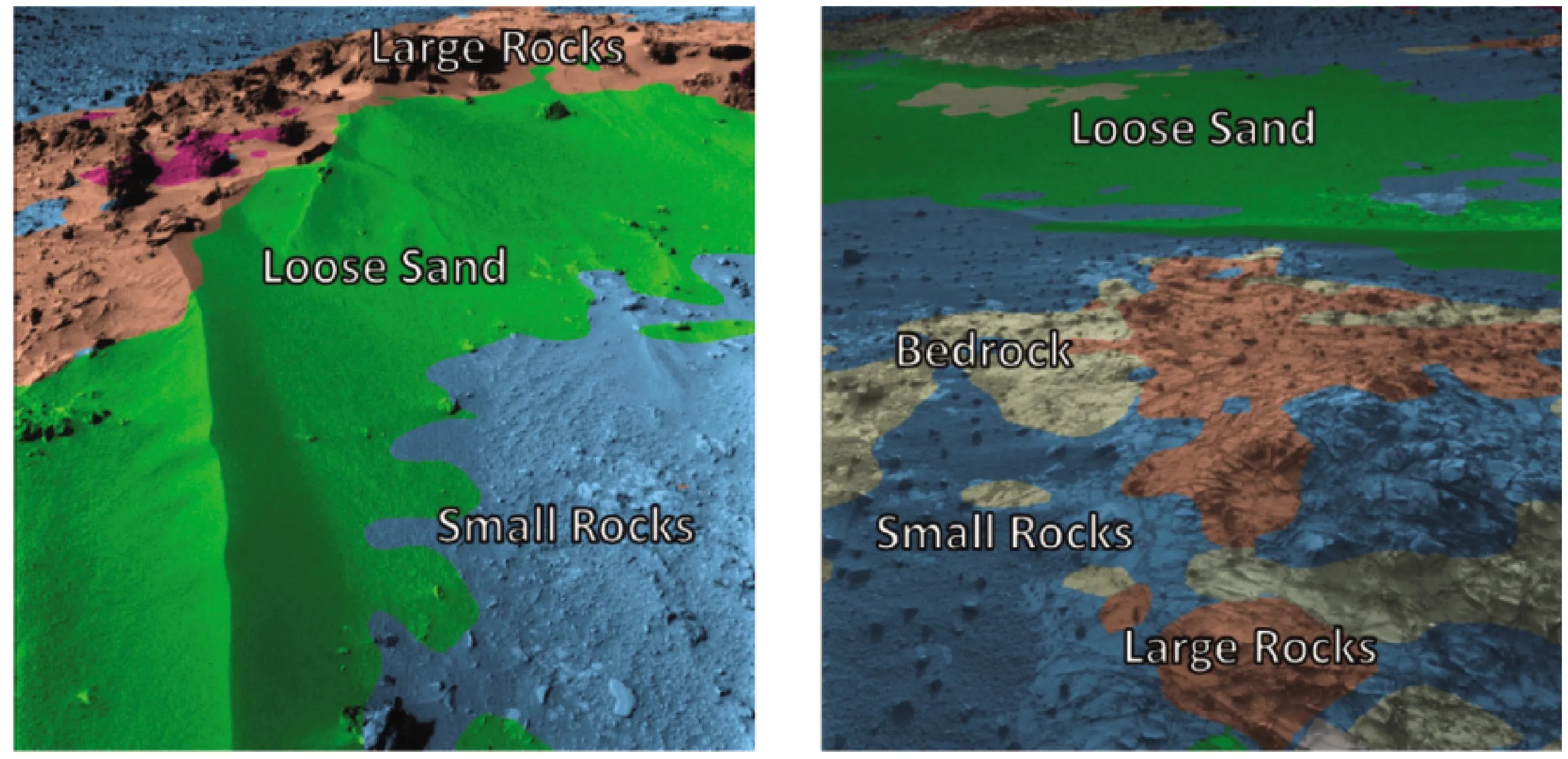

初期主要采用聚类和传统机器学习的方法[40],例如采用DEM数据进行无监督聚类的方法[41],自适应模糊粗糙特征结合SVM的方法[42],结合图像梯度和统计特征和随机森林的方法等[43-44]。深度学习方法则在近年的研究中被采用,如文献[45]利用全卷积网络对地形地貌进行分类,将分类结果用于决策路径规划,其中对于轨道器影像进行17类地形分类,对于火星车导航相机影像进行6种地形分类,其试验结果轨道器影像地形分类精度高,平均精度达90.2%,而导航相机影像地形分类精度差,平均精度不足55%。火星车影像地形分类结果如图2所示。该项技术中轨道器影像地形地貌分类参与可通过性分析的成果已应用于NASA的Mars2020的预选着陆区分析中[46]。文献[47]在之前研究基础上,又提出利用多个深度学习网络分别对火星车图像进行解译和可通过性分析,实现科学目标探测需求牵引的巡视器路径规划,目前这些技术处于研究测试阶段。

不同的地形地貌类型对于探测车行驶的潜在危险有所不同,车轮打滑和沉陷是两类研究较多的危险情况,另外,在行驶安全的情况下不同的地形对车轮的磨损也是不同的。车轮打滑和沉陷的研究分别通过传感器参数状态监测以及视觉方法来建立相应模型。文献[48]通过感知不同传感器的运行状态来检测车轮打滑,并提出基于边缘检测的车轮下陷估计算法。文献[49]对影像中轮腿混合移动系统区域进行颜色空间分割和形态学方法来计算巡视器的下陷程度。文献[50]通过动态非线性方法将图像转换至HSI空间提取车轮土壤边界,并通过离散数学模型计算不同地形条件下的车轮沉陷量。文献[51]将俯仰角、翻滚角以及上一步的滑移量作为输入,结合经典几何模型来计算巡视器的滑移量。文献[52]通过分析勇气号从Sol 154到Sol 737的滑移发现,滑移与坡度方向和幅度高度相关,并对4种不同地形滑移分析后发现基岩滑移量最小。文献[53]根据地层和其侵蚀形式利用HiRISE图像生成地貌图,并利用好奇号影像更新结果,遍历了其通行的整个路径来分析不同地貌对车轮的损害影响程度。上述研究是在地球上通过模型探测车研究和测试或工程数据后处理分析,尚未在深空探测车工程上实时化应用。

2 深空探测车视觉定位技术进展

深空探测任务中,探测车定位为导航避障规划提供位置信息,是开展表面巡视探测任务的基础,对任务的安全执行有着重要意义。深空环境没有GNSS等直接定位信号,因此需要依靠惯导、里程计及视觉相机等车载传感器通过自主定位为探测任务提供定位结果。随着行驶距离的增长,自主定位的误差累积不可避免,为降低定位累积误差对任务规划的影响,还需考虑引入轨道器影像或降落相机影像等其他视觉数据,通过集成处理修正探测车定位累积误差。

探测车定位分为绝对定位和相对定位,绝对定位是确定探测车在全局坐标系(星固坐标系)的位置,相对定位指确定探测车当前站点相对于上一个站点的位置。2.5节中探测车影像同轨道器影像集成的定位是绝对定位,其他方法从原理上讲都是相对定位。相对定位在局部坐标系中持续进行,一般将着陆点位置作为局部坐标系的坐标原点,也是相对定位的起点。根据着陆点定位的绝对位置,可以把相对定位结果转换成绝对定位结果[20,54]。

下面对站点视觉定位、在线视觉测程定位、探测车影像同轨道器影像集成的定位等工程任务中常用的视觉定位技术展开论述。航迹推算不属于视觉定位,但作为基础性的定位方法在工程任务常用;视觉与多传感器组合导航定位开展了较多研究,有很好的应用潜力,因此这两种方法也一并介绍。

2.1 航迹推算

航迹推算方法通过融合探测车车载惯性测量单元(IMU)和里程计数据,不断推估出探测车的位置姿态结果,具有不受外界环境影响、定位输出稳健性强的优点。定位过程中,惯导感知探测车姿态与速度的变化,输出平台角速度与加速度值,里程计则记录探测车行驶路径的长度数据。两类数据一般采用卡尔曼滤波进行融合,通过里程计的观测约束惯导陀螺和加速度长时间运行产生的位置漂移,输出稳健的定位结果。航迹推算方法是探测车巡视探测中的常规定位方法。但在松软土壤和崎岖地面区域行驶时,探测车车轮打滑严重,使用航迹推算方法定位误差显著增大。美国MER任务中,勇气号与机遇号探测车航迹推算精度为10%[55]。我国嫦娥任务玉兔号与玉兔二号航迹推算精度为行驶距离的15%[20,54]。为满足探测任务需要,还需采用视觉等其他定位手段获取探测车高精度位置姿态信息。

2.2 站点视觉定位

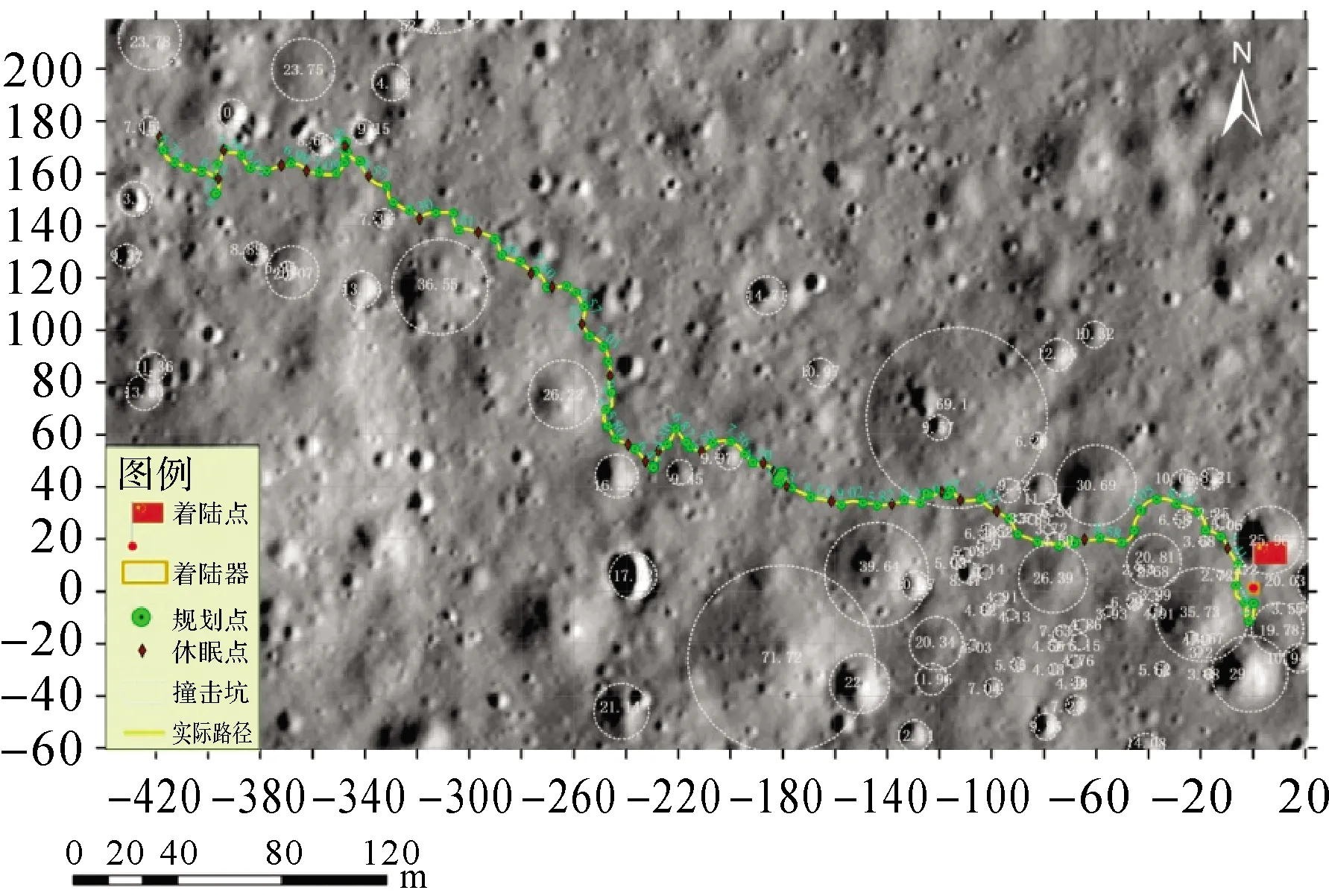

探测任务中,探测车一般在导航站点及探测站点利用车载立体相机获取多对立体影像。基于前后站点的立体影像,通过寻找站点图像间的同名点作为连接点,应用视觉定位方法解算当前站点影像相对上一站点影像的相对位置姿态参数,结合前一站点的位置信息即可计算输出当前站点的定位结果。该方法的定位结果不随时间而发生漂移,也不受地形条件影响,具有较好的自主性和较高的精度,已业务化应用于我国玉兔号和玉兔二号月球车定位,修正GNC航迹推算定位结果[20,54,56]。图3为玉兔二号月球车站点视觉定位结果(截至日期:2021-03-20)。

图2 好奇号火星车导航相机影像的地形分类结果[45]Fig.2 Examples of terrain classification results of two Curiosity navcam images[45]

图3 玉兔二号月球车前28月昼行驶路线Fig.3 Traverse map of Yutu-2 rover up to the 28th lunar days

站点视觉定位方法的核心是寻找相邻站点影像间的同名点。由于相邻站点间距离一般在10 m左右,相邻站点成像时间间隔大,站点图像在尺度、视角、光照条件等方面存在较大不同,需采用能较好克服图像尺度、形变及亮度变化的匹配方法。在嫦娥三号与四号巡视探测中,月球车在每个站点采用前向立体影像及回望立体影像进行视觉定位[57]。定位时,依据由航迹推算得到的探测车初始定位结果,大致提取前后站点影像的同名区域,通过图像缩放、变形等处理,使得相邻影像上同名区域尽可能在尺度、视角上一致。随后,采用Affine-SIFT[58]匹配方法寻找相邻站点影像的同名点。依据同名点结果,以前一站点影像位姿参数为真值,用光束法平差方法计算当前站点探测车的位置。

通过地面操作人员的评估,嫦娥任务中的站点视觉定位精度优于4%[20,54],相比航迹推算方法,可有效提升月球车的定位精度。然而,月球表面环境十分复杂,受光照影响部分相邻站点图像难以自动获取足够数量的同名点匹配结果,需通过少量人机交互操作完成定位。

在MER火星车任务中,文献[12]将探测车在停泊点获取的导航相机、全景相机影像通过特征点构建全局的影像区域网,采用光束法平差方法解求影像的最佳位置与姿态,实现探测车的高精度定位;考虑到探测车影像随时间而增多,开发了递增式光束法平差方法用于定位解算,使得对新加入影像的平差处理能够基于之前的平差结果,而不需要重新进行全局解算,大大减少了平差计算的复杂度与计算量[15]。

2.3 在线视觉测程定位

探测车在地形复杂区域的行驶时,通过获取探测车序列立体影像(相邻立体像对间距0.5 m或更短),经过车载计算机的在线视觉测程定位计算,可为探测车实时提供高精度的连续定位结果。美国MER、好奇号等任务中采用此方法用于探测车在部分有挑战性的路段(如上下坡时)的安全连续行驶。在MER任务中,约每3 min输出一帧立体影像定位结果用于探测车在线定位,速度和效率有待提高[59-61]。我国的天问一号火星车也采用了视觉测程定位技术,提高自主导航定位精度。

视觉测程定位方法首先对前后帧立体影像采用Förstner或Harris特征算子提取像对上的特征点,获取影像上的立体匹配点;然后,通过图像匹配方法寻找前后帧立体影像间的同名点;最后,根据同名点分布位置计算当前帧影像相对前一帧影像的相对位姿参数,输出当前帧立体影像的位姿结果。视觉测程定位原理上类似站点视觉定位,然而同相邻站点影像相比,序列立体影像间纹理特征变化不明显,一般采用模板匹配等常规方法实现相邻帧图像特征追踪,通过优化的快速定位解算方法实现探测车的在线连续定位。

与站点视觉定位方法类似,视觉测程方法也是一种连续推估的定位方法,同样存在定位误差的累积。考虑到序列立体影像间距通常不大,同名地物可能在连续数帧影像上均有成像,文献[62]提出了一种基于序列立体影像光束法平差的视觉定位方法,通过同名特征在多帧影像上的追踪,选取其中的几何关键帧,构建局部的影像区域网,采用光束法平差优化计算得到当前帧影像位姿参数,提升了传统视觉测程定位方法的精度。近年来,以ORB-SLAM[63]、LSD-SLAM[64]为代表的视觉SLAM方法,优化了特征提取与匹配方法,提升了定位效率与精度,有望为探测车的在线视觉定位提供借鉴与参考。

2.4 视觉与多传感器组合导航定位

尽管视觉定位方法精度较高,但易受环境纹理、光照条件影响,在星球表面贫纹理区域定位精度降低甚至可能无法定位。因此,原理上可以将探测车惯导与里程计的数据同视觉数据进行融合,通过多传感器的融合提升探测车定位的稳健性与精度,解决贫纹理条件下单独使用视觉数据无法定位的问题。文献[65]提出了一种基于立体相机、惯导和里程计的松耦合组合导航方法,通过扩展卡尔曼滤波融合输出比视觉定位精度更高的结果。文献[66]提出了一种基于联邦滤波的组合导航方法,确保了立体影像定位处理失败时仍能稳健输出连续的高精度定位结果。为进一步提高组合导航的精度,文献[67]提出了基于滤波的紧耦合算法,采用类似滑动窗口的方式对窗口内所有状态建立约束,同时对窗口外变量状态进行边缘化,有效减少状态参数,提高了系统稳健性与收敛性。文献[68]提出了基于惯导与视觉的紧耦合定位算法,通过建立统一的视觉与惯性测量代价函数实现整体优化。文献[69]提出了基于紧耦合的滑动窗口非线性优化单目视觉惯性里程计定位方法,通过惯导预积分处理及4自由度参数的图优化输出实现了单目相机与惯导的集成定位。

相比单个传感器,视觉相机与惯导及里程计等多传感器进行松耦合或紧耦合融合均能有效提升定位的稳健性与精度[70]。视觉与多传感器组合导航定位的尚未在工程中应用,经过更多的研发和测试,组合导航定位有良好的应用潜力。

2.5 探测车影像同轨道器影像集成的定位

长距离行驶的探测车自主定位结果的误差累积,可通过探测车地面影像同轨道器影像底图的集成而消除。MER中,文献[12]在地面影像镶嵌生成的全景影像上人工寻找远处地标点,如山峰等,通过建立全景影像上地标点同轨道器影像上对应地标的相互几何位置关系,实现探测车的定位。文献[71]分别开发了针对石块密集区和裸露基岩区的轨道器影像同地面影像集成的自动定位方法。在石块密集区域,利用立体相机获取的三维点云数据高程信息在地面影像上获得石块分布形状,同时在高分辨率轨道器影像底图中利用影像梯度信息提取石块分布信息;通过计算两种分布状态的相似变换模型参数,得到探测车在轨道器影像底图上位置。在裸露基岩较多的区域,通过探测车影像生成同轨道器影像分辨率相似的DOM,改变地面影像成像视角,进而通过特征匹配确定地面DOM同轨道器影像的关系,实现探测车站点的绝对定位,达到了优于轨道器图像一个像素的精度。该方法应用于我国嫦娥系列任务中,通过月球车地面图像制作的DOM同降落相机影像或轨道器影像的DOM间的匹配,完成月球车在着陆区的全局定位[20,54]。

3 深空探测车路径规划技术进展

深空探测车路径规划指综合考虑各种环境因素及车本身能力的情况下,规划从起点到目标点行驶路径的过程。探测路径规划是其安全行驶、高效探测的重要保障,是探测车导航的重要步骤。

根据规划路径的范围,深空探测车路径规划可分为两类:一类是基于先验地图等信息的全局路径规划,该规划一般针对较远目标,主要考虑科学目标的可达性及整体路径的最优化[72-73]。另一类是基于探测车周围环境感知的局部路径规划,以探索局部科学目标及规避障碍,主要考虑车的安全性及行驶代价最小[74]。

不同类型的路径规划方法都涉及两个关键的技术:行驶代价的计算及最优路径规划算法。探测车的行驶代价一般考虑地形可达、光照情况、通信可达及车的能源平衡等多种因素[75],在行驶代价构建及定量化的基础上形成代价图,然后利用路径规划技术计算最优路径。如我国月球车导航单元规划中考虑地形行走代价、移动里程代价、操作控制代价等因素,构建环境立方模型,然后利用A*算法规划路径[76]。

行驶代价一般考虑环境因素及车自身的因素。获取这些环境信息一般利用已有环境信息和车上的传感器(如立体导航相机)[77],毅力号上为了更大范围的环境感知还配备无人机进行协同探测[78]。车自身因素包含车的越障能力、操作性能、能源的平衡等[79]。各领域都提出了大量的路径规划算法[80-81]。在深空探测车任务中考虑对行驶代价处理方式不同,应用得较多得是针对静态场景的A*算法或Dijkstra算法,算法内存占用小,计算速度快[82-83]。而针对动态场景,采用较多的D*算法[84],该算法具备更高效的重规划性能。诸如神经网络算法[85]等算法也在探测车路径规划中得到应用。此外,也有学者研究多种算法之间的结合实现探测车的路径规划[43]。

目前路径规划的方式主要分为人机交互的路径规划与自主路径规划。人机交互的路径规划目前应用较多,如我国的玉兔号、玉兔二号月球车[75]、美国的勇气号、机遇号等火星车都采取这种方式[73,86-88]。探测车进入导航点后,利用传感器进行环境感知,遥操作人员根据环境感知结果,结合科学目标及路径规划算法定制行驶路径,指挥探测车移动。该方法能有效保障探测车行驶安全及可靠性,但受限于数据传输带宽及遥操作时延,效率较低。深空探测车自主路径规划指车在行驶的过程中自主避障、路径选择及目标接近。该方法对车的环境感知能力及计算性能都提出了很高的要求,有望提高行驶效率,但其在深空环境中的可靠性还有待进一步验证。

4 深空探测车智能化行驶与探测展望

为了提高探测能力并获得更多的科学发现,未来的深空探测车需要着陆在更具有挑战性的区域,行驶更长的距离,针对更多的科学目标获取原位探测数据,提高其环境感知的智能化水平、提高探测车长距离自主导航定位的能力,是支撑巡视探测任务朝着智能化、高效率、大范围探测发展的必由之路。

(1) 深空探测车智能感知。目前探测车每个规划单元的行驶距离短、探测效率低的主要原因是探测车环境感知的智能化程度不够。未来探测车环境感知将主要朝着智能化方向发展,将在多方面提高智能化水平,大幅提升探测车的行驶和探测效率。环境感知不仅感知地形的几何信息,而且要感知其语义信息,即通过自动地形分类得到所行驶前方的地形类别,还要自动识别撞击坑、石块等表面目标,实现实时的全面的环境感知。探测车智能感知的实现,需要充分吸收以深度学习为代表的人工智能技术,充分挖掘视觉传感器的潜力,适时配置和利用激光雷达等多种传感器,以及提高车载计算机的算力。

目前,月球车和火星车巡视探测任务中的科学探测目标,如石块、岩层、土壤、撞击坑等均是科学家们研究指定的,探测车没有自主发现科学目标的要求及能力。未来的探测任务中,随着探测车行驶和探测能力的提高,对科学目标的确定应采取科学家指定和探测车自主发现相结合的方式。在行驶过程中,探测车在保证安全及能按时到达指定目标的前提下,自主发现一些科学目标获取科学数据。拥有了自主发现科学目标的能力,深空探测车的探测方式将得到质的飞跃。

(2) 长距离自主导航定位。受限于感知和定位能力以及安全性的考虑,以前月球车和火星车每个单元规划的行驶距离平均为数米至数十米,使得探测车机械行驶能力远没有发挥出来。长距离自主导航定位,如每个单元规划数百米乃至更长距离下的自主导航定位,是深空探测车发展的重大需求和必然选择。这就需要把目前工程中常用的站点间的视觉定位,改进成连续的实时视觉定位,或者称为实时视觉SLAM[70],并且与上文中论述的实时障碍识别、地形分类、目标识别相结合,实时地自主规划到达远处目标点的路径。长距离自主导航对定位精度的要求也会相应提高,否则定位误差的累计会给探测车行驶带来安全隐患。为了提高定位精度,更有效地集成双目视觉、惯导和里程计很有必要。

探测车的周期规划和单元规划主要依赖于其视觉传感器数据,而科学家对着陆区的宏观研究科学探测规划(即整体规划)主要依赖于轨道器影像底图。因此,需要把探测车定位到轨道器影像底图,这一巡视器与轨道器的一体化定位还能够消除仅依赖于探测车视觉定位在长距离上的累计误差。探测车在轨道器影像底图的定位已有研究并在遥操作过程中使用,如何将其前置到计算和存储受限的探测车上实现自主定位是值得进一步研究的问题。

实现了长距离自主导航定位和轨道器与巡视器的一体化定位的自动化,将大大提高深空探测车行驶与探测的效率,同时减轻地面遥操作工程人员的工作强度和密度。长距离自主导航定位技术与智能感知的结合,将真正实现深空探测车的智能化、高效率、大范围探测,给巡视探测任务带来更多的科学回报。

5 结 语

作为深空探测车行驶和探测的核心技术,环境感知与导航定位技术已经在月球和火星巡视探测任务发挥了关键作用。之前的环境感知与导航定位重点解决了安全性和精度的问题,目前研究和应用正朝着智能化、长距离自主导航定位等方向发展,其中仍有很多难题尚待解决,需要深空探测技术人员和相关科研工作者努力攻关解决,其中测绘遥感、计算机视觉、人工智能等学科专业的技术发展将起到有力的推动作用。