基于多尺度细节的孪生卷积神经网络图像融合算法

刘 博, 韩广良, 罗惠元

(1. 中国科学院 长春光学精密机械与物理研究所, 吉林 长春 130033;2. 中国科学院大学, 北京 100049)

1 引 言

图像融合将同一场景下两幅或多幅源图像的相关联有效信息整合成一幅综合图像,实现了不同模态图像的信息互补。经融合处理得到的图像能够弥补单一图像信息量不足问题,更符合人眼视觉感知和工业视觉领域需求,因此图像融合在许多领域都有广泛的应用。

近些年,图像融合技术发展迅速,相关学者针对像素级图像融合进行了深入研究。其中基于多尺度的融合方法因有着鲁棒性强、具有局部时频特性等特点,一直是一个热门的研究课题。经典融合方法包括基于塔形分解的变化融合方法、基于小波变换的融合方法、基于轮廓波变换方法[1]等。基于塔形分解的变换方法包括:基于拉普拉斯金字塔变换(LP)[2]、基于对比度金字塔变换[3]以及基于梯度金字塔变换[4]等。基于小波变换方法包括:基于方向小波变换[5]以及双树复小波变换(DTCWT)[6]等。然而以上方法在方向性上存在较大限制,且不具备平移不变性,融合结果中易出现边缘特征捕获不足和边缘圆晕效应问题。而非下采样轮廓波(NSCT)[7]和非下采样剪切波(NSST)[8]具有较好的方向性和平移性,能够在一定程度上解决上述问题,但融合过程中没有充分考虑空间一致性,对全局结构的边缘轮廓特征提取能力不强。边缘保留滤波具有平移不变性和边缘保留性,能够在平滑图像的同时保持边缘清晰。因此,很多方法将边缘保留滤波引入到图像融合中,以克服上述缺陷。文献[9]构造了一种多尺度方向双边滤波器,结合双边滤波器和非采样方向滤波器组进行图像融合。文献[10]采用基于L0光滑滤波的多尺度边缘保持分解,提出了一种增强融合结果细节的融合策略。文献[11]提出了基于滚动引导滤波和混合多尺度分解的图像融合方法,其利用滚动引导滤波将图像分解到基本层、小尺度层和大尺度层,通过对不同层级进行融合使融合图像具有更好的纹理边缘特征。滚动引导滤波作为保边滤波器的一种,不仅能够平滑细节,而且能够保留图像的边缘特征,避免边缘位置出现圆晕现象,这对保证融合图像质量具有重要意义。

此外,随着机器学习技术的发展,一些基于学习的融合方法也被相继提出。文献[12]设计一种基于编码和解码体系结构的网络框架,通过无监督训练实现端到端图像融合。文献[13]结合多尺度模块设计融合网络,通过对不同尺度的特征进行提取提高融合效果。文献[14]结合图像块融合思想,通过设计神经网络来指导源图像块进行融合。神经网络具有强大的特征提取能力,其可以捕捉图像中最显著物体的内部特征。但随着网络层数增多,不断进行池化的操作,可能会使特征图损失很多细节信息,导致在边缘部分的信息丢失。

基于边缘滤波的多尺度分解具有较好的细节信息与边缘轮廓信息提取能力,而神经网络则对物体的内部区域具有较强的特征提取能力。本文中将这两个模块结合起来使用,并提出了一种基于多尺度细节的卷积神经网络图像融合方法。通过将神经网络与改进的滚动引导滤波相结合,以多尺度的方式结合神经网络得到的权值图共同处理信息,使融合图像更好地满足人类视觉效果。滚动引导滤波的联合滤波采用联合双边滤波器来实现,并采用前次迭代图像作为滤波器引导图像。通过结合信息熵原理对空间平滑参数与灰度权重参数进行改进,使其实现针对不同源图像的参数自适应化。这种方法能够保留边缘信息的同时使多尺度图像充分提取细节信息。另外,通过非线性映射变换对构建的多尺度图像细节进行非线性映射,从而丰富突出细节层内细节纹理信息。

2 本文算法原理

本文融合框架主要分为3部分,如图1所示。首先,两张源图像被送入孪生卷积神经网络中,经过网络特征提取后,得到与源图像特征相关的权值映射图。其次,对源图像进行滚动引导滤波,并对相邻迭代的细节层图像进行差值,获得多级差分细节图像。然后对多级差分图像进行函数映射变换,使图像细节得到增强。最后,通过局部能量与权值图相结合,自适应调整融合模式对多尺度图像进行融合,从而得到融合图像。

图1 多聚焦图像融合框架Fig.1 Multi-focus image fusion framework

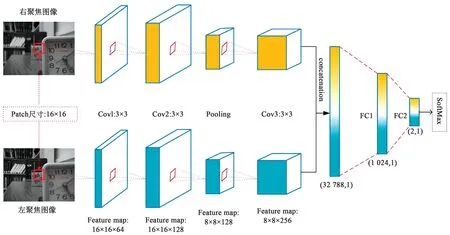

2.1 孪生卷积神经网络

孪生网络是由两个完全相同结构的卷积神经网络组成,两个CNN能够将输入图像映射到新的空间中进行表示,然后通过损失函数计算评价两者之间的相似度。Sumit 等[15]提出了孪生网络,通过从数据中学习相似性度量来对不同类别样本加以区分,从而实现多分类任务。本文以孪生网络作为神经网络框架提取融合图像的权值图W,如图2所示。源图像通过滑窗的方式得到16×16的patch作为网络的输入图像输入到训练好的网络中。网络对图像进行特征提取,然后将特征图像连接起来组成特征向量。特征向量经过两个全连接层,得到一个二分类的特征向量,该向量代表清晰度分类的得分情况。将该二维向量经softmax层进行归一化后可得到所属类别的概率值,它可表示为图像的清晰度度量值,依据此值来组成权值图。该CNN结构主要由3个卷积层、一个池化层、两个全连接层以及softmax层组成。具体参数如表1所示,3个卷积层的卷积核大小为3×3,步长设定为1,最大池化层采用2×2大小的内核,步长设定为2。

图2 孪生网络框架Fig.2 Architecture of siamese network

表1 CNN网络参数Tab.1 CNN network parameters

输入网络的patch的大小影响着算法的速度与精度,为保证两者之间的平衡,本文中patch采用16×16的尺寸。源图像通过滑窗得到16×16的patch,由于网络结构中存在一个pooling层,因此滑窗的步长为2。将取得的patch对送入网络后会得到与清晰度特征信息相关的二分类概率值,将此值作为融合系数用来指导源图像融合。为得到与源图像大小尺寸相对应的权值图,需要对其进行填充。如图3所示,将1×1的权值进行填充使其与patch的尺寸相同,对于滑窗相邻的patch,其权值图在其相对应的重叠部分采用均值法来得到对应权值。通过这种方式可以重组出与源图像大小相对应的权值图。

图3 权值图生成机制Fig.3 Mechanism for generating the weight map

2.2 多尺度图像构建

传统金字塔分解多尺度的过程中对边缘细节信息并不敏感,对细节的捕捉能力差,因此,利用保边滤波器进行多尺度图像构建能够更好地保护图像的边缘信息。其中滚动引导滤波[16]能够在平滑细节纹理等信息的同时,通过不断迭代的方式实现边缘信息的恢复。

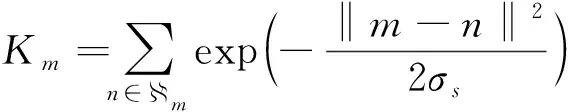

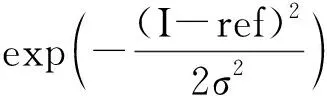

滚动引导滤波过程主要可分为小结构消除和边缘恢复两部分。小结构消除过程主要通过高斯滤波来实现,如式(1)所示。

(1)

(2)

式中:

同样作为归一化系数;Jt(m)、Jt(n)是第t次迭代得到的引导图像在空间索引m、n处的像素值,σr是灰度域的权重,它决定图像边缘恢复的强度。该过程采用联合双边滤波的形式将第t次迭代的输出图像Jt作为引导图像,在滤波过程中它能够在梯度变化处起主导作用,提高滤波器处理边缘特征信息的强度,经滤波后得到输出图像Jt+1。通过迭代使输出图像不断更新,图像的边缘特征也被不断恢复。

参数σs和σr是表征滚动引导滤波性能的重要参数,它们决定着图像滤波的最终效果。采用固定值作为σs和σr的输入往往需要大量实验和经验总结,并且随着滤波迭代更替图像对参数的要求也会发生变化,不具备自适应性。图像的信息熵能够反映图像内信息的丰富程度,熵的本质体现了一个系统的混乱程度,而图像的滤波正是对图像混乱程度进行改变的过程。因此,图像的信息熵与参数σs和σr存在联系,通过图像的信息熵来决定参数σs和σr可以使滚动引导滤波具备较强的自适应性。

参数σs主要用于控制滤波的尺度,通过式(3)、式(4)和式(5)对各层滤波参数进行设置。

(3)

(4)

(5)

图像的每次迭代会在联合滤波的作用下进行不同程度的保边滤波,对相邻迭代图像进行差值处理可以得到差分图像。图4展示了相邻两次迭代图像间被模糊掉的细节信息。σs的每次迭代更新都采取公式(3)进行更新,这使得图像的纹理平滑程度将随之变化,不同尺度的细节层包含的纹理信息也将由细到粗变化,从而实现细节轮廓特征的多尺度自适应提取。

图4 滚动引导滤波多尺度构建Fig.4 Multi-scale construction of rolling guided filtering

参数σr主要用于滤波的边缘恢复与保留,其设置如式(6)、式(7)和式(8)所示:

(6)

(7)

(8)

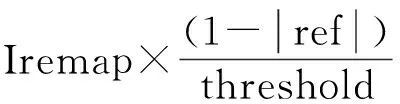

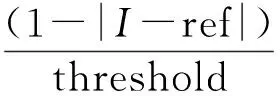

局部拉普拉斯滤波[17]是一种边缘保护滤波。它通过对图像进行逐个像素点的像素映射变换使图像的细节信息得到增强。本文参考其原理对滚动引导滤波分解的细节层图像进行非线性映射变换,实现图像细节增强,图5大致展示了其变换过程。本文首先对多尺度细节层图像进行函数映射变换,以t作为阈值用于界定细节特征像素与边缘特征像素。对于t范围内的细节像素,通过映射变换对其进行非线性增强,而对边缘像素保持线性不变。

图5显示了细节增强的效果图,图5(a)和图5(b)是一组多聚焦源图像,图5(c)和图5(e)经滚动引导滤波分解的多尺度细节层图像,图5(d)和图5(f)是与之对应的映射增强后细节层图像。具体映射变换如式(9)、式(10)所示。

(9)

(10)

图5 非线性映射增强。(a),(b)一组多聚焦源图像;(c),(e)多尺度分解后的细节层图像;(d),(f)映射增强后细节层图像。Fig.5 Nonlinear mapping enhancement. (a), (b) a group of multi-focus source images; (c), (e) detail layer images after multi-scale decomposition, (d), (f) detail layer images after mapping enhancement.

2.3 融合规则制定

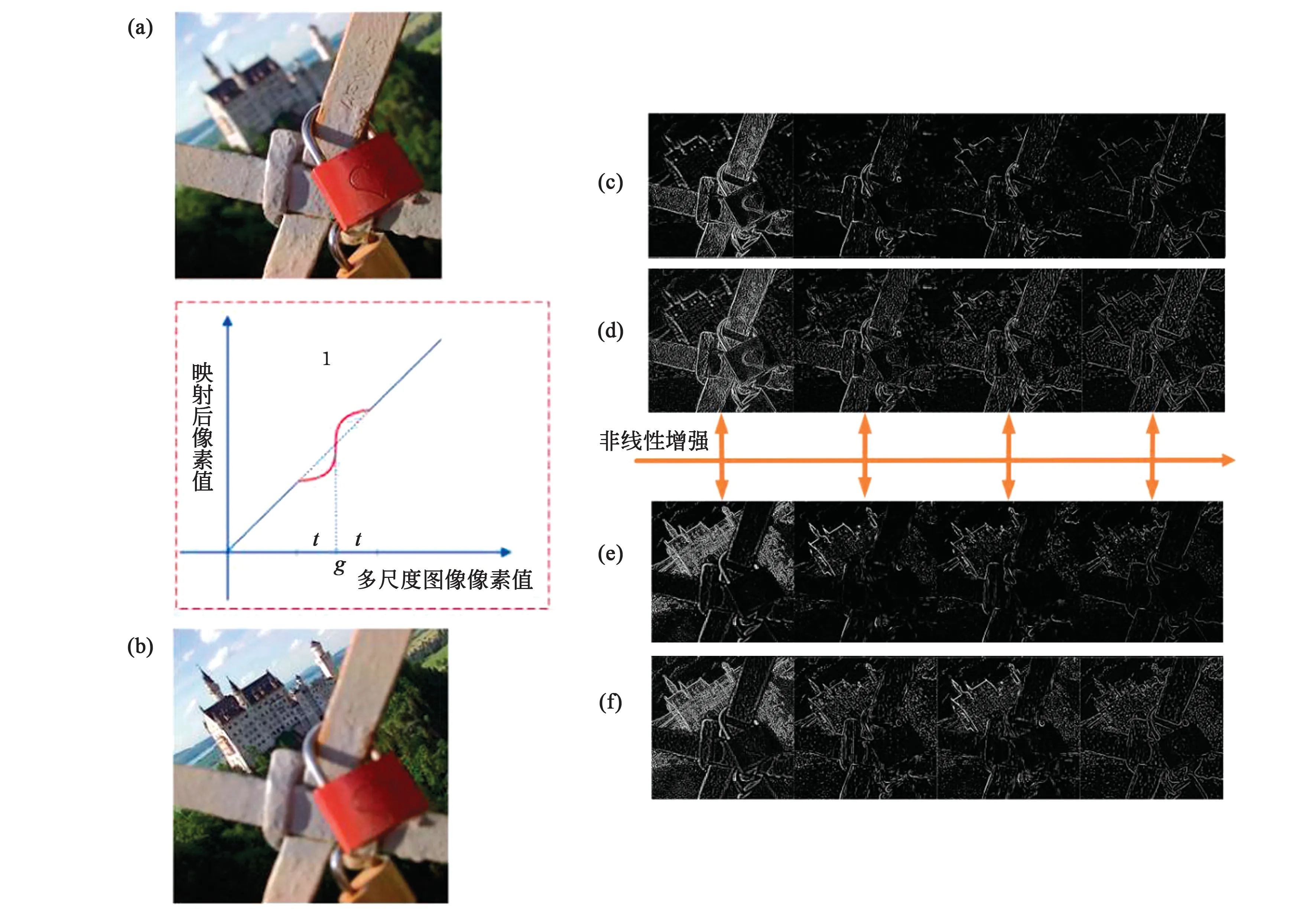

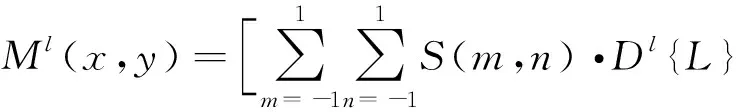

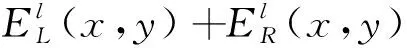

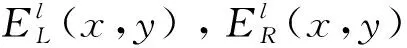

源图像经多尺度分解以及细节层增强后与基础层共同组成多尺度图像。图像的融合主要针对各层之间进行融合然后逐层叠加。左、右聚焦多尺度图像分别记作Dl{L}、Dl{R},其中l代表第l层多尺度图像,并将基础层记作D0{L}、D0{R}。各层之间采用局部能量与权值图W相结合的方式进行融合。局部能量特征的定义是

E(x,y)=∑m∑nS(m,n)·

F(x+m,y+n)2,

(11)

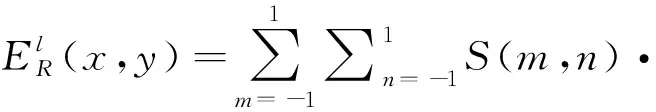

式中,S(m,n)是局部区域的加权系数,其核大小为3×3。E(x,y)代表点(x,y)在m,n区域像素值的能量值。反映到图像特征上,E(x,y)值高代表该区域的特征更加明显,即此区域对应的不同尺度图像细节信息更丰富或是低频亮度特征更充分。所以,对Dl{L}、Dl{R}求区域能量,即:

(12)

(13)

(14)

(15)

当Ml≥th时,此时认定两图像的相似度较高,都存在重要特征信息,故采用基于权值图W进行融合。计算如下:

Dl{F}=W(x,y)·Dl{L}(x,y)+

(1-W(x,y))·Dl{R}(x,y).

(16)

通过这种融合规则对各层多尺度图像进行融合,最后对各层的融合图像进行叠加,得到源图像的融合图像。

3 实验与结果

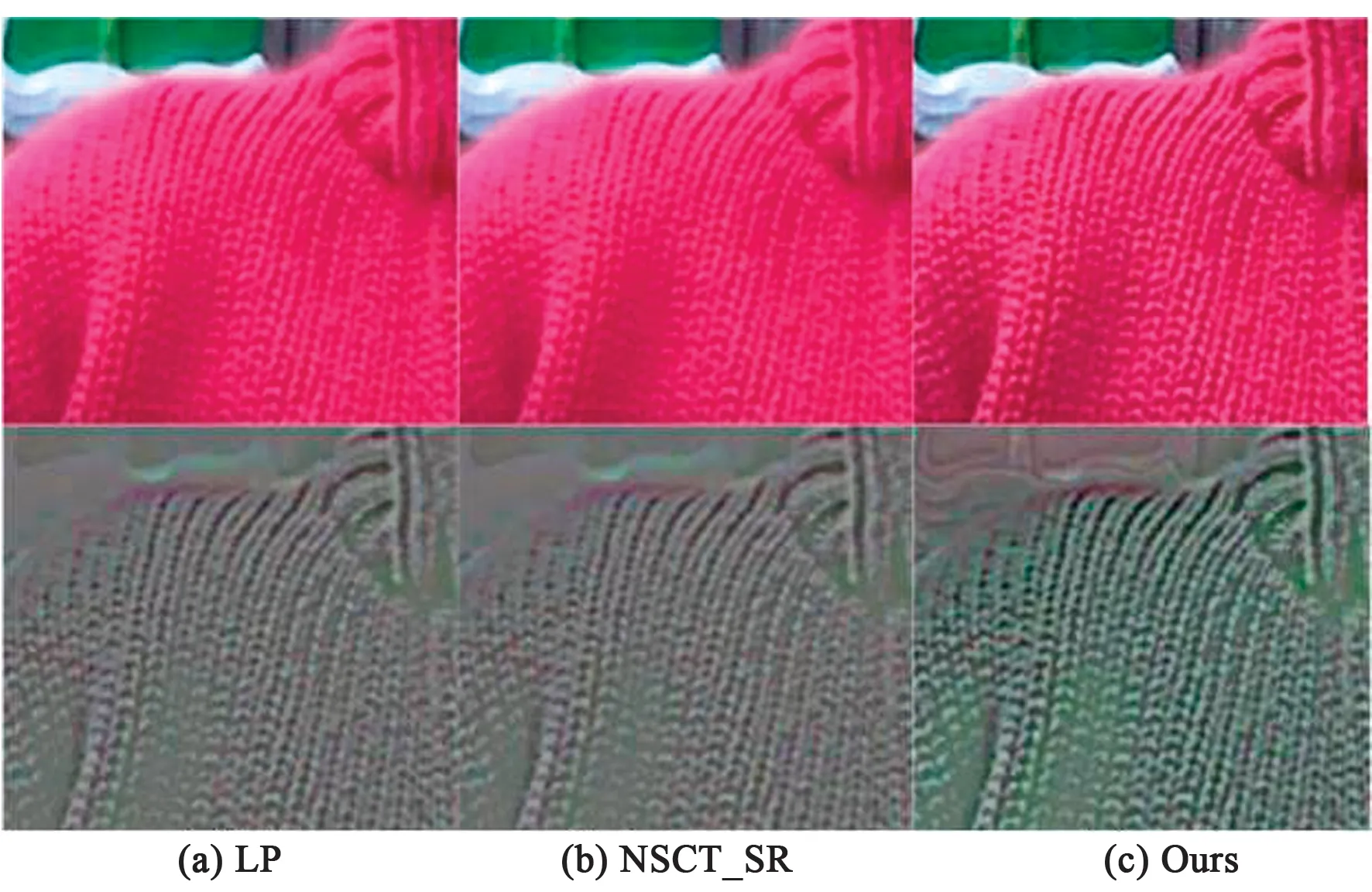

为验证算法的有效性,本部分将通过主观评价和客观评价相结合的方式对算法进行比较分析。所对比方法分别为拉普拉斯变换融合方法(LP)[2],基于稀疏表示与轮廓波的融合方法(CVT_SR)[18],双树复小波变换融合方法(DTCWT)[6],基于稀疏表示与非下采样轮廓波的融合方法(NSCT_SR)[19]以及滚动引导滤波(GFF)[11]的融合方法。主观评价由人眼的视觉效果作为评价指标,具有直观、简单等优点。图6是采用lytro数据集中的一组多聚焦图像,通过不同融合算法进行的实验效果对比图。左上部分为图中黄色框内的局部放大图像用于对比各种算法的细节纹理效果。图6(f)为本文算法融合结果,可以看到相比其他算法,黄色框内的衣物对比度更高,纹理特征更加清晰。为便于分辨与观测,本文将图6(d),图6(e)和图6(f)分别与源图像进行差值处理,通过归一化后取图中黄色框区域的差分图像进行对比,如图7所示。

图6 采用lytro数据集中多聚焦图像“小孩”进行融合对比实验。(a)~(f)所采用方法依次是:CVT_SR、DTCWT、GFF、LP、NSCT_SR以及本文方法。Fig.6 Multi-focus image “child” in inlytro data set were used for the fusion comparison experiment. The methods used in (a) ~ (f) are CVT_SR, DTCWT, GFF, LP, NSCT_SR and Ours.

图7 “小孩”的细节放大效果对比图Fig.7 “Child” local details effect comprison diagram

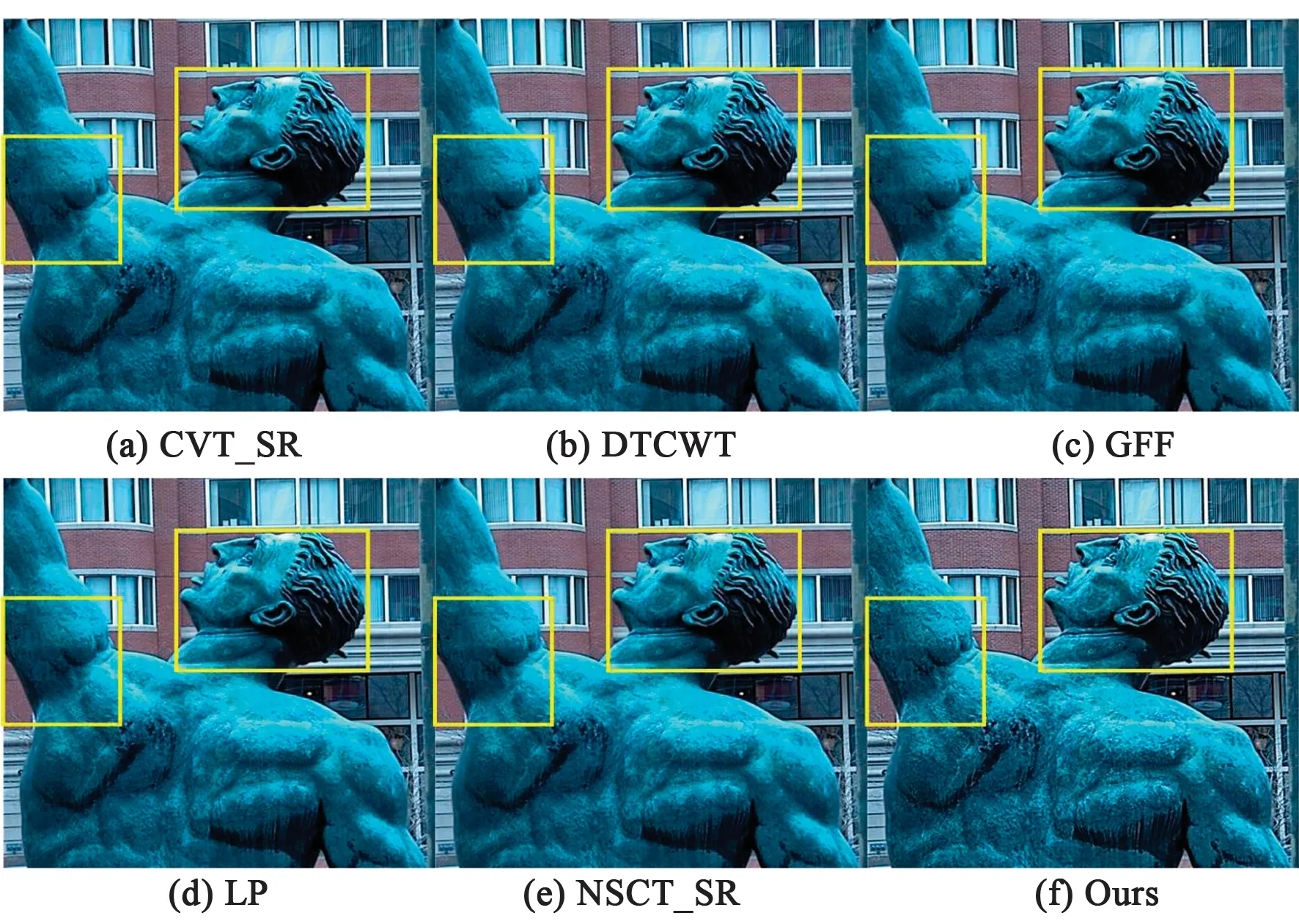

图8 采用lytro数据集中多聚焦图像“雕塑”进行融合对比实验。(a)~(f)所采用方法依次是:CVT_SR、DTCWT、GFF、LP、NSCT_SR以及本文方法。Fig.8 Multi-focus image “sculpture” in inlytro data set were used for the fusion comparison experiment. The methods used in (a) ~ (f) are CVT_SR, DTCWT, GFF, LP, NSCT_SR and Ours.

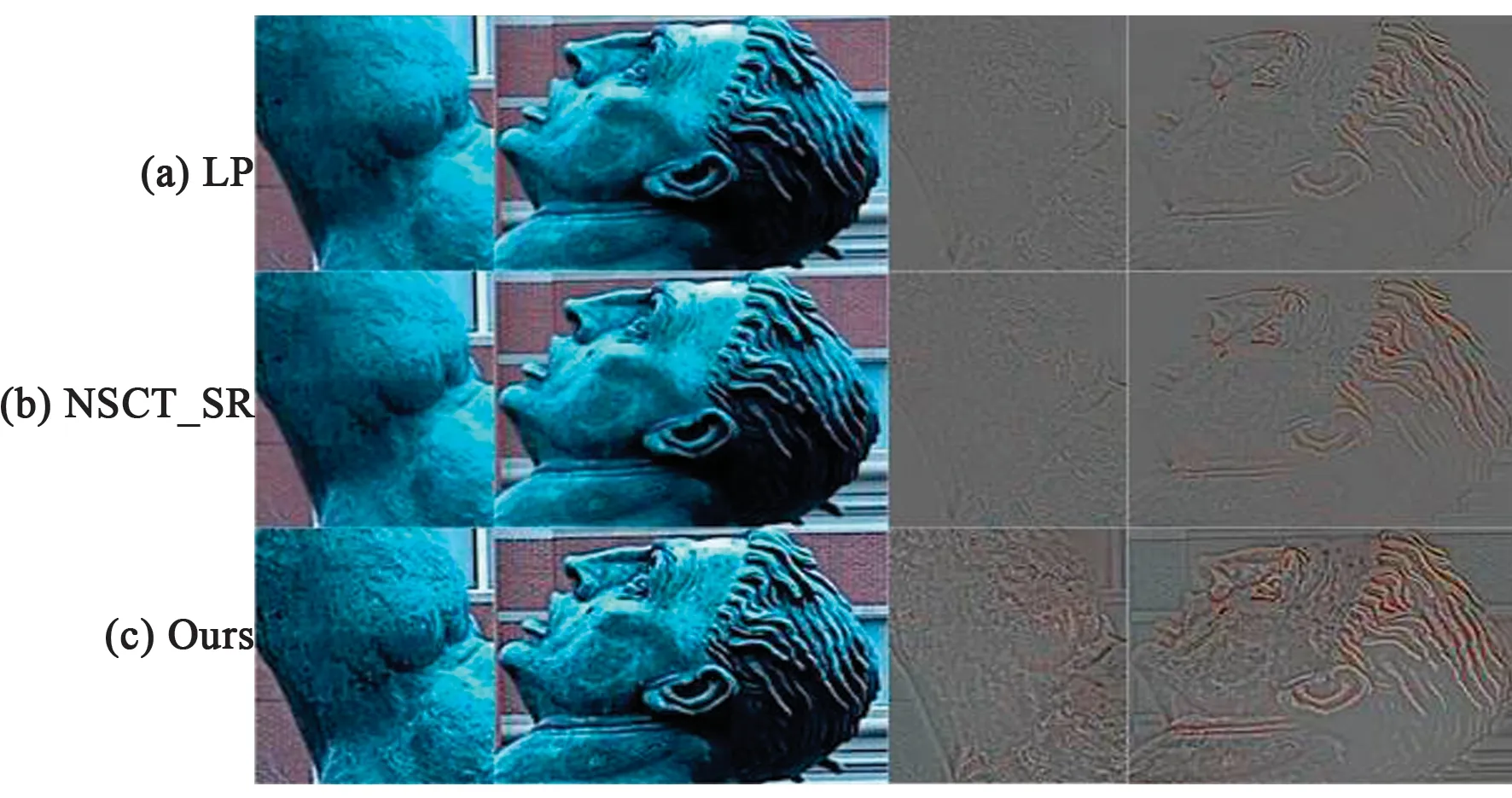

可以看到,图7(c)的纹理更加清晰,边缘部分没有模糊现象。图8也是采用lytro数据集中的一组多聚焦图像进行对比实验,图9是图8(d),图8(e)和图8(f)中黄色框内的局部放大效果。经对比可以看到,图9(c)中雕像头部与手臂的轮廓边缘清晰完整,细节特征更加丰富。

图9 “雕塑”的细节放大效果对比图Fig.9 “Sculpture” local details effect comprison diagram

图10是TNO数据集中一组红外可见图像的各算法实验结果。

图10 各算法全局效果对比图Fig.10 Comparison of the global effect of each algorithm

类似地,本文在图11中展示了融合图像的局部放大图。可以看到,相较与其他算法效果图,图11(c)人物目标显著,坡地草坪、树枝纹理以及木桩轮廓可分辨度更高,具有更好的视觉效果。

图11 融合图像的细节放大效果对比图Fig.11 Comparision of details enlarged of the fusion images

由于人的视觉感知存在差异,对评价结果存在一定的影响,因此需要通过构建与人眼视觉效果相近的客观评价指标模型对融合图像进行更进一步的客观评价。

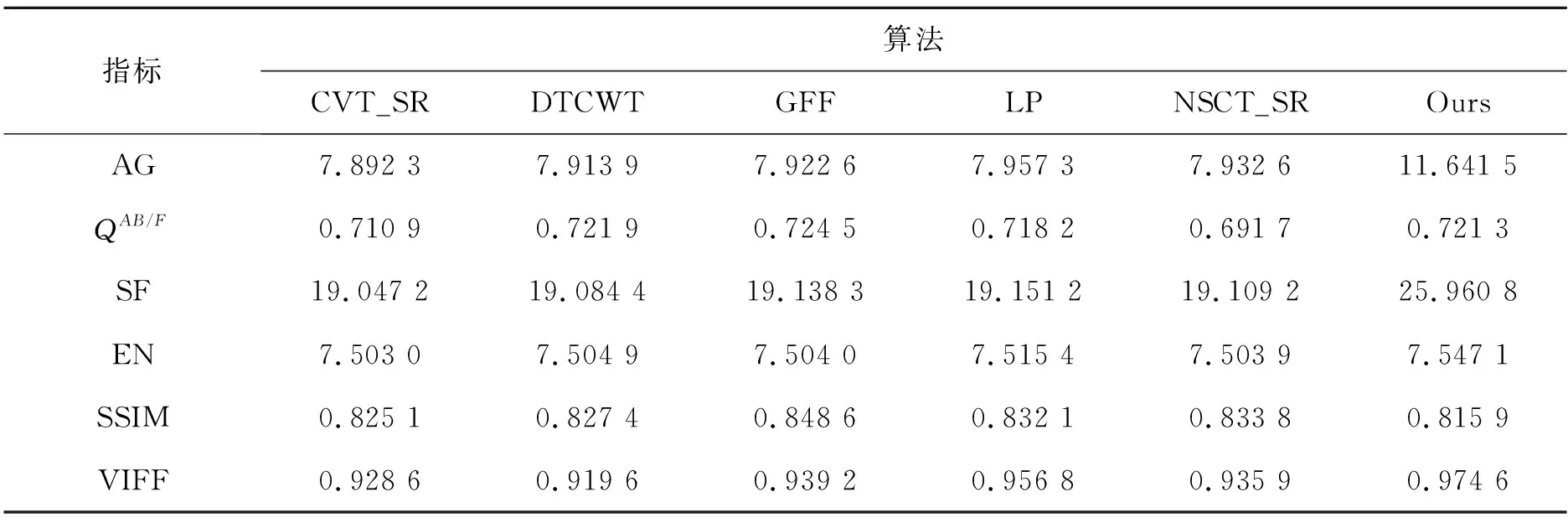

本文采用6种重要的评价指标对算法进行测试。这6种评价指标分别是:平均梯度(AG)、QAB/F度量(QAB/F)、空间频率(SF)、信息熵(EN)、结构相似性(SSIM)以及视觉信息保真度(VIFF)。其中AG也称作图像锐度值,能够衡量图像细节纹理特征清晰度,其值越高代表图像细节纹理越清晰。QAB/F利用局部度量来估计输入图像的显著信息在融合图像中的表现程度,能够反映融合图像从输入图像中获得的视觉信息的质量。SF能够度量图像空间域的总体活跃度,可反映图像对微小细节反差表达的能力。EN是用于测量融合图像中所包含信息量的重要指标。SSIM通过计算融合图像与参考图像之间的结构相关信息来判断结构的相似度。VIFF通过模拟人类视觉系统原理从通信和信息共享的角度评判图像质量,具有图像视觉效果的判定能力,其值越大,图像的保真度越高。

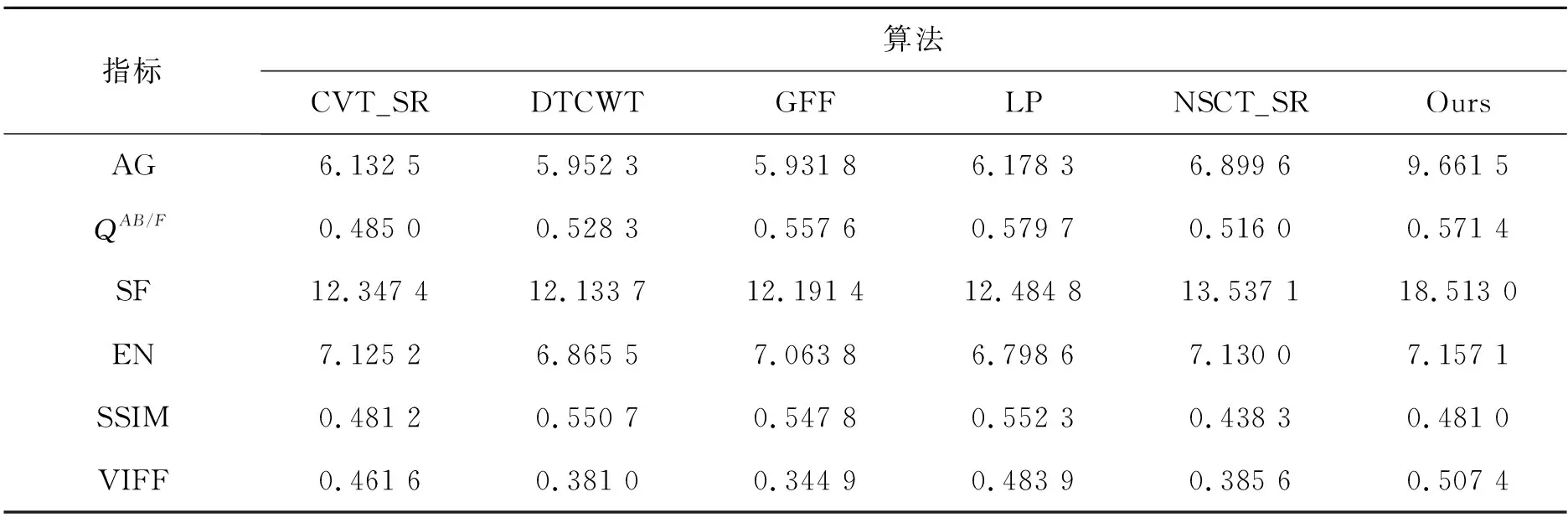

表2、表3分别是多聚焦图像集和红外图像集在各种算法下所得客观指标的均值表。表2采用 lytro数据集中的17对多聚焦图像作为源图像数据进行测试,而表3采用TNO数据集和红外图像数据集中的29对红外可见光图像作为源图像数据进行测试。由表2和表3可见,本文算法在MG、SF、IE和VIFF上具有明显优势,代表着本文算法在细节纹理分辨度和视觉效果保真度方面效果更佳。但在SSIM上略低于其他算法,究其原因在于进行多尺度非线性增强使图像的照明度、对比度以及图像结构部分得到一定增强。用源图像作为参考图像时,由于结构发生一定变化,使得此项指标低于其他算法结果。综合主观评价与客观评价,本文算法在细节纹理、轮廓清晰以及视觉保真效果上具有明显优势。

表2 多聚焦融合图像客观指标比较Tab.2 Objective index comparison of multi-focus fusion images

表3 红外可见光融合图像客观指标比较Tab.3 Comparison of objective indexes of infrared visible light fusion images

4 结 论

本文提出一种基于多尺度细节的卷积神经网络图像融合算法。通过孪生网络提取图像特征构建权值图,并通过改进的滚动引导滤波对源图像进行自适应多尺度分解,并进一步使用映射函数增强了图像细节,最后基于局部能量原理与权值图,设计自适应调整融合模式,将多尺度特征图进行融合。该方法能够更好地突出细节纹理特征,提高视觉感知特性。实验结果表明,所提方法融合结果具有更加丰富的细节特征,避免了图像出现圆晕效应,更符合人类的视觉感知系统。