对比卷积神经网络分类模型与放射科医师鉴别浸润性肺腺癌的效能

尹 柯,张久权,伍建林,巴文娟,林 琳,沈 晶,熊婧彤,张伟杰

(1.重庆大学附属肿瘤医院影像科,重庆 400030;2.大连大学附属中山医院放射科,辽宁 大连 116001;3.扬州大学附属医院放射科,江苏 扬州 225003;4.大连医科大学附属第二医院放射科,辽宁 大连 116023;5.陕西渭南神州德信医学成像技术有限公司,陕西 渭南 714099)

2011年,国际肺癌研究协会、美国胸科学会和欧洲呼吸学会[1]基于高分辨率CT-病理学相关性研究提出新的肺腺癌国际多学科分类体系,以供临床医师预测肺腺癌组织病理学亚型、患者预后及规划临床干预措施[2]。近年来,胸部影像学深度学习(deep learning,DL)图像分析成为研究热点,主要用于评估CT所检出的良、恶性肺结节[3-6],并日渐成熟[8-9],现阶段面临的挑战是利用DL分类不同性质肺结节。微浸润腺癌(minimally invasive adenocarcinoma,MIA)与不典型腺瘤性增生(atypical adenomatous hyperplasia,AAH)、原位腺癌(adenocarcinoma in situ,AIS)同为浸润前病变(pre-invasive lesion,PIL)[10-12];对PIL均可行亚肺叶切除术,术后5年生存率近100%,而对浸润性腺癌(invasive adenocarcinoma,IA)则推荐行肺叶切除加淋巴结清扫或取样术,术后5年生存率60%~88%,故术前有效区分两者对选择手术方式及改善患者预后具有重要意义[9,13-14]。本研究比较基于胸部CT建立的卷积神经网络(convolutional neural network,CNN)分类模型与放射科主治医师鉴别磨玻璃结节(ground glass nodule,GGN)中的PIL与IA的效能。

1 资料与方法

1.1 一般资料 回顾性分析2013年1月—2018年12月1 086例经手术病理确诊PIL或IA患者的胸部CT;男414例,女672例,年龄18~78岁,平均 (55.5±12.2)岁;共检出1 214枚GGN,其中974例检出1枚、96例检出2枚、16例检出3枚。纳入标准:①术前1个月内接受胸部薄层CT检查;②组织病理学证实为PIL或IA;③GGN最长径≤30 mm。排除标准:①术前接受化学或放射治疗;②图像质量差及存在肺纤维化。按9∶1比例将所有GGN分为CNN分类模型训练组(1 092枚)及验证组(122枚)。训练组包括490枚AAH、AIS及MIA和602枚IA;验证组包括43枚AAH、AIS及MIA和79枚IA。

1.2 仪器与方法 采用Siemens Somatom Definition双源CT、Siemens Somatom Definition AS 64层CT或Siemens Somatom Sensation 16排CT仪,于患者吸气末行胸部扫描,范围自胸廓入口至肺底、包含肾上腺,管电压100~140 kV,管电流200~280 mAs,层厚及间隔均为5 mm,FOV 350 mm×350 mm,矩阵512×512;扫描结束后采用骨算法将原始图像重建为层厚1 mm图像。

1.3 图像处理 将原始数据转换为各向(即轴位、冠状位、矢状位)同性格式,即采用1×1×1 mm3分辨率和3次样条插值生成各向同的DICOM图像,以降低CT扫描变化对算法学习的影响;并以多个分辨率和大小不同但中心相同的3D立体结节图像块分析各向同性DICOM图像。

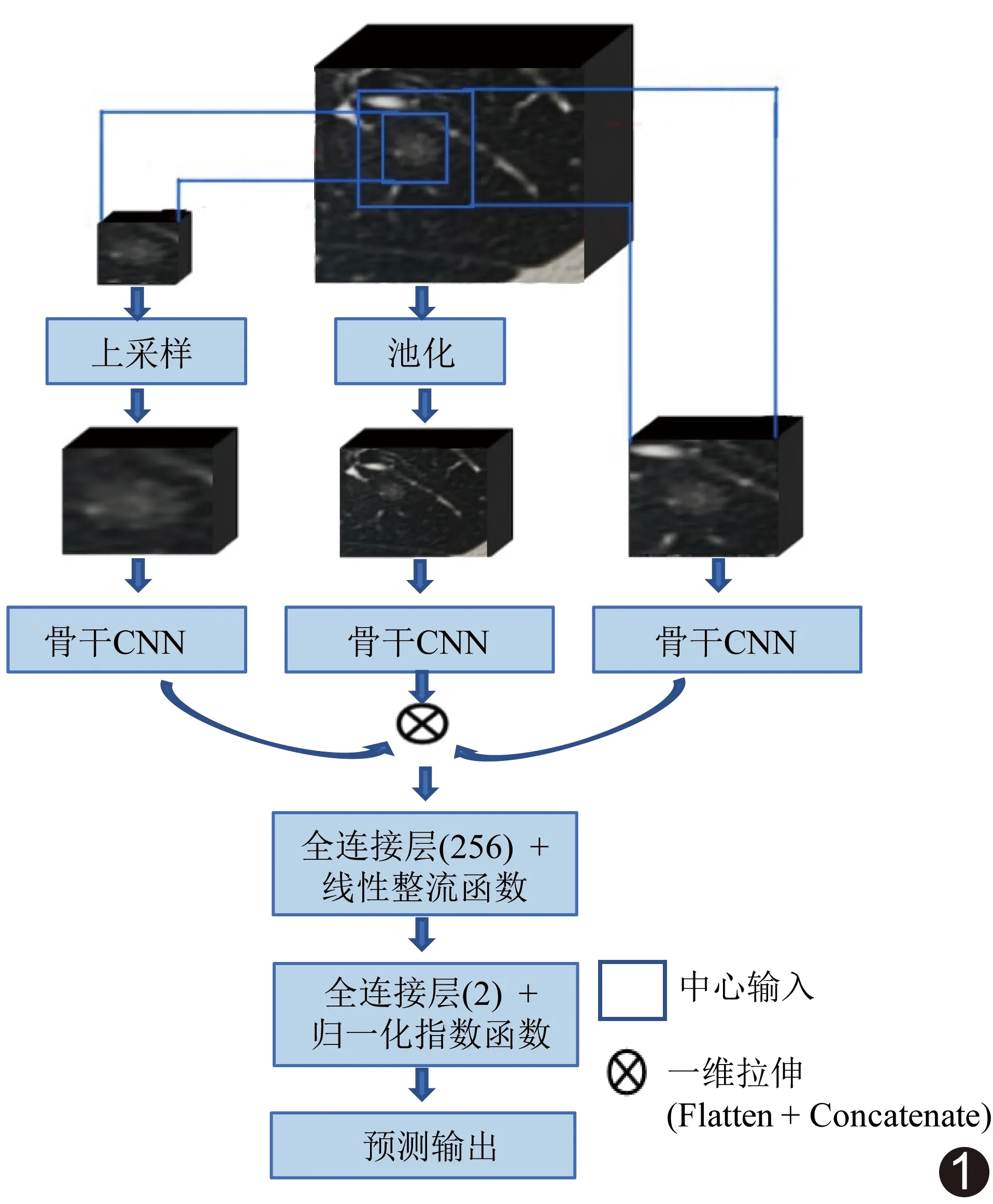

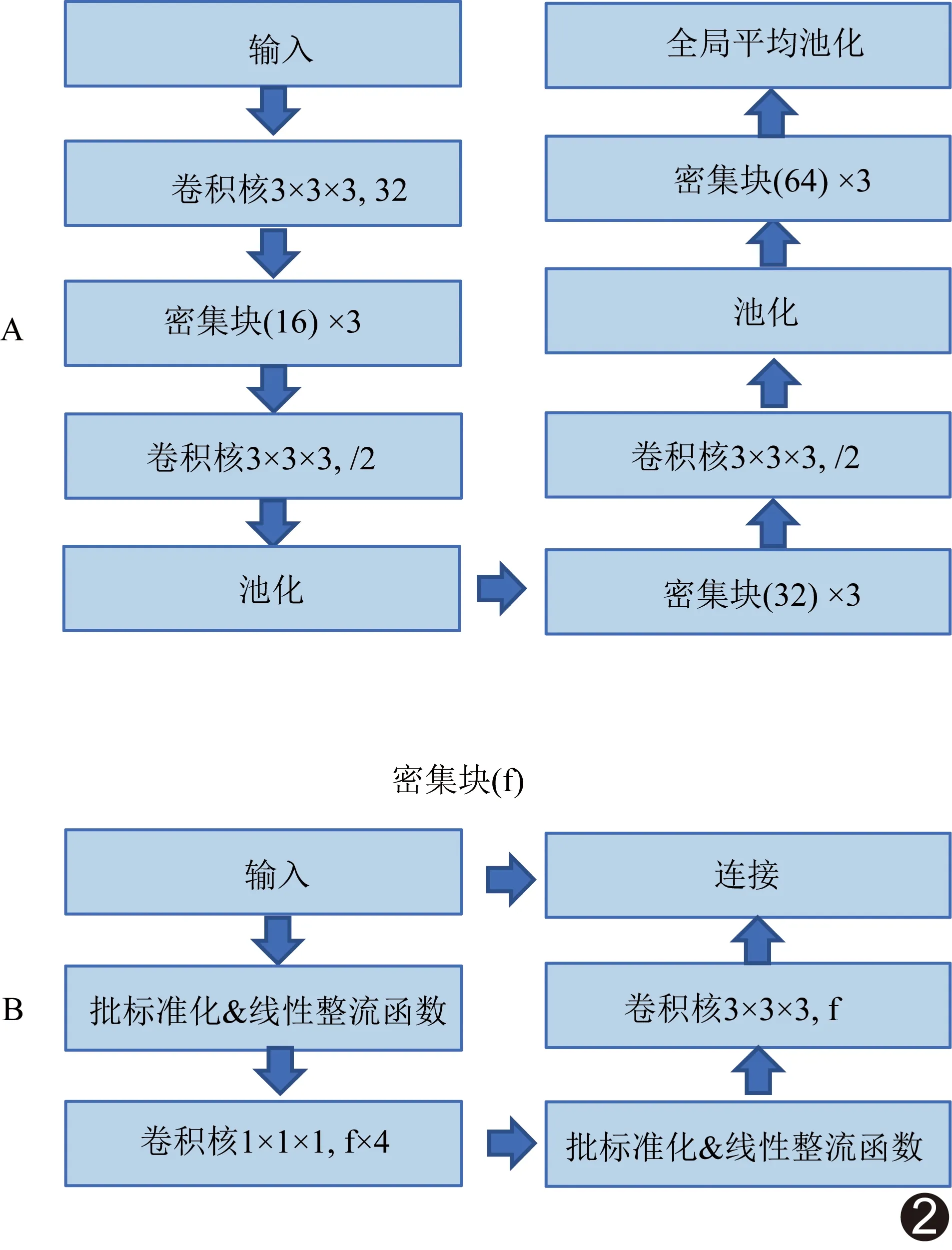

1.4 训练CNN分类模型 采用开源软件Keras库构建CNN模型,其多尺度CNN架构由3层分支组成(图1),各分支图像输入中心相同而大小不同,分别为72 mm×72 mm×72 mm、36 mm×36 mm×36 mm及18 mm×18 mm×18 mm。通过池化和/或上采样操作将所有图像统一调整为72×72×72体素。将归一化后图像分别传递至骨干网络进行级联,再传递至全连接层和线性整流单元,通过归一化指数函数激活输出层,获得每个类别的概率。骨干网络为CNN架构的关键组成部分,常以一系列具有不同数目滤波器的卷积块组成基础骨干网络,建立多个密集块组成的密集型骨干网络(图2A),每个骨干网络由3个密集块组成,每个密集块含4f个1×1×1卷积核和f个3×3×3卷积核,采用“瓶颈”技术串联卷积核的输入特征和输出结果(图2B)。以CNN分类模型对验证组进行验证。

图1 多尺度CNN架构由3层分支组成,分支以给定结节为中心输入图像,具有不同尺寸,以最大池化和上采样操作将其调整为统一的72×72×72体素

图2 骨干网络示意图 A.密集型骨干网络示意图;B.密集块构成示意图

1.5 放射科医师评估效能 由1名具有3年影像学诊断经验的住院医师整理并提供验证组GGN在CT图像中的位置列表;再由分别具有6年及8年影像学诊断经验的主治医师1及2(非胸部影像学专长)根据结节位置独立评估其为PIL或IA的可能性,并设定五个信心级别,即:肯定是PIL、可能是PIL、不确定、可能是IA以及肯定是IA。

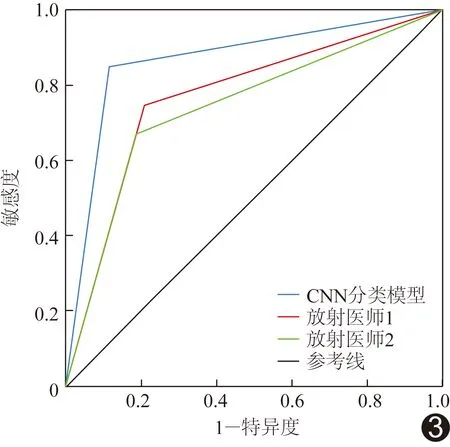

1.6 统计学分析 采用SPSS 20.0统计分析软件。将“肯定是IA”和“可能是IA”置信水平视为阳性结果,将其他水平视为阴性结果。绘制受试者工作特征(receiver operating characteristic,ROC)曲线,比较CNN分类模型及2名放射科医师鉴别验证组PIL与IA的效能,获得其曲线下面积(area under the curve,AUC)、敏感度、特异度和总体分类准确率。以χ2检验比较CNN分类模型与放射科医师诊断敏感度及特异度的差异。P<0.05为差异有统计学意义。

2 结果

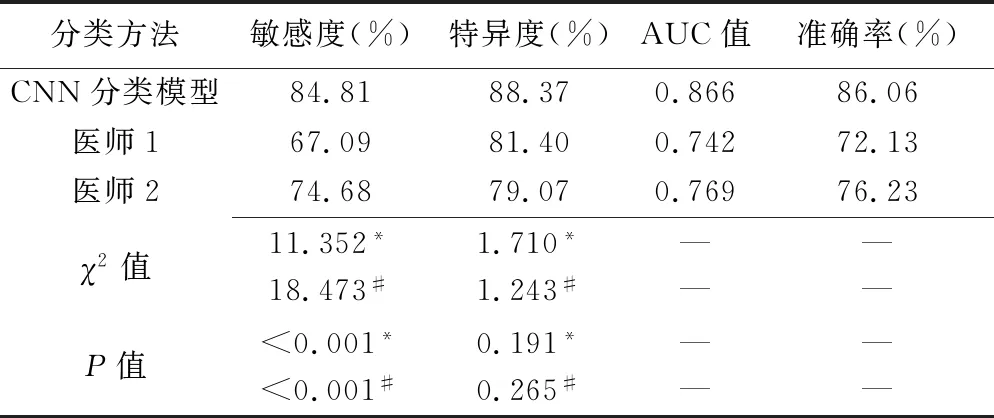

ROC曲线(图3)结果显示,CNN分类模型、医师1及2鉴别验证组PIL与IA的AUC分别为0.866、0.742及0.769,敏感度分别为84.81%、67.09%及74.68%,特异度分别为88.37%、81.40%及79.07%。CNN分类模型的诊断敏感度显著高于医师1(P<0.001)、2(P<0.001);CNN分类模型诊断的特异度与医师1、2差异均无统计学意义(P均>0.05),见表1。

表1 CNN分类模型与2名医师鉴别验证组GGN为PIL或IA的ROC曲线结果

图3 CNN分类模型与医师1、2鉴别PIL与IA的ROC曲线

3 讨论

治疗PIL的方式与IA有所不同,故早期发现GGN并以无创方法有效鉴别其为PIL或IA对患者生存及预后具有重要价值[10-12]。本研究建立CNN分类模型,将GGN分类为PIL与IA,其AUC、总体分类准确率及敏感度均高于2名放射科医师,提示其诊断效能可能较初、中级放射科医师更高,具有良好临床应用前景。本研究构建CNN分类模型的诊断敏感度及总体分类准确率比传统机器学习算法[11]更佳,逻辑回归敏感度为81.1%、总体分类准确率为81.5%,随机森林的敏感度为80.7%、总体分类准确率为83.0%,决策树的敏感度为72.8%、总体分类准确率为76.7%,而AdaBoost算法的敏感度74.4%、总体分类准确率82.1%。

既往研究基于高分辨率CT[10,12,15-16]或放射组学[17-19]预测早期肺腺癌浸润程度,其所提取的CT征象及放射组学信息均依赖人为预处理、CT征象及放射组学信息分析,导致再现性降低。基于CNN的DL分类模型直接来自CT图像中学习预测特征的成像信息,简化多级分析流程,且可重复性更高。本研究中CNN分类模型的总体分类准确率与上述研究相似或更高,表明CNN分类模型可于未预先提取特定征象或信息的情况下实现较准确的PIL与IA分类,具有良好的临床实用性、重复性和普及性。此外,本研究结果显示,CNN分类模型的敏感度显著高于2名放射科主治医师,提示CNN分类模型对于准确评估GGN中的IA表现更佳,更有利于临床及时干预和处理IA患者。本研究中的2名放射科医师均为中级职称,其专长并非胸部影像学诊断,亦未曾专注于研究肺磨玻璃样腺癌或接受相关专业培训,仅根据既往工作经验自行分析判断分类结果,导致诊断敏感度较低。采用CNN分类算法不仅可充分利用多维度DICOM数据信息,还能通过学习肺腺癌浸润程度分类中更多未知关键特征信息来充当记忆网络,从而对GGN分类更加稳定,并可及时调整学习策略而更加灵活智能,对分类较疑难GGN亦能保持较高准确性,弥补青年医师诊断经验的不足。

本研究CNN分类算法的主要缺陷是数据本身及数据量不足问题。理想情况下,应采用相同扫描参数采集所有CT数据,但在实践中难以实现。为此本研究在算法训练过程中采用多种数据处理方式,如翻转、缩放、平移和旋转等,以尽量降低数据异质性。此外,本研究数据仅来自两家医疗机构,具有一定局限性,有待多中心采集数据,进一步增强模型的泛化能力和鲁棒性,提高CNN分类模型的敏感度和总体准确率。

总之,CNN分类模型对GGN分类为PIL与IA的效能优于放射科主治医师,有望为临床鉴别诊断GGN提供新的智能化辅助手段。