基于分布式强化学习算法的精准助学数据分析方法研究

邢文娜,宁睿

(西安航空职业技术学院,陕西西安 710089)

随着我国经济的发展,人们的生活水平逐渐提高,然而仍有相当一部分群体处于生活较为贫困的状态[1-3]。在高校中同样存在一定数量的贫困学生,尤其是高等教育体制改革、高校扩招后,贫困生所面临的问题进一步凸显。为了改善贫困学生的生活水平,国家开展了多种形式的助学计划。

然而,高校扶贫对象的确认主要依靠学生申请、班级成员与辅导员评估的模式,存在编造虚假申请材料与舞弊的现象。同时由于部分贫困学生害怕受到歧视,申请积极性较低[4-7]。这些具体情况均会导致助学金无法真正惠及需要帮助的学生,因此,开展高效、合理、智能的贫困生确认方法成为当前高校扶贫工作的重点之一[8]。

随着大数据技术与深度学习技术的不断发展,深度挖掘学生的在校消费数据成为了可能[9-11]。利用经过人工标注的、有监督训练的模型,可自动识别与判断该学生是否具有贫困生的特征。文中利用深度学习的RBF 神经网络技术与分布式强化学习技术,分别将预处理过的学习消费数据聚类和分析,构建基于分布式强化学习的精准助学数据分析算法。

1 精准助学数据分析方法框架

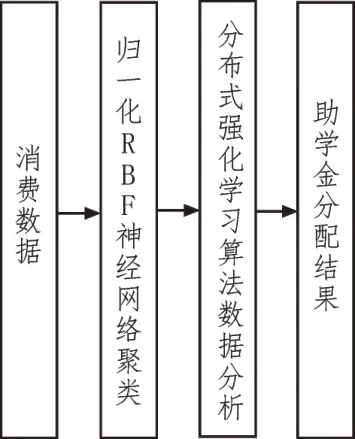

为精准识别学生的贫困程度,文中通过对学生在校园内产生的各项消费数据进行采集与分析,并通过分布式强化学习来深层次挖掘学生的消费习惯。进而对学生的消费能力进行排序,以此为依据进行助学金的分配。具体结构框架如图1 所示。

图1 基于分布式强化学习助学金分配结构框架

归一化RBF 神经网络聚类可将各个消费场景产生的数据提取特征向量,RBF 神经网络是一种三层无监督神经网络[12]。文中将其改进,设置多层隐藏层,并进行归一化,以实现将低维度的数据转化为高维度的向量,从而将低维度的线性不可分问题转化为高维空间的线性可分问题。

分布式强化学习是在行动与评价中学习知识,从而改进行动方案,来适应周围环境,并最终实现目标的过程。试错搜索与延迟回报是强化学习最大的特点,其基本模型如图2 所示。当智能体做出某个行为动作时,环境因该行为动作产生状态变化,同时反馈给智能体一个奖励信息。智能体根据当前环境状态及反馈回的奖励信息来选择下一个动作,而动作选择的标准是让得到奖励信息的概率增大。

图2 基于分布式强化学习助学数据分析结构框架

2 精准助学数据分析方法

2.1 精准助学数据来源

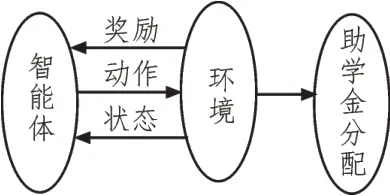

精准助学数据分析算法除了需要有先进的算法,还需要有合适的数据来源作为分析材料,图3 为精准助学数据来源及预处理示意图。使用大数据技术可以从学生在校园区域内产生的各项消费数据分析该学生的消费能力、消费习惯等信息,进而量化学生的贫困程度,精准筛选贫困生。随着数字化与智能化应用在校园的推进,使得学生的某些行为被记录下来。餐厅、图书馆、超市、澡堂、洗衣房及校园内代步车等场所或设备均有相应的终端可以采集到学生的消费信息与充值信息,通过中心化数据库将这些信息收集并处理,即可成为分析学生消费习惯、贫困程度的原始数据。

图3 数据来源及预处理示意图

原始数据虽能表征学生的消费能力与消费习惯,但其存在大量的无效数据。因此,在进行数据挖掘前需要对原始数据进行预处理。数据预处理包含:数据清洗、数据补充以及衍生变量的计算,数据清洗是指针对数据采集终端同一消费行为重复采集数据、数据记录异常等情况进行无效数据的过滤及清除,以降低数据量;数据补充是针对数据采集终端因故障等原因未能采集到数据的现象,通过数据中心的数据对比来补充相关消费信息;衍生变量是指利用原始数据计算得到其他相关指标,涉及的指标有总消费次数、总金额、食堂消费金额、超市消费金额等。

2.2 多Agent系统分布式强化学习

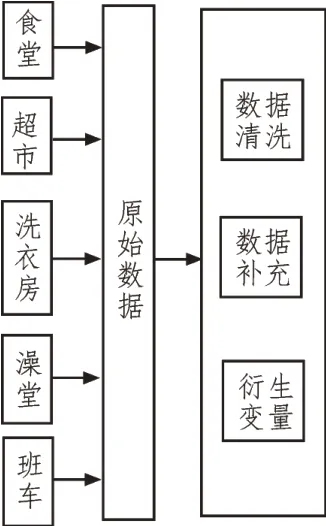

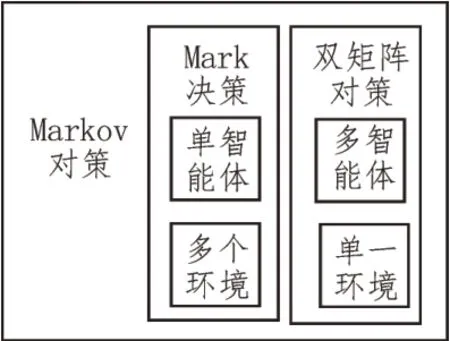

随着数字化校园的推进,越来越多的智能体被使用,由此产生的消费数据可用来分析各个学生的消费能力、行为习惯等信息。由食堂、洗衣房、澡堂等组成多智能体协作系统在解决实际问题时,群体强化学习算法可实现较优的效果,各个智能体之间的交互可使用对策模型来进行表述。Markov 对策是对传统Markov 决策的改进和优化,将其变成由多个参与者参加的分布式决策过程,并将多步对策看作是随机发生的。Markov 对策框架如图4 所示,是Mark 决策与双矩阵对策的组合。Mark 决策是一种单个智能体、多个环境的模型,而双矩阵对策是多个智能体、单个环境的模型。通过两者的结合,可认为Markov 对策是多个智能体、多个环境的模型[13-14]。

图4 Markov对策框架结构示意图

Q 学习是多智能体领域内应用最广泛的强化学习算法,将Q 学习算法从单个智能体扩展到多个智能体时,可以将所有智能体的联合动作代替单个智能体的动作。在多智能体系统内,使用Bayesian 网络可建立各个智能体之间的相互关系。该相互关系可用联合概率分布进行表征,联合概率越大,表明智能体之间的紧密耦合程度越高。由于各个智能体在选择行为动作时通常依据某种策略,在概率学上表现为智能体在某状态下选择的动作是服从一定概率分布的随机行为。因此研究某智能体的行为时,可通过研究其他智能体历史行为,学习其行为选择策略并建模,由此确定该智能体的最佳响应。某智能体在进行行为选择时,可通过其他智能体所选择动作的先验概率,在Bayesian 网络的基础上推导相应的后验概率,即确定行为选择策略[15-16]。

2.3 精准助学数据分析模型

学生的消费行为是动态行为,通过长时间的数据收集、分析可以更加准确地分析学生的经济状况,因此贫困生的筛选与认定应当是动态的过程。文中使用分布式强化学习来实现动态数据分析模型的建立,可将瞬时优化目标函数转化成长期的优化目标。当数据与数据库中已存在消费行为相似时,智能体可根据学习到的知识直接得到与当前消费行为相近的结果,避免重复计算。

动态模型可以化简为MDP 过程,其定义如下。

式中,S代表消费状态集合;A代表助学奖金的发放;P代表转移概率矩阵;r代表奖赏函数。消费状态集合是指所有学生消费状态的集合,为了方便后续计算,需要按照一定的规则表示成向量。定义集合如式(2)所示。

其中,p(t)表示每天的消费金额;h(t)表示每天的消费次数;Sm(t)表示第t天学生账户余额状态。文中,转移概率被视为未知量,可使用免模型学习算法Q-learning 来求解。

由于学生在校园中存在多个消费场景,在这些场景中,学生的消费习惯应该是统一的,因此需要联合动作学习。在此设定下,强化学习算法认为智能体可通过相互观察,来获取彼此所选择的行为与相应的报酬等信息,进而维护自身的Q函数。此时,所有智能体的Q值将组成一个对策集合Q1(st),…,Qn(st)。因此,值函数可被表示为式(3):

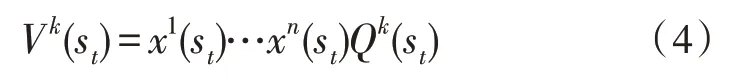

相应的,令Nash 平衡的解为x1(st),…,xn(st),则值函数可进一步表示为式(4):

值函数得到更新后,Q值亦随之改变。更新规则如式(5)所示。

通过以上分析,精准助学数据分析算法的过程如下:

1)将状态访问次数初始化,设置n(s)为0,对于任意状态及任意动作行为,其平衡解的概率值为x(s,ak)=1/|A|;

2)智能体k通过观察其他智能体来预测联合动作概率x(s,a1,…,an),并以此来选择最优策略x(s,ak);

3)在选择行为动作时,智能体k通过独立学习来更新自身行为的概率分布,依据概率x(s,ak)选择下一动作;

4)智能体k根据Bayesian 公式来调整其他智能体的动作选择信念,并更新Q值;

5)令n(s+1)=n(s)+1,返回步骤2)继续循环。

3 测试与验证

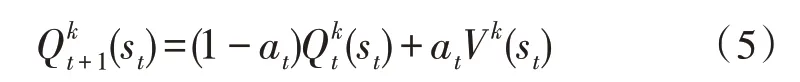

为了验证文中所述方案的有效性与可行性,使用某高校312 名学生的一卡通消费数据进行验证。经过预处理后的部分数据,如表1 所示。预处理后的数据涉及各个消费场景的消费次数、单次消费最大值、中位值。从中选择3/4 作为训练数据,使得归一化RBF 神经网络与分布式强化学习模型的各个网络参数可以精准地识别数据背后的规律性。其余数据作为测试数据,以检验文中所提出的精准助学数据分析方法的准确率。

表1 每月学生各项消费数据(预处理后)

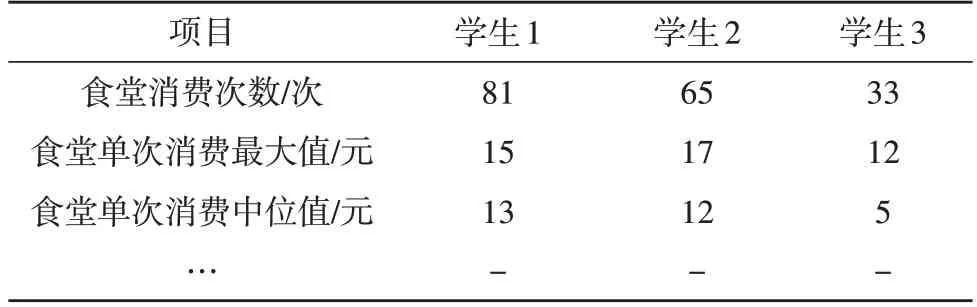

首先,使用训练模型进行归一化RBF神经网络的隐藏层层数与神经元个数的确认。从图5 中可以看出,隐藏层层数的增加会显著提高聚类准确率增长的速度,在神经元较少的情况下仍可实现较高的准确率。而神经元个数的增加同样会提高聚类准确率,但当神经元个数增加到一定数量时,准确率趋于固定值。综合神经网络运行时间及聚类准确率,归一化RBF神经网络被设置为3层隐藏层,每层各30个神经元。

图5 不同隐藏层层数及神经元个数对聚类准确率结果对比

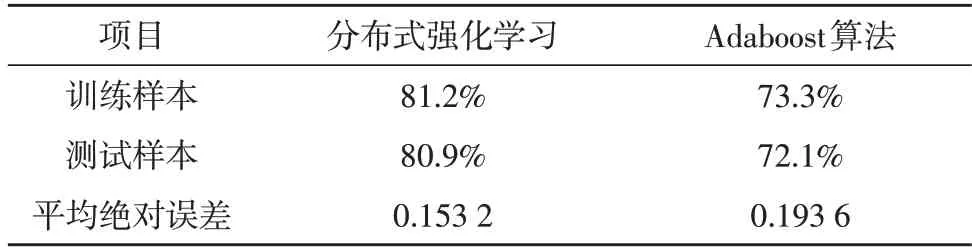

其次,通过设置对照组的方式来验证分布式强化学习算法的有效性。实验组采用文中所述的分布式强化学习算法模型,对照组采用Adaboost 算法进行贫困生的认定。两组均采用相同的已清洗数据,使用相同配置的计算机平台进行验证。针对文中采用的分布式强化学习,相应仿真参数为:学习率为0.8,折扣系数为0.9。Adaboost 算法采用多个弱分类器进行分类以提升学习精度,每个弱分类器的权重不同,通过微调各个权重值来提高分类准确度。文中所述方案与Adaboost 算法的识别结果对比,如表2所示。从表2 中可以看出,无论是训练数据或是测试数据,文中所述方案的识别准确率均比Adaboost算法高。同时分布式强化学习的平均绝对误差为0.153 2,较Adaboost 算法低。这是由于分布式强化学习中各个智能体在选择行为动作时,会通过观察与学习其他智能体的行为策略,避免进行更多的试错行为,提高了学习效率且加快收敛速度。

表2 分布式强化学习与Adaboost算法识别结果对比

4 结束语

文中使用分布式强化学习与归一化RBF 神经网络进行了精准助学数据分析技术的研究,通过合适的隐藏层层数与神经元个数的选择来提高归一化RBF 神经网络的聚类准确率。同时采用分布式强化学习进一步挖掘学生消费数据的内在逻辑关系,通过对智能体在面对系统状态所采用的行动进行奖励或惩罚,进而改善学习策略的效率。经过测试,文中所述方案在贫困生的识别方面具有80.9 %的准确率,与Adaboost 算法相比更适合高校贫困生的认定。