采用双重注意力特征金字塔网络检测群养生猪

胡志伟,杨 华,娄甜田

·农业信息与电气技术·

采用双重注意力特征金字塔网络检测群养生猪

胡志伟1,2,杨 华1※,娄甜田3

(1. 山西农业大学信息科学与工程学院,太谷 030801;2. 山西大学计算机与信息技术学院(大数据学院),太原 030006;3. 山西农业大学农业经济管理学院,太谷 030801)

为解决复杂环境下,猪只粘连和猪栏遮挡等因素给生猪个体多目标实例检测带来的困难,该研究以群养猪圈场景下8栏(日龄20~105 d)共计45头生猪为研究对象,以视频为数据源,采用平视视角、镜头位置不固定的数据采集方式,共获得标注图像3 834张,并将其划分为训练集2 490张、验证集480张、测试集864张。引入一种融合通道注意力(Channel Attention Unit,CAU)与空间注意力(Position Attention Unit,PAU)的双重注意力单元(Dual Attention Unit,DAU),并将DAU用于特征金字塔网络(Feature Pyramid Network,FPN)结构中,研究基于两大骨干网络ResNet50、ResNet101与4个任务网络Mask R-CNN、Cascade Mask R-CNN、MS R-CNN及HTC(Hybrid Task Cascade)交叉结合模型对群养生猪实例检测性能。结果表明:与CBAM、BAM、SCSE等注意力模块相比,HTC-R101-DAU比HTC-R101-CBAM在IOU阈值为0.5、0.75、0.5~0.95(所有目标)、0.5~0.95(大目标)条件下的4种AP(Average Precision)指标分别提升1.7%、1.7%、2.1%与1.8%;单独加入CAU与PAU以分别探究通道与空间注意力单元对任务网络检测性能影响,试验结果表明,DAU与CAU及PAU相比性能更佳,且加入特定串联数量的PAU效果优于CAU;为获取更为丰富的上下文信息,分别串联1~4个PAU单元以构建不同空间注意力模块,试验结果表明,随着串联PAU单元数量的增加,相同任务网络其预测AP指标值先增加后减小。综合分析,HTC-R101-DAU模型可更为精确、有效地对不同场景生猪进行实例检测,可为后续生猪个体深度研究奠定基础。

图像处理;目标检测;算法;特征金字塔;通道注意力;空间注意力

0 引 言

集约化饲养环境中,生猪养殖密度的不断增加大大增加感染病患风险,加大猪瘟防控难度。机器视觉技术能够提供低成本、非接触式监测方法,对生猪个体进行精准快速检测有助于构建养殖可追溯系统,并及时发现异常行为,降低疾病发生率[1-3]。但猪栏内光线变化复杂、群养猪易挤踏堆叠,猪只粘连以及杂物遮挡等客观因素给生猪个体检测带来较大困难,因而多干扰场景下快速且准确地检测出生猪目标是亟需解决的关键问题。

卷积神经网络CNN(Convolutional Neural Network)[4-5]作为特征提取器,已在小麦[6]、玉米[7]、葡萄[8]、牛[9-10]等目标领域得到广泛应用。在生猪个体研究领域,其已在图像分割[11-12]、目标跟踪[13]、行为识别[14-15]、姿态类别识别[16]等方面得到广泛研究。对于生猪个体检测,燕红文等[17]基于特征金字塔注意力与YOLOV3[18]结合用于群养生猪检测;沈明霞等[19]提出基于YOLOV3的目标检测算法,用于对个体较小、易粘连的仔猪个体进行识别;刘岩等[1]结合双线性SVM与CNN进行多目标生猪检测;但上述基于CNN的检测方法仅将生猪个体从养殖环境中分离出来,不能检测出一张图片中同类物体的不同个体,而实例级检测可对同类物体中的不同个体进行有效区分,其更适用于诸如生猪目标跟踪、运动量统计等伴有身份性识别的下游检测任务,应用前景更为广泛。He等[20]提出的Mask R-CNN模型可对粘连生猪图像进行高精度实例分割与检测,且已在生猪实例分割任务上取得较多研究成果。Tu等[21]提出基于Mask Scoring R-CNN[22]的群养生猪实例分割;李丹等[23]基于Mask R-CNN构建猪只爬跨行为实例分割模型,实现94.5%识别准确率;高云等[24]在深度卷积神经网络的基础上建立PigNet网络,对群养生猪图像进行实例分割,实现对猪体的分辨和定位。但上述实例分割方法仅将Mask R-CNN应用于生猪领域,而实例分割方法本身兼备实例检测的功能。为此,本文选用Mask R-CNN等实例分割方法探讨其在生猪实例检测任务上的适用性,而在生猪群养环境下,粘连生猪个体的猪鼻、猪蹄等细节部位信息存在独特性,对生猪区别性部位特征进行强化可更好地细化检测边界。注意力机制在筛选特征时,能够提升利于实例检测的区域信息权重,抑制次要信息以提升模型效果,且已在多个领域取得不错效果,可用于生猪区别性部位信息强化。Tong等[25]将通道注意力思想用于DenseNet[26]中对遥感图像场景分类;Yang等[27]提出双重空间注意力对虹膜进行识别;Huang等[28]提出交错空间注意力在减少计算量的同时提升语义分割精度。但上述基于注意力机制的研究仅单独使用通道或空间注意力信息,为能充分融合两种注意力信息,CBAM(Convolutional Block Attention Module)[29]、BAM(Bottleneck Attention Module)[30]、SCSE(Spatial and Channel Squeeze & Excitation)[31]、DANet(Dual Attention Network)[32]等注意模块对特征图从通道和空间维度分别进行建模,但上述同时融入两种注意力思想的方法仅单纯对特征提取网络的最终输出特征图进行注意力筛选,对于特征提取网络中不同感受野大小的信息并未进行对应注意力提取,而感受野不同其所关注的区域大小不同,对其进行不同注意力筛选将能有效改善多尺度大小目标的检测精度。基于此,本文将Fu等[32]提出的通道注意力与Huang等[28]提出的空间注意力融合嵌入特征金字塔网络中,对群养环境下的生猪进行实例检测。

本研究通过融合通道与空间注意力构建双重注意力模块,并将其引入特征金字塔网络对深度分离、杂物遮挡、高度粘连等不同场景下的群养生猪个体进行非接触、低成本实例检测。为验证引入双重注意力模块金字塔网络的检测性能,分别对比分析其在不同骨干网络与任务网络的应用效果。同时,通过对比试验,确定最合适的空间注意力单元。本研究以期通过不同场景下的生猪个体实例级检测,为生猪行为分析奠定基础。

1 试验数据

1.1 试验数据来源

试验数据分别采集于山西省汾阳市冀村镇东宋家庄村(2019年6月1日9:00-14:00,天气晴,温度23~29 ℃,光照强烈,室外环境)与山西农业大学实验动物管理中心(2019年10月13日10:30-12:00,天气多云,温度10~19 ℃,光照偏弱,室内环境),选取大白、长白及杜洛克混养品种猪作为拍摄对象以检验模型对多品种生猪的实例检测性能。2个猪场猪栏长×宽×高分别为3.5 m×2.5 m×1 m和4 m×2.7 m×1 m,每栏生猪数量3~8只不等,每个猪场选取4栏共计8栏日龄20~105 d的群养生猪合计45头作为试验对象,采用佳能700D防抖摄像头拍摄,每栏选取2段时长超过30 min的视频以保证数据源的连贯性。

1.2 数据采集方式

对生猪个体行为及目标状态的相关研究[11,14,23]多采用将摄像头固定于猪栏顶端,拍摄俯视视频的数据获取方式。与此不同,本文采用平视视角、镜头位置不固定的方式进行数据采集,可弥补俯视方式不足:1)获取的图像可有效捕捉富含生物学信息的生猪脸部、蹄部等关键部位;2)生猪与镜头间的距离易于调控,可获取多条件变化数据;3)平视视角与人类观察动物的视角一致,所采集的数据更适配于移动端应用。以山西农业大学实验动物管理中心为例,其数据采集平台如图1所示。

群养生猪具有活动轨迹可控性差、分散或粘连性强的特点,为获取距离镜头远近不同生猪个体,摄像机距离猪栏0~0.3 m不等。为获取不同水平视角生猪图像,摄像机三脚架距离地面的高度为0.5~1.3 m不等。

1.3 试验数据预处理

对采集的视频进行与刘坤等[3]一致的数据预处理过程,通过检测框标注、放缩操作、数据增强获得最终实例检测数据集,如图2所示。

1)对视频切割所获取的图像进行像素填充,并采用LabelMe进行实例检测框标注,同时考虑到Cascade Mask R-CNN、MS R-CNN以及HTC模型均利用分割信息作为辅助以增强内容表征,同时对分割信息也进行了标注;

2)进行放缩操作,将对步骤1)获取的图像分辨率由2 048×1 024降为512×256;

3)采用与刘坤等[3]一致的数据增强操作,最终共获得标注图片3 834张,将其划分为训练集、验证集与测试集,其中训练集大小为2 490张,验证集大小为480张,测试集大小为864张。

2 生猪实例检测模型

2.1 任务模型

Mask R-CNN[20]由骨干网络(backbone,如ResNet[4]系列网络)、特征金字塔网络(Feature Pyramid Network,FPN)[34]、区域提交网络(Region Proposal Network,RPN)[33]、ROIAlign[33]及功能性输出5部分组成;Cascade Mask R-CNN[35]改进自Mask R-CNN,其通过串联多个不同的IOU(Intersection over Union)[36]阈值头部网络以不断优化分割细度;Mask Scoring R-CNN[22](简称MS R-CNN)改进自Mask R-CNN,其通过引入MaskIOU[22]模块提升对杂乱、遮挡等复杂条件下目标位置预测精准度;HTC[37]改进自Cascade Mask R-CNN,其通过引入语义分割分支以增强空间内容表征,提升预测边框精确度。上述Mask R-CNN、Cascade Mask R-CNN、MS R-CNN与HTC方法在开放领域常被用于实例分割,而在模型学习过程中,实例分割与实例检测任务相辅相成,因此4种模型均可用于实例检测领域。

2.2 加入双重注意力单元的FPN

卷积网络在特征提取过程中,低阶特征更关注位置信息,但其缺乏语义鉴别能力,而高阶特征更利于语义区分,但位置判别能力不足。特征金字塔网络(Feature Pyramid Network,FPN)[34]可用于解决高低阶特征图中语义与位置信息间的矛盾,实现对高低阶不同尺度特征有效融合。传统FPN由自底向上(Bottom-up)、自顶向下(Top-down)以及阶段输出(Stage-output)3个部件组成(如图3所示)。对于每个Bottom-up部件块,0.5×表示下采样操作,该操作可将特征图分辨率降为原来的一半;对于Top-down部件块,2×表示上采样操作,其可将特征图大小扩为原先的2倍,将上采样结果与同级Bottom-up输出按位相加可得到对应层级输出。

传统FPN结构中,对于同级Bottom-up与Top-down部件仅通过简单线性叠加方式进行融合,这种操作未能整合特征图间的非线性关系。而注意力机制可对特征图内部不同位置特征施以差异性权重值,有选择性地激活任务相关区域,抑制次要信息以提升模型效果。为此,本文引入带有双重注意力单元(Dual Attention Unit,DAU)的FPN结构模块,其具体操作模块如图3所示。

DAU由非对称卷积块(Asymmetric Convolution Block,ACB)与双重注意力块(Dual Attention Block,DAB)两部分构成。对于某层Top-down部件特征图h(高阶特征)与相同层Bottom-up部件特征图l(低阶特征),执行下述操作得到该层FPN输出:

1)对h与l特征图按位相加得到输出merge;

2)为充分将高低阶特征间的非线性关系引入融合特征图中,受Ding等[38]启发构建ACB模块,对merge进行3路大小分别为3×3、1×3与3×1的非对称卷积与Relu激活函数操作,该操作能在不引入任何超参数条件下改善特征图对翻转和旋转的鲁棒性。将上述处理结果定义为ACB作为后续模块输入。

3)特征图中的每个通道映射可视为对某一特定类别的响应,且不同语义响应间彼此相互关联。为充分利用通道映射间的依赖关系以增强通道间的特征映射,在FPN结构中引入了Fu等[32]提出的通道注意力单元(Channel Attention Unit,CAU)以显式建模通道间的依赖性,如图3中CAU模块所示。

4)为生成密集、逐像素的上下文信息,在FPN结构中引入Huang等[28]提出的位置注意力单元(Position Attention Unit,PAU)对单特征图中所有像素点进行加权得到位置注意力图,以引导原始特征图进行位置选择生成包含密集上下文关联的特征图,如图3中PAU模块所示。

5)将通道与位置维度注意力信息作用于ACB特征图进行重校准,并将CAU与PAU校准叠加结果DAB与merge融合得到最终DAU模块输出DAU。

本文在FPN的Top-down与Bottom-up同层级部件块信息融合过程中引入ACB非对称卷积信息与DAB注意力信息,通过两次线性转非线性操作的方式对高低阶特征进行深度融合,并利用FPN结构自身优势,在不同感受野大小特征图上执行对应特征重校准,能够深度利用高低阶信息,进一步提升检测效果。

3 试验平台参数及模型评价指标

3.1 试验平台参数

试验平台配置为16 GB Tesla V100 GPU,采用mmdetection框架进行代码编写。考虑到显存大小限制,将批大小设置为8,设置迭代轮数为50。采用SGD作为优化器,初始优化器学习率设置为0.02;设置正则化权值衰减系数weight_decay为0.0001,设置动量因子momentum为0.9,以避免模型陷入局部最优解或跳过最优解;与mmdetection框架配置一致,对原始图像3通道值进行均值(123.675, 116.28, 103.53)、方差(58.395, 57.12, 57.375)的归一化处理。对于Mask R-CNN 任务网络,设置IOU阈值为0.5、score阈值为0.5,对于Cascade Mask R-CNN任务网络,其3个级联网络IOU阈值分别设置为0.5、0.6与0.7、score阈值为0.5。采用COCO相关指标进行模型优劣评价。

3.2 模型评价指标

采用检测精度AP(Average Precision)作为评价标准。AP表示精确率-召回率(Precision-Recall)曲线下方面积,其公式化表示如式(1)~(3)所示。因为选用不同的IOU阈值直接影响TP(True Positive)与FP(False Positive)值,而TP与FP值进一步影响Precision与Recall大小,进而给AP指标值带来波动,选用AP0.5(阈值为0.5),AP0.75(阈值为0.75),AP0.5~0.95(阈值以0.05为步长在0.5与0.95间选取10个数)3种AP指标衡量不同条件下检测性能。同时考虑到生猪个体占图像比例大小差异性问题,将生猪大小分为小目标(生猪区域面积<322像素)、中等目标(322像素<生猪区域面积<962像素)与大目标(生猪区域面积>962像素),并在IOU阈值为0.5~0.95间计算大目标条件下的AP指标值,记为APL。

式中TP表示模型预测为生猪类别框且真实标记也为生猪框的样本数量,FP表示模型预测为生猪框但真实标注并非为生猪框的样本数,FN(False Negative)表示预测为杂质背景但真实标注为生猪框的样本数量,d表示积分变量。

4 结果与分析

4.1 加入不同注意力模块后不同任务网络效果

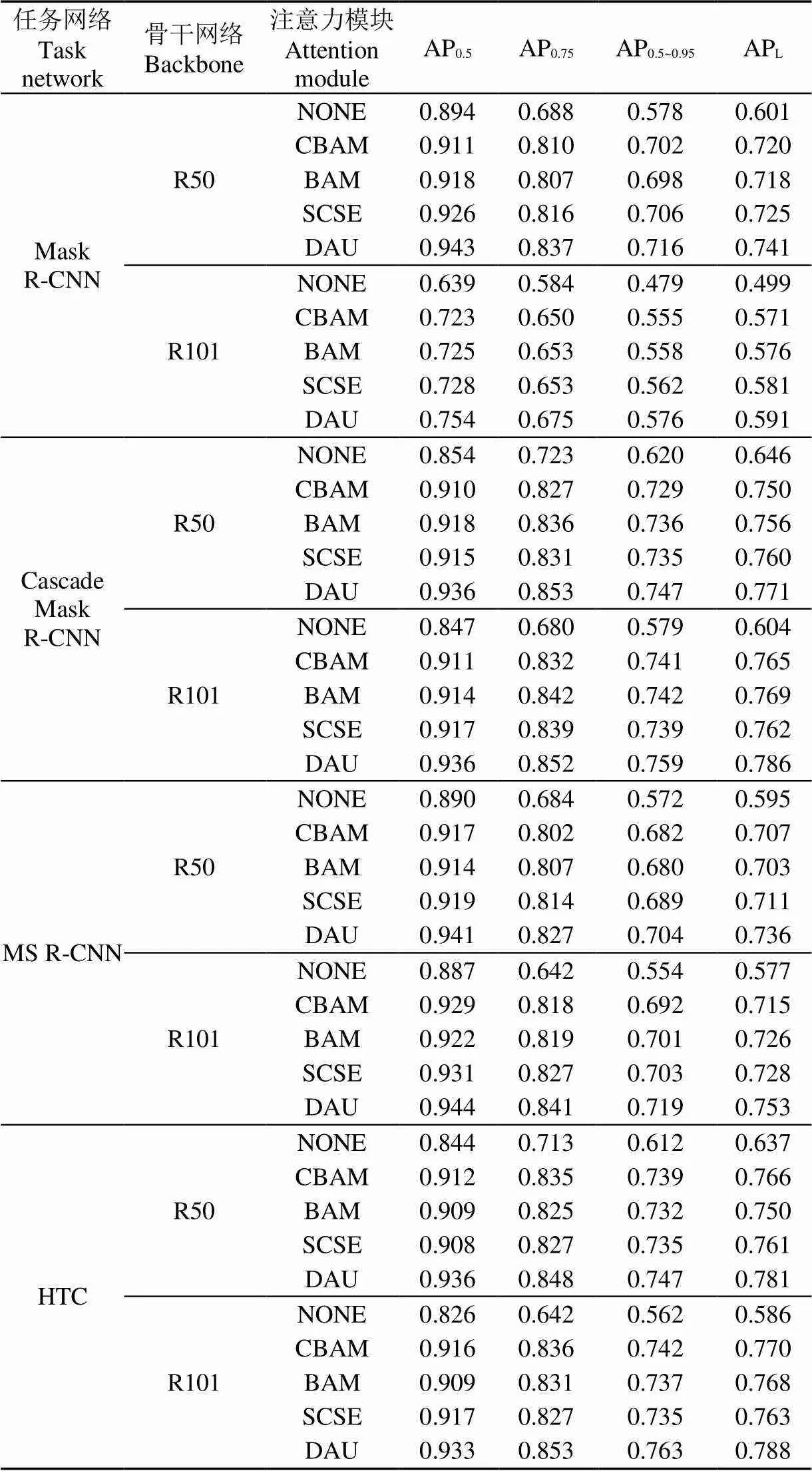

选用ResNet50[4]和ResNet101[4]作为特征提取器以探究不同骨干网络性能影响状况,在特征筛选过程中均引入FPN结构,并将结果作为Mask R-CNN、Cascade Mask R-CNN、MS R-CNN以及HTC任务网络输入;为探究不同注意力模块对任务网络检测结果影响以寻找最适用于群养生猪实例检测的注意力模块,在FPN结构中引入现有表现最优且同时包含通道与空间注意力信息的CBAM[29]、BAM[30]以及SCSE[31]模块与本文提出的DAU单元进行相同试验条件下各AP指标值对比,结果如表1所示。其中对于CBAM模块分别使用CAM(Channel Attention Module)与SAM(Spatial Attention Module)子模块替换图3中的CAU与PAU单元;对于BAM模块分别使用CAB(Channel Attention Branch)与SAB(Spatial Attention Branch)子模块替换CAU和PAU单元;对于SCSE模块分别使用cSE(Spatial Squeeze and Channel Excitation)和sSE(Channel Squeeze and Spatial Excitation)子模块替换CAU和PAU单元。

表1 不同注意力模块在不同任务网络条件下的AP指标值

注:R50与R101分别表示ResNet50与ResNet101骨干网络;NONE表示未添加任何注意力模块;AP0.5,AP0.75,AP0.5~0.95分别表示3种IOU阈值条件下的AP指标;APL表示IOU值为0.5~0.95间大目标下的AP指标。下同。

Note: R50 and R101 represent the backbone network of ResNet50 and ResNet101 respectively; NONE means no attention module has been added; AP0.5, AP0.75, AP0.5~0.95respectively represent the AP index under three IOU threshold conditions, and APLrepresents the AP index under the large target with an IOU value of 0.5 to 0.95. The same below.

试验结果表明:

1)对于同一任务网络,在选用不同骨干网络时,其各个检测AP指标值大小不一。在未加入任何注意力模块的任务网络中,选用R50作为骨干网络的检测AP值优于R101,与选用R101相比,选用R50的Mask R-CNN任务网络上提升幅度最明显,而在MS R-CNN上提升幅度最小。以Mask R-CNN为例,Mask R-CNN-R50-NONE(表示以Mask R-CNN为任务网络,R50为骨干网络且不加入任何注意力模块,下同)的AP0.5、AP0.75、AP0.5~0.95、APL指标分别比Mask R-CNN-R101-NONE提升25.5%、10.4%、9.9%与10.2%;在加入注意力模块后,除Mask R-CNN外,其余任务网络在以R50与R101作为骨干网络条件下,各检测AP值较为接近,以HTC任务网络为例,HTC-R101-SCSE(表示以HTC为任务网络,R101为骨干网络且加入SCSE注意力模块,下同)比HTC-R50-SCSE的AP0.5、APL指标分别仅提升0.9%与0.2%,两者的AP0.75、AP0.5~0.95指标大小较为接近,说明注意力模块在特征提取过程中可大幅减小因骨干网络选取不同所带来的差异性,减小因骨干网络选用不当所带来的性能损失。

2)对于同一骨干网络,在选用不同任务网络时,其各个检测AP值预测结果差异较大。R50作为骨干网络条件下,未加入任何注意力模块时,Cascade Mask R-CNN任务网络的AP0.75、AP0.5~0.95、APL指标取得最佳效果,而在加入各个注意力模块后,HTC任务网路的AP0.75、AP0.5~0.95指标均呈不同程度的提高,说明注意力模块的引入可在一定程度上重塑任务网络的性能状况,使得原本表现较差的任务网络获得不错的效果,降低因为任务网络选用不当所造成的模型预测结果不佳风险。

3)对于相同骨干网络与任务网络,加入不同的注意力模块各个检测AP值预测效果不一。与加入CBAM、BAM及SCSE注意力模块相比,添加本文提出的DAU注意力单元的AP0.5、AP0.75、AP0.5~0.95、APL指标均能取得最佳的效果。以HTC-R101为例,加入DAU单元后的AP0.5、AP0.75、AP0.5~0.95、APL指标分别为0.933、0.853、0.763与0.788,与CBAM相比分别提升1.7%、1.7%、2.1%与1.8%,与加入BAM和SCSE模块相比分别提升2.4%、2.2%、2.6%、2%和1.6、2.6%、2.8%、2.5%,说明与其他注意力模块相比,DAU单元更关注生猪个体区域,能剔除猪栏、猪粪、猪食等冗余信息,进而改善检测精度。

4.2 通道与空间注意力单元对不同任务网络效果

为探究通道与空间注意力单元对任务网络检测性能影响,分别在相同试验条件下对2.2.2与2.2.3节提出的通道注意力单元CAU、空间注意力单元PAU与双重注意力单元DAU进行对比试验。单一PAU单元可捕捉原始特征图中垂直与水平方向的上下文信息,但这种信息较为稀疏,为获取更为密集的像素级上下文信息,对PAU模块进行循环串联操作可获取更为密集的上下文信息,为获取最合适的PAU单元串联个数,分别构造1~4个串联数量的PAU单元,并分别计算其AP指标值,如表2所示。

试验结果表明:

1)双重注意力DAU单元与通道注意力单元CAU和空间注意力单元PAU相比,能获得更佳的AP指标值。以MS R-CNN-R101为例,加入DAU单元(见表1)比加入CAU单元的AP0.5、AP0.75、AP0.5~0.95、APL指标值分别提升0.8%、1.1%、1.1%与2%,比PAU单元中表现最优的PAU-2 4种指标值分别提升2%、0.5%、0.6%、1.7%。说明同时融合通道与空间注意力信息的DAU对群养生猪个体目标的定位更为精确,这是因为通道注意力可从通道维度对特征图进行信息筛选,选择性增大生猪区域部位通道权重,空间注意力能从特征图位置粒度进行权重分配,选择性增大猪鼻、猪蹄等生猪区域部位激活值,两者结合将通道与注意力信息相互补充,进一步提升生猪检测边界准确度。

注:PAU-1~PAU-4分别表示串联1~4个PAU单元。

Note: PAU-1-PAU-4 mean 1-4 PAU units, respectively.

2)与通道注意力单元CAU相比,加入特定串联数量的PAU注意力单元一般能取得较好的AP指标值。以Cascade Mask R-CNN-R50为例,加入PAU-2比CAU的AP0.5、AP0.75、AP0.5~0.95、APL指标值分别提升2.5%、1.8%、1.3%和2%。这是因为与通道注意力将特征图中的每一特征点同等对待所不同的是,空间注意力对特征图中的每一特征点均施以权重信息,区别性对待特征图中的每一位置,强化利于生猪区域定位部分信息贡献率,因而其获得的边界位置信息更为精细、更为精准。

3)在加入骨干网络时,串联不同数量的PAU单元,其任务网络性能存在较大差异。随着串联PAU单元的数量增加,相同试验条件模型的AP指标值基本呈现先增加后减小趋势,且加入PAU-2单元一般能取得最佳AP值。以PAU-2加入Cascade Mask R-CNN-R50模型为例,其AP0.5、AP0.75、AP0.5~0.95、APL指标值分别达到0.928、0.839、0.742、0.767,比加入PAU-4单元在各个指标上分别提升5.9%、10.6%、11.1%与11.1%,说明并非加入串联数目越多的PAU单元对生猪检测越有效,加入串联数目较少的PAU单元(如PAU-1)捕获的空间注意力信息有限、甚至可能打乱已经捕获的有效语义信息,而加入数目较多的PAU单元(如PAU-4)不仅增大了模型计算量与显存占有量,而且较多学习参数的存在使得模型极易出现过拟合,实际融合PAU模块时以串联2~3个为宜。

4.3 不同场景检测结果

为进一步研究任务网络中分别加入通道注意力单元与不同串联数目空间注意力单元在不同场景下鲁棒性能,将测试集细分为深度分离、杂物遮挡、高度粘连3种场景,以性能最佳的HTC-R101网络为例,其在加入CBAM、BAM、SCSE注意力模块与CAU、PAU-2以及DAU单元后的各个模型实例检测效果(不同颜色检测框代表不同的生猪个体,且在检测出生猪个体的同时进行了生猪计数)如图4所示。

从图4中可知,与不加入注意力模块或单元相比,加入任意注意力信息后,不同场景检测框准确性均得到有效提升,不包含注意力单元的模型对于部分生猪个体并未能进行检测分离(如第一列中编号为③④的生猪个体);3种场景下,加入DAU单元的HTC-R101与加入CBAM、BAM、SCSE模块相比均能取得最佳的实例检测效果,即使在部分场景下,加入CBAM、BAM、SCSE模块后能对生猪个体位置进行定位,但包含DAU单元的HTC-R101取得最佳的检测置信度;与加入CAU与PAU-2单元相比,加入DAU单元后其检测边缘框预测更为精准,这是因为DAU单元充分将CAU与PAU捕获的通道与空间注意力信息特征融合,从两种维度层面强化模型对生猪个体部位特征的学习;但对于远离镜头、头部位置不明显且猪舍光线较暗的场景生猪个体(如第一列中编号为①②的生猪个体),即使加入DAU单元,仍然无法对其进行有效检测,这可能是因为模型在学习过程中将猪脸部位信息作为较为区分生猪个体的重要特征,在后续工作中需增加偏离镜头且猪体部位不全、光照条件更为复杂的样本数据以使得模型能够对高难度场景的生猪个体进行有效分离。

5 结 论

本文在特征金字塔网络FPN(Feature Pyramid Network)中引入通道注意力单元、空间注意力单元与双重注意力单元,研究不同骨干网络对任务网络、不同注意力模块对任务网络以及单独通道单元和不同串联数量空间注意力单元对任务网络检测性能影响,并对不同场景生猪检测结果进行分析,主要结论如下:

1)不同骨干网络对任务网络生猪检测效果具有一定影响。在未加入任何注意力模块的任务网络中,R50(ResNet50)检测AP(Average Precision)值优于R101(ResNet101),但在加入任意注意力模块后,2种骨干网络各检测AP值较为接近。

2)与加入CBAM、BAM及SCSE注意力模块相比,HTC-R101-DAU比HTC-R101-CBAM的AP0.5、AP0.75、AP0.5~0.95、APL指标分别提升1.7%、1.7%、2.1%与1.8%,说明DAU在注意力信息提取上更为有效。

3)DAU单元与通道注意力单元CAU和空间注意力单元PAU相比,其能获得更佳的AP指标值,对于MS R-CNN-R101,加入DAU单元比CAU单元的AP0.5、AP0.75、AP0.5~0.95、APL指标分别提升0.8%、1.1%、1.1%与2%,比PAU-2单元的4种指标分别提升2%、0.5%、0.6%、1.7%,说明同时融合两种维度注意力信息可相互补充提升位置检测准确性。

4)随着串联PAU单元的数量增加,模型预测的AP指标值基本呈现先增加后减小趋势,且在PAU-2单元上能取得最佳AP值。

5)加入DAU单元的HTC-R101与加入CBAM、BAM、SCSE、CAU、PAU-2单元后的各个模型相比,其检测框位置更准确,检测置信度更高。

[1]刘岩,孙龙清,罗冰,等. 基于改进CNN的多目标生猪检测算法[J]. 农业机械学报,2019,50(Supp.):283-289.

Liu Yan, Sun Longqing, Luo Bing, et al. Multi-target pigs detection algorithm based on improved CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(Supp.): 283-289. (in Chinese with English abstract)

[2] 李亿杨,孙龙清,孙鑫鑫. 基于多特征融合的粒子滤波生猪采食行为跟踪[J]. 农业工程学报,2017,33(增刊):246-252.

Li Yiyang, Sun Longqing, Sun Xinxin. Automatic tracking of pig feeding behavior based on particle filter with multi-feature fusion[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(Supp.): 246-252. (in Chinese with English abstract)

[3]刘坤,杨怀卿,杨华,等. 基于循环残差注意力的群养生猪实例分割[J]. 华南农业大学学报,2020,41(6):169-178.

Liu Kun, Yang Huaiqing, Yang Hua, et al. Instance segmentation of group-housed pigs based on recurrent residual attention[J]. Journal of South China Agricultural University, 2020, 41(6): 169-178. (in Chinese with English abstract)

[4] Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C]// Advances in Neural Information Processing Systems(NIPS). Cambridge, MA: MIT Press, 2012: 1097-1105.

[5]He K M, Zhang X Y, Ren S Q, et al. Deep residual learning for image recognition[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2016: 770-778.

[6]鲍文霞,孙庆,胡根生,等. 基于多路卷积神经网络的大田小麦赤霉病图像识别[J]. 农业工程学报,2020,36(11):174-181.

Bao Wenxia, Sun Qing, Hu Gensheng, et al. Image recognition of field wheat scab based on multi-way convolutional neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(11): 174-181. (in Chinese with English abstract)

[7]许景辉,邵明烨,王一琛,等. 基于迁移学习的卷积神经网络玉米病害图像识别[J]. 农业机械学报,2020,51(2):230-236,253.

Xu Jinghui, Shao Mingye, Wang Yichen, et al. Recognition of corn leaf spot and rust based on transfer learning with convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(2): 230-236, 253. (in Chinese with English abstract)

[8]娄甜田,杨华,胡志伟. 基于深度卷积网络的葡萄簇检测与分割[J]. 山西农业大学学报:自然款科学版,2020,40(5):109-119.

Lou Tiantian, Yang Hua, Hu Zhiwei. Grape cluster detection and segmentation based on deep convolutional network[J]. Journal of Shanxi Agricultural University: Natural Science Editor, 2020, 40(5): 109-119. (in Chinese with English abstract)

[9]何东健,刘建敏,熊虹婷,等. 基于改进YOLOv3模型的挤奶奶牛个体识别方法[J]. 农业机械学报,2020,51(4):250-260.

He Dongjian, Liu Jianmin, Xiong Hongting, et al. Individual identification of dairy cows based on improved YOLOv3[J]. Transactions of the Chinese Society for Agricultural Machinery, 2020, 51(4): 250-260. (in Chinese with English abstract)

[10]刘忠超,何东健. 基于卷积神经网络的奶牛发情行为识别方法[J]. 农业机械学报,2019,50(7):186-193.

Liu Zhongchao, He Dongjian. Recognition method of cow estrus behavior based on convolutional neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(7): 186-193. (in Chinese with English abstract)

[11]Yang A, Huang H, Zheng C, et al. High-accuracy image segmentation for lactating sows using a fully convolutional network[J]. Biosystems Engineering, 2018, 176: 36-47.

[12]胡志伟,杨华,娄甜田,等. 基于全卷积网络的生猪轮廓提取[J]. 华南农业大学学报,2018,39(6):111-119.

Hu Zhiwei, Yang Hua, Lou Tiantian, et al. Extraction of pig contour based on fully convolutional networks[J]. Journal of South China Agriculture University, 2018, 39(6): 111-119. (in Chinese with English abstract)

[13]Zhang L, Gray H, Ye X, et al. Automatic individual pig detection and tracking in pig farms[J]. Sensors, 2019, 19(5): 1188-1208.

[14]薛月菊,杨晓帆,郑婵,等. 基于隐马尔科夫模型的深度视频哺乳母猪高危动作识别[J]. 农业工程学报,2019,35(13):184-190.

Xue Yueju, Yang Xiaofan, Zheng Chan, et al. Lactating sow high-dangerous body movement recognition from depth videos based on hidden Markov model[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(13): 184-190. (in Chinese with English abstract)

[15]高云,陈斌,廖慧敏,等. 群养猪侵略性行为的深度学习识别方法[J]. 农业工程学报,2019,35(23):192-200.

Gao Yun, Chen Bin, Liao Huimin, et al. Recognition method for aggressive behavior of group pigs based on deep learning[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(23): 192-200. (in Chinese with English abstract)

[16]燕红文,刘振宇,崔清亮,等. 基于改进Tiny-YOLO模型的群养生猪脸部姿态检测[J]. 农业工程学报,2019,35(18):169-179.

Yan Hongwen, Liu Zhenyu, Cui Qingliang, et al. Detection of facial gestures of group pigs based on improved Tiny-YOLO[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2019, 35(18): 169-179. (in Chinese with English abstract)

[17]燕红文,刘振宇,崔清亮,等. 基于特征金字塔注意力与深度卷积网络的多目标生猪检测[J]. 农业工程学报,2020,36(11):193-202.

Yan Hongwen, Liu Zhenyu, Cui Qingliang, et al. Multi-target detection based on feature pyramid attention and deep convolution network for pigs[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2020, 36(11): 193-202. (in Chinese with English abstract)

[18]Redmon J, Farhadi A. YOLOV3: An incremental improvement[J/OL]. [2021-03-28].https://arxiv.org/abs/1804.02767.

[19]沈明霞,太猛,Cedric O,等. 基于深层卷积神经网络的初生仔猪目标实时检测方法[J]. 农业机械学报,2019,50(8):270-279.

Shen Mingxia, Tai Meng, Cedric O, et al. Real-time detection method of newborn piglets based on deep convolution neural network[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(8): 270-279. (in Chinese with English abstract)

[20]He K, Gkioxari G, Dollár P, et al. Mask r-cnn[C]// Proceedings of the IEEE International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2017: 2961-2969.

[21]Tu S, Liu H, Li J, et al. Instance segmentation based on Mask Scoring R-CNN for group-housed pigs[C]// International Conference on Computer Engineering and Application (ICCEA). Piscataway, NJ: IEEE, 2020: 458-462.

[22]Huang Z, Huang L, Gong Y, et al. Mask scoring r-cnn[C]// Proceedings of the IEEE conference on Computer Vision and Pattern Recognition(CVPR). Piscataway, NJ: IEEE, 2019: 6409 -6418.

[23]李丹,张凯锋,李行健,等. 基于Mask R-CNN的猪只爬跨行为识别[J]. 农业机械学报,2019,50(S1):261-266,275.

Li Dan, Zhang Kaifeng, Li Xingjian, et al. Mounting behavior recognition for pigs based on mask R-CNN[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(S1): 261-266, 275. (in Chinese with English abstract)

[24]高云,郭继亮,黎煊,等. 基于深度学习的群猪图像实例分割方法[J]. 农业机械学报,2019,50(4):179-187.

Gao Yun, Guo Jiliang, Li Xuan, et al. Instance-level segmentation method for group pig images based on deep learning[J]. Transactions of the Chinese Society for Agricultural Machinery, 2019, 50(4): 179-187. (in Chinese with English abstract)

[25]Tong W, Chen W, Han W, et al. Channel-attention-based DenseNet network for remote sensing image scene classification[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2020, 13: 4121-4132.

[26]Huang G, Liu Z, Van Der Maaten L, et al. Densely connected convolutional networks[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Piscataway, NJ: IEEE, 2017: 4700-4708.

[27]Yang K, Xu Z, Fei J. DualSANet: Dual spatial attention network for Iris recognition[C]//Proceedings of the IEEE/CVF Winter Conference on Applications of Computer Vision. Piscataway, NJ: IEEE, 2021: 889-897.

[28]Huang Z, Wang X, Huang L, et al. CCNet: Criss-Cross attention for semantic segmentation[C]//Proceedings of the IEEE Conference on International Conference on Computer Vision (ICCV). Piscataway, NJ: IEEE, 2019: 603-612.

[29]Woo S, Park J, Lee J, et al. CBAM: Convolutional block attention module[C]//Proceedings of the IEEE Conference on European Conference on Computer Vision (ECCV). Berlin, German: Springer, 2018: 3-19.

[30]Park J, Woo S, Lee J Y, et al. Bam: Bottleneck attention module[J/OL]. [2021-03-28]. https://arxiv.org/abs/1807.06514.

[31]Roy A G, Navab N, Wachinger C, et al. Concurrent spatial and channel squeeze & excitation in fully convolutional networks[C]//Medical Image Computing and Computer Assisted Intervention. Berlin, German: Springer, 2018: 421-429.

[32]Fu J, Liu J, Tian H, et al. Dual attention network for scene segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2019: 3146-3154.

[33]Ren S Q, He K M, Ross G. Faster R-CNN: towards real-time object detection with region proposal networks[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence, 2015, 39(6): 1137-1149.

[34]Lin T, Dollar P, Girshick R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2017: 936-944.

[35]Cai Z, Vasconcelos N. Cascade R-CNN: Delving into high quality object detection[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2018: 6154-6162.

[36]Rezatofighi H, Tsoi N, Gwak J Y, et al. Generalized intersection over union: A metric and a loss for bounding box regression[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition(CVPR). Piscataway, NJ: IEEE, 2019: 658-666.

[37]Chen K, Ouyang W, Loy C C, et al. Hybrid task cascade for instance segmentation[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Piscataway, NJ: IEEE, 2019: 4974-4983.

[38]Ding X, Guo Y, Ding G, et al. ACNet: Strengthening the kernel skeletons for powerful CNN via asymmetric convolution blocks[C//Proceedings of the IEEE Conference on International Conference on Computer Vision(ICCV). Piscataway, NJ: IEEE, 2019: 1911-1920.

Instance detection of group breeding pigs using a pyramid network with dual attention feature

Hu Zhiwei1,2, Yang Hua1※, Lou Tiantian3

(1.,,030801,;2.(),,03006,; 3.,,030801,)

High breeding density has brought a great risk to the prevention and control of swine fever in intensive pig production. Accurate and rapid detection of individual live pigs can contribute to taking timely countermeasures for the minimum incidence of diseases. However, some factors including pig adhesion and sundries barrier have made difficulties in the detection of individual pigs with multiple targets. In this study, a dual -attention feature pyramid network was proposed to rapidly detect the group breeding pigs. A total of 45 live pigs aged 20 to 105 days in 8 pens were selected as the research object. A head-up angle of view was used to collect a total of 3 834 labeled images, where 2 490 images were set as the training set, 480 as the validation set, and 864 as the test set. Two types of attention units were introduced into the Feature Pyramid Network (FPN), which encoded the semantic interdependencies in the channel (named Channel Attention Unit (CAU)), and spatial (named Position Attention Unit (PAU)) dimensions, respectively. The reason was that an attention-based method increased the weight of regional information for better instance detection, while suppressed the secondary information for the better model. The CAU had selectively enhanced the interdependencies among the channels by integrating the associated features. Meanwhile, the PAU had selectively aggregated the features at each position through a weighted sum of features at all positions. A Dual Attention Unit (DAU) was proposed to flexibly integrate CAU features with PAU information. An asymmetric convolution block was introduced to improve the robustness of the model to flipping and rotation. Two backbone networks were selected as ResNet50 and ResNet101, whereas, four major task networks were the Mask R-CNN, Cascade Mask R-CNN, MS R-CNN, and HTC cross-combination model, in order to detect the performance of group breeding pigs. The results showed that the embedding DAU contributed to the most significant performance in different task networks with distinct backbone networks, compared with the Convolutional Block Attention Module (CBAM), Bottleneck Attention Module (BAM), and Spatial-Channel Squeeze & Excitation (SCSE). When the HTC-R101-DAU was under the Intersection over Union (IOU) thresholds of 0.5, 0.75, 0.5-0.95 (all targets), and 0.5-0.95 (large targets), four Average Precision (AP) indicators increased by 1.7%, 1.7%, 2.1%, and 1.8%, respectively. There was a certain impact of backbone networks on the pig detection in the same task network. The detection of R50 was better than that of R101 in the task network without any attention unit. The detection AP values of two backbone networks were relatively close after adding the attention unit. The CAU and PAU were separately added to explore the influence of channels and positions in attention units on the detection performance of task network. Experiments showed that the DAU was comparable to CAU and PAU for the better AP index, indicating that simultaneous fusion of two-dimensional attention complemented each other for a high accuracy of position detection. In addition, a specific number of PAU units generally achieved better AP index values, compared with CAU. A position-attention module was constructed with 1 to 4 PAU units that connected in series for high accuracy of pixel-level dense context. The predictive values appeared a trend of increasing initially and decreasing afterwards after different numbers of PAU were merged under the same experimental conditions. Therefore, the HTC-R101-DAU model can more accurately and effectively detect live pigs in different scenes. The finding can provide a sound reference for the follow-up production of intensive pigs.

image processing; object detection; algorithms; feature pyramid network; channel attention; position attention

胡志伟,杨华,娄甜田. 采用双重注意力特征金字塔网络检测群养生猪[J]. 农业工程学报,2021,37(5):166-174.doi:10.11975/j.issn.1002-6819.2021.05.019 http://www.tcsae.org

Hu Zhiwei, Yang Hua, Lou Tiantian. Instance detection of group breeding pigs using a pyramid network with dual attention feature[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2021, 37(5): 166-174. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2021.05.019 http://www.tcsae.org

2020-12-14

2021-02-14

国家自然科学基金(31671571);山西农业大学青年科技创新基金(2019027)

胡志伟,博士生,研究方向为畜牧信息化。Email:zhiweihu@whu.edu.cn

杨华,博士,教授,研究方向为农业信息化。Email:yanghua@sxau.edu.cn

10.11975/j.issn.1002-6819.2021.05.019

TP391

A

1002-6819(2021)-05-0166-09