基于DenseNet的无人机在线多目标跟踪算法

钱泷

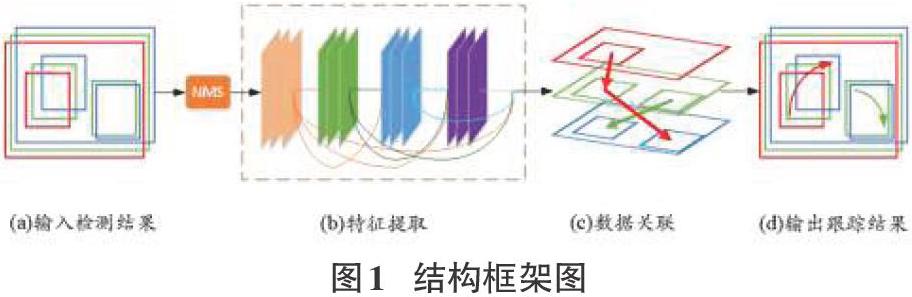

摘要:多目标跟踪任务的目的,是对图像序列中不同的目标设置不同的编号(ID),最终得到不同目标的运动轨迹。本文针对跟踪过程中目标ID极易变化的现象,提出了一种新的在线多目标跟踪算法。算法主要包含三个步骤:输入预处理、特征提取和数据关联。其中预处理步骤使用NMS算法对输入的检测结果进行筛选;特征提取步骤使用密集连接的特征提取网络对目标进行外观特征的提取,输出特征向量矩阵;数据关联步骤则使用级联匹配的方式,依据目标的位置信息和外观特征信息为其分配各自的ID。此外,该文还整理了一个具有挑战性的无人机场景下的多目标跟踪测试集。实验结果表明,该方法有效地减少了错误的目标ID变化,提高了多目标跟踪算法面对复杂场景时的精度,并保持较快的运行速度。

关键词:多目标跟踪;ID变化;密集连接;级联匹配

中图分类号:TP391 文献标识码:A

文章编号:1009-3044(2021)02-0007-05

Abstract: The main purpose of the multi-target tracking task is to set different identity numbers (ID) for different objects in an image sequence, and finally get the motion trajectories of different targets. Aiming at the phenomenon that the target ID is easy to change in the tracking process, this paper proposes a new online multi-target tracking algorithm. The algorithm consists of three steps: input preprocessing, feature extraction and data association. In the preprocessing step, the NMS algorithm is used to filter the input detection results; in the feature extraction step, a dense connection feature extraction network is used to extract the appearance features of the target, and the feature vector matrix is output; in the data association step, the corresponding ID is assigned according to the location information and appearance feature information of the target. On the other hand, we propose challenging multiple people tracking test set for UAV scenarios. The experimental results show that this method can effectively reduce the error of target ID changes, improve the accuracy of multi-target tracking algorithms in complex scenes, and maintain a fast running speed.

Key words: multi-object tracking; ID switches; dense connection; cascade matching

1 背景

多目标跟踪是视觉跟踪领域的研究热点之一,数十年来得到了中外学者的广泛研究并取得了显著的成果。借助目标检测算法的发展[1-2]和行人再识别技术的革新[3-4],基于检测的多目标跟踪算法已经成为当下目标跟踪的主流方法。在车辆导航、智能监控、人机交互、人群计数等领域都展现了重要的应用价值。然而,受制于真实场景的复杂性,例如遮挡、光照变化、尺度变化以及相机运动等因素的存在,如何保持跟踪算法的准确性和鲁棒性仍然被认为是一项具有挑战性的任务。

多目标跟踪可以视为一个跨帧的数据关联任务,将位于不同视频帧的检测目标按照相似程度进行配对。依据关联方式的不同,常用的检测跟踪算法可分为在线(逐帧)和离线(逐批)两种。在线模式的跟踪算法与视频序列的播放同步运行,并实时输出跟踪结果。这种跟踪算法首先通过提取每帧的检测结果,生成包含跟踪目标信息的特征向量,然后依据提取到的特征对目标进行跨帧的数据关联。基于批处理的跟踪器可以使用来自未来帧的信息来帮助减少检测噪声,同时对整个视频序列使用全局优化。虽然批处理算法较为容易获得鲁棒的跟踪结果,但其运行工作量巨大,不能满足实时跟踪的需要。我们的工作重点是在线模式的跟踪,因为它具有巨大的工业实用价值和发展潜力。

近年来,研究者们大多致力于获得更为准确的检测结果,以改进检测的方式来改进跟踪算法。但在实际应用中,大量跟踪失败的原因并非是出现了漏检或误检,而是无法从检测结果中提取到有价值的特征信息。因此,我们通过提升特征提取网络的性能,以获得描述更丰富、区分度更高的目标特征,以此来改善数据关联的效果。另一方面,度量是衡量目标特征相似程度的规则,现有的度量方法难以应对越来越复杂的跟踪场景所带来的挑战,例如常用的IOU距离度量在目标較小、间距较近的无人机场景下所能输出的区分度很低,容易产生歧义进而导致关联错误。我们通过对实验反馈的研究分析,对关联过程中常用的余弦相似度和IOU距离度量进行了改进。为了检验所做改进的效果,我们按照MOT Challenge提供的benchmark为本实验标注和整理了一个具有挑战性的无人机观测场景数据集。

2 相关技术研究

在方法论的改进[5-8]和新的基准数据集的提出[9]的共同推动下,多目标跟踪在过去十年中在速度和精度上都有了很大的提高[10-11]。在这一部分,我们简要介绍几种侧重不同方向的跟踪算法和当下多目标跟踪的发展方向。

Bergmann等人[12]强调目标检测在跟踪中的价值。他们使用目标检测器的检测框来预测下一帧中目标的位置。这种将检测器转换为跟踪器的方法简单且高效,在不针对跟踪数据进行训练的情况下取得了良好的跟踪效果。实验结果表明,目标检测在处理难以通过滤波算法和行人的再识别技术来解决的相似性问题上具有很大的潜力。这也为我们的算法研究提供了信心。

Li W等人[13]根据噪声的来源不同而应用不同的优化策略。使用光流网络解决相机运动问题,并利用辅助跟踪器来处理丢失的检测问题。此外,作者还同时使用外观和运动信息来提高匹配质量。最终作者在VisDrone2019公共数据集中取得了优异的成绩。实验表明,根据其应用场景的特点将复杂问题分解为多个子问题的策略[14]可以有效地提高网络的性能。比如颜色特征具有较好的抵抗目标形变的能力,但它难以描述目标的空间结构,且对光照过于敏感。运动特征可以在目标被遮挡后帮助恢复目标的跟踪信息,但是随着时间延长,运动模型会由于误差积累而逐渐发散,难以保持长时间的稳定性。孤立地使用某一种运动或表观信息都不能理想地解决多目标跟踪问题,必须结合使用场景和目标特点综合考虑跟踪算法的设计方案。

Sort[15]和Deepsort[16]是实时轻量化多目标跟踪算法的杰出代表。Sort主要关注目标的运动信息,将卡尔曼滤波算法应用于目标位置的预测,并采用匈牙利算法对帧间目标进行关联。这种简单而巧妙的设计使它能够以200 fps的速度运行,但它在跟踪的精度方面表现不佳。Deepsort在Sort的基础上进行了改进,通过在匹配过程中引入深度关联度量,大大地减少了身份切换次数,提高了跟踪精度,并保持着较快的速度。Deepsort为后来的多目标跟踪提供了一个简洁可行的数据关联方案,同时具有很高的可拓展性。本着Deepsort的思想,我们改进了其级联匹配模块的度量方法和ID的分配方式,并将其应用到我们的跟踪算法中。

3 设计方案

3.1 整体架构

如图1所示,算法与视频序列的播放同步进行,实时输入检测与跟踪的结果,直到视频播放结束。由于相似的检测内容会导致数据关联中向量之间区分度的降低,最终导致误跟踪和ID变化的产生。因此,我们首先使用NMS算法对输入进行过滤,减少冗余检测框对跟踪的干扰。特征提取的目的是从输入的检测信息中收集和整合我们想要的特征信息并将它们构建为特征矩阵,以便作为后续匹配的依据。生成的特征矩阵在下一帧视频序列播放时被传入数据关联。在数据关联阶段,我们依据目标的运动信息、外观信息将已知的目标与当前帧内的目标进行配对。如果当前帧出现了无法与已知目标配对的目标,则将其视作诞生了一个新目标。

3.2 特征提取网络

由于我们无法直接利用目标检测结果的边界框构建跨帧的关联,必须依赖框内的特征信息作为检测与关联之间的桥梁,因此特征提取网络决定着数据关联的结果。如果不能正确的从检测信息中提取到目标的特征,即便我们正确检测到了目标并且使用了合理的数据关联算法,也无法跟踪到目标。

多目标跟踪的目标多为群体相似度较高的动态目标,如车辆和人群,普通架构的特征提取网络很难做到性能和速度的兼顾。针对以上问题,我们基于DenseNet[17]所提出的架构思想,设计了一种基于密集連接的特征提取网络。与广泛使用的ResNet[18]相比,在网络层之间建立了紧密的连接,并通过在通道上连接特征来实现特征重用,有很好的抗过拟合能力。经过大量的实验对比,我们发现在规模较小的ReID数据集上训练时,基于Dense连接的网络更容易收敛,在运行时也能够提取更充分的特征。

3.3 数据关联

数据关联算法是多目标跟踪网络的主要组成部分,它负责对检测到的目标和轨迹进行匹配,并为匹配成功的目标分配ID。我们沿用Deepsort所提出的级联匹配策略来判断目标的身份,首先使用卡尔曼滤波依据目标在上一帧的位置信息预测目标在当前帧可能出现的位置即目标的轨迹,然后通过比较目标与预测轨迹所处坐标位置之间的马氏距离和外观特征之间的相似程度来判定它们是否匹配,然后对未匹配的目标和轨迹进行基于IOU的匹配。

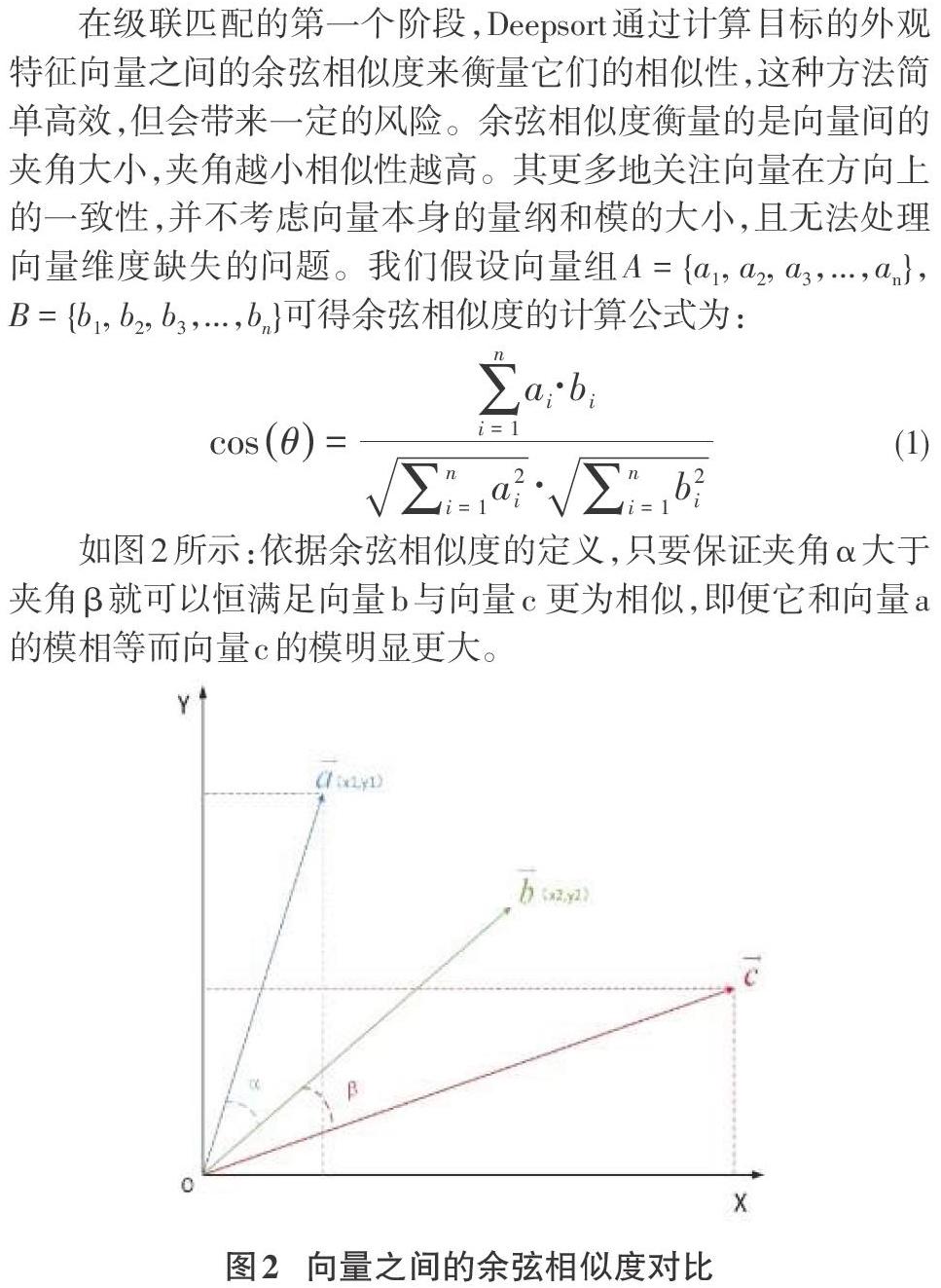

在级联匹配的第一个阶段,Deepsort通过计算目标的外观特征向量之间的余弦相似度来衡量它们的相似性,这种方法简单高效,但会带来一定的风险。余弦相似度衡量的是向量间的夹角大小,夹角越小相似性越高。其更多地关注向量在方向上的一致性,并不考虑向量本身的量纲和模的大小,且无法处理向量维度缺失的问题。我们假设向量组A = {a1, a2, a3,...,an},B = {b1, b2, b3,...,bn}可得余弦相似度的计算公式为:

如图2所示:依据余弦相似度的定义,只要保证夹角α大于夹角β就可以恒满足向量b与向量c 更为相似,即便它和向量a的模相等而向量c的模明显更大。

我们使用皮尔森系数来代替余弦相似度。皮尔森系数对参与比较的向量分别进行中心化处理,消除了量纲对比较结果的影响,不仅反映了向量在方向上的差异,同时也反映了向量各维在值上的差异,相比余弦相似度更为契合实际情况的需求。我们经过实验测试,将皮尔森系数阈值置为0.7。其计算公式如下:

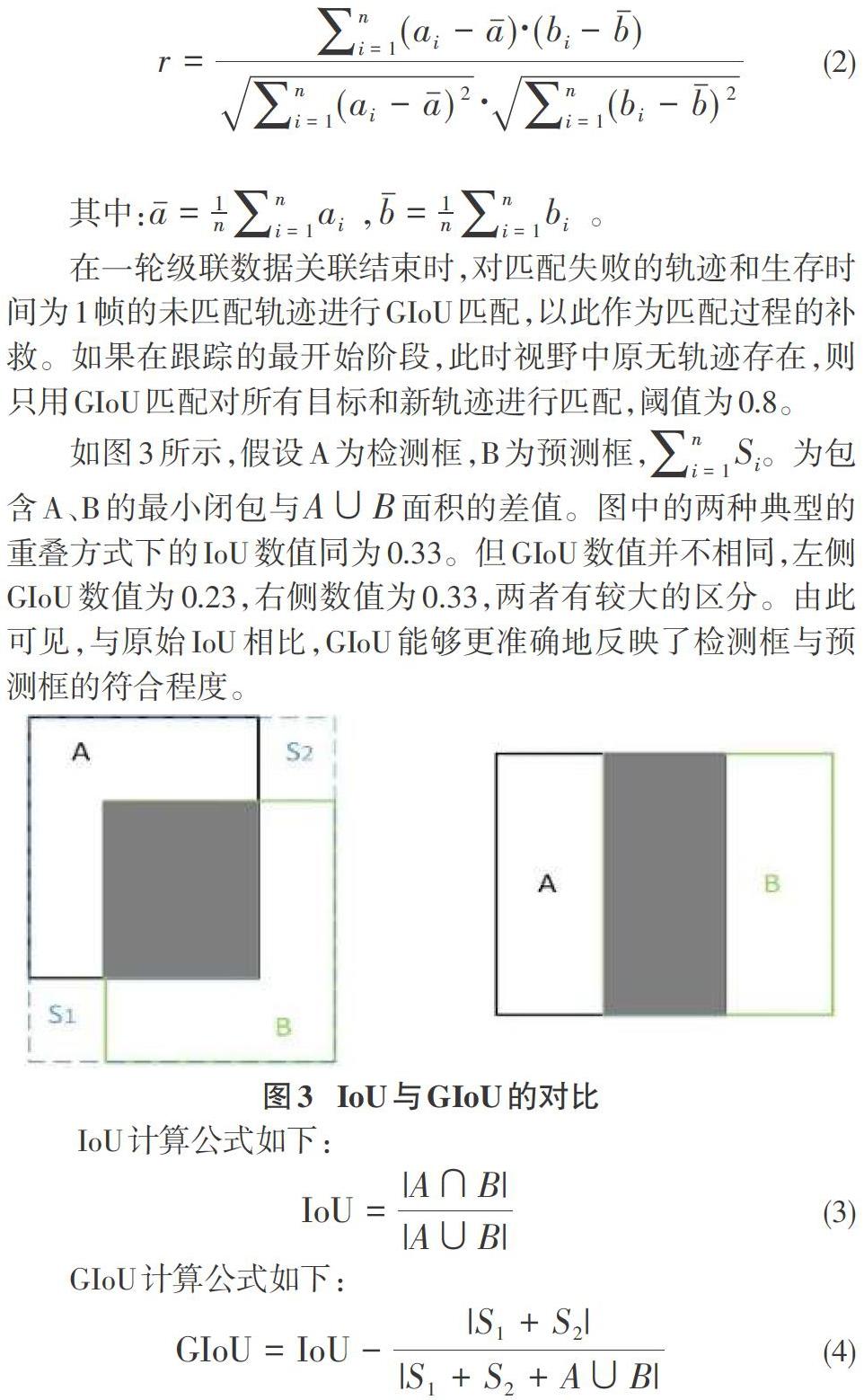

在一轮级联数据关联结束时,对匹配失败的轨迹和生存时间为1帧的未匹配轨迹进行GIoU匹配,以此作为匹配过程的补救。如果在跟踪的最开始阶段,此时视野中原无轨迹存在,则只用GIoU匹配对所有目标和新轨迹进行匹配,阈值为0.8。

如图3所示,假设A为检测框,B为预测框,[i=1nSi]。为包含A、B的最小闭包与[A∪B]面积的差值。图中的两种典型的重叠方式下的IoU数值同为0.33。但GIoU数值并不相同,左侧GIoU数值为0.23,右侧数值为0.33,两者有较大的区分。由此可见,与原始IoU相比,GIoU能够更准确地反映了检测框与预测框的符合程度。

我们关注那些没有成功匹配的轨迹。如果它们在接下来的30个连续帧中依然与任意目标都不匹配,我们可以认为该轨迹和关联的目标已离开视野,不再考虑该轨迹的匹配。

4 实验

在这一部分中,我们将详细介绍完整的实验过程并展开对实验结果的分析。

4.1 实验准备

4.1.2 模型训练

为了满足实时跟踪网络对速度的要求,我们设计了一个较短的密集连接的特征提取网络,并选择在1块1080ti显卡上进行训练。如表1所示,4个网络块组成,每个网络块有6、16、24和16层,激活函数为elu,学习率为1e-3,并输出128维向量。在MARS数据集[19]上的训练曲线如图4所示,纵轴代表损失函数的数值值,横轴代表训练次数。折线部分是放大后损失函数的波动情况。较平滑的为损失函数的拟合曲线。可以看出,经过30万次训练后,损失趋于稳定,40万次训练后,损失趋于收敛。该网络速度完全满足实时性要求,并有很高的精度。

4.1.3 数据集

为了评估跟踪算法的性能,我们整理了一个具有挑战性的多目标跟踪测试集UAV_MOT。此测试集包含7组在无人机视野下的场景中捕获的视频序列,并全部按照MOT Challenge的格式进行标注。其中2组选自VisDrone2020挑战赛比赛数据集,1组选自于MOT16数据集,剩余4组由我们使用无人机实地进行拍摄。该数据集场景复杂,目标较小且遮挡频繁,很适合用于跟踪算法性能的测试。

4.2 对比测试

在UAV_MOT测试集上我们进行了多组对比测试,用以验证我们的特征提取网络的有效性与变更度量标准所带来的改进。为避免检测结果的优劣对实验造成影响,我们使用YOLOV3作为公共的检测器,以保证所有实验组合使用相同的输入。算法的输出按照MOT Challenge提供的基准进行评估,其结果如表2所示。同时,我们还展示了可视化的实验效果,如图5所示,奇数行为Deepsort输出,偶数行为我们的算法输出。

4.3 实验结果与分析

4.3.1 评估标准

我们严格按照MOT Challenge的评估标准对实验结果进行分析,部分关键指标如下:

MOTA:跟踪准确度,综合IDs、误报率(FP)和漏报(FN)的整体跟踪精度,是评价跟踪算法最重要的性能指标。

MOTP:跟踪精度,指标注的信息与实际预测的包围框的匹配程度。

IDF1:综合考虑目标ID的准确率和召回率的指标。

IDs:身份变化数量,指目标的ID编号总共发生了多少次变化。

4.3.2 结果分析

首先对实验进行定量的分析。如表2第2行所示,更换dense特征提取网络后算法的主要指标均有所上升,说明在特征提取上的改进是有效的。如表2第3行所示,更换了特征提取网络和关联度量之后,算法性能进一步提升,在MOTA上提高了5.2个百分点,在ID变化上减少了112(约为13%)。

我们的算法在可视化效果也有明显的提升。如图5第1、第2行所示,6号目标在被几乎完全遮挡后我们的算法仍可恢复其ID,但是在Deepsort的输出中其ID变更为9。如图5第3、第4行所示,在经过人群后,我们的1、2、3号目标ID都保持稳定,但Deepsort中多数ID都已發生变化。以上结果证明了我们的算法在目标小、干扰多的复杂场景下可以保持较为稳定的跟踪性能以及更高的跟踪精度。此外,我们的跟踪算法具有较低的复杂度和较快的速度。

5 论文总结

本文提出了一种基于密集连接网络的轻量级多目标跟踪算法,能够有效地抑制多目标跟踪任务中身份数目的异常增长,减轻相似目标之间的相互干扰。我们通过使用密集连接的方式训练和设计特征提取网络,相比传统的ResNet而言更为高效,在输出维度相同的情况下可以输出区分度更高的目标特征。同时,还采用了改进的级联匹配模块对跟踪目标和轨迹进行匹配。在UAV_MOT数据集上的实验表明,该方法有效地减少了身份切换次数,具有更高的跟踪准确度和稳定性。

参考文献:

[1] Lin T Y, Dollár P, Girshick R,et al. Feature pyramid networks for object detection[C].Computer Vision and Pattern Recognition(CVPR), 2017:936-944.

[2] Li T C,de la Prieta Pintado F,Corchado J M,et al.Multi-source homogeneous data clustering for multi-target detection from cluttered background with misdetection[J].Applied Soft Computing,2017,60:436-446.

[3] Wu D,Zheng S J,Yuan C A,et al.A deep model with combined losses for person re-identification[J].Cognitive Systems Research,2019,54:74-82.

[4] Choe C,Choe G,Wang T J,et al.Deep feature learning with mixed distance maximization for person Re-identification[J].Multimedia Tools and Applications,2019,78(19):27719-27741.

[5] Alahi A, Goel K, Ramanathan V,et al.Social lstm: Human trajectory prediction in crowded spaces[C].IEEE Conference on Computer Vision and Pattern Recognition(CVPR), 2016:961-971.

[6] Luo W, Xing J, Zhang X,et al.Multiple object tracking: A literature review[C].Eprint Arxiv, 2017.

[7] Xiang Y, Alah A, Savarese S.Learning to track: Online multi-object tracking by decision making[C].Proceedings of the IEEE international conference on computer vision, 2015:4705-4713.

[8] Fagot-bouquet L, Audigier R, Dhome Y,et al.Collaboration and spatialization for an efficient multi-person tracking via sparse representations[C].IEEE International Conference on Advanced Video(AVSS), 2015:1-6.

[9] Milan A,Leal-Taixe L,Reid I,et al.MOT16:a benchmark for multi-object tracking[EB/OL].[2020-08-18].https://arxiv.org/abs/1603.00831.

[10] Riahi D,Bilodeau G A.Online multi-object tracking by detection based on generative appearance models[J].Computer Vision and Image Understanding,2016,152:88-102.

[11] Sadeghian A, Alahi A, Savarese S.Tracking the untrackable: Learning to track multiple cues with long-term dependencies[C].IEEE International Conference on Computer Vision (ICCV), 2017:300-311.

[12] Bergmann P, Meinhardt T, Leal-Taixe L.Tracking without bells and whistles[C].IEEE/CVF International Conference on Computer Vision (ICCV), 2019:941-951.

[13] Li Weiqiang,Mu Jiatong,Liu Guizhong.Multiple Object Tracking with Motion and Appearance Cues[C].IEEE/CVF International Conference on Computer Vision Workshop (ICCVW), 2019:161-169.

[14] Jiang N,Bai S C,Xu Y,et al.Online inter-camera trajectory association exploiting person Re-identification and camera topology[C]//2018 ACM Multimedia Conference on Multimedia Conference - MM '18.October 15-26,2018.Seoul,Republic of Korea.New York:ACM Press,2018:1457-1465.

[15] Bewley A, Ge Z, Ott L, Ramos F,et al.Simple online and realtime tracking[C].IEEE International Conference on Image Processing (ICIP), 2016:3464-3468.

[16] Wojke N, Bewley A, Paulus D.Simple online and realtime tracking with a deep association metric[C].IEEE International Conference on Image Processing(ICIP), 2017:3645-3649.

[17] Huang G, Liu Z, Van Der Maaten L,et al. Densely Connected Convolutional Networks[C].Computer Vision and Pattern Recognition(CVPR), 2017:2261-2269.

[18] HE Kaiming,ZHANG Xiangyu,REN Shaoqing,et al.Deep residual learning for image recognition[C].Computer Vision and Pattern Recognition(CVPR), 2016:770-778.

[19] Zheng L,Bie Z,Sun Y F,et al.MARS:a video benchmark for large-scale person Re-identification[C].Computer Vision - ECCV 2016,2016.

【通聯编辑:谢媛媛】