基于深度学习的显著性目标检测综述

史彩娟,张卫明,陈厚儒,葛录录

华北理工大学人工智能学院,河北唐山 063210

视觉显著性是指模仿人类视觉系统快速检测出视觉上最独特的显著性区域,即显著场景,然后对该区域进行感知和处理。显著性目标检测(salient object detection,SOD)是指检测显著场景中最吸引注意力的物体。近年,显著性目标检测得到了广泛研究和应用,如图像分类[1-2]、语义分割[3-4]、超像素[5]、图像检索[6]、视觉跟踪[7]、内容感知图像编辑[8]和机器人导航[9]等。

显著性目标检测方法一般可以分为传统显著性目标检测方法和基于深度学习的显著性目标检测方法。传统显著性目标检测方法主要是利用人类直观感觉或者启发式先验,如利用色度比较[10]、背景比较[11]和边界点先验[12]等,通过人工提取特征来检测目标。然而,人工提取特征非常耗时。近年,深度学习的发展极大促进了显著目标检测研究,基于深度学习的显著性目标检测方法不断被提出。不同于传统方法,基于深度学习的显著性目标检测方法不需要人工提取特征,而是自动学习得到多尺度特征;另外,检测性能也有了很大提升,如检测精度大幅提升,时效性越来越好,模型轻量级,单一网络同时完成显著性目标的检测和边界定位等。但是,现有的基于深度学习的显著性目标检测方法也还存在不足,如复杂背景下的显著性目标检测性能有待进一步提升,检测的实时性有待提高,模型复杂度需要降低等。

近年,部分学者对基于深度学习的目标检测方法进行了梳理总结[13-19],但是对国内外基于深度学习的显著性目标检测算法的总结与分析非常有限。因此,本文将对基于深度学习的显著性目标检测算法进行总结分析。首先详细阐述了基于深度学习的显著性目标检测的不同方法;其次简单介绍了常用数据集和评估准则;接着对多个基于深度学习的显著性目标检测方法进行了性能比较;最后分析了现有基于深度学习的显著性目标检测方法的不足及未来发展方向。

1 基于深度学习的显著性目标检测方法

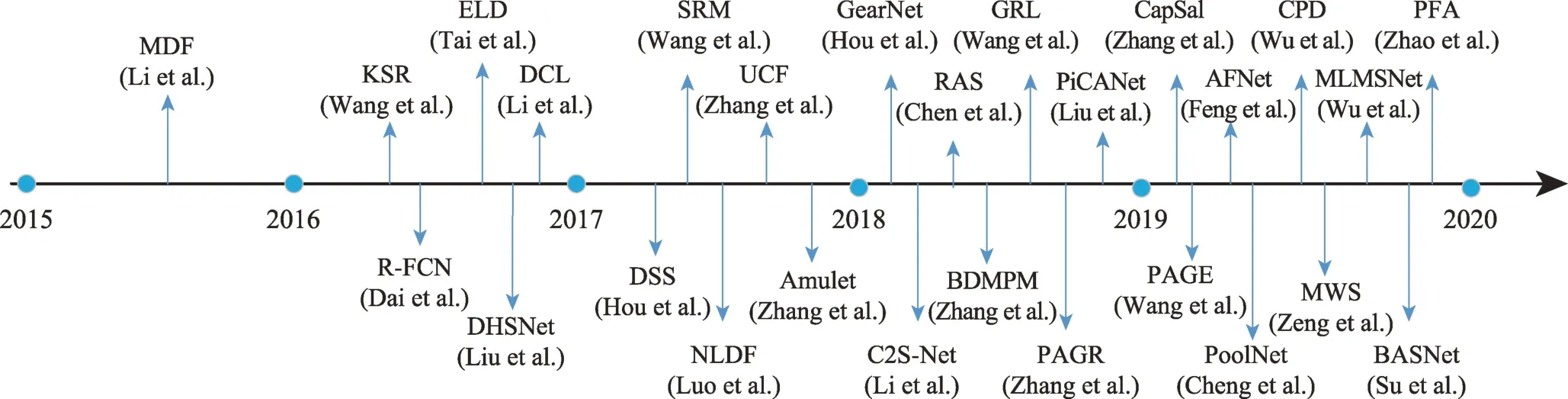

随着深度学习的快速发展,基于深度学习的显著性目标检测方法被广泛提出,克服了传统方法中人工提取特征耗时或者迁移性较差等问题。图1 给出了近年来基于深度学习的显著性目标检测的发展历程及主要方法。本文分别从边界/语义增强、全局/局部结合和辅助网络三个不同的角度对现有的基于深度学习的显著性目标检测方法进行介绍。

1.1 基于边界/语义增强的显著性目标检测

研究发现,深度网络VGG[20](visual geometry group)和ResNet[21](residual neural network)等提取的多层多尺度特征中低层特征包含良好的空间信息,可以定位边界,而高层特征具有丰富的语义信息,可以定位显著性目标。因此,为了提高显著性目标检测的性能,有的研究对低层特征进行操作来增强边界[22],获得更加清晰的显著性目标边界;有的研究锐化高层特征来获得丰富的语义信息,通过语义增强来更好地定位显著性目标[23];还有一些研究对边界和语义同时进行增强[24],以获得更好的显著性目标检测效果。因此,本节将从边界增强、语义增强,边界/语义增强三个角度对基于深度学习的显著性目标检测方法进行介绍。

1.1.1 基于边界增强的显著性目标检测方法

Fig.1 Development of salient object detection based on deep learning图1 基于深度学习的显著性目标检测的发展

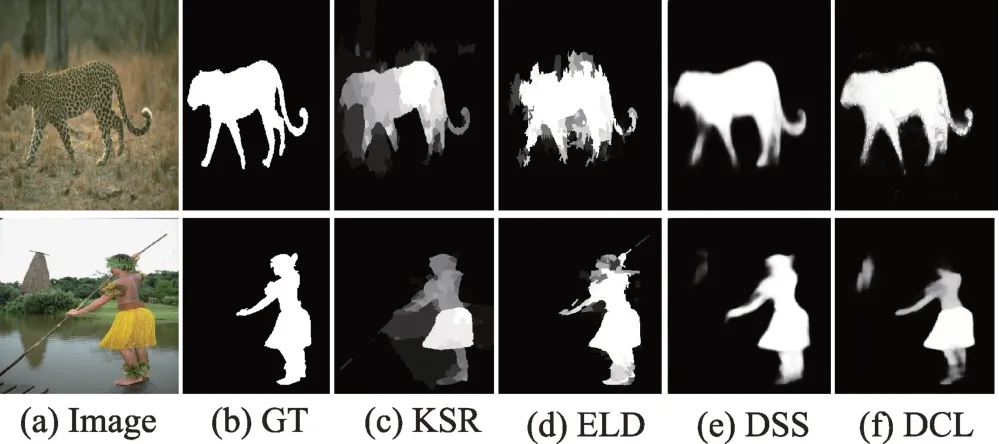

边界增强是指通过增强深度特征中的低层特征来获得更多的边界信息,从而更好地定位显著目标边界。Tai 等人提出ELD(encoded low-level distance)算法[22]对颜色及其分布和滤波器响应位置等低层特征的特征距离进行编码,生成低阶距离图以获得边界检测效果;Wang 等人提出的KSR(kernelized subspace ranking)算法[25]构建了一种基于核化的子空间排序模型来测量低层特征的两两距离,根据模型给出的建议分数生成低层特征图。以上两种方法通过编码低层特征距离来检测边界信息,定位显著性目标轮廓,但是轮廓边界有时会模糊,导致部分边界细节丢失,仿真结果如图2(c)、(d)所示。为了进一步提升显著性目标边界检测效果,一些研究通过引入相关操作来增强低层特征具有边界信息。Li 等人提出的DCL(deep contrast learning)算法[26]采用分段空间池流模拟不连续的显著性目标边界,解决显著性目标边界模糊的问题。Hou 等人提出的DSS(deeply supervised salient)算法[27]是在HED(holistically-nested edge detection)体系结构中引入了具有跳跃结构的短连接,使每一层具有更加丰富的多尺度特征映射,从而获得显著性目标的清晰边界。DCL 和DSS 方法的仿真显著图如图2(e)、(f)所示。从仿真结果可以看出,相较于直接编码低层特征距离的算法,进一步引入相关操作的方法获得的显著性目标边界更加清晰。但是,这些操作的引入容易引起显著性目标检测不准确,如图2(e)、(f)第二行出现了不准确的显著性目标(山)。

Fig.2 Saliency maps of methods based on boundary enhancement图2 基于边界增强方法的显著图

另外,还有一些研究直接对显著性目标的边界进行检测。Hou 等人提出TBOS(three birds one stone)算法[28],采用了一种通用架构对显著性目标边界进行检测,同时能够完成骨架提取和目标分割。Feng 等人提出的AFNet(attentive feedback network)算法[29]采用BEL(boundary-enhanced loss)边界增强损失来获得更精确的边界,进而实现对显著性目标,特别是凸起窄条纹的分割。Qin等人提出的BASNet(boundaryaware salient network)算法[30]将混合损耗用于边界感知的显著性目标检测,能够准确地预测出清晰的边界结构,以及有效地分割出显著性目标区域。以上三种直接提取显著性目标边界的检测算法的显著图如图3(c)、(d)所示。从图3 可以看出这类方法能够提取清晰的显著性目标边界,边界细节相对较好,显著性目标的检测准确度较高(无关的显著性目标较少)。

Fig.3 Saliency maps of methods based on direct extraction of boundaries图3 直接提取边界方法的显著图

1.1.2 基于语义增强的显著性目标检测方法

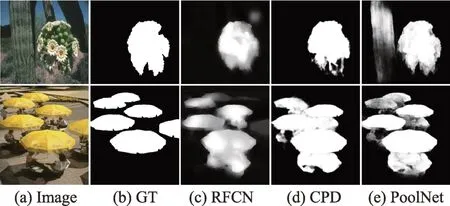

语义增强是指从高层特征中获得丰富的语义信息,从而更好地定位显著性目标,使显著性目标更加突出。Dai等人提出的R-FCN(region-based fully convolutional networks)算法[23]通过全卷积网络获得高层语义特征以获得具有通用性的显著性图。Wu 等人提出CPD(cascaded partial decoder)算法[31],直接利用生成的显著性图细化骨干网的特征来提高高层特征的表示能力;另外,利用多尺度特征进一步细化显著性图并纠正映射错误。Liu等人提出的PoolNet算法[32]充分利用卷积神经网络的池操作,将金字塔池块放在U 型结构的最顶层来获取丰富的语义信息。以上三种基于语义增强的显著性目标检测方法的显著图如图4(c)~(e)所示。这类方法可以准确定位显著性目标的位置,但是由于仅针对高层特征所包含的语义进行增强,有时会造成显著性目标边界模糊或者多个显著性目标重合。

Fig.4 Saliency maps of methods based on semantic enhancement图4 基于语义增强方法的显著图

为了获得有效的显著性目标,一些研究通过引入注意力机制进一步增强语义信息。Liu 等人提出的PiCANet(pixel-wise contextual attention network)算法[33]首先为每个像素生成注意力图,然后有选择地整合上下文信息来构建有效特征,最后与U-Net 架构结合生成显著性图。Chen 等人提出的RAS(reverse attention salient)算法[34]根据逆向注意提出了一个自上而下的边训练边输出的剩余学习方式,实现对最深层语义信息的增强。基于注意力机制的语义增强显著性目标检测算法的显著图如图5(c)、(d)。引入注意力机制来有效提取语义信息,准确定位显著性目标的位置。

Fig.5 Saliency maps of methods based on semantic enhancement with attention mechanism图5 基于注意力机制的语义增强方法的显著图

1.1.3 基于边界/语义增强的显著性目标检测方法

通过前面两类方法的分析可以看出,只进行边界增强容易造成显著性目标模糊,而只进行语义增强则会引起显著性目标的边界模糊。因此,为了克服二者的缺点,一些研究对边界和语义同时进行增强,同时获得良好的显著性目标信息以及轮廓信息,从而提升显著性目标检测性能。

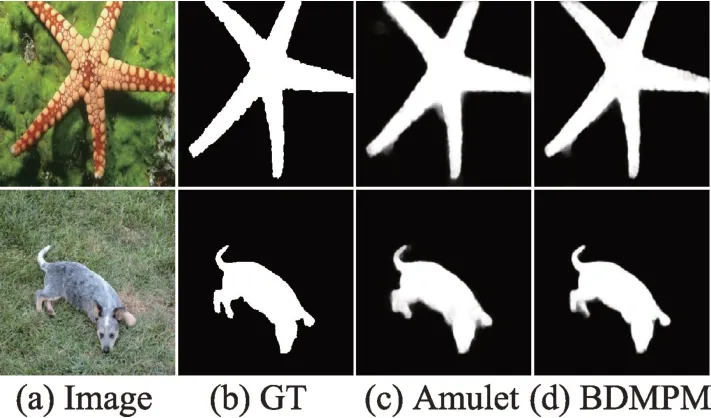

Zhang 等人提出的Amulet 算法[24]将多层特征映射集到多个分辨率,获得同时包含语义信息和边缘细节的显著性图。Zhang 等人提出的BDMPM(bidirectional message passing model)算法[35]设计了一种门函数来控制消息的传递速率和双向传递。双向的消息传递结构可以同时对语义信息和空间细节进行编码实现显著性目标检测。以上两种基于边界/语义增强的显著性目标检测算法的显著图如图6(c)、(d)。这些方法既可以准确定位显著性目标的位置,又可以获得清晰的显著性目标边界。主要是因为通过语义增强可以减小无效目标的干扰,更好地定位显著性目标的位置;通过边界增强可以获得清晰的显著性目标边界。

Fig.6 Saliency maps of methods based on boundaries/semantic enhancement图6 基于边界/语义增强方法的显著图

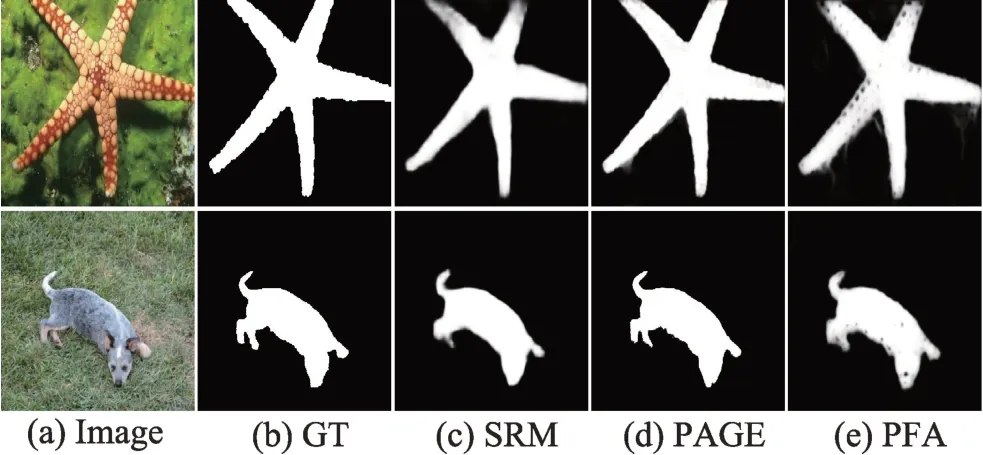

另外,还有一些研究采用金字塔结构同时对高低层特征进行处理,实现显著性目标边界和语义的同时增强。Wang 等人提出的SRM(stagewise refinement model)算法[36]首先利用深度前馈网络生成一个粗略的预测图,然后将一个金字塔结构应用于不同区域得到更加精确的显著性图。Wang 等人提出的PAGE(pyramid attention edge)算法[37]设计了显著性目标检测的基本金字塔注意结构,能够挖掘多尺度的深层显著性信息,同时利用一个边缘检测模块完成边界提取。Zhao 等人提出的PFA(pyramid feature attention)法[38]将多层卷积特征分成高层特征和低层特征,首先对高层特征设计了一个上下文信息金字塔模块(context-aware pyramid feature extraction,CPFE)来提取丰富的上下文语义信息,然后采用信道注意模块(channel-wise attention,CA)来进一步增强语义信息,从而更好地定位显著性目标区域;对于低层特征采用空间注意模块(spacial attention,SA)来细化空间信息,更好地定位显著性目标的边界;最后,将SA和CA 的输出进行有效融合来获得更好的显著性图。基于金字塔的边界/语义增强的显著性目标检测算法的显著图如图7(c)~(e)所示,可以看出PFA 算法性能优于PAGE 算法和SRM 算法。

1.2 基于全局/局部结合的显著性目标检测

研究发现全局信息(颜色、纹理、背景/前景等)包含显著性目标的位置信息,而局部信息可以增强显著性目标边界。一些检测方法采用递归操作、多分辨率操作和注意力机制等将全局/局部相结合以获得更好的显著性目标检测性能。

Fig.7 Saliency maps of methods based on boundaries/semantic enhancement with feature pyramid图7 基于特征金字塔的边界/语义增强方法的显著图

递归操作是指全局和局部操作交替进行。Liu等人提出的DHSNet(deep hierarchical saliency network)[39]算法首先利用全局对比度、对象性和紧凑性等全局信息得到一个显著性图,然后采用层次递归卷积神经网络(hierarchical recurrent convolutional neural network,HRCNN)利用局部上下文信息对显著性图进一步增强。Wang 等人提出的GRL 算法[40]采用递归方式利用加权响应图提取上下文信息定位显著性目标,然后对局部边界进行细化以获得更加清晰的边界。虽然递归方式取得了一定的效果,但是研究发现递归操作非常耗时耗力。另一种全局/局部相结合的显著性目标检测方法是采用多分辨率特征来提升显著性目标检测效果。Luo 等人提出的NLDF(non-local deep features)[41]算法利用卷积块和反卷积设计了一种简单的4×5 卷积神经网络结构,通过每一列提取并强化特定分辨率的局部特征,最后将局部和全局信息结合起来输出。另外,还有一些研究在递归和多分辨率操作的基础上添加了注意力机制,对提取的全局/局部信息进一步强化,提升显著性目标检测性能,如Zhang 等人提出的渐进注意引导递归网络PAGR(progressive attention guided recurrent)[42]。基于全局/局部结合的显著性目标检测方法的显著图如图8(c)~(f)所示。在相同的VGG(visual geometry group)模型下,与DHS 算法相比,NLDF 和PAGR 算法能够获得更加清晰的显著性图,由于PAGR 算法引入了注意力机制,其性能最优。

1.3 基于辅助网络的显著性目标检测

Fig.8 Saliency maps of methods based on global/local combination图8 基于全局/局部结合方法的显著图

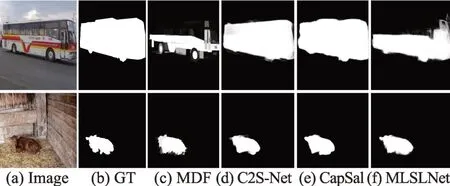

基于辅助网络的显著性目标检测是指采用其他领域已有模型作为辅助网络来提升显著性目标检测性能。Li 等人提出的MDF(multiscale deep features)算法[43]使用预先训练的图像分类模型来产生分级的显著性图;Li 等人提出的C2S-Net(contour to contour salient network)算法[44]将深度轮廓检测模型自动转换为显著性目标检测模型;Zhang 等人提出的CapSal 算法[45]将字幕网络(image captioning network,ICN)作为辅助语义任务来提高复杂场景中的显著目标检测性能;Wu 等人提出的MLSLNet(mutual learning supervised learning network)算法[46]以一种交互方式让显著性目标检测和前景轮廓检测交替进行来得到显著性图。图9 给出了基于辅助网络的显著性目标检测算法的显著图。

Fig.9 Saliency maps of methods based on auxiliary network图9 基于辅助网络方法的显著图

1.4 不同类型显著性目标检测方法分析比较

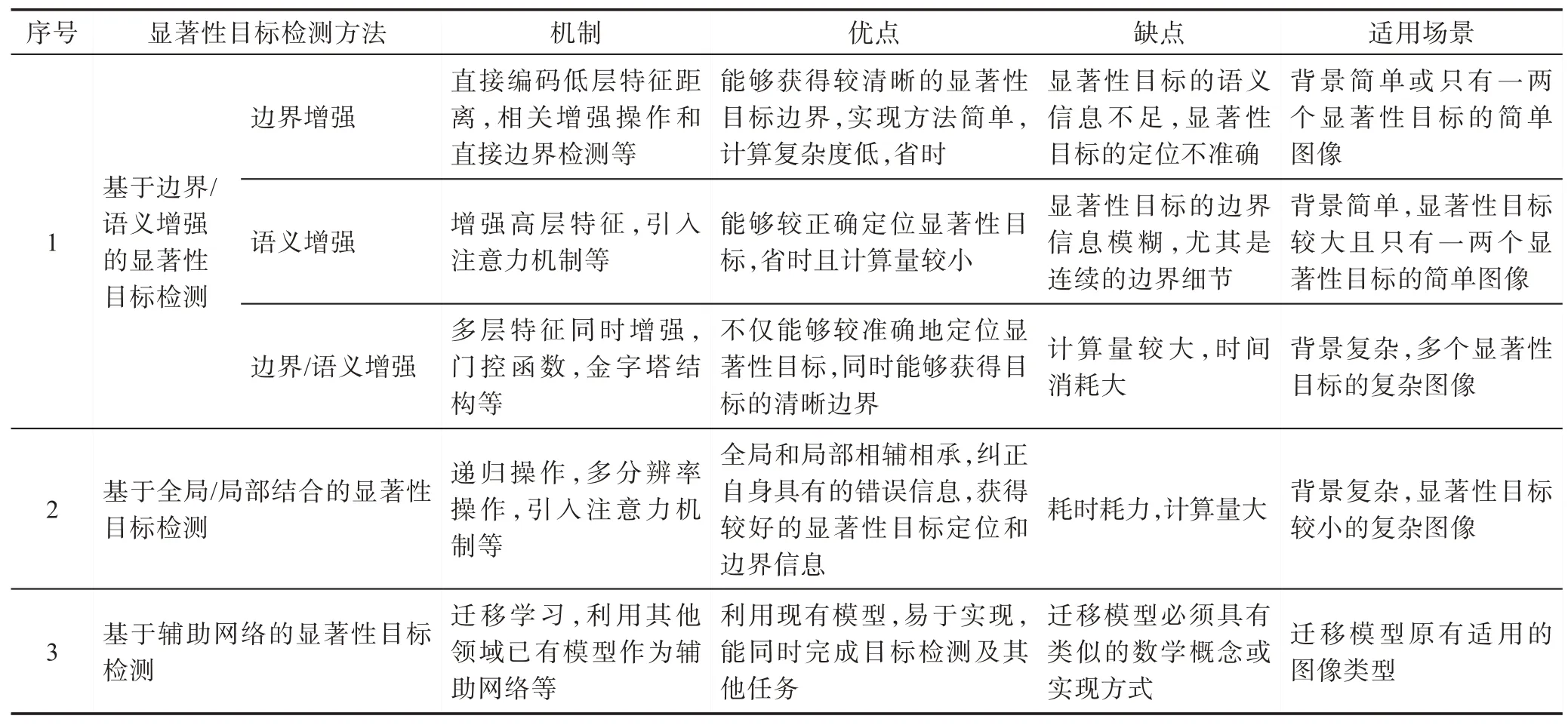

表1 列出了以上三种类型显著性目标检测方法的机制、优点、缺点和适用场景。

通过以上分析及表1 可以看出,现有基于深度学习的显著性目标检测方法边界模糊的原因和相应的解决方法可以归纳为以下几类:(1)深度模型包含许多下采样操作,上采样后的特征难以恢复原有的空间信息,融合后引起边界模糊。因此,为了减小下采样操作引起的多尺度融合损失,引入一些特定操作,如PoolNet 算法中采用功能聚合模块等。(2)针对不同因素对边界检测的影响,通过编码低层特征距离来检测边界信息,定位显著性目标轮廓,如ELD 算法和KSR 算法;或者是设计新的损失函数,通过反向传播调整模型参数,如AFNet算法和BASNet算法。(3)基础模型简易导致检测的边界模糊,可以通过多尺度操作增强原有的特征效果,如DSS 算法、SRM 算法和PAGE 算法等,或添加注意力机制来提取更有效的低层特征,如PFA 算法等。

Table 1 Analysis and comparison of different types of salient object detection methods表1 不同类型显著性目标检测方法分析比较

另外,通过研究分析发现,基于深度学习的显著性目标检测方法中常常引入注意力机制,大致可以分为三种:(1)时空域注意力,比较适合同时具有时序及空域特征的场景,通过递归神经网络(recurrent neural network,RNN)设计注意力机制,如PAGR 算法;(2)软注意力,是一种确定性的注意力,可以直接通过网络生成,它也是可微的,可以通过神经网络算出梯度,并且通过前向传播和后向反馈来学习得到注意力的权重,如PFA 算法和RAS 算法;(3)硬注意力,从输入信息中选择重要的特征,如PiCANet 算法每个像素生成注意力图,这种方式更高效和直接。

2 常用数据集及评估准则

介绍基于深度学习的显著性目标检测常用数据集以及评估准则。

2.1 常用数据集

为了满足不同的显著性目标检测研究需求,多个显著性目标检测数据集被提出,如MSRA数据集[47]、ASD 数据集[48]、SOD 数据集[49]、MSRA10K 数据集[10]、PASCAL-S 数据集[50]、DUTS 数据集[51]、SED 数据集[52]、ECSSD 数据集[53]、DUTO-OMRON 数据集[11]和HKU-IS数据集[43]。下面对基于深度学习的显著性目标检测中常用的MSRA10K 数据集、HKU-IS 数据集、DUTS数据集、SOD 数据集、ECSSD 数据集、DUTO-OMRON数据集和PASCAL-S 数据集分别进行介绍。

MSRA10K 数据集:也称为THUS10K,2007 年由西安交通大学与微软亚洲研究院的Liu 等人提出,只提供了边界框级别的显著性真值标定,具有大规模和精确的注释,常用来训练显著性目标检测模型。

HKU-IS 数据集:包含4 447 个图像,由香港大学的Li 等人在2015 年建立,该数据集中的图像包含多个断开连接的显著性目标,多目标的边界重合和色彩对比度较低。

DUTS 数据集:具有10 553 个训练图像和5 019个测试图像。所有训练图像来自ImageNet DET[54]训练集,而测试图像来自ImageNet DET 测试集和SUN[55]数据集。训练和测试集都包含非常重要的场景,用于显著性目标检测。

SOD 数据集:包含300 张图像,来自于伯克利分割数据集,每张图像具有像素级注释。大部分图像包含多个显著性目标,并且目标与背景的颜色对比度较低。

ECSSD 数据集:包含1 000 张图像,2013 年由香港中文大学的Yan 等人构建。ECSSD 数据集中的图像具有复杂的结构和背景。

DUTO-OMRON 数据集:包含5 168 个高质量图像,2013 年由大连理工大学的Yang 等人建立。该数据集中的图像具有多个显著性目标,背景相对复杂。

PASCAL-S 数据集:2014 年由乔治亚理工学院的Li 等人建立,包括8 个类别。采用不同的显著性标记对来自PASCAL VOC[56]的850 张图像修复后构成。PASCAL-S 数据集用于评估具有复杂背景、多个目标场景的模型性能。

2.2 常用评估准则

本节介绍基于深度学习的显著性目标检测中常用的评价准则。

F-度量(Fβ)[48]。对精度和召回率进行总体评估,通过加权计算可以得到Fβ,其计算公式为:

一般β2=0.3,Fβ值越大表明模型性能越好。

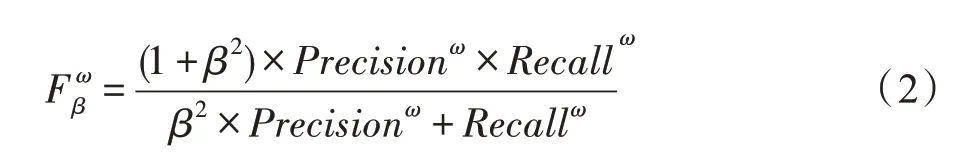

加权F-度量加权F-度量是F-度量的推广,通过交替计算精度和召回率得到。加权F-度量为了解决邻域信息的不同,为不同位置的不同误差分配了不同的权重,其计算公式如下:

P-R 曲线。以Precision和Recall作为纵-横轴坐标的二维曲线,即查准率-查全率曲线,选取不同阈值时对应的精度和召回率绘制。P-R 曲线围起来的面积是AP(average precision)值,AP值越高,模型性能越好。

平均绝对误差(MAE)[58]。MAE计算公式如下:

其中,W和H分别表示图像的宽和高。P(x,y)表示显著性概率结果,Y(x,y)表示真值。MAE值越小表示模型越好。

3 基于深度学习的显著性目标检测方法性能比较

3.1 定量比较

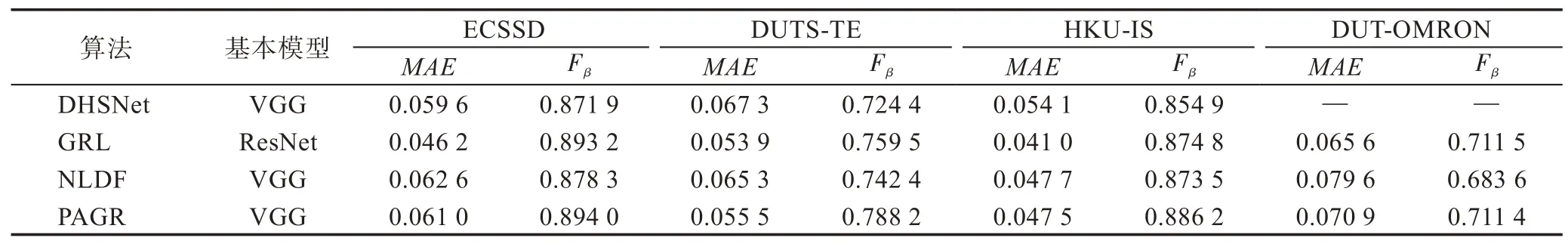

本节对三种类型基于深度学习的显著性目标检测的不同算法分别进行了定量比较,在数据集ECSSD、DUT-OMRON、HKU-IS 和DUTS-TE 上进行了实验,采用F-度量(Fβ)和平均绝对误差(MAE)作为评估准则,结果见表2、表3 和表4。

从以上3 个表格可以看出:(1)基于VGG16 结构,各模型性能由高到低依次为AFNet、MLSLNet、PFA 和PAGE,其中AFNet 和MLSLNet 侧重于边界信息,而PFA 和PAGE 侧重于多尺度信息。由于PFA 利用了低层特征的空间信息使得其性能优于PAGE,而AFNet着重对显著性目标的边界(特别是凸起的窄条纹)进行提取和增强,其性能在四种方法中达到了最优。(2)基于ResNet 结构,各模型性能由高到低依次为PoolNet、CPD 和BASNet。PoolNet 取得最佳性能主要得益于其在池化操作方面做出的改进,以及采用功能聚合模块实现不同尺度特征的无缝融合。

Table 2 Quantitative comparison of methods based on boundaries/semantic enhancement表2 基于边界/语义增强方法的定量比较

Table 3 Quantitative comparison of methods based on global/local combination表3 基于全局/局部结合方法的定量比较

Table 4 Quantitative comparison of methods based on auxiliary networks表4 基于辅助网络方法的定量比较

综上所述,PoolNet 模型取得了优于其他模型的显著性目标检测性能。另外,也反映了基于ResNet结构的模型优于基于VGG16 结构的模型。但是,由于VGG结构相对简单,仍然具有一定的研究及应用价值。

3.2 P-R 曲线分析

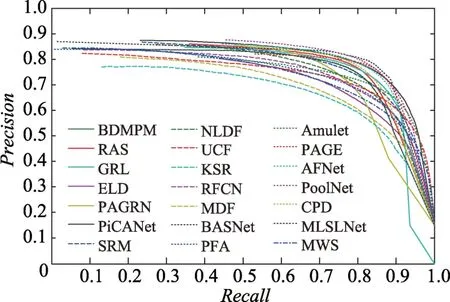

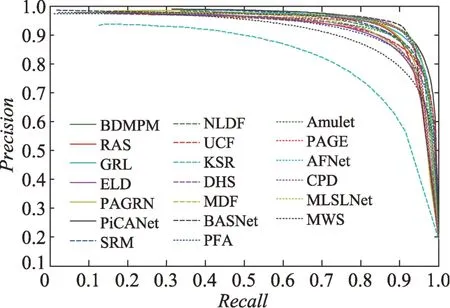

图10 到图14 给出了基于深度学习的显著性目标检测算法在5 个数据集DUT-OMRON、DUTS、ECSSD、HKU-IS 和PASCAL-S 上的P-R 曲线。

Fig.10 P-R curves on DUT-OMRON dataset图10 DUT-OMRON 数据集上的P-R 曲线

Fig.11 P-R curves on DUTS dataset图11 DUTS 数据集上的P-R 曲线

可以看出PoolNet 算法在5 个数据集上均取得了最佳性能,主要归因于其在池化方面做出的改进及采用特征聚合模块实现多尺度特征的无缝融合。

3.3 视觉比较

Fig.13 P-R curves on HKU-IS dataset图13 HKU-IS 数据集上的P-R 曲线

Fig.14 P-R curves on PASCAL-S dataset图14 PASCAL-S 数据集上的P-R 曲线

Fig.15 Visual comparison of different methods图15 不同方法的视觉比较

图15 给出了基于深度学习的不同显著性目标检测算法的视觉比较,从中可以看出:(1)基于边界/语义增强的显著性目标检测算法中,性能由高到低的算法依次为PoolNet、CPD 和BASNet。其中,BASNet算法专注于边界信息,能够检测出清晰的显著性目标边界,在简单的ECSSD 数据集和PASCAL-S 数据集中表现良好。但是,在相对复杂的DUT-OMRON等数据集中表现较差,这是因为缺乏丰富的高层语义信息。CPD 算法专注于提取高层特征包含的语义信息,因此在DUT-OMRON 等数据集中的表现优于BASNet算法。PoolNet算法性能最佳,是因为设计了池化金字塔从高层特征中提取了丰富的语义信息,同时设计了功能聚合模块实现了多尺度特征的无缝融合。(2)基于全局/局部结合的显著性目标检测的算法中,PAGR 算法取得了最佳性能,它在递归和多分辨率操作的基础上添加了注意力机制,使产生的特征更加有效。(3)在基于辅助网络的显著性目标检测算法中,MLSLNet 性能较好,其迁移的前景轮廓检测是有效的。(4)本文所提显著性目标检测的算法中,PoolNet 算法取得了最好的性能,得益于算法中的池化金字塔和功能聚合模块,获取了丰富的语义信息,同时实现了多尺度特征的无缝融合。

4 基于深度学习的显著性目标检测算法的不足与未来展望

近年,基于深度学习的显著性目标检测方法从不同方面进行了探索,如特征金字塔、池操作、注意力机制等,并取得了不错的性能。但是,现有方法也仍存在如下不足:

(1)现有显著性目标检测算法主要针对背景简单的图像,而实际图像一般均具有复杂背景,因此现有方法对复杂背景下的显著性目标检测还有很大的局限。

(2)对于实际应用场景,一般要求显著性目标检测具有很好的实时性,但是现有方法主要是针对静止图像或者是计算复杂度比较大,导致实时性差。

(3)现有显著性目标检测算法对大目标的检测效果较好,但是对实际应用中的小目标检测性能较差,不能满足实际应用的需求。

(4)现有显著性目标检测方法多采用矩形框定位显著性目标的位置,简单方便,但是由于显著性目标的大小形状各异,仅采用矩形框定位具有很大的局限性。

(5)现有显著性目标检测方法一般采用完全监督学习的方式训练模型,计算量和所需时间代价巨大,不满足实际应用环境和需求。

因此,为了克服现有方法的不足,未来基于深度学习的显著性目标检测可以从以下五方面展开研究:

(1)针对复杂背景下显著性目标检测性能较差的情况,设计适应复杂背景(对背景敏感或者前景背景对比度低等)的显著性目标检测模型,另外建立包含复杂背景的图像数据集,为新模型的训练与评估做好准备。

(2)为了满足实际应用中对实时性的需求,设计低复杂度、轻量级的显著性目标检测模型是显著性目标检测的一个研究热点。目前主要有三种方式:第一是直接在网络设计中对网络轻量级化,如轻量化网络模型SqueezeNet 在模型设计时规定了三种特有的设计原则,同时将不同的卷积封装成卷积网络模块;第二是采用深度可分离卷积,对卷积进行分离操作,然后在卷积层对神经网络进行归约,如MobileNet网络可以应用于移动端;第三是对网络直接进行压缩与编码,对网络进行剪裁,然后进行权值量化共享,最后采用霍夫曼编码降低存储。

(3)在某些实际特定场景中目标很小,如何对小目标进行有效检测以满足实际应用的需求,成为了当前急需解决的一个问题。因此,特定场景下小目标检测也是未来显著性目标检测的一个研究方向,可以使用分辨率更高的卷积特征图以及残差模块来增强对小目标的检测能力。

(4)针对显著性目标检测方法采用矩形框定位显著性目标的局限性,可以采用不同的措施进行不同尺度目标定位。由于不同位置可能对应着不同尺度或变形的物体,采用能够对尺度或者感受野大小进行自适应的可变形卷积来实现精确定位。另外,可以采用多点定位法完成显著性目标的位置定位。多点定位是指在显著性目标周围选取几个关键点,比如右上、左下、中心点和偏移量的测量。多点定位可以灵活地对显著性目标的轮廓完成定位,省时省力,不用像矩形框那样,提前设计并预留多个矩形框的存储。

(5)由于人为获取标签费时费力,且不符合一些场景的实际情况,因此为了克服这些缺陷,采用无监督或弱监督学习进行显著性目标检测模型的研究和设计将是未来的必然发展方向。

5 结束语

本文对基于深度学习的显著性目标检测方法进行了综述,通过对国内外研究现状的分析可知,基于深度学习的显著性目标检测算法得到了广泛研究,各种不同的方法被提出,但是检测性能还需要进一步提升,如检测精度、速度、复杂背景、小目标、弱监督等。因此,能够准确、实时地对复杂背景下的小目标进行弱监督显著性检测是未来基于深度学习的显著性目标检测不断追求的目标。