基于Faster R-CNN的旋转机械红外检测与识别

王 洋,杨 立

基于Faster R-CNN的旋转机械红外检测与识别

王 洋,杨 立

(海军工程大学 动力工程学院,湖北 武汉 430033)

旋转机械是机械设备的核心部件,一旦发生故障会造成不可估量的损失,因此旋转机械的实时监测诊断显得尤为必要。无人值守的红外智能监测诊断将是故障诊断新的发展方向,要实现红外智能监测诊断首先要准确识别旋转机械部件。本文利用红外热像仪监测旋转机械的运行状态,获得了电动机、联轴器、轴承座、齿轮箱等设备的红外热图;采用Faster R-CNN算法对测量得到的旋转机械红外图像进行了学习训练和目标识别,结果表明该算法能够准确识别旋转机械部件;研究了单角度和旋转角度红外监测的识别效果,发现在相同角度下使用红外灰度图像进行训练的检测效果比使用红外伪彩色图像训练的检测效果更佳;对比了4种预训练网络对于红外目标识别的影响,采用Resnet50预训练网络的平均检测精度为0.9345,识别精度更高。

旋转机械;红外检测;目标识别;Faster R-CNN

0 引言

旋转机械是指那些主要功能是由旋转运动来完成的机械设备[1],如电动机、发电机、柴油机、燃气轮机、蒸汽轮机、滚动轴承以及各种齿轮传动装置等机械设备。旋转机械在各行各业应用广泛、数量众多,通常是机械设备中的重要组成部件,旋转机械一旦发生故障将会造成不可估量的损失和影响,因此对于旋转机械的状态监测与故障诊断十分重要。

常用的监测与诊断技术主要有[2]:振动信号监测诊断技术、声信号监测诊断技术、温度信号监测诊断技术、润滑油的分析诊断技术、其他无损检测诊断技术。红外监测诊断技术是一种温度信号监测诊断技术,是利用红外技术了解和掌握设备的工作状态,早期发现故障并能预报故障发展趋势的监测诊断技术[3]。其优点在于成像评估、图像直观;非接触式、测温范围广;无需停机、高效评估;灵敏度、高分辨率[4],因此引起了国内外研究者的广泛兴趣。Tran等[5]利用红外热像仪采集旋转机械红外图像,通过二维经验模态分解进行聚类分析,可以准确地区分各种故障类型。孙富成等[6]利用红外热像仪采集变速箱两端轴承的红外热图像,通过二维经验模态分解与主成分分析法相结合进行图像融合,准确地诊断出轴承故障。

上述方法通过红外图像采集与分析来进行故障诊断,但未能实现智能化监测诊断。要实现智能化的旋转机械红外状态监测与故障诊断,第一步要准确识别红外图像中的各个旋转机械部件,分别对每个部件进行状态分析与故障诊断。而要智能识别旋转机械部件目标,则可以通过基于深度学习的目标检测算法来进行训练检测。

近几年,基于深度学习的目标检测算法迅猛发展,成为人工智能领域的研究热点之一。自2012 年Krizhevsky等提出的深度卷积神经网络(Deep Convolutional Neural Networks,DCNN)AlexNet[7]在大规模视觉识别挑战赛(ImageNet Large Scale Visual Recognition Challenge,ILSVRC)[8]上实现了创纪录的图像分类准确度之后,许多计算机视觉应用领域都将研究重心放在了深度学习方法上,涌现了许多基于深度学习的目标检测算法,其中具有代表性的主要有R-CNN(Regions with Convolutional Neural Networks features)[9]、Fast R-CNN[10]、Faster R-CNN[11]、YOLO(You Only Look Once)v1[12]、SSD(Single Shot MultiBox Detector)[13]、YOLO v2[14]、Mask R-CNN[15]、YOLO v3[16]等,这些算法在机器人视觉、消费电子产品、安保、自动驾驶、人机交互、基于内容的图像检索、智能视频监控和增强现实[17-22]等领域都有广泛的应用,取得了较好的检测效果。

由于Faster R-CNN算法具有广泛的应用和较好的效果,本文将通过基于深度学习的Faster R-CNN目标检测算法对红外图像进行学习训练,使用训练完成的探测器来实现旋转机械红外图像部件智能识别,为旋转机械状态监测与故障诊断提供基础。

1 Faster R-CNN目标检测算法

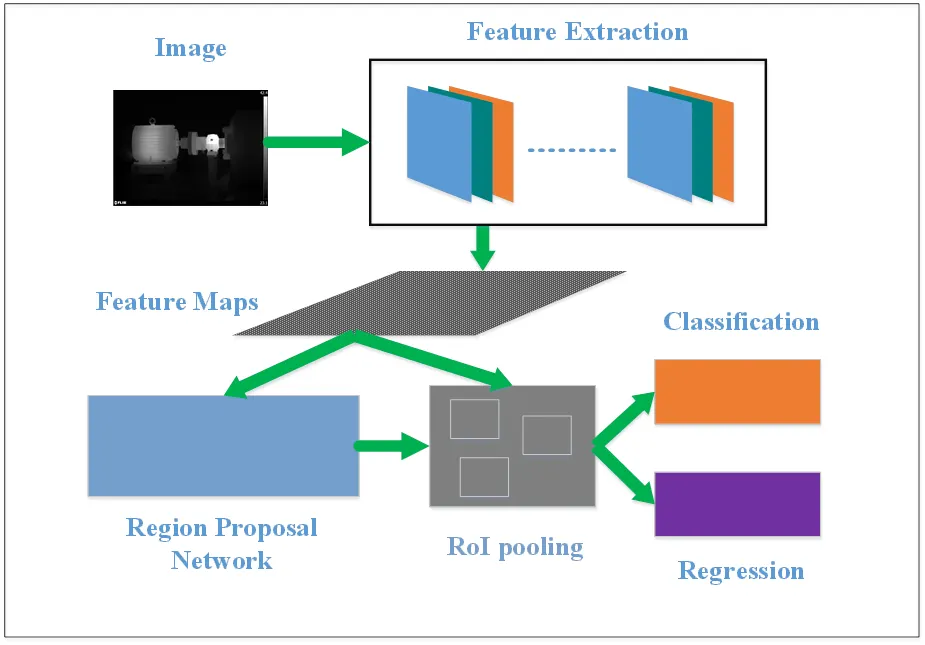

Faster R-CNN是由Ross Girshick等人继2014年推出R-CNN,2015年推出Fast R-CNN之后推出的更快、更准的目标检测网络,其结构框架如图1所示,包含4个关键模块,即Feature Extraction(特征提取网络)、Region Proposal Network(区域建议网络,简称RPN)、Classification(区域分类)、Regression(区域回归)。用一个神经网络将这4个模块结合起来,训练了一个端到端的网络。

图1 Faster-RCNN结构图

图片输入Faster R-CNN网络后,首先由特征提取网络(常用一些预训练好的网络Alexnet[7]、Googlenet[23]、VGG[24]、Resnet[25]等)来提取特征图,然后在特征图上的每一个锚点上取多个候选的区域,并根据相应的比例将其映射到原始图像中;接着将这些候选的区域输入到区域建议网络(RPN)中,RPN网络对这些区域进行分类,确定这些区域是前景还是背景,同时对其进行初步回归,计算这些前景区域与真实目标之间的偏差值,然后做非极大值抑制,即根据分类的得分对这些区域进行排序;接着对这些不同大小的区域进行RoI pooling(区域池化)操作,输出固定大小的特征图;最后将其输入简单的检测网络中,然后利用卷积进行区域分类,同时进行区域回归,精确调整区域,从而输出最优目标区域及区域得分。

2 实验分析

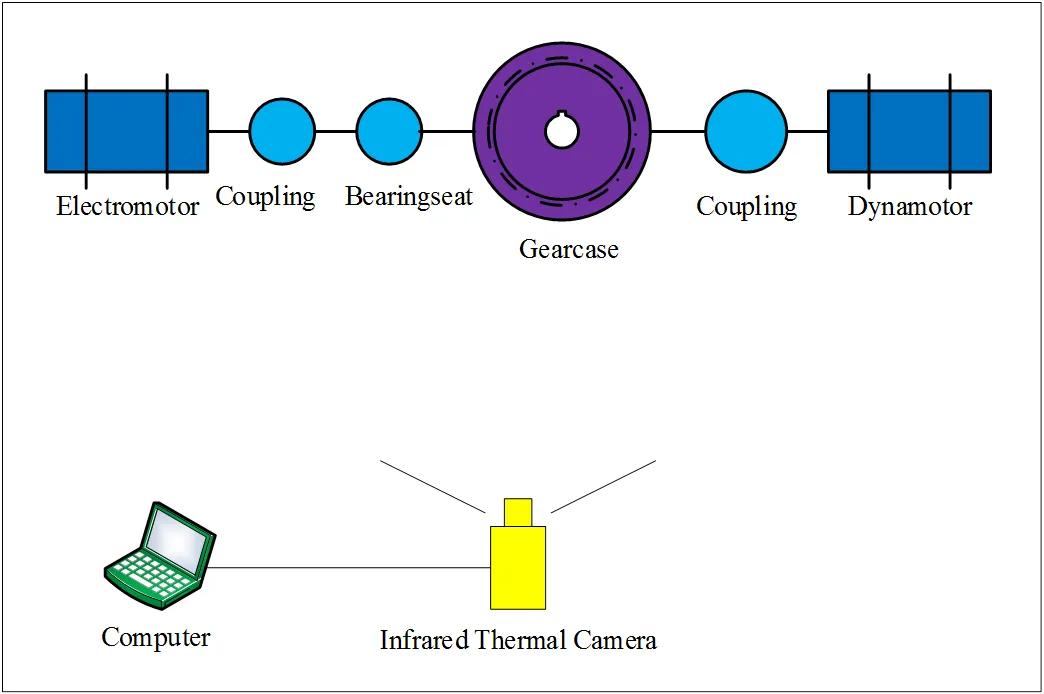

对于旋转机械的红外监测可以采用视频监控的模式,本文通过搭建一套由电动机、滚动轴承、联轴器、轴承座、齿轮箱、发电机组成的旋转机械实验台来进行研究分析,实验台结构如图2所示。

在准确设置热像仪参数的条件下,采用笔记本电脑连接FLIR T650sc热像仪采集各个不同角度下旋转机械运行5~15min的红外视频,采集不同角度下红外图像60张,以供深度学习算法进行学习训练和检测评估,部分图像数据如图3所示。

2.1 单角度下旋转机械红外灰度图像目标识别

视频监控主要通过固定角度和自动旋转角度两种方式,首先我们选取一段10min的单角度红外视频进行分析研究,分别间隔1s、2s、4s、8s从视频提取红外灰度图像600张、300张、150张、75张,图片尺寸均为640像素×480像素,使用Matlab中ImageLabel对图像中的各个旋转机械部件进行标记并生成标准数据集,然后使用目标探测网络Faster R-CNN进行学习训练,数据集中前80%的数据用于训练,后20%的数据为测试集用于检测评估。训练使用SUPERMICRO服务器,配置为Windows Server 2012系统、Intel(R)Xeon(R)CPU E5-2695 v4@2.10GHz处理器、512G内存、NVIDIA Tesla K80显卡。在相同训练参数设置下,4种不同数量数据集下训练完成的探测器对于单张测试图片的检测效果如图4所示。

图2 实验平台组成结构图

图3 部分不同角度下的图像数据

图4 四种不同数量数据集训练的探测器对单张图片检测效果

从图4中可以看出4种探测器均能识别出旋转机械部件,但是不同的探测器检测出来的各部件的位置、大小稍微有一些差异。为了更准确地评估训练检测效果,使用召回率(Recall)、精确度(Precision)、平均精度(Average-Precision,AP)以及mAP(mean Average-Precision)、交并比(IoU,Intersection-over- Union)等指标对探测进行量化评估。

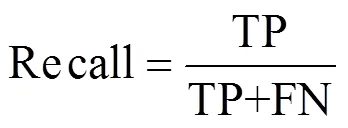

召回率即目标从包含目标的图像中被成功检测出来的比例,计算公式为:

式中:TP(True Positives)代表目标识别正确的数量、FN(False Negatives)代表目标识别错误的数量。

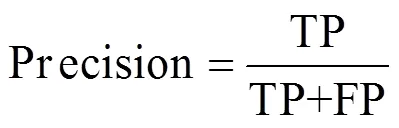

精确度即检测到目标的图像中真正包含目标的比例,计算公式为:

式中:TP(True Positives)代表目标识别正确的数量、FP(False Positives)代表其他目标错误的识别为此目标的数量。

平均精度(AP)为Precision-Recall曲线下面的面积,其大小在[0,1]区间,通常来说AP值越高,分类器越好。mAP指多个类别AP的平均值,是目标检测算法中最重要的一个指标。

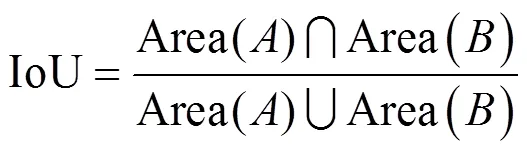

交并比(IoU)指系统预测出来的目标区域与原来图片中标记的目标区域的重合程度,计算公式为:

式中:Area()表示原图中标记的目标区域;Area ()表示探测器检测出来的目标区域。

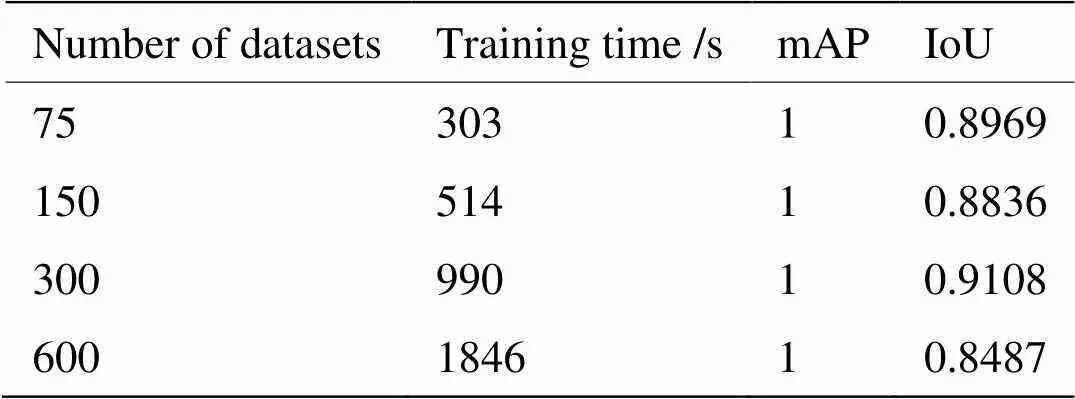

使用测试集数据对4种探测器进行检验评估,可以得到不同数量数据集下网络训练及检测情况如表1所示。

表1 四种不同数量数据集下网络训练检测情况

由表1可以看出,训练集越大,训练时间越长;平均精度都为1,说明4种探测器均能准确识别旋转机械部件,但是识别的范围不尽相同,从交并比数据上可以看出探测器识别出的范围与真实目标范围的偏差程度,在提取300张数据集时检测评估交并比最大,说明该检测更准确,600张数据集的检测效果较差,说明相同数据量过大,反而出现过拟合现象。

2.2 单角度下旋转机械红外伪彩色图像目标识别

基于上面的分析,从10min视频中提取300张图像具有较好的训练检测效果的图像,为此从相同红外视频中间隔2s提取红外伪彩色图像300张、相同数据的红外灰度图像300张,图片尺寸均为640像素×480像素,同样使用Matlab中ImageLabel对图像中的各个旋转机械部件进行相同的位置标记并生成标准数据集,使用相同的目标探测网络Faster R-CNN进行学习训练,同样前80%的数据用于训练,后20%的数据用于检测评估,训练完成的探测器对于单张图片的检测结果如图5所示。

图5 不同图像类型下训练的探测器对单张图片检测效果

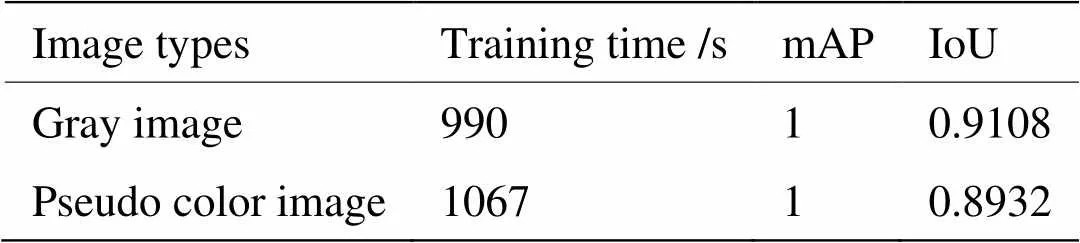

为了更准确地评估不同图像类型下的训练检测效果,使用测试集数据进行检验评估,可以得到不同图像类型下网络训练检测情况如表2所示。

表2 不同图像类型下网络训练检测情况

由表2可以看出,两种图像的训练时间相差77s,检测的平均精度一样,此外,灰度图像检测的目标区域交并比更高,检测效果更好。

2.3 多角度下旋转机械红外灰度图像目标识别

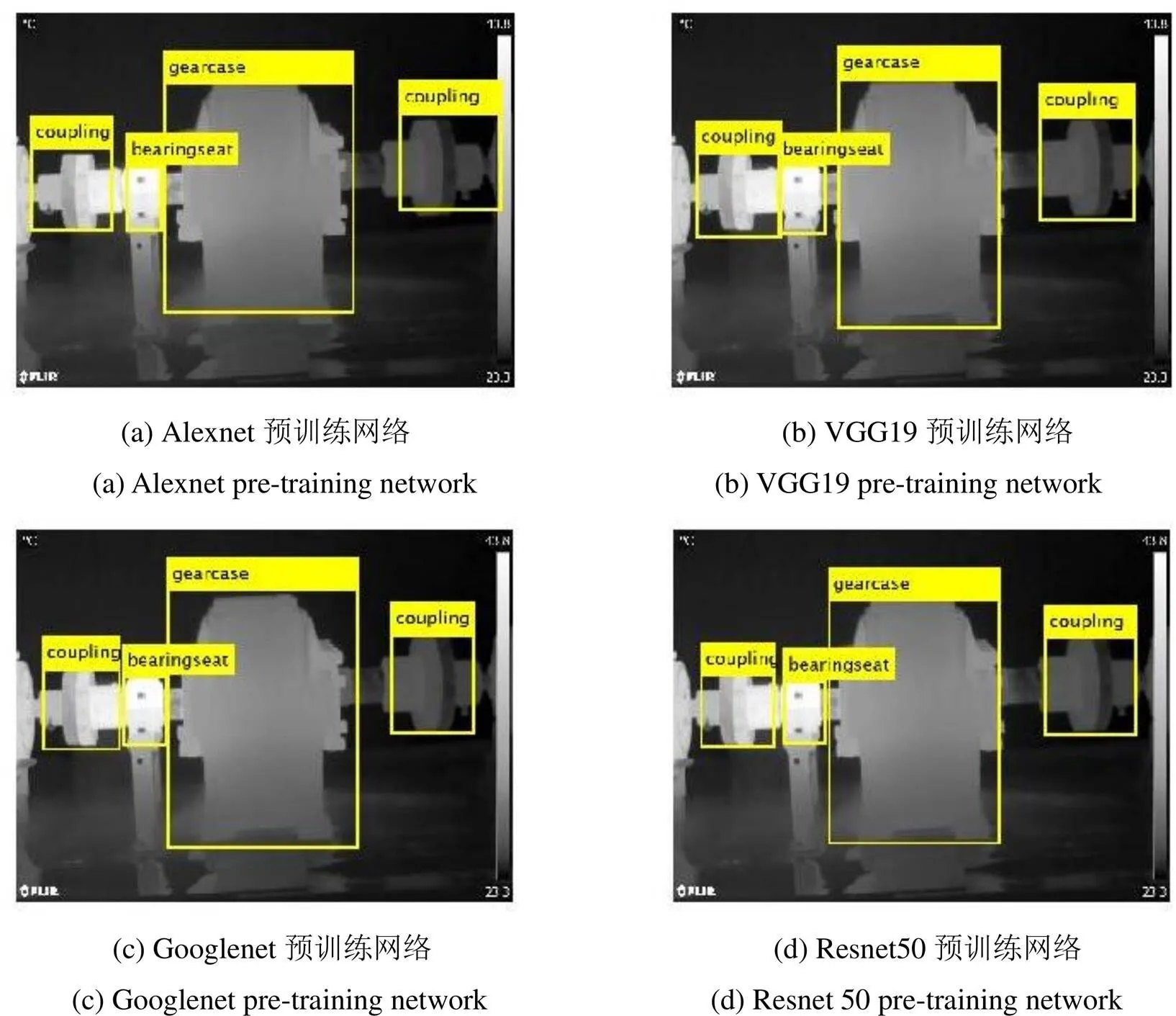

对于自动旋转型监控模式,可以通过不同角度下采集的红外视频和图像进行训练研究。由于灰度图像具有较好检测效果,因此本文从采集的多角度红外视频和图像中提取灰度图像1300张,选择其中的1000张图片作为训练集,剩余的300张图片作为测试集,图片尺寸均为640像素×480像素,同样使用Matlab中ImageLabel对训练集和测试集图片中的各个旋转机械部件进行标记,一共6个部件类型标签,并生成标准数据集,然后使用目标探测网络Faster R-CNN进行学习训练,在训练中选择不同的预训练网络Alexnet、VGG19、Googlenet、Resnet50等进行特征提取。在相同训练集、测试集,相同的参数设置下,不同预训练网络对于单张图片的检测效果如图6所示。

图6 不同预训练网络下的单张图片检测效果

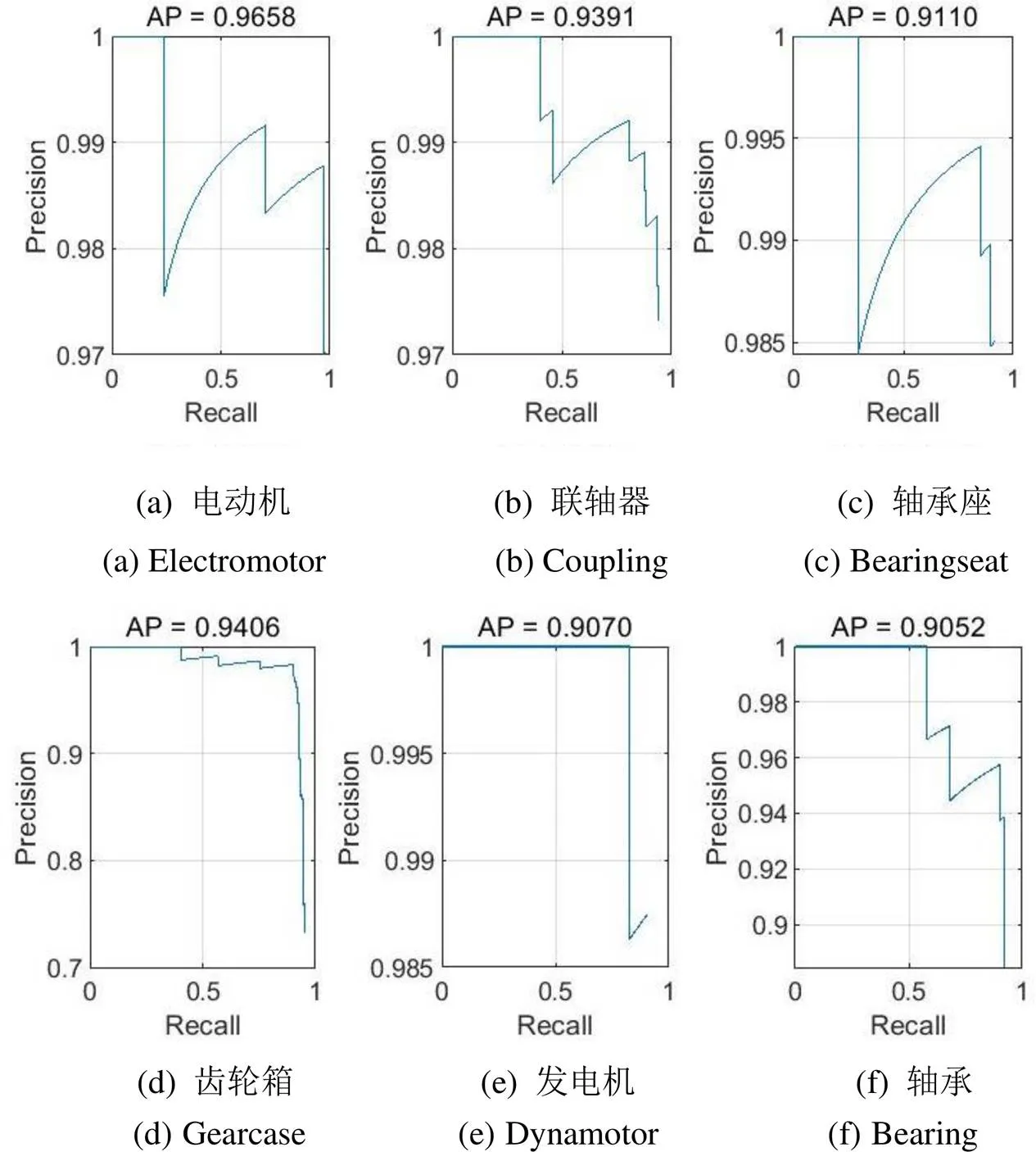

由图6可以看出4种探测器均能识别旋转机械部件,其中Alexnet预训练检测结果中联轴器(Coupling)的检测位置有明显偏差,其余基本能够检测出旋转机械部件。为了更准确地评估4种探测器的训练检测效果,使用测试集数据进行检验评估,可以得到不同预训练网络下的Precision- Recall曲线如图7~图10所示。

图7 Alexnet预训练网络下6个目标的PR曲线

图8 VGG19预训练网络下6个目标的PR曲线

图9 Googlenet预训练网络下6个目标的PR曲线

图10 Resnet50预训练网络下6个目标的PR曲线

图7中Alexnet预训练下6个目标平均检测精度(mAP)为0.9281,图8中VGG19预训练下6个目标平均检测精度为0.9188,图9中Googlenet预训练下6个目标平均检测精度为0.8735,图10中Resnet50预训练下6个目标平均检测精度为0.9345,由mAP数据可以看出使用Resnet50作为预训练网络具有最佳的检测效果。

3 结论

本文采用Faster R-CNN算法对旋转机械红外图像进行了训练和检测,实验表明,该方法可以应用于旋转机械红外目标检测,能够自动识别旋转机械部件。在单角度下通过不同间隔时间提取不同数量图片进行检测评估,得出单角度下10min红外视频提取300张左右图片训练检测效果最佳。通过分析相同角度下红外灰度图像和红外伪彩色图像训练检测结果得知,使用红外灰度图像进行训练检测效果更佳。通过对比不同预训练网络下的目标检测效果得知,在Resnet50的预训练网络下,红外目标检测效果最佳。旋转机械红外目标识别主要是为旋转机械各部件智能故障诊断打下坚实基础,下一步对各部件的故障类别和故障程度进行智能判别,建立一套旋转机械故障监测诊断系统。

[1] 孙颖. 旋转机械故障的研究及常见故障[J]. 知识经济, 2010(16): 117.

SUN Ying.Research on common faults and faults of rotating machinery [J]., 2010(16): 117.

[2] 沈庆根, 郑水英. 设备故障诊断[M]. 北京: 化学工业出版社, 2005.

SHEN Qinggen, ZHENG Yongying. Equipment fault diagnosis[M]. Beijing:, 2005.

[3] 程玉兰. 红外诊断技术与应用(一)[J]. 设备管理与维修, 2003(9): 41-43.

CHENG Yulan. Infrared diagnosis technology and Application(1)[J]., 2003(9): 41-43.

[4] Bagavathiappan S, Lahiri B B, Saravanan T, et al. Infrared thermography for condition monitoring – A review[J]., 2013, 60(5): 35-55.

[5] Tran Van Tung, YANG Bo-Suk, GU Fengshou, et al. Thermal image enhancement using bi-dimensional empirical mode decomposition in combination with relevance vector machine for rotating machinery fault diagnosis[C]//, 2013, 38(2): 601-614.

[6] 孙富成, 宋文渊, 滕红智, 等. 基于红外热图像的变速箱轴承状态监测与故障诊断[J]. 电光与控制, 2017, 24(7): 113-117.

SUN Fucheng, SONG Wenyuan, TENG Hongzhi, et al.Infrared Thermal Image Based Condition Monitoring and Fault Diagnosis of Gearbox Bearings[J]., 2017, 24(7): 113-117.

[7] Krizhevsky A, Sutskever I, Hinton G. ImageNet Classification with Deep Convolutional Neural Networks[J]., 2017, 60(6): 84-90.

[8] Russakovsky O, Deng J, Su H, et al. Image Net Large Scale Visual Recognition Challenge[J]., 2015, 115(3): 211-252.

[9] Girshick R, Donahue J, Darrell T, et al. Rich Feature Hierarchies for Accurate Object Detection and Semantic Segmentation[C]//, 2014: 580-587.

[10] Girshick R. Fast R-CNN[C]//, 2015: 1440-1448.

[11] REN S, HE K, Girshick R , et al. Faster R-CNN: Towards Real-Time Object Detection with Region Proposal Networks[J]., 2015, 39(6): 1137-1149.

[12] Redmon J, Divvala S, Girshick R, et al. You Only Look Once: Unified, Real-Time Object Detection[C]//, 2016: 779-788.

[13] LIU W, Anguelov D, Erhan D, et al. SSD: Single Shot MultiBox Detector[C]//, 2016: 21-37.

[14] Redmon J, Farhadi A. YOLO9000: Better, Faster, Stronger[C]//, 2017: 6517-6525.

[15] HE K, Gkioxari G, Dollar P, et al. Mask R-CNN[J]., 2017(99): 1.

[16] Redmon J, Farhadi A. YOLOv3: An Incremental Improvement[J/OL]. 2018, https://arxiv.org/abs/1804.02767.

[17] LIU L, OUYANG W, WANG X, et al. Deep Learning for Generic Object Detection: A Survey[J]., 2020, 128(2): 261-318.

[18] 王林, 张鹤鹤. Faster R-CNN模型在车辆检测中的应用[J]. 计算机应用, 2018, 38(3): 666-670.

WANG Lin, ZHANG Hehe. Application of Faster R-CNN model in vehicle detection[J]., 2018, 38(3): 666-670.

[19] 桑军, 郭沛, 项志立, 等. Faster-RCNN的车型识别分析[J]. 重庆大学学报,2017, 40(7): 32-36.

SANG Jun, GUO Pei, XIANG Zhili, et al.Vehicle detection based on faster-RCNN[J].,2017, 40(7): 32-36.

[20] 张汇, 杜煜, 宁淑荣, 等. 基于Faster RCNN的行人检测方法[J]. 传感器与微系统, 2019, 38(2): 147-149, 153.

ZHANG Hui, DU Yu, NING Shurong, et al. Pedestrian detection method based on Faster RCNN[J]., 2019, 38(2): 147-149, 153.

[21] 史凯静, 鲍泓, 徐冰心, 等. 基于Faster RCNN的智能车道路前方车辆检测方法[J]. 计算机工程, 2018, 44(7): 36-41.

SHI Kaijing, BAO Hong, XU Bingxin, et al. Forward Vehicle Detection Method of Intelligent Vehicle in Road Based on Faster RCNN[J]., 2018, 44(7): 36-41.

[22] 朱虹, 翟超, 吕志, 等. 基于Faster-RCNN的智能家居行人检测系统设计与实现[J]. 工业控制计算机, 2018, 31(4): 68-70.

ZHU Hong, ZHAI Chao, LU Zhi, et al. Smart Home Pedestrian Detection System Based on Faster-RCNN[J]., 2018, 31(4): 68-70.

[23] Szegedy C, Liu W, Jia Y, et al. Going Deeper with Convolutions[C]//, 2015: 1-9.

[24] Simonyan K, Zisserman A. Very Deep Convolutional Networks for Large-Scale Image Recognition[J/OL]. 2014,https://arxiv.org/abs/1409. 1556.

[25] HE K, ZHANG X, REN S , et al. Deep Residual Learning for Image Recognition[C]//, 2016: 770-778.

Infrared Detection and Identification of Rotating Machinery Based on Faster R-CNN

WANG Yang,YANG Li

(College of Power Engineering, Naval University of Engineering, Wuhan 430033, China)

Rotating machinery is the core component of mechanical equipment and canthus cause a significant loss ifit breaks down. Therefore, real-time monitoring and diagnosis of the rotating machinery is critical. Automatedinfrared intelligent monitoring and diagnosis is a recent development infault diagnosis. To realize infrared intelligent monitoring and diagnosis, it is necessary to accurately identify rotating machinery components. In this study, an infrared thermal camera was used to monitor the running state of the rotating machinery and infrared images of the motor, coupling, bearing seat, gearbox, and other equipment. The Faster R-CNN algorithm wasused to train the rotating-machinery infrared imagesand to identify the targets. The results showed that the algorithm can accurately identify rotating machinery components. The recognition effect of single-angle and rotating-angle infrared monitoring was studied. It was found that the detection effect of infrared gray images fortraining at the same angle is better than that of infrared pseudo-color images. The influence of four types of pre-training networks on infrared target recognition was compared. The average detection accuracy of the resnet50 pre-training network was 0.9345, and the recognition accuracy washigher.

rotating machinery, infrared detection, object identification, Faster R-CNN

TK38

A

1001-8891(2020)11-1053-08

2020-03-07;

2020-09-08.

王洋(1986-),男,硕士研究生,主要研究方向为红外故障诊断。E-mail: 373647411@qq.com。