基于BEMD改进的视觉显著性红外和可见光图像融合

崔晓荣,沈 涛,黄建鲁,王 笛

基于BEMD改进的视觉显著性红外和可见光图像融合

崔晓荣,沈 涛,黄建鲁,王 笛

(火箭军工程大学,陕西 西安 710025)

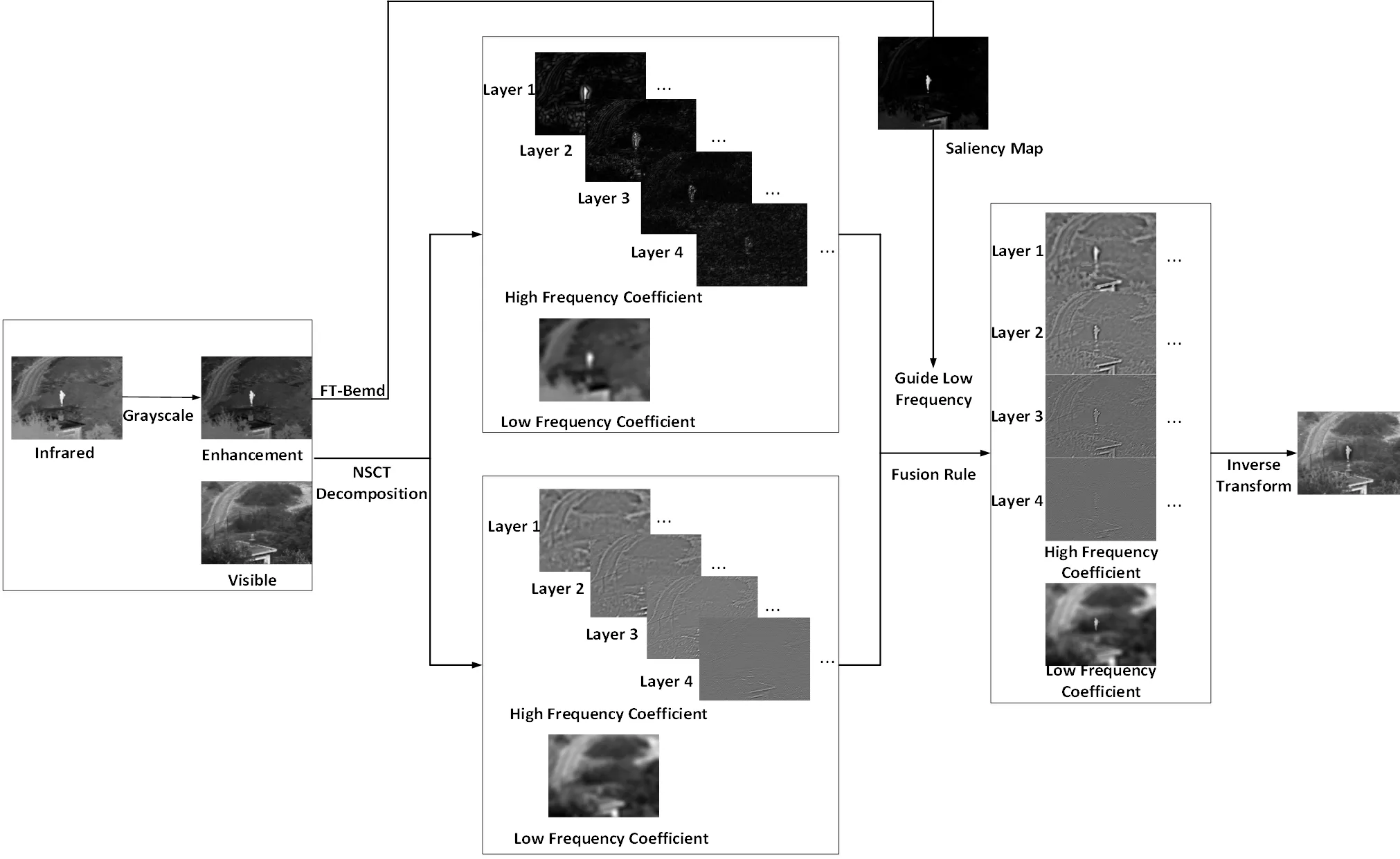

针对视觉显著性融合过程中目标对比度低,图像不够清晰的问题,本文提出一种基于二维经验模态分解(bidimensional empirical mode decomposition,BEMD)改进的Frequency Tuned算法。首先利用BEMD捕获红外图像的强点、轮廓信息用于指导生成红外图像的显著性图,然后将可见光图像和增强后的红外图像进行非下采样轮廓波变换(nonsubsampled contourlet transform,NSCT),对低频部分采用显著性图指导的融合规则,对高频部分采用区域能量取大并设定阈值的融合规则,最后进行逆NSCT变换生成融合图像并进行主观视觉和客观指标评价,结果表明本文方法实现了对原图像多层次、自适应的分析,相较于对比的方法取得了良好的视觉效果。

图像融合;二维经验模态分解;显著性图;非下采样轮廓波变换

0 引言

伴随着传感器技术的发展,多源图像融合的种类和质量日益提高,融合后的图像不仅要起到增强的目的,还需要重点突出关键信息,便于人眼和机器更好的甄别和探测。在多源图像融合中,红外和可见光图像几乎可以呈现出所有对象固有的特征,研究成果又具有代表性意义,其算法和模型往往可以作为其它多源融合的基础。融合应用的又最为广泛,已在导弹制导、红外夜视、海关缉私、海上救援、森林消防、资源勘探、生物医学等[1-2]领域得到广泛和深入的研究。

融合过程依赖多尺度分解对不同频率成分进行区分和筛选,因而推动着多尺度分析理论的发展,愈加灵活的局部多方向性多分辨率图像表示方法及其改进方案层出不穷。基于轮廓波及其改进的非下采样轮廓波变化[3]、基于传统Shearlet变化的非下采样剪切波变化[4](nonsubsampled shearlet transform,NSST)、基于二维经验模态分解[5]改进的快速自适应二维经验模态分解(fast and adaptive bidimensional empirical mode decomposition,FABEMD)等多尺度分析工具已经成功应用于图像融合领域。其中NSCT不仅具有多分辨率、局部化、多方向、平移不变等优良特性,还能够进行很好的稀疏表示,可降低工程应用中对配准精度的要求,特别适合应用在传感器信号处理中。

近年来,随着机器学习的发展,视觉显著性检测逐渐成为研究热点。视觉显著性用于描述一幅图像或一个场景中某些物体吸引人视觉注意的能力,这种能力差别在于其与周围物体的差异性或者观察者的主观经验,通常由人眼注视点在此区域的密集程度表示[6]。视觉显著性应用于图像融合,已经取得了良好的效果。Harel等[7]提出了一种新的自下而上的视觉显著性模型,即基于图的视觉显著性(graph-based visual saliency,GBVS)。它包括两个步骤:首先在某些特征通道上形成激活图,然后以突出显著性并允许与其它图结合的方式对其进行规范化。该模型很简单,并且在自然并行化的范围内具有生物学上的合理性,但是提取出的特征对象边界模糊,不能稳固地突出显示显著区域,甚至远离对象边界。Hou等[8]提出的谱残差(spectral residual, SR)方法,试图将图像转移到频域中去掉背景信息来进行显著性检测。Achanta等[9]提出的Frequency-Tuned(FT)显著性计算方法,利用颜色和亮度输出具有清晰定义显著对象边界的全分辨率显著图,且保留了更多的频率内容,但是由于使用了高斯滤波器,在平滑图像细节的同时也使得图像边缘变得模糊。

傅等人[10]用引导滤波器改进FT显著性检测算法,用图像引导滤波器来代替原算法中的高斯核函数,并将其应用到红外图像显著性检测,有效突出了红外目标和可见光背景信息。林等人[11]使用L0范数图像平滑改进FT算法来提取红外图像的显著性图,并对可见光图像进行对比度受限的自适应直方图均衡化处理,对红外图像进行S型曲线对比度拉伸变换,最终得到细节信息更丰富,目标区域也更为突出的融合图像。安影等[12]对基于FT算法的最大对称环绕显著性检测(saliency detection using maximum symmetric surround,MSS)做暗抑制改进(dim-suppressed MSS,DSMSS),将其用于基础层的融合上,并结合改进的显著性检测和引导滤波对细节层进行融合,取得了较好的融合效果。

Nunes等[13]提出的二维经验模态分解,BEMD是一维EMD[14]的二维拓展,主要用于图像信号的多尺度分析,在图像融合、光谱分析等方面成功运用。通过BEMD可以获得原始图像多尺度的二维固态模函数(bidimensional intrinsic mode function,BIMF)。它对于图像中的细节信息,比如轮廓,强点,具有更强的描述能力,已在实际图像处理中得到成功验证[15]。其分解得到的多模态成分对于描述原图像的全局和细节特性具有良好的互补性,算法提取的子图像符合视觉感知的成分,具有独特的优势。

针对上述问题,本文在Frequency-tuned显著性检测算法的基础上引入二维经验模态分解对其进行改进,并利用灰度因子[16]来调节红外图像的整体质量,最后结合NSCT分解原理进行滤波器的选择和参数的设置,以达到最佳的分解效果,并设计融合规则来完成系数融合和重构过程[17]。

1 基于二维经验模态分解改进的红外图像显著性检测算法

1.1 改进Frequency-tuned显著性检测模型

显著图依靠灰度信息将人眼对各个区域感兴趣的程度进行量化,FT显著性检测依托人的视觉处理机制,对注意力集中的自下而上的显著性进行处理,受到生物学概念的启发,利用颜色特征的中央-周边算子来得到显著图,从频率角度分析图像,转化成低频部分和高频部分。低频部分反映了图像的整体信息,如物体的轮廓和基本的组成区域。高频部分则反映了图像的细节信息,如物体的纹理。显著性区域检测用到的更多的是低频部分的信息,相比其他显著性检测原理,更加符合人的视觉体验。

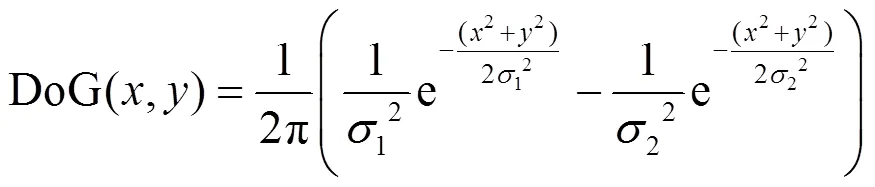

为了保留原始图像最佳频率特征,FT算法中使用高斯差分算子DoG来进行滤波,如下式:

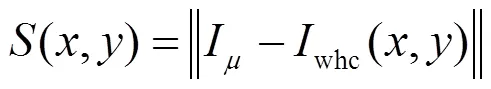

式中:1和2的值决定带通滤波器得到的空间频率值是否合适,当1>2时,低频截止由1确定,而高频截止由2确定。文献[9]中将1驱动到无穷大,以保留所有其它频率。为了消除高频噪声和背景纹理,使用5×5高斯核,最终高频截止频率使用给出的p/2.75。获取图像的显著性公式为:

式中:是图像平均特征向量;whc(,)是原始图像经过高斯模糊后对应(,)位置像素值,而||×||是L2范数,用欧式距离计算,同时计算Lab空间下每点与均值的欧式距离作为显著值。

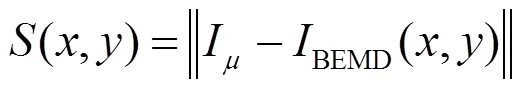

将DoG作为卷积核在平滑图像细节的时候不可避免带来边缘模糊的现象,将其应用在FT显著性检测中,虽然依靠设置阈值突出了目标区域,但是显著性区域边界和显著性对象质量有待进一步提高,本文利用二维经验模态分解对原图像中轮廓、强点等较强的凸显能力,对FT算法进行了改进:

式中:BEMD(,)是由二维经验模态分解得到的内蕴模式函数和残余项得到的。

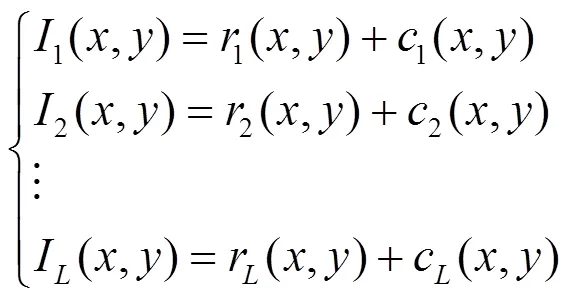

1.2 二维经验模态分解

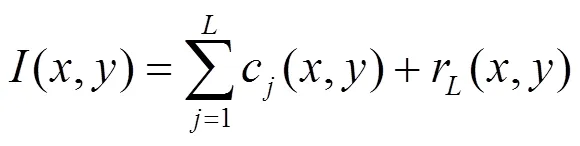

BEMD具有二维图像处理能力,经过BEMD分解得到二维本征模态函数(BIMFs)和残余分量(Residual),可设置参数实现对原图像多层次、自适应的分析。对于图像中的特殊信息,比如轮廓、强点等具有更强的描述能力,经过分解得到如下公式:

式中:c(,)代表层BIMF,≤,r(,)为最终趋势图像。本研究为了更好利用BEMD分解之后得到的细节信息,对图像(,)的分解设置为以下步骤:

1)输入图像,分解层数设置为(代表了BIMFs的个数);

2)残差分量设为,令0=(,);

3)在图像平面中提取局部极大、极小值,使用3×3邻域窗口方法从中获取局部极大值矩阵和极小值矩阵;

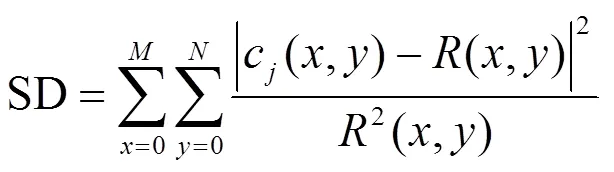

6)更新c(,)=-av,利用c精度,判断筛选过程是否满足迭代停止条件。若不满足精度,则令=c,进入筛选流程,返回步骤3);若满足精度则令R=R-1-c,返回步骤3),继续分解直到层。精度SD(standard deviation)[14]选取标准差准则如下:

式中:原图像大小为×,(,)为像素位置。

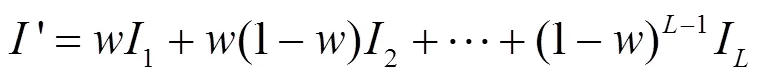

在二维模态分解过程中,选取中间过程得到下式:

式中:为原始图像;表示分解层数,随着分解尺度的增加,余量层表示的基础层信息会逐渐变模糊,细节层特征也逐渐消失,所以为了更好地指导显著性图,并不适宜取得过大。本文设计如下自适应加权规则来提取余量层和细节层信息:

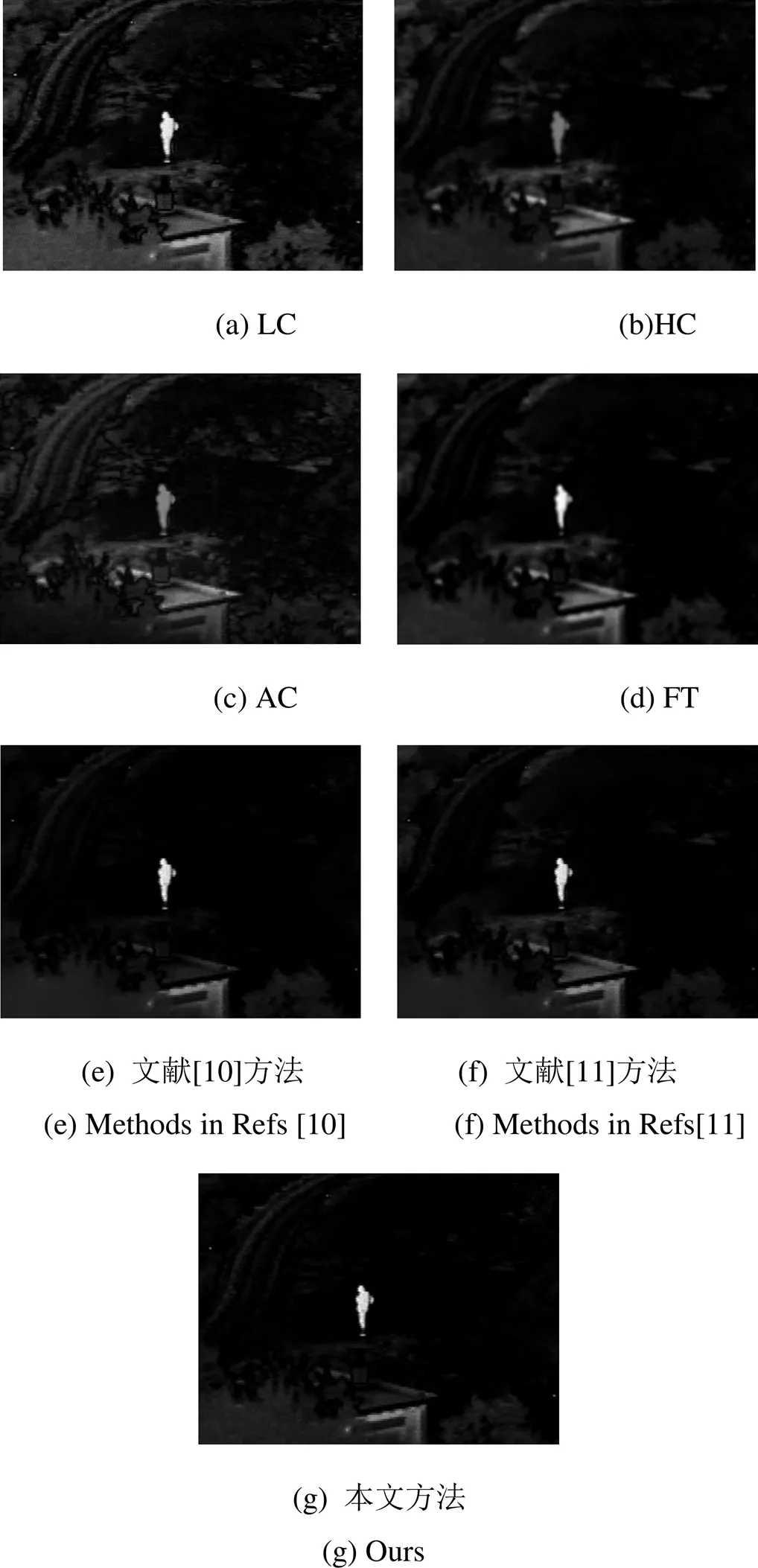

式中:B为归一化以后得到的融合信息,接着将图像数组进行数值类型转换即得到BEMD。分解得到的混合多模态成分对于描述原始图像的全局和细节特性具有良好的互补性。

1.3 红外图像显著性检测

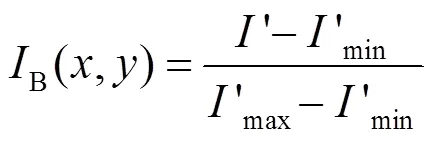

将FT算法、基于全局对比度的LC(spatial attention model contrast-LC)[18]算法和HC(histogram contrast)算法[19]、基于局部对比度的AC(achanta contrast)[20]算法、文献[10]用引导滤波器改进FT显著性检测算法、文献[11]使用L0范数图像平滑改进的FT算法和本文算法进行对比实验,并对显著性检测结果进行主观视觉评价。

原始红外图像选自荷兰TNO Human Factors Research Institute拍摄的“UN camp”,如图1所示,

对比结果如图2所示。

图1 原始红外图像

图2 不同显著性算法检测结果

从视觉效果上,本文显著性方法处理后的效果明显优于经典的FT算法,LC算法,HC算法。和文献[10]方法和文献[11]方法处理结果对比,目标人物轮廓更加清晰,亮度有所增加,对无用背景信息的抑制更加充分。

2 基于显著性指导的NSCT融合

2.1 红外图像灰度因子增强处理

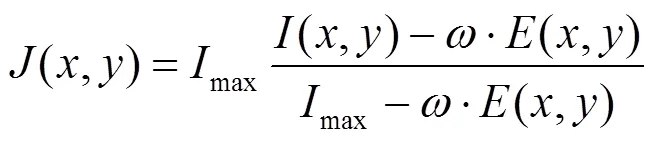

针对红外图像成像机理而导致对比度低,视觉效果模糊的问题[21],本文对原红外图像进行NSCT分解之前先对红外图像进行预处理,采用如下处理方式:

式中:,wj为第j个像素对应的窗口,wj为图像中第j个像素相对应的权值;Eg为原始灰度因子值;E(x, y)为导向滤波后的灰度值;J为处理后图像;I为原始图像;Imax为原红外图像最大灰度值,w∈(0,1)为修正系数。

经过灰度因子处理以后,图3(b)有效增强了红外图像对比度,也更好地保留了细节信息,和原图像进行对比,可以明显感觉到整幅图像的“雾”明显减少,景深更富有层次感,即红外图像得到增强。

2.2 基于NSCT的分解过程

NSCT分解由非下采样塔式滤波器组(Nonsubsampled Pyramid Filter Bank,NSPFB)和非下采样方向滤波器组(Nonsubsampled Directional Filter Bank,NSDFB)两部分组成,第一步利用非下采样金字塔(Nonsubsampled Pyramid,NSP)对图像进行多尺度分解以有效捕获图形中的奇异点。第二步由二通道无下采样扇形滤波器组进行方向分解,由二通道分解得到四通道子带系数。NSCT独到之处在于对相应的滤波器进行上采样操作,消除了频谱混叠现象,具有优良的平移不变特性,而且分解得到的子带图像和原图像大小相同。

如图4,NSCT分解结构示意图,表示出了NSCT分解的完整过程。原图像首先经非下采样金字塔(NSP)分解为一个低频子带L1和一个高频子带B1;高频子带继续依赖非下采样方向滤波器组得到带通方向子系数,目标物的轮廓和细节特征就包含在其中。

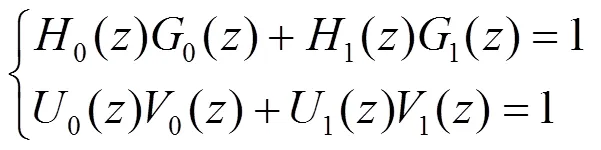

NSCT所依赖的二通道无下采样塔形滤波器组和二通道无下采样扇形方向滤波器组都满足Bezout恒等式,如下式,保证了完全重构(Perfect Reconstruction,PR)条件:

式中:0、1和0、1为NSPFB的分析滤波器和综合滤波器,0、1和0、1为NSDFB的分析滤波器和综合滤波器。对滤波器0()和1()选择对应的采样矩阵进行上采样和滤波操作,实现精确方向分解,提高了方向分辨率,并且没有增加计算复杂度。

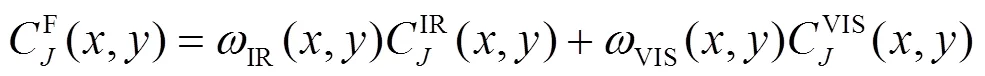

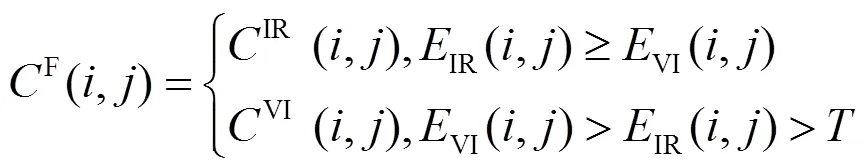

2.3 融合规则的设计

式中:IR+VIS=1。IR为(,)经过归一化以后得到的权重图。

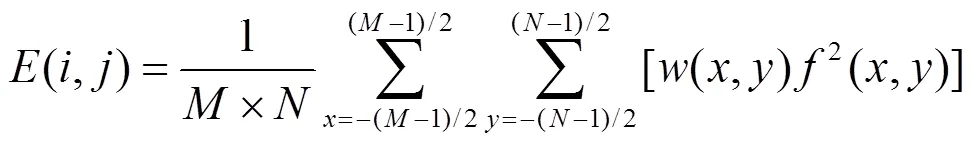

式中:(,)表示某像素点(,)邻域窗口能量值,局部区域×取为3×3。(,)为(,)处像素点的灰度值,(,)为权值且离像素点(,)越近则权值越大,为设定的阈值,本文根据选取局部区域的窗长来确定。

3 实验结果与分析

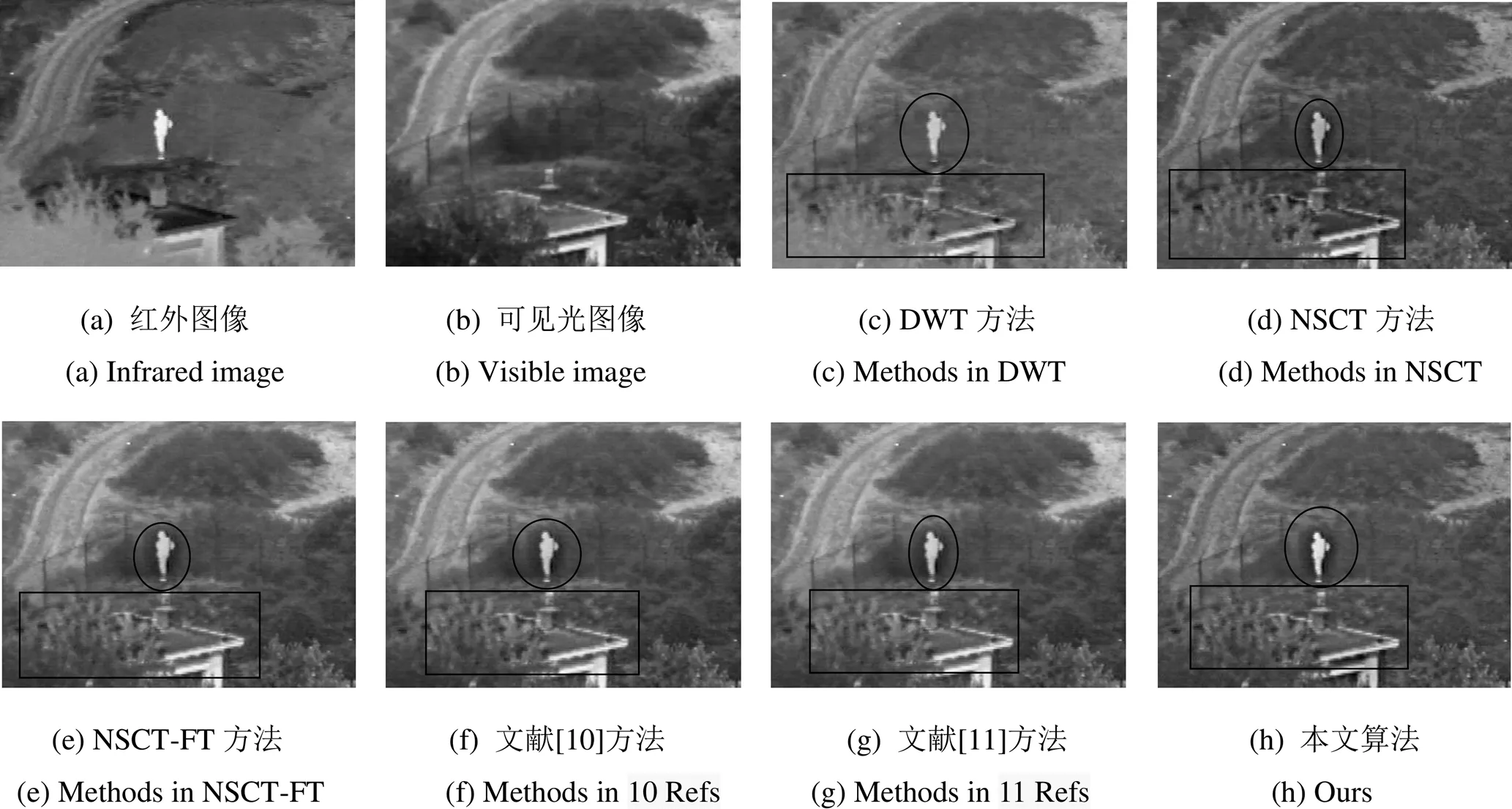

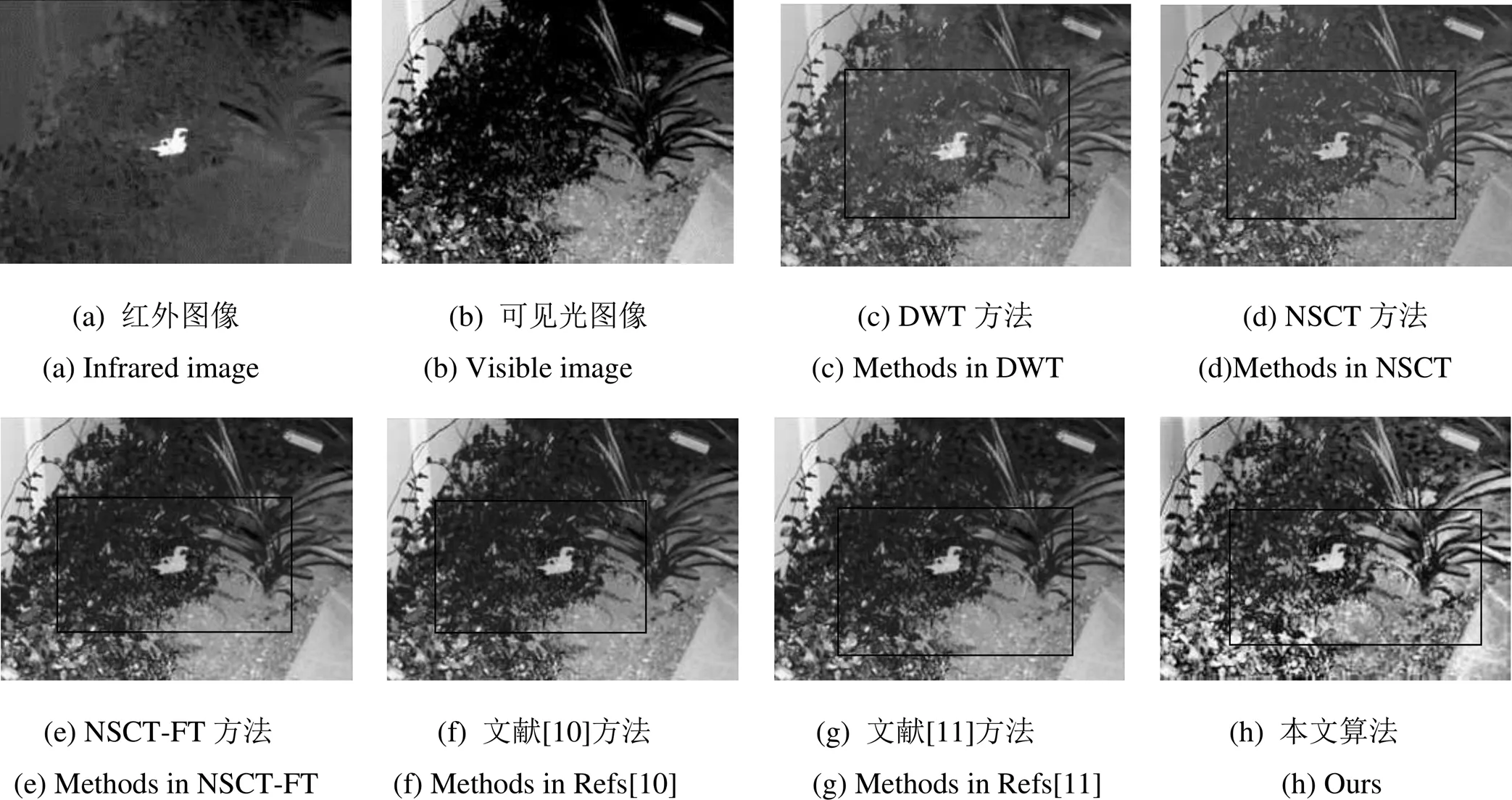

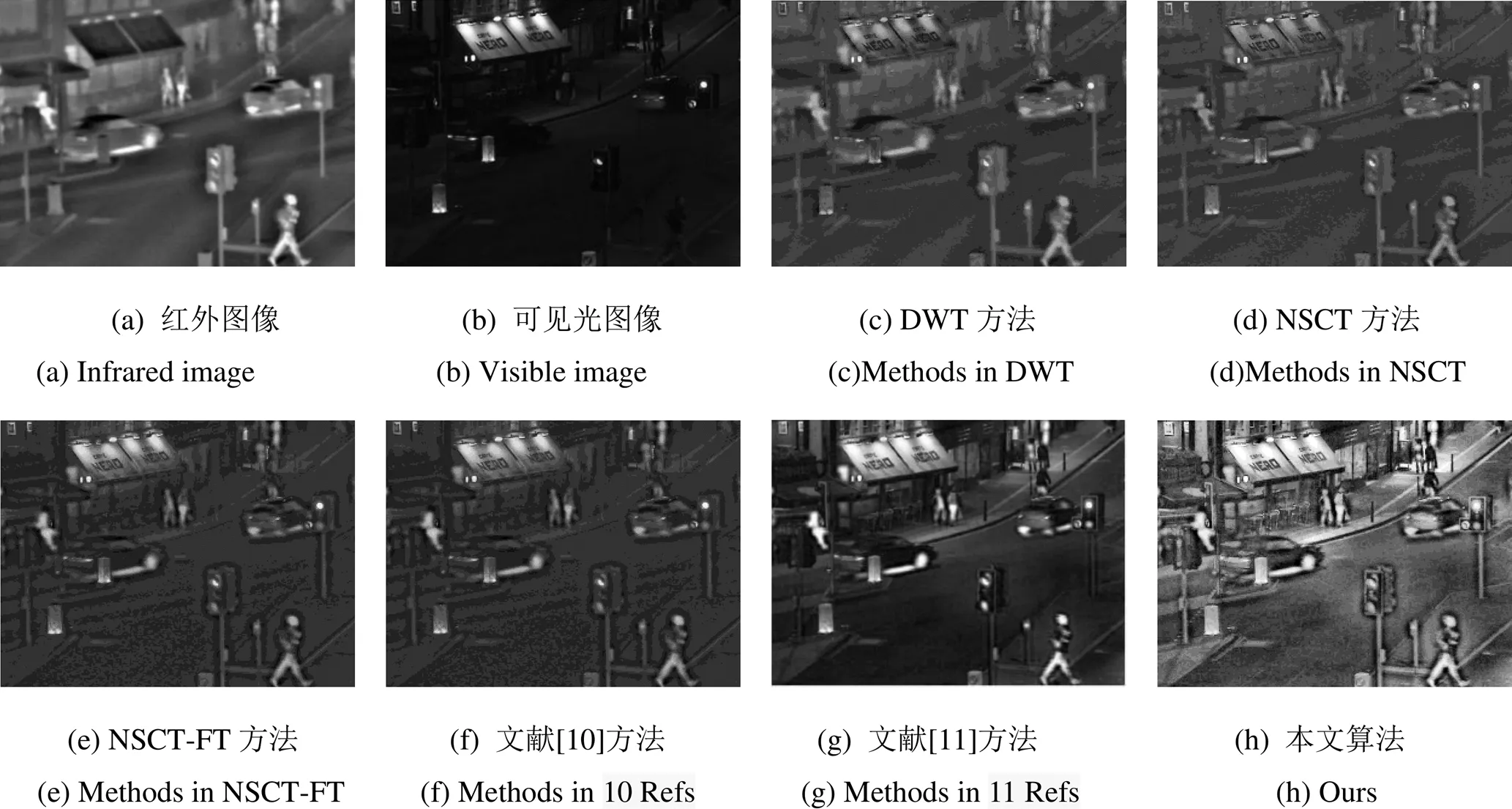

为了验证本文所提算法的有效性,选用5组不同背景的红外和可见光图像进行对比实验,这5组图像均来自荷兰TNO Human Factors Research Institute拍摄的公开数据集,且都经过严格配准。第一组图像是UN camp,第二组图像是Duck,第三组是Quad,第四组图像是Road,第五组图像是Meting。

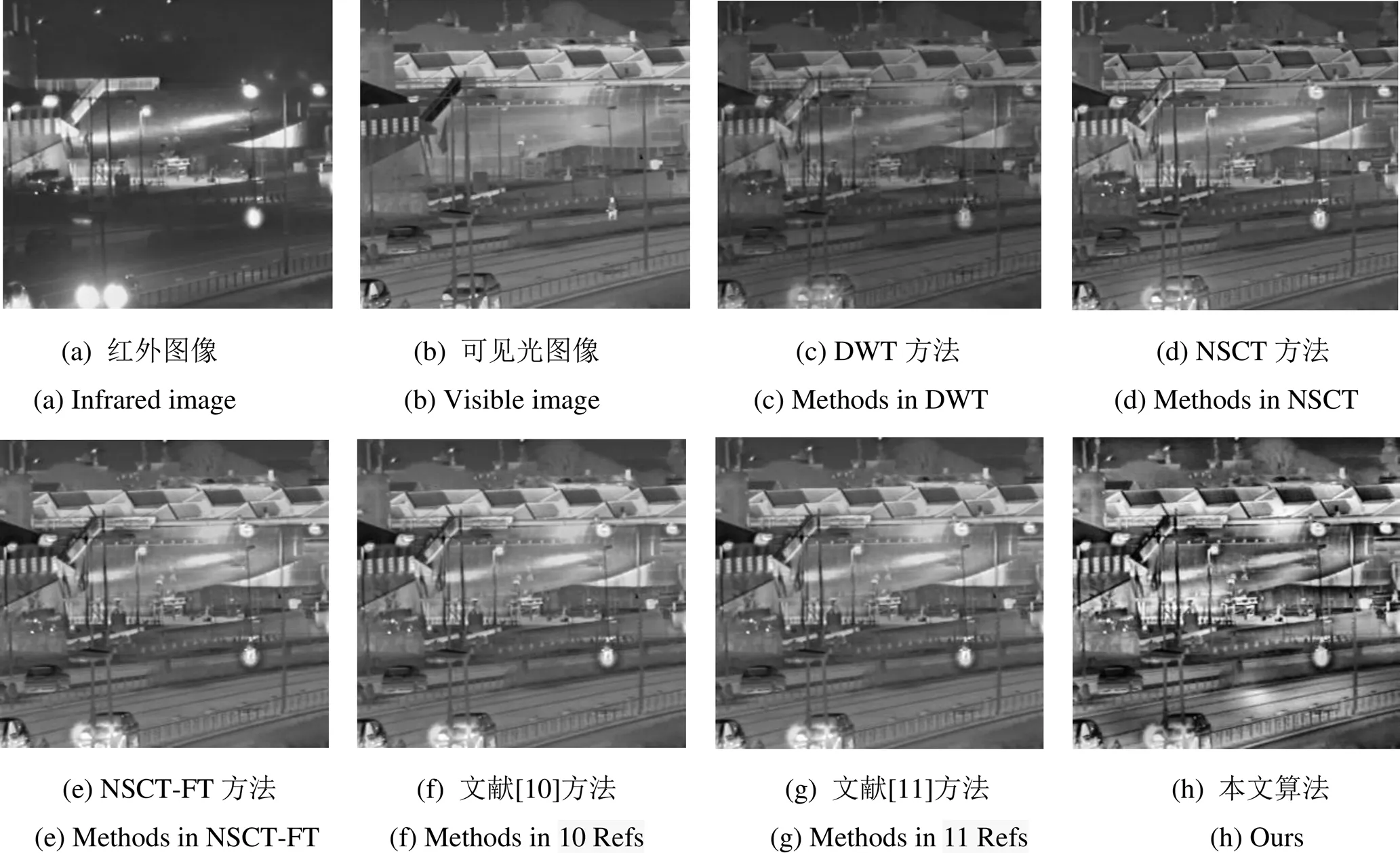

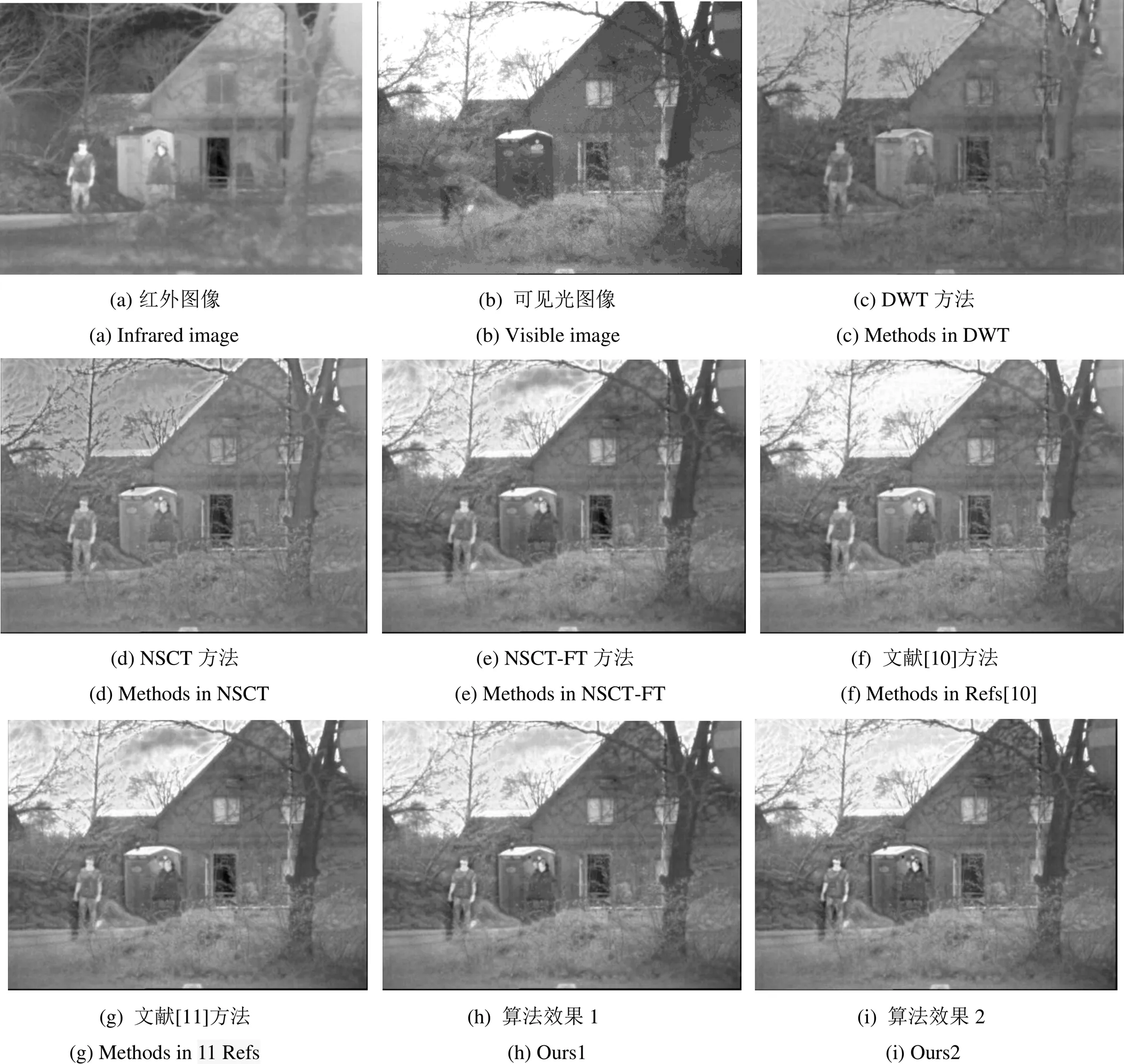

本文方法和DWT(discrete wavelet transform)、NSCT、NSCT-FT、文献[10]基于引导滤波、文献[11]基于L0范数图像平滑以上5种算法进行对比实验,如图6,图7,图8,图9,图10所示。为了在不同分辨率和像素下验证本文方法的处理效果,所选取的图像分辨率和像素大小不同,其中Duck像素大小为246×178,UN camp像素大小为360×270,Road像素大小为505×501,Quad像素大小为632×496,Meting像素大小为768×576。

本文所有实验均在MATLAB R2014a上仿真完成,计算机设备为笔记本Win8,处理器为Intel(R) Core(TM) i5-5200U CPU @2.20GHz,内存(RAM)4.00GB。DWT算法采用db4小波进行4层分解,融合方法采用简单的低频取平均值,高频取大的融合规则,NSCT,NSCT-FT,文献[10]以及文献[11]融合过程中的高低频系数同样采用上述融合规则。BEMD分解过程中,精度SD设置为0.1,每层最大允许的迭代次数设置为3,若还是不满足精度则直接跳出,使用跳出时的值,分解层数设置为3,顺序统计滤波器的窗口大小设置为3×3。FT显著性算法中,高斯滤波器窗口大小根据文献[9]设置为5×5。文献[10]方法中,引导滤波器参数按照原文中设置,窗口半径=8,修正参数eps=100/(×),其中×为图像的大小。红外图像处理过程中,导向滤波器窗口半径设置为=2,eps=0.12,修正系数=0.4,用原始图像作为引导图像。本文方法中NSCT分解过程中滤波函数窗口设置3×3,阈值设置为4,设定分解层数为4,每层分解方向数为[2,3,3,4],NSCT选择“pyrexc”拉普拉斯滤波器,选择方向滤波器“vk”。

图5 基于多尺度变换的红外与可见光图像融合方案

针对不同分辨率的图像,本文图6~图10(h)设置的分解和融合参数相同,其中图6分辨率较低,图7~图10分辨率较高,将用于对比不同分辨率图像处理效果。图10像素值最大,通过改变部分参数,即调整BEMD分解过程中的精度SD,红外图像处理过程中导向滤波器窗口半径和修正系数,将精度SD设置为0.2,导向滤波器窗口半径设置为4,修正系数设置为0.6,得到融合图像如图10(i)所示,用来探究本文算法对像素值较大的图像处理效果。

图6 UN camp融合后图像

图7 Duck融合后图像

图8 Quad融合后图像

图9 Road融合后图像

图10 Meting融合后图像

3.1 主观质量评价

经过对比观察,以上6种融合算法都成功实现了信息融合。图6经过本文算法处理以后,“人”的亮度有所增加,轮廓信息在视觉上更加清晰明亮,房子的房顶、屋檐细节信息明显,灌木丛的融合细节层次丰富、野地富有层次感,整幅图形具有很好的视觉效果。图7经过和其它5种算法对比可以发现,“鸭子”及周围较大的植物经过显著性增强以后亮度增加,且图像细节纹理更加丰富,红外显著性目标得到很好凸显,图像更加清晰。图8是在夜晚拍摄,通过对比可以发现行人和车辆等主要显著性目标明显变的明亮,且目标物的轮廓和细节信息伪影较少,甚至可以透过车窗看见车里面的物体,店门口的椅子和店铺的门和窗户更加清晰。图9也是在夜间拍摄,主观感受到整幅图像清晰明亮,特别是路面和远处的棚顶显著性得到凸显,通过和其它几种算法在细节方面对比,可以发现车辆的轮廓和马路两边的纹理也得到充分保留,图9和图8共同验证了弱可见光条件下本文算法的有效性。图10(h)房屋的轮廓和哨所的顶部较亮,较好地保持了文献[10]和文献[11]的显著性效果,人的面部亮度有所增加,实现了对重要目标的显著性增强,左上角树枝的显著性保持的也较好,相比文献[11],树枝的残影得到有效减弱,树枝亮度得到保持。图10(i)相较图10(h)在视觉感受上整体差别不大,这说明本文算法在处理像素值较大的图像时,处理效果趋向稳定。

综上,对于分辨率较高的图7~图10,本文算法显著性增强的效果较为明显。对于图像分辨率较低的图6,在保持相同的分解和融合参数下,处理效果得到部分改善,但是整幅图像给人的视觉效果仍然欠佳,融合质量还有待进一步提高。本文算法在实现成功融合的基础上,相较传统的小波变化、NSCT,NSCT-FT有较大的进步,相较文献[10],文献[11]改进的算法在部分特征和整体视觉效果上有所进步。

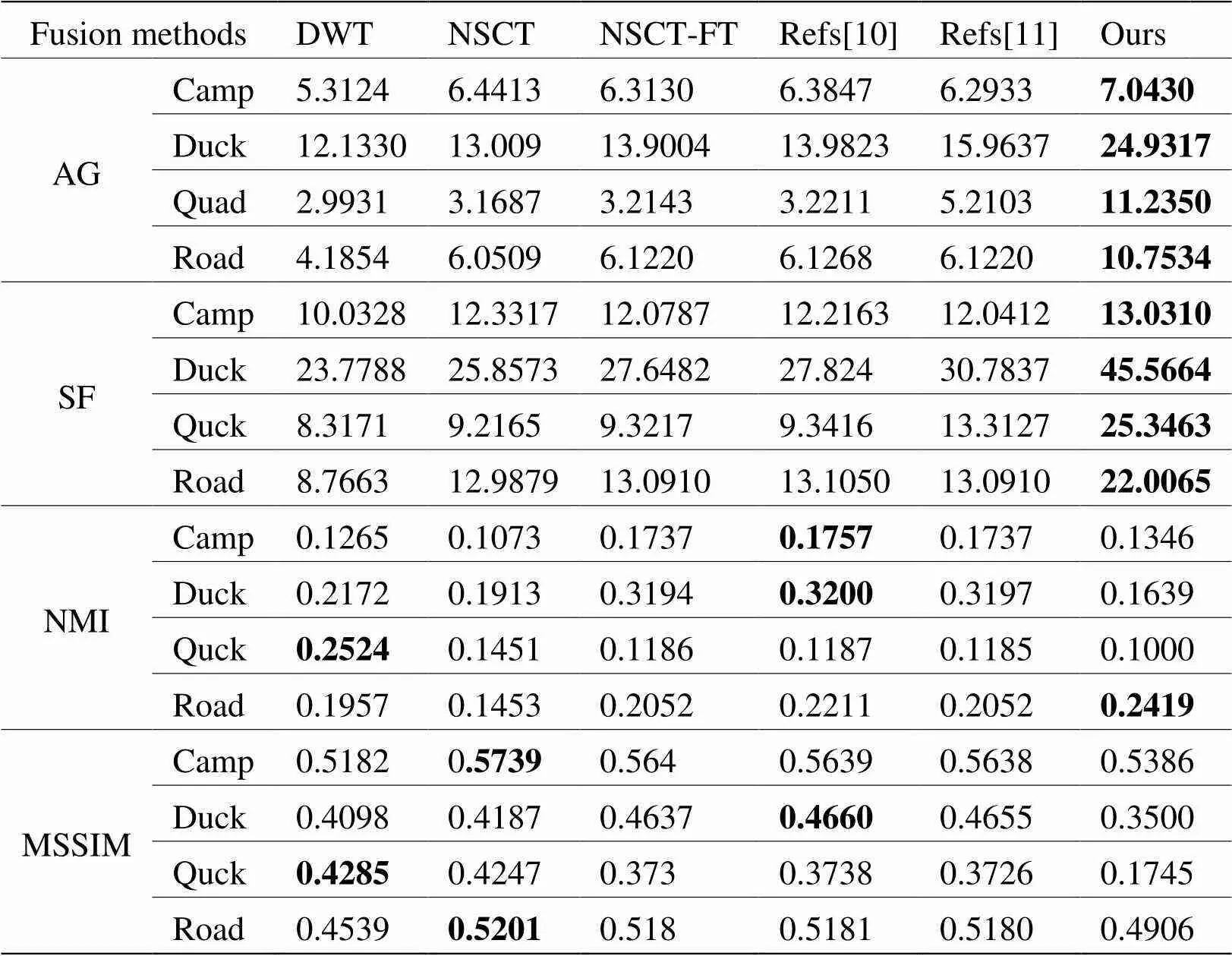

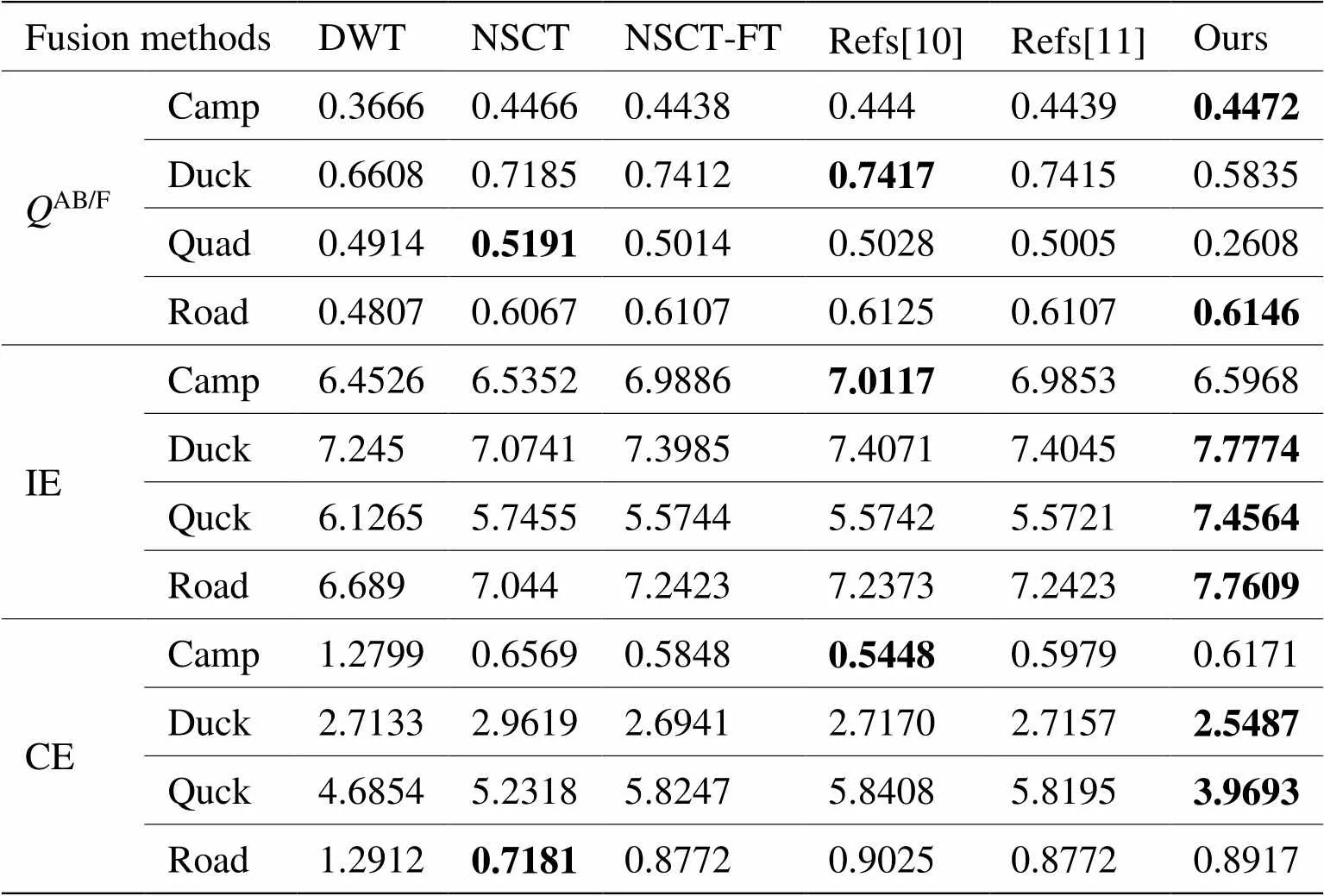

3.2 客观质量评价

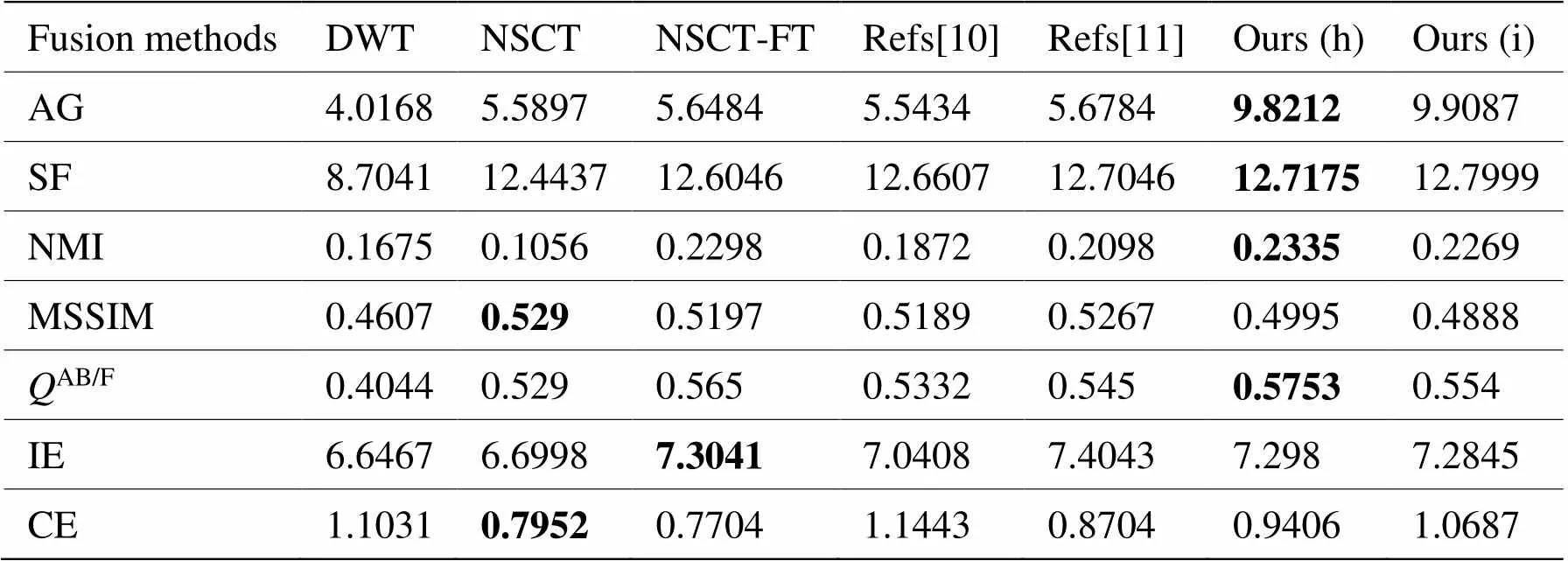

为了较全面评价本文算法在融合性能上处理效果,本文选用平均梯度[22](Average Gradient,AG)、交叉熵(cross entropy,CE)、空间频率[23](Spatial Frequency,SF)、归一化互信息[24](normalized mutual information,NMI)、平均结构相似度[25](Mean Structural SI Milarity,MSSIM),AB/F[26],信息熵[27](Information Entropy,IE),这7项评价指标来对融合过程进行客观评价。其中CE用来衡量图像间的差异,值越小则差异越小;MSSIM表明源图像和融合图像的相似度程度,值越高融合效果越好;AB/F说明融合图像保留源图像的边缘信息情况,值越大融合效果越好。IE用来衡量信息丰富程度,熵值越大信息量越丰富;NMI体现了融合图像对原始图像信息的保持程度,值越大则获取源图像的信息越多;AG反映了融合图像对微小细节反差和纹理变化的表达能力,值越大图像越清晰;SF可度量融合图像空间域的总体活跃度,值越大图像越清晰。

表1、表2、表3得到了7种客观评价指标的数值,最优值用黑体标出。通过数值对比,本文方法在平均梯度、空间频率、信息熵以及交叉熵这4个方面有所提高。5组图像的平均梯度值和空间频率值普遍都高,这和主观观察结果一致,本文方法处理过的图像在纹理细节和清晰度方面优于对比算法,其中第二组图像和第三组图像的平均梯度值变化幅度大于第一组图像的变化幅度,从主观视觉上看,图6中“人”的亮度有所提升,体现了本文所用显著性算法的有效性,同时因为背景信息景深过于复杂,所以平均梯度变化幅度较小。同样在空间频率方面本文算法得到的值也和主观视觉观察到的一致,从主观视觉上观察,也是更清晰更舒适。在衡量图像信息丰富程度信息熵时,本文方法并没有在3组图像上都表现最优,表现最优的两组图像变化幅度也不是很大,说明本文方法在表现红外和可见光图像融合后整体信息丰富程度方面有缺陷,这是因为在用二维经验模态分解指导显著图的过程中,因为插值和迭代的原因,必然会损失部分背景信息,但是本文也较好地突出了显著性目标,所以在信息丰富程度方面有待进一步提高,同样原因本文方法在MSSIM,归一化互信息方面表现的都不尽如意。在交叉熵的衡量上,却取得了很好的效果,图6交叉熵值接近对比的算法,图7和图8已经明显小于对比算法的值。对于图10(h),本文算法在平均梯度、空间频率、归一化互信息这几个方面仍然优于对比算法,从客观质量评价角度证明本文方法对分辨率较高的图像仍然由较好的处理效果。对图10调整部分参数后得到客观评价指标如表3中(i),通过和(h)比较可以发现各个评价指标的数值比较接近,没有出现某一个指标跳变的情况,这和主观评价指标一致,即两幅图像在主观视觉上相差不大。

表1 指标1~4客观评价结果

表2 指标5~7客观评价结果

表3 图10客观评价结果

4 结语

基于视觉显著性的红外和可见光图像融合,符合人类视觉系统(Human Visual System,HVS)的主观感受。本文依据经典的FT方法以及部分基于FT改进的算法突出显著性目标亮度、融合图像清晰度不足的问题,提出依靠二维经验模态分解来捕捉红外图像的强点和轮廓特征。最后对融合结果进行主观和客观评价,主观评价结果基本和客观评价指标一致,反应了本文改进显著性融合算法的有效性,但是本文的部分客观评价指标数值有待进一步提高,二位经验模态分解过程中存在插值和迭代过程,因此算法的时间复杂度较大,后续研究中将会在改进插值方式,提高分解效率方面开展工作。

[1] MA C, MIAO Z, ZHANG X P, et al. A saliency prior context model for real-time object tracking[J]., 2017, 19(11): 2415-2424.

[2] HU W, YANG Y, ZHANG W, et al. Moving Object Detection Using Tensor Based Low-Rank and Saliently Fused-Sparse Decomposition[J]., 2016, 7149(c): 1-1.

[3] Da Cunha A L, ZHOU Jianping, Do M N. The nonsubsampled contourlet transform: theory, design, and applications[J]., 2006, 15(10): 3089-3101.

[4] KONG W, ZHANG L, LEI Y. Novel fusion method for visible light and infrared images based on nsst-sf-pcnn[J].2014, 65: 103-112.

[5] BHUIYANS M A , ADHAMI R R , KHAN J F. Fast and Adaptive bidimensional empirical mode decomposition using order-statistics filter based envelope estimation[J]., 2008(1): 1-18.

[6] A Toet. Computational versus psychophysical bottom-up image saliency: A comparative evaluation study[J].2011, 33(11): 2131-2146.

[7] HAREL J, KOCH C, PERONA P. Graph-based visual saliency[C]//, 2006: 545-552.

[8] HOU X, ZHANG L. Saliency detection: A spectral residual approach[C]//, 2007: 1–8.

[9] ACHANTA R, HEMAMI S, ESTRADA F, et al.Frequency-tuned salient region detection[C]//2009, 2009: 1597-1604.

[10] 傅志中, 王雪, 李晓峰, 等. 基于视觉显著性和NSCT的红外与可见光图像融合[J]. 电子科技大学学报, 2017, 46(2): 357-363.

FU Zhizhong, WANG Xue, LI Xiaofeng, et al. Infrared and Visible Image Fusion Based on Visual Saliency and NSCT[J]., 2017, 46(2): 357-363.

[11] 林子慧, 魏宇星, 张建林, 等. 基于显著性图的红外与可见光图像融合[J]. 红外技术, 2019, 41(7): 640-646.

LIN Zihui, WEI Yuxin, ZHANG Jianlin, et al. Image Fusion of Infrared and Visible Images Based on Saliency Map[J]., 2019, 41(7): 640-646.

[12] 安影, 范训礼, 陈莉, 等. 结合FABEMD 和改进的显著性检测的图像融合[J]. 系统工程与电子技术, 2020, 42(2): 292-300.

AN Ying, FAN Xunli, CHEN Li, et al. Image fusion combining with FABEMD and improved saliency detection[J]., 2020, 42(2): 292-300.

[13] Nunes J C, Bouaoune Y, Delechelle E, et al. Image analysis by bidimensional empirical mode decomposition[J]., 2003, 21(12): 1019-1026.

[14] HUANG N E, SHEN Z, LONG S R, et al. The empirical mode de-composition and the Hilbert spectrum for nonlinear and non-stationary time series analysis[J]., 1998, 454(1971): 903-995.

[15] Bidimensional empirical model decomposition method for image processing in sensing system[J]., 2018, 68: 215 -224.

[16] 王笛, 沈涛, 孙宾宾, 等. 基于大气灰度因子的红外图像增强算法[J]. 激光与红外, 2019, 49(9): 1135-1140.

WANG Di, SHEN Tao, SUN Binbin, et al. Infrared image enhancement algorithm based on atmospheric gray factor[J]., 2019, 49(9): 1135-1140.

[17] MA J, ZHOU Z, WANG B, et al. Infrared and visible image fusion based on visual saliency map and weighted least square optimization[J]., 2017, 82: 8-17.

[18] ZHAI Y, SHAH M. Visual attention detection in video sequences using spatiotemporal cues[C]//14, 2006: 815-824.

[19] CHENG Mingming, Niloy J Mitra, HUANG Xiaolei,et al. Global Contrast based Salient Region Detection[J]., 2015, 37: 569-582.

[20] Achanta R, Estrada F, Wils P, et al. Salient region detection and segmentation[C]//, 2008: 66-75.

[21] 杨爱萍, 王海新, 王金斌, 等. 基于透射率融合与多重导向滤波的单幅图像去雾[J]. 光学学报, 2019, 38(12): 104-114.

YANG Aiping, WANG Haixin, WANG Jinbin, et al. Image Dehazing Based on Transmission Fusion and Multi-Guided Filtering[J]., 2019, 38(12): 104-114.

[22] CUI G, FENG H, XU Z, et al. Detail preserved usion of visible and infrared images using regional saliency extraction and multi-scale image decomposition[J]., 2015, 341: 199-209.

[23] Piella G, Heijmans H. A new quality metric for image fusion[C]//, 2003: 173-176.

[24] QU G, ZHANG D, YAN P. Information measure for performance of image fusion[J]., 2002, 38(7): 313-315.

[25] WANG Z, A C Bovik, H R Sheikh, et al. Image quality assessment: from error visibility to structural similarity[J]., 2004, 13(4): 600-612.

[26] Xydeas CS, Petrovic V. Objective image fusion performance measure[J]., 2000, 36(4): 308-309.

[27] J W Roberts, J Van Aardt, F Ahmed. Assessment of image fusion procedures using entropy, image quality, and multispectral classification[J]., 2008, 2(1): 023522.

Infrared and Visible Image Fusion Based on BEMD and Improved Visual Saliency

CUI Xiaorong,SHEN Tao,HUANG Jianlu,WANG Di

(Rocket Force University of Engineering, Xi’an 710025, China)

Aiming at the problems of low target contrast and insufficiently clear images in the process of visual saliency fusion, this paper proposes an improved frequency Tuned algorithm based on bi-dimensional empirical mode decomposition (BEMD). First, the strong points and contour information of the infrared image captured by BEMD is used to guide the generation of saliency maps of the infrared image. Then, the visible image and the enhanced infrared image are subjected to a non-subsampled contourlet transform(NSCT). The saliency map-guided fusion rule is used for the low-frequency part. The high-frequency part is used to set the area energy to be large and rely on the threshold value rules. Finally, the inverse NSCT transform is used to generate a fused image and subjective visual and objective index evaluations are performed to it. The results show that the method in this paper achieves a multi-level and adaptive analysis of the original image, and achieves good vision compared to the contrast methods.

images fusion, bidimensional empirical mode decomposition, saliency map, nonsubsampled contourlet transform

TP391.41

A

1001-8891(2020)11-1061-11

2020-01-23;

2020-10-28.

崔晓荣(1995-),男,硕士研究生,主要从事红外图像处理方面研究。E-mail: cur1601645438@163.com。