IT资源优化技术研究及其应用效果

张红杰 杨德兴 尹龙 林辉 赵玉梅 马迅飞

摘 要: 高性能计算已成为运行RTM逆时偏移、FWI全波形反演等复杂运算的有效手段。随着"两宽一高”等勘探技术的发展,野外采集的数据量越来越大,先进的勘探方法带来更为复杂的计算,单套PC集群的软硬件配置及较低的网络带宽,已不能满足PB级项目的技術要求。文章分析了当前IT资源面临的主要问题,提出PC集群、网络架构、I/O存储等优化技术新思路,在整体系统效率、I/O性能改善、交互速度提升等方面取得了好的效果。

关键词: PC集群; I/O; 网络; 交换机; MDS

中图分类号:TP338.6 文献标识码:A 文章编号:1006-8228(2020)11-32-03

Abstract: HPC has become an effective method to run complex operations such as RTM (Renverse Time Migration) and FWI (Full Waveform Inversion). With the development of exploration technologies such as "two wide and one height", more and more data are collected in the field. Advanced exploration methods bring more complex calculation. The hardware and software configuration of a single set of PC cluster and the low network bandwidth cannot meet the technical requirements of the PB level projects. This paper analyzes the main problems faced by current IT resources, and proposes new ideas of optimization technologies such as PC cluster, network architecture and I/O storage, which have achieved good results in overall system efficiency, I/O performance improvement and interaction speed improvement.

Key words: PC cluster; I/O; network; switche; MDS

0 引言

计算机技术的发展日新月异,无论是服务器的计算性能,存储的读写能力和容量,还是网络带宽和延迟,其技术指标都在急速增长,为石油勘探处理业务的快速发展提供了良好的计算环境。

近年来,随着地震勘探精度的不断提升和“两宽一高”等勘探技术的应用,野外采集的数据量呈指数级增长。以前处理的单步数据体仅有几十甚至上百TB,而目前的数据量已高达几百或PB级,且RTM逆时偏移、FWI等新方法在处理业务上的应用,使其计算量成倍增长。

另外,甲方对数据处理周期的要求也将越来越短,因此,落后、低配置的高性能计算机,将不再适应地震数据处理的需要,而大规模购置高端的计算机资源,也会带来巨大的投资成本。

1 IT资源问题分析

现代计算机是一种基于高速网络、具备一定计算能力、图形处理能力、I/O能力和存储能力负载均衡的复杂系统,无论是单节点计算机能力还是网络传输、I/O读写能力,任何一环出现问题,都将制约着整个系统的性能发挥。

一套PC集群随着应用时间的延长,在设备引进之初时整套系统较为先进,运算性能较高,但在后来的运行中,由于数据量的增大和计算量的增多等原因,计算速度将变得缓慢,系统性能也变得落后。

1.1 节点配置问题

⑴ 内置临时盘容量小、性能低

长期以来,人们习惯于用“峰值运算速度”,作为超级计算能力的评价标准。但PC集群的实际应用性能,与其峰值性能相比,往往相差甚远,特别是I/O能力严重制约了CPU的运算性能。

在处理业务中,一般将节点的内置硬盘做成临时盘,给作业的中间成果提供I/O读写,而临时盘的性能对运行的影响很大。

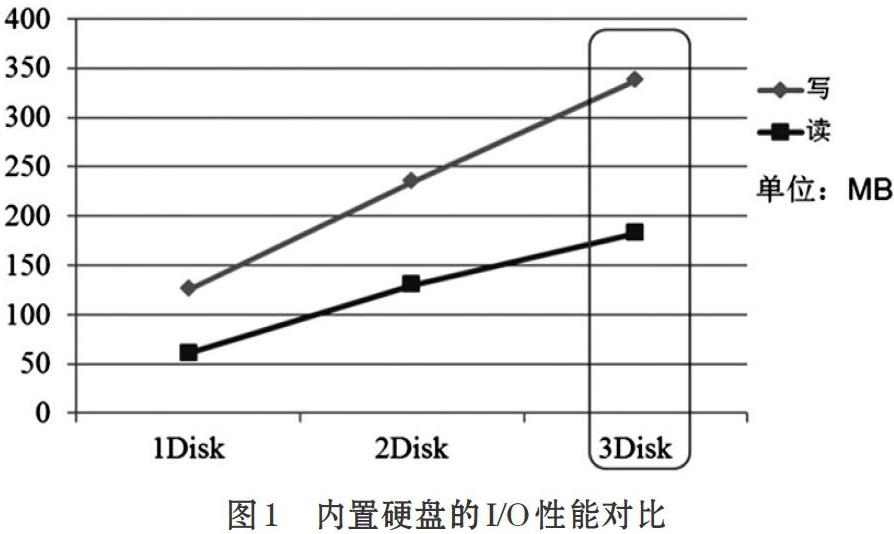

随着地震数据量增大,原有硬盘的空间小、性能低,硬盘的I/O能力仅为130MB/s,不能满足目前处理业务的要求(图1)。

⑵ 内存配置小

大多数旧的节点,其内存配置一般在64GB以下,在运行大的作业如深度偏移时,占用较大的交换区,从而使节点的运行效率下降。

1.2 网络瓶颈问题

⑴ 集群之间的网络瓶颈[1]

数据中心的计算资源,一般都是由多套相对独立的PC集群组成,各集群之间通过核心交换机连接。大部分集群与核心交换机的带宽为1-2*10GB/s,仅可以满足远程登录、交互和小数据量的远程访问。

随着应用需求的增长,跨系统远程访问存储增加,原有的小带宽网络,限制了跨系统远程访问存储的能力,使得远程读写文件系统的效率大大降低。

⑵ 终端房与核心交换机间的带宽瓶颈[1]

终端房与核心交换机的主干网络,最大也只有2万兆(2*10GB/s)带宽,却连接了近百台终端设备,而每台终端设备全部是千兆(1GB/s)网络,主干网络与多用户设备的网络需求不匹配。

1.3 文件读写问题

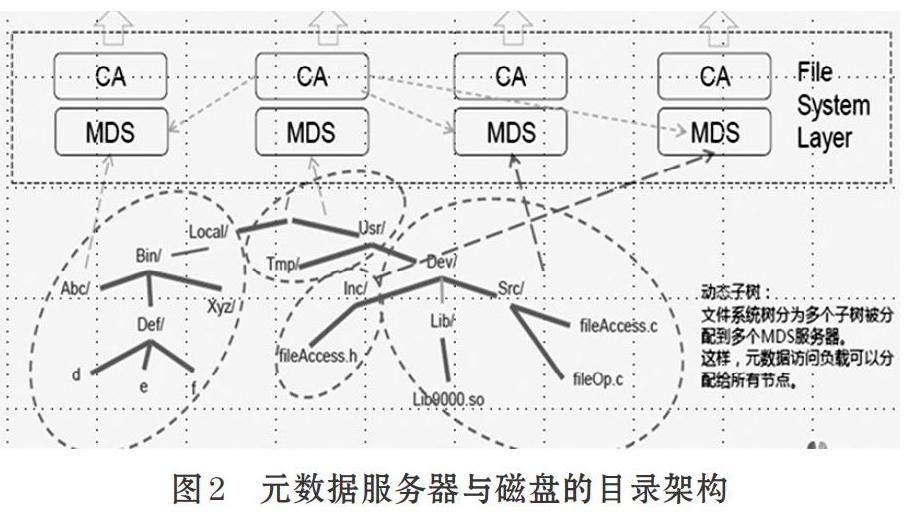

有些并行存储的同一个目录,是由一个MDS服务器控制和管理[2]。当同一个目录下有大量的数据读写时,会导致某一MDS元数据服务器的负载较重,而使读写变慢。

地震处理项目的同一工区数据,往往都集中存放在某个盘的同一个目录下,同一目录下的文件可能达到上万个或更多,当大量的作业进行磁盘I/O读写操作时,由于MDS服务器的影响,而使数据的读写速度变得非常慢(图2)。

2 资源优化技术研究

根据业务应用需求,适时对IT资源优化重组,提高设备性能并延长其寿命,这是当前计算机资源优化配置、系统集成与升级改造技术的研究重点与关键。

2.1 节点优化技术

⑴ 将几套128节点分散的小集群,升级为一套512节点的较大规模集群,并进行PB级数据处理系统的测试和优化,形成PB级数据处理能力。

⑵ 将单节点的2块硬盘,升级扩容到4-5块硬盘,将多块硬盘进行捆绑,提升读写空间大小。同时,将Ext3格式的文件系统改成Ext4格式,将Raid5改成Raid0[3],打开Raid卡Cache缓存,优化读写条带大小,提升内置硬盘的读写性能。

⑶ 针对高密度处理要求的大内存配置,将64GB的内存扩容到128GB,减少内存访问延迟,扩展访问带宽,降低对Swap交换区的占用,提升数据传输能力。

2.2 网络优化技术[4]

⑴ 将单节点的千兆网络改为万兆,同时部署万兆集群交换机,提升每个集群节点的网络传输能力。

⑵ 核心交换机的带宽由2*10GB/s改为2*40GB/s,提升跨集群数据传输和远程访问能力;同时,终端房的交换机与核心交换机的级联带宽也升级为2*40GB/s,充分发挥桌面到万兆网络的带宽能力,提升终端交互和远程登录的速度。

⑶ 对办公网进行改造,将原有的100MB/s、1000MB/s网络改成10GB/s,实现万兆到桌面的远程交互能力,解决了所有交互处理时的慢、卡、顿现象。

3 IT资源优化效果

3.1 PC集群优化效果

⑴ 本地盘优化集成

将4块内置机械硬盘或2块SSD固态硬盘,捆绑成Raid0并配置为临时磁盘,并将Raid卡的Cache打开,文件系统做成新的Ext4格式[5],条带大小做成512Kb,用于中间成果数据的读写,极大提高了磁盘的读写性能,从而降低作业运行时间。

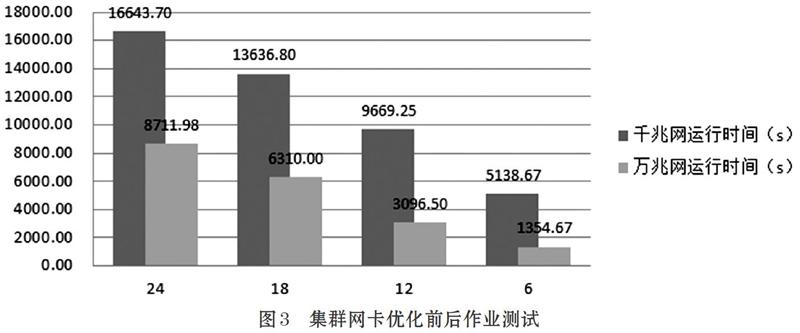

⑵ 内存与网络优化

将内存由64GB升级扩容到128GB,同时使用万兆网卡替换现有的千兆网卡,部署万兆集群交换机,提升集群节点综合运算能力(图3)。

3.2 网络优化效果

通过增大集群到核心交换机之间的网络带宽,将多套独立的小集群整合为一套大的PC集群,实现了资源的集中统一,提升了集群间的数据传输能力,实现了PB级超大数据的并行处理能力,从而提高了作业运行速度,缩短了运行周期。

增大终端机房至主机房的上行网络带宽,提升了终端机房到主机房的访问速度,尤其提升了用户远程交互能力。在终端房同时使用10台工作站向主机房传输数据时,其平均速度从148MB/s上升到470MB/s,终端机房到主机房的网络聚合带宽有了明显提升。

3.3 文件系统优化效果

通过在文件系統下创建多个目录,并将这些目录设置为同一个项目的附盘,把地震数据和速度文件分散到不同的目录下,使元数据的访问分散到不同的MDS服务器上,降低单个MDS的负载,从而提高了数据的读写速度(图4)。

4 结束语

通过自主技术创新、应用技术研究和开发技术创新,在很大程度上解决了PC集群存在的I/O瓶颈、网络带宽低、CPU计算资源与外设不匹配等诸多技术难题,提高了设备效率,同时降低了投资成本;其成果已经在生产中得到广泛应用和推广,很好的解决了生产实际问题,取得了明显的经济效益。

对于拥有上万颗CPU、数亿元计算机软硬件资产的高性能计算中心而言,针对现有的计算机资源,进行合理配置、优化集成、升级改造其软硬件系统,以达到提高性能和效率的目的,其可挖掘的技术潜力巨大,非常值得持续开展一些新课题的研究。

参考文献(References):

[1] 高俊峰.高性能Linux服务器构建实战[M].机械工业出版社,2014.

[2] 宋振龙.面向超级计算的大规模并行存储系统关键技术研究[D].国防科学技术大学,2014.

[3] 吴晨涛.信息存储与IT管理[M].人民邮电出版社,2015.

[4] 俞朝晖等.计算机网络技术使用宝典[M].中国铁道出版社,2014.

[5] 余柏山等.系统管理与网络管理[M].清华大学出版社,2016.