密集残差网络红外图像超分辨率重构

贾 宇,温 习,王晨晟

(1.华中光电技术研究所-武汉光电国家研究中心,湖北 武汉 430223;2.中国人民解放军32381部队,北京 100072)

1 引 言

对于成像系统而言,更高的分辨率代表着更丰富的细节信息。一般而言,在未达到衍射极限的情况下,可以通过光学系统的设计和增大靶面像素数来提高图像的分辨率。但在实际应用中,由于体积与成本的限制,不可能无限制地采用复杂、昂贵的光学系统与探测器。这就需要在硬件条件一定的情况下,通过算法来进行图像的超分辨率增强。因此,图像超分辨率(SR)也一直是学术界关注的研究热点[1]。超分辨率旨在提高图像的像素分辨率,将一定分辨率的图像转换成具有更高(通常是倍增)分辨率的图像,以使其具有更好的视觉质量和更精细的细节信息[2-3]。

通过超分辨率提升获得的高分辨率图像,更多的是以提供给人眼观察为主。因此,作为显示输出端的优化手段,它对于如电脑显示器,高清监视器和手持设备(智能电话和平板电脑等)来说异常重要。在应用领域上,超分辨率可用于场景中的物体检测、监视视频中的人脸识别、医学成像、遥感成像和天文图像等。医学图像SR技术的应用可以给医生呈现更清晰的细节,帮助医生做出更准确的医学诊断[4-7];SR技术应用在航空遥感[8-9]探测中可以获得更复杂的地表纹理信息细节;在刑侦上应用的SR技术可以帮助警方提供更准确的犯罪嫌疑人外形与面貌信息,为侦查过程提供更有效的线索[10]。

很多超分辨率算法都要借助与额外的机构或成像器件,如基于亚像元微位移的多幅低分辨率图像重构方法[11]、基于微扫描获取的多幅低分辨图像重构方法[12]与基于压缩感知方法构建测量矩阵的超分辨率重构方法[13]。这三种SR方法都需要微扫描系统、多个CCD或压缩采样等硬件设备和复杂的后续处理技术来提高图像分辨率,占据成像系统空间。

因此,很多采用了纯计算的方式来实现超分辨率图像增强。这种方法可大致分为两大类:传统方法和深度学习方法。经典算法已经存在了数十年,但与基于深度学习的算法相比却表现不佳。因此,最新算法依赖于数据驱动的深度学习模型来重构所需的细节,以实现准确的超分辨率。

基于深度学习的超分辨率重构方法是一种新兴的方法。与传统方法相比,具有清晰度好、精度高等优点。然而,一些基于深度学习的SR算法以均方差最小化为优化目标[14-17]。该方法虽然能提高重构图像的客观评价指标,但不能有效地重构图像的细节纹理。Ledig等人提出(使用对抗式生成网络的超分辨率,SRGAN)将对抗式生成网络应用于SR领域[18]。重构后的图像纹理相对清晰,但与真实图像相比有些图像细节不真实。

为了重构更真实的高分辨率红外图像细节信息,从提高低分辨率红外图像中缺失的高频细节信息的角度出发,本文提出了一种密集残差网络和对抗式生成网络相结合的SR算法。在该算法中,密集残差网络有效利用了低分辨率红外图像的全部特征,生成高清晰度的高分辨率红外图像。最后,利用判别网络对生成的网络输出图像是否为高分辨率红外图像进行识别。该方法利用密集残差网络和对抗式生成网络在红外图像SR领域的优势,使重构图像具有更好的纹理信息和更清晰的视觉效果。

2 模型设计

本文提出的红外图像SR算法结合了密集残差网络和对抗式生成网络。对抗式生成网络的优点是可以重构具有更真实纹理细节的红外高分辨率图像。在网络中,利用密集残差网络有效利用了低分辨率红外图像的全部特征,提高网络在训练过程中对红外图像局部细节的理解。最后,该方法可以重构出具有较好细节和清晰度的高频高分辨率红外图像。本节将详细介绍这种红外图像SR方法的具体操作。

2.1 对抗式生成网络

对抗式生成网络由生成式网络和判别式网络组成。对抗式生成网络的训练过程是判别式网络训练N次,穿插生成式网络训练1次的交替优化过程。其优化损失函数可定义为:

(1)

其中,V(D,G)表示对抗式生成网络的损失优化函数;G代表生成式网络;D代表判别式网络;Pdata(x)表示真实图像所服从的分布;Pz(z)表示噪声所服从的分布;E表示数学期望。这样,生成网络可以不断优化,得到与原始图像非常相似的输出结果。因此,基于对抗式生成网络的SR方法可以重构出具有良好视觉效果的高分辨率图像,图1为对抗式生成网络流程图。

图1 对抗式生成网络流程图

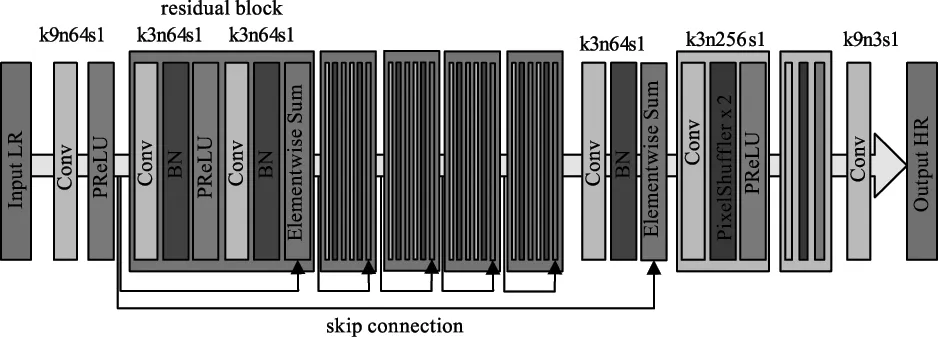

1)生成网络

根据对抗式生成网络的定义,通过求解式(1)中的最优化问题,得到Pdata(x)的超参数θg:

(2)

其中,该公式包括四个功能模块:边缘信息提取、残差密集学习、边缘增强融合和图像上采样模块。生成网络框架如图2所示。边缘提取模块通过拉普拉斯锐化滤波器获得初步边缘红外图像,并通过3×3卷积层将边缘的先验信息转化为高分辨特征;残差密集块(RDB)形成连续存储机制,RDB中的局部特征融合可自适应学习通过计算图像特征空间中的间隙,使图像特征之间的欧氏距离最小,从而使以前更有效的特征能够稳定网络训练过程和感知损失,从而使生成的图像在语义上与高分辨率红外图像特征差别较小,生成的图像能够拟合高分辨率红外图像特征的潜在分布。定义Ωi(·)表示RDB的第i层卷积之后的输出特征映射的激活值。感知损失函数的表达式为:

lfeature=

(3)

图2 生成网络框架

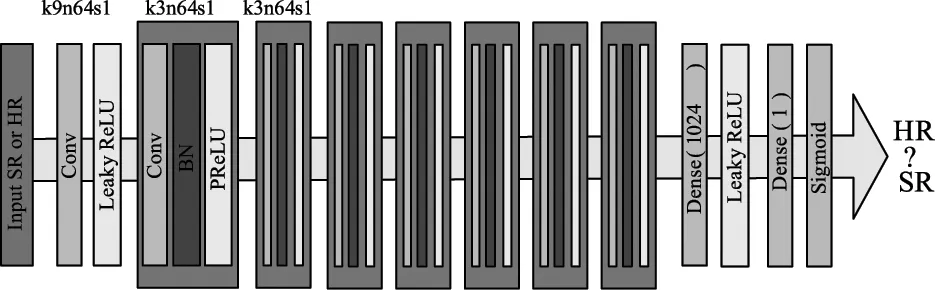

2)判别网络

利用判别网络对实际样本数据和生成网络生成的虚假图像进行概率估计,通过优化公式(1)中的最小最大化问题得到Ωi。判别网络框架如图3所示。判别网络主要用于二值分类,以区分生成图像的真实性。D的网络结构如图1所示。利用步长为1的卷积层提取红外图像的浅层特征,利用步长为2的卷积层减小红外图像尺寸。然后利用4个密集连接块(DDB)对图像特征进行密集连接学习,利用具有PReLU和Sigmoid激活函数的密集层对图像特征的真、假属性进行判别。

(4)

ladv_D(X,Y)=EY~Pdata(Y)[logD(Y)]+EEX~Pdata(x)

[log(1-D(G(X)))]

(5)

图3 判别网络框架

由于重构图像放大后的纹理太不自然,为了解决这一问题,在对抗式生成网络中加入了图像变换系数处理过程,使网络能够训练出红外图像的超系数α,从而提高了图像的高分辨率和频率细节信息使图像的纹理更逼真。因此,在本文中,我们的损失函数将系数的损失加到SRGAN感知损失函数中。损失函数可以表示为:

loss=ladv_D(X,Y)+αladv_G(X,Y)

(6)

3 实验和分析

3.1 实验设备和数据集

本文提出的基于GAN的红外图像SR模型已经在Ubuntu 16.04上的PyTorch 0.4.1中实现,其中CUDA 8、CUDNN 5.1和NVIDIA 1080Ti都是基于GAN的。所有实验都是在高分辨率红外图像数据集上进行的。数据集一包含2000个训练图像和200个测试图像,数据集二包含400个图像。混合后的图像被随机分为两部分:A部分和B部分。A部分包括2000个图像,B部分包括其他400个图像。

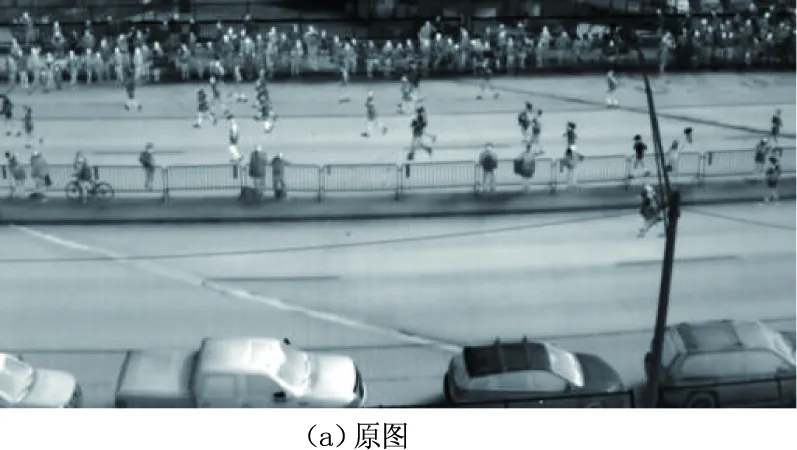

训练数据集由2400幅高分辨率红外图像组成,其中2000幅来自数据集一中的训练图像,其余来自数据集二中的训练图像。测试数据集由200个独立于训练图像的低分辨率红外图像组成。所有图像首先调整为1024×1024像素,作为参考高分辨率(HR)图像。图4为超分辨率重构示例图。

3.2 评价指标

在超分辨率重构领域,评价重构图像质量最常用的指标是峰值信噪比(PSNR)和结构相似性指数(SSIM)。然而,许多研究表明,均方误差和峰值信噪比不能准确反映图像的视觉质量,因此我们还引用特征相似性(FSIM)、通用图像质量(UIQ)来评价重构图像的质量。根据人类视觉系统(HVS),FSIM主要通过图像的低级特征来理解图像。相位一致性(PC)可以提取高维度的图像特征,但无法对图像对比度的变动做出响应,因此引入梯度特征获取图像对比度信息。相位一致性是FSIM的主要特征,梯度是FSIM的次要特征。FSIM值越大,图像之间的特征相似度越高,重构图像的质量越好。FSIM表示如下:

(7)

其中,Φ表示图像的整个像素域;SPC(x)和SG(x)分别表示为图像的相位一致性和梯度大小。SL(x)和PCm(x)表示为:

SL(x)=[SPC(x)α]·[SG(x)β]

(8)

PCm(x)=max(PC1(x),PC2(x))

(9)

UIQ是一种综合了线性相关损失、亮度失真和对比度失真三个因素的图像质量评价指标。UIQ值越大,重构图像与原始图像在线性、亮度和对比度方面的相关性越高,重构图像的质量越好。UIQ定义如下:

(10)

其中,式(10)中的第一项表示x与y之间的线性相关系数。当值为1时,表示x和y是线性相关的。第二项表示图像亮度的相关性,第三项表示图像对比度的相关性。

3.3 实验结果与分析

为了显示本文方法的性能,我们将本文方法与SRGAN方法进行了定量比较。使用两个红外高分辨率图像测试数据集进行实验,得到的重构图像的PSNR和SSIM结果分别为2、3和4,如表1所示。从表1的结果可以看出,本文提出的改进方法的图像质量评价标准PSNR和SSIM比以往大多数方法有了显著的改进。为了更准确地评价重构图像的质量,我们利用FSIM和UIQ对实验结果进行了进一步的分析。从表2可以看出,我们提出的方法在FSIM和UIQ两个评价指标上都取得了良好的效果。

表1 测试数据集PSNR/SSIM对比表

表2 测试数据集FSIM/UIQ对比表

4 结 论

通过对基于深度学习的SR算法研究,我们发现对抗式生成网络模型可以重构纹理更清晰的红外高分辨率图像。由于密集残差网络具有将图像中的高频细节和低频细节分解并分别表示的特点,为进一步提高重构图像质量,提出将密集残差网络融合到对抗式生成网络结构中。通过一系列实验验证,本文提出的超分辨率重构算法能够有效地改善SRGAN算法重构图像质量评价标准中测量值较低的缺点,PSNR、SSIM、FSIM和UIQ都有所提高。同时,该算法生成具有真实纹理细节的重构图像。该方法充分体现了该方法在红外图像SR领域的优势。