基于序列标注反馈模型的方面信息提取方法

范守祥,姚俊萍+,李晓军,马可欣

(1.火箭军工程大学 301教研室,陕西 西安 710025;2.61486部队,上海 200072)

0 引 言

方面信息提取的目标是从给定原始文本序列中提取表征实体、实体属性或反映实体某一侧面的信息。方面信息是情感信息的直接受体,通常为一个词语或短语。比如在笔记本电脑评论“They don’t just look good; they deliver excellent performance.”中,“look”和“performance”分别表征了笔记本电脑两个不同侧面且被赋予正向的情感极性,故应作为方面信息提取出来。目前已出现许多不同类型的提取方法,如基于主题模型的方法[1-3]以及基于条件随机场的方法[4,5]等。随着深度学习在各个领域的广泛运用与发展,基于深度学习的方面信息提取方法[6-9]正受到越来越多的关注,并且取得不错的成果。

在使用深度学习方法进行方面信息提取时,常作为序列标注任务,重点是使模型能够自动提取有用特征,比如Yin等[10]通过在词向量空间中构建词与词之间的句法依赖路径向量,将句法依赖信息融入到词的最终特征表示中,Ma等[11]用序列到序列的生成模型将目标词的语义特征、上下文特征、文本整体语义特征以及前词标签特征等融入到目标词最终特征表示中。除上述特征外,目标词以及前词的词性信息对于判断目标词是否为方面信息具有重要价值。比如在上例中,如果知道“performance”为名词,“excellent”为形容词,获取修饰关系,将能够更加高效判断“performance”为方面信息。目前,方面信息提取任务中存在两个突出问题:一是如何将包括词性信息在内的各类信息更有效融入到最终特征表示中,比如当前多数研究是将词性信息嵌入到词向量中,构造包含词性特征的向量空间,但利用效果不明显。二是如何解决错误传递问题。当前大多词性或句法解析系统准确率不高,且评论语言具有随意性,存在省略表达、语法错误、拼写错误等多种问题,会进一步降低词性解析准确率,融入此类特征有可能造成特征混乱,甚至产生负面效果。

本文提出一种基于编码器-解码器架构的序列标注反馈模型,针对上述第一个问题,在Ma等[11]提出方法基础上,模拟人对事物做出判断时融入各类信息且不断择优选择的过程,将目标词标签分类特征分成语义特征、词性特征、依赖特征3类构成,并利用双路编解码、门控机制等策略,对各类信息进行多次融合,生成依赖词性特征以及不依赖词性特征的两类特征表示,并利用该特征分别进行目标词类别判断,最后在两类判断结果的基础上再次进行结果选择,得出最佳判断结果。针对第二个问题,提出一种数据增强与反馈方法,在训练模型时,利用类似遗传算法的思想,通过对判断错误的样本进行随机删词、随机交换词语位置以及随机交换当前错误样本与其余训练样本中词语3种方式,生成新训练样本,融入到下一轮训练过程中,增加拼写错误、语法错误、随机错误以及简化语言表达等语言表达形式的样本数量,弥补训练样本不平衡问题,提高模型对各类语言形式的适应能力。实验结果表明,通过上述模型设计与训练方式的改进,训练效果得到较大提升。

1 相关工作

近年来,基于神经网络的深度学习方法在自然语言处理各领域任务中得到广泛应用,如机器翻译、问答系统、情感分析、文本摘要等等。亦有许多基于深度学习的方法被提出,用以解决方面信息提取任务。在这些方法中,常使用基于RNN(recurrent neural network)、CNN(convolutional neural network)、注意力机制(attention mechanism)、预训练词嵌入(pretrained word embedding)等模型和技术。基于深度学习方法可以自动捕获词、短语或句子的特征而不需要人为设计。比如Poria等[6]将CNN引入到方面提取任务中,Liu等[7]提出一种基于RNN的判别模型,将不同语料训练出的词嵌入作为不同类型RNN的输入,展示出利用神经网络方法提取方面信息的有效性。

目前使用基于深度学习的方法进行方面信息提取主要有以下3种思路。①利用预训练词嵌入本身被编码的语义信息。词的编码表示是使用神经网络处理自然语言问题的基础,早期使用独热编码(one-hot)表示词语的方式不仅造成严重的数据稀疏问题,且无法很好表达词语的含义以及词语之间的关系。通过大量文本资源训练得出的词嵌入能较好保留词语的语义特征,且语义相近的词语在词嵌入空间中位置较为接近,能有效保留词语间的关系。比如He等[8]提出一种无监督模型,使用独立的方面词嵌入重构句子表示,并将其与原始句子表示之间的差异作为最小化目标,学习得到方面信息词嵌入,依据方面信息词嵌入与原始词嵌入在同一词嵌入空间中的特点,通过距离找到合理的方面信息。②利用句子中词语间的句法依赖关系。句法依赖信息是句子中不同成分之间的依赖关系,方面信息往往是特定句法依赖结构中的特定成分。比如Yin等[10]提出在词嵌入空间中,通过学习依赖路径向量将两个词联系起来,构建包含词嵌入、目标词的线性上下文表示、依赖路径上下文表示等特征,并作为CRF(conditional random field)的输入提取方面信息。③利用观点信息和方面信息共现特征。方面信息是观点表达对象这一事实表明,方面信息和观点信息经常同时出现在一个完整表达中,缺少其中一项的另一项都不能称为方面信息或者观点信息,利用方面信息和观点信息的共现关系可以加强两者提取效果。比如,Wang等[9]提出一种多层注意力网络,每一层都使用一对注意力机制分别学习方面信息和观点信息的特征,且两者间相互学习注意力权值;Li等[12]使用两个带有记忆模块的LSTM(long short-term memory)网络分别处理方面信息和观点信息抽取,观点和方面之间的关系则通过两个网络的记忆模块间的信息交互建立。

2 基于编码器-解码器架构的序列标注反馈模型

图1 模型总体结构

本文提出一种基于编码器-解码器架构的序列标注反馈模型,由编码器、解码器以及数据增强与反馈组件三部分组成。在编码器中,利用双层双向GRU(gated recurrent unit)网络对词向量与词性向量分别进行编码,得到融合上下文的词与词性的向量特征表示;在解码器中,构建了双路解码组件以及门控信息融合单元,分别对目标词标签进行解码,而后融合两路解码结果并再次解码,得到最终最优标签解码结果;在数据增强与反馈组件中,按照预定样本生成规则,对模型判断错误的样本进行新样本生成,并反馈到下一轮训练样本中。这一部分,将分别对模型中的编码器、解码器中的双路解码组件、双路门控信息融合单元,以及数据增强与反馈组件进行详细描述,模型整体结构如图1所示。

2.1 问题描述与符号说明

方面信息提取是在给定含有方面信息及对应情感表达的文本序列

S={x1,x2,…,xn}

(1)

条件下,提取方面信息

A={xn-i,xn-i+1,…,xn-i+k}(k≤i)

(2)

的问题。为便于模型描述,文中使用w={w1,w2,…,wn} 表示文本序列对应词向量序列,使用p={p1,p2,…,pn} 表示文本序列对应的词性向量序列,使用y={y1,y2,…,yn} 表示文本序列对应的标签索引序列,采用 {B,I,O} 三级方面信息分类方案,其它符号说明见图1注释。

2.2 编码器

在编码器中,使用两个独立的双层双向GRU网络分别对词性量和词性向量进行编码。GRU网络是循环神经网络的一种,可以有效保留序列信息,并且可以解决梯度消失与爆炸问题。编码器依次读取文本序列中每一个词语对应词向量与词性向量,输出目标词的输出向量及隐状态向量

(3)

(4)

2.3 双路解码组件

在双路解码组件中,重点解决解码过程中的信息依赖问题,生成目标词的标签依赖特征。直觉上,在目标词分类特征形成过程中,目标词的语义特征、整体语义特征、前词标签特征、前词词性特征等都能够影响目标词的特征表示,在Ma等[11]设计的方法中使用了前3类特征,词性特征对于解码目标词特征表示具有重要作用,同时这种作用是动态的,在面对不同的语言表达时,词性信息所起的作用强弱不同。所以,基于对词性信息的这一认识,构建了两路解码组件,一路用以形成包含词性信息的依赖特征,另一路则相反,最终通过两路信息融合出能够体现词性信息不同作用的依赖特征表示。在使用编码器-解码器架构时,其突出优点是可以对文本进行预先编码,获得文本的整体语义信息,同时可以作为记忆模块在解码过程中随时调用记忆信息,这些信息可满足解码过程中所需各类信息。整个模块从编码器获取目标词条件下的整体语义信息、词性信息以及隐状态信息,同时输入前词标签信息,得到解码输出信息及隐状态信息

(5)

(6)

2.4 双路门控信息融合单元

双路门控信息融合单元重在解决生成目标词特征表示问题,该特征表示包含目标词语义信息、词性信息、依赖信息,3类信息通过合并门进行融合。同样生成两路分别包含与不包含词性信息的目标词表示特征。这两路表示特征分别进行目标词标签分类判断,得出依赖词性信息与不依赖词性信息的两个一级分类结果,再通过参数矩阵控制两类结果融合,最终产生目标词的二级分类结果,这样建模突出了词性特征对最终结果的影响是一种具有强弱控制的影响。计算过程如下

(7)

(8)

(9)

(10)

P(yt|y1∶t-1,w,p)=softmax(W9(W7rt+W8r′t)+b2)

(11)

其中,gt∈Rnd为信息合并门,由目标词语义特征、依赖特征、词性特征以及变化矩阵控制,经过门方向的归一化后得到;rt∈Rnd为一级分类结果,经由目标词各gt信息控制门控制信息流入量后计算得到;P(yt|y1∶t-1,w,p) 表示目标词最终标签类别概率分布,经两路一级分类结果与相应控制矩阵进一步控制信息融合比例后得到,W1-W9以及b0-b2均为可学习参数。

最终,通过最小化负对数似然损失对整个模型进行训练

(12)

式中:y′t表示标准标注类别索引值,θ表示模型中所有可学习参数。纵观整个模型,将决定一个词标签类别的信息分为语义信息、词性信息、依赖信息3类,在信息流动过程中,多次进行信息融合,旨在保证模型在判断目标词标签分类结果过程中,对各类信息具有控制与学习的能力。

2.5 数据增强与反馈组件

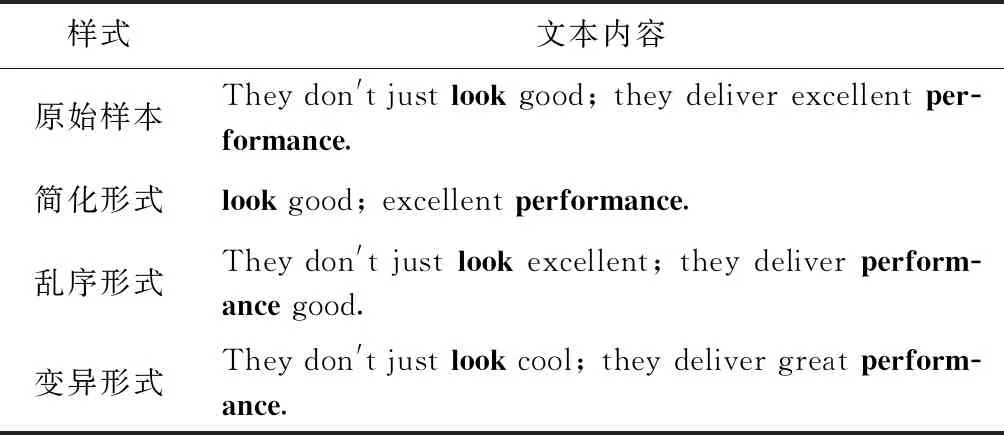

在利用词性信息进行方面信息提取时,词性解析错误将传递到最终的特征表示中,严重影响模型对词性信息的利用水平,甚至阻碍模型判断准确率的提升。为降低这种错误传递问题对模型的不良影响,提出数据增强与反馈组件。该组件工作于训练流程中,是提升模型对判断错误样本中语言模式理解认识能力、强化模型提取方面信息关键特征能力的重要组件。通过深入观察分析评论文本发现:评论文本在语言表述形式上具有极大灵活性,体现在经常出现简化表达、错误表达等现象。一方面,这些现象是造成词性解析错误的重要原因,另一方面,也应该看到,这类样本虽无法借助词性信息助力得到模型的正确判断,却能够得到人类的正确理解。比如对表1中原始样本经过简化、乱序、变异转换后,得到的样本出现表达不完整,存在语法错误等问题,但并不影响对其整体含义的认识以及方面信息的判断。对于评论表达的这个认识启示我们,对于模型判断错误的样本,可以通过人为构造简化、乱序、变异甚至错误的表达生成新的训练样本,增加与错误样本相关语言模式样本数量,加强模型对类似样本语言模式的认识能力,降低模型在处理此类样本时对词性信息的依赖程度。具体的,对训练集中模型判断错误的样本采用如下样本生成机制。

表1 样本形式变换示例

(1)删除词:随机删除样本中除方面信息以外的词语,通过参数α控制删除单词数量比例,模拟样本的简化或错误表达形式;

(2)交换词:随机交换样本中除方面信息以外的词语,通过参数β控制交换单词数量比例,模拟样本的乱序或错误表达形式;

(3)变异词:随机将样本中除方面信息以外词语与剩余训练样本中除方面信息以外词语进行交换,通过参数γ控制变异单词数量比例,模拟样本的同义或错误表达形式。

通过上述3种方式为每个判断错误训练样本生成3个新样本,反馈到下一轮训练样本中。由于采用随机样本生成方式经过变换产生的新样本很可能出现无法理解或与原始样本相矛盾的情况,为降低此类生成样本对模型的不良影响,每轮训练仅对排除新增样本的原始训练样本进行样本生成与反馈操作,使模型每轮次训练尽可能学习符合原始文本语言模式的特征,提高模型对判断错误样本相关表述的理解能力。

3 实验部分

3.1 实验数据与设置

本实验沿用目前在方面信息提取任务领域广泛使用的两个数据集,分别是SemEval-2014任务4[13]中的Laptop评论数据集和SemEval-2016任务5[14]中的Restaurant评论数据集,详情参见表2。所有评论数据均标记有根据字母位置索引定位的方面信息,使用NLTK(natural language toolkit)将文本分割为单词序列,使用斯坦福大学的自然语言处理工具包Stanford-CoreNLP对评论文本进行词性解析,获取单词词性信息,并从训练数据集中随机抽取150个训练样本作为验证数据集。

表2 样本数据信息统计

为提高模型通用性与实验可对比性,词向量采用Glove.840B.300 d预训练词向量初始化,词性向量以及标签类别向量均采用随机初始化,向量维度设定为300。编码器GRU网络隐层大小设定为300,解码器GRU网络隐层大小设定为600。使用Adam[15]优化算法更新模型参数,学习率设定为0.001。采用dropout策略防止参数过拟合,dropout率设定为0.5,batch大小设定为24。

3.2 对比方法

为充分评估模型的有效性,将与下列方法进行对比:

(1)RNCRF[16]:基于句法依赖树构建递归神经网络,学习词语表示特征,并作为条件随机场的输入特征,判断词语标签类别;

(2)MIN[12]:基于LSTM的多任务学习模型,设计有记忆模块,并通过记忆模块间的信息交互同时提取方面和情感信息;

(3)CMLA[9]:耦合多层注意力模型,通过多层注意力机制分别提取方面与情感信息特征,并通过交互学习提升彼此特征表示能力;

(4)Glove-CNN[17]:利用词向量本身蕴含的信息以及多层CNN构建简单模型,提取方面信息特征;

(5)HAST[18]:从LSTM构建的记忆中提取方面检测历史以及观点摘要信息,并以此强化当前方面信息检测能力;

(6)seq2seq4ATE[11]:基于序列到序列的生成模型,借助文本整体语义特征以及前词标签依赖特征等信息解码目标词标签特征。

3.3 实验结果与分析

本文提出方法与对比方法性能情况见表3。从表中可以看出,所有方法都存在Laptop评论数据测试结果好于 Restaurant 评论数据测试结果情况,这可能与多方面因素有关,比如Laptop评论数据中存在大量通用表述的方面信息,比如“Operating System”“Screen”等,这些方面信息较容易被模型习得,而Restaurant评论数据中除了一部分通用表述方面信息以外还存在大量低频方面信息,比如具体餐品名称“Lemon Chicken”、“Honey Walnut Prawns”,这些餐品名称在形式上以不规则短语为主,规律性较难被模型掌握;另外样本数据的不平衡性也可能是导致这种现象的原因之一。

表3 方法性能对比统计(F1/%)

在RNCRF方法中使用了句法解析以及词性信息,使得Laptop评论数据测试结果较好,但是在Restaurant评论数据表现出所列方法中最低性能水平,体现出模型对Restaurant评论数据识别能力较差,与本文提出方法相比,在两个数据集上分别存在3.82%和6.34%的差距,说明模型利用句法及词性信息不够充分,应对句法以及词性解析错误的能力较弱。

MIN、CMLA、HAST这3种方法均利用了方面信息与观点信息之间的依赖关系提升方面信息的提取效果,其中MIN、CMLA明确用到显式观点标记信息,HAST使用了隐含观点信息,3种方法均表现出不错的效果,但是某些情况下,观点信息可能会导致方面信息的误判,比如在“Most of them were either too big, too noisy and too slow after 2 years”中,评论者并未明确提出方面信息,只是说明了一种普遍的现象,但是其中出现了很多具有强烈负面观点的信息,使模型在利用这些信息时易产生错误判断,此时需要通过文本整体语义做出更准确判断。本文虽未借鉴上述方法利用观点信息,但是在构造依赖信息时融入了文本整体语义信息,同时利用了目标词语义信息、词性信息等,使整体性能比上述方法有较大提升。

Glove-CNN利用通用词向量本身的蕴含的语义信息以及CNN的特征抽取能力提取方面信息,优势在于模型简单计算高效;seq2seq4ATE与本文提出模型最为接近,均采用了编码器-解码器的模型架构,不同之处在于本文将词性信息多次融入到最终的特征表示中,且模拟人类进行文本语义理解的方式,融合各方信息综合判断目标词的标签类别,在两个数据集上分别比seq2seq4ATE提升1.6%和0.92%,取得所有对比方法中最佳性能。

3.4 消融实验

为进一步验证本文提出方法有效性,进行了相关消融实验,主要包括排除样本生成实验(OURS-w/o-SG)、单路解码实验(OURS-w/o-DD)、排除门控机制实验(OURS-w/o-WOG),具体实验结果见表4。

表4 消融实验结果

从表4中,可以明显看出,将本文所提出方法简化后,所得到的实验结果在两个实验数据集上均有所下降,表明本文提出方法的各模块均有效提高方面信息提取整体性能,具有重要作用;其次,可以看到,在排除样本生成以后,模型在两个数据集上的实验结果出现较大下降,分别达到了3.1%、3.34%,可认为将词性信息加入模型后,由于词性解析系统本身正确率不高以及评论语言表达随意性等问题造成的词性解析结果错误,使模型的性能受到很大影响,说明样本生成对模型整体表现具有重要作用;最后,在排除门控机制实验中,Restaurant评论数据测试结果下降1.99%,性能降低较为明显,而在相应的Laptop评论数据测试中仅下降0.66%,说明门控机制可以较为有效的应对复杂方面信息识别。

此外,对于本文提出的数据增强与反馈机制,进行了两组实验,分别为Glove-CNN、seq2seq4ATE两种方法添加了数据增强与反馈机制,结果显示数据增强与反馈机制在方面信息提取任务中表现出普遍有效性的倾向。具体实验结果见表5。

表5 样本生成对比实验结果

3.5 数据增强参数分析

通过上述各实验数据可以看出:①3种样本生成控制参数普遍控制在0.3-0.5之间时产生当前条件下最好实验结果,在随机生成条件下,样本生成参数过大会使生成样本严重偏离可能的真实语言现象,而过小会降低生成样本的演化水平;②不同方法、不同数据集下生成最好实验结果的样本生成参数略有不同,可能是由于不同模型对不同数据集样本提取的特征有所不同,且产生的错误样本不同造成的。

4 结束语

本文针对方面信息提取任务,提出一种基于编码器-解码器架构的序列标注反馈模型,并将文本分类特征划分为语义特征、词性特征、依赖特征3类特征组成。实验结果表明,本文采用的双路编解码、门控机制等策略对语义、词性、标签等信息的融合起到至关重要的作用,有效提高模型对各类信息的利用水平;所采用的数据增强与反馈机制,强化了模型对错误分类样本的认识能力,同时对模型提取信息特征起到有益促进作用。在未来工作中,我们将继续对特征的融合表示方式进行研究,并进一步对样本生成机制进行研究,转变随机生成为有限控制生成,探索样本随机生成下的规律性。