复杂场景下深度表示的无人机目标检测算法

李 斌,张彩霞,杨 阳,张文生

1.佛山科学技术学院,广东 佛山 528000

2.中国科学院 自动化研究所,北京 100080

1 引言

无人机容易成为恐怖袭击或者隐私泄露的武器。对无人机进行监管,迫切需要无人机检测系统。复杂城市背景下的无人机检测问题是“低小慢”目标检测任务中的难点问题,同时,由于城市背景复杂且存在大量的噪声和干扰,准确检测出无人机目标十分困难。

目标检测方法分为浅层学习和深度学习方法。浅层学习方法通常利用模板和图像稳定的特征点,获得模板与场景中对象的对应关系,检测出目标实例,再使用AdaBoost[1]算法结合HOG[2]特征等特征提取方法和支持向量机[3]等分类方法实现类别检测。Lowe提出的SIFT[4]算法,通过查找不易受扰动影响的特征来匹配目标;Bay提出的SURF[5]算法利用近似的赫森矩阵减少降采样过程,构建尺度金字塔,提高了速度。

相比浅层学习,深度网络提取特征的能力提升,Yann等提出的OverFeat[6]算法首次将分类、定位以及检测整合。此后,发展成两类:一类是结合候选框和卷积神经网络的基于分类目标检测方法,为二阶段算法;另一类是将目标检测转换为回归问题算法,为单阶段算法。二阶段算法从R-CNN[7]网络开始,其采用选择性搜索方法代替滑动窗口,大幅提高目标数据集上的性能。此后,Girshick和Ren等相继提出了Fast R-CNN[8]与Faster R-CNN[9]算法,Fast R-CNN设计了一种感兴趣区域池化结构,有效解决R-CNN图像尺寸相同的约束;Faster R-CNN采用区域推荐网络生成候选框,再对这些候选框分类和坐标回归,检测精度大幅提升,但是速度非常慢。单阶段算法由Redmon等提出的YOLO[10]算法开始,其通过卷积网络提取特征训练,直接预测每个网格内的边框坐标和类别置信度。Liu等提出SSD[11]算法,结合YOLO的回归思想和Faster R-CNN。Redmon等又相继提出了YOLOv2[12]和YOLOv3[13]算法,二代虽然也提高了检测性能,但是由于一个区域只负责预测一个物体,对被遮挡目标的识别表现不好;三代借鉴了特征金字塔网络[14],采用多尺度来对不同大小的目标进行检测,再次提高数据集上的性能。

对于无人机目标检测任务,在浅层学习方法上,王晓华等[15]提出仿生视觉注意机制的无人机目标检测,其提取了亮度、方向和区域对比度特征,利用AdaBoost分类器进行分析和融合,该方法存在手工特征提取复杂、无人机目标检测不全等问题,刘阳等[16]提出随机森林的无人机检测,提高了对小目标无人机检测的准确率,但是存在召回率较高等缺点。在深度学习方法上,翟进有等[17]提出深度残差网络的无人机多目标识别,将两层残差学习模块与三层残差学习模块结合使用,但是存在无人机位置不准确等问题。刘佳铭[18]提出深度卷积神经网络的无人机识别方法,将无人机目标检测分类分开实现,其存在识别准确率低、定位不准确等问题。

为了更加准确、快速地检测无人机,本文针对YOLOv3进行研究和改进,针对其目标位置不准确等问题,重点分析其位置损失函数,使用广义交并比[19]损失函数和焦点损失[20]分别替换原损失函数中的位置损失和置信度损失,又引入损失权重,提高性能。结果表明,在本文的数据集中,mAP75由原来的51.99%提升到72.03%,充分证明了改进方法的有效性。

2 YOLOv3网络模型

2.1 YOLOv3结构

YOLO系列网络将目标检测问题转化为回归问题,合并分类和定位任务到一个步骤,直接预测物体的位置及类别,检测速度可以满足实时分析的要求。YOLOv3的检测流程如图1。

图1 YOLOv3的检测流程

如图1,其特征提取网络为Darknet-53,为全卷积网络,使用了跳层连接,既加深网络强化收敛效果,又不会使训练困难。输出层通过上采样和特征融合,共设立三个尺度,分别为网络的倒数三个下采样层的上一层的残差块输出,从而实现多尺度预测,有效地增强了对不同大小物体及被遮挡物体的检测效果,同时采用随机多尺度训练的方式增强了鲁棒性,其中,激活函数采用线性整流函数。YOLOv3的网络组成如图2。

图2 YOLOv3的网络组成

由图2知,YOLOv3在残差块的输出上实现多尺度预测,当输入为416×416时,对应特征大小分别为:13×13、26×26和52×52。每一个尺度对应三个先验框,共计9个,最终取其中一个,其中,小的特征图上有大的感受野,对应大的先验框和大目标。每一个输出都包括目标的中心位置(x,y),宽高(w,h)置信度以及类别,则对一张输入图片的输出为1×10 647×(5+k),k代表类别数,本文中k=1。YOLOv3预测边界框中心点相对于对应区域左上角的相对偏移值,其实际位置和大小如公式(1)~(4):

其中,(cx,cy)为区域左上角坐标,(tx,ty)是网络关于中心坐标的预测值,(tw,th)为宽和高的预测值,(pw,ph)是先验框的宽和高,(bx,by,bw,bh)为实际位置。通过对置信度设定阈值,过滤掉低分的预测框,再对剩下的预测框使用非极大值抑制算法,得到最终预测结果。

2.2 YOLOv3的损失函数

损失函数对于目标检测任务尤为关键,分析作者源码得出YOLOv3网络的损失函数为公式(5):

其中,λobj为位置损失和置信度损失之间的权重系数,tw为真实框的宽,th为真实框的高,tr包含真实框的宽高和中心信息,pr为预测框的宽高和中心信息,tc为真实的类别,pcj为第j个候选目标的预测类别,tconf为真实的置信度,pconf为预测置信度,10 647表示当输入为416×416时,网络预测的候选目标个数。

从公式(5)得出,其主要分为三部分,坐标损失、置信度损失和分类损失。采用误差平方和计算坐标损失,采用二值交叉熵计算置信度损失和分类损失。

尽管损失函数最终采用了和的形式而不是平均,这是对正负样本差问题有一定的考虑,但是效果不理想,存在改进空间。同时,由于其位置损失不够正确地描述预测框和真实框之间差异,导致模型学习到的位置信息不够准确。基于此,本文针对无人机检测的要求和特点做了相应的改进。

3 损失函数改进

3.1 广义交并比损失

交并比(Intersection over Union,IoU)是在目标检测基准中使用的最流行的评估度量。然而,优化为了回归边界框参数使用的距离损失和最大化交并比是存在差距的,即采用距离损失来优化边界框的参数和预测框和真实框的交并比之间没有直接关系。最好的度量就是度量本身,使用交并比来度量它们的距离是恰当的,但是,其在不重叠的边界框的情况下不能进行优化,而广义交并比(Generalized Intersection over Union,GIoU)有效解决这个问题。

交并比是预测框和真实框之间的交并集的比值,广义交并比定义为交并比和它们产生的最小封闭凸面中并集不包含的部分比值的差,交并比和广义交并比的定义如公式(6)和(7):

其中,A表示真实框,B表示预测框,C表示预测框和真实框之间产生的最小封闭凸面,表示前面减去后面剩下的部分。可以得出广义交并比有以下性质:同交并比类似,广义交并比对目标的大小不敏感;广义交并比的大小总是小于等于交并比,且-1≤GIoU≤1;当预测框和真实框重合时,GIoU=IoU=1。

当广义交并比应用于二维目标检测时,即比较两个轴对齐的边界框,在这种情况下,真实框和预测框组成的交叉面和最小封闭面都具有矩形形状,即存在解析解来计算它们的最小封闭凸面。广义交并比与交并比有相同的性质,可以是距离,即它也可以作为边界框损失,假设),其中为边界框的预测值,Bg为真实值,且(),则对应的面积可以表示为公式(8)和公式(9):

则Bp和Bg的IoU和GIoU为公式(11)和(12):

那么广义交并比损失LGIoU定义为公式(13):

由广义交并集损失函数的定义和计算方法可以看到,它能更加准确地描述预测框和真实框的距离,对训练过程更加有益,基于此,本文将其应用到原损失函数中的位置损失部分。

3.2 焦点损失

YOLOv3检测过程会产生两个问题:极度不平衡的正负样本比例:其候选样本生产方式会使正负样本相差巨大,而且大部分的负样本都是易分样本;梯度被易分样本主导:虽然这些样本的损失值很低,但是数量众多,对于损失依旧有很大贡献,从而导致收敛效果不够好。而焦点损失(Focal Loss)就是为了解决这些问题,其定义如下。

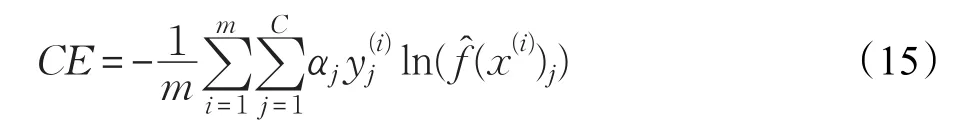

分类任务常用的损失函数是交叉熵损失。假设有m个样本,分类目标有C类,交叉熵定义如公式(14):

其中,f̂(x)表示预测类别概率,y是实际类别的编码向量。交叉熵函数本身将所有类别的物体均等对待,在遇到类别不平衡现象时容易造成预测偏移,而且无法对难分样本进行加强训练。焦点损失正是针对不同的问题分别改善,首先,针对正负样本不均衡,对不同类别引入一个权重因子α削弱大数量类别对损失值的影响,具体实现方式如公式(15):

等式(8)仅仅解决了正负样本之间的平衡问题,并没有区分易分和难分样本。当一个样本的预测概率越高,模型对该样本的识别力越强,则该样本成为易分样本,反之则是难分样本。针对易分和难分样本,以预测概率为基础,引入一个权重因子β削弱易分样本对损失值的影响,则焦点损失定义为公式(16):

其中,,γ是一个可调节的超参数。由此可知焦点损失综合考虑了正负样本比例和易分难分问题,对网络的性能有一定提升,本文将其应用到原损失函数中的置信度损失部分,并对不同的α和γ值进行了实验。

4 实验结果

4.1 数据集

为了验证改进的方法在无人机检测中的有效性,本文建立了一个无人机数据集。为了保证了数据集在实际使用时的真实性,数据集的图片都是从监控视频中截取的不同时间的视频片段。将视频经过分帧等一系列操作后,再经过人为筛选剔除掉图像序列中的低质量图像,最后获得图像3 651张。最后,划分训练集2 638张,验证集1 013张。其中,图片的分辨率为1 280×1 024,均为RGB三通道图像。类别为无人机(drone),数据集的样本如图3。

图3 数据集样本示例

4.2 模型训练

针对无人机数据集,为了快速实验,本文所要的改进都是基于原文用Python复现的框架,GPU选择Nvidia1080Ti,系统为Ubuntu16.04,CUDA为9.0。初始化学习率为0.000 001,最大学习率为0.000 1,动量因子为0.9,batch size为6,Anchors设置为PASCAL VOC的默认值。测试时,输入统一采用544×544,非极大抑制算法的参数设置为0.45,以IoU大于0.75为阈值评估得分。

4.3 实验结果分析

通常目标检测采用平均准确率作为检测准确性的评估指标,综合考虑定位精度与分类准确度,对无人机数据集用mAP75作为性能指标。首先对焦点损失中的不同的α和γ取值对模型的影响做了实验,实验的全部结果如表1。

表1 不同的α和γ的实验结果

从表1可以得出,α和γ的值都对mAP75的值有较大的影响,也证明了焦点损失在训练中发挥了有效性,当α=1,γ=2.0时,mAP75值最高。不同的α和γ值在训练时的学习率和损失曲线如图4。

图4 不同的α和γ值在训练过程中的损失变化

通过观察图4,在训练过程中,损失值都在缓慢降低,最终到达到收敛,不同点在于,损失变化的波动情况。不同的参数组的波动幅度都不同,其中,对于最优的参数组,其损失下降曲线的非常平滑,得到的训练效果最好,在得到最优的参数组后,本文对不同的模型进行了比较实验,结果如表2。

表2 不同模型的实验结果

其中,YOLOv3表示原始算法的实验结果,Y_G表示仅使用广义交并比损失后的实验结果,Y_G_F表示既使用广义交并比损失又使用焦点损失后的实验结果,Y_G_F_W表示采用损失权重比时的结果。其中,位置损失的权重为5,置信度损失的权重为0.5,分类损失的权重为1。

由表2知,采用广义交并比损失后,mAP75上升了13.65%,充分验证了它比原来的平方和损失能更好地度量预测值和真实值的距离,使得学习到的位置信息更加准确。在此基础上,采用焦点损失,mAP75提升了3.14%,证明焦点损失能有效结合广义交并比损失,实现了共同训练,验证了学习更精确的位置信息和解决正负样本不平衡和难分样本问题不矛盾。此外,在增加了误差权重之后,mAP75的值又提升了3.25%,侧面验证了正负样本不均衡对实验性能的影响是巨大的,同时,增加了位置误差权重能够更加使得模型变得位置敏感,提升性能。此外,和SSD300、Retinanet相比,改进后的算法在精度上仍具有优势,应用于实际项目上更加可行。具体的检测结果示例如图5。

此外,为了进一步验证本文算法在目标检测中的可靠性,在PASCAL VOC上进行训练和评估,其中VOC数据集中目标检测数据集含有20类目标图像。在采用了VOC2007 trainval和VOC2012 trainval联合训练的方式,并以VOC2007 test评估数据集,以IOU大于0.5为阈值评估得分,实验结果如表3。

图5 检测结果示例

表3 不同模型在VOC上的实验结果

由表3知,相比SSD、Faster R-CNN、YOLOv3的性能已经足够强大,在项目实践占据重要地位。但是,其在性能上仍然有很大的进步空间,而本文的改进就是最好的证明。通过在无人机数据集和PASCAL VOC上都成功地验证了算法的有效性,值得项目推广使用。

5 总结和展望

针对无人机检测需求,本文分析了YOLOv3模型的结构和特点,对损失函数做出了有益改进。通过分析训练和测试流程,针对无人机检测任务,采取广义交并比损失和焦点损失对原损失函数进行重构。同时还引入了损失权重,提高位置敏感度,有效地提升了检测性能。实验结果表明:重构损失在训练过程中下降稳定,减少了梯度消失的情况,学习到了更加精确的位置信息,获得了更好的检测效果。本文从损失函数的角度,提出现有网络的改进方法,在下一步的研究工作中,将会在更多其他的网络模型中,采用更大规模的数据集,用以验证改进的损失函数的通用性与鲁棒性。