基于卡尔曼滤波的SiamRPN目标跟踪方法

张子龙 王永雄

摘要:基于深度学习的视觉跟踪方法在多个基准数据库上取得了很好的跟踪性能,特别是基于Siamese框架的目标跟踪方法取得了突破性的进展。为了提高跟踪效果,有效解决跟踪过程中干扰和遮挡问题,本文提出了一种基于卡尔曼滤波的SiamRPN(Siamese+RPN)目标跟踪方法。首先,利用训练好的SiamRPN跟踪算法和卡尔曼滤波跟踪模型分别对目标物体进行跟踪,得到2种跟踪算法跟踪结果的置信度,然后,基于置信度加权融合模型得到最后的跟踪框。卡尔曼滤波器可预测目标在一定遮挡干扰等情况下的位置,SiamRPN算法利用区域候选网络RPN将每一帧的跟踪转换为一次局部检测任务,快速准确地得到跟踪框的位置和尺度,提出的算法避免了使用常规的低效费时的多尺度自适应方法,融合了2种优秀跟踪算法的优点,不仅跟踪速度较快,而且抗干扰和遮挡能力明显提高。在经典数据库上的实验验证了提出的算法明显提高了目标运动较快、干扰较强和有遮挡情况下的跟踪效果,在速度没有明显下降的前提下,成功率和精度等多个性能指标均有较大的提升。

关键词: 目标跟踪; 卡尔曼滤波; 孪生网络; 加权融合

【Abstract】The visual learning method based on deep learning has achieved good tracking performance on multiple benchmark databases. Especially, the object tracking method based on Siamese framework is a breakthrough. In order to improve the tracking effect and solve effectively the interference and occlusion problems in tracking, a SiamRPN (Siamese+RPN) object tracking method based on Kalman filtering is proposed. Firstly, the trained SiamRPN tracking algorithm and the Kalman filter tracking model are used to track the object respectively, and the confidence of the results of the two tracking algorithms is obtained. Then, the final tracking frame is obtained based on the confidence weighted fusion model. The Kalman filter can predict the position of the object under certain occlusion interference. The regional candidate network RPN in SiamRPN algorithm is used to convert the tracking of each frame into a local detection task, and obtain the position and scale of the tracking frame both quickly and accurately. The conventional inefficient and time-consuming multi-scale test and online fine-tuning is abandoned. The new method includes the advantages of two excellent tracking algorithms. Thus, not only the tracking speed is fast, but also the anti-interference and occlusion capabilities are significantly improved. Experimental results on the classical database verify that the proposed algorithm significantly improves the tracking effect in the condition of fast object motion, strong interference and occlusion. The performances such as success rate and accuracy are greatly achieved without decreasing the tracking speed obviously.

【Key words】 object tracking; Kalman filter; SiamRPN network; weighted fusion;

0 引 言

视觉目标跟踪是最近几年计算机视觉领域的主要研究方向之一,也是计算机视觉分析、自动驾驶和姿态估计等领域的一个基本问题。跟踪的主要难点是在具有遮挡、干扰、变形、背景杂波等变化的复杂场景中准确地检测和定位目标。目前主流的跟踪方法分为2类。一类基于相关滤波的跟踪算法[1-3],该方法因为速度快、效果好吸引了众多研究者的目光。相关滤波器通过将输入特征回归为目标高斯分布来训练滤波器,Bolme等人[2]提出用相关滤波器进行目标跟踪,并优化傅里叶域中误差平方和的输出,使跟踪速度达到了每秒669帧。Henriques等人[4]通过引入循环移位矩阵和和技巧(Exploiting the Circulant Structure of Tracking-by-detection with Kernels, CSK)可以在基本不损失计算速度的基础上极大地扩充训练样本,但该算法的目标框大小是固定的,对发生尺度变化的目标不具有鲁棒性。 Henriques 等人[5]在后续工作中提出了核相关滤波器(High-Speed Tracking with Kernelized Correlation Filters,KCF), 该滤波器在CSK的基础上提出用快速梯度直方图特征(Fast Histogram of Oriented Gradiend,FHOG)提高跟踪精度。针对目标运动中造成的尺度变化问题,Danelljian等人[6]提出了平移滤波加尺度自适应的方法(Discriminative Scale Space Tracking,DSST),并引入多特征融合机制,显著地提高了跟踪精度。另一类方法是基于强大的深度学习方法,随着深度学习的发展,其强大的学习能力和优秀的特征表达能力在视觉跟踪领域展现了巨大的潜力。学者们开始用鲁棒性更强的卷积神经网络来提取目标特征。Ma等人[7]提出了HCF(Hierarchical Convolutional Features for visual tracking)算法,将传统的HOG特征替换为深度卷积特征,由于低层特征有较高的分辨率能够对目标进行精准的定位,高层特征包含更多的语义信息,故而提出用分层卷积特征对目标进行学习。Danelljan等人[8]提出了连续卷积算子(Continuous Convolution Operators for visual Tracking, CCOT),该算法在特征融合的基础上,通过在连续空间域的学习,创建时域连续的相关滤波器,并将不同分辨率的特征图输入滤波器,使传统特征和深度特征相结合,显著地提高了跟踪的实时性和鲁棒性。Danelljan等人[9]针对CCOT处理高维特征需要处理多个滤波器的问题,为了提高时间和空间效率,提出了高效的卷积算子ECO(Efficient Convolution Operators for tracking),利用因式分解构造一组更小的滤波器,降低了模型的复杂度,防止过高的维度而導致的低效率和过拟合问题,同时利用高斯混合模型表示不同的目标外观,降低模型的更新频率,防止过拟合。

近年来,采用基于Siamese(孪生)网络框架进行目标跟踪的孪生网络以其优良的性能在视觉跟踪领域受到了广泛的关注。经典的SiamFC方法首先学习构建先验的孪生相似性函数[10],然后利用这个相似性函数比较目标模板和搜索区域的相似度,最后得到搜索区域的得分图(score map)。该跟踪算法在速度方面取得不错的效果。SiamRPN[11]是在Siamese网络的基础上引入了一个区域候选网络(RPN),将每一帧的跟踪转换为一次局部检测任务,SiamRPN网络强大的检测功能使得跟踪方法获得了较高的精度和速度。然而,当目标运动速度较快或者目标周围有干扰物的时候,跟丢目标的概率依然很高。为此,Morimitsu[12]提出用多种上下文特征来扩展SiamFC跟踪器,从非常深的网络中提取多个上下文和语义级别的特征,获取跟踪目标的更加完备特性描述,从而提高跟踪效果。该方法能够有效地从不同层中提取出互补特征,并在融合时显著提高了模型的抗干扰性能。同样为了提高模型的抗干扰能力和泛化能力,Wang等人[13]提出了RASNet(Residual Attentional Siamese Network for high performance online visual tracking),该算法在Siamese网络的基础上,通过引入3种注意力机制(Residual Attention、General Attention和Channel Attention),精确描述目标的外观轮廓,优先选择更加强有力的特征通道,再对其进行加权融合,并把这项注意力机制作为一个layer嵌入Siamese网络中,提升了模型的判别能力和抗干扰性能。但是,在长时跟踪中,Siamese类跟踪器不能很好地应对目标全遮挡、目标出画面等挑战。

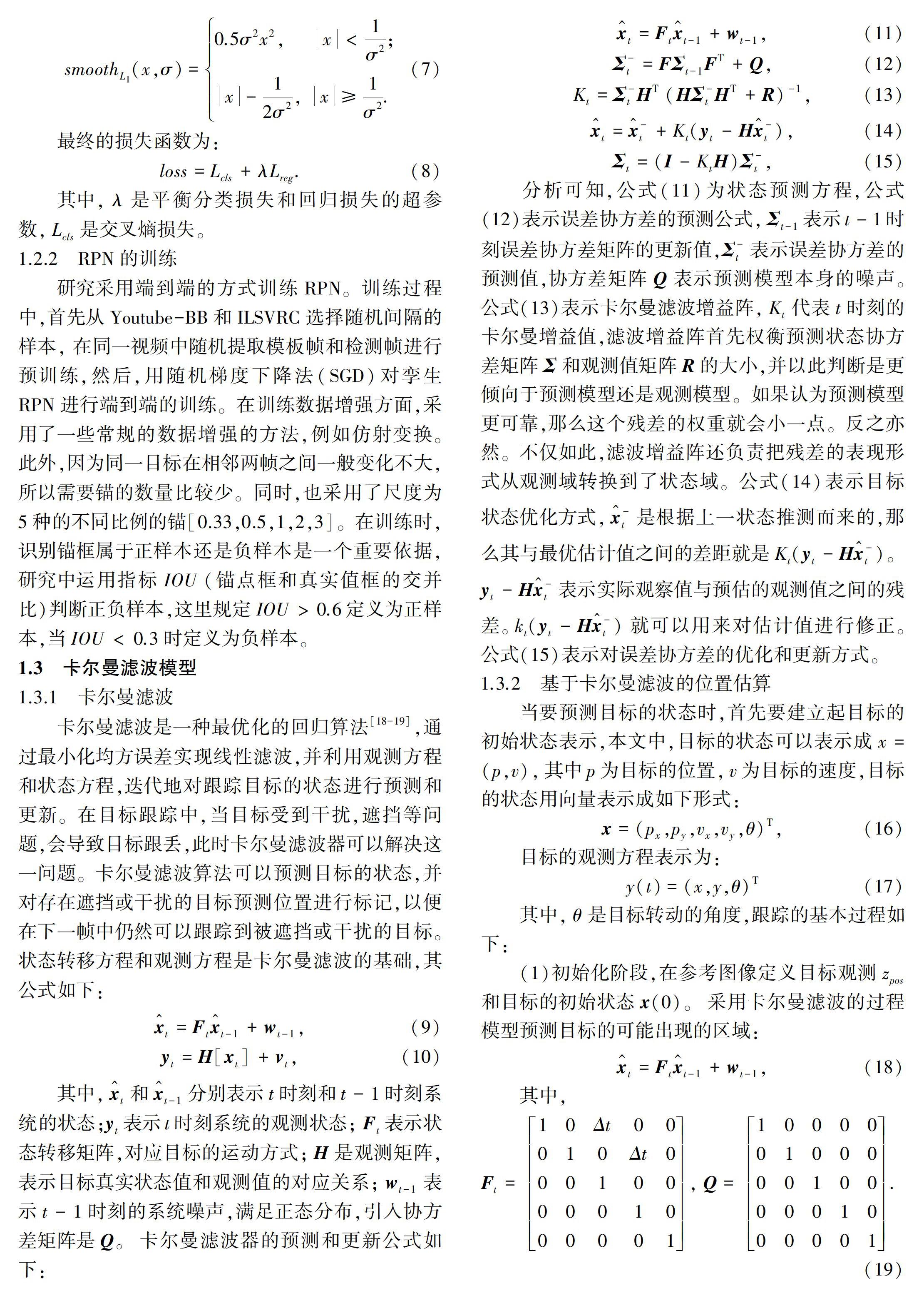

为了提高模型抗干扰性和解决短时全遮挡问题,本文提出了一种基于卡尔曼滤波的SiamRPN目标跟踪方法,当视频输入时,SiamRPN和卡尔曼滤波模块同时进行跟踪,SiamRPN模型分支首先利用卷积神经网络对模板帧和检测帧进行特征提取,然后经过RPN网络回归得到跟踪目标的位置坐标和尺度。模型的另一分支利用卡尔曼滤波对检测帧的目标进行预测,最后通过置信度加权融合2个子模型的跟踪结果,确定最优跟踪框。SiamRPN中的区域候选网络RPN可以快速准确地计算出跟踪框的位置和尺度,避免了使用常规的低效费時的多尺度自适应方法。当目标受到严重干扰或遮挡时,卡尔曼预测模块依靠优秀的预测位置能力,相对准确地跟踪到目标的位置,这是Siamese类跟踪器不具有的性能。因此,本文的方法不仅跟踪速度快,而且在抗干扰和解决遮挡问题上表现出明显的优势。

1 基于卡尔曼滤波的孪生网络

1.1 基于Siamese的跟踪网络

近年来,基于Siamese网络的跟踪器因其良好的跟踪精度和效率而受到广泛关注[14-16]。这些跟踪器将目标跟踪表示为通过学习目标模板和搜索区域的特征表示之间的相互关联来学习一般的相似性映射,并从具有孪生网络结构的深度模型中学习跟踪相似度,一个分支用于学习目标的特征表示,另一个分支用于学习搜索区域的特征表示。为了从2个分支的相互关系中生成相似映射,研究中训练了一个全卷积神经网络,将2个网络分支连接起来,一个用于对象模板,另一个用于搜索区域。目标补丁(实例)通常是在第一帧的序列,可以被视为一个范例z。研究的目标是在搜索区域x找到与范例z最相似的目标对象。

1.2 SiamRPN网络框架

1.2.1 SiamRPN介绍

SiamRPN第一次是在Faster RCNN中使用[17],专门用来提取候选框,在RCNN和Fast RCNN等物体检测架构中,提取候选框的方法通常是Selective Search,是传统的方法之一,而且比较耗时,使用CPU需要花费2 s计算一张图。为提高计算速度,提出了利用RPN提取候选框,一方面RPN耗时少,另一方面RPN可以很容易结合到Fast RCNN中,合成为一个整体。

在视觉跟踪中,区域候选网络RPN的引入使得网络在跟踪的时候不需要多尺度测试,通过网络回归可以直接得到更加准确的目标位置,不需要插值等附加计算。[JP2]在网络训练中,研究引入了大规模的视频数据集Youtube-BB进行训练,相比较于原来的VID数据集,Youtube-BB在视频数量上有大约50倍的提升,这保证了网络能够得到更为充分的训练。

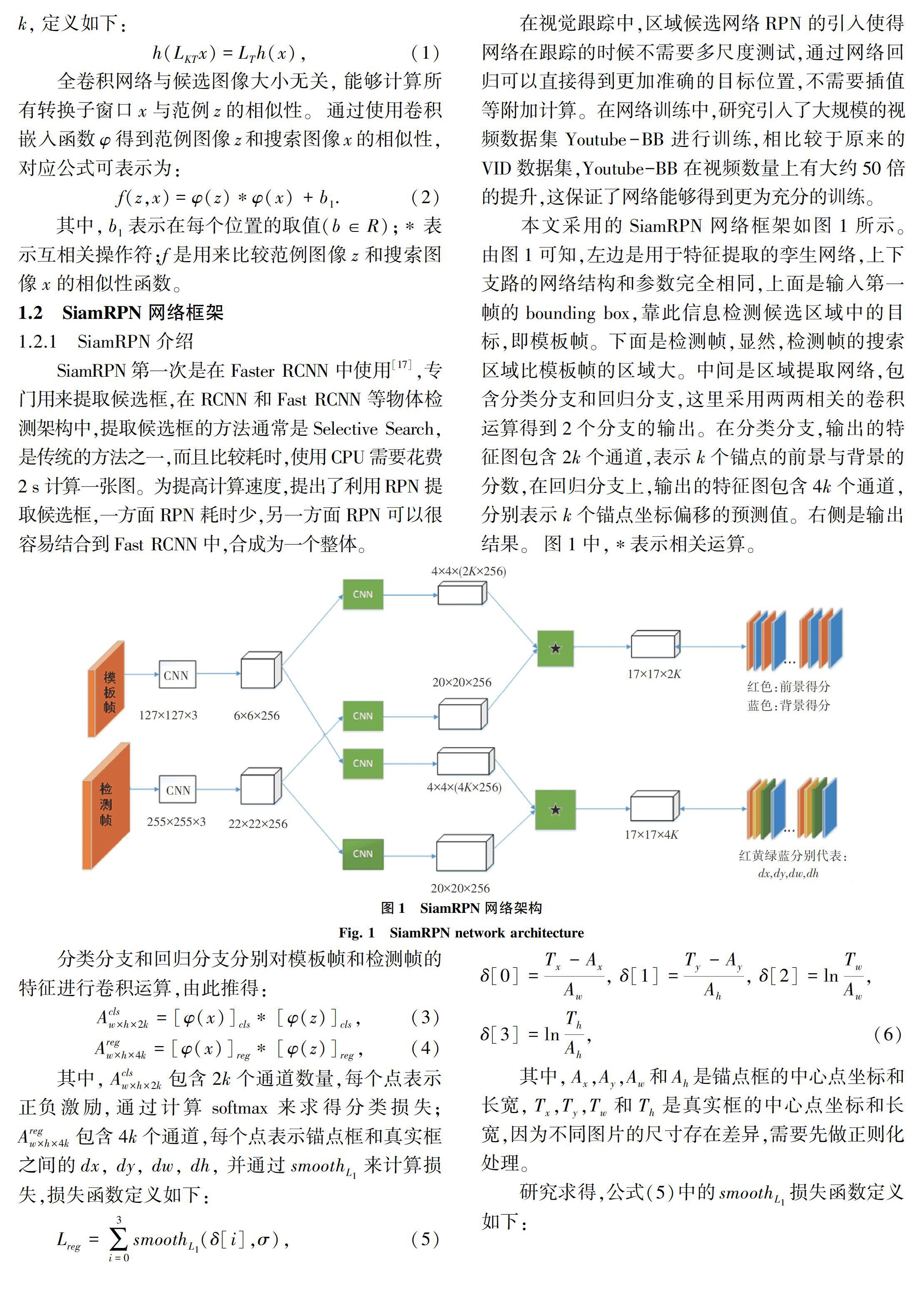

本文采用的SiamRPN网络框架如图1所示。由图1可知,左边是用于特征提取的孪生网络,上下支路的网络结构和参数完全相同,上面是输入第一帧的bounding box,靠此信息检测候选区域中的目标,即模板帧。下面是检测帧,显然,检测帧的搜索区域比模板帧的区域大。中间是区域提取网络,包含分类分支和回归分支,这里采用两两相关的卷积运算得到2个分支的输出。在分类分支,输出的特征图包含2k个通道,表示k个锚点的前景与背景的分数,在回归分支上,输出的特征图包含4k个通道,分别表示k个锚点坐标偏移的预测值。右侧是输出结果。图1中,表示相关运算。

2.2 定性分析

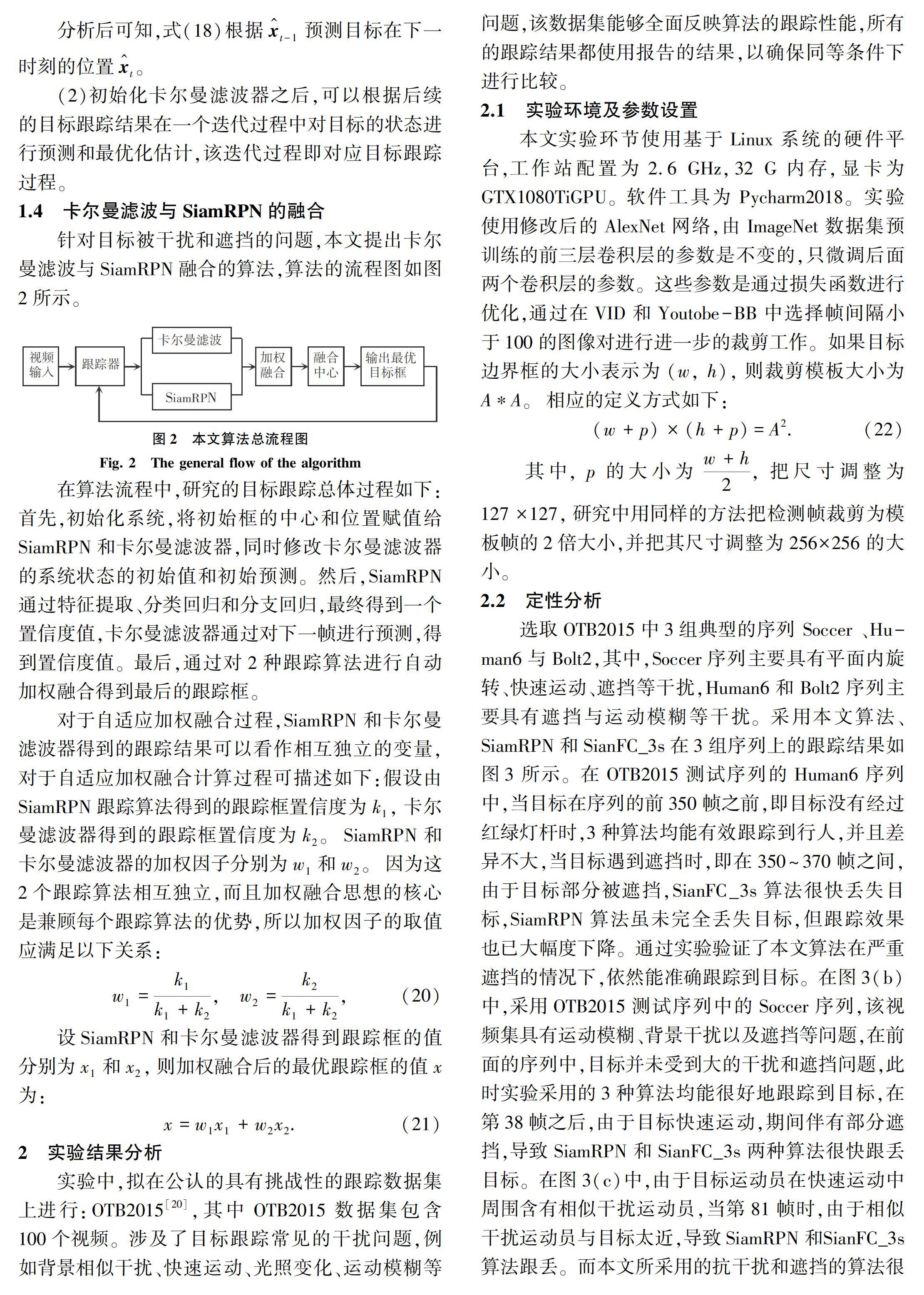

选取OTB2015中3组典型的序列 Soccer 、Hu-man6与Bolt2,其中,Soccer序列主要具有平面内旋转、快速运动、遮挡等干扰,Human6和Bolt2序列主要具有遮挡与运动模糊等干扰。采用本文算法、SiamRPN和SianFC_3s在3组序列上的跟踪结果如图3所示。在OTB2015测试序列的Human6序列中,当目标在序列的前350帧之前,即目标没有经过红绿灯杆时,3种算法均能有效跟踪到行人,并且差异不大,当目标遇到遮挡时,即在350~370帧之间,由于目标部分被遮挡,SianFC_3s算法很快丢失目标,SiamRPN算法虽未完全丢失目标,但跟踪效果也已大幅度下降。通过实验验证了本文算法在严重遮挡的情况下,依然能准确跟踪到目标。在图3(b)中,采用OTB2015测试序列中的Soccer序列,该视频集具有运动模糊、背景干扰以及遮挡等问题,在前面的序列中,目标并未受到大的干扰和遮挡问题,此时实验采用的3种算法均能很好地跟踪到目标,在第38帧之后,由于目标快速运动,期间伴有部分遮挡,导致SiamRPN和SianFC_3s两种算法很快跟丢目标。在图3(c)中,由于目标运动员在快速运动中周围含有相似干扰运动员,当第81帧时,由于相似干扰运动员与目标太近,导致SiamRPN和SianFC_3s算法跟丢。而本文所采用的抗干扰和遮挡的算法很好地解决了这个问题,当目标遇到遮挡时,由于RPN模块不能应对该问题,本文提出的卡尔曼滤波可以很好地预测目标的位置。综上分析可知在图3中,(a)是遮挡问题,(b)和(c)是严重的干扰和遮挡问题,从实验结果可以看出,相比于SiamRPN等算法,本文所提出的基于卡尔曼滤波的SiamRPN目标跟踪方法在面对背景干扰问题上具有明显的优势。

2.3 定量分析

OTB2015包含从常用跟踪序列中收集的100个序列。评估基于2个指标:精度图和成功率图。精度图显示目标跟踪结果与目标距离在20像素以内的帧数百分比。成功率图显示了阈值在0~1之间变化时成功帧的比例,其中成功帧表示其重叠大于给定阈值。曲线下面积(AUC)的成功图用于排序需要对比的跟踪算法。在本实验中,是将本文提出的方法与数个代表性的跟踪器进行了比较,包括SiamRPN、PTAV、CREST、SRDCF、SINT、CSR-DCF、SianFC_3s、CFNet、DSST。不同跟踪算法的成功率图与精度图见图4。从图4中可以看出,相比于传统算法SiamFC_3s,加入了区域候选网络RPN后的SiamRPN其成功率和精度分别提高了5.5%和8%。本文算法在SiamRPN上引入了卡尔曼滤波模块,成功率和精度分别提高了0.8%和2.1%,通过定量分析表明,本文提出的算法具有更好的跟踪性能。

3 结束语

本文提出了一种基于卡尔曼滤波的SiamRPN目标跟踪方法,在SiamRPN算法的基础上,融合了卡尔曼滤波,该算法不仅跟踪速度块,而且有效解决了跟踪过程中的干扰和遮挡问题,实现了跟踪目标在运动较快、干扰较强和有遮挡情况下的高性能跟踪。其中,SiamRPN算法中的区域候选网络RPN可以快速准确地计算出跟踪框的位置和尺度,避免了使用低效费时的多尺度测试来确定跟踪框的尺度。通过对比实验可以看出本文提出的基于卡尔曼滤波的SiamRPN目标跟踪方法,在面对目标遮挡、背景干扰等传统目标跟踪问题时,具有更好的跟踪性能。虽然本文算法与对比算法相比能够取得较好的效果,但是增加卡尔曼滤波模块的同时也降低了跟踪速度。本文算法针对短期的干扰具有优良的性能,但在面对长期的遮挡和干扰的跟踪效果仍不够理想,还需要进一步的研究工作完善该算法。

参考文献

[1] BIBI A, MUELLER M, GHANEM B. Target response adaptation for correlation lter tracking[M]// LEIBE B, MATAS J, SEBE N, et al. Computer Vision – ECCV 2016. Lecture Notes in Computer Science. Cham:Springer,2010,9910:2544.

[2]BOLME D S, BEVERIDGE J R, DRAPER B A, et al. Visual object tracking using adaptive correlation lters[C]//IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ, USA: IEEE, 2010:2544.

[3]李麒驥, 李磊民, 黄玉清. 尺度自适应的核相关滤波跟踪器[J]. 计算机应用, 2016, 36(12):3385.

[4]HENRIQUES J F, CASEIRO R, MARTINS P, et al. Exploiting the circulant structure of tracking-by-detection with kernels[C]//European Conference on Computer Vision. Berlin/ Heidelberg:Springer, 2012: 702.

[5]HENRIQUES J F, CASEIRO R, MARTINS P, et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2014, 37(3): 583.

[6]DANELLJAN M, HGER G, KHAN F S, et al. Discriminative scale space tracking[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 39(8): 1561.

[7]MA Chao, HUANG Jiabin, YANG Xiaokang, et al. Hierarchical convolutional features for visual tracking[C]//Proceedings of the IEEE International Conference on Computer Vision. Santiago, Chile:IEEE,2015: 3074.

[8]DANELLJAN M, ROBINSON A, KHAN F S, et al. Beyond correlation filters: Learning continuous convolution operators for visual tracking[M]// LEIBE B, et al. Proceedings of the 14th European Conference on Computer Vision. Amsterdam, The Netherlands:Springer, 2016: 472.

[9]DANELLJAN M, BHAT G, KHAN F S, et al. ECO: Efficient convolution operators for tracking[C]// Proceedings of 2017 IEEE Conference on Computer Vision and Pattern Recognition. Honolulu, HI, USA:IEEE, 2017:6931.

[10]BERTINETTO L, VALMADRE J, HENRIQUES J F, et al. Fully-convolutional siamese networks for object tracking[M]//HUA G, JGOU H.Computer Vision-ECCV 2016 Workshops. Lecture Notes in Computer Science. Cham:Springer, 2016,9914: 850.

[11]LI B, YAN J, WU W, et al. High performance visual tracking with siamese region proposal network[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City:IEEE,2018: 8971.

[12]MORIMITSU H. Multiple context features in siamese networks for visual object tracking[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich, Germany:Diamond,2018: 116.

[13]WANG Q, TENG Z, XING J, et al. Learning attentions: Residual attentional siamese network for high performance online visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City:IEEE, 2018: 4854.

[14]ZHU Z, WANG Q, LI B, et al. Distractor-aware siamese networks for visual object tracking[C]//Proceedings of the European Conference on Computer Vision (ECCV). Munich, Germany:Diamond, 2018: 101.

[15]HE Anfeng, LUO Chong, TIAN Xinmei, et al. A twofold Siamese network for real-time object tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition.Salt Lake City:IEEE, 2018: 4834.

[16]SUN C, WANG D, LU H, et al. Learning spatial-aware regressions for visual tracking[C]//Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition. Salt Lake City:IEEE,2018: 8962.

[17]REN S, HE K, GIRSHICK R, et al. Faster R-CNN: Towards real-time object detection with region proposal networks[C]//International Conference on Neural Information Processing Systems. Cambridge:MIT Press, 2015: 91.

[18]胡波, 陳恳, 徐建瑜, 等. 基于Kalman预测和Mean-shift算法的视频目标跟踪[J]. 光电子. 激光, 2009 (11):1157.

[19]赵广辉,卓松,徐晓龙. 基于卡尔曼滤波的多目标跟踪方法[J]. 计算机科学,2018,45(8):253.

[20]WU Y, LIM J, YANG M H. Object tracking benchmark[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2015,37(9):1834.