重校准特征融合对抗域适应的遥感影像场景分类

陈德海 潘韦驰 丁博文 黄艳国

(江西理工大学电气工程及自动化学院 江西 赣州 341000)

0 引 言

目前全球对地观测系统(EarthObservingSystem,EOS)的快速发展,使得大量的遥感影像数据成为人类了解地球信息的重要信息来源,从而导致影像数据中所包含的空间信息越来越丰富,影像分辨率越来越高,使得影像场景中复杂的语义信息难以提取。而这些信息在城市规划、自然灾害中有着不可或缺的作用。此外,类内差异性和类间相似性等问题的存在对遥感影像场景分类带来了巨大的挑战。虽然目前有许多研究方法被提出[1-4],但大部分的方法是基于图像的低、中层特征,因此在遥感影像场景样本有限甚至没有的情况下,如何有效地提取遥感影像场景的高层语义特征,并研究出能有效提升大规模遥感影像场景分类性能的方法是目前遥感信息领域亟待解决的问题。

近几年,深度学习因其强大的学习能力被应用到诸多领域[5-7],同时也被不少学者应用于遥感影像场景分类[8-13]中,取得了不错的效果。然而,在使用卷积神经网络进行遥感影像场景分类时,通常只是单一地通过堆叠卷积层来提取遥感影像场景的高层特征,由于遥感影像中存在着复杂的空间特征信息,使得遥感影像在场景分类中分类精度不理想。文献[14]利用卷积神经网络进行场景分类,同时在训练过程中通过整合额外的光谱信息计算出深度特征,进而可以进行高分辨率遥感图像中建筑物以及非建筑物的识别。文献[15]针对遥感场景分类,分析了三种卷积神经网络策略用以提高分类精度,降低训练参数。文献[16]通过联合显著性采样和卷积神经网络进行遥感场景分类,但对于类内差异性和类间相似性等问题,显著性算法无法识别。遥感影像场景分类的域适应方法在近几年也有学者进行研究[17-20],其在域适应问题上的特点在于:其一,源域与目标域遥感影像场景特征空间分布不同;其二,遥感影像场景中含有的特征复杂,也就意味着需要大量的遥感影像场景样本支持。

针对上述情况,本文提出了一种重校准特征融合对抗域适应的分类方法,该方法首先将SEblock嵌入VggNet16中学习遥感影像场景的细粒度特征,然后利用对抗域适应方法减少源域和目标域遥感影像场景的特征差异,提高模型对目标域遥感影像场景的分类精度以及泛化能力。实验中构建一个大型遥感影像场景数据集作为源域并利用UCMerced_LandUse和SIRI-WHU两个通用数据集作为目标域,用来验证本文方法的有效性。

1 相关原理

1.1 特征重校准

文献[21]通过研究网络结构中通道之间的关系,提出一种新的结构单元——缩聚与激发模块(SqueezeandExcitationblock)。其目标是通过卷积特征通道之间的相互依赖性来提高网络生成的特征图的质量,允许网络执行特征重新校准。通过该机制,它可以学习使用全局信息来选择性地强调有效的信息特征并抑制干扰特征。SEblock分为3个步骤。首先通过缩聚操作用全局平均池化(GAP)将输入的特征图进行统计求和,获取全局信息。具体公式如下:

式中:Z∈RC,H、W表示特征图的高度和宽度;Zc表示经过全局平均池化后特征图的集合。

其次,使用激发操作捕获通道之间的依赖性,对缩聚操作中的特征图进行处理。具体公式如下:

s=σ(W2δ(W1z))

最后,进行对特征的重校准操作,公式如下:

yc=Fscale(uc,sc)=sc·uc

式中:yc表示经过重校准后的二维矩阵。通过将特征图uc与权重sc相乘,得到第c个通道的输出矩阵yc。

1.2 生成对抗原理

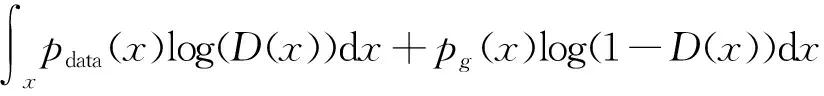

生成式对抗模型GANs(Generative adversarial networks)是Goodfellow等[22]提出的一种深度学习框架,其在图像处理和计算机视觉领域中的应用尤为成熟。GANs的核心思想来源于博弈论,由生成器G与判别器D组成。生成器从图像的特征分布采样出随机噪声并输入到生成器中,产生生成样本,然后通过判别器辨别样本的真实性,生成器和判别器二者进行相互对抗更新迭代,使生成器能够拟合真实样本的特征。GANs的实质是一个极大极小博弈(minimax game)优化问题,其数学描述如下:

Ez~pz(z)[log(1-D(G(z)))]

式中:x表示来自真实样本Pdata(x)中的真实图像;z表示来自采样噪声Pz(z)中的向量;E为数学期望值;D(x)表示数据通过判别器D后的输出;G(z)表示生成的图像。通过训练判别器D以尽可能地去分配真实样本与生成器G中生成样本的标签,同时训练生成器G以最小化log(1-D(G(z))),即最大化判别器的损失值。

在给定生成器G的条件下,需要极小化V(G,D)来求得最优解。可将V(G,D)写成积分形式:

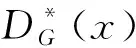

式中:pdata(x)与pg(x)分别是真实样本与生成样本的概率密度函数。此时求解上式的极小值。解的最优解如下所示:

2·JS(pdata(x)‖pg(x))-2log2

由上述推导可知,极大极小博弈问题此时已转化为真实样本与生成样本分布之间的JS散度问题,当pdata(x)=pg(x)时,模型达到最优。所以,以V(G,D)作为损失函数,最终G(z)的输出将趋近于真实样本分布。为此,本文将对抗学习方法引入到遥感影像场景分类的对抗域适应中,最小化源域遥感影像场景和目标域遥感影像场景的特征分布差异。

2 方法设计

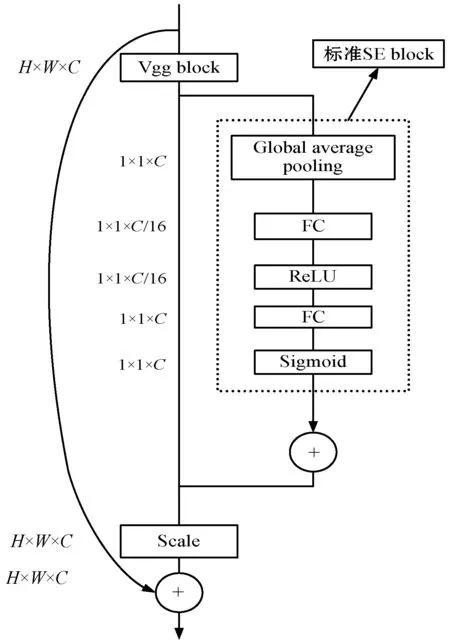

2.1 SE-VggNet

对抗域适应方法需要对源域影像特征与目标域影像特征进行差异性训练,而遥感影像具有地理特征复杂、空间信息丰富等特点,往往忽略了一些细粒度特征,增加场景分类的难度,而仅通过单一的堆叠卷积层,无法获得遥感影像场景的重要特征,从而导致分类不精确。因此受到SE block启发,通过将SE block嵌入到VggNet中,提高SE block提取有效遥感场景影像特征抑制场景中干扰特征的效果,提高网络提取影响场景细粒度特征的能力。网络结构设计如图1所示。

图1 网络结构设计

网络结构设计步骤为:在每个Vgg block的卷积变换之后嵌入SE block,对每个遥感场景特征通道的信息进行权重自动分配;通过Scale操作加权到最初遥感场景特征图中,以增强整个模型的分类性能。

通过该结构,既可以学习影像场景的全局信息,获得遥感场景特征的健壮性表示,还可以根据每个特征通道的重要程度去增强有效特征权重并抑制干扰特征权重,从而实现特征通道的自适应校准,提高遥感影像场景的分类精度,使得对抗域适应方法训练得到的差异性特征更加有效。

2.2 对抗域适应

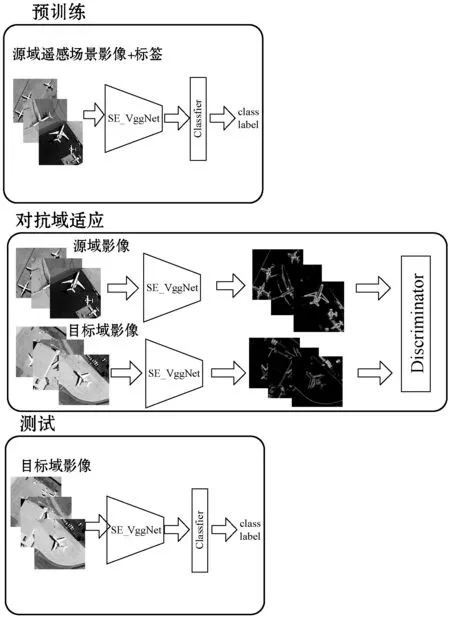

图2 本文总体框架

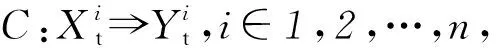

对于源域遥感影像场景部分,训练过程中本文使用标准监督损失函数,公式如下:

式中:Xs表示源域的遥感影像场景数据集;Ys表示数据集的标签;Ms表示源域的特征映射;C表示为源域分类器。Ⅱ[·]是一个指示函数,取值规则为:[表达式为真]=1,[表达式为假]=0。

为了最小化源域与目标域遥感影像场景特征差异,判别数据点来自于源域还是目标域。在对抗域适应中,判别器D与最小化特征映射M的损失函数如下式所示:

Ext~Xt[logD(Mt(Xt))]

式中:Xt为目标域遥感影像场景;Mt为目标域的特征映射;D为判别器。在对抗域适应阶段,主要目的是正则化SE-VggNet提取到的源域与目标域的遥感影像场景特征,然后最小化两者的映射分布,通过源域分类器C对目标域特征进行分类。判别网络结构如表1所示。

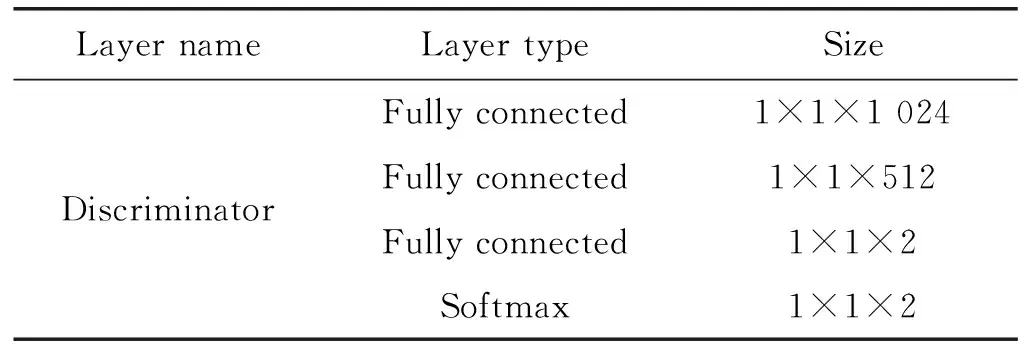

表1 判别网络结构

3 实验与分析

3.1 源域遥感场景分类数据集构建

目前还未有公开适用于对抗域方法的数据集,因此需要一个大型的源域数据集。本文的源域数据集由RSI-CB256[23]与NWPU-RESISC45[24]构成。RSI-CB256数据集利用众包的OSM的POI数据标注了全球范围内的大规模遥感影像,该数据集包含35类影像场景,共36 000幅图片,每类约为690幅,数据来源于Google Earth和Bing Maps,空间分辨率为0.22~3 m。NWPU-RESISC45数据集包含45类场景图片,每类700幅,与RSI-CB256数据集相比只有14个类别是重复的,其余31个类别是不重复的,该数据集分辨率为0.2~30 m。以上2种数据集共同构成本文的源域数据集,总计67 500幅,影像场景,所有影像场景统一尺寸为224×224,部分影像场景示例如图3所示。

沙漠 高尔夫球场 海港 森林图3 源域数据集部分示例

3.2 实验数据集

实验数据集1为UCMerced_LandUse data set(University of California Merced Land-Use data set),选自美国地质勘探局国家城市地图航空遥感影像。数据集含有停车场、森林、高尔夫球场等21类影像场景,每类含有100幅尺寸为256×256的遥感影像,空间分辨率为0.3 m,部分图像示例如图4所示。

农田 飞机 棒球场 海滩图4 UCMerced_LandUse数据集部分示例

实验数据集2为SIRI-WHU数据集,选自Google Earth遥感影像数据,共12类,每类包含200幅尺寸为200×200的遥感场景影像,空间分辨率为2 m,部分图像示例如图5所示。

工业区 商业区 海港 居民区图5 SIRI-WHU数据集部分示例

本文实验在Tensorflow框架下进行,硬件环境为Amazon EC2的P2.xlarge实例,该实例的GPU型号为Nvidia Tesla K80。

3.3 评价指标

实验采用3个指标用于评价本文方法的分类性能:总体分类精度、混淆矩阵、Kappa系数。

总体分类精度定义为:

式中:N代表总体样本数量;S代表分类正确的样本数量。

混淆矩阵用于评估各类遥感影像场景之间的混淆程度,矩阵的行和列分别代表真实与预测的遥感场景,矩阵中任意一个元素xij代表将第i种遥感场景预测为第j种遥感场景的数量占该类别总数的比例。

Kappa系数由混淆矩阵计算得出,公式如下:

式中:N为总体样本数;K为遥感影像场景类别数;xii是混淆矩阵的对角元素;ai是该矩阵第i行元素总和;bi是该矩阵第i列元素总和。

3.4 实验结果与分析

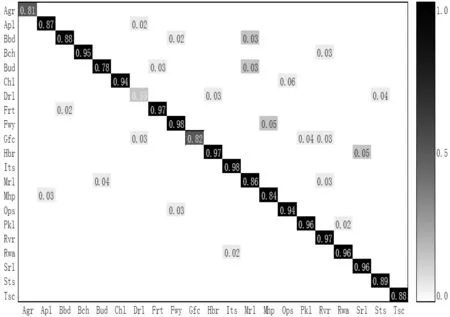

UCM_LandUse数据集实验结果如图6所示,总体分类精度为89.45%,Kappa系数为0.882。从混淆矩阵可以看出21类遥感影像场景,18类场景分类精度能达到84%以上,其中10类场景分类精度能达到95%以上。由于农田与高尔夫球场包含植被、土地等特征信息,导致分类精度仅有81%和82%,而由于密集住宅区包含大量的空间特征信息,如建筑物、街道等,易与其他场景影像产生特征交叉容易产生混淆,导致分类精度仅有51%,但大部分影像场景分类精度较高,表明本文方法能够有效减少源域和目标域遥感影像场景的特征差异并且能够提高对于目标域遥感影像场景数据集的分类精度。

图6 UCM_LandUse数据集混淆矩阵

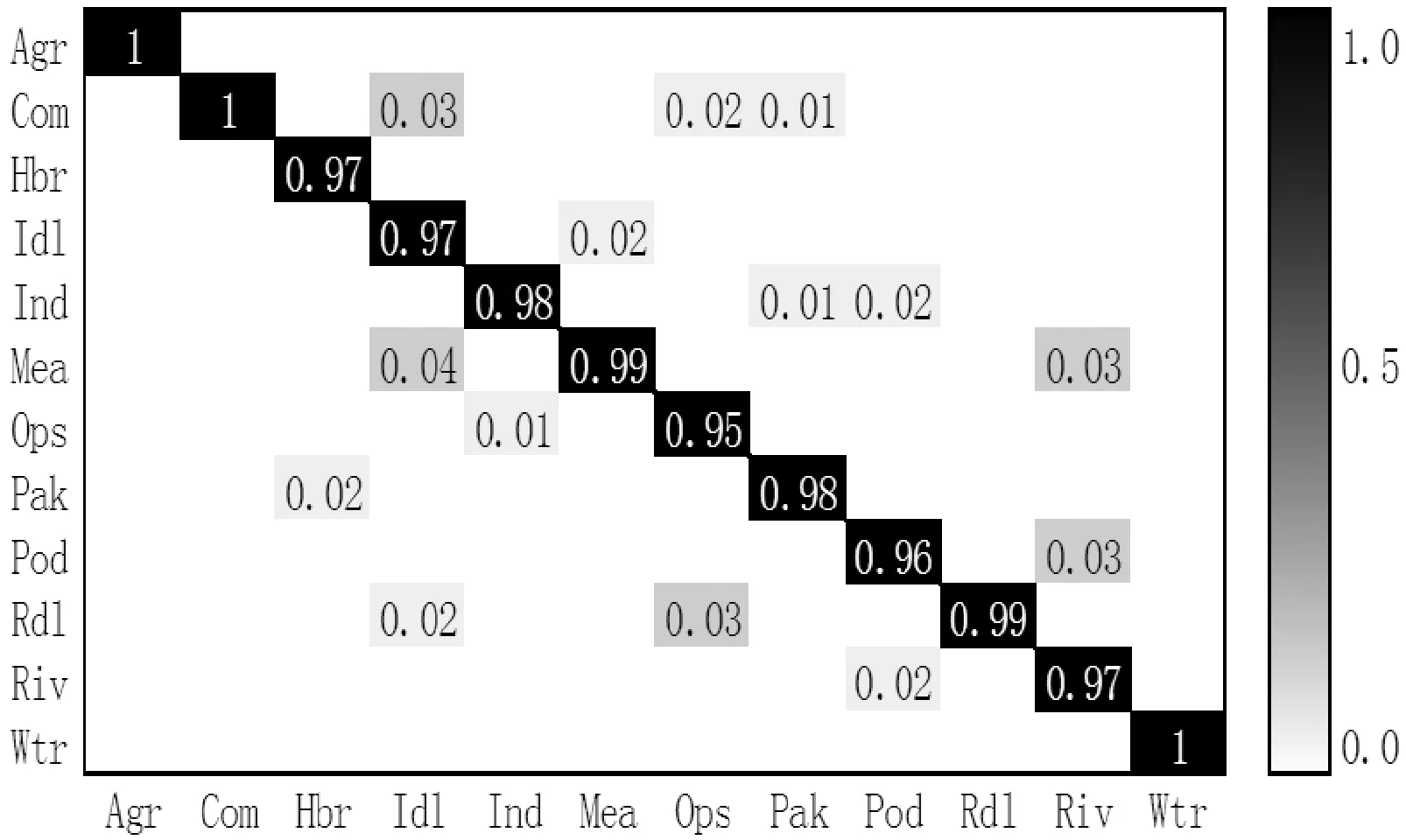

SIRI-WHU数据集实验结果如图7所示,总体分类精度为98.12%,Kappa系数为0.978。由混淆矩阵可以看出12类遥感影像场景的分类精度均在95%以上,其中农田、商业区、水源场景达到了100%的分类精度,立交桥与池塘场景的分类精度与其他场景相比分类精度较低,分别为95%与96%,但总体上表明本文方法对该数据集的分类性能好,能够有效克服源域和目标域遥感影像场景的特征分布问题。UCM_LandUse数据集与SIRI-WHU数据集相比分类精度较低,主要是因为居民区场景的特征相似程度高以及农田与高尔夫球场存在特征相似的情况,容易使模型产生混淆。综上所述,本文针对遥感影像场景分类提出的结合校准特征与对抗域适应的方法分类精度高,能够有效解决源域和目标域遥感影像场景特征分布不同导致目标域数据集分类精度较低的问题。

图7 SIRI-WHU数据集混淆矩阵

3.5 与现有方法对比分析

为了进一步说明方法的有效性,将本文方法与现有方法进行对比分析。对比的方法有:(1) Source Only利用源域数据集和卷积神经网络学习场景影像的特征,利用该特征直接对目标域数据进行分类,不使用对抗域适应方法;(2) MMD[25]使用MMD损失函数最小化源域和目标域的特征分布差异,使用最后一个全连接层输出计算MMD损失;(3) DANN[26]利用对抗学习方法最小化源域与目标域的特征分布,在域分类器之前加入了一个梯度反转层。各方法精度如表2所示。

表2 各方法分类精度 %

由表2可知,在UCM_LandUse和SIRI-WHU中,本文方法的分类精度要优于其他方法,与MMD方法相比分类精度提高了6.01%和3.29%,与DANN方法相比分类精度提高了6.58%和4.29%。结果表明,结合校准特征的对抗域适应方法在遥感影像场景分类上有明显的优势,具有较好的分类性能,同时对于不同数据集有较高的泛化能力。

4 结 语

本文提出结合校准特征与对抗域适应的遥感影像场景分类方法,利用在VggNet16中嵌入SE block进行特征重校准,提高有效特征权重并抑制干扰特征权重,使得网络训练出更能体现遥感影像场景的有效特征,然后利用对抗域适应方法降低源域与目标域遥感影像场景特征差异并实现遥感影像场景分类。在两种公开数据集UCM_LandUse和SIRI-WHU上的实验表明,本文方法可提取到遥感影像场景的有效特征,相较于其他方法在分类精度和泛化能力上有明显的优势,也为未来的无监督分类方法提供了一种新的思路。