间接蒸发冷却空调箱机组制冷的数据中心气流组织探讨

肖新文 魏 赠 曾春利

间接蒸发冷却空调箱机组制冷的数据中心气流组织探讨

肖新文 魏 赠 曾春利

(世图兹空调技术服务(上海)有限公司 上海 201108)

以6SigmaRoom仿真软件对间接蒸发冷却空调箱机组运用于数据中心的三种常用的送回风方式按照机组全部开启及备用机组故障不开启两种不同运行模式进行了CFD气流组织模拟。通过分析气流模拟得出的温度场及流场发现,机组全部开启时,三种送风方式都具有良好的温度场及流场;而备用机组故障不开启时,高架地板下送顶回、侧送侧回两种方式仍满足冷通道温度要求,顶送顶回方式局部冷通道区域不满足国标温度要求;综合考虑不同运行模式下温度场及流场的模拟结果,高架地板下送顶回的气流组织最佳。

数据中心;间接蒸发冷却;空调箱机组;CFD模拟;气流组织;节能

0 引言

空调箱,也叫做组合式空调机组,由许多功能段(混合段、过滤段、冷水盘管、热水盘管、风机段、加湿段、出风段等等)自由组合而成,可对空气进行加热、冷却、除湿、空气净化、消声等多种处理[1]。空调箱机组按照用途特征分成通用机组、新风机组、净化机组及专用机组[2],运用于数据中心的空调箱机组就是一种专用机组。数据中心行业国际上主流标准ASHARE TC 9.9 2004更新成ASHARE TC 9.9 2008版本,国内GB 50174-2017《数据中心设计规范》正式落地,国内外标准变化的核心在于放宽了温湿度的要求,最新国标要求服务器机柜进风温度在18~27 ℃之间,湿度可以在相对湿度不大于60%,同时满足露点温度在5.5~15 ℃之间[3]。宽泛的温湿度要求为使用带自然冷却的节能型空调箱(如间接蒸发冷却机组)创造了先决条件;空调箱通常放置室外设备平台、屋顶或者专门的空调机房,安装及维护空调箱机组对于数据中心本身基本无干扰,而且空调箱的制冷量比较大,模块化机组,机组数量少,维护量小;大型互联网IDC数据中心对于空调箱节能新技术的使用趋之若鹜,也推动了数据中心行业使用空调箱的发展潮流。基于以上原因越来越多的数据中心采用空调箱机组进行制冷[4-6]。依据严瀚工程经验分析:空调系统理论PUE因子与实际PUE因子之间的巨大差异就是在于无形的气流组织部分[7]。故选择合适的气流组织减少机房气流涡流避免空调箱机组风机做无用功有利于机房节能,降低机房实际运行PUE值。空调箱机组通常应用于中大型数据中心,其采用的气流组织有别于行间空调的水平送风,也与传统机房空调不尽相同。究竟怎样的气流组织最合适空调箱机组采用,本文将对此进行分析及讨论。

1 应用背景

1.1 数据中心气流组织

数据中心传统机房空调通常有多种型式的气流组织,叶明哲[8]综合对比了上下送风分别4种形式的气流方式,对部分下送风气流组织进行了推荐,易伶俐[9]认为:上送风方式适用于对送风量需求小或者机房调整少的小型数据中心;地板下送风方式适合中小型数据中心;列间空调送风方式适合大型的或者有扩容需求的数据中心。空调箱在数据中心的运用伴随节能而来,其在数据中心的气流组织受到业界广泛的关注[10-12]。间接式蒸发冷却具有良好的节能效果,成为三部委联合发布的《关于加强绿色数据中心建设的指导意见》中重点推荐的绿色数据中心先进适用技术[13],相关研究表明全国各地均可使用间接蒸发自然冷却空调箱机组[14]。间接蒸发冷却空调箱机组属于蒸发冷却机械制冷联合空调机组,机组核心部件是空气-空气换热器,机组在空气—空气换热器的中间配置雾化喷嘴,空气隔着铝翅板壁进行换热,两侧的空气完全隔离,独立循环,室内外空气品质不相互干扰。机组以间接蒸发冷却为主辅助机械制冷,依据蒸发冷却及机械制冷的开启情况分为干模式、湿模式及混合制冷三种运行模式。根据不同的应用场景间接蒸发冷却空调箱机组室内侧的送回风口有下送下回、下送侧回、侧送侧回及侧送顶回等不同布置方式。封闭热通道直接将冷风与设备散热面进行对流降温,其制冷效果比较明显,且数据机房设备散热量不影响室内其他区域[15]。封闭热通道后机组回风温度高,不仅有利于提高制冷系统效率,而且可延长自然冷却运行时间,是空调箱回风的优选方案。目前间接蒸发自然冷却空调箱机组制冷的数据中心的气流组织主要有高架地板下送顶回、侧墙送顶回及顶送顶回三种方式,本文将对这三种气流组织方式进行CFD模拟及探讨。

1.2 数据中心气流组织分析工具

计算流体力学的通用软件种类很多,如化工领域常用的Phoenics、Fluent及CFX,如侧重于固体传热和应力应变分析的ansys及主要用于气流组织模拟的airpak[16]。国内清华大学建筑技术科学系开发了的通用三维流体流动与传热数值计算软件STACH-3专门针对暖通空调领域的通风、空调房间内以及室外微环境的模拟仿真问题。针对数据中心通信机房气流组织和温度及流场分布的研究,目前主要的CFD软件有 Fluent、Flotherm、Flovent和6SigmaDC,6SigmaRoom仿真软件更加适合数据中心房间内的气流组织分析研究[17],本文亦采用6SigmaRoom仿真软件进行气流组织分析。

2 气流组织CFD模拟及性能分析

2.1 CFD模拟边界条件简述

2.1.1 样本数据中心物理模型

样本数据中心机房长为26.5 m,宽为18 m,面积为477 m2,房间净高(高架地板至天花板)为3.5 m,吊顶高为1.5 m,高架地板高为1 m。单个机柜尺寸为600 mm(宽)×1 200 mm(深)×2 500 mm(高),热负载为3.5 kW,合计共200个,不考虑围护负荷,合计热负载为700 kW。服务器负载放置在0.8 m高度以下,冷热通道均为1.2 m,每列布置10个机柜,南北方向(数据中心宽度)上布置两列机柜,两列之间预留1.8 m,机柜与侧墙之间距离2 m左右。依据GB 50174-2017《数据中心设计规范》A级机房要求,设计送风温度23 ℃,回风温度为35 ℃。不考虑梁、柱对于机柜及空调箱机组布置的影响,数据中心机柜平面布局如图1所示。

图1 样本数据中心机柜平面布局图

2.1.2 三种气流组织边界条件

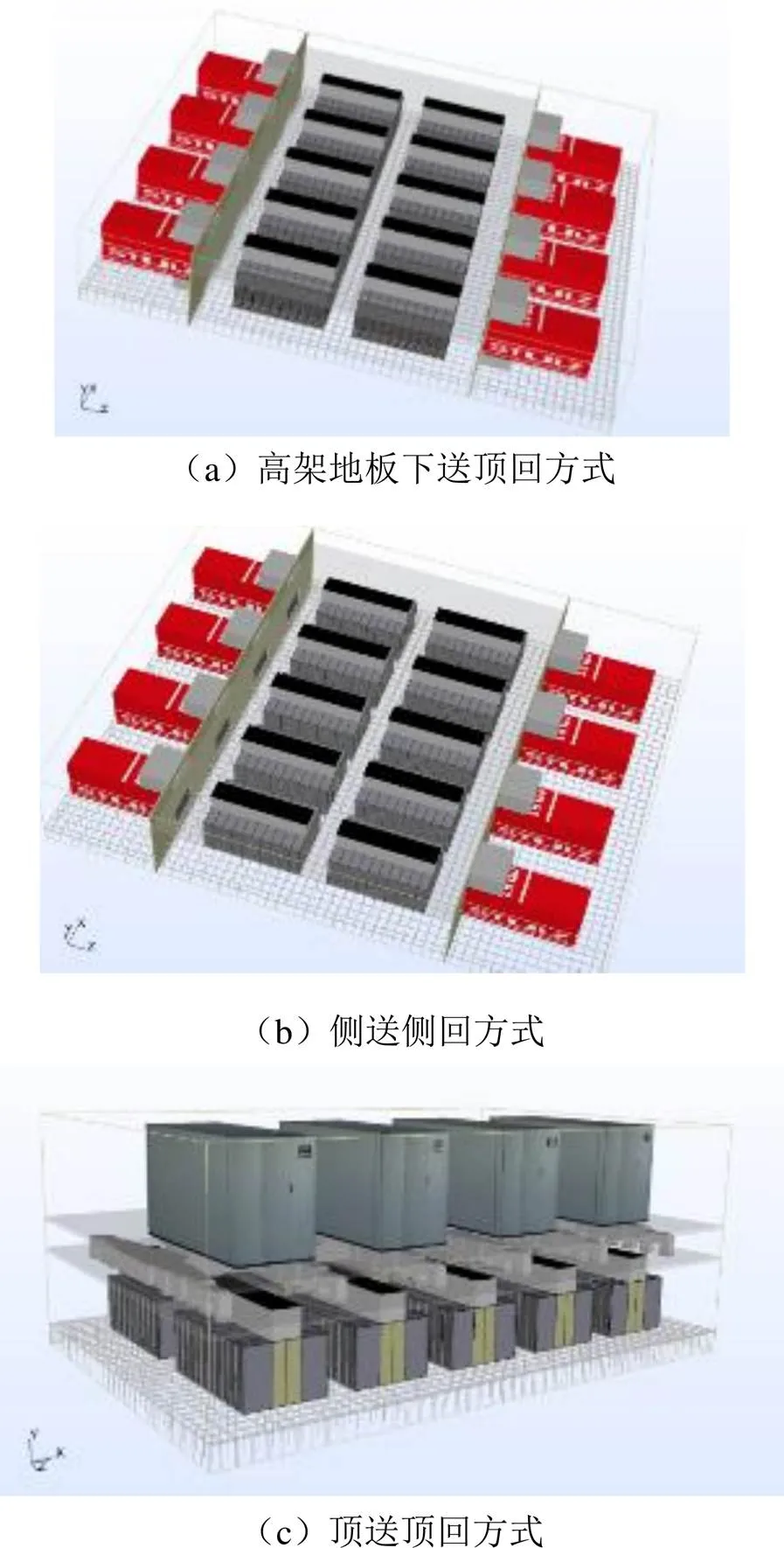

高架地板下送顶回方式将8台空调箱机组放置在数据中心机房的两侧,按照7+1配置;每台机组额定制冷量为100 kW,额定风量为25 000 m3/h。空调机组的出风通过风管接至高架地板下,每个机组接在高架地板下的出风口尺寸为3 320 mm(宽)×1 000 mm(高),气流方向与机柜摆放方向平行,每列机柜正前面布置1块通风地板,地板的开孔率为50%,热通道封闭至吊顶,整个吊顶为回风静压箱,气流自吊顶通过回风管返回至空调箱机组室内侧的回风口。高架地板下送顶回方式空调箱机组及出回风口布置示意图如图2(a)所示。

侧墙送顶回方式将8台空调箱机组放置在数据中心的两侧,按照7+1配置;每台机组额定制冷量及风量与高架地板下送顶回方式一致。每台空调机组的送风通过风管接至侧墙出风,每台机组在侧墙的出风口尺寸为3 320 mm(宽)×1 500 mm(高),开口率为64%。热通道封闭至吊顶,整个吊顶为回风静压箱,气流自吊顶通过回风管返回至空调箱室内侧的回风口。侧墙送顶回方式空调箱机组及出回风口布置示意图如图2(b)所示。

顶送顶回方式将4台空调箱机组放置在数据中心机房的屋顶,按照3+1配置;每台机组额定制冷量为234 kW,额定风量为58 350 m3/h,全部主用机组的总额定冷量及总风量与前两种方式完全一致。每台空调箱机组的送风接入静压主风管后由分支风管接至吊顶下部出风,主风管尺寸为2 500 mm(宽)×800 mm(高),长度为26m,方向为东西走向;长度支管尺寸为1600mm(宽)×800mm(高),长度为7m,方向南北走向;风管中心距楼板700mm,距天花板800mm。出风口尺寸为500mm(长)×500mm(宽),每列服务器的前面平均布置5个,按照全开计算。热通道封闭至吊顶,整个吊顶为回风静压箱,气流自吊顶通过屋面风管返回至屋顶空调箱室内侧的回风口。顶送顶回方式空调箱机组、风管及出风口布置示意图如图2(c)所示。

图2 三种不同气流组织空调箱机组、风管及出回风口布置示意图

2.2 CFD气流模拟

2.2.1 气流组织求解及评价参数

求解计算采用标准的-湍流模型,采用已标定的残差来控制求解方程的收敛精度,模拟时各计算残差曲线都收敛于1,则各参数值趋于稳定。流动的控制方程如下[18]:

通过分析CFD模拟得出的数据中心温度场可以确定服务器的吸风温度,服务器吸风温度是数据中心环境控制的重要技术参数,其决定服务器是否可以正常运行,正常的吸风温度是气流组织优良的先决条件。而流线是指某一时刻在流场中画出的一条空间曲线,流线簇的疏密程度反映了该时刻流场中流速的不同[19],通过分析流场分布可以了解气流是否存在冷热掺混,是否存在紊乱区域,也是判断气流组织正常的重要参数。

2.2.2 机组全开的气流组织分析

间接蒸发冷却空调箱机组主要利用自然冷源及蒸发冷却制冷,所以机组年运行的主要功耗为风机功耗,而风机的功率与风机的转速的立方成正比[20],风机转速降低则风机功耗成立方下降。所以通常数据中心运行时开启所有机组(含备用机组),保持数据中心循环总风量不变,这样风机转速将在低于额定转速下运行,运行功耗下降。为了确保气流模拟贴近实际运行状况,三种不同气流组织均按照所有机组全部运行保持175 000 m3/h的总循环风量不变进行模拟。

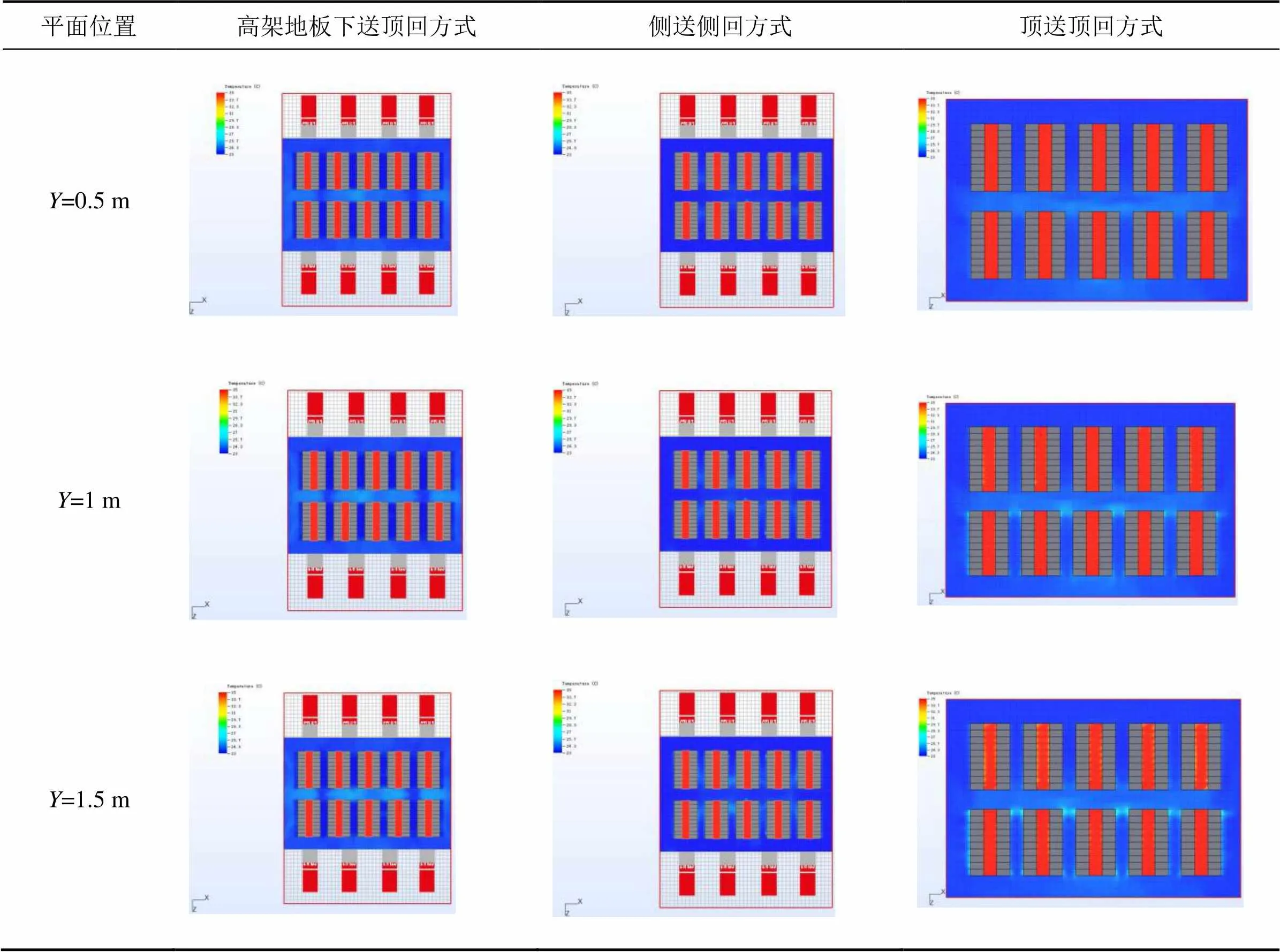

为了准确了解机柜不同高度的进风温度分布情况,每0.5 m的高度上截取平面温度场,机组全开情况下三种送风方式的机房不同高度平面温度场及机房整体流场分别如表1及表2所示。

表1 三种送风方式的数据中心不同高度平面的温度场

续表1 三种送风方式的数据中心不同高度平面的温度场

表2 三种送风方式的机房整体流场

从表1中图面上可以看出,由于无服务器吸风主动引流,1 m以上的机柜三种送风方式均有局部地区温度稍高,但均不超过GB 50174-2017《数据中心设计规范》中服务器吸风冷通道27 ℃的温度限值;而1 m(含)以下机柜的吸风温度均在23 ℃左右,无任何热点。同时,表2中图面也显示,三种送风方式的流场分布均匀,无明显紊流及涡流区域。

上述模拟基于服务器放置在高度为0.8 m以下的机柜下部进行的,为验证将服务器放置在机柜上部,机柜1 m以上的区域是否仍然存在局部热点而影响服务器的吸风温度,将服务器布置在机柜1.5 m以上,重新进行模拟,并且截取2.0 m处的温度场与服务器放置机柜下部中0.5 m高的平面温度场进行对比,温度场对比如表3所示。

从表3中图面上可以看出,两种不同服务器放置方式的典型高度平面上吸风区域的温度场均分布均匀,无局部热点发生,所以服务器在机柜中的放置位置对气流组织的温度场分布没有明显影响,只要确保没有安装服务器的区域加装盲板确保冷热通道完全隔离即可。

表3 不同服务器放置位置三种送风方式典型高度平面的温度场

2.2.3 备用机组不开启的气流组织分析

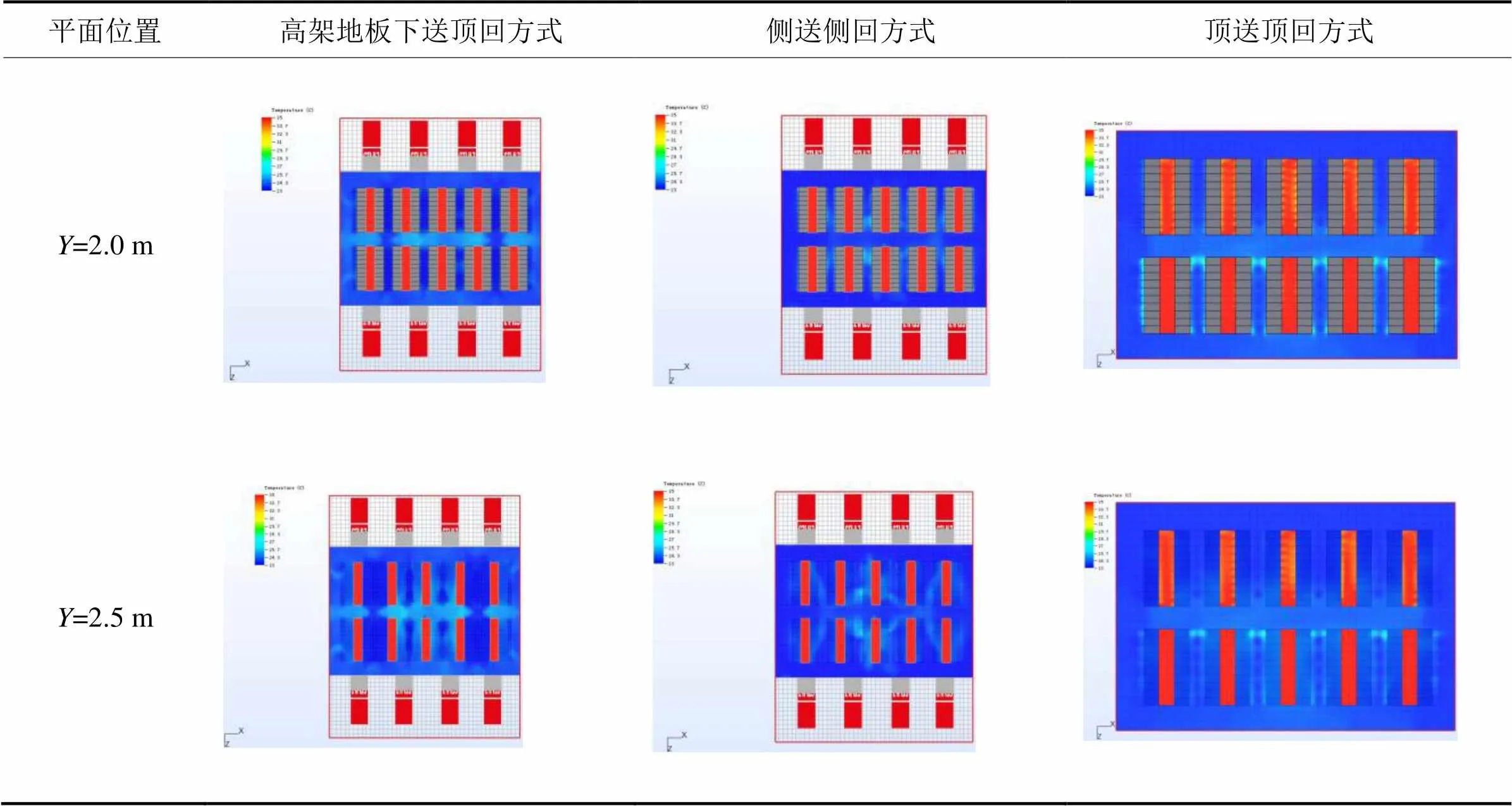

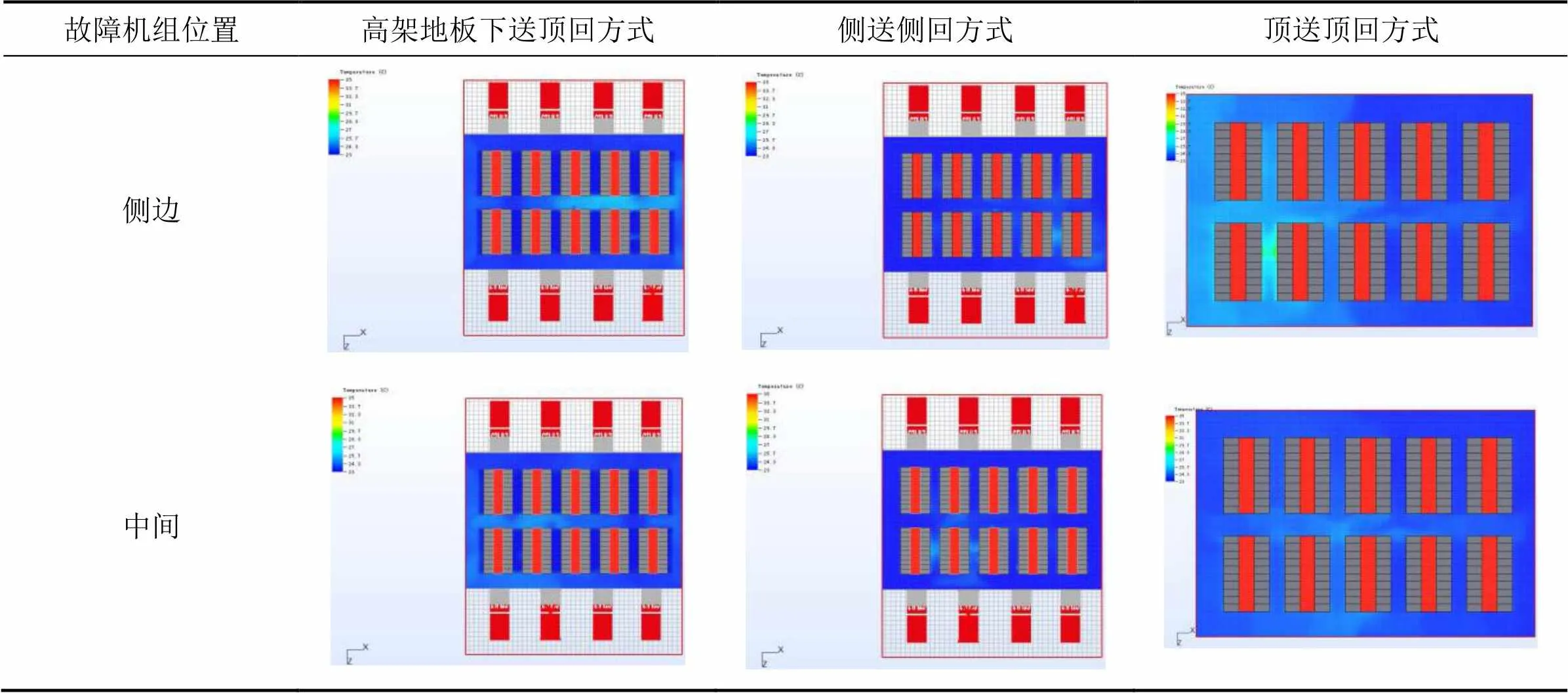

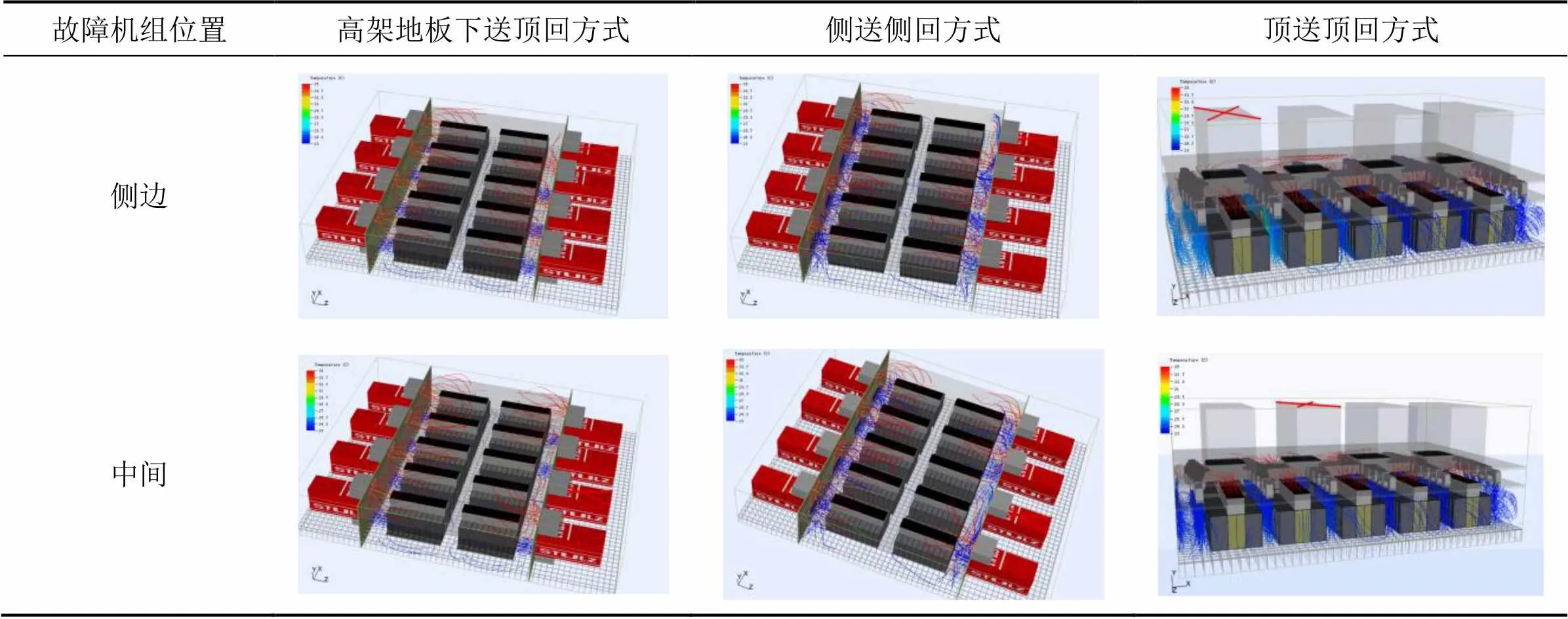

三种送回风方式静压途径分别是高架地板、房间冷池直接静压及风管搭配房间冷池。为了评估三种不同静压的气流组织对于空调机组发生故障的敏感度,了解其运行状况,按照备用空调机组不开启,但保持数据中心总循环风量及制冷量不变对三种不同气流组织重新进行气流模拟。而且为研究故障机组位置对气流的影响,气流模拟按照侧边、中间空调故障分别进行。在备用机组故障,主用机组在额定制冷量及风量工况下运行时机房内0.5 m高的典型平面(服务器位置)温度场及机房整体流场分别如表4及表5所示。

表4 不同位置备用空调箱机组故障时三种送风方式典型高度平面的温度场

表5 不同位置备用空调箱机组故障时三种送风方式的机房整体流场

由表4可以看出,高架地板下送顶回方式,尽管在中间过道部分区域温度稍微升高,但服务器的吸风温度基本没有变化;侧送侧回方式,冷通道部分区域温度升高,但服务器的吸风温度均保持在26 ℃以下,满足GB 50174-2017《数据中心设计规范》中的冷通道18~27 ℃的温度要求。而顶送顶回方式因故障机组的位置差异引起数据中心内部温度场发生明显变化:中间机组故障时,部分过道温度偏高,但是其服务器的吸风温度尚均满足国标要求的冷通道温度要求;而侧边机组故障时,由于故障机组位置以及其与风口布置的相对位置的叠加因素,数据中心局部热点温度达29 ℃,不满足服务器吸风要求。再结合表5中流线图细部分析可以进一步发现:由于故障机组的气流只能单侧补充,侧面机组故障相比于中间机组故障对高架地板下送顶回及顶送顶回的送风方式的流线影响稍大;而因扩散气流路径及服务器排布的综合影响,侧送侧回方式的流场对中间机组故障反而比对侧面机组故障更为敏感,中间机组故障时有两个冷通道的流场受影响且局部温度提高。

3 结论

(1)维持数据中心的总冷量及风量不变,所有间接蒸发冷却空调箱机组全部开启时,三种送风方式均具有良好的温度场及流场。

(2)备用机组故障,主用机组在额定冷量及风量的工况下运行时,高架地板下送顶回、侧送侧回两种方式仍满足冷通道要求,顶送顶回方式局部区域的冷通道不满足国标温度要求。侧面机组故障相比于中间机组故障对高架地板下送顶回及顶送顶回的送风方式的流线影响稍大,而侧送侧回方式的流场对中间机组故障反而比对侧面机组故障更为敏感。

(3)综合不同运行模式下温度场及流场的模拟结果,高架地板下送顶回的气流组织最佳。

[1] 庄叔平.空调箱数字化设计系统的模型分析[D].上海:上海交通大学,2015:1.

[2] GB 14294-2008,组合式空调机组[S].北京:北京标准出版社,2009.

[3] GB 50174-2017,数据中心设计规范[S].北京:中国计划出版社,2017.

[4] 耿志超,黄翔,折建利,等.间接蒸发冷却空调系统在国内外数据中心的应用[J].制冷与空调,2017,31(5):527- 532.

[5] 黄翔,韩正林,宋姣姣,等.蒸发冷却通风空调技术在国内外数据中心的应用[J].制冷技术,2015,35(2):47-53.

[6] 刘凯磊,黄翔,薛运,等.蒸发冷却与机械制冷联合的系统在数据中心的应用初探[J].制冷与空调,2016,16(11): 77-81.

[7] 严翰.气流组织对数据中心空调系统能耗影响的研究[D].上海:上海交通大学,2015.

[8] 叶明哲.数据中心气流选择[C].2012年中国通信能源会议论文集,2012:176-189.

[9] 易伶俐.不同空调送风方式在数据中心的应用[J].制冷与空调,2016,16(3):8-9,7.

[10] 穆正浩,王颖.宁夏中卫云计算数据中心空调设计[J].暖通空调,2016,46(10):23-26.

[11] 耿海波,李建尧,邹成.温和地区数据中心新风自然冷却节能技术探讨[J].暖通空调,2017,47(10):19-25.

[12] 宋姣姣,黄翔,范坤,等.交叉式露点间接蒸发冷却空调机组应用于模拟机房的试验研究[J].流体机械,2014, 42(4):67-71,22.

[13] 工业和信息化部,国家机关事务管理局,国家能源局.关于加强绿色数据中心建设的指导意见[EB/OL].http://www.miit.gov.cn/n1146285/n1146352/n3054355/n3057542/n3057546/c6638560/content.html, 2019-02-12/ 2019-04-02.

[14] 肖新文.间接蒸发冷却机组应用于数据中心的节能分析[J].暖通空调,2019,49(3):67-71.

[15] 李洪珠,段林洁.数据中心封闭冷热通道数值模拟对比分析[J].制冷,2014,33(3):60-64.

[16] 顿喆,秦赟,关欣.基于Fluentairpak的数据中心机房的气流组织模拟优化[J].建筑节能,2015,43(3):27-33.

[17] 周煜康.风墙数据中心气流组织研究及能耗分析[D].西安:西安电子科技大学,2015.

[18] 沈向阳,陈嘉澍,卓献荣,等.数据机房冷区内气流组织的优化[J].流体机械,2014,42(3):71-75,31.

[19] 张雪娇,周军莉,邓勤犁,等.数据中心三种送风方式的对比研究[J].建筑科学,2019,35(2):102-107,115.

[20] 肖新文.液冷与动态自然冷却的综合运用技术探讨[J].制冷与空调,2018,32(6):636-642.

On Airflow Distributions of Data Centers Cooled by Evaporative Cooling Air Handling Units

Xiao Xinwen Wei Zeng Zeng Chunli

( Stulz Air Technology and Service Shanghai Co., Ltd., Shanghai, 201108)

Using 6SigmaRoom simulation software, CFD air distribution simulations of three common air supply and return types in data centers cooled by indirect evaporative cooling air handling units are carried out according to two different operating modes that all the units are running or the standby unit is switched off because of failure. By analyzing the temperature fields and flow fields obtained by the airflow simulations, it is found that all the three types of air distributions have good temperature fields and flow fields when all the units are running, while when the standby unit fails to run, the air distributions of air supply through raised floor tiles and through grilles on the side walls can still meet the temperature requirement of cold aisles, but some areas in cold aisles of air distribution of air supply through duct in the ceiling cannot meet the temperature required by the national code. Taking the temperature fields and flow fields of the three types of air distributions under different operating modes into consideration, the air distribution of air supply through raised floor tiles is the best.

data center; indirect evaporative cooling; air handling unit; CFD simulation; airflow distribution; energy saving

TU831

A

1671-6612(2020)01-062-08

肖新文(1980.8-),男,硕士研究生,工程师,E-mail:xiaoxinwen11@126.com

2019-04-30