局部自主遥操作中的抓取构型识别研究

韩 冬,黄攀峰,齐志刚

(1.西北工业大学航天学院智能机器人研究中心,西安710072;2.西北工业大学航天飞行动力学技术重点实验室,西安710072;3.山西师范大学物理与信息工程学院,临汾041000)

1 引言

随着载人航天技术的不断发展与太空探索的不断深入,航天员的空间作业任务也不断增加,如空间站的在轨维护、空间实验的有效开展以及舱外设备的安装与巡检等。航天员完成这类操作固然效率较高,但代价昂贵且安全性也无法有效保障,采用空间机器人代替航天员完成各种复杂任务成为各国研究的热点[1-2]。目前的空间机器人尚不具备完全自主能力,通过操作者在地面进行遥操作完成复杂作业是当前的主要形式。时延是影响遥操作系统稳定性、透明性的关键因素,空间机器人遥操作面临着大时延与有限带宽问题[3],因此采用操作者给出操作目标,机器人在视觉引导下进行局部自主遥操作成为解决该问题的有效途径[4]。

不同于机器人的自主操作,局部自主遥操作需要人机合作完成任务,因此既需要完成目标的检测与标定为人提供操作依据,又要识别抓取构型为机器人完成抓取任务提供必要条件。抓取构型的选取可分为分析法和经验法[5]。分析法包含力闭合法[6]和形闭合法[7],聚焦于如何稳定的抓住目标,但其无法完成对目标的标定。自2014年后,由于人工智能的发展,经验法迅速发展起来,其中深度学习发展尤为迅速,深度学习方法可以学习大量抓捕经验,从而训练出来一组模型参数,但由于鲁棒性差且需采取离线训练的方法,因此不适合空间机器人遥操作。

针对这些问题,国内外学者提出通过图像识别来实现目标检测与标定并确定抓取构型的方法[8]。皮思远等[9]提出了改进的全卷积深度学习模型用于可抓取物品识别,应用插值方式进行反池化操作,提高了分类结果的准确率。但该方法将特征提取与分类采用了分层方法,特征提取不全面,耗时较长。Saxena等[10]采用降维处理算法,利用二维图像数据信息学习“好的抓取点”与“坏的抓取点”,并通过实验验证该方法的有效性,但由于获得图像信息的非完整性,在实际场合应用比较困难。Rusu等[11]采用视角区域特征直方图法识别抓取构型。Papazov等[12]利用RGB-D传感器在复杂场景下获得物体的三维信息,对抓取区域进行重构。Kumra等[13]利用深度卷积神经网络在RGB-D图片中提取特征,并采用浅卷积神经网络对感兴趣的物体进行抓取构型解算。以上方法由于图像处理网络与识别网络信息不共享,导致其处理速度较慢,在大时延多任务条件下可能造成系统不稳定。

针对上述方法存在的识别目标速度慢、准确性低的问题,本文提出一种基于改进Faster RCNN[14]的目标检测与抓取构型识别方法。为满足识别要求,对抓取构型进行参数化处理,提出最优的五维参数描述。在深度卷积神经网络对目标区域进行特征提取的基础上,通过区域生成网络(Regional Proposal Network,RPN)进行目标检测,利用Anchor法完成抓取构型参数提取,最后通过线性回归与分类网络实现修正,进一步提高目标检测与构型识别的准确性。

2 目标检测与抓取构型估计算法

2.1 抓取构型参数化

为实现目标的成功抓取,需要估计出目标位姿并转换为机械臂末端的抓取构型。不失一般性,设计抓取位置为物体顶部,因此可以简化Jiang等[15]的七维参数抓取构型方法,采用五维参数描述,具体如图1所示。该图可以表示抓取构型在图像中的位置和机械臂末端夹持器的状态,绿色边框代表夹持器二指的位置,并且二指与绿边平行,蓝色边长度代表夹持器张开的长度,蓝边与水平方向的夹角代表夹持器旋转的角度,矩形框的中心为夹持器抓取的位置,本文用g表示机器人成功抓取物体的抓取构型参数,表达式见式(1)。

式中(x,y)代表抓取构型的中心位置,(w,h)分别代表抓取构型的宽和高,θ代表矩形框相对于水平方向旋转的角度,设定顺时针旋转为负,逆时针旋转为正,由于方向的对称性,抓取角度区间取 [-90°,90°]。

为了使目标抓取具备更强的鲁棒性,将抓取角度参数θ的取值分为20种,因夹持器为二指构型,因此其旋转正负90°后构型相同,每个抓取角对应的区间如表1所示。

图1 抓取构型示意图Fig.1 Schematic diagram of grasp configuration

表1 抓取角度对应区间Table 1 Corresponding regions of grasp angle

2.2 目标检测与抓取构型估计

目标检测是在图像中检测并识别目标,从而为操作者提供指示并确定机械臂末端抓取构型。本文在Faster R-CNN的基础上,利用RPN对目标进行识别,通过滑动窗口和Anchor机制先确定抓取构型的(x,y,w,h)参数,然后将对应的区域特征输入到全连接层,得到的目标识别结果输出到线性回归网络和分类网络,线性回归网络进一步对抓取构型进行修正,提高抓取构型的精度。分类网络根据抓取区域特征确定抓取构型参数θ的大小,确定抓取角度。

本算法的神经网络框架如图2所示,该框架是由3部分组成:第1部分完成图像特征提取,第2部分实现抓取构型中与目标位姿相关参数的识别,第3部分对参数进行修正并确定抓取角度。

图2 抓取构型识别算法流程图Fig.2 Flow chart of recognition algorithm for grasp configuration

第1部分是由特征提取网络构成,采用经典的VGG16网络[16],该网络是 Image Net ILSVRC 2014竞赛模型,其网络层比常用网络结构扩展了2倍,对特征提取更加丰富,为后期的目标检测和抓取构型估计提供输入。该部分与Faster R-CNN算法所采用的特征提取网络一致,首先输入高为H、宽为W像素的图像,然后采用VGG16神经网络架构进行特征提取,得到的特征图像高宽分别为H/16、W/16。 在卷积层,采用卷积核为3×3,步长为1,填充(Padding)参数为补零(SAME)的卷积方式,输出特征图。

第2部分是由RPN网络组成,该部分采用上一部分输出的特征图,通过Anchor方法检测到目标,识别目标位姿,并用修正边界框标识,网络输出修正边界框与抓取概率。

第3部分完成抓取构型识别,通过将修正边界框的特征值输入到全连接层,然后分别输出抓取构型对应20种角度的抓取概率。

2.2.1 生成修正边界框

1)特征提取。通过512通道,3×3卷积核将特征提取后得到的特征图像进行卷积,输出为(512,H/16,W/16)大小的特征图像,再通过 2 个并行的1×1卷积核进行卷积,通道数分别为18和36。输出特征图像保持高、宽不变。

2)参考边界框提取。以特征图像的每个像素为中心,按不同尺度和长宽比产生矩形框,由于夹持器张开角度限制,尺度选取应适当。为满足识别出不同尺度不同形状的目标,选取尺度为[2,4,8],长宽比采用[1 ∶2,1 ∶1,2 ∶1]的 3 种比率,共9个区域。由于尺度选取对应的是特征图像,实际操作中需把参考边界框映射到原始图像,考虑到基础尺度为16,因此映射到原始图像后,每个参考边界框的尺度为[322,642,1282],每个尺度对应的长宽比率如图3所示。

图3 特征图与参考边界框Fig.3 Feature maps and bounding boxes with reference

为了解决参考边界框重叠问题,采用了非极大值抑制(Non-maximum suppression)方法,通过利用不同的尺寸和比例将产生的所有参考候选框与已标定的真实抓取构型进行比较,把与标定抓取构型的交并比(Io U)大于设定阈值的边界框定义为参考边界框,交并比的计算方法见式(2)。

式中,A∩G代表真实抓取构型与预测抓取构型面积的交集,A∪G代表真实抓取构型与预测抓取构型面积的并集,如图4所示。

3)RPN网络回归。由卷积核(36,1,1)卷积得到(36,H/16,W/16)预测偏移值,其中每一个位置对应36通道,每4个通道的数值对应每个参考边界框的中心位置(x,y)和高宽(H,W)的偏移值,由于每个位置对应9个参考边界框,因此每个位置有36通道,分别对应9个参考边界框的偏移值,然后通过Reshape函数将预测偏移值转换成为(9×H/16×W/16,4)结构的边界框偏移值。

图4 交并比示意图Fig.4 Schematic diagram of Io U

4)修正边界框生成。将生成为(9×H/16×W/16,4)的边界框偏移值与参考边界框相加,即可得到修正边界框。考虑到抓取构型与目标姿态有关,为了使修正边界框满足抓取要求,采用2次线性回归方法, A=(Ax,Ay,Aw,Ah) 代表 Anchor的中心位置与长宽参数, G=(Gx,Gy,Gw,Gh) 代表目标在图像中的真实区域, G′=(G′x,G′y,G′w,G′h)代表经过线性回归所得到的区域,可得G′≈G。根据泰勒展开定理,当Anchor区域与目标真实区域相距较近时,两者的关系可近似表示为线性关系,该线性关系可表示为式(3):

式中,φ(A)为特征向量,w为待学习的权重参数, d(A)= [dx(A),dy(A),dw(A),dh(A)]为线性关系表达式,具体表示为式(4):

为了使回归后的区域值与真实区域值偏差最小,设计修正网络损失函数为式(5):

式中, t= [tx,ty,tw,th], 各分量表示为式(6):

修正边界框到抓取构型的回归过程如图5所示。其中红色为修正边界框,蓝色为对修正边界框线性回归后的结果,在对其进行角度修正后,可获得目标的抓取构型。

图5 修正边界框线性回归过程Fig.5 Linear regression of bounding boxes with revise

5)修正边界框筛选。舍去超出图像的修正边界框和长宽比太小的修正边界框;根据每个修正边界框的抓取分数,选取前6000个高分数修正边界框;利用非最大值抑制(Non-Maximum Suppression)方法,从6000个修正边界框中选出300个修正边界框。

2.2.2 生成边界框抓取概率

1)将RPN网络生成的特征图通过二分类网络由卷积核(18,1,1)卷积得到(18, H/16,W/16)结构的特征图,由于每一个位置对应9个候选边界框,因此其通过卷积得到的18通道分别对应每个候选边界框的可抓取分数和不可抓取分数。

2)将得到每个区域的得分通过非线性映射函数Softmax映射到[0,1]区间,得到每个候选边界框可抓取概率和不可抓取概率,然后得到每个修正边界框的抓取概率。

2.2.3 生成抓取构型参数

将2.2.1节步骤5中筛选出来的300个修正边界框进行区域池化(RoI Pooling)处理,生成固定大小为(7,7,512)的特征值,输入到全连接层,预测出每个修正边界框对应每个抓取角度的概率,同时对位置和大小进一步进行修正,最后得到抓取构型参数。

2.2.4 设计损失函数

考虑到抓取任务的需求,按照多任务要求设计最小化损失函数,如式(7)所示。

式中,g代表参考抓取构型的可抓取分数,a代表旋转角度类别,t代表参考抓取构型线性回归参数,当修正边界框与标定的真实抓取构型交并比超过设定阈值时,值取1,否则值取0,为预测抓取构型参数A与真实抓取构型参数G的差值,λ1、λ2为平衡参数,Lgrp,Lang采用Softmax损失函数,Lreg采用L1损失函数。采用L1损失函数,可以有效的使训练模型收敛,提高训练效率[17]。

3 神经网络模型训练

神经网络模型训练采用了随机梯度下降法,在损失函数收敛后,完成神经网络模型训练。

3.1 模型训练

在训练模型过程中,训练数据的准备、超参数的选取对训练的模型至关重要,其对训练模型的精度和鲁棒性起决定性作用。

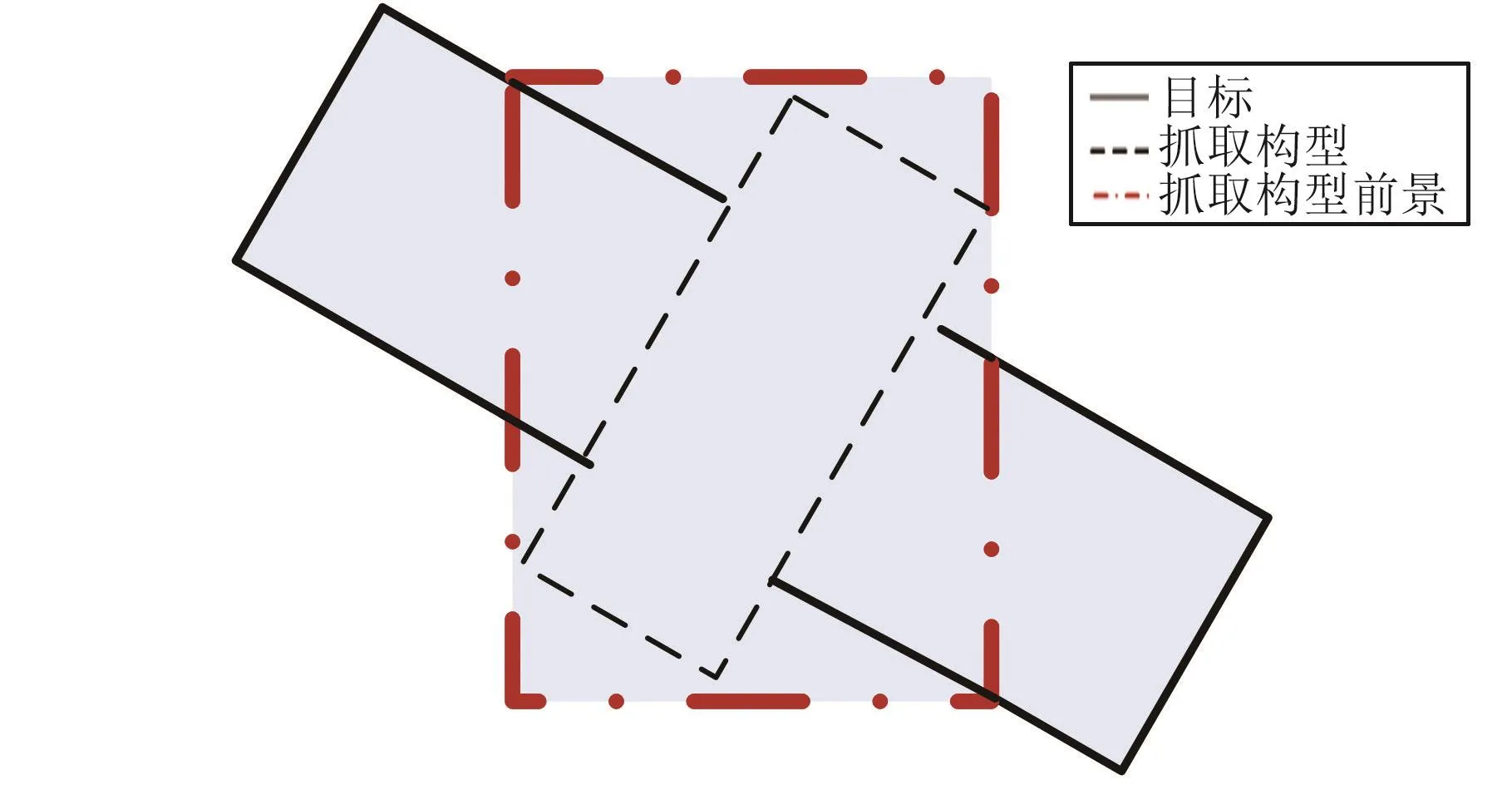

首先读取Cornell Grasp Detection数据集的pcdxxxxcpos.txt文件,根据每4行数据,计算标注的抓取构型参数,利用前2行位置坐标计算抓取构型参数(h,θ),其中h为两点之间的距离,θ为两点直线与水平线之间的夹角,利用表1找到对应区间的代表角度,并将标注抓取构型标记为对应类型θ,最后根据位置坐标计算出抓取构型的中心位置(x,y)。 为提供较多的特征数据和训练数据的鲁棒性,把覆盖标注的抓取构型最小区域设置为前景,称其为“抓取构型前景”,前景区域如图6所示,其中实线矩形代表抓取物体,虚线矩形代表标注抓取构型,点画线矩形代表“抓取构型前景”。采用标注抓取构型参数与预测候选框的参数差值进行线性回归,将与前景区域交并比大于0.7的预测候选框设置为正样本,小于0.3的预测候选框设置为负样本,其他情况的舍去,不参与模型训练。通过筛选,每张图片中的正负样本总共个数为256个。

将原始图像根据缩放比例k进行放大,其中k值计算方法见式(8),将图像去中心化,即每个像素3通道值减去[102,115,122],得到去中心化的图像数据作为训练样本,为提高训练出来模型的鲁棒性,通过水平翻转的方法将训练数据量扩展到1倍。

图6 前景区域示意图Fig.6 Schematic diagram of foreground region

在训练模型时,采用整体训练的方法,同时利用ImageNet训练好的参数进行初始化网络参数。Epochs参数为1000,学习率为 0.001,Weight Decay参数设置为0.0001,Minibatch参数选择为1,即每一张图片作为一个Batch进行训练;在将RoI区域向全连接层输入特征时,采用的固定尺寸为(7,7),并在训练时,全连接层失活率(Dropout)采用0.5。

经过 Fine-Tuning训练后,通过 Tensorboard得到的损失函数收敛过程如图7所示,从结果可知,损失函数收敛。

图7 损失函数收敛过程Fig.7 Convergence process of loss function

3.2 模型测试

将训练得到模型用于测试,测试时每张图片得到300个抓取构型,每个构型对应20种类别得分,即20种角度得分,每种类别对应4个抓取构型修正参数[tx,ty,tw,th]。 把每个构型最高分对应的类别作为构型抓取角度,通过采用非极大值抑制方法得到若干个抓取构型,经过排序后,把最高得分的构型视为抓取构型。若检测得抓取构型与标注的抓取构型交并比大于设定阈值,则视为抓取构型检测成功。

4 测试结果

4.1 网络识别测试

对多目标抓取构型检测结果如图 8所示。每个目标标识前3个概率最大的抓取构型,其中绿色边框为夹持器的两指所在位置,红色边框长度为夹持器张开宽度,红色边框与水平线的夹角为抓取构型相对于水平面旋转角度,每个抓取构型标有序号,序号越小代表预测的抓取构型概率越高,即抓取物体成功率越高。

图8 多目标抓取构型检测结果示意图Fig.8 Grasp configuration detection of multiple objects

利用Cornell Grasp Detection测试数据对训练得到的模型进行测试,测试集共有图片1034张,统一像素为640×480,训练文件为9个,测试文件为1个,神经网络训练框架为tensorflow,GPU为GTX2080Ti。相同测试条件下,与4种已有识别方法准确率比较如表2所示。Jiang等[15]改进抓取点检测为抓取矩形区域检测并提出搜索空间分割算法,提高了检测速度,但由于空间的分割使得特征提取不完整,因此降低了检测准确率。Lenz等[18]为解决多目标检测问题,提出了二阶级联网络方法,特征提取通过多级网络完成,提高了检测速度,但初级特征提取选择了浅层网络,导致准确率较低。针对单个目标的多边界框选取问题,Redmon等[19]提出了局部预测方法,对多边界框给出了抓捕成功率的预测值,提高了抓捕成功率,但其采用了单次回归方法,导致边界框的修正不够精确。Guo等[20]采用了深度卷积网络对抓捕构型进行识别,并建立了具有触觉传感器的机器人实验平台,证实了抓捕构型识别的准确性。

表2 识别准确率比较Table 2 Comparison of recognition accuracy

改进区域卷积网络算法采用级联深度卷积网络,由表2可知,本文提出的算法识别准确率高于其他方法,识别准确率为96.4%,这源于算法在以下3方面的改进:

1)采用VGG16深层网络进行特征提取,比常用的网络结构扩展了2倍,其他几种算法采用6层浅层网络进行特征提取,本文算法提取特征信息更加丰富,与其他算法相比具有一定的优越性;

2)采用2次线性回归的方法对抓取构型进行修正,在有限时间增加的条件下,显著提高了识别准确率;

3)优化了特征区域选取方法,将覆盖抓取构型的最小矩形区域设为前景进行学习,这样可以更加充分的学习抓取构型区域特征,提高识别准确率。

在抓取构型识别的同时,为给操作者提供必要的指示信息,算法会将抓取构型进行编号,并提供不同构型抓取成功概率,操作者可以根据信息辅助操作与决策。标记结果如图9所示,其中图片上方标注16组数据,每组数据对应图片中每个抓取构型参数,由竖线分隔。第1列代表抓取构型标号,其与检测候选框标号一一对应;第2列代表抓取构型相对于水平面旋转角度;第3列代表对应抓取构型的抓取成功概率,根据抓取成功概率的不同,选择适当的抓取构型以及抓取位置。

4.2 实验平台测试

为验证算法的有效性与准确性,设计了机器人试验平台,该平台由包含二指结构夹持器的ABB14000机器人以及图像获取设备Kinect构成,Kinect可以准确检测目标的深度信息,如图10所示。图像信息由的Kinect传感器采集,通过网络传输到机器人中控计算机进行处理,在识别出抓捕构型后,机械臂按参数(x,y)运动到目标上方,通过机器人末端关节旋转来调整夹持角度θ,夹持器张开长度由参数w给出,机械臂根据深度信息向下运动h距离。

图9 复杂几何体抓取构型检测结果示意图Fig.9 Grasp configuration detection of complicated geometrical bodies

图10 算法验证试验平台Fig.10 Fabricated setup for verification experiments

图11 展示了试验过程的4个阶段,分别为机械臂水平运动到抓取位置上方,旋转机械臂末端关节角并张开夹持器,垂直运动到目标物体上方并完成夹持,转移物体到放置盒内。通过机械臂夹持物体试验验证了本文算法对抓取构型识别的准确性。

5 结论

图11 验证试验4个阶段Fig.11 Four snapshots of the verification experiment

本文针对局部自主遥操作过程中识别目标速度慢、准确率低的问题,提出了一种基于改进快速区域卷积神经网络(faster R-CNN)的抓取构型识别方法。该算法采用VGG16深度卷积神经网络对图像进行特征提取,2次线性回归的方法进行修正,并改进了前景特征区域的选取,使抓取构型更加精确,进一步提高识别的准确率。考虑到末端夹持器的特点,提出了复合损失函数,提高了训练效率。通过Cornell Grasp Detection测试数据对训练得到的模型进行测试,算法识别准确率测试结果为96.4%,性能优于同类相关算法。机器人试验平台测试结果表明,在简单场景下,通过该方法可以完成机器人对目标的抓取任务。