一种多光谱遥感影像与航拍影像融合算法

李小军,闫浩文,杨树文,牛丽峰

(1.兰州交通大学 测绘与地理信息学院,兰州 730070;2.甘肃省地理国情监测工程实验室,兰州 730070)

0 引言

无人机技术的快速发展,使得无人机遥感影像的获取更加快捷和方便。无人机航拍简便快捷,空域要求低,时效性更好,在工业和军事领域均得到了广泛应用[1]。由于无人机一般在云层以下飞行,获取的遥感影像分辨率更高,受遮挡影响更小。但小型无人机受载重限制,一般获取的航拍影像缺乏多光谱信息,影响了后续遥感影像光谱分析与解译。为此,需要采用多光谱融合技术,提高无人机航拍影像的光谱分辨率。

过去的20年间,多分辨率分析的融合方法作为有效解决多光谱融合问题的主要手段之一获得了大量学者的关注。多分辨率分析方法主要通过多分辨率分解提取高分辨影像的空间纹理细节信息,将其注入到低分辨多光谱影像中,获取兼有空间分辨率和光谱分辨率的融合影像。空间细节信息的提取,主要包含降采样小波变换[2]、非抽样小波方法[3]、孔小波变换[4-5]、拉普拉斯金字塔方法[6]、轮廓波方法[7]、和曲小波方法[8]等。多分辨率分析方法在计算注射权重时,一般采用全局或局部的统计方法。其中,采用局部的统计方法明显优于全局的统计方法。但在对局部进行聚类统计时,学者大多采用固定的矩形框,而没有考虑像素间的相关性,这将导致注入信息增益的方块效应,特别是高分影像的边缘更易出现光谱扭曲。另外,由于多光谱影像和航片影像分辨率差异较大,单次的融合处理也难以直接对其进行融合。

为此,本文提出了一种基于脉冲耦合神经网络(pulse-coupled neural network,PCNN)的遥感卫星多光谱影像与无人机航拍影像融合算法。该算法通过二次融合方案逐级提高多光谱影像的分辨率,同时在融合中利用PCNN符合人眼视觉特性的非规则区域分割特性进行注射权重的计算,最后将细节信息注入到多光谱影像获得融合影像。实验结果表明,本方法在较好保持无人机遥感影像亚米级分辨率同时,获得了多光谱影像的光谱信息。

1 PCNN遥感影像分割

PCNN最初是基于哺乳动物视觉皮层神经元脉冲发放现象建立的,它对图像的理解符合人眼视觉特性。标准PCNN是一种由脉冲耦合神经元横向连接的反馈网络。每个神经元由3个部分组成,分别为接收输入域、连接调制域及脉冲产生域[9]。其数学描述如下:

(1)

(2)

Uij[n]=Fij[n]1+βLij[n]

(3)

(4)

Eij[n+1]=e-αEEij[n]+VEYij[n]

(5)

PCNN模型应用于遥感影像处理时,一个像素就是一个神经元(i,j),(k,l)是(i,j)邻域神经元。I为输入的遥感影像。参数αF、αL和αE是时间常量,VF、VL和VE为标准化常量,β为连接权重,F和L分别为反馈输入和连接输入。当内部活动项U大于活动阈值E时,神经元在当前迭代n被激发,产生输出脉冲Y。

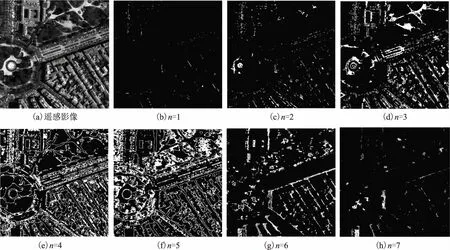

遥感影像融合中,主要利用PCNN的分割特性。在这里,如果神经元在第n次迭代中被激发,则将活动阈值E相应设为无穷大,以保证每个神经元属于唯一的分割区域。利用PCNN进行遥感影像分割的部分分割结果如图1所示,其中图1(a)为原始输入遥感图像,图1(b)~图1(h)为不同迭代n下的分割结果。通过PCNN分割,整个遥感影像被分割为具有一定相关性的非规则区域。如图2(a)所示为传统进行局部注射权重统计所采用的矩形区域统计方法,本文采用的非规则统计区域如图2(b)和图2(c)所示。显而易见,非规则统计区域更容易统计到具有相似特征和邻域关系的相关像素特征。

图1 PCNN遥感影像分割示例

2 多光谱影像与无人机航拍影像融合算法

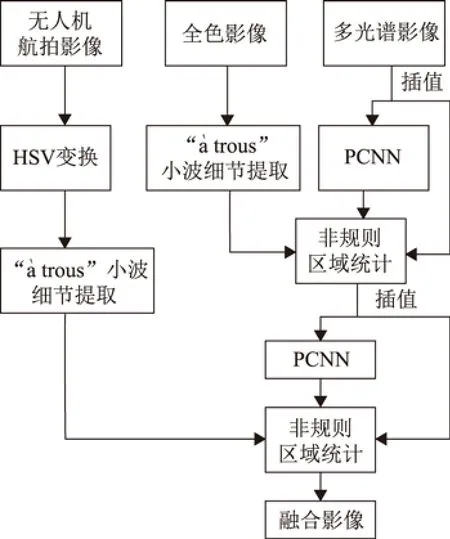

本文提出的卫星多光谱影像和无人机航拍影像融合算法如图3所示。算法具体执行步骤如下:

图3 本文算法流程示意图

①对多光谱遥感影像采用三次非线性插值到全色分辨率,得到全色尺寸多光谱影像Imsk,其中k表示多光谱影像不同的光谱通道,K为光谱通道总数;

②对全色影像执行“trous”小波分解,提取全色影像细节Psd[4];

③对多光谱影像执行PCNN神经网络,将其分割为非规则区域,进行统计特征计算,并通过公式(6)计算增益权重Gk1;

④对全色分辨率的多光谱影像继续进行PCNN处理,获得Y矩阵,并利用公式(6)计算增益权重Gk2;

⑤对航拍影像执行HSV颜色空间变换,对其中的V分量执行“à trous”小波分解,提取航拍影像细节Pud;

⑥根据公式(7)计算获得具有航片亚米级分辨率的多光谱影像Ismsk。

(6)

Ismsk=Imsk+Gk1×Psd+Gk2×Pud, k=1,…,K

(7)

3 实验结果分析及评价

3.1 实验数据源

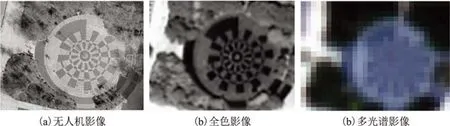

用于实验的无人机影像数据,是课题组采用八旋翼无人机携带航拍相机于2017年11月25日于兰州交通大学八教广场拍摄,采用的无人机如图4所示,拍摄的八教广场航拍影像如图5(a)所示。无人机航拍影像的分辨率为0.2 m。多光谱和全色影像采集于高分二号遥感卫星于2017年8月4日的成像结果。多光谱图像具有蓝色、绿色、红色和近红外4个波段。多光谱影像的分辨率为3.5 m,全色影像的分辨率为0.875 m。相应的八教广场全色影像和多光谱影像分别如图5(b)和图5(c)所示。

图4 航拍无人机

图5 遥感原始影像数据

3.2 PCNN参数设置

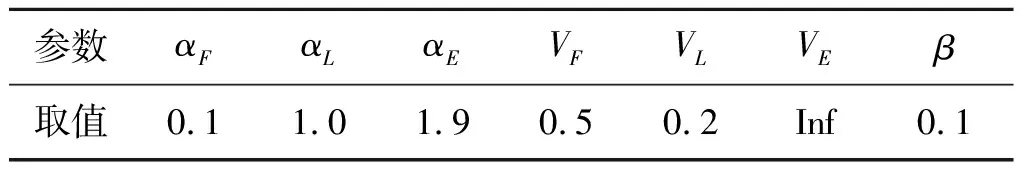

PCNN参数设置中除了αE参数采用1.9,VE设置为无穷大值,其他PCNN参数均采用经典值[10]。其中,输入遥感影像I归一化到0~1之间。迭代次数初始值n=1。F=YF=YU=0,E=1。连接权重矩阵W和M为[0.5,1,0.5;1,0,1;0.5,1,0.5]。其余参数如表1所示。

表1 PCNN模型参数设置值

3.3 融合质量评价标准

实验主要采用通用的遥感影像融合评价指标进行定量评价,主要包括光谱扭曲度、空间信息失真度、光谱映射角和融合质量评价索引4个指标[11]。其中,光谱扭曲度是对融合后的遥感影像光谱失真的描述,其值越小融合效果越好;空间信息失真度描述融合影像与原始高分辨率影像纹理细节的相似性,同样值越小融合效果越好;光谱映射角通过计算融合影像与多光谱影像的差异角来获得光谱扭曲程度,其值越小融合效果越好;融合质量评价索引是对融合影像光谱扭曲和空间细节保持的综合评价,值越大融合质量越好,融合质量评价索引的最大值为1。公式(8)~公式(11)分别给出了4种指标的数学描述[11]。其中,Dλ表示光谱扭曲度、Ds表示空间信息失真度、SAM表示光谱映射角、QR表示融合质量评价索引。

(8)

(9)

(10)

QR=(1-Dλ)α(1-Ds)β

(11)

3.4 对比实验

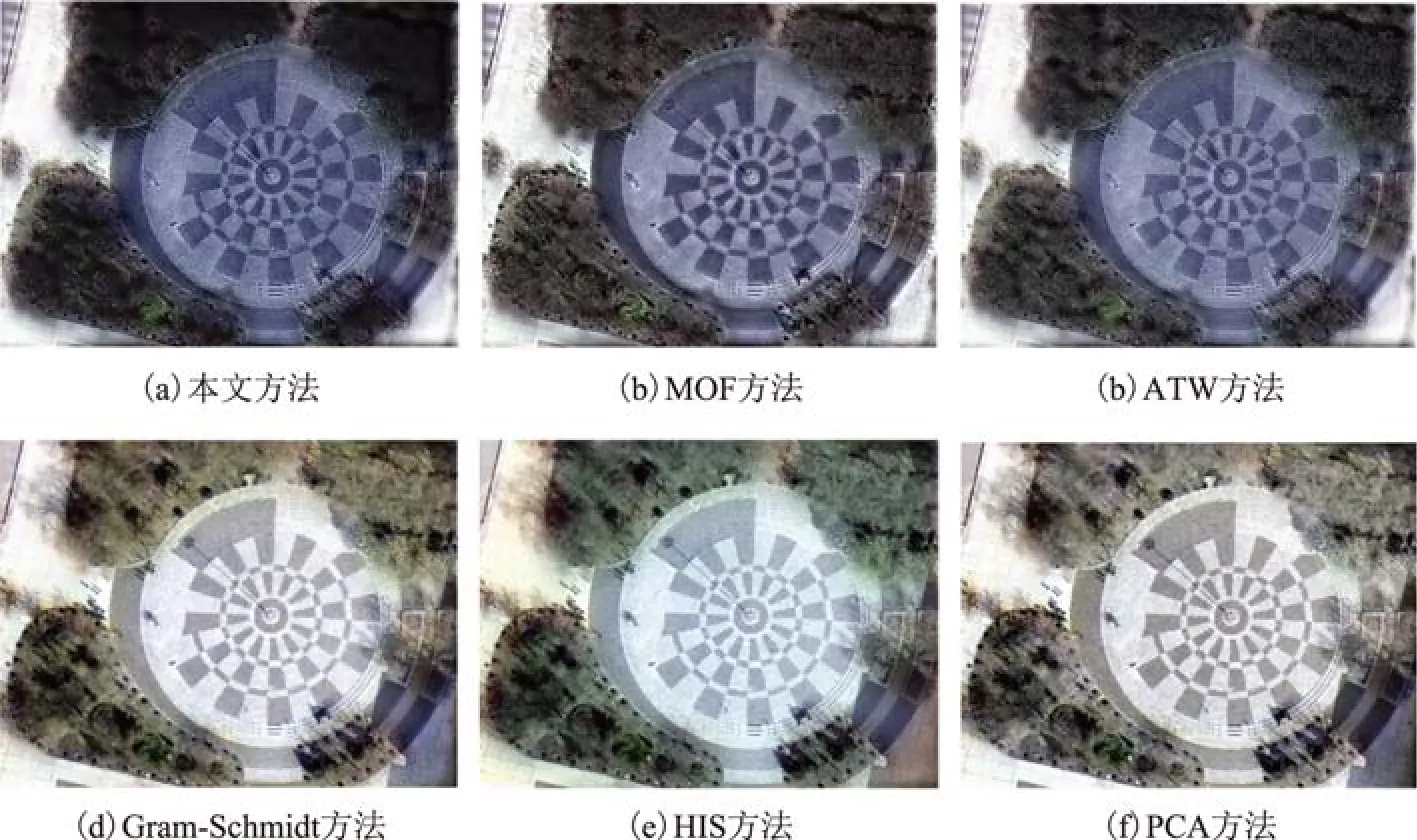

为了评价本文算法的有效性,本节将本文算法与其他5种方法做了对比实验。包括基于形态学算子的融合算法(morphological operators based fusion method,MOF)[12]、基于小波分解的融合算法(additive à trous wavelet transform with unitary injection model,ATWT)[4]、GS(gram-schmidt)变换融合方法[13]、IHS分解的融合方法[14]及主成分分析(principal component analysis,PCA)融合方法[15]。对比算法中均采用2次融合的方法,即先将全色影像与多光谱影像融合,再将融合结果与无人机航片影像融合。图6(a)为本文算法融合结果,图6(b)~图6(f)分别为对比算法融合结果。从主观上观察发现,相比图5原始遥感影像,本文方法、MOF方法和ATWT方法光谱保持较好,纹理细节也获得了较大提升,而Gram-Schmidt变换方法、IHS融合方法和PCA融合方法在纹理细节上得到了较好提升,但它们的光谱信息均发生较大扭曲,特别是大理石地面和广场均出现不同程度的其他波段光谱成分,树木的光谱也出现了较大失真。

图6 对比结果图

对几种方法的融合定量指标分析见表2所示。由表2可见,本文方法的融合结果在光谱扭曲度、空间信息失真度、光谱映射角和融合质量评价索引等4个指标均优于其他方法。因此,本文融合方法所得的融合影像光谱失真更少、空间纹理信息更加丰富,验证了本文卫星多光谱遥感影像与无人机航拍影像融合算法的有效性。

表2 定量对比评价结果

4 结束语

针对无人机航拍影像缺乏多光谱信息问题,提出了一种基于PCNN模型的卫星遥感多光谱影像与无人机航拍高分影像的融合算法。由于PCNN模型符合人眼视觉特性,将其引入遥感影像融合,获得的融合影像光谱扭曲更小,空间纹理细节保持更好。通过采用高分二号遥感影像和无人机影像融合的对比实验,验证了本文方法的有效性。