融合全局和局部方向特征的掌纹识别方法

陈晓蔓,贾 伟,李书杰,刘晓平

融合全局和局部方向特征的掌纹识别方法

陈晓蔓,贾 伟,李书杰,刘晓平

(合肥工业大学计算机与信息学院,安徽 合肥 230009)

掌纹识别是受到较多关注的生物特征识别技术之一。在各类掌纹识别的方法中,基于方向特征的方法取得了很好的效果。为了进一步提升识别精度,提出一种融合全局和局部方向特征的掌纹识别算法,主要融合了基于方向编码的方法、基于方向特征局部描述子的方法和结合方向特征和相关滤波器的方法。其中前2种方法属于空间域方法,可很好地提取掌纹的局部方向特征;而第3种方法属于频域方法,能有效地提取全局方向特征。在匹配值层对该3种方法的识别结果进行融合。本文算法在2个掌纹数据库上进行了验证,实验结果表明,本文方法的识别性能明显优于其他几种掌纹识别方法。

生物特征识别;掌纹识别;方向特征;信息融合;匹配值层融合

随着整个社会进一步的网络化和数字化,越来越多的场合需要对人的真实身份进行有效鉴别。而生物特征识别技术(biometrics)是最为有效的身份鉴别解决方案之一。所谓生物特征识别技术是利用人体本身所固有的物理或行为特征,通过图像处理和模式识别等方法鉴别个人身份的技术[1],与传统的基于密码或ID卡的身份鉴别方式相比,具有可随身携带、不易伪造且不用记忆等特点,因此有更好的方便性、安全性、可靠性和有效性。近些年来该技术受到较多关注,目前,面向民用的身份鉴别,主要使用低分辨率掌纹识别技术[2-9]。低分辨率掌纹识别主要是指分辨率介于75~150 dpi的图像,其特征包括掌线、纹理和纹线的方向等。低分辨率掌纹识别技术主要的优点包括:①高判别性,掌纹具有丰富的特征,该系统精度高,即使是双胞胎,也很容易进行区分;②特征稳定,由于手掌近似一个平面,特征变异相对较小,具有较好的稳定性;③感兴趣区域(region of interest,ROI)容易定位,通过手指连接区域很容易定位参考点,从而切取出ROI;④图像质量高,使用普通的采集设备或智能手机等均可方便地采集到高质量的掌纹图像。

针对低分辨率掌纹识别,许多学者如ZHONG等[2]、ZHANG等[3]、KONG等[6]、FEI等[8]分别对各具特色的掌纹识别算法进行了综述总结。低分辨率掌纹识别算法可大致分为:基于线特征的方法、子空间学习的方法、方向编码的方法、相关滤波器的方法、纹理的方法、局部描述子的方法和基于深度学习的方法等。

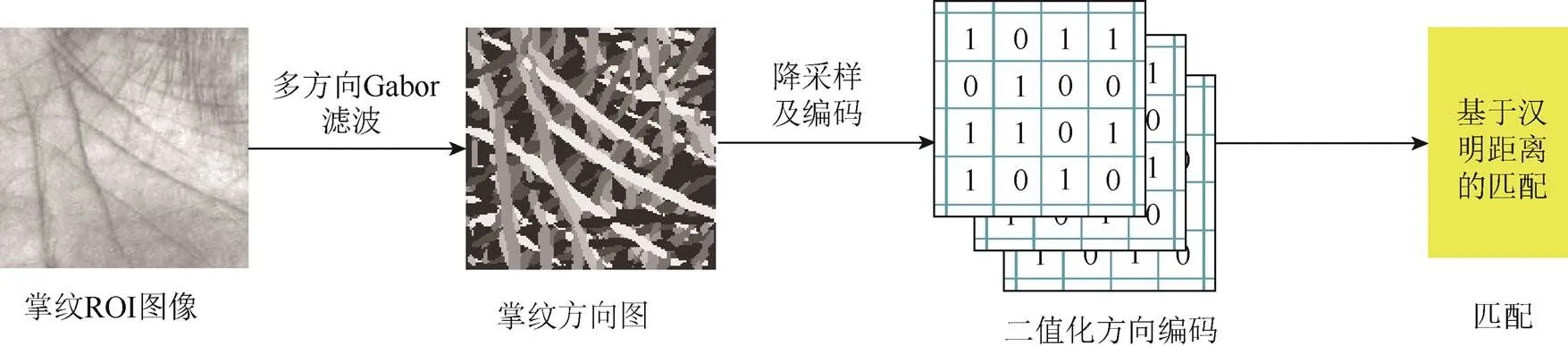

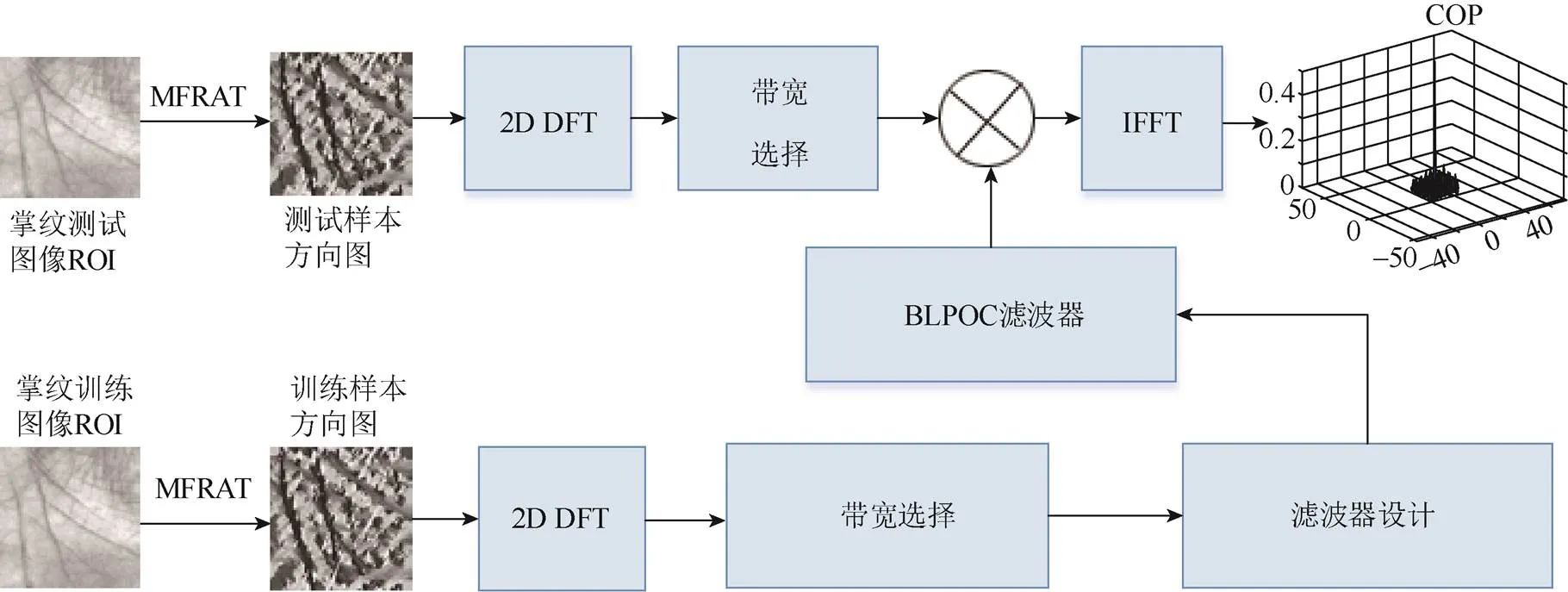

在掌纹的各类特征中,方向特征是最为重要的特征之一,主要因为掌纹包含主线和褶皱线,其具有明显的方向,对于光照、小的畸变等变异具有较好的鲁棒性,因此取得了很好的识别效果,已经成为掌纹识别领域最为重要的方法之一。基于方向特征的方法有3种子类型,分别是基于方向编码的方法、基于方向特征的局部描述子方法、结合方向特征和相关滤波器的识别方法。其中,前2种方法属于空间域方法,而结合方向特征和相关滤波器的方法则是频域方法。经典的基于方向编码的方法主要有competitive code (CompC)[10],sparse multi-scale competitive code (SMCC)[11],binary orientation co-occurrence vector (BOCV)[12],robust line orientation code (RLOC)[13]和ordinal code[14]等。以CompC方法为例,基于方向编码方法的流程如图1所示,首先采用6个方向的Gabor滤波器和竞争规则提取掌纹像素的主方向特征,然后使用二进制表示掌纹主方向特征,最后使用汉明距离进行匹配。为了利用掌纹图像的尺度信息,ZUO等[11]提出了采用稀疏编码获得鲁棒的多尺度掌纹方向特征的SMCC算法;GUO等[12]提出的BOCV方法包含了多方向信息;JIA等[13]采用改进的有限Radon变换(modified finite Radon transform, MFRAT)提取掌纹方向特征图,即RLOC算法,并在匹配时采用一个像素对区域的匹配方式;SUN等[14]提出ordinal code方法,采用3组正交高斯滤波器提取掌纹方向特征。但基于方向编码的方法也存在一定的缺点,如在降采样过程中,往往只使用一个方向值,而很多像素的方向信息被丢弃,未充分利用某个像素可能包含多个方向信息这一特点,造成信息损失。为解决该问题,文献[15-16]提出了基于方向特征的局部描述子方法,提取掌纹的多个方向特征。以LLDP (local line directional pattern)方法为例,其流程如图2所示。首先通过Gabor滤波器,对掌纹ROI图像进行多个方向的滤波,然后比较滤波后的各个方向的值,确定每个像素的多个方向,即最大方向、最小方向等,并按照一定的编码规则确定该像素的方向编码,最终形成整个图像的方向特征编码图;为更好的表示局部信息,对方向特征编码图像进行分块,并构建直方图,将每个分块的直方图首尾相连,形成最终的直方图,即局部描述子作为最终特征。方向图同样可看成一种图像,因此JIA等[17]使用频域方法对掌纹方向特征图进行特征提取和匹配,提出了结合BLPOC (band-limited phase-only correlation)和方向表达(directional representation, DR)的BLPOC_DR方法,该方法是一种全局方法,取得了较好的识别结果。BLPOC_DR方法的具体流程如图3所示。通过对算法的分析可知,BLPOC_DR算法属于全局特征提取的方法,而LLDP和CompC (或SMCC)算法属于局部特征提取方法。

图1 方向编码方法的总体流程

图2 基于方向特征的局部描述子方法的总体流程

图3 BLPOC_DR方法的总体流程

针对鲁棒的生物特征识别,文献[18]指出基于单一特征的识别方法存在一定的局限性,因为其无法完整的描述待识别目标,造成信息损失。为解决该问题,采用多特征融合的方法,通过多种特征的信息互补可提升识别系统的准确性。根据心理物理学和神经生理学的研究,局部和全局信息 对人类视觉系统至关重要,且局部信息和全局信息处于不同但互补的状态。全局特征(global representations, GR)反应了图像的整体结构,用于粗略的特征表示;而局部特征(local representations, LR)则更加注重图像的细节,反应图像局部区域内更详细的变化。因此,适当地组合局部和全局信息,可以达到更好的图像识别效果。

融合GR和LR的识别方法,可以分成2种类型。类型I,通过不同方法分别提取GR和LR;类型II,采用相同的方法,在整幅图像中提取GR,在子区域中提取LR。对于类型I的融合方式,融合函数可表示为

其中,level为融合的层次;GR和LR为GR和LR的提取方法和。相似的,类型II的融合方式为

其中,为同一种特征提取方法。

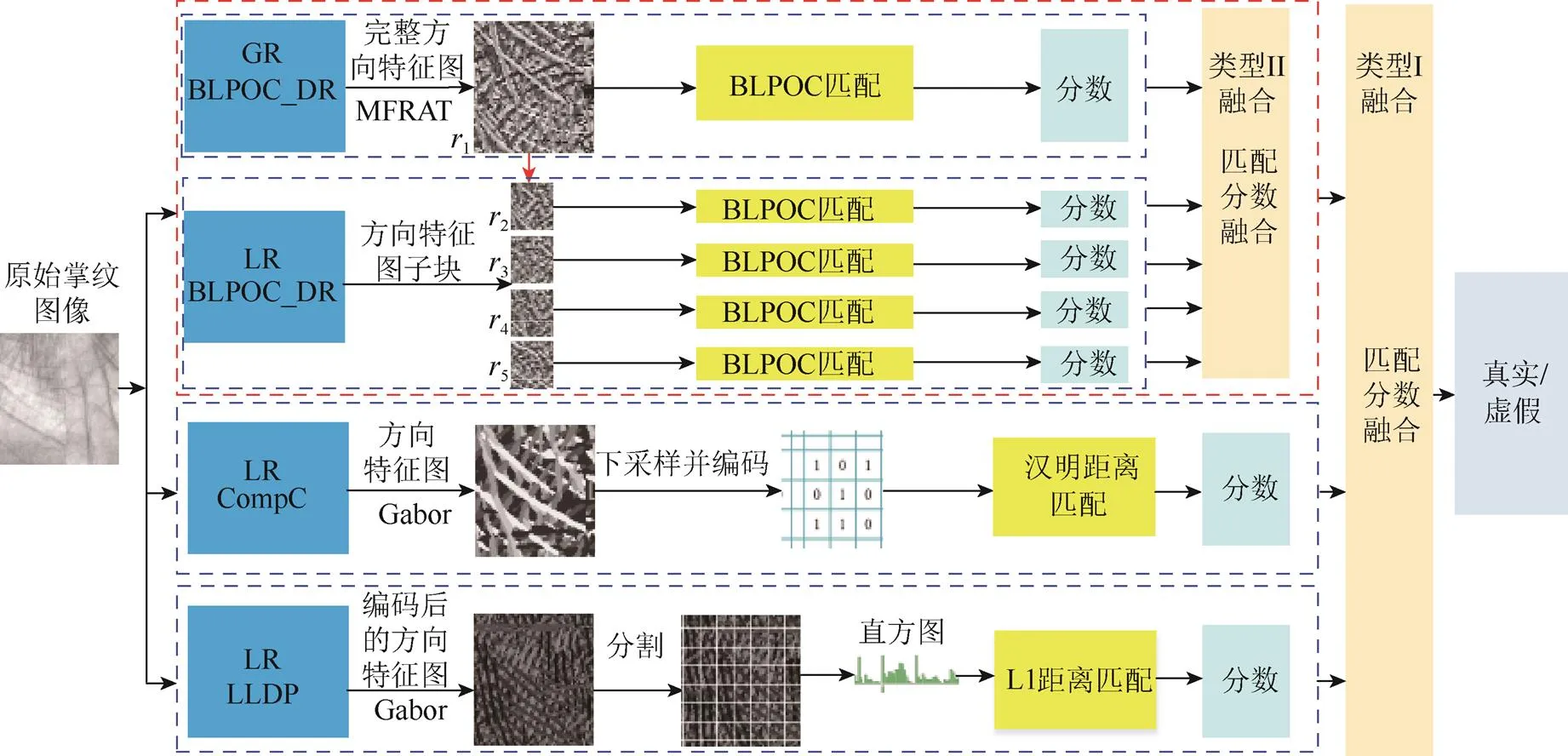

为了进一步提升掌纹识别系统的鲁棒性,本文提出了一种采用上述2种类型,进行混合融合的多特征识别方法。由于本文融合的是基于方向特征的方法,因此将其称之为FDR (fusing directional representations)方法。FDR的主要思路为:①采用BLPOC从整幅方向特征图中提取GR;②采用BLPOC在方向特征图子区域提取LR,与GR进行类型II的融合;③采用基于方向编码的方法CompC(或SMCC)和基于方向信息描述子的算法LLDP分别提取掌纹的LR;④在匹配值层对3种算法进行类型I的信息融合,得到最终的识别结果。BLPOC_DR,CompC (或SMCC)和LLDP都有很好的识别性能,而且机制并不相同,可以优势互补,因此,FDR方法能取得更加优异的识别结果。

1 相关工作

1.1 CompC方法简述

CompC算法采用6个不同方向的Gabor滤波器(θ)与掌纹ROI图像进行卷积来提取掌纹方向特征,即

其中,*为卷积操作;θ=π(–1)/6,=1,2,···,6。对于任意像素(,),卷积后得到6个方向的卷积结果m,选择最小值对应的方向下标作为掌纹特征。

在CompC中,需对128×128大小的掌纹ROI进行特征提取,所以匹配较耗时,因此通过下采样,形成32×32的特征图。由于特征图的值由1到6组成,因此,采用3位2进制表示6个方向。在匹配阶段,采用汉明距离计算2幅掌纹图像的相似性。

1.2 SMCC方法简述

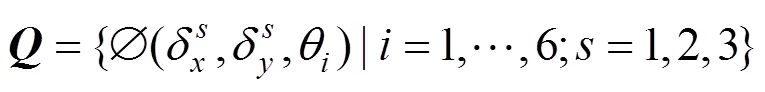

给定一幅掌纹图像,块z,y定义为掌纹图像在(,)处生成的子图,z,y首先需进行归一化,使得均值为0并统一标准差。接着采用稀疏表达对z,y编码,即

1.3 LLDP方法简述

基于Gabor滤波器的LLDP描述子,首先采用12个方向Gabor滤波器对给定掌纹ROI图像进行滤波。令(θ)代表Gabor滤波器的实部,其中θ代表Gabor滤波器第个方向。将与12个方向的Gabor滤波器实部进行卷积,对于像素点(,),其与第个方向的(θ)卷积结果可用m表示,如式(1)。

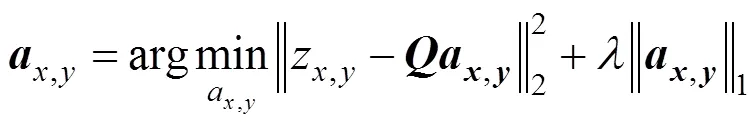

其中,为LLDP编码值;(,)为区域中的像素位置;(,)为在位置(,)上的LLDP编码;为累加值,一般取1。获得每个图像块的后,将每个子区域对应的特征直方图连接,生成掌纹图像的特征直方图。

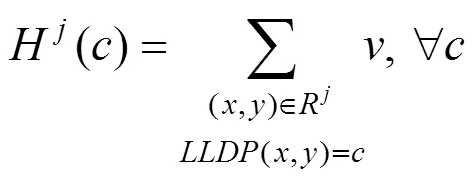

其中,∏为直方图连接操作;为图像块的数量。在匹配阶段,使用1距离、卡方距离等方法计算直方图之间的相似度。

1.4 BLPOC_DR方法简述

BLPOC_DR方法首先采用12个方向的MFRAT对掌纹图像进行滤波,对滤波结果{m,=1,2,···,12}排序,选择出最小的m对应的方向下标,替换原始掌纹像素,构建掌纹的方向图。

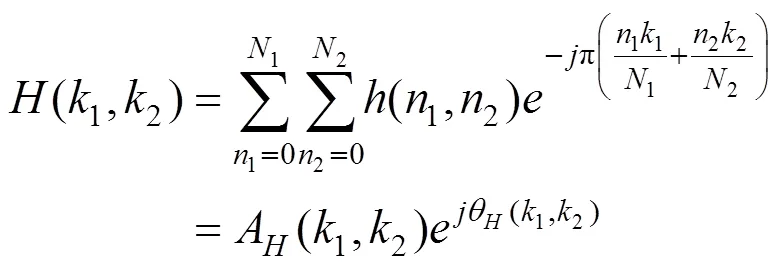

在生成的掌纹方向图上,采用BLPOC进行特征提取和匹配。给定2幅图像(1,2)和(1,2),其大小为1×2,(1,2)和(1,2)分别为(1,2)和(1,2)的二维离散傅里叶变换,(1,2)的定义如下

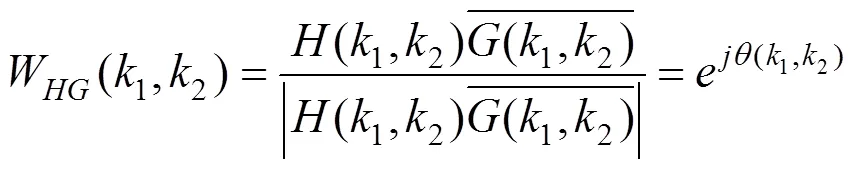

其中,A(1,2)为幅度;(1,2)为相位。(1,2)采用相同的方法得到。归一化的互功率谱W(1,2)表示为

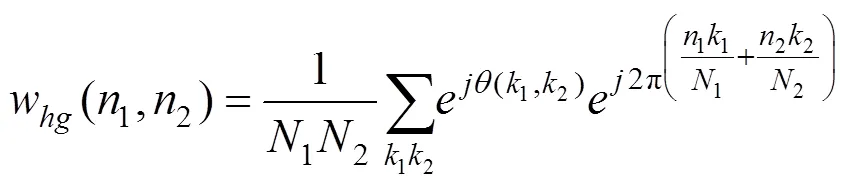

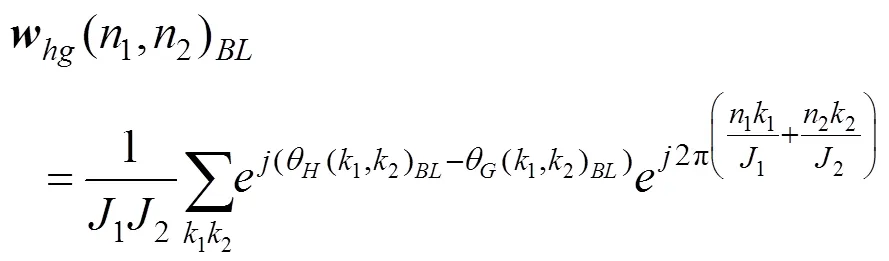

通过式(8)可以看出,POC使用所有的傅里叶变换分量生成输出平面。文献[19]的研究表明,通过移除图像的高频分量且仅仅使用低频分量可以达到提升识别效果的目的。设(1,2)和(1,2)的中心区域分别为(1,2)和(1,2),大小为1×2。因此,BLPOC方程可定义为

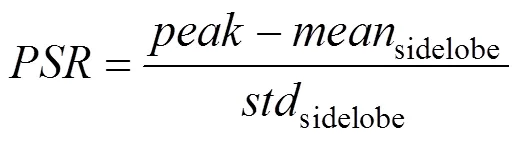

(1,2)为一维向量,需要按字典顺序将其转化成2D矩阵,得到相关输出平面(correlation output plane,COP)。在匹配阶段,采用峰值旁瓣比(peak-to-sideloberation, PSR)作为相似性度量

其中,sidelobe为环绕峰值的旁瓣区域的均值;sidelobe是为旁瓣区域的标准差。

2 方 法

2.1 FDR方法

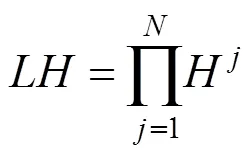

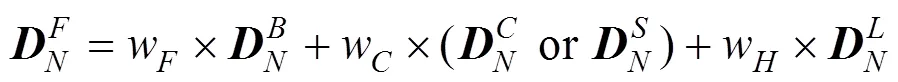

FDR方法首先使用BLPOC对全局方向图和局部方向子图分别进行特征提取和匹配,进行类型II的融合。然后使用LLDP和CompC(或SMCC)算法提取掌纹的局部特征,与类型II的融合结果进行类型I的融合。可以看出,FDR包含了2种类型的融合方式,是一种混合融合方法,可表示为

其中,Score Level代表融合的方式为匹配值融合。

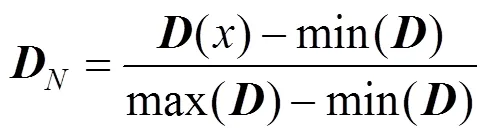

BLPOC_DR算法采用BLPOC在掌纹的整体方向特征图上,提取全局特征。来自不同的掌纹图像可能包含相同的全局结构,所以,局部特征显得尤为重要。为了提取掌纹的局部特征,需要对掌纹方向特征图进行分块处理,对每一子块,采用BLPOC进行局部特征提取和匹配。最后,将BLPOC算法提取的全局特征和局部特征进行匹配值融合,称为BBLPOC_DR算法。

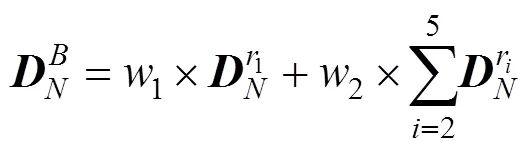

其中,1和2分别为BBLPOC_DR算法中的全局和局部特征权值。由于1区域的掌纹识别结果优于其他子区域的识别结果,因此通常设置1和2为4和1。

其中,w,w和w为权值,其取值大小取决于所采用的数据库。

在FDR中,如果参与融合的算法包括CompC算法,将FDR命名为FDRC,如果CompC算法被SMCC算法取代,则将FDR命名为FDRS。图4为本文提出的FDR方法的框架结构。

2.2 FDR方法分析

在FDR方法中,CompC算法(或SMCC)由于采用6个方向的滤波器和下采样等操作,会丢失部分信息,而BBLPOC_DR算法和LLDP算法采用的滤波器数量较多,能采集到更多的方向信息,因此对于CompC(或SMCC)存在的问题可进行一定程度的弥补;BBLPOC_DR算法采用MFRAT滤波器提取掌纹的方向特征,若存在光照变化且MFRAT滤波器较小时,提取的掌纹方向特征不够鲁棒,而CompC (或SMCC)采用尺寸较大的方向滤波器提取方向特征,可有效的应对光照的变化,并与BBLPOC_DR算法形成互补。BBLPOC_DR属于相关滤波器的算法,在提取特征时对于图像间小的平移变异比较鲁棒,而LLDP算法采用直方图的方式表示掌纹特征,能够有效的应对数据库中存在的旋转变化。通过以上分析,可以得出,BBLPOC_DR、CompC(SMCC)、LLDP 3种算法,都有各自的优缺点,但3种算法能够相互补充。FDR同时包含3种方法优势,另外,3种方法的缺点可以在一定程度上相互克服。

图4 匹配值融合的多方向特征掌纹识别算法

3 实验及结果分析

3.1 掌纹数据库

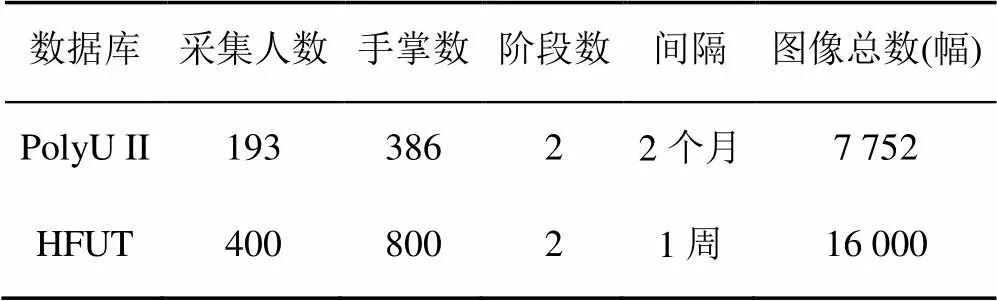

为验证本文算法的有效性,在香港理工大学掌纹库(Hong Kong Polytechnic University Palmprint II Database, PolyU II)和合肥工业大学掌纹库(Hefei University of Technology, HFUT) 2个掌纹数据库上进行了实验验证,2个数据库包含的掌纹ROI图像大小均为128×128。表1为本文使用掌纹数据库的情况。PolyU II数据库包含由386个手掌提供的7 752幅掌纹图像,数据分2阶段采集,每个手掌2个阶段分别采集约10幅掌纹图像,其间隔为2个月。PolyU II数据库自发布以来,已经成为最广泛使用的掌纹数据库。PolyU II数据库中的4幅掌纹ROI图像如图5(a)所示。

表1 本文所使用的掌纹数据库的细节信息

HFUT数据库是由本实验室采集的掌纹数据库。数据分2阶段采集,从800个手掌接触式采集掌纹,每个手掌2个阶段分别采集约10幅掌纹图像,其间隔为10天,整个数据库包含16 000幅掌纹图像,是相对比较大的掌纹数据库。相较于PolyU II库,HFUT库在采集时采用无钉式的掌纹采集方式,且在自然光下采集。HFUT数据库中的4幅掌纹ROI图像如图5(b)所示。

图5 不同掌纹数据库的4幅ROI图像

所有的实验均在具有Matlab R2017b的PC机上进行。对于BBLPOC_DR算法,根据经验将1的1和2值设为26,对其他子区域,将其1和2值设为22。在识别实验中,本文采用最近邻算法作为分类器。本文将FDR算法与已有的算法如local binary pattern (LBP)[20],local derivative pattern (LTP)[21],local directional pattern (LDP)[22],enhanced local directional patterns (ELDP)[23],local directional number pattern (LDN)[24],histogram of oriented lines(HOL)[15],LLDP[16],RLOC[13],ordinal code[14],CompC[10]和SMCC[11]算法进行识别性能比较。

3.2 识别性能测度

本文使用6个识别性测度对实验结果进行识别性能评估,包括正确识别率(accurate recognition rate, ARR),错误接受率(false acceptance rate, FAR),错误拒绝率(false rejection rate, FRR),等错率(equal error rate,EER),以及ZeroFAR,ZeroFRR等。FAR指授权用户被错误拒绝的比例;FRR是指非授权用户被错误接受的比例;EER是指FAR曲线和FRR曲线相交时候的值,此时FAR等于FRR。ZeroFAR是指FAR为0的时FRR的值;而ZeroFRR是指FRR为0时FAR的值。

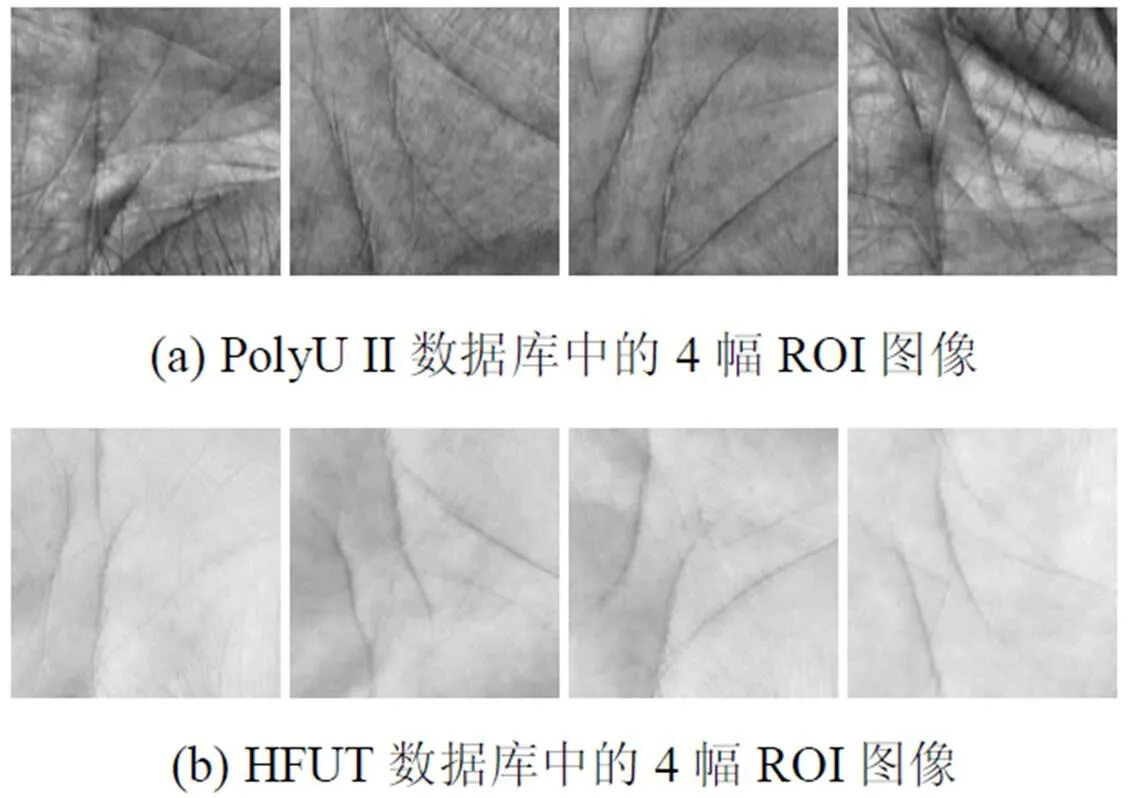

3.3 本文算法在PolyU II库上的性能评估

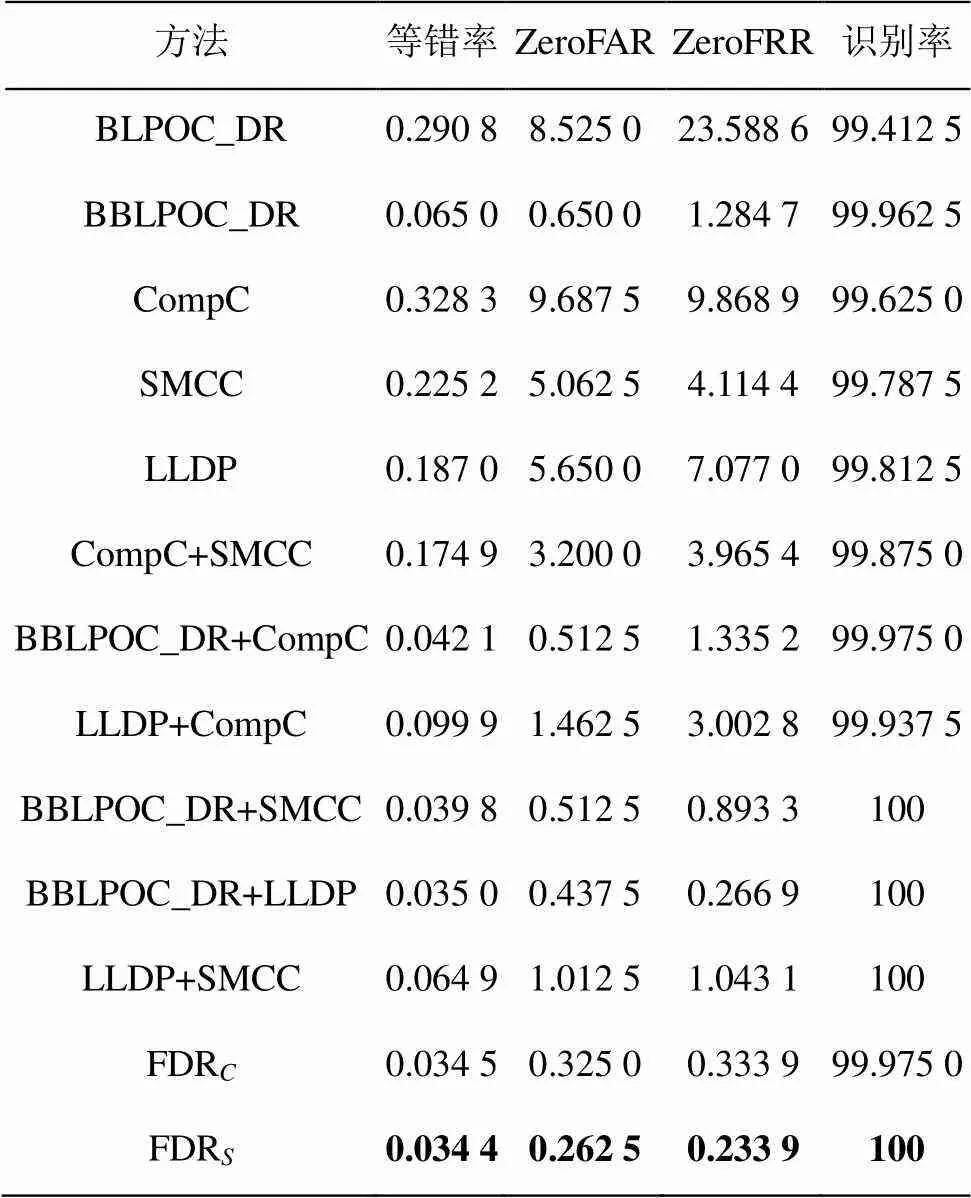

对于PolyU II库,首先对BLPOC_DR算法、BBLPOC_DR算法、CompC算法、SMCC算法、LLDP算法及其他的融合算法进行评估。具体的,将PolyUII数据库中第1阶段的前3幅掌纹图像用于训练,第2阶段的所有掌纹图像用于测试。在BBLPOC_DR和BLPOC_DR算法中,均采用9×9的MFRAT滤波器提取掌纹的方向特征。从表2的结果可以看出,BBLPOC_DR算法其识别性能要明显优于BLPOC_DR算法,由此证明,基于类型II的融合全局和局部掌纹特征的算法要明显优于仅仅基于全局掌纹特征的算法。从整体的实验结果可以看出,BBLPOC_DR算法、CompC算法、SMCC算法、LLDP算法均获得了很好的识别率,说明单一的方向特征表示方法在掌纹特征提取方面具有良好的性能。因此,在进行多方向特征表示方法融合实验时,可设定w,w和w的值为1。对于融合的方向特征方法,EER均有明显的降低。由于SMCC和CompC均为局部的方向编码方法,其融合结果较其他方式差,因此表明了不同性质的方法对于掌纹识别性能提升的重要性。LLDP和SMCC同属于掌纹的LR提取方法,但LLDP为基于描述子的方法,SMCC属于基于方向编码的方法,两者融合后的EER为0。表中FDRS和FDRC的EER也为0。

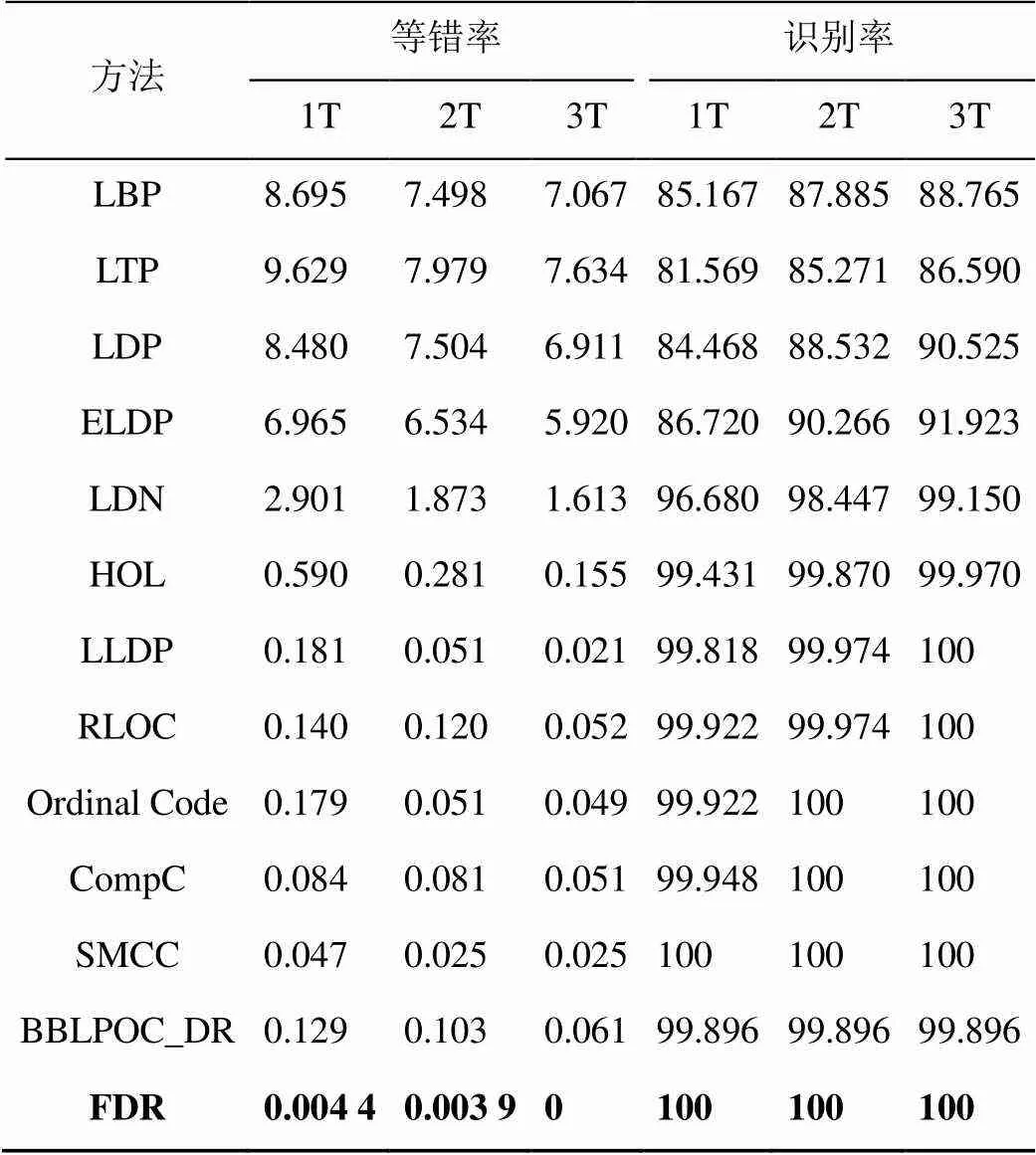

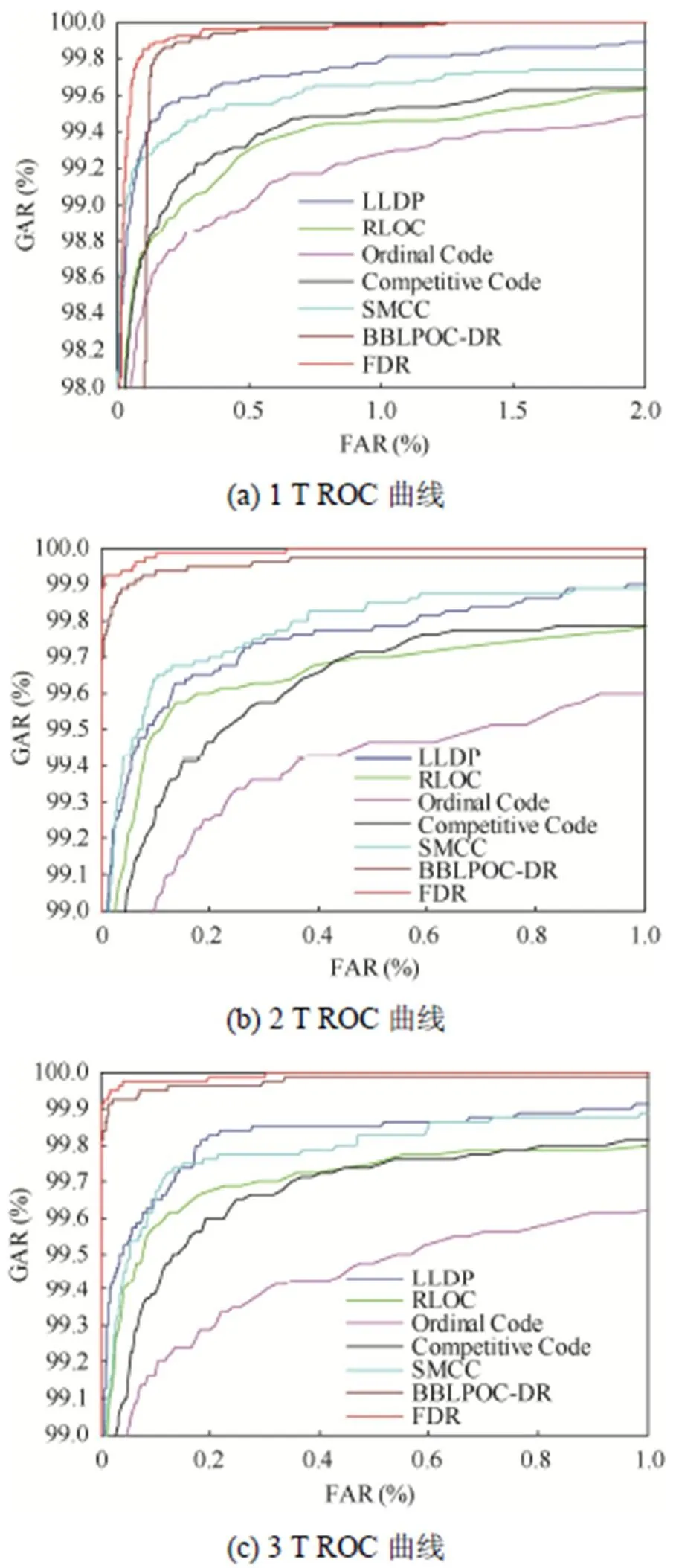

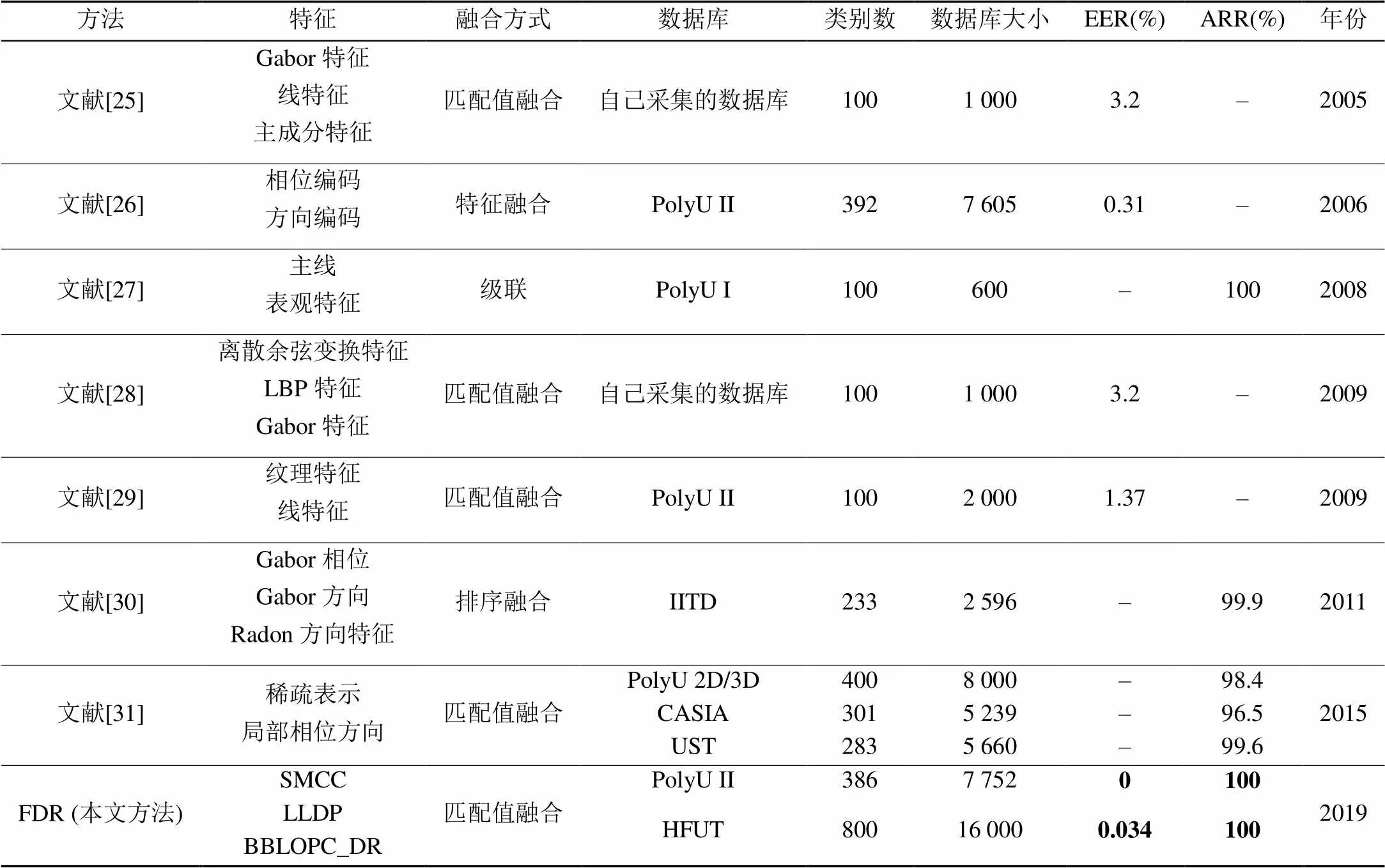

表3列出了本文方法与现有部分掌纹识别方法EER和ARR的对比。为了测试不同训练数据量对识别性能的影响,因此分别设置参与训练集的掌纹数量为1(1T),2(2T),3(3T)。从表3可以看出,当仅使用1或2个图像进行训练时,本文FDR方法的EER非常低;且当有3个训练图像时,其EER值为0,说明了本文方法的识别性能明显优于其他算法。图6为PolyU II库上各算法的ROC曲线。

表2 在PolyU II库上的融合实验结果(%)

表3 在PolyU II库上的掌纹识别方法性能比较(%)

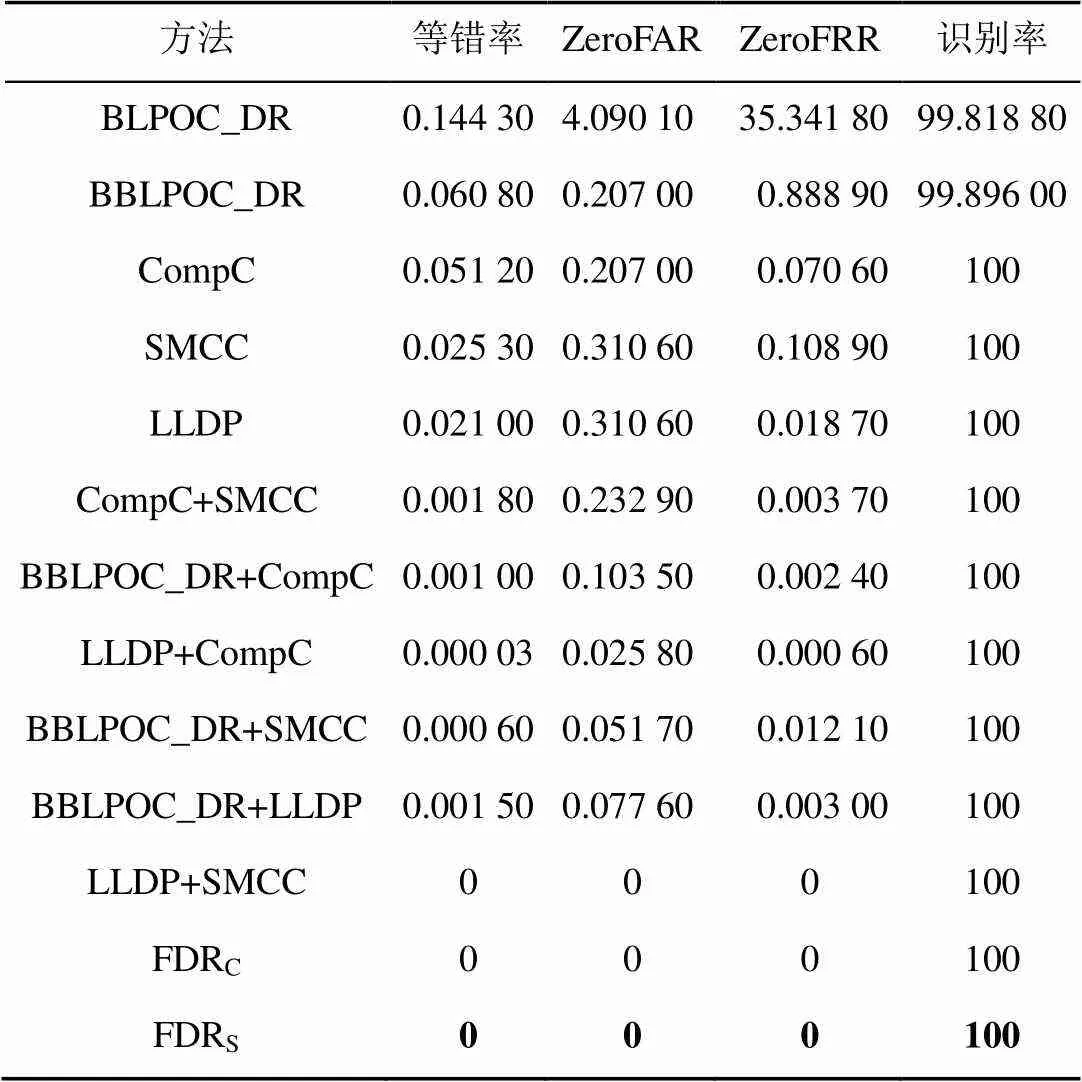

3.4 本文算法在HFUT库上的性能评估

对于HFUT数据库,同PolyU II库类似,首先对单一的基于方向特征的掌纹识别方法和融合的方向特征表示方法进行了性能评估。同样的,采用数据库中第1阶段采集的3幅掌纹图像作为训练集,第2阶段采集的所有掌纹图像作为测试集。对于BLPOC_DR和BBLPOC_DR,在图像特征提取时,采用的MFRAT滤波器的大小为11×11。表4为基于方向特征方法的识别结果。从表中可以看出,BBLPOC_DR算法要明显优于BLPOC_DR算法,且相较于LLDP,SMCC和CompC算法,BBLPOC_DR的识别性能最优。因此在融合实验中,设定w的值为4,其余的加权参数为1。同样的,FDRS和FDRC取得了最低的EER值。

图6 PolyUII库上的ROC曲线

表4 在HFUT库上的融合实验结果(%)

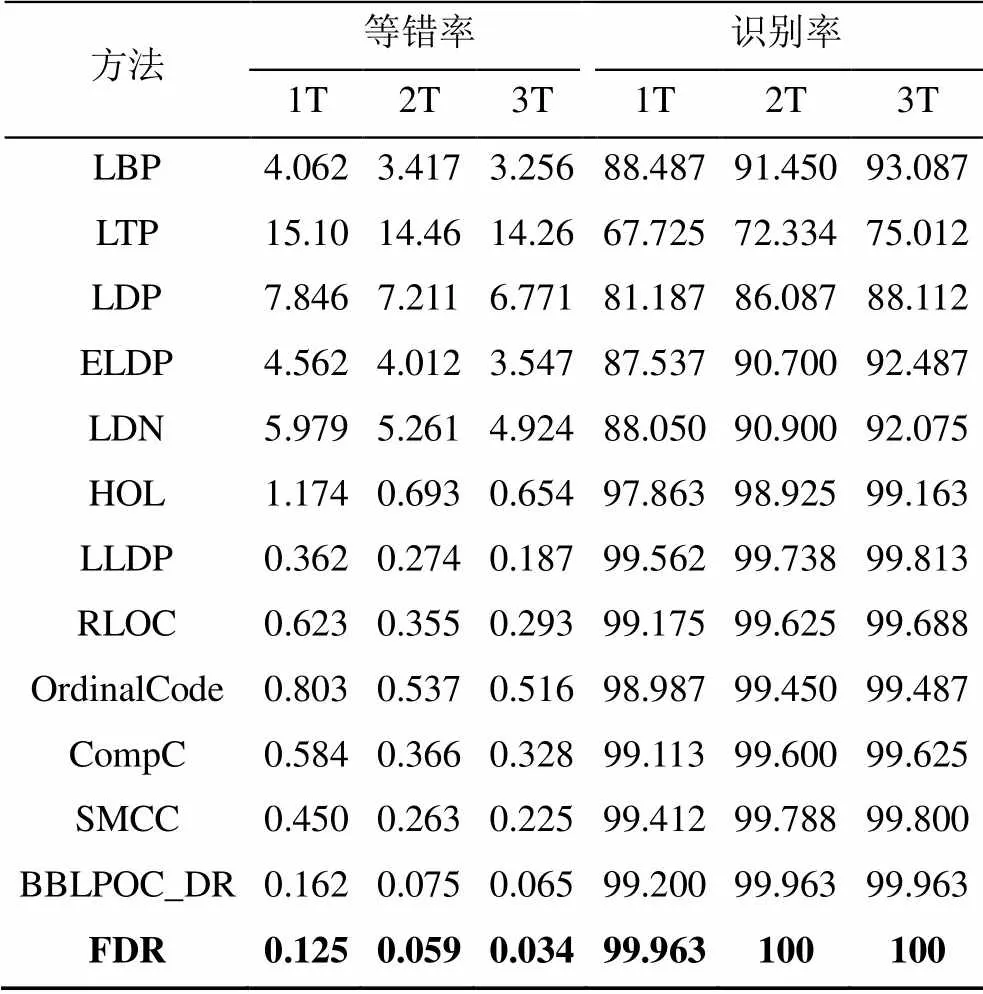

表5给出了在HFUT库上,本文的算法与其他掌纹识别算法的比较。实验结果表明,FDR方法在训练集数量为2时,识别率达到了100%。可以看出,本文方法的识别性能要明显优于其他方法。图7为HFUT库上各算法的ROC曲线。

表5 在HFUT库上的掌纹识别方法性能比较(%)

图7 HFUT库上的ROC曲线

3.5 与其他多特征融合算法的比较

表6为本文FDR算法与其他多特征融合算法进行的比较。实验中采用的训练集数量为3。根据表6可以看出,本文的FDR算法的识别性能明显优于其他多特征融合算法,因此,可以认为,融合局部和全局掌纹方向特征的识别算法能够取得非常理想的识别效果。

表6 FDR与其他多特征融合算法的比较

4 结 论

本文提出了融合局部和全局掌纹方向特征的FDR方法。其融合了3种基于方向特征的掌纹识别方法,分别为BBLPOC_DR算法,LLDP算法,CompC算法(或SMCC算法)。FDR算法充分利用了全局和局部特征融合的优点和基于方向特征算法的识别性能优势,同时,所采用的3种掌纹识别方法之间能够互相补充。因此,FDR能够有效提升识别性能达到鲁棒的掌纹识别目的。本文在2个掌纹数据库上对FDR算法进行了性能测试,实验证明,FDR算法的识别性能优于其他几种掌纹识别方法。

[1] JAIN A K, NANDAKUMAR K, ROSS A. 50 years of biometric research: Accomplishments, challenges, and opportunities [J]. Pattern Recognition Letters, 2016, 79: 80-105.

[2] ZHONG D X, DU X F, ZHONG K C. Decade progress of palmprint recognition: A brief survey [J]. Neurocomputing, 2019, 328: 16-28.

[3] ZHANG D, ZUO W M, YUE F. A comparative study of palmprint recognition algorithms [J]. ACM Computing Surveys, 2012, 44(1): 1-37.

[4] XU Y, FEI L K, WEN J, et al. Discriminative and robust competitive code for palmprint recognition [J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2018, 48(2): 232-241.

[5] KUMAR A. Toward more accurate matching of contactless palmprint images under less constrained environments [J]. IEEE Transactions on Information Forensics and Security, 2019, 14(1): 34-47.

[6] KONG A, ZHANG D, KAMEL M. A survey of palmprint recognition [J]. Pattern Recognition, 2009, 42(7): 1408-1418.

[7] FEI L K, ZHANG B, ZHANG W, et al. Local apparent and latent direction extraction for palmprint recognition [J]. Information Sciences, 2019, 473: 59-72.

[8] FEI L K, LU G M, JIA W, et al. Feature extraction methods for palmprint recognition: A survey and evaluation [J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2019, 49(2): 346-363.

[9] FEI L K. Local discriminant direction binary pattern for palmprint representation and recognition [EB/OL]. [2018-12-28]. https://ieeexplore.ieee.org/abstract/ document/8600369.

[10] ZHANG D, KONG W K, YOU J, et al. Online palmprint identification [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2003, 25(9): 1041-1050.

[11] ZUO W M, LIN Z C, GUO Z H, et al. The multiscale competitive code via sparse representation for palmprint verification [C]//2010 IEEE Computer Society Conference on Computer Vision and Pattern Recognition. New York: IEEE Press, 2010: 2265-2272.

[12] GUO Z H, ZHANG D, ZHANG L, et al. Palmprint verification using binary orientation co-occurrence vector [J]. Pattern Recognition Letters, 2009, 30(13): 1219-1227.

[13] JIA W, HUANG D S, ZHANG D. Palmprint verification based on robust line orientation code [J]. Pattern Recognition, 2008, 41(5): 1504-1513.

[14] SUN Z N, TAN T N, WANG Y H, et al. Ordinal palmprint represention for personal identification [C]// 2005 IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR'05). New York: IEEE Press, 2005: 279-284.

[15] JIA W, HU R X, LEI Y K, et al. Histogram of oriented lines for palmprint recognition[J]. IEEE Transactions on Systems, Man, and Cybernetics: Systems, 2014, 44(3): 385-395.

[16] LUO Y T, ZHAO L Y, ZHANG B, et al. Local line directional pattern for palmprint recognition [J]. Pattern Recognition, 2016, 50: 26-44.

[17] JIA W, ZHANG B, LU J T, et al. Palmprint recognition based on complete direction representation [J]. IEEE Transactions on Image Processing, 2017, 26(9): 4483-4498.

[18] ROSS A, JAIN A. Information fusion in biometrics [J]. Pattern Recognition Letters, 2003, 24(13): 2115-2125.

[19] MIYAZAWA K, ITO K, AOKI T, et al. An effective approach for iris recognition using phase-based image matching [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2008, 30(10): 1741-1756.

[20] OJALA T, PIETIKAINEN M, MAENPAA T. Multiresolution gray-scale and rotation invariant texture classification with local binary patterns [J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2002, 24(7): 971-987.

[21] ZHANG B C, GAO Y S, ZHAO S Q, et al. Local derivative pattern versus local binary pattern: Face recognition with high-order local pattern descriptor [J]. IEEE Transactions on Image Processing, 2010, 19(2): 533-544.

[22] JABID T. Robust facial expression recognition based on local directional pattern [J]. ETRI Journal, 2010, 32(5): 784-794.

[23] ZHONG F J, ZHANG J S. Face recognition with enhanced local directional patterns [J]. Neurocomputing, 2013, 119: 375-384.

[24] RAMIREZ RIVERA A, ROJAS CASTILLO J, OKSAM CHAE O. Local directional number pattern for face analysis: Face and expression recognition [J]. IEEE Transactions on Image Processing, 2013, 22(5): 1740-1752.

[25] KUMAR A, ZHANG D. Personal authentication using multiple palmprint representation [J]. Pattern Recognition, 2005, 38(10): 1695-1704.

[26] WU X Q, ZHANG D, WANG K Q. Fusion of phase and orientation information for palmprint authentication [J]. Pattern Analysis and Applications, 2006, 9(2-3): 103-111.

[27] JIA W, LING B, CHAU K W, et al. Palmprint identification using restricted fusion [J]. Applied Mathematics and Computation, 2008, 205(2): 927-934.

[28] NANNI L, LUMINI A. Ensemble of multiple palmprint representation [J]. Expert Systems with Applications, 2009, 36(3): 4485-4490.

[29] PRASAD S M, GOVINDAN V K, SATHIDEVI P S. Palmprint authentication using fusion of wavelet based representations [C]//2009 World Congress on Nature & Biologically Inspired Computing (NaBIC). New York: IEEE Press, 2009: 520-525.

[30] KUMAR A, SHEKHAR S. Personal identification using multibiometrics rank-level fusion [J]. IEEE Transactions on Systems, Man, and Cybernetics, Part c (Applications and Reviews), 2011, 41(5): 743-752.

[31] TABEJAMAAT M. Selective algorithm outline (SAO): An alternative approach for fusing different palm-print recognition algorithms [J]. Neural Processing Letters, 2016, 43(3): 709-726.

Palmprint Recognition Based on Fusing Global and Local Directional Features

CHEN Xiao-man, JIA Wei, LI Shu-jie, LIU Xiao-ping

(School of Computer Science and Information Engineering, Hefei University of Technology, Hefei Anhui 230009, China)

Palmprint recognition is one of the most popular biometrics identification technologies. Among the various methods of palmprint recognition, the method based on directional features has achieved good results. In order to further improve the recognition accuracy, a palmprint recognition algorithm combining global and local directional features is proposed, which mainly combines the method based on directional coding, the method based on local descriptor of directional features and the method of combining directional features and correlation filters. The first two methods belong to the spatial domain method, which can extract the local directional features of the palmprint. The third method belongs to the frequency domain method, which can effectively extract the global directional features. The recognition results of the three methods are merged at the score level. The algorithm is validated on two palmprint databases. The experimental results show that the recognition performance of this method is better than other palmprint recognition methods.

biometrics; palmprint recognition; directional representations; information fusion; score level fusion

TP 391

10.11996/JG.j.2095-302X.2019040671

A

2095-302X(2019)04-0671-10

2018-12-28;

定稿日期:2019-03-05

国家自然科学基金项目(61673157)

陈晓蔓(1994-),女,安徽淮南人,硕士研究生。主要研究方向为图像处理、生物特征识别。E-mail:xmchen1112@163.com

刘晓平(1964-),男,山东济南人,教授,博士,博士生导师。主要研究方向为计算机辅助设计、计算机图形学。E-mail:lxp@hfut.edu.cn