一种基于多相关滤波器组合的目标跟踪方法

潘迪夫 李耀通 韩锟

摘 要:针对复杂跟踪环境条件下目标的跟踪失败问题,提出一种基于多相关滤波器组合的目标跟踪方法.首先2个分别采用颜色属性(Color Name,CN)特征和方向梯度直方图(Histogram of Oriented Gradient,HOG)特征的核相关滤波器(Kernelized Correlation Filter,KCF)通过自适应融合手段进行响应图信息融合,确定目标的预测位置;然后通过以目标区域为基础进行多尺度采样,提取CN-HOG拼接特征构建尺度相关滤波器,得到目标的最佳尺度;最后设计了模型的自适应更新策略,通過判断目标是否发生遮挡来决定是否在当前帧进行模型更新.在50组视频序列上对所提算法与6种当前主流的相关滤波跟踪算法进行了实验.实验结果表明,在复杂的跟踪环境条件下,所提算法取得了最好的跟踪精度和成功率,能够有效处理目标遮挡和尺度变化等问题,且具有较快的跟踪速度.

关键词:目标跟踪;相关滤波;尺度评估;模型自适应更新

中图分类号:TP391 文献标志码:A

A Target Tracking Method Based on Multi-correlation Filter Combination

PAN Difu,LI Yaotong,HAN Kun

(School of Traffic and Transportation Engineering,Central South University,Changsha 410075,China )

Abstract: To cope with the problem of object tracking failure in the challenging environment, a target tracking method based on multi-correlation filter combination was proposed. Firstly, two kernelized correlation filters(KCF) based on color name(CN) features and histogram of oriented gradient(HOG) features, respectively, integrated the map information through adaptive fusion method, and were used to determine the prediction position of the target. Then, through the multi-scale sampling based on the target region, CN-HOG compositive feature was extracted to construct a scale correlation filter to obtain the optimal scale of target. Finally, the adaptive updating strategy of the model was designed to determine whether the model was updated in the current frame through determining whether the target was occluded. The proposed algorithm and 6 state-of-the-art methods were tested on 50 video sequences. The experiment results indicate that the proposed algorithm gains the best precision and success rate in the challenging environment, it can effectively deal with the problem of object occlusion and scale change, and it has a fast tracking speed.

Key words: object tracking;correlation filter;scale estimate;model adaptive updating

视觉跟踪在计算机视觉应用领域中扮演着重要的角色[1-3],例如视频监控、人机交互、机器人技术和增强现实等.目前,基于相关滤波(Correlation Filters,CF)的跟踪算法因其高精度、高鲁棒性、速度快的特点[4],引起了相关学者们的广泛关注和研究.针对目标表征建模的相关滤波跟踪算法主要分为两类:单模型和多模型.单模型是指采用单特征来训练分类器的相关滤波跟踪算法,主要包括采用灰度特征的核循环结构跟踪器(CSK)[4]、使用CN特征扩展稠密采样跟踪器(CN)[5]、采用HOG特征的核相关跟踪器(KCF)[6]、采用HOG特征的尺度自适应跟踪器(DSST)[7].多模型是指采用多特征来训练分类器的相关滤波跟踪算法,主要包括通过串接CN特征和HOG特征的尺度自适应跟踪器(SAMF)[8]、基于CN特征和HOG特征贡献度进行加权组合的尺度自适应跟踪器(Staple)[9]、根据CN特征和HOG特征的响应图进行加权融合的模型自适应更新跟踪器(FAUT)[10]、CN特征和HOG特征串接的多尺度跟踪器(FMFPSA)[11]、CN特征和HOG特征自适应融合的跟踪器(FAKCF)[12].经过大量的实验结果分析可知,由于多模型相关滤波跟踪算法采用多特征描述目标,提高了跟踪算法的判别力,其跟踪性能高于单模型.

尽管上述的跟踪算法已取得较好的跟踪效果,但现实环境中依然存在很多挑战性问题,主要包括光照变化、背景复杂、目标旋转以及目标遮挡等情况造成目标表征发生变化而导致目标跟踪失败.还有在上述的多模型相关滤波跟踪算法中,对于多特征的使用方法仍然存在一些不合理之处,并且关于目标尺度评估的准确性也有待提高.

基于上述分析,本文提出一种基于多相关滤波器组合的目标跟踪方法(Multi-Correlation Filter Combination based Tracking Method,MCFC),其中2个分别采用单特征训练的KCF跟踪器用于目标定位,通过本文提出的以历史响应峰值的均值为基础的响应图信息融合判断机制进行响应图融合,得到最终的目标位置,以提高算法的定位精度;然后1个采用组合特征训练的相关滤波器用于目标尺度评估,以增加算法尺度估计的准确性;最后设计一种以历史响应峰值的均值和峰值旁瓣比为基础的模型自适应更新策略,以提升算法的鲁棒性.在若干视频序列上进行对比实验,证明了本文所提算法具有较高的整体跟踪性能.

1 KCF跟踪器基本原理

KCF跟踪器是一种通过引入核函数对相关滤波理论进行改进的核相关滤波方法,核心思想是通过对图像块进行循环密集采样构造循环矩阵,利用循环矩阵的性质与傅里叶域建立关系,通过离散傅里叶变换在频域中快速实现分类器训练和目标检测,以达到快速跟踪目标的目的[6].相关滤波目标跟踪方法采用岭回归分类器来预测目标位置[4-6,13].对循环采样得到的训练样本X和高斯函数得到的理想输出Y构造目标优化函数模型

求解分类器系数W.通过映射函数φ(·) 将低维空间的特征x映射到Hilbert空间得到φ(x),此时分类器的解可表示为W = (αi φ(xi)),则f(xj) = 〈w,φ(xi)〉=i 〈φ(xi)T,φ(xj)〉,引入核函数k(xi,xj) = 〈φ(xi)T,φ(xj)〉,构造循环矩阵K,矩阵K中元素kij = k(xi,xj),对式(1)进行求解可得

α = (K + λI)-1Y (2)

式中:I为单位矩阵,λ为防止过拟合的正则项[14].利用循环矩阵K的性质通过离散傅里叶变换(DFT)将问题变换到频域进行求解

式中xx表示样本特征x的自相关核向量,y为样本x对应的标签向量,符号^表示向量的离散傅里叶变换(此表示方法应用于全文).对于核函数,本文选择图像处理中常用的高斯核,其计算公式为

(4)

中:kxz表示训练样本特征x和检测样本特征z的互相关核向量,可通过式(4)计算获得.输出响应y中的峰值位置即为当前帧图像中的目标位置.根据计算的检测结果对分类器参数α和目标模板x进行更新

αt = (1 - η)αt-1 + ηαt′xt = (1 - η)xt-1 + (1 - η)zt (6)

其中,η为学习率,以适应目标外观表征变化,提高跟踪器的鲁棒性和准确性.

2 MCFC目标跟踪方法

2.1 位置跟踪的相关滤波器组合

MCFC方法将采用基于颜色属性(Color Name,CN)特征和基于方向梯度直方图(Histogram of oriented Gradients,HOG)特征的两个相关滤波器分别对目标进行位置跟踪,两个滤波器的训练和检测过程均独立完成,两者所输出的响应图会根据本文提出的判断机制进行有效融合,得到最终的目标位置.

2.1.1 目标特征选择分析

在视觉跟踪的应用中,CN特征[15]是一种比灰度特征更具判别能力的多通道全局表征特征[5],其在运动物体快速运动和变形的情况下取得很好的跟踪效果,但在光照剧烈变化下处理效果不理想;而HOG特征[16]作为描述图像局部区域轮廓、形状的局部特征,光照变化对其检测效果影响不大,但在目标快速运动和变形环境下跟踪能力有所下降.不同環境下两种特征单独使用的跟踪效果见图1.因此,本文分别选择CN特征和HOG特征构建独立的相关滤波器,并将两者所输出的响应图进行有效融合,以此弥补在不同环境下单一滤波器跟踪性能的不足之处.

2.1.2 响应图信息融合判断机制

由2.1.1节分析可知,基于CN特征和基于HOG特征的两个相关滤波器是互补的,两者结合能够适应更多复杂的跟踪场景,但是如何有效地将它们所输出的响应图信息融合仍然是值得深究的一个问题.目前,在视觉跟踪领域中基于特征信息融合的手段主要有两大方面,一是特征层面上的特征串接,即将提取的CN特征与HOG特征转化为二维空间大小相同的多通道特征矩阵,然后两个矩阵串接起来训练和更新滤波器,如Li等[8]的SAMF方法和杨源等[11]的FMFPSA方法,该种手段并没有对特征的贡献度进行分析,只是将两种特征简单叠加,易将错误的特征信息引入到模型中,从而导致跟踪失败;另一方面是决策层面的响应图融合,即根据颜色特征和HOG特征的响应值比值来给两者分配权重,两种特征的响应值与权重相乘再相加得到最终的响应图,如王■等[10]的FAUT方法和Bertinetto

等[9]的Staple方法,该种手段对特征信息的权重占比进行了分析,但也只是简单地对两种特征的峰值进行比较或者是以两者的理想输出与实际输出的差值之和的比值作为判断依据,当出现伪峰值或两种特征的响应峰值差异较大时,上述的判断依据便会失去准确性,如图2所示.

图2(a)中CN特征对应的峰值较HOG特征的小,但是CN特征定位精度比HOG特征的高,此时若以两者峰值的比值作为权重的分配依据则会带来较大的定位误差;图2(b)中CN和HOG特征对应的响应图分布情况相似,但此时HOG特征定位精度远高于CN特征,若以理想输出与实际输出的差值之和的比值作为特征融合依据,也会导致目标定位误差;图2(c)中CN特征出现伪峰值,此时若采用上述任一判断依据均会造成目标定位失败.基于上述分析可知,决策层面的响应图信息融合更具有合理性,但是其融合判断手段的可靠性和准确性不足.经过大量实验分析可知响应峰值、定位精度以及历史峰值的均值存在一定的关系.因此,本文以历史峰值的均值为基础提出一种新的响应图信息融合判断机制,步骤如下.

Step 1. 已知信息:第t-1帧图像的CN滤波器和HOG滤波器参数、目标模板以及目标位置pt-1;两个滤波器从第1帧到第t-1帧历史峰值的均值AFcnt-1 和AF hog t-1 ;还有相应的阈值T cnl ,T cnu ,T hogl ,T hogu ,其中

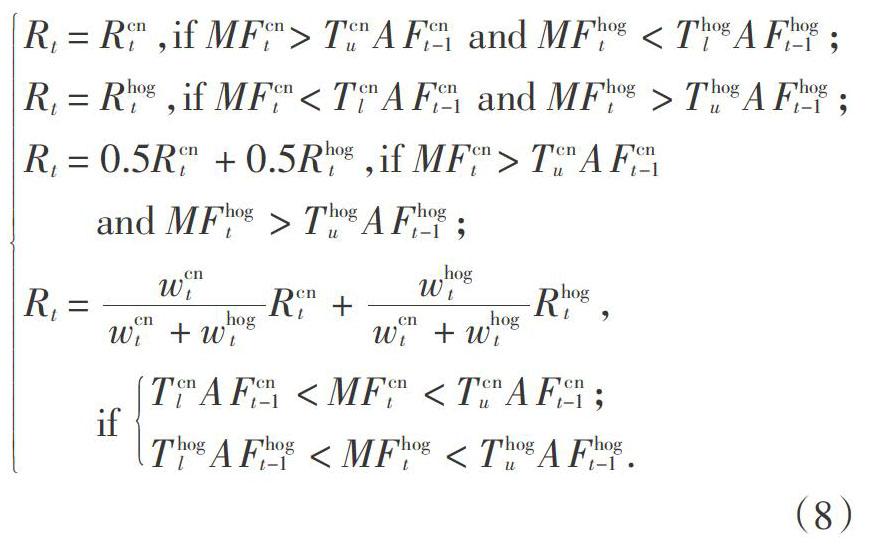

T cnl Step 2. 分别求取第t帧图像CN滤波器和HOG滤波器的响应图R cnt 、R hogt ,响应峰值MF cnt 、MF hogt ,并以式(7)求取参数wcnt ,whogt . Step 3. 按以下式(8)确定第t帧图像的响应图Rt. (8) 由上述步骤得到的响应图Rt中的最大值处即为目标位置pt,当式(8)中所有的条件均不能满足时,那么取第t - 1帧图像的目标位置作为第t帧图像的目标位置,即pt = pt - 1. 2.2 尺度评估的相关滤波器 目前,在视觉跟踪领域中针对目标尺度变化问题的主要解决方法是对目标建立尺度金字塔搜索模型,在跟踪过程中通过寻找金字塔模型中输出响应最高的尺度来作为目标的真正尺度[7-8,11,17],其中最具代表性的是Li等[8]SAMF方法和Danelljan等[7]的DSST方法.SAMF方法是将位置跟踪与尺度评估结合起来同时计算,即在设定的所有尺度中寻找最大的输出响应值对应的位置作为目标位置,同时该最大响应值所在的尺度作为目标尺度;DSST方法是首先确定目标的位置,在该位置上再通过尺度搜索来确定目标的尺度.这两种方法均取得了很好的跟踪效果,但DSST方法的跟踪速度要比SAMF方法的更快.因此,本文借鉴DSST方法中的尺度评估手段,并对其加以改进.尺度评估采用的是线性相关滤波器,其构建方式与KCF相似,只是将高斯核替换为线性核,在这里不再赘述其基本原理,只给出相应的计算公式,如式(9)和式(10)所示,具体细节请参考文献[7]. 式中:式(9)求取尺度评估滤波器的输出响应ys;ys中最大响应值对应的尺度即为目标尺度.式(10)更新尺度评估滤波器参数Al和B. f为具有d通道的训练样本特征,g为高斯函数产生的理想输出,zs为检测样本特征,λs和ηs分别为正则项和学习速率. DSST方法的尺度滤波器采用的特征是HOG特征,由2.1.1节分析可知,HOG特征在目标快速运动和变形情况下跟踪效果并不理想,CN特征在光照剧烈变化环境下会造成定位误差,同样在尺度评估中两种特征遇到相同的问题也会导致尺度估计偏差,具体情形见图3. 由图3分析可知,在不同环境下仅使用单一特征对目标进行尺度评估会造成一定的尺度偏差甚至跟踪漂移.因此,本文结合两种特征对目标进行尺度评估,即将CN和HOG特征拼接起来,增加目标的表征信息,以此代替DSST方法尺度滤波器的HOG特征.如图3所示,本文尺度滤波器对目标尺度的评估结果在图3(a)和(b)中均为最优,在图3(c)中次优,比仅使用单一特征尺度滤波器的性能有了较大的提升,同时其对跟踪环境的适用性更加广泛. 2.3 模型自適应更新 在目标跟踪过程中,由于跟踪环境的多样性和复杂性,常常会遇到一些挑战性问题,如光照剧烈变化、背景复杂和目标遮挡等,特别是在发生目标遮挡时,若此时还是继续以式(5)对滤波器参数和目标模板进行更新,则会将错误的目标表征信息引入到目标模板中,同时滤波器参数会出现偏差,最终导致后续的跟踪失败.因此必须制定一个更新策略,让跟踪算法自行判断是否发生目标遮挡,若是则不进行模型更新.经过实验分析可知,滤波器输出的响应图能够有效反映目标当前的环境状态,如背景复杂或发生遮挡等,见图4. 图4(a)显示在初始背景下滤波器输出的响应图是单峰的,且峰值很大,分布情况与理想高斯函数输出响应接近;图4(b)显示在复杂背景下滤波器输出的响应图虽然还是单峰的,但是峰值已经明显减小;图4(c)显示当目标发生部分遮挡时,滤波器输出的响应图是多峰的,且峰值已经降到很低,但依然能够成功定位目标;图4(d)显示当目标发生完全遮挡时,滤波器输出的响应图是多峰的,峰值很低,此时最大峰值位置可能并不是目标位置,即出现伪峰值,导致后续的跟踪失败. 由图4分析可知,在目标跟踪过程中,可以根据滤波器输出响应图的分布情况来判断目标是否发生遮挡.为了将响应图的分布情况转化为一个量化指标,本文参考文献[13],引入峰值旁瓣比(Peak to Sidelobe Ratio,PSR)对响应图的分布情况进行统计,并将PSR作为模型更新的一个置信度指标,PSR的计算方法如下:

PSRt (11)

式中: p为响应图最大值(峰值),峰值周围的区域定义为旁瓣区域;μ和σ分别为旁瓣区域所有响应值的均值和标准差.实验中旁瓣区域定义为峰值周围 11×11的区域.PSR越大,表明跟踪质量越好.为了使模型更新策略更可靠,本文将响应图输出的最大值 Fmax作为另一个置信度指标,只有当这两个指标均大于其历史均值APSR 和AFmax的一定比例β1和β2,如式(12)所示,才认为是高置信度,并以式(6)对滤波器参数和目标模板进行更新,具体过程见图5及其分析结果.

由图5分析可知,Coke序列的第254帧和260帧分别发生目标部分遮挡和完全遮挡,此时响应图的PSR和最大响应值均小于其历史均值的β1和β2 倍,因此不对模型进行更新,避免将错误的目标表征信息引入到模型中;第275帧中,当目标不被遮挡,由于模型没有被污染,则又能重新正确跟踪目标,此时其响应图的PSR和最大响应值均大于其历史均值的β1和β2倍,可以对模型进行更新.

2.4 方法整体流程

综合上述,MCFC方法的整体流程图如图6所示,方法的主要跟踪步骤如下.

输入:第t帧图像It;第t-1帧图像的目标位置pt-1和尺度大小st-1,CN和HOG特征位置跟踪滤波器参数 αcn t-1,αlog t-1和目标模板xcn t-1,xlog t-1,尺度评估滤波器参数At-1,Bt-1;

输出: 第t帧图像目标位置pt和目标尺度st,CN和HOG特征位置跟踪滤波器参数αcn t ,αlog t 和目标模板 xcn t ,xlog t ,尺度评估滤波器参数At,Bt.

目标定位:

Step 1. 以第t-1帧的目标位置pt-1和尺度st-1为基础,在图像It中提取CN和HOG特征检测样本

zcn t ,zlog t ;

Step 2. 利用zcn t 和zlog t 通过式(4)分别计算CN和HOG特征位置跟踪滤波器的输出响应ycn t ,ylog t ,并根据式(7)将ycn t 和ylog t 融合为yt;

Step 3. 确定yt中最大值位置即为目标位置pt.

尺度评估:

Step 4. 以第t帧目标位置pt和第t-1帧目标尺度 st-1为基础,在图像It中分别提取CN和HOG特征,并将两者拼接为CN-HOG特征检测样本zs,t;

Step 5. 利用zs,t通过式(8)计算尺度评估滤波器的输出响应ys,t;

Step 6. 确定ys,t中最大值对应的尺度即为目标尺度st.

模型更新:

Step 7.以第t帧目标位置pt和尺度st为基础,在图像It中分别提取CN和HOG特征位置跟踪滤波器的训练样本xcn t ,xlog t ,尺度评估滤波器的训练样本ft;

Step 8. 根据式(10),利用xcn t 和zcn t ,xlog t 和zlog t 通过式(5)分别将CN和HOG特征位置滤波器参数更新为αcn t 和αlog t ,目标模板更新为xcn t 和xlog t ;

Step 9. 根據式(10),利用ft通过式(9)将尺度评估滤波器参数更新为At,Bt.

3 实 验

本文的仿真实验均在CPU为Intel Corei5-6400、主频为2.70 GHz、8 GB内存的计算机环境下通过MATLAB2016a软件平台进行实现.算法的参数设置具体如下:目标特征提取区域的大小设置为目标大小的2.5倍;相关滤波器的正则化参数λcnp =10-2,λhogp = 10-4,λs = 10-2;高斯核宽σcnp = 0.2,σhogp = 0.5;学习速率ηcnp = 0.075,ηhogp = 0.02,ηs = 0.02;尺度步长a = 1.02和尺度采样个数S = 33.通过大量的实验对比分析,当响应图融合判断阈值T cnl = 0.3,T cnu =0.75,T hogl = 0.25,T hogu = 0.65,模型自适应更新比例系数β1 = 0.3,β2 = 0.45时,算法能得到最好的跟踪性能.在实验过程中,所有的参数设置固定不变.

为了充分验证本文MCFC跟踪方法的跟踪鲁棒性和准确性,我们将使用OTB2013[19]测试数据集50个视频序列,其中包括具有尺度变化的28组视频和目标遮挡的27组视频等,并与当前主流的相关滤波跟踪算法进行对比.选取的算法有:CSK[4]、KCF[6]、CN[5]、Staple[9]、SAMF[8]、DSST[7].其中,使用单特征的有:CSK(灰度特征)、KCF(HOG特征)、CN(CN特征)、DSST(HOG特征);使用特征融合的有:Staple(颜色统计特征+HOG特征)、SAMF(CN特征+HOG特征);考虑目标尺度评估的有:Staple、SAMF、DSST.接下来,我们将根据实验结果从定性和定量两个方面分析7种跟踪算法的性能.

3.1 定性分析

图7展示的是实验中7种跟踪算法的部分跟踪结果.根据视频序列中不同的跟踪环境条件,我们将从以下6个方面对算法的性能进行定性分析:

1)光照变化:以“Shaking”和“Human7”为例.由图7(a)和(b)分析可知,当运动目标所处环境发生剧烈的光照变化时,大部分的跟踪算法都发生了跟踪漂移,而MCFC方法却始终能够稳定地跟踪目标,表明该算法对光照变化具有较好的鲁棒性.

2)尺度变化:以“Skating1”和“Board”为例.由图7(c)和(d)可知,在跟踪过程中,当运动目标的尺度发生变化时,大部分的跟踪算法都能成功定位目标,并且SAMF、DSST、Staple和MCFC算法都能实现目标尺度的自适应变化,但本文的MCFC算法的尺度评估方法更加准确.

3)目标旋转:目标旋转包括平面内旋转和平面外旋转.平面内旋转以“BlurOwl”和“Shaking”为例,在图7(a)和(e)中,目标发生了平面内旋转,此时要求算法采用的特征具有高度的旋转不变性,而本文采用的CN特征具有旋转不变性,所以能够很好适应这种情况;平面外旋转以“Board”和“Football”为例,在图7(d)和(f)中,目标发生平面外旋转,此前建立的目标模型会失效,而本文加入了模型自适应更新策略,当目标恢复之前状态,仅有本文MCFC算法成功定位目标.

4)背景复杂:以“Couple”和“Football”为例.在背景复杂的跟踪环境下,如图7(f)和(h)所示,要求跟踪算法具有较高的准确性,而在这两个视频序列的整个跟踪过程中,只有MCFC算法能准确跟踪目标.

5)目标遮挡:以“Girl2”和“Box”为例.在图7(i)和(j)中,目标分别发生了部分遮挡和完全遮挡,由于本文的MCFC算法引入了模型自适应更新策略,有效减少了将错误的目标信息更新到目标模型中,对目标遮挡情况具有较高的鲁棒性,因此始终能准确跟踪目标.

6)运动模糊:以“BlurOwl”和“BlurBody”为例.由图7(e)和(h)可知,当目标发生运动模糊时,由于本文有效的响应图信息融合判断机制,在两个视频序列的整个跟踪过程中,只有本文的MCFC算法能一直正确跟踪目标.

3.2 定量分析

本文将采用以下几个评价指标[19]对跟踪算法进行定量分析.

1)中心位置误差(center location error,CLE):跟踪算法检测的目标中心位置与标定的目标中心位置之间的平均欧式距离;

2)距离精度(distance precision,DP):视频中CLE小于某一设定距离阈值的帧数与总帧数的百分比;

3)重叠精度(overlap precision,OP):跟踪算法预测的目标框与标定的目标框之间的重叠面积与总面积的比值超过某一设定重叠阈值的视频帧数与总帧数的百分比;

4)精度曲线:横轴为给定的距离阈值,纵轴为对应的DP,通常取阈值为20个像素时精度曲线值(P20)为典型值;

5)成功率曲线:横轴为给定的重叠阈值,纵轴为对应的OP,将曲线下方的面积(AUC)作为该曲线的典型值.

本文共设置了三组实验,第一组是7种算法的单个视频跟踪性能的定量分析;第二组是7种算法的综合性能的定量分析;第三组是对比7种算法的平均跟踪速度.

实验1:单个视频跟踪性能的定量分析

针对上述的10组视频序列,采用CLE、DP和OP三个评价指标对7种算法的跟踪性能进行对比分析.表1为7种跟踪算法在10组视频中的CLE、DP和OP结果.表中有下划线的数据表示最优结果,有点式下划线的数据为次优结果(下文采取同样表述方式).取每种算法在10组视频中的平均CLE、DP(距离阈值为20像素)和OP(重叠阈值为0.5)的平均值作为判断依据,在这三个评价指标中,MCFC算法均取得最优结果,表明本文算法能够很好地适应不同的跟踪环境,具有较好的跟踪性能.

实验2:算法综合跟踪性能的定量分析

为了综合评比7种算法的跟踪性能,选用OTB2013的50组视频序列进行测试分析,采用精度曲线和成功率曲线两个评价指标来进行综合跟踪性能的定量分析.

图8为7种算法在50组视频中的整体精度曲线和成功率曲线.由图8分析可知,采用多特征的MCFC、Staple和SAMF算法的精度和成功率明显高于采用单特征的KCF、DSST、CN和CSK算法.这表明对目标使用多特征描述能够增强跟踪算法的判别能力,提高跟踪性能.在MCFC、Staple和SAMF三种算法中,MCFC的精度(P20)和成功率(AUC)均是最高的,比第二名的Staple分别提高7.5%和4.4%,证明本文MCFC算法的有效性.

为了进一步对比7种算法在不同的跟踪环境条件下的跟踪性能,在50组视频中分别求取每种算法在11种跟踪环境条件[19]下的DP和OP,结果如表2和表3所示.11种跟踪环境包括:光照变化(Illumination Variation,IV)、平面外旋轉(Out-of-Plane Rotation,OPR)、尺度变化(Scale Variation,SV)、遮挡(Occlusion,OCC)、变形(Deformation,DEF)、运动模糊(Motion Blur,MB)、快速运动(Fast Motion,FM)、平面内旋转(In-Plane Rotation,IPR)、不在视野内(Out-of-View,OV)、背景复杂(Background Clutters,BC)、低分辨率(Low Resolution,LR).

由表2數据可知,MCFC算法的距离精度除了在LR跟踪环境下的结果为次优,其余的均为最优结果,如SV、OCC等;由表3数据可知,MCFC算法的重叠精度在大部分跟踪环境下均为最优结果,如SV、OCC等,其余也为次优结果.综合表3和表4的数据,结果表明了MCFC跟踪方法在目标遮挡、目标变形等跟踪环境下具有较高的鲁棒性和准确性,充分验证了本文所提的响应图信息融合判断机制、尺度评估方法以及模型自适应更新策略的有效性.

实验3:7种算法的平均跟踪速度对比

为了验证本文MCFC方法的实时性,分别求取7种算法在50组视频中的平均跟踪速度,结果如表4所示.MCFC算法在取得最好跟踪精度和成功率的同时,其平均跟踪速度值为15.6帧/s,仍具有较快的跟踪速度.

4 结 论

本文提出了一种多相关滤波器组合的目标跟踪方法,位置跟踪相关滤波器用于目标的准确定位,尺度评估相关滤波器用于目标的尺度估计.主要改进的地方有3处:提出一种以历史响应峰值的均值为基础的响应图信息融合判断机制,提高了目标跟踪算法的定位精度;将CN和HOG拼接作为尺度评估滤波器的使用特征,提高了跟踪算法尺度估计的准确性;结合历史响应峰值的均值和PSR的模型自适应更新策略,有效解决目标遮挡、目标平面外旋转等问题,提高了跟踪算法的鲁棒性.

由于本文MCFC算法在目标定位和尺度评估上均使用了CN和HOG特征,造成了跟踪速度下降,但在获得更高跟踪性能的同时,仍具有较快的跟踪速度.将来可以通过特征降维等手段减少算法的计算量,在保证跟踪性能的基础上提高跟踪速度.同时可以结合深度学习方法来融合多分辨率的特征图,以此提高本文MCFC算法的跟踪性能.

参考文献

[1] 高文,朱明,贺柏根,等. 目标跟踪技术综述[J]. 中国光学,2014,7(3):365—375.

GAO W,ZHU M, HE B G,et al. Overview of target tracking technology [J]. Chinese Optics,2014,7(3):365—375.(In Chinese)

[2] LI X,HU W,SHEN C,et al. A survey of appearance models in visual object tracking[J]. ACM Transactions on Intelligent Systems & Technology,2013,4(4):1—58.

[3] SMEULDERS A W M,CHU D M,CUCCHIARA R,et al. Visual tracking: An experimental survey[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence,2013,36(7):1442—1468.

[4] RUI C,MARTINS P,BATISTA J. Exploiting the circulant structure of tracking-by-detection with kernels[C]//European Conference on Computer Vision. Springer-Verlag,2012:702—715.

[5] DANELLJAN M,KHAN F S,FELSBERG M,et al. Adaptive color attributes for real-time visual tracking[C] //IEEE Conference on Computer Vision and Pattern Recognition. IEEE Computer Society,2014: 1090—1097.

[6] HENRIQUES J F,CASEIRO R,MARTINS P,et al. High-speed tracking with kernelized correlation filters[J]. IEEE Transactions on Pattern Analysis & Machine Intelligence,2015,37(3):583—596.

[7] DANELLJAN M,HAGER G,KHAN F S. Accurate scale estimation for robust visual tracking[C]//British Machine Vision Conference. 2014:65.1—65.11.

[8] LI Y,ZHU J K. A scale adaptive kernel correlation filter tracker with feature integration[C]//European Conference on Computer Vision. Springer,Cham,2014:254—265.

[9] BERTINETTO L,VALMADRE J,GOLODETZ S,et al. Staple: complementary learners for real-time tracking[C] //Computer Vision and Pattern Recognition. IEEE,2016:1401—1409.

[10] 王,王春平,李軍,等. 特征融合和模型自适应更新相结合的相关滤波目标跟踪[J]. 光学精密工程,2016,24(8):2059-2066.

WANG W,WANG C P,LI J,et al. Correlation filter tracking based on feature fusing and model adaptive updating[J]. Optics and Precision Engineering,2016,24(8):2059—2066.(In Chinese)

[11] 杨源,库涛,查宇飞,等. 快速多特征金字塔的尺度目标跟踪方法[J]. 西安交通大学学报,2016,50(10):49-56.

YANG Y,KU T,ZHA Y F,et al. Fast multi-feature pyramids for scale-adaptive object tracking[J]. Journal of Xi′an Jiaotong University,2016,50(10):49—56.(In Chinese)

[12] 熊昌镇,赵璐璐,郭芬红. 自适应特征融合的核相关滤波跟踪算法[J]. 计算机辅助设计与图形学学报,2017,29(6):1068—1074.

XIONG C Z,ZHAO L L,GUO F H. Kernelized correlation filters tracking based on adaptive feature fusion[J]. Journal of Computer-Aided Design & Computer Graphics,2017,29(6):1068—1074.(In Chinese)

[13] BOLME D S,BEVERIDGE J R,DRAPER B A,et al. Visual object tracking using adaptive correlation filters[C] //Computer Vision and Pattern Recognition. IEEE,2010: 2544—2550.

[14] CORTIS C,VAPNIK V. Support-vector networks[J]. Machine Learning,1995,20(3):273—297.

[15] WEIJER J V D,KHAN F S. An overview of color name applications in Computer Vision[C]//Computational Color Imaging. Springer International Publishing,2015:16—22.

[16] DALAL N,TRIGGS B. Histograms of oriented gradients for human detection[C] // IEEE Computer Society Conference on Computer Vision and Pattern Recognition. IEEE,2005: 886—893.

[17] 沈秋,严小乐,刘霖枫,等. 基于自适应特征选择的多尺度相关滤波跟踪[J]. 光学学报,2017,37(5):166—175.

SHEN Q,YAN X L,LIU L F,et al. Multi-scale correlation filtering tracker based on adaptive feature selection[J]. Acta Optica Sinica,2017,37(5):166—175.(In Chinese)

[18] 马晓楠,刘晓利,李银伢. 自适应尺度的快速相关滤波跟踪算法[J]. 计算机辅助设计与图形学学报,2017,29(3):450—458.

MA X N,LIU X L,LI Y Y. Fast scale-adaptive correlation tracking[J]. Journal of Computer-Aided Design & Computer Graphics,2017,29(3):450—458.(In Chinese)

[19] WU Y,LIM J,YANG M. Online object tracking: a benchmark[C]//IEEE Conference on Computer Vision and PatternRecognition.

2013:2411—2418.