移动网络定位研究进展

张 毅,徐昌庆,万 群

(1.华为技术有限公司,上海 201206;2.上海交通大学电子信息与电气工程学院,上海 200240;3.电子科技大学信息与通信工程学院,成都 611731)

0 引言

移动网络定位是对卫星定位系统的重要和有益补充,尤其是在卫星信号覆盖不足的区域或多径丰富的区域,如室内、密集城区等。移动网络自身的技术特点如多天线、大带宽、高覆盖率等,使得其在定位领域具备独特价值。随着物联网、车联网的广泛应用,多种定位技术将相互补充、相互融合,提供高可用性、高精度、高可靠的综合定位解决方案。

典型的无线网络定位技术包括:小区ID识别、基于接收信号强度的射频指纹匹配或传播距离推算,以及基于无线信号到达时间/到达时间差、到达角度估计的算法等。此外,第三代合作伙伴计划(3rdGeneration Partnership Project,3GPP)在标准中也制订了与全球导航卫星系统(Global Naviga-tion Satellite System,GNSS)、惯性测量单元(Iner-tial Measurement Unit,IMU)、Wi-Fi以及气压计等多种定位源融合的协议规范。

上述定位技术中,基于小区ID识别的定位精度取决于基站覆盖半径或站间距,一般误差在数十到上百米之间;基于接收信号强度的射频指纹匹配技术,由于需要大量的指纹采集和维护工作,在实际工程应用中难度较大;基于接收信号强度的传播距离推算,同时受无线信道模型、收发天线位姿及方向图、馈线损耗等多重因素影响。在4G和5G无线网络中,基于到达时间/到达时间差、到达角度等以参数估计为基础的定位技术,以及多源融合定位技术,日益成为研究的重点。

参照一般业界观点,本文把基于小区ID识别、接收信号强度的指纹匹配或传播距离推算的技术归为非参数估计定位技术;把基于到达时间/到达时间差以及到达角度的技术归为参数估计定位技术;而与GNSS、IMU、Wi-Fi、气压计的融合等归为融合定位技术。

1 基于非参数估计的移动网络定位关键技术

移动网络的基本单元为小区(cell),小区核心设备是基站,基站的主要功能模块包括天线/馈线、远程射频单元(Remote Radio Unit,RRU)、基带单元(Baseband Unit,BBU),以及主控与传输单元等。每个小区按照网络规划,覆盖一定的地理区域,在城市环境下,小区的典型覆盖半径为数百米;在郊区环境下,小区的典型覆盖半径为数千米。终端用户一般指手机,通过同步与随机接入过程,建立起与小区的连接,进行数据和话音传输。移动网络通过cell ID标识每个小区。因此,网络侧可以用终端用户接入小区的cell ID及其覆盖的地理区域来粗略表征位置,如图1所示。作为最基本的定位方法,其已经在全球部分运营商网络中获得商用。

图1 基于小区ID的定位Fig.1 Cell ID based positioning

单纯基于小区ID的定位方案,精度受小区覆盖半径的影响,一般误差较大,需要与其他技术结合。

基于接收信号强度的定位方法可大致划分为传播路径长度推算和射频指纹匹配两种。前者依赖于无线信号的空间传播损耗,其中空旷的自由空间传播损耗公式如下:

Lfs=32.44+20lgd+20lgf

(1)

式中,路径损耗与传输距离d平方成正比,与信号频率f平方成正比。实际应用场景中,考虑多径等因素的影响,传播损耗与传输距离立方甚至更高的n次幂成正比,n为路径损耗因子。此外,多个国际技术组织如EURO-COST也针对不同场景,通过大量实测数据,拟合了空间传播损耗模型,典型的如COST231-Hata模型[1]应用于郊区场景的路径损耗公式如下:

L(dB)= 46.33+(44.9-6.55lght)lgd+

33.9lgf-((1.1lgf-0.7)hr-1.56lgf+0.8)-13.82lght

(2)

其中,ht为发射天线高度,hr为接收天线高度。

对室内传播而言,由于一般遮挡或反射及折射严重,加之近场效应的存在,很难得到一个通用性好的空间传播损耗模型。

在接收机侧,信号强度还受基站和终端天线增益、馈线损耗等因素的综合影响:

RSRP=Pt+Gr+Gt-Lc-L

(3)

其中,Pt为信号发射功率,Gr、Gt分别为接收机和发射机的天线增益,Lc为馈线损耗(以上参数均表示为dB值)。其中,天线增益G本身受水平和垂直方向性的影响,与位置有关,而路径损耗因子与天线挂高、传播环境相关,很难事先测定或建模,这些都决定了算法的应用有效性及精度一般难以达到预期。

基于接收信号强度的指纹算法基于如下假设:每个位置及其周边一定范围区域的接收信号强度相近,可通过将基站覆盖区域划分成若干网格,长期手动或自动采集网格中的接收信号强度,并建立数据库,作为后续射频指纹匹配的基础。根据待定位终端的接收信号强度,采用K最邻近(K-Nearest Neighbor, KNN)等准则[2],判断终端所在网格,如图2所示。

图2 基于网格的射频指纹匹配Fig.2 Grid based radio-finger-print matching

此类方法有其实用价值,可用于手机分布的热力图研究,并提升无线网络规划性能,在中国移动(China Mobile Communications Group Co.,Ltd.,CMCC)等网络有所应用。该方法的主要问题包括:采集及建库工程量大,在采集过程中,需要已知终端位置(实际工作中一般通过最小化路测(Minimization of Drive-Test,MDT)实现);待定位终端的姿态一般是不确定的,不同的倾斜角度、不同的持握方式,或者同一水平位置不同的垂直高度,都使得接收信号强度会离预期值有较大的偏差。

此外,接收信号强度也可与小区ID一起,进一步提升定位精度,构成增强cell ID技术,并在运营商网络中逐步推广应用,目前国内某运营商正在广州测试验证。

2 基于参数估计的移动网络定位关键技术

移动网络定位中的参数估计包括:到达时间(Time Of Arrival,TOA)、上行信号到达时间差(Uplink Time Difference Of Arrival,U-TDOA)、下行信号到达观测时间差(Observed Time Difference Of Arrival,O-TDOA),以及上行信号到达角度(Angle Of Arrival,AOA)等。基于参数估计的定位方案和算法理论上可获得更高的精度,部分场景下甚至接近实时动态(Real-Time Kinematic,RTK)定位的性能,目前主流的移动网络运营商如CMCC、Vodafone、DT、Verizon及设备制造商Huawei、Ericsson、Nokia、ZTE和芯片厂商如Qualcomm、HiSilicon等都在此领域投入了大量技术和标准研究。

其中,TOA技术通过测量无线电信号的传播时间,乘以电磁波传播速度来计算节点之间的距离,进而解算用户终端位置。在某些场景下,TOA和飞行时间(Time Of Flight,TOF)可混用,均指无线信号在收发天线相位中心之间的传播时间。直接采用TOA算法面临的问题是发射机和接收机必须精确同步,在传输信号的过程中需要标记时间戳。典型的实现方式如下:

(4)

如图3所示,Tround和Tprop分别表示由基站和终端时间戳标记的环回和响应时间。由公式可知,TOF精度与环回/响应时间有关,时间越长,误差越大,此外基站和终端时钟偏差越大,TOF也越大。在此基础上,可引入双边双向测距,抑制时钟偏差影响。

TOA/TOF在部分定位系统如超宽带(Ultra Wideband,UWB)中有所应用,Decawave公司的芯片即支持该方案,但需要多次交互,功耗较大且定位用户容量较低,更重要的是需要标定天线等器件的群时延并予以补偿,这在实际无线通信网络中实现是比较困难的,因此一般较少直接应用(LTE 36.214标准中定义了类似的机制,但几乎没有厂家开发此特性,也没有在网络中得到应用)。业界更倾向于通过多个站点TOA求差,得到TDOA,消除非理想同步的影响,也无需通过复杂机制添加时间戳。TDOA算法的核心思想是通过检测信号到达多个测量单元的时间差,在此基础上解算终端相对位置。TDOA算法解算终端二维坐标,可以用3个不同的基站测量得到2组TDOA值,终端位于由2组TDOA确定的双曲线的某一支上,如图4所示。解算三维坐标需要至少4个基站。

TDOA算法是对TOA算法的改进,不直接使用信号到达时间,不需要加入专门的时间戳,可应用于现有移动通信系统,对网络的要求相对较低。

目前主流的终端芯片都已支持O-TDOA,即手机接收基站发射的定位导频信号(Positioning Reference Signal,PRS)并测量反馈导频时间差(Reference Signal Time Difference,RSTD)到服务器,由服务器解算。由于北美有E911强制要求,Verizon、Rogers等运营商均支持该定位方式,北美销售的LTE终端普遍也开通了此功能。国内没有类似的强制要求,出于隐私保护的考虑,网络和终端没有开通此类业务,这也给用户报警等紧急情况下的定位带来一定的困难。

AOA算法是利用阵列天线测量信号入射方向,进而估算出用户终端位置。该方案需要在不同的地方部署2个及以上带有天线阵列并校准的节点。特别地,在已知基站和终端高度时,可通过俯仰角和方位角估计信息,利用单节点实现定位;此外,在得到AOA和TOF估计值的情况下,也可以通过求解表征角度的射线与表征传播距离的圆的焦点,实现单节点定位。在现有移动网络中,由于阵元数目、间距等约束,以及施工过程中有时没有准确标定阵列方位角,AOA算法没有得到普遍应用,但基于上述单节点定位等特性,预计在5G网络中的应用会逐步广泛,下文中有所论述。

2.1 移动网络定位中的TOA/TDOA参数估计算法

对TOA进行估计,在信道单径条件下可推导其无偏估计方差的克拉美罗下界[3-4]为:

(5)

同理,多径下TOA参数估计的精度取决于无线信号的带宽、接收信噪比、多径分量的组成[5]。为接近或达到上述理论界,同时兼顾实现复杂度等工程约束,需要仔细选择并优化TOA/TDOA估计算法。

TOA/TDOA估计算法一般包括如下几类:

1)基于互相关、广义互相关、匹配滤波等相关类算法,接收机采用本地参考信号在时域循环移位与接收信号做相关运算,寻找峰值最大的点,将其坐标作为对应的时延量。

具体实现中,如果接收机具备快速傅立叶变换(Fast Fourier Transformation,FFT)加速器,时域循环相关运算也可以转换为频域乘法,降低复杂度。此类方法受多径等因素影响较大,性能相对有限,一般用在GNSS或移动通信网络的信号捕获阶段。

广义互相关法(General CrossCorrelation,GCC)[6]作为这类方法的代表,通过对接收信号进行预处理,使参考信号与接收信号的相关峰更尖锐,从而提升估计性能。常用的GCC加权函数包括:ROTH、SCOT、PATH等,此类加权函数的构造需要信号和噪声的统计信息,在实际系统中一般难以获取。

2)基于特征结构的估计方法。

此类方法以对接收信号协方差矩阵特征分解为基础,根据特征值分布,分离信号子空间和噪声子空间,进而通过空间谱估计得到接收信号的TOA值。此类方法包括MUSIC[7-8]、Root-MUSIC、MUSIC-Tde[9]、ESPRIT[10]、最大熵谱等,能在样本数较少的情况下,实现小于采样时间的超分辨率估计,相对于Capon[11]等波束成形算法在分辨率上有优势。这些算法的一般问题是运算量较大,尤其是大规模协方差矩阵的特征值分解非常复杂,为提升综合效率一般采用定点化运算,往往导致噪声子空间估计误差累积。此外,此类算法在衰落信道下性能有所恶化。

将空间谱估计领域算法用于TOA/TDOA估计可得到小于采样间隔的估计值。典型的MUSIC算法得到协方差矩阵并分离噪声子空间后,计算伪谱:

(6)

其中,A表示导向矢量或信号阵列,UN表示由特征分解得到的噪声子空间,通过在PMUSIC表征的伪谱上搜索峰值来求解参数估计值。算法要求噪声为加性高斯分布(Additive White Gaussian Noise,AWGN)、噪声与信号之间相互正交、多个信号源之间相互独立或通过空间平滑[12-13]等算法去相关。此外,信源数目的估计精确性也会对性能造成一定的影响,常用算法包括基于信息论的MDL[15-16]、AIC[17]等,普遍存在要求样本或快拍数较多、信噪比较高等问题,其中AIC在信源数较少时还存在过估计的问题。

3)基于代价函数的估计方法

通过建立代价函数并以平均代价最小为准则,求解最优时延估计值。常见算法包括最小均方误差(Minimum Mean Squared Error,MMSE)、最大似然(Maximum Likelihood,ML)、非线性最小二乘(Non-linear Least Squares,NLS)等。此类算法一般对信号统计特征无要求,理论上可实现分辨率小于采样时间的超分辨率时延估计。多径信号的时延估计问题属于多维优化,直接使用最大似然法的计算复杂度很高。基于ML准则的最大期望(Expectation Maximum,EM)[18]、基于MMSE准则的WRELAX[19]等算法通过一维优化代替多维优化,尝试简化复杂度。在 EM 算法中,多维优化的多参数估计问题被转换成多个一维优化问题,通过参数迭代的方法求取多个一维问题的最优解,该方法在控制算法复杂性的同时不降低算法的估计精度。

4)SAGE/CAF等多径迭代求解算法

在上述算法的基础上,新的算法如利用信道稀疏性的稀疏表示[20-22],以及SAGE[23]、CAF[24]等算法不断涌现,为实现超分辨率时延估计进一步提供了可能。

其中基于交叉模糊度函数(Cross Ambiguity Function,CAF) 的信道参数估计方法在无线信道建模与参数估计方面都有一定的效果。与SAGE 类似,CAF也是一种迭代技术,每一次迭代估计一条径的参数,再根据估计所得的参数重构这条径的接收信号,然后从总的接收信号中减去该信号,如此循环迭代,直到估计出所有多径信号的参数为止。将第m个天线的接收信号xm(t)和训练信号s(t)的交叉模糊函数定义如下:

(7)

只要xm(t)和s(t)的时延和Dopper频移不重叠,就可以在CAF域将这2个信号分开。如果入射到接收天线阵列上的信号相位未知,那么可以利用所有天线单元输出端的CAF幅度的平均值粗略估计信号的时延和Doppler频移,即定义非相干CAF如下:

(8)

一旦交叉模糊函数的峰值位置确定,可以定义如下形式的向量Pi:

(9)

而波达角则可以通过下面的优化问题估计:

有了第i条径的角度信息就可以把各个天线单元接收到的该条径相干叠加, 并且可以基于此计算相干交叉模糊函数:

(10)

接下来借助第i条径的波达角、时延、Doppler频移和接收阵列的结构特征,重构该条径在各个接收天线单元的接收信号:

(11)

其中,βm,i是第i条径到达第m个天线的衰减因子,βm,i可以通过下式估计:

(12)

(13)

一旦得到衰减因子βi,就可以完全重构出第i条径对应的接收信号,因此,可以从总的接收信号中把这条径对应的信号减去。然后重复上述过程,继续估计剩余的多径参数。

5)基于人工智能的参数估计

随着人工智能、机器学习、深度学习[25]等技术的兴起,陆续有学术界和工业界的专家学者探索将其用于参数估计。

图5中,输入层可设置为频域或时域信道CSI数据,隐含层可设置为2~3层或更多,输出为TOA或AOA参数估计值。华为公司无线定位能力中心采用10万个信道数据作为样本,其中7万个用作训练,3万个用于测试,从仿真结果来看性能较好,但用实际数据测试发现泛化能力还待加强,而且目前深度学习技术尚处于黑盒阶段,难以跟踪并定位其中的问题,在实际应用还需要进一步加深研究。

图5 基于机器学习的参数估计Fig.5 Machine learning based parameter estimation

6)TOA估计的其他研究领域

业界研究的热点还包括多径、多信号源、有色噪声、非平稳信号等环境下的时延估计,提出了高阶理论、分定分布、循环平稳等理论,解决上述模型下算法的有效性和鲁棒性问题。

传统TOA参数估计的克拉美罗界推导一般基于单天线系统。无线网络从4G开始,引入多天线技术以支持更大的系统容量。在此基础上,参数估计的克拉美罗界预计会进一步下降,仿真均方根误差(Root Mean Squared Error,RMSE)结果也基本证明了这一点,目前业界还没有完成并公开详细理论推导。

对TDOA定位而言,需要在定位节点之间保证精准同步,常见的同步方式包括GNSS、1588V2等。通过光纤分布式网络传送时钟信息,可以实现ns甚至更高精度级同步。在以太网上,也成功实现了ns级同步。此外,合理的空口同步方式,也可接近类似的性能。

7)TOA/TDOA定位进展

华为公司无线定位能力中心与上海交大导航所、电子科大、东南大学、西电、光电院测地所等单位合作,在交大闵行校区利用LTE网络,实现了10m以内精度的定位,并采用NR 100MHz带宽信号,在某机场实现了亚米级定位。

2.2 移动网络定位中的角度参数估计算法

与基于TOA/TDOA的定位方法相比,基于AOA的方法优势在于:不同基站之间(或用户终端与基站之间)不需要高精度同步,理论上定位需要的基站数也少于TDOA。

用于AOA测量的常见天线阵列包括:

1)均匀线阵

如图6所示,均匀线阵(Uniform Linear Array, ULA)是常见的阵列形式,各阵元均匀分布在一条直线上。ULA是一般算法研究的基础,在移动网络中可用于估计终端上行信号的入射角。常用算法包括CAPON、Bartlett、MUSIC以及压缩感知和稀疏表示等。在偏离ULA阵列法线的区域参数估计方差较大。此外在传统算法的基础上,可以通过快速傅里叶变换等多种方案降低运算复杂度。

图6 均匀线阵Fig.6 Uniform linear array

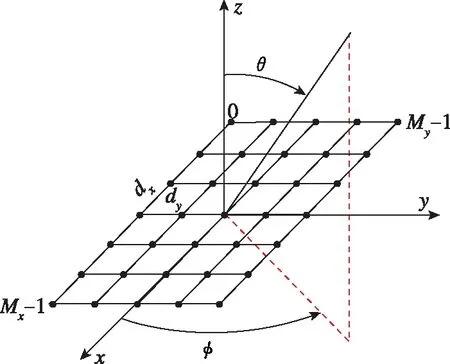

2)矩形阵列

矩形阵列是5G的备选阵列之一,如图7所示,天线阵元呈矩形分布。在此基础上,可以实现方位角和俯仰角的联合估计,进而实现一定场景下的单站定位。常见算法包括CAPON、Bartlett或二维MUSIC在大阵列下都比较有效,但需要重点解决运算复杂度的问题。

图7 矩形阵列Fig.7 Rectangular array

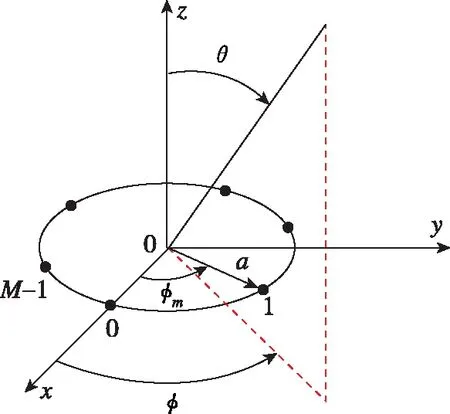

3)均匀圆形阵列

如图8所示,天线阵元均匀分布在圆周上。均匀圆阵可实现360°无模糊的方位角估计,同时实现俯仰角估计(在靠近法线的方向估计方差较大),但由于其导向矢量不具备范德蒙形式,需要采用模式激励[26]等算法进行变换。Quuppa公司将其应用到局域定位中,取得了一定的效果;在广域移动网络中,需要综合考虑多天线下的系统性能,包括容量和覆盖,圆阵用得很少。

图8 均匀圆阵Fig.8 Uniform circular array

4)实际天线阵列

实际应用中,移动网络基站天线设计出于兼容多个频点多种制式的考虑,一般阵列形式与上述经典形式不同,如普遍天线阵元间隔大于半波长,造成空间欠采样从而影响估计精度,甚至出现虚假谱峰现象;此外高增益定向天线垂直方向由多个阵列合成,在此情况下,传统的AOA参数估计算法也需要做相应优化,例如波束空间MUSIC[27]。

一般在角度估计算法研究中,默认已知信源数目或多径数目,这在实际系统中,往往是难以实现的,导致部分算法失效。

近年来出现的压缩感知(Compressed Sensing,CS)用于参数估计[28],用低于奈奎斯特采样率的信号压缩方法,可以在相同的阵列规模获取更多的目标信息和更高的分辨率。此外,还可以利用多个阵列共同进行定位计算。协阵列是一种应用比较广泛的联合角度估计方法,上海交大、电子科大等在研究使用多个阵元数量有限的阵列来提高估计性能。

在天线阵元数目有限的情况下,斯坦福大学提出的Spotfi算法[29]可以通过大带宽扩展二维空间-频域谱,并通过巧妙的方式实现了多径下的空间平滑,是一个不错的方案,相对于传统的角度-时延联合估计算法[30]具有一定优势。该算法在Wi-Fi上得到了验证,也可以推广到LTE或5G中,当然,其中采用MUSIC算法需要解决的径数估计问题,在有限快拍或样本下尚无高可信度的解决方案。

2.3 移动网络定位中的解算及滤波算法

移动网络定位解算算法相对成熟,常见的如LS及Fang[31]、Talyor[32]、Chan[33]等都有较好的性能,在实际测试中差异较小,但Taylor级数展开算法需要获取初值。在参数估计准确的条件下,可以结合GDOP、SNR等进行合理的定位站点选取,进一步优化解算性能。

特别地,对存在固定定时偏差的若干个基站,可采用Gauss-Newton法,实现多个终端的同时解算。但一般需要有相对精确的初始值,才能保证迭代过程收敛。

对移动终端的位置跟踪,可以采用卡尔曼滤波[34]、扩展卡尔曼滤波[35-36]或粒子群滤波,修正误差。

3 移动网络定位面临的技术挑战

移动网络定位面临的技术挑战包括:

1)定位节点数目受限。传统的卫星导航系统通过利用多颗在轨卫星实现目标定位,而移动通信网络一般基于容量和覆盖进行网络规划,客观上限制了能参与定位的基站数目,终端用户视距可见基站数目一般为1~4个。

2)无线传播环境复杂,用于测量和测距的无线信号受室内外传播环境如墙壁、物体、人等的遮挡和散射,导致不同程度的多径效应,从而影响TOA、TDOA、AOA的估计准确度;此外,多径导致的各信源相干,不能满足部分传统算法默认的条件,必须采用空间平滑等算法加以优化。

3)由于传播路径上障碍物的存在, 非视距(Non-Line of Sight,NLOS)导致信号首径丢失或者弱化,严重影响定位性能。目前业界已经有很多算法和方案尝试解决此问题,包括利用残差法[37]大概率识别NLOS站点、终端附加IMU进行航位推算,以及下文提到的标准中定义的定位Only站点。

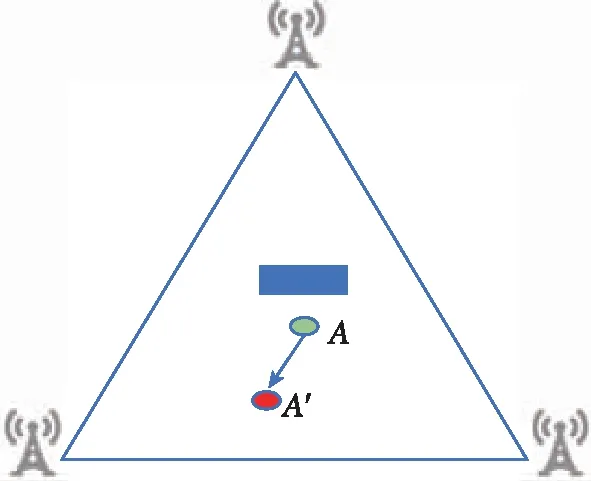

采用TDOA指纹匹配的算法,解决NLOS下的定位误差问题,是一种可能的方案,但在下述场景中,此类方案及算法仍然存在失效的可能,如图9所示。

图9 NLOS下的TDOA匹配Fig.9 Ambiguity of TDOA matching in NLOS

图9中,点A由于NLOS导致TDOA引入误差,解算到点A′,即A和A′有相似的TDOA值(归一化之后),单独的匹配无法正确区分这2个点。

4 移动网络定位相关标准

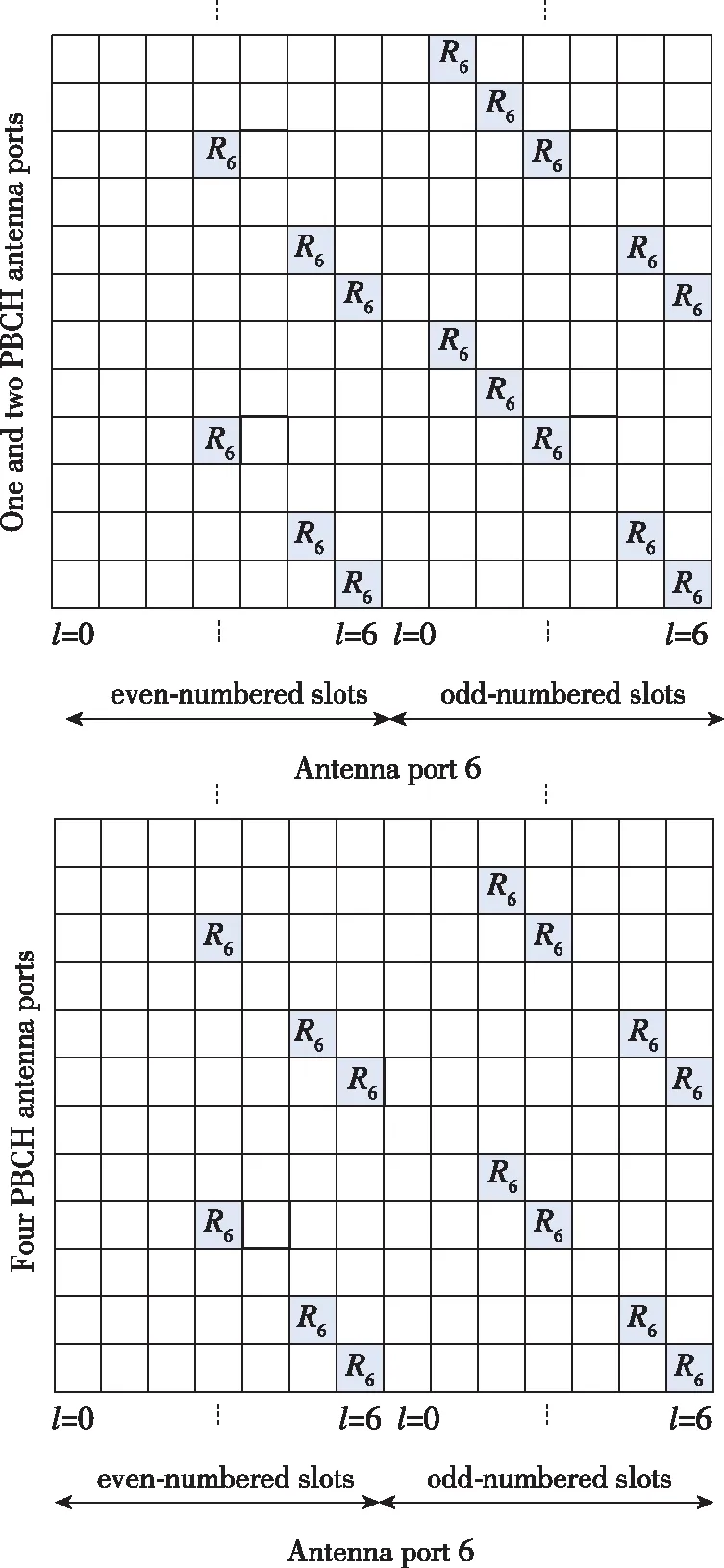

3GPP在LTE标准中支持基于UTDOA和AOA的定位,以及基于OTDOA的定位,包括定位参考信号和过程[38]。其中R9规范里,对下行定位导频信号PRS做了专门的规定。定位信号能够通过特定的天线端口发送到接收端,这可以减小定位信号与有用数据之间的相互干扰,加快LTE定位的商用化速度。

PRS信号需满足资源开销可控以降低对系统容量的影响,峰均比较低以提升功放效率,此外需具备较强的自相关和正交特性,使接收机信号捕获时比较容易获取相关峰,并消除邻小区信号的干扰,保证TOA/TDOA参数估计的精确度。

Normal CP下,PRS pattern定义如图10所示。

图10 定位导频时频域映射(NCP)Fig.10 Resource mapping of PRS(NCP)

LTE R14版本中,定义了PRS ID与小区ID解耦,有利于实现定位Only站点[39],即定位站可在物理上独立存在,只按配置在对应时频资源发射PRS,终端根据接入基站的指示,测量定位Only站的PRS,并以正常方式反馈RSTD,由服务器实现解算,这对解决NLOS问题是一个很大的突破,理论上可以实现低成本的按需部署,保证定位的精度和可用性,这也是移动网络定位相对卫星定位的一个独特优势。

对上行定位技术,可以采用探测参考信号(Sounding Reference Signal,SRS)或其他信号,进行时域、频域参数估计或其他增强算法,完成高精度定位。

在LTE R15规范里,还制订了通过SIB信息传输DGNSS差分改正数的标准[40],包括RTD、RTK。该方案得到了一些主要移动网络运营商如德电的支持,并进行了实际测试,效果良好。

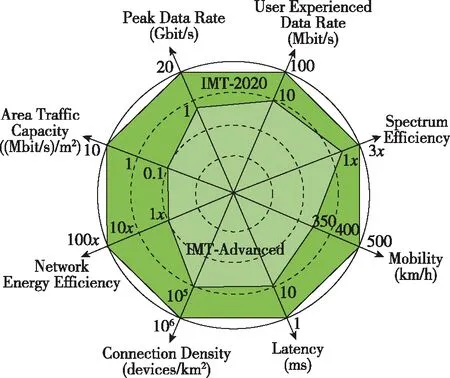

作为下一代移动通信系统,5G对业务速率、频谱效率、能量效率、连接延迟、移动速率和可靠性等关键指标的描述如图11所示。

图11 5G关键指标Fig.11 5G key performance

5G定位的目标是实现亚米级高精度高可用性定位。一般认为基于射频指纹等传统非参数估计的定位方案难以达到上述要求。5G移动通信系统的以下特征有利于大幅提升定位的精度和可用性,并保证定位的实时性:

1)大信号带宽,典型值如100MHz、800MHz,有助于提升TOA/TDOA的参数估计精度,尤其是多径抑制能力得到大大增强;

2)Massive MIMO多天线子系统,典型阵元数目达到128、256,有助于提升多径下的角度估计能力;

3)密集组网,城区典型站间距一般为一两百米,有助于空口校准及选择GDOP较小的多个站点进行解算;

4)短帧长有利于保证定位的实时性。

在5G定位信号设计中,正参照现有定位信号设计的准则,结合利用5G其他导频方案设计,在支持更大带宽、更好的序列特性、更多用户复用、系统开销更小、更低峰均比等方面,进一步予以优化,尤其是综合考虑本文所述的TOA/AOA参数估计和非参数估计方式,结合阵列流型、射线追踪等技术,保证多场景、不同环境下的定位性能。

此外,各网元之间关于定位的接口和协议设计也是需要考虑的重点,针对定位的特殊要求,可以设计NR定位切片。

目前,3GPP 5G定位标准已进入study item阶段,业界正在积极推进,预计将于2019年终完成第一版协议冻结。业界正在相关领域开展研究,包括定位架构与协议流程设计、定位信号设计与算法优化,并通过样机进行关键技术验证,以期达到预定目标。研究成果后续将规划到相应产品版本中,推动移动网络定位技术的成熟和商用。

5 结论

基于移动网络的定位是目前主流卫星定位技术的重要和有益补充,可以提升高精度定位的可用性和可靠性;移动网络定位传统算法原理相对成熟,但需要结合实际工程约束进行优化,例如在有限样本或快拍下多径数目的准确估计、基站间非理想同步下的精确校正,以及针对基站实际天线阵列的算法优化;一些新方向如压缩感知、稀疏表示以及深度学习等值得进一步探索,以提升算法鲁棒性并降低复杂度;此外,移动网络的一些独特优势,如便于与GNSS、Wi-Fi融合,可灵活按需部署定位节点等,可进一步提升移动网络定位的价值;随着5G的逐步商用,其大带宽、多天线、密集组网等特性,使得普遍高精度定位进一步成为可能。