二自由度飞行姿态模拟器的模糊强化学习控制

任立伟 班晓军 吴奋 黄显林

摘 要:針对二自由度飞行姿态模拟器的姿态稳定问题,依据强化学习中的策略迭代算法设计姿态稳定控制器。将策略迭代学习算法与多项式TS模糊系统相结合,对控制器参数进行学习调整,实现对二自由度飞行姿态模拟器姿态稳定控制性能的优化。通过多项式TS模糊模型对执行器的策略函数以及评价器的值函数进行逼近,建立基于多项式TS模糊模型的执行器-评价器结构,经过策略迭代过程,学习得到最优控制器参数,使得值函数最小。通过仿真验证,证明了基于多项式TS模糊模型的执行器—评价器结构的策略迭代算法在飞行器姿态稳定控制方面的有效性。

关键词:飞行器控制;姿态稳定;强化学习;策略迭代算法;多项式TS模糊系统

DOI:10.15938/j.emc.2019.11.016

中图分类号:TP 273

文献标志码:A

文章编号:1007-449X(2019)11-0127-08

收稿日期: 2019-03-15

基金项目:国家自然科学基金(61304006,61273095)

作者简介:任立伟(1989—),女,博士研究生,研究方向为模糊系统理论;

班晓军(1978—),男,博士,教授,博士生导师,研究方向为模糊控制理论、鲁棒增益调度控制理论、机电伺服控制系统等;

吴 奋(1964—),男,博士,教授,研究方向为鲁棒变参数控制、切换和混杂控制、非线性控制、先进控制技术的工程应用;

黄显林(1956—),男,博士,教授,博士生导师,研究方向为研究方向为飞行器制导、导航与控制、复杂系统非线性鲁棒与自适应控制等。

通信作者:班晓军

Fuzzy learning controller design of 2DOF flight attitude simulator

REN Liwei1, BAN Xiaojun1, WU Fen2, HUANG Xianlin1

(1. Center for Control Theory and Guidance Technology, Harbin Institute of Technology, Harbin 150001, China;

2.Department of Mechanical and Aerospace Engineering, North Carolina State University,Raleigh 27695-7910,USA)

Abstract:

Aiming at the attitude stabilization problem of twodegreesoffreedom flight attitude simulator, an attitude stabilization controller was designed based on the policy iteration algorithm in the reinforcement learning.The policyiteration learning algorithm and the polynomial TS fuzzy systems were combined together, conducting parameters′ adjustment of the controller, and achievingthe optimization of the attitude stability control performance of the twodegreesoffreedom flight attitude simulator.By approximating the policy function of the actor and the value function of the critic with the polynomial TS fuzzy models, the actorcritic structure based on the polynomial TS fuzzy models was established. Through the policy iteration process, the optimal parameters of the controller were learned to minimize the value function.The simulation results show that the policy iteration algorithm based on polynomial TS fuzzy models is effective in controlling aircraft attitude stabilization.

Keywords:aircraft control; attitude stabilization; reinforcement learning; policy iteration algorithm; polynomial TS fuzzy system

0 引 言

旋翼式飞行器因其结构简单、成本低廉、使用便利等特点,被广泛应用于诸多领域,因此对其姿态控制方法的研究是很有必要的。为了有效提高旋翼式飞行器姿态控制系统的研发效率并降低研发成本,旋翼式飞行姿态模拟器应运而生。

文献[1-2]提出了一种适合在实验室环境下研究旋翼式微小型飞行器姿态控制的小型二自由度飞行姿态模拟器。此套设备可以方便地改变整个系统的质心位置,从而改变被控对象动力学方程中的参数,为研究强鲁棒性、自适应姿态稳定以及大角度姿态调整控制问题提供了一个良好的实验平台。该二自由度飞行姿态模拟器具有自身不稳定性、非线性等特性,采用可行又有效的控制策略才能保证其运行的稳定性。

强化学习(reinforcement learning,RL)是计算智能领域发展起来的一种机器学习方法[3-4],它通过智能体与环境的交互进行探索,在采取动作和环境的评价信息中获得所需知识,进一步指导后续动作,最终得到最优的动作策略,以适应环境达到预期目的。强化学习与最优控制和自适应控制有着密切的联系,Frank L. Lewis及其团队在把RL应用到控制领域的过程中做出了大量重要的工作,得到了很多有价值的理论成果[5-8]。强化学习具有对环境先验知识要求低的优点,其主要学习任务是获得“状态—动作”之间的映射关系。函数逼近的本质就是利用某一函数来逼近这一映射关系。对于控制领域,即强化学习不需要对象模型信息,主要目的是获取控制策略,上述函数实际上就是控制器,对于参数化控制器而言,就是在交互過程中通过环境的评价信息对这个控制器的参数进行优化,从而达到改善控制效果的目的。强化学习控制方法目前作为一种基于人工智能的优化控制方法,在求解复杂控制决策问题过程中,极具潜力和优势[9-13]。

一般所研究的强化学习系统,其状态和动作空间都是离散且有限的,值函数可以用表格表示。而对于大的状态、动作空间甚至连续状态、动作空间,值函数的存储将面临“维数灾难”问题。为了解决这个问题,值函数逼近方法被引入到强化学习中,已经成为一种有效方法。模糊逻辑推理作为控制理论中的一种重要方法,由于其具有万能逼近的特点而被用于强化学习中,用于逼近状态值函数或状态动作值函数,其中包括因逼近能力以及简单结构而被广泛研究的TakagiSugeno(TS)模糊模型[14-15]。

近些年来,多项式TS模糊模型受到越来越多的关注。实质上,多项式TS模糊模型可看作是TS模糊模型的一种推广。这两种模型主要区别在于模糊规则的后件部分:TS模糊模型后件部分是线性模型,而多项式TS模糊模型后件部分是多项式模型。因此,相比于传统的TS模糊模型,多项式TS模糊模型可以更好地描述非线性系统。具体来说,针对同一非线性动态系统进行描述,前件变量相同的前提下,多项式TS模糊模型能够显著减少模糊规则条数,并且随着模型前件变量的增加,优势会更为突出;或是在相同模糊规则条数下,多项式TS模糊模型可以更多地表征非线性系统工作点附近的信息。目前,已有一系列研究针对多项式TS模糊系统的系统分析与控制展开[16-24],取得了很多研究成果。

本文尝试将强化学习中的策略迭代算法与一类多项式TS模糊系统[24]相结合,利用多项式TS模糊模型分别对执行器的策略函数以及评价器的值函数进行逼近,建立基于多项式TS模糊模型的执行器-评价器结构,对控制器参数进行迭代优化。此外,本文将所设计的强化学习控制方法应用于二自由度飞行模拟器的控制系统设计,优化其控制器参数,成功实现对二自由度飞行模拟器俯仰角姿态稳定控制性能的优化。

1 飞行姿态模拟器动力学模型

1.1 非线性系统模型

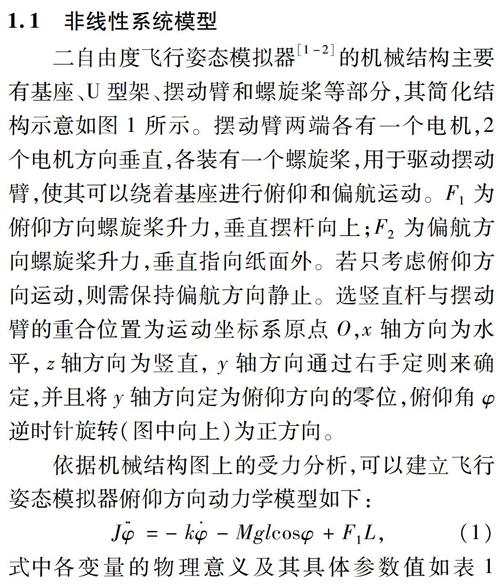

二自由度飞行姿态模拟器[1-2]的机械结构主要有基座、U型架、摆动臂和螺旋桨等部分,其简化结构示意如图1所示。摆动臂两端各有一个电机,2个电机方向垂直,各装有一个螺旋桨,用于驱动摆动臂,使其可以绕着基座进行俯仰和偏航运动。F1为俯仰方向螺旋桨升力,垂直摆杆向上;F2为偏航方向螺旋桨升力,垂直指向纸面外。若只考虑俯仰方向运动,则需保持偏航方向静止。选竖直杆与摆动臂的重合位置为运动坐标系原点O,x轴方向为水平,z轴方向为竖直,y轴方向通过右手定则来确定,并且将y轴方向定为俯仰方向的零位,俯仰角φ逆时针旋转(图中向上)为正方向。

依据机械结构图上的受力分析,可以建立飞行姿态模拟器俯仰方向动力学模型如下:

Jφ··=-kφ·-Mglcosφ+F1L,(1)

式中各变量的物理意义及其具体参数值如表1所示。

选择状态变量x1=φ,x2=φ·及控制输入变量u=F1L,即可得到飞行模拟器的仿射非线性模型如下:

x·=f(x)+g(x)u,(2)

其中:x=[x1,x2]T,f(x)=x21J(-kx2-Mglcos(x1)),

g(x)=01J。

1.2 连续系统的离散化

针对非线性系统(2),时间轴上连续取相同时间间隔T=tk+1-tk>0,[tk,tk+1)=[kT,(k+1)T)称为采样间隔,T为采样周期。本文中每个采样间隔内,输入信号被零阶保持,即

u(t)≡u(kT)=u(k),kT≤t<(k+1)T。(3)

采用四阶龙格-库塔法对系统(2)进行近似离散化,其递推方程如下(步长h=T):

x(k+1)=x(k)+h6(K1+2K2+2K3+K4),(4)

其中,

K1=f(x(k))+g(x(k))u(k),

K2=fx(k)+h2K1+gx(k)+h2K1u(k),

K3=fx(k)+h2K2+gx(k)+h2K2u(k),

K4=f(x(k)+hK3)+g(x(k)+hK3)u(k)。

2 强化学习策略迭代算法

考虑如下单输入离散时间非线性动态系统[7]:

x(k+1)=F(x(k))+G(x(k))u(k),(5)

其中x(k)∈瘙 綆

n表示系统k时刻的状态,u(k)∈瘙 綆

表示系统k时刻的控制输入。F(x(k))和G(x(k))均为光滑的非线性函数。

定义回报函数r(x(k),u(k))如下:

r(x(k),u(k))=Q(x(k))+uT(k)Ru(k),(6)

其中Q(x(k))和R是正定的。特别地,二次型回报函数为

r(x(k),u(k))=xT(k)Qx(k)+uT(k)Ru(k)。(7)

控制目标是寻求一个状态空间到控制输入空间的映射关系h(·)∶瘙 綆

n→瘙 綆

,即策略

u(k)=h(x(k))。(8)

使得未来的累积回报最小,有

Vh(x(k))=∑SymboleB@

i=kγi-kr(x(i),u(i))。(9)

其中,Vh(x(k))表示評价策略u(k)=h(x(k))的值函数;x(i)(k≤i≤∞)表示满足式(5)和式(8)的状态;γ∈[0,1]表示折扣因子,如果为0,则价值只由当前回报决定;如果是1,则所有的后续回报和当前回报一视同仁;如果是0到1之间的数字,即当前回报的权重比后续回报的权重大。

本文研究的前提在于系统是可镇定的[7],且存在一个可行的控制策略u(k)=h(x(k))使得闭环系统是渐近稳定的。此处,可行的控制策略是指该策略可以使系统镇定并且产生有界代价函数的策略。只有对于可行的控制策略,值函数Vh(x(k))的值才有意义。

最优策略u(k)=h*(x(k))使得值函数(9)最小化,得到最优价值

V*(x(k))=minh(·)(∑SymboleB@

i=kγi-kr(x(i),h(x(i)))),(10)

然而这一优化问题很难求解。Bellman最优原理,作为最优控制的一个奠基石,由其可以得到如下离散时间HamiltonJacobiBellman(HJB)方程:

V*(x(k))=minh(·)(r(x(k),h(x(k)))+

γV*(x(k+1))),(11)

进一步,可得到最优策略:

h*(x(k))=argminh(·)(r(x(k),h(x(k)))+

γV*(x(k+1)))。(12)

上述连续状态、动作空间下的离散时间非线性动态系统最优控制问题可以用强化学习方法求解,基本思路分为两步:首先根据当前的策略u(k)=h(x(k))估计值函数Vh(x(k));然后根据当前估计的值函数改进策略。基于上述机制,研究者们提出了很多强化学习算法,本文主要基于比较经典的策略迭代算法展开研究,其具体步骤如下:

1)初始化:选择任意容许控制策略h0(x(k));

2)策略评估:利用Bellman方程确定当前策略的价值,即

Vj+1(x(k))=r(x(k),hj(x(k)))+

γVj+1(x(k+1))。(13)

3)策略更新:通过下式对策略进行更新

hj+1(x(k))=argminh(·)(r(x(k),h(x(k)))+

γVj+1(x(k+1)))。(14)

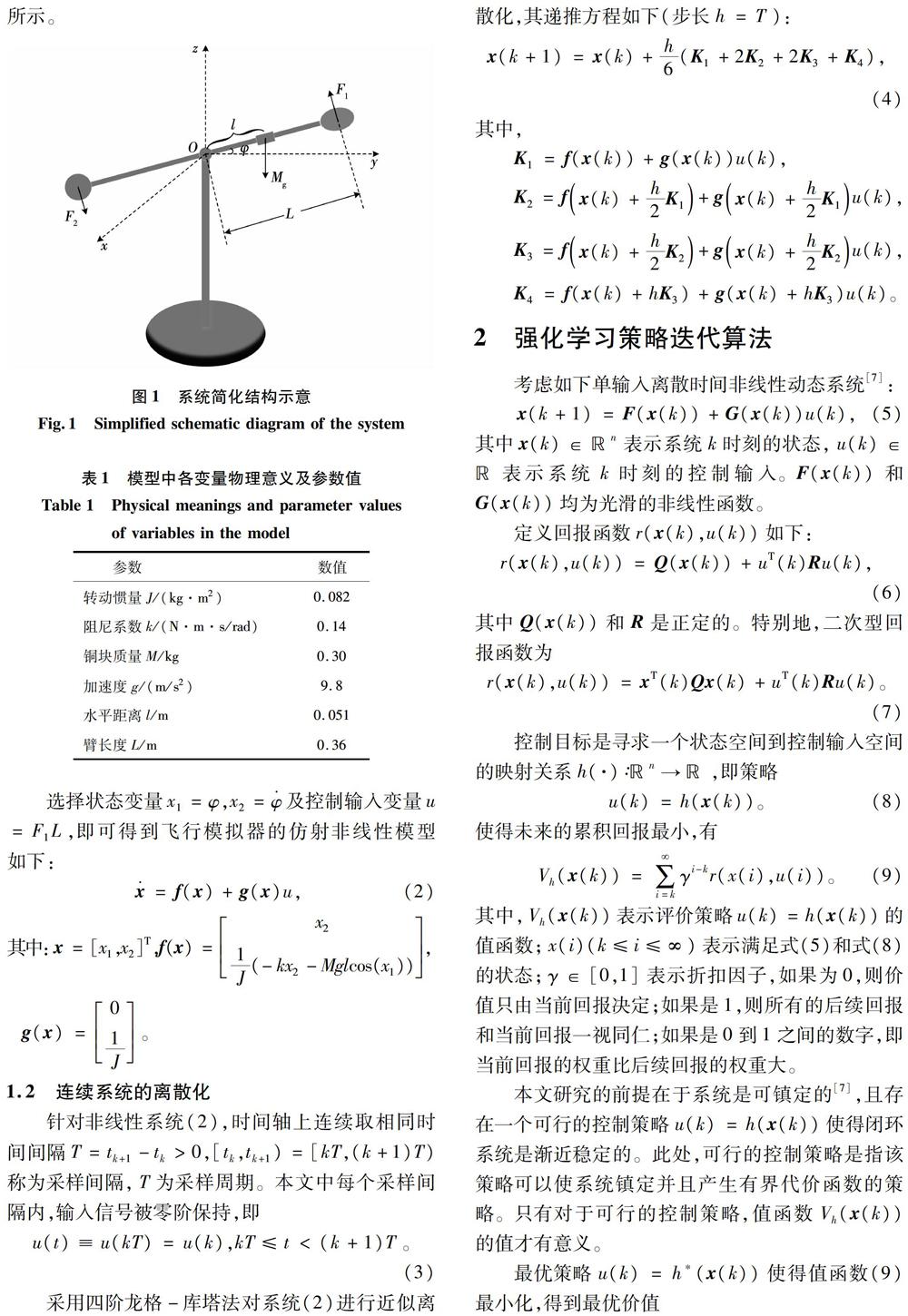

实现上述策略迭代算法的经典强化学习结构为执行器-评价器结构[7],如图2所示。其中,评价器的任务是采用Bellman方程(13)对值函数进行更新,执行器的任务是采用式(14)对策略进行更新。

针对有限状态和动作空间,策略迭代可通过存储和更新查找表实现。然而对于非线性系统(5),状态空间和控制输入空间是连续及无限的,此时使用Bellman方程(13)对当前策略的价值评估意味着需要对所有状态x(k)计算策略hj(x(k))的价值,即求解该Bellman方程是很困难的。解决该问题的关键是通过函数逼近器对值函数进行近似。

3 基于多项式TS模糊模型的执行器-评价器结构

本节将通过多项式TS模糊模型[24]对执行器的策略函数以及评价器的值函数进行逼近,建立基于多项式TS模糊模型的执行器—评价器结构。

3.1 评价器实现—多项式TS模糊模型近似值函数

由第2节可知道,实现具有无限状态空间动态系统的策略迭代的关键是近似值函数。本节将通过如下式所示的多项式TS模糊模型对值函数进行近似,其第条规则如下:

R: IF x1(k) is M1 AND x2(k) is M2 AND … AND xn(k) is Mn,THEN

Vh(x(k))=∑ni=1alixi(k)+∑ni=1∑nj=ibli,jxi(k)xj(k)。(15)

其中:xi(k),i=1,2,…,n為系统在k时刻的状态;n为输入变量的个数;Mi是前件变量xi(k)的模糊集,μMi(xi(k))表示其隶属函数;Vh(x(k))为第条模糊规则输出;ali和bli,j分别表示后件参数,经强化学习可得到。此外,

x(k)=[x1(k),x2(k),…,xn(k)]T。

模糊规则中逻辑“与”运算符选择常用的“代数乘积”,得到第条规则的激活度为

μ(x(k))=∏ni=1μMi(xi(k))。(16)

采用一般化的解模糊方法得到解模糊化后的模型输出,如下:

Vh(x(k))=∑Ωl=1ξ(x(k))Vh(x(k)),(17)

其中:Ω为模糊规则数量;ξ(x(k))为模糊权函数;Vh(x(k))由第条模糊规则的后件方程式(15)计算,且

ξ(x(k))=μ(x(k))∑Ωl=1μ(x(k))≥0,(18)

以及

∑Ωl=1ξ(x(k))=1。(19)

此外,在执行器—评价器结构中,评价器接收系统的状态变量和式(6)定义的回报函数,对强化学习的每次学习产生评判,产生如下时序差分误差(Temporal Difference (TD) Error):

e(k)=r(x(k),h(x(k)))+

γVh(x(k+1))-Vh(x(k))(20)

以及值函数估计。因此,针对值函数近似方法,一般可将式(20)作为近似性能指标。

3.2 执行器实现—多项式TS模糊控制器

本节将通过如下式所示的多项式TS模糊模型[24]对执行器的策略函数进行近似,其第w条规则如下:

Rw:IF x1(k) is Nw1 AND x2(k) is Nw2 AND … AND xn(k) is Nwn, THEN

uw(x(k))=cw+∑ni=1qwixi(k)+

∑ni=1∑nj=iswi,jxi(k)xj(k),(21)

其中:Nwi是前件变量xi(k)的模糊集;ηNwi(xi(k))表示其隶属函数;uw(x(k))为第w条模糊规则输出;cw、qwi和swi,j分别表示后件参数,经强化学习可得到。

模糊规则中逻辑“与”运算符选择常用的“代数乘积”,得到第w条规则的激活度为

ηw(x(k))=∏ni=1ηNwi(xi(k))。(22)

采用一般化的解模糊方法得到解模糊化后的模型输出,如下:

u(x(k))=∑ψw=1ζw(x(k))uw(x(k)),(23)

其中,ψ为模糊规则数量,ζw(x(k))为模糊权函数,uw(x(k))由第w条模糊规则的后件方程式(21)计算,且

ζw(x(k))=ηw(x(k))∑ψw=1ηw(x(k))≥0,(24)

以及

∑ψw=1ζw(x(k))=1。(25)

4 仿真研究

利用第3节中所提出的基于多项式TS模糊模型的执行器-评价器结构的策略迭代算法, 针对第1节中的飞行姿态模拟器俯仰方向动力学模型进行数值仿真研究。本文的强化学习控制算法并不需要对象模型,仿真中的模型只是用来模拟学习过程中与智能体进行交互的外部环境,而不直接向智能体提供任何信息。控制目标为设计多项式TS模糊控制器(23),使得给定系统一个初始角度,在控制器作用下最终可稳定到0度,同时实现策略最优化及值函数最优化。具体为经过策略迭代过程,学习得到最优控制器参数,使得值函数最小。

针对飞行姿态模拟器俯仰方向连续状态空间模型(2),选择离散采样时间T=0.005 s,经四阶龙格-库塔法离散化得到其离散状态空间模型。

由式(1)和式(2)知,系统稳定到0度时,有

u(k)=Mgl,(26)

所以选择回报函数如下:

r(x(k),u(k))=xT(k)Qx(k)+

(u(k)-Mgl)TR(u(k)-Mgl)。(27)

其中,Q=1001,R=1。

选定多项式TS模糊模型(17)对值函数进行近似,模糊规则数为Ω=2,前件变量为x1(k),其第条规则如下:

R: IF x1(k) is M1,THEN

Vlh(x(k))=bl1,1x21(k)+bl1,2x1(k)x2(k)+

bl2,2x22(k)。(28)

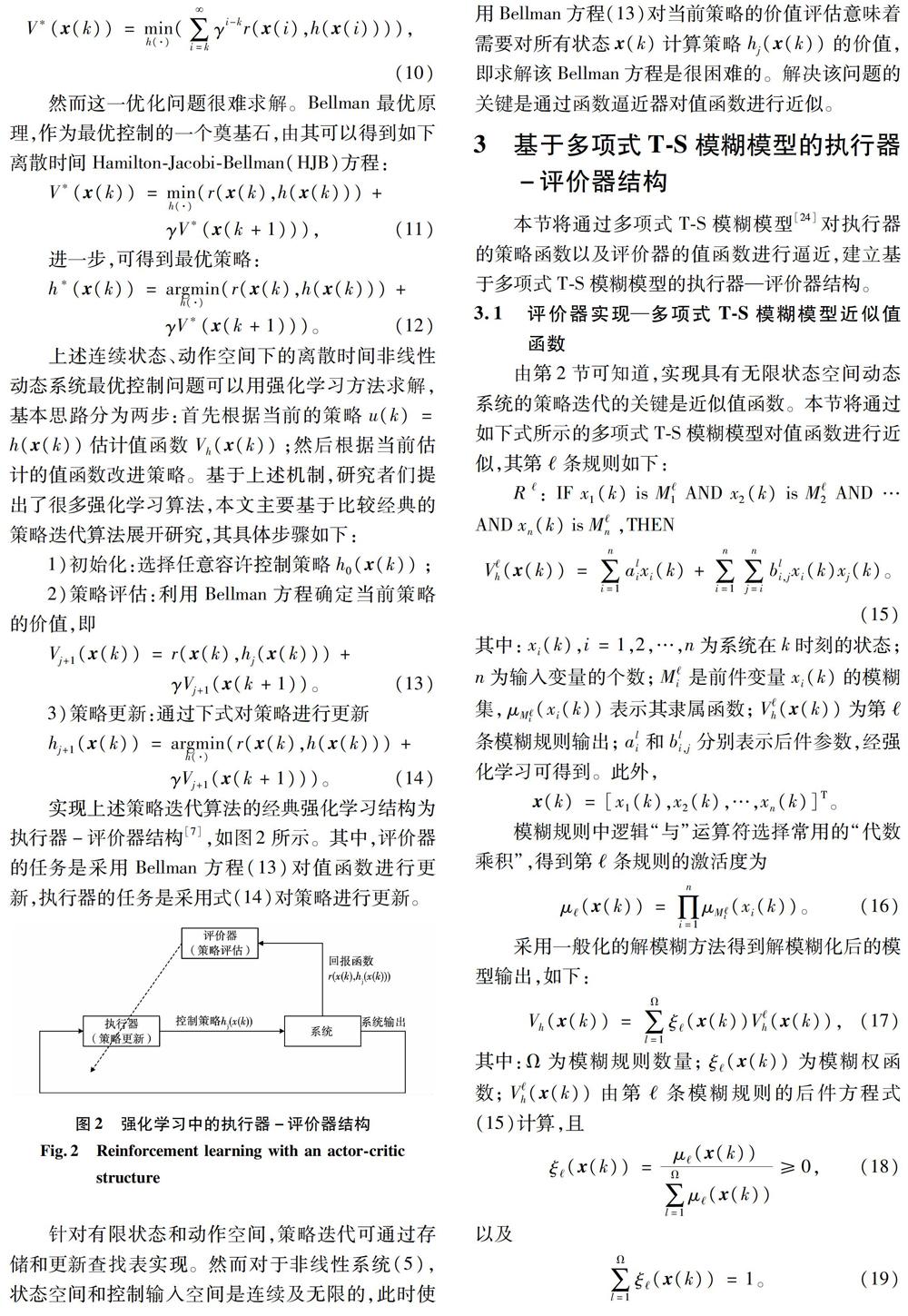

模糊權函数分别选为如下式所示的高斯型(其形状见图3)。

ξ1(x1(k))=e-x21(k)0.5,

ξ2(x1(k))=1-ξ1(x1(k))。(29)

选定多项式TS模糊控制器(23)模糊规则数ψ=2,前件变量为x1(k),其第w条规则如下:

Rw:IF x1(k) is Nw1,THEN

uw(x(k))=cw+qw1x1(k)+qw2x2(k)+

sw1,1x21(k)+sw1,2x1(k)x2(k)+

sw2,2x22(k)。(30)

模糊权函数分别选为如下高斯型(其形状同图3):

ζ1(x1(k))=e-x21(k)0.360 7,

ζ2(x1(k))=1-ζ1(x1(k))。(31)

策略迭代算法中评价器和执行器的参数初始值分别如表2和3所示。

初始状态为x(0)=[-0.990 20]T,折扣因子γ=1。经过15步迭代得到的收敛策略迭代结果(即评价器和执行器参数收敛值)分别如表4和表5所示。

最优策略(其参数如表5所示)下,系统在初始值为x(0)=[-0.990 20]T时的状态响应以及控制输入分别如图4和图5所示。

由式(26)可知,当系统稳定在0度时,经计算可得控制量u(k)=0.149 9,图5所得控制量终值结果与该理论计算结果一致。

进一步,依据所得最优策略(其参数如表5所示),改变系统初值为x(0)=[0.710 70]T,可得到该初始状态下系统的状态响应以及控制输入分别如图6和图7所示。

评价器参数收敛过程以及多项式TS模糊模型近似值函数所得到的最优策略对应的TD误差分别如下图8和图9所示。

从图4~图7中可看出,经过迭代学习过程,得到的具有最优控制策略参数的控制器,能够使得二自由度飞行模拟器的俯仰角和角速度均稳定在0度。从图8和图9中,可以看到评价器参数收速度较快,且所得到的TD误差为零,即实现了值函数最小化的性能指标。该仿真结果不仅说明多项式TS模糊模型近似值函数是可行的,此外,基于多项式T-S模糊模型的执行器-评价器结构的强化学习策略迭代算法在二自由度飞行模拟器上的应用是成功且有效的。

5 结 论

本文基于强化学习中的策略迭代算法对一个自主研制的二自由度飞行姿态模拟器的姿态稳定问题进行研究,该模拟器为实验室环境下研究旋翼式微小型飞行器姿态控制提供了一个很好的平台。首次将策略迭代学习算法与多项式TS模糊系统相结合,建立基于多项式TS模糊模型的执行器-评价器结构,对控制器参数进行学习调整,实现对二自由度飞行姿态模拟器姿态稳定控制性能的优化,具有一定的应用价值。实际上,该算法并不局限于某一策略形式,能够参数化表达的控制策略形式都可以通过该算法进行策略参数优化,实际应用中,可以根据需要进行策略形式选择。

参 考 文 献:

[1] 赵岩. 二自由度直升机模拟器控制系统设计[D]. 哈尔滨:哈尔滨工业大学, 2013.

[2] 尹航, 杨烨峰, 赵岩,等. 二自由度飞行姿态模拟器自整定控制器设计[J].电机与控制学报,2018,22(4):109-116.

YIN Hang, YANG Yefeng, ZHAO Yan, et al. Selftuning controller design for a 2DOF flight attitude simulator [J]. Electric Machines and Control, 2018, 22(4):109-116.

[3] SUTTON R S, BARTO A G. Reinforcement LearningAn Introduction[M]. Cambridge, MT: MIT Press, 1998.

[4] Jerry M.MENDEL. Adaptive learning and pattern recognition systems: theory and applications[M]. Academic Press, 1970.

[5] WEI Q, LEWIS F L, LIU D, et al. Discretetime local value iteration adaptive dynamic programming: Convergence analysis[J]. IEEE Transactions on Systems Man and Cybernetics: Systems, 2018, 48(6): 875-891.

[6] KIUMARSI B, LEWIS F L, JIANG Z P. H∞ control of linear discretetime systems: Offpolicy reinforcement learning[J]. Automatica, 2017, 78(1): 144-152.

[7] LEWIS F L, VRABIE D. Reinforcement learning and adaptive dynamic programming for feedback control[J]. IEEE Circuits and Systems Magazine, 2009, 9(3): 32-50.

[8] ZHAO D, LIU D, LEWIS F L, et al. Special issue on deep reinforcement learning and adaptive dynamic programming[J]. IEEE Transactions on Neural Networks and Learning Systems, 2018, 29(6): 2038-2041.

[9] KHATERAA, ELNAGAR A M, ELBARDINIM, et al. Adaptive T–S fuzzy controller using reinforcement learning based on Lyapunov stability[J]. Journal of the Franklin Institute, 2018, 355(14): 6390-6415.

[10] XIONG Y, HAIBO H, QINGLAI W, et al. Reinforcement learning for robust adaptive control of partially unknown nonlinear systems subject to unmatched uncertainties[J]. Information Sciences, 2018, 463(1):307-322.

[11] ZHANG C, ZOU W, CHENG N, et al. Trajectory tracking control for rotary steerable systems using interval type2 fuzzy logic and reinforcement learning[J]. Journal of the Franklin Institute, 2018, 355(2): 803-826.

[12] ZHU Y, ZHAO D, YANG X,et al. Policy iteration for H∞ optimal control of polynomial nonlinear systems via sum of squares programming[J]. IEEE Transactions on Cybernetics, 2018, 48(2): 500-509.

[13] 趙冬斌, 邵坤, 朱圆恒,等.深度强化学习综述:兼论计算机围棋的发展[J]. 控制理论与应用, 2016, 33(6):701-717.

ZHAO Dongbin, SHAO Kun, ZHU Yuanheng, et al. Review of deep reinforcement learning and discussions on the development of computer go[J]. Control Theory & Applications, 2016, 33(6):701-717.