基于无人机遥感可见光影像的北疆主要农作物分类方法

戴建国,张国顺,郭 鹏,曾窕俊,崔美娜,薛金利

基于无人机遥感可见光影像的北疆主要农作物分类方法

戴建国1,3,张国顺1,3,郭 鹏2,曾窕俊1,崔美娜1,3,薛金利1,3

(1. 石河子大学信息科学与技术学院,石河子 832003; 2. 石河子大学理学院,石河子 832003;3. 兵团空间信息工程技术研究中心,石河子832003)

作物类型准确分类是大田作业和管理的基础。该文通过无人机遥感试验获取的可见光影像,利用色彩空间转换和纹理滤波构建了色调、饱和度和亮度的27项纹理和低通滤波特征;然后采用ReliefF-Pearson特征降维方法,剔除分类能力弱且相关性高的冗余特征;最后,基于优选特征训练分类模型,并结合人工分类结果对各模型进行精度比较和效果验证。结果表明:特征选择得到的H-CLP、H-Ent、I-Cor、I-CLP、I-Ent、S-CLP和I-Var是利用可见光影像进行北疆主要农作物分类的最佳特征,可在充分表征影像特征的同时降低数据冗余。支持向量机(support vector machine, SVM)分类方法精度最高,整体分类准确率达83.77%,ANN和KNN分类精度次之。通过在验证区进行像素级别作物分类,发现SVM分类方法效果最好,棉花、玉米、苜蓿和西葫芦作物分类精度均达到了80%以上。该研究可为基于无人机可见光影像的农作物种植信息普查提供参考。

无人机;遥感;可见光影像;色彩与纹理特征;机器学习;作物分类

0 引 言

准确的农作物空间分布信息是农业现代化管理的基础,因此大田农作物分类识别是农业遥感的研究热点之一。遥感农作物分类的核心方法是影像光谱特征分析[1]。如刘佳等[2]利用HJ-1A/B月度时间序列NDVI,通过分析波谱曲线,实现了衡水市主要农作物识别及种植面积测算;王文静等[3]利用Landsat8时间序列NDVI、光谱反射率和几何纹理作为分类特征,对沙湾县主要农作物进行分类研究,效果较好。虽然卫星遥感是目前大面积农作物分类主要手段,但存在成本昂贵、回访周期长和空间分辨率低等问题[4],且过于依赖于卫星过境时的天气状况[5],实时性和准确性均受限。随着高分辨率传感器和低空无人机技术的发展[6],凭借其灵活性高、周期短、空间分辨率高、受天气和云层影响小等优势[7],弥补了传统卫星遥感的不足,成为目前小区域农业遥感数据获取的主要手段。相比于中低分辨率遥感影像,高分辨率影像的纹理、形状及上下文关系等信息更加丰富[8],可用于构建可见光影像的分类特征。

现阶段,利用无人机影像进行地物分类的方法主要分为2类:一是利用光谱信息计算植被指数构建分类特征,结合传统方法实现植被区域的识别。如汪小钦等[9]构建了可见光波段差异植被指数(visible-band difference vegetation index, VDVI)对健康绿色植被识别,精度可达90%以上;丁雷龙等[10]在转换色度坐标后,构建了过绿减过红指数(ExG-ExR)对与背景特征差别较大的植被识别效果较好;井然等[11]采用空间分析筛选后的可见光植被指数对水生植被分类,总体精度达到91.7%。此类研究已较为成熟,适用于影像地物类型单一、前景与背景差别明显的情况,在图像为复杂地物类型时适用性较差。二是采用图像增强和纹理滤波的方法,挖掘影像纹理和结构等信息,对复杂地物中的典型作物进行识别。如韩文霆等[12]结合变异系数和差异系数对影像纹理特征筛选,得到的绿色均值、蓝色协同性和纹理低通植被指数(texture low pass vegetation index, TLVI),在玉米种植信息提取方面效果显著。闵文芳等[13]构建了一系列颜色和纹理特征,采用BP神经网络和像素累加法实现了典型作物识别和面积测量,准确度可达90.3%。目前,该类研究集中于在复杂地物背景下针对某种特定作物的识别,难以对同一区域内多种作物进行同步区分。

本文针对在复杂地物中对多种作物进行同步识别时存在的问题,结合已有的研究成果,利用色彩空间转换和纹理滤波构建分类特征,通过特征选择降低数据维度,使用多种机器学习算法,以石河子垦区为典型区域,对北疆主要作物(棉花、玉米、苜蓿和葫芦瓜)进行分类识别研究,以期获得基于可见光影像的多种作物同步分类的最佳特征和算法,为北疆农业肥水精准管理和种植结构优化提供参考。

1 研究区及数据准备

1.1 研究区概况

研究区位于新疆生产建设兵团第八师石河子垦区,东经85°58′~86°24′,北纬43°26′~45°20′。该区域平均海拔约为364 m,冬季严寒,夏季炎热,干燥少雨,蒸发量大,属典型的温带大陆性气候[14]。年平均温度7.5~8.2 ℃,年日照时长达2318~2732 h,无霜期147~191 d,年平均降雨量180~270 mm,光照时间长、热量充足[15-16],主要种植作物类型为棉花、玉米、小麦、甜菜、西葫芦和苜蓿等作物。

1.2 数据获取

获取的数据分为试验区和验证区2个部分,其中试验区位于石河子垦区石河子总场二分场三连蘑菇湖村,主要作物类型为棉花、玉米、西葫芦和苜蓿,以及部分林木和其他地物(非林、非耕地)。影像数据于2017年8月29日获取,飞行平台为CW-10垂直起降固定翼无人机系统,起飞、降落均采用四旋翼垂直起降,该机翼展2.6 m,机身长1.6 m,最大起飞质量12 kg,巡航速度20 m/s,最大续航时间1.5 h。传感器采用Parrot Sequoia相机,该传感器包含绿光、红光、红边、近红外和RGB三原色通道,相机数传模式为WIFI无线传输。拍摄当天,天气晴朗、地面风速小于4级,满足航摄要求。试验设计飞行航高150 m,航线18条,航线总长20.16 km,航向重叠度80%,旁向重叠度70%,曝光方式为定距曝光,仅获取分辨率为1600万像素的RGB三原色数据,共1009幅航摄原始相片,拼接后得到影像幅宽长约2.41 km,宽约1.57 km。验证区位于石河子总场一分场五连杨家庄村,数据来自Google earth历史影像,影像时间为2017年9月5日。影像格式及色彩信息与试验区无人机航摄数据相同,影像空间分辨率为0.85 m,影像幅宽长约1.67 km,宽约0.85 km。试验区和验证区影像如图1所示。

图1 试验区和验证区示意图

航摄结束后对试验区进行作物类型及分布状况调查,试验区内棉花作物占比约为60%,苜蓿作物占比约为4%,其他类别相对均匀,约为9%;验证区内棉花作物占比约为28%,葫芦瓜作物占比约为20%,其他类别相对均匀约为13%。

1.3 数据预处理

试验区航摄相片通过Pix4Dmapper软件进行图像快速拼接检查,相机优化参数为1.66%,满足后续正射影像的生成要求。拼接生成正射影像的整个工作流程分3个步骤完成:首先利用飞行POS数据寻找同名点,平均每张原相片匹配52494.3个同名点;然后通过空三测量计算原始影像的真实位置和拼接参数,建立点云模型;最后基于影像内容的优化和区域网平差技术,自动校准影像并生成初步正射影像。航拍时间在正午时刻,此时虽然受太阳高度角的影响相对较小,但建筑物、林带等仍会产生形变和阴影,需调整正射影像拼接线,以获得高精度、高质量的正射影像图。试验区影像以TIFF格式存储三通道的灰度信息,每个通道包含8 bit信息。空间分辨率为0.057 m,为提高后续处理效率,重采样至0.25 m。

2 研究方法

2.1 研究方案

由于研究使用的可见光影像只有红、绿、蓝3色的灰度信息,仅使用其中的RGB色彩信息难以实现作物类型区分,因此首先需要借助于色彩增强和纹理滤波技术挖掘影像中潜在的结构和纹理等信息;然后采用ReliefF-Pearson特征选择方法,根据分类贡献权重和相关性系数筛选分类特征;再结合筛选后的分类特征建立分类样本,使用5种机器学习算法进行训练和参数调优;最后基于像元级别执行监督分类,结合目视解译结果使用混淆矩阵[17]和Kappa系数分析评价各分类算法的总体精度,最终获得利用可见光影像进行农田作物分类的最优特征和分类算法。总体研究方案如图2所示。

图2 技术路线图

2.2 色彩空间转换

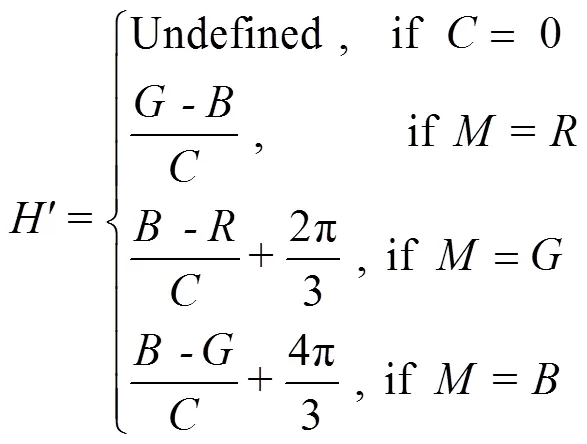

可见光影像在光谱特征方面只能提供、、通道的灰度信息,各通道数据之间存在较高的相关性及随机噪声[18],若直接进行信息提取则精度难以保证。而HSI模型可消除彩色影像中强度分量的影响[19],且能够大幅度减小图像分析和处理工作量[20],有利于色彩特性检测与分析。利用FA Kruse方法将影像色彩转换至圆柱极坐标下的双锥体Munsell颜色空间的方法如下[21]

转换后的影像包含色相()、饱和度()和亮度()3个色彩波段。表示颜色的辨别,如绿色,红色等;表示色彩的强度或纯度,饱和度越大,颜色越鲜艳;表示颜色的明亮程度。图3表示在HSI色彩模型下的各类别样本特征,可以看出不同作物类型在色相、饱和度及纹理上有明显差异,成为后续分类信息提取的依据。

图3 HSI色彩模型下的典型样本

Fig.3 Typical samples under HSI color model

2.3 特征构建

无人机可见光影像的光谱分辨率较低,但结构和纹理等信息较为丰富,因此可借助于影像滤波来表达影像的各方面特征,如地物的边缘特征、协同性、相异性和信息熵等[22-23]。

使用ENVI软件做滤波处理,空间域选用二阶概率统计滤波提取影像纹理特征,获得色调、饱和度和亮度3个分量的均值、方差、协同性、对比度、相异性、信息熵、二阶矩和相关性共24项纹理特征。综合考虑精度与效率,将滤波的窗口设置为7×7,空间相关性矩阵和的变化量均为1,灰度质量级为64。频率域选用卷积低通滤波获取3个分量的平滑值,得到3项色彩特征,卷积低通滤波窗口设置为7×7。为了使特征统计更具一般性,在选取样本时,尽可能使样本均匀分布于各类别内部。使用ENVI软件ROI工具建立各类别样本,并统计每个样本的27项特征的属性值。

2.4 特征降维

Relief算法最早由Kira和Rendell提出,主要用于解决二分类问题的特征降维。Kononenko推广至ReliefF算法,解决了多类别分类时特征选择及缺失数据处理的问题[24]。ReliefF特征选择的原理是通过计算训练样本的假设间隔实现特征分类贡献评价,给每一特征赋予分类能力权重[25],特征权值越大,表示该项特征分类能力越强。

ReliefF特征选择借助于MATLAB软件实现,将统计的样本数据导入,使用ReliefF主函数执行核心算法分别计算27项特征的分类权重。对各特征权重因子排序,取权重因子大于0.15的11个特征H-CLP、H-Ent、I-Cor、H-Hom、I-CLP、I-Ent、I-Hom、I-Dis、S-CLP、S-Cor和I-Var。由于特征选择之后的特征之间还可能存在相关性,利用SPSS软件分析已选择的11项特征两两之间Pearson相关系数,依据特征之间的相关性越强信息冗余度越高、权值越低分类能力越弱的原则[26]剔除相关性强且权值低的H-Hom、I-Hom、I-Dis和S-Cor 4个特征(图4中白色柱),最终得到相关性弱、权值高的H-CLP、H-Ent、I-Cor、I-CLP、I-Ent、S-CLP和I-Var作为优选分类特征,特征权重如图4所示。

注:H-CLP、H-Ent、I-Cor、H-Hom、I-CLP、I-Ent、I-Hom、I-Dis、S-CLP、S-Cor和I-Var分别代表色相低通值、色相信息熵、亮度相关性、色相协同性、亮度低通值、亮度信息熵、亮度协同性、亮度相异性、饱和度低通值、饱和度相关性和亮度方差值。

2.5 模型构建

基于7个优选特征重新建立分类样本,并对特征变量进行归一化处理[27],利用ArcMap软件中随机生成点的方法构建了1844个样本组成样本集。将其中的2/3作为训练集(1229个),1/3作为测试集(615个)。各类别具体样本数为:棉花作物训练样本263个,测试样本132个,共395个;玉米作物训练样本163个,测试样本82个,共245个;西葫芦作物训练样本188个,测试样本94个,共282个;苜蓿作物训练样本125个,测试样本62个,共187个;林木类别训练样本240个,测试样本120个,共360个;其他类别训练样本250个,测试样本125个,共375个。分别采用K最近邻法(KNN)、支持向量机(SVM)、朴素贝叶斯(NB)、人工神经网络(ANN)、决策树(C5.0)5种分类算法进行训练,并借助于交叉验证不断优化分类参数。最终确定5个分类算法参数设置如下:

1)KNN采用欧氏距离,triangular核函数,最近邻值为30;

2)SVM的核函数为径向基函数(radial basis function,RBF),惩罚系数为10,gamma为0.1;

3)NB全部设置为默认参数;

4)ANN选择logistic激活函数,隐层节点数为10,权值递减值为0.001,RMS误差值为0.01,最大迭代训练1000次;

5)C5.0设置置信区间为0.25,不使用全局修剪简化树,最小分支数为10。

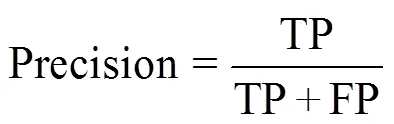

2.6 精度评价

由于该研究属于多分类问题,因此求取精确率(Precision)、准确率(Accuracy)、召回率(Recall)、1值共4个指标的宏平均值(macro_avg)作为综合精度评价指标对分类结果进行评价[28]。

式中TP表示将正例划分为正例数;FP表示将负例划分为正例数;TN表示将负例划分为负例数;FN表示将正例划分为负例数。

式中表示类别数目,P表示第类的精确率,召回率和1值的宏平均值计算方法相同。

3 结果与分析

3.1 模型对比分析

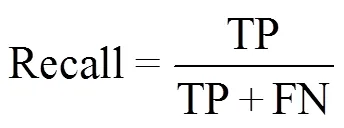

分别用准确率、精确率、召回率和1值对5种模型的分类结果进行精度评价,结果如表1所示。纵向对比可看出,准确率、精确率、召回率和1值均呈现出相同的趋势,表明分类样本分布均衡,未发生数据集偏斜。结果表明,SVM、ANN和KNN方法的整体分类效果较好,分类准确率均达到了80%以上。其中,SVM方法分类准确率最高,测试集分类准确率达到了83.77%,ANN和KNN方法分类准确率次之;C5.0和NB方法的分类效果较差,其中NB的分类效果最差,测试集分类准确率为74.91%。横向比较各模型在训练集和测试集的分类精度,发现测试集分类准确率比训练集分类准确率仅有不同程度的微小下降。其中,SVM下降了2.84%,ANN下降了2.03%,KNN下降了4.86%。降幅小于5%,依据前人研究经验,可认为模型可靠。

表1 不同分类器的分类精度

3.2 分类效果分析

基于优选的H-CLP、H-Ent、I-Cor、I-CLP、I-Ent、S-CLP和I-Var 共7个分类特征,使用ENVI软件对训练后的SVM、ANN和KNN模型对试验区和验证区作物进行像元级别的监督分类,同时根据实地采样点数据建立的解译标志对影像目视解译作为模型精度评价的依据。试验区SVM、ANN、KNN和目视解译分类结果如图5a所示,验证区SVM、ANN、KNN和目视解译分类结果如图5b所示。从试验区分类效果图看,SVM、ANN、KNN分类方法对作物区域分类效果较好,作物地块边界较为完整,而对非作物区域分类效果较差。验证区分类效果与试验区分类效果基本一致,作物区域分类效果优于非作物区域分类效果,且在各类别内存在不同程度的误分小斑块。从全图来看,SVM方法的误分小斑块最少,地块边界也较为规则完整;KNN分类方法误分小斑块最多,但地块边界较为规则完整;ANN分类方法误分小斑块数量介于SVM和KNN分类方法之间,但地块边界不完整,有区域性误分现象。从类别来看,作物类别的误分小斑块数量明显少于非作物类别的误分小斑块数量;在作物类别中,棉花和玉米作物的误分小斑块相对较少,而西葫芦和苜蓿的误分小斑块相对较多。其原因可能与作物的种植模式、冠层形态及物候等因素相关,棉花和玉米作物为机械直播式,具有固定的行距与株距,棉花作物9月份初正处于裂铃期,玉米作物处于抽穗后期,冠层结构已基本覆盖背景,处于最佳识别期。西葫芦作物为人工定植的方式,种植稀疏,9月份初处于收获期,叶片泛黄,已过最佳识别期。苜蓿作物为条播的种植方式,收割方式为按茬收获,试验区苜蓿作物处于收割前生长阶段,生物量大,而验证区苜蓿作物处于收割后生长阶段,生物量较小。

图5 试验区和验证区分类结果

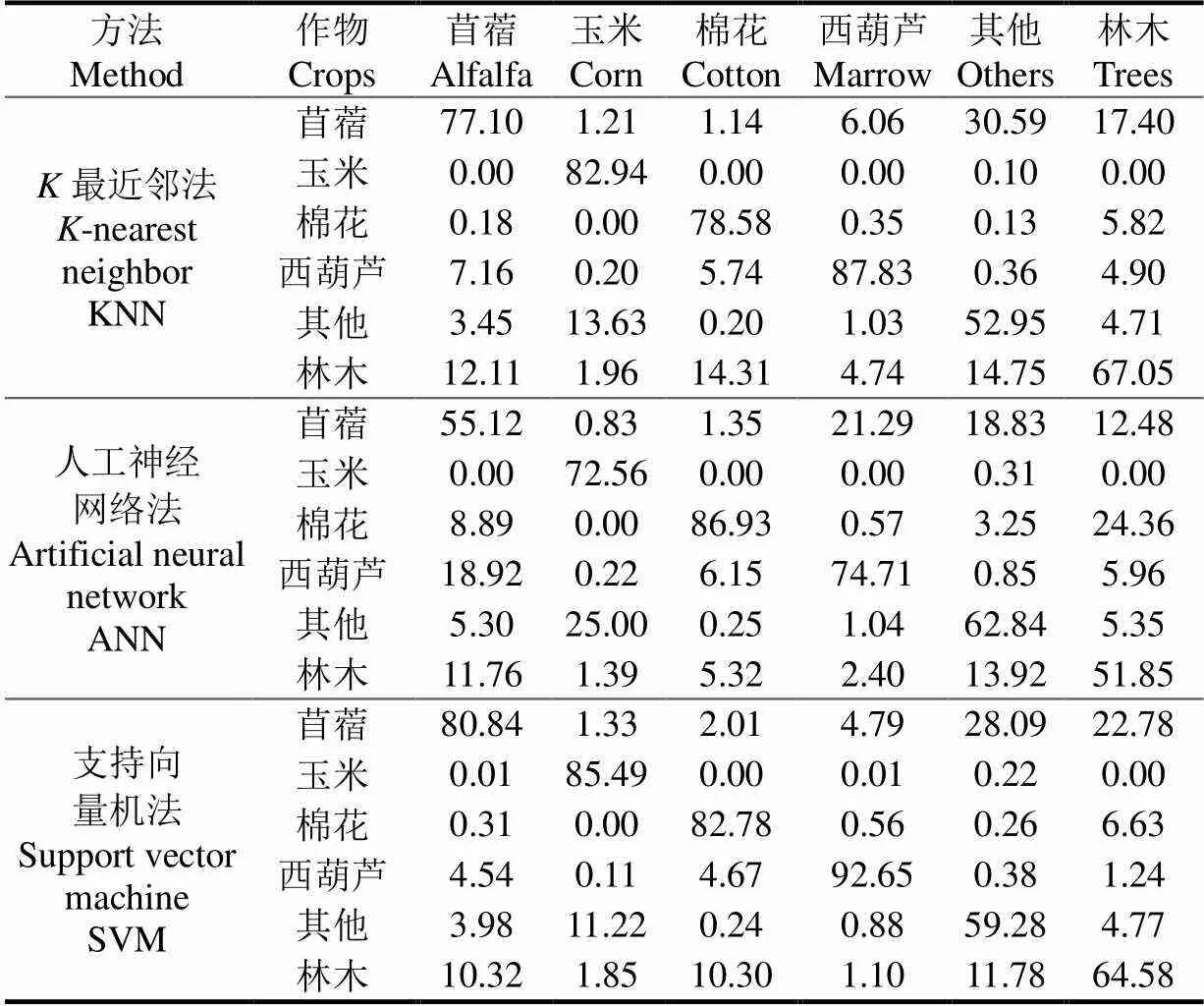

结合目视解译分类结果计算试验区和验证区SVM、ANN和KNN分类结果的混淆矩阵、总体精度和Kappa系数,以评价的分类效果。试验区和验证区SVM、ANN和KNN分类方法的总体精度及Kappa系数如表2所示,验证区SVM、ANN和KNN分类结果的混淆矩阵如表3所示。

表2 分类总体精度及Kappa系数比较

由表2可知,纵向比较总体精度和Kappa系数,试验区和验证区表现出相同的分类效果,即SVM分类方法的整体分类精度最高,试验区和验证区均达到了80%以上,KNN和ANN分类方法的整体分类精度次之,试验区和验证区均达到了70%以上。横向比较试验区和验证区的总体精度和Kappa系数,SVM、ANN和KNN方法在验证区总体分类精度相较于试验区总体分类精度稍有下降,其中SVM方法下降了1.5%,KNN方法下降了1.85%,ANN方法下降了1.99%。Kappa系数表现出相反的趋势,SVM方法在验证区和试验区的Kappa系数未发生变化,而KNN和ANN方法在验证区的Kappa系数相较于试验区稍有上升,其中KNN方法上升了0.06,ANN方法上升了0.09。

分析以上现象的原因,由于实际分类影像中各类别的占比不均衡,总体分类精度不能正确反映真实的分类精度,而Kappa系数是考虑到类别比例的精度评价,在类别比例不均衡的情况下更能反映实际分类精度。统计试验区和验证区目视解译的各类别面积,发现试验区内棉花类型占比约为2/3,其他类别相对均匀,其分类精度受到棉花作物单个类别的影响;验证区内棉花作物占比约为1/3,其他类别相对均匀。

相比而言,验证区各类别占比相对均衡,因此本文以验证区SVM、ANN和KNN分类方法的Kappa系数作为分类精度的最佳衡量指标,且SVM分类方法分类精度最高,Kappa系数为0.75,KNN和ANN分类方法次之。

由表3可知,SVM、ANN和KNN方法对作物类别的分类精度均高于非作物类别的分类精度。其中,SVM方法在作物类别分类的稳定性及可靠性较好,精度均达到了80%以上,而在非作物类别分类精度在59%以上。KNN方法在作物类别分类的稳定性及可靠性一般,玉米和西葫芦作物的分类精度在80%以上,棉花和苜蓿作物的分类精度在77%以上,而非作物类别分类精度在52%以上。ANN方法在作物类别分类的稳定性及可靠性较差,棉花作物的分类精度较好,达到了85%以上,玉米和西葫芦作物的分类精度在72%以上,苜蓿作物的分类精度在55%以上,而非作物类别分类精度仅在50%以上。

表3 验证区分类混淆矩阵

4 讨 论

本文基于无人机获取的高分辨率可见光影像,充分利用色彩和纹理信息构建并筛选特征,对比分析多种分类算法,获得了能够对北疆地区主要农作物快速、准确分类的最佳特征和算法模型。该研究方法对于无人机遥感在精准农业中的应用具有一定的参考价值,但由于作物种植所具有的多样性和复杂性,还存在一些待改进之处。本文依据最佳特征构建的SVM分类方法,作物类别的整体分类精度均达到80%以上,但非作物类别仅为60%左右,分类精度仍有较大的提升空间。分析误差产生的原因,主要包括以下两方面:一是由于作物生长状态不一致导致的“同物异征”。如同一作物由于播种时间的差异,导致同类作物包含多个生长期特征,整体识别度降低。二是研究区受到人类活动影响较大,人造地物特征差异较大,并且部分地物边缘重叠,难以获取实际地物边界。针对以上误差源,有如下两方面的思考:其一,可见光传感器所获取的数码相片不仅包含二维平面的色彩、纹理和结构等特征,而且包含三维空间坐标,可尝试计算三维空间信息(如点云、株高信息等)作为分类特征参与分类。其二,各作物类别的生长期存在差异,因此每种作物的最佳分类时间不尽相同,可以结合多时相的可见光影像以及作物的物候特征,进一步提升分类精度。

目前无人机和传感器技术已较为成熟,垂直起降固定翼无人机单架次覆盖面积达150 km2,搭载的数码相机成本低且受天气影响较小,获取的数码照片数据占用空间小且处理简单,使大面积农田信息快速及时采集成为可能。另外,随着卫星传感器技术的发展,低成本、高空间分辨率的商业遥感卫星逐渐成为核心数据支持,并且可通过星座组网获得更短的重返周期,可为更大范围的农业领域遥感监测提供数据支持。同时,北疆地区气象条件较好,对可见光数据获取的影响较小,且作物种植类型相对固定,大田种植模式也非常适合无人机或卫星遥感监测。因此,本文提出的方法可快速完成大面积农作物种植信息调查,除此之外还可以为特定农作物种植面积量算、作物长势和水份情况监测以及农业自然灾害监测提供方法参考。

5 结 论

本文充分挖掘了可见光影像中的潜在信息,将色彩增强和纹理滤波相结合构建了分类特征,结合特征降维方法优选色彩纹理特征,利用多种分类方法训练优化模型参数,并进行分类精度评价,获得了基于无人机可见光影像的北疆主要农作物最佳分类特征及方法。主要结论如下:

1)色彩增强和纹理滤波相结合能够有效地构建农作物分类备选特征,结合ReliefF-Pearson方法能够在筛选最佳分类特征的同时降低数据维度,从而减少数据量,提高数据处理效率和模型泛化能力。

2)SVM、KNN和ANN方法的整体分类效果较好。结合优选特征进行监督分类,从误分小斑块的数量及作物地块边界的完整性等各方面考量,SVM分类方法总体效果最好,且稳定可靠。

3)本文所采用的分类特征和分类方法对北疆棉花、玉米、苜蓿和西葫芦等主要作物的分类效果较好,各作物分类精度均达到了80%以上。该方法可以很好地用于无人机可见光影像农作物分类,后续可结合多时相分析来进一步提升分类精度。

[1] 吴梦红,杨长保,林楠.高分辨率遥感影像在土地覆被变化监测中的应用[J].科学技术与工程,2017,17(22):100-106. Wu Menghong, Yang Changbao, Lin Nan. Application of high-spatial remote sensing image in land cover change monitoring[J]. Science Technology and Engineering, 2017, 17(22): 100-106. (in Chinese with English abstract)

[2] 刘佳,王利民,杨福刚,等.基于HJ时间序列数据的农作物种植面积估算[J].农业工程学报,2015,31(3):199-206. Liu Jia, Wang Limin, Yang Fugang, et al. Remote sensing estimation of crop planting area based on HJ time-series images[J]. Transactions of the Chinese Society of Agricultural Engine(Transactions of the CSAE), 2015, 31(3): 199-206. (in Chinese with English abstract)

[3] 王文静,张霞,赵银娣,等.综合多特征的Landsat8时序遥感图像棉花分类方法[J].遥感学报,2017,21(1):115-124. Wang Wenjing, Zhang Xia, Zhao Yindi, et al. Cotton extraction method of integrated multi-features based on multi-temporal Landsat 8 images[J]. Journal of Remote Sensing, 2017, 21(1): 115-124. (in Chinese with English abstract)

[4] 史舟,梁宗正,杨媛媛,等. 农业遥感研究现状与展望[J].农业机械学报,2015,46(2):247-260. Shi Zhou, Liang Zongzheng, Yang Yuanyuan, et al. Status and prospect of agricultural remote sensing[J]. Transactions of the Chinese Society of Agricultural Machinery, 2015, 46(2): 247-260. (in Chinese with English abstract)

[5] 李冰,梁燕华,李丹丹,等.多时相GF-1卫星PMS影像提取农作物种植结构[J].中国农业资源与区划,2017,38(9):56-62. Li Bing, Liang Yanhua, Li Dandan, et al. Crop planting structure extraction based on multi-temporal GF-1 pms remote sensing images[J]. Journal of China Agricultural Resources and Regional Planning, 2017, 38(9): 56-62. (in Chinese with English abstract)

[6] 王利民,刘佳,杨玲波,等.基于无人机影像的农情遥感监测应用[J].农业工程学报,2013,29(18):136-145. Wang Limin, Liu Jia, Yang Lingbo, et al. Applications of unmanned aerial vehicle images on agricultural remote sensing monitoring[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2013, 29(18): 136-145. (in Chinese with English abstract)

[7] 韩文霆,郭聪聪,张立元,等.基于无人机遥感的灌区土地利用与覆被分类方法[J].农业机械学报,2016,47(11):270-277. Han Wenting, Guo Congcong, Zhang Liyuan, et al. Classification method of land cover and irrigated farm land use based on UAV remote sensing in irrigation[J]. Transactions of the Chinese Society of Agricultural Machinery, 2016, 47(11): 270-277. (in Chinese with English abstract)

[8] 冯昕,杜世宏,张方利,等.基于多尺度融合的高分辨率影像城市用地分类[J].地理与地理信息科学,2013,29(3):43-47. Feng Xin, Du Shihong, Zhang Fangli, et al. Urban land classification of high resolution images based on multi-scale fusion[J]. Geography and Geo-Information Science, 2013, 29(3): 43-47. (in Chinese with English abstract)

[9] 汪小钦,王苗苗,王绍强,等.基于可见光波段无人机遥感的植被信息提取[J].农业工程学报,2015,31(5):152-159. Wang Xiaoqin, Wang Miaomiao, Wang Shaoqiang, et al. Extraction of vegetation information from visible unmanned aerial vehicle images[J]. Transactions of the Chinese Society of Agricultural Engineering(Transactions of the CSAE), 2015, 31(5): 152-159. (in Chinese with English abstract)

[10] 丁雷龙,李强子,杜鑫,等.基于无人机图像颜色指数的植被识别[J].国土资源遥感,2016,28(1):78-86. Ding Leilong, Li Qiangzi, Du Xin, et al. Vegetation extraction method based on color indices from UAV images[J]. Remote Sensing for Land and Resources, 2016, 28(1): 78-86. (in Chinese with English abstract)

[11] 井然,邓磊,赵文吉,等.基于可见光植被指数的面向对象湿地水生植被提取方法[J].应用生态学报,2016,27(5):1427-1436. Jing Ran, Deng Lei, Zhao Wenji, et al. Object-oriented aquatic vegetation extracting approach based on visible vegetation indices[J]. Chinese Journal of Applied Ecology, 2016, 27(5): 1427-1436. (in Chinese with English abstract)

[12] 韩文霆,李广,苑梦婵,等.基于无人机遥感技术的玉米种植信息提取方法研究[J].农业机械学报,2017,48(1):139-147. Han Wenting, Li Guang, Yuan Mengchan, et al. Extraction method of maize planting information based on UAV remote sensing techonology[J]. Transactions of the Chinese Society of Agricultural Machinery, 2017, 48(1): 139-147. (in Chinese with English abstract)

[13] 闵文芳,江朝晖,李想,等.基于无人机平台和图像分析的田间作物检测[J].湖南农业大学学报:自然科学版,2017,43(2):212-216. Min Wenfang, Jiang Zhaohui, Li Xiang, et al. Area measurement for field crops based on UAV platform and image analysis[J]. Journal of Hunan Agricultural University :Natural Sciences, 2017, 43(2): 212-216. (in Chinese with English abstract)

[14] 娄长安,潘能,文雯,等.石河子垦区农田土壤重金属含量与风险评价[J].石河子大学学报:自然科学版,2013(5):541-548. Lou Changan, Pan Neng, Wen Wen, et al. Assessmet and analysis of heavy metal content in farmland soil in Shihezi reclamation area[J]. Journal of Shihezi University : Natural Science, 2013(5): 541-548. (in Chinese with English abstract)

[15] 许文霞,翟勇,黄婷,等.石河子垦区农田土壤有机质和全氮空间分布特征研究[J].土壤通报,2015,46(6):1352-1358. Xu Wenxia, Zhai Yong, Huang Ting, et al. Spatial distribution of soil organic matter and total nitrogen in farmland in shihezi agricultural areas[J]. Chinese Journal of Soil Science, 2015, 46(6): 1352-1358. (in Chinese with English abstract)

[16] 吕娜娜,白洁,常存,等.近50年基于农作物种植结构的新疆绿洲农田蒸散发时空变化分析[J].地理研究,2017,36(8):1443-1454. Lü Nana, Bai Jie, Chang Cun, et al. Spatial-temporal changes in evapotranspiration based on planting patterns of major crops in the Xinjiang oasis during 1960-2010[J]. Geographical Research, 2017, 36(8): 1443-1454. (in Chinese with English abstract)

[17] 雷蕾,王晓丹.结合SVM与DS证据理论的信息融合分类方法[J].计算机工程与应用,2013,49(11):114-117. Lei Lei, Wang Xiaodan. Approach of information fusion and classification by SVM and DS evidence theory[J]. Computer Engineering and Applications, 2013, 49(11): 114-117. (in Chinese with English abstract)

[18] 韩洁,郭擎,李安.结合非监督分类和几何—纹理—光谱特征的高分影像道路提取[J].中国图象图形学报,2017,22(12):1788-1797. Hang Jie, Guo Qin, Li An. Road extraction based on unsupervised classification and geometric-texture -spectral features for high-resolution remote sensing images[J]. Journal of Image and Graphics, 2017, 22(12): 1788-1797. (in Chinese with English abstract)

[19] 王阿川,陈舒畅,王学良.结合HIS和小波变换的自适应遥感影像融合[J].光电工程,2016,43(8):76-83. Wang A’chuan, Chen Shuchang, Wang Xueliang. Adaptive remote sensing image fusion based on his and wavelet transform[J]. Opto-Electronic Engineering, 2016, 43(8): 76-83. (in Chinese with English abstract)

[20] 章三妹,唐正明.基于HIS颜色空间的彩色图像分割算法研究[J].西华师范大学学报:自然科学版,2012,33(3):304-307. Zhang Sanmei, Tang Zhengming. The research of color image segmentation algorithm based on his color space[J]. Journal of China West Normal University: Natural Sciences, 2012, 33(3): 304-307. (in Chinese with English abstract)

[21] Kruse F A, Raines G L. Technique for enhancing digital color images by contrast stretching in munsell color space[J]. Center for Integrated Data Analytics Wisconsin Science Center, 1984: 755-760.

[22] 侯群群,王飞,严丽.基于灰度共生矩阵的彩色遥感图像纹理特征提取[J].国土资源遥感,2013,25(4):26-32. Hou Qunqun, Wang Fei, Yan Li. Extraction of color image texture feature based on gray-level co-occurrence matrix [J]. Remote Sensing for Land and Resources, 2013, 25(4): 26-32. (in Chinese with English abstract)

[23] 胡勇,张孝成,马泽忠,等.无人机遥感影像中农村房屋信息快速提取[J].国土资源遥感,2016,28(3):96-101. Hu Yong, Zhang Xiaocheng, Ma Zezhong, et al. Rural residential area extraction from UAV remote sensing imagery[J]. Remote Sensing for Land and Resources, 2016, 28(3): 96-101. (in Chinese with English abstract)

[24] 菅小艳,韩素青,崔彩霞.不平衡数据集上的Relief特征选择算法[J].数据采集与处理,2016,31(4):838-844. Jian Xiaoyan, Han Suqing, Cui Caixia. Relief feature selection algorithm on unbalanced datasets[J]. 2016, 31(4): 838-844. (in Chinese with English abstract)

[25] 蒋玉娇,王晓丹,王文军,等.一种基于PCA和ReliefF的特征选择方法[J].计算机工程与应用,2010,46(26):170-172. Jiang Yujiao, Wang Xiaodan, Wang Wenjun, et al. New feature selection approach by PCA and ReliefF[J]. Computer Engineering and Applications, 2010, 46(26): 170-172. (in Chinese with English abstract)

[26] Kirwan J R. Reporting of significance levels versus Pearson's correlation coefficient[J]. Br J Rheumatol, 1984, 23(3): 232-233.

[27] 肖汉光,蔡从中.特征向量的归一化比较性研究[J].计算机工程与应用,2009,45(22):117-119. Xiao Hanguang, Cai Congzhong. Comparison study of normalization of feature vector[J]. Computer Engineering and Applications, 2009, 45(22): 117-119. (in Chinese with English abstract)

[28] 温奇,王薇,李苓苓,等.高分辨率遥感影像的平原建成区提取[J].光学精密工程,2016,24(10):2557-2564. Wen Qi, Wang Wei, Li Lingling, et al. Extraction of built-up area in plain from high resolution remote sensing images[J]. Optics and Precision Engineering, 2016, 24(10): 2557-2564. (in Chinese with English abstract)

Classification method of main crops in northern Xinjiang based on UAV visible waveband images

Dai Jianguo1,3, Zhang Guoshun1,3, Guo Peng2, Zeng Tiaojun1, Cui Meina1,3, Xue Jinli1,3

(1,,832003;2.,,832003; 3.,,832003,)

Northern Xinjiang is a significant base of agricultural production in China. Finding out the cropping structure of main crops is important for food security. Accurate acquisition of field crop planting information is the basis of agricultural production and the key to accurate estimation of yield. This paper selected some farmlands of the 8thDivision of Xinjiang Production and Construction Corps as the experimental region and verified region. In August 2017, the CW-20 fixed-wing drone was equipped with a Parrot Sequoia camera, which captured the visible light image. The red, green and blue bands were employed to color space conversion and texture filtering, the texture and structural features of the image were deeply explored, and the automatic extraction of crop planting information was realized. Firstly, color space transformation and gray level co-occurrence matrix texture filtering were used to obtain 27 texture features of hue, saturation, and brightness. Secondly, classification weights and correlation coefficients of 24 texture features and 3 low-pass features were calculated by ReliefF-Pearson feature reduction method. The redundant features with weak classification ability and high correlation were rejected. Hue convolution low pass, hue entropy, intensity correlation, hue homogeneity, intensity convolution low pass, intensity entropy, intensity homogeneity, intensity dissimilarity, saturation convolution low pass, saturation correlation, and intensity variance were the optimal features for visible waveband image classification. Based on the optimal classification features,-nearest neighbor (KNN), support vector machine (SVM), Naive Bayes (NB), artificial neural network (ANN), and decision tree (C5.0) classification algorithms were used to train model parameters and assess the classification effect. The overall classification of all methods is quite satisfactory, and the classification accuracy rate is over 80%. Among them, the SVM method has the highest classification accuracy, and the accuracy of testing set area classification is 83.77%, followed by the ANN and KNN methods. Finally, the SVM, KNN, and ANN classification methods were used to perform pixel-level supervised classification of images in experimental region and verified region, and the classification effects were evaluated based on visual interpretation maps. The results show that the SVM, KNN, and ANN classification methods are satisfactory in the classification of crop category, and the boundary of the field block is relatively complete, but the classification effect of the non-crop category is unsatisfactory. From the confusion matrix, the SVM method has the highest classification accuracy. Its overall accuracy is 80.74% and Kappa coefficient is 0.75. The classification accuracies of cotton, corn, marrow, and alfalfa crops are 82.78%, 85.49%, 92.65% and 80.84%, respectively, while that of the trees and other categories are only 64.58% and 59.28%, respectively. The overall accuracies of KNN and ANN methods are above 74%. In summary, based on the optimal color-texture features selected by ReliefF-Pearson, the SVM classification method is the most stable and reliable in the crop category classification and can be utilized to classify the main crops in northern Xinjiang. However, all classification methods are built on the pixel level. There are some differences in the canopy structure of the same crop, and some internal areas may be misclassified as others. Using object-oriented segmentation can improve the classification accuracy. In addition, there are differences in the growth period of different kinds of crops, and the difference in the optimal identification time differs greatly in the accuracy of each category. Using crop phenology information combined with the time-series images can get the expected classification effect. The method of this paper has a certain applicability for the UAV (unmanned aerial vehicle) visible waveband images to obtain planting information of the main crops in northern Xinjiang and provides a methodological reference for a large-scale crop planting information survey.

unmanned aerial vehicle; remote sensing; visible waveband images; color and texture features; machine learning; crops classification

10.11975/j.issn.1002-6819.2018.18.015

S252

A

1002-6819(2018)-18-0122-08

2018-03-30

2018-07-24

国家自然科学基金资助项目(31460317)

戴建国,副教授,主要从事农业信息化和遥感技术研究。 Email:daijianguo2002@sina.com

戴建国,张国顺,郭 鹏,曾窕俊,崔美娜,薛金利. 基于无人机遥感可见光影像的北疆主要农作物分类方法[J]. 农业工程学报,2018,34(18):122-129. doi:10.11975/j.issn.1002-6819.2018.18.015 http://www.tcsae.org

Dai Jianguo, Zhang Guoshun, Guo Peng, Zeng Tiaojun, Cui Meina, Xue Jinli. Classification method of main crops in northern Xinjiang based on UAV visible waveband images[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2018, 34(18): 122-129. (in Chinese with English abstract) doi: 10.11975/ j.issn.1002-6819 .2018.18.015 http://www.tcsae.org