基于卷积神经网络和多信息融合的三维乳腺超声分类方法

孔小函 檀 韬 包凌云 王广志#*

1(清华大学医学院生物医学工程系,北京 100084) 2(埃因霍温理工大学生物医学工程系,埃因霍温 5162wh) 3(杭州市第一人民医院超声影像科,杭州 310006)

引言

乳腺癌是严重危害女性健康的恶性肿瘤之一。据美国癌症协会(ACS)2012年公布的数据显示[1],乳腺癌是全世界女性中被诊断最多的癌症类型,也是女性癌症致死的主要原因。在2012年的所有女性癌症病例中,乳腺癌所占比例高达25%。早期检查可以及时发现乳腺异常,增加治疗选择。超声成像是临床上常用的乳腺影像学检查方式,但是目前手动超声用于乳腺癌筛查尚存在一些问题:一是操作者依赖性,可重复性差;二是无法建立标准的筛查流程。近年来,一种新的自动乳腺全容积超声成像(automated breast volume scanner,ABVS)技术开始进入临床,它采用超宽探头自动完成对整个乳腺的扫描,并且可以生成标准化的三维超声图像,可以从不同切面对同一病变进行全面的观察,为医生的诊断提供了更多的信息。相关临床试验证明,这种超声扫描技术具有诊断准确度高、操作者无关性和三维可视化等优点,是一种有前途的乳腺成像模式[2]。

医生往往需要根据超声图像对乳腺肿瘤进行良恶性的评估,而评估的结果是进一步确定治疗方案的重要前提。但是目前通过超声图像判断肿瘤的良恶性十分依赖于医生的个人经验,若能建立相关的计算机辅助诊断(computer-aided diagnosis,CAD)系统用于进行乳腺肿瘤的辅助分类,对于提高临床上的诊断效率和降低误诊率都具有重要的意义[3]。

乳腺超声图像分类是一项非常具有挑战性的工作:一是超声成像质量较差,图像往往包含较多噪声,给自动分类诊断增加了难度;二是目前尚缺乏大型公开且已标记的乳腺超声图像数据集,给算法的研究和测试带来了一定的困难。目前医学图像分类的常用方法可以分为两种,一种是基于手工特征的分类方法,另一种是基于深度学习的分类方法。

传统的分类方法一般包含4个阶段:图像预处理、图像分割、特征提取和选择、分类[3]。其中,越有代表性的特征往往意味着更好的分类结果,所以特征的设计[4]和选择[5]一直是研究的热点。在三维乳腺超声领域,Moon等提取形状、椭球拟合等三维特征用于肿瘤良恶性的分类[6];Tan等研究了冠状面上的毛刺特征对于分类性能的提升[7],他们都利用了三维乳腺超声上独有的特征来提高分类精度。但是,传统分类方法的流程较为复杂,而且特征的提取和选择尚没有通用的标准,方法的泛化能力较差。

近几年,深度学习[8]技术在自然图像的分类问题中取得了突破性进展[9-11]。不同于传统方法,深度学习不需要经历人工设计的目标检测、目标分割、特征提取等步骤,而是直接输入图像和图像标签,有监督地学习出具有复杂参数的高级模型,从而对新输入的图像进行预测。目前,将深度学习应用在医学图像分类领域取得了一系列的成果[12],在乳腺钼靶和病理切片图像中也得到了较为成功的应用[13-16]。在乳腺超声分类问题上,有关学者也开始尝试使用深度学习方法来简化分类流程,提高分类精度。Cheng等采用了一种堆栈式去噪自动编码器(SDAE)对二维乳腺超声图像进行分类,结果表明该种深度学习方法优于基于纹理的传统分类算法,达到了82.4%的准确率[17]。Han等利用迁移学习技术,使用7 408幅二维超声图像进行训练,达到了90%的准确率,显示了深度学习算法在临床应用上的潜力[18]。不过,上述研究均是将深度学习方法应用于二维乳腺超声图像中,目前还没有在三维乳腺超声数据上应用深度学习算法进行分类的相关研究。

三维乳腺超声的一个突出特点是比传统手动超声增加了冠状面方向上的信息,是对横截面信息的良好补充,临床上也常用作诊断依据。但是,冠状面图像和横截面图像在肿瘤良恶性分类判别中的所占权重及作用尚不明确,如何融合不同切面的图像信息来共同决定最终的分类判别仍是一个需要探究的问题。本研究采用深度学习中的卷积神经网络(convolutional neural networks, CNN)作为主要分类方法,设计了可以接受冠状面和横截面同时输入并且通过后期融合进行分类判断的网络结构,评估了该融合方法对于分类性能的影响。除了图像信息外,本研究还收集了每个病变的描述信息,设计了一种新颖的可以融合图像信息和文本信息的网络结构,使得仅训练一个网络模型就可以完成综合所有信息的分类判别,提升了分类效率。

1 方法

1.1 数据及预处理

本研究使用的数据集来自于340位患者,其中图像数据是通过西门子ACUSON S2000 ABVS和GE Invenia ABUS自动乳腺全容积超声成像设备扫描获得。图像数据集一共包含了880幅图像,其中12幅来自于GE ABUS设备,其余的均来自西门子ABVS设备。其中,良性病变图像401幅,恶性病变479幅。病变良恶性的分类标注来自医生,且均经过活检确认。此外,还收集了每幅图上关于病变图像特征描述的标注信息。因此,数据的预处理主要包含两个方面:图像数据预处理和文本标注预处理。

1)图像数据预处理。图像数据是三维数据,由于其特殊的成像方式,数据的每个维度具有不同的分辨率和像素数。随机选取某幅图像为例,其3个方向的像素数分别为718×446×565,像素间距依次是0.212×0.375×0.071(单位:mm/pixel)。本研究采用降采样和线性插值的方式将各方向的像素间距均调整为0.25 mm/pixel,使图像可以正常表现病变的实际形态和大小。然后根据医生标记的病变中心点坐标,分别截取横截面和冠状面方向上的ROI(region of interest)图像。因为数据集中大多数肿瘤的尺寸分布在10~20 mm之间,且三维乳腺超声的探测深度一般在40 mm左右,调整后的图像像素间距为0.25 mm/pixel,所以本研究将ROI的大小设为140像素×140像素,实际大小为35 mm×35 mm,得到的示例图像如图1所示。

图1 乳腺肿瘤的ROI图像。(a)良性肿瘤的冠状面ROI;(b)良性肿瘤的横截面ROI;(c)恶性肿瘤的冠状面ROI;(d)恶性肿瘤的横截面ROIFig.1 ROI images of breast tumor. (a) Coronal ROI of benign tumor; (b) Transverse ROI of benign tumor; (c) Coronal ROI of malign tumor; (d) Transverse ROI of malign tumor

可以看到,横截面和冠状面的肿瘤形态和灰度分布表现存在一定的差异。由于三维乳腺超声特殊的成像方式,探头运动方向上的分辨率较差,导致矢状面方向上的图像存在较严重的失真,临床上医生往往也不使用其作为诊断依据,故本研究后续不采用该方向上的图像用于分类判断。

2)文本标注预处理。标注信息是根据美国放射学会制定的BI-RADS(breast imaging reporting and data system)的标准病变描述。标注信息由6个特征构成,具体如表1所示。临床中,医师会根据图像中肿瘤的表现来进行标注。在使用这些文本信息之前要进行逐项转换,先将各项描述转换为表1中对应的数字,再根据各项的数值范围,将其进行线性变换映射到[0,1]区间,作为该项标注特征的描述。假设某项标注为x,在该项描述中可取的最大值为max,则转换公式为

f(x)=x/max

(1)

表1 BI-RADS标注信息说明Tab.1 Description of BI-RADS annotations

1.2 卷积神经网络

卷积神经网络(CNN)是一种前馈神经网络,能从一个二维图像中提取其拓扑结构,采用反向传播算法来优化网络结构,求解网络中的未知参数。与其他深度学习结构相比,卷积神经网络在图像和语音识别方面能够给出更好的结果。相比传统的图像处理算法,CNN避免了对图像复杂的前期预处理过程(如提取人工特征等),可以直接输入原始图像[19],因而得到了更为广泛的应用。

目前经典的卷积神经网络结构有LeNet[20](1998年)、AlexNet[9](2012年)、GoogLeNet[10](2015年)、ResNet[11](2016年)。这些经典的结构都经过了大量数据的测试与验证,往往具有更好的性能。一个卷积神经网络通常由以下5部分构成:

1)输入层。输入层是整个网络的输入,负责载入图像,用于后续的操作。

2)卷积层。通常包含多个卷积核,对输入的图像进行滤波,并加上偏置(bias),进行特征的提取。多个不同的卷积核可以提取出多个特征,每一个卷积核映射出一个新的2D图像。

3)激活函数层。将前面卷积核的滤波结果传入非线性激活函数,使网络具有非线性的表达能力,常用的激活函数有ReLU函数、Sigmoid函数等,其中ReLU函数的表达式为:

f(x)=max(0,x)

(2)

4)池化层。通过计算局部区域内的最大值或平均值来表示区域的整体特征,实现图像特征的降采样,缩小特征矩阵的大小,以减少神经网络的参数量和计算量。目前一般使用最大池化(max pooling)来保留最显著的特征。

5)全连接层。全连接层中前一层的任意一个节点,都和下一层的所有节点相连接,可以将提取的特征映射到样本标记空间,实现“分类器”的作用。

1.3 CNN模型设计

由于所处理的数据集较小,本研究采用搭建自己的网络结构并从头训练的方法。由Yann LeCun提出的LeNet5[20]是最早发展的卷积神经网络之一,该网络的提出也为深度学习的发展奠定了基础。LeNet5的诸多特性依然在目前表现最优的卷积神经网络中使用。所以本研究参考LeNet5的结构,首先搭建了一个包含3个卷积层、3个全连接层的简单网络结构,可以输入二维图像进行训练,作为基本模型,称作Single-Net,网络结构如图2所示。

图2 Single-Net网络结构Fig.2 The architecture of Single-Net

1)Single-Net。第1层为输入层,可输入单张的横截面(transverse)或冠状面(coronal)图像;第2层为卷积层,共有32个大小为3×3的卷积核,步长(stride)为1,激活函数采用ReLU函数;第3层为最大池化层,使用max pooling方法进行下采样,感受野为3×3,步长为2;第4、5层分别重复2、3层的结构;第6层为卷积层,共有64个大小为3×3的卷积核;第7层为最大池化层;第8层为全连接层,将上一层的输出拉伸成一维之后映射到256个输出节点上,同时进行L2正则化来防止过拟合;第9层是全连接层,输出节点为128,同时进行L2正则化;第10层为全连接层,输出节点为类别数2;最后通过Softmax函数将分类结果归一化。

在三维乳腺超声的实际应用中,医生会采用冠状面和横截面相结合的阅览方式来进行诊断。三维超声重建冠状断面上所表现的汇聚征、不规则毛刺征及完整的界面回声对乳腺肿瘤的鉴别诊断具有重要价值[21]。同时,横截面上的形态和声影等信息与冠状面有较大的差异。根据这一特点,本研究尝试设计了一种新的CNN网络结构,可以同时使用冠状面和横截面的ROI图像用于分类判断来提高准确率。需要注意的是,冠状面和横截面的图像特征存在较大差异,例如横截面上的后方回声,在冠状面上并没有体现。根据卷积神经网络的原理,本研究设计了2个独立的卷积结构分别用于两个截面的特征提取。特征提取完成后,将二者的结果相连接,利用全连接层实现特征的选取及权重优化,从而完成双图像输入的分类判断。该网络结构称为2Views-Net,具体结构如图3所示。

图3 2Views-Net网络结构Fig.3 The architecture of 2Views-Net

2)2Views-Net。输入层是将同一个三维数据的横截面和冠状面ROI图像一起输入模型,随后的卷积部分与Single-Net的卷积部分(conv block)的结构保持一致,卷积操作结束后将两个输出结果拉伸成一维向量,并进行拼接合并,然后输入全连接层部分,fc1共有512个神经节点,fc2有256个神经节点,最终完成分类。相比于Single-Net的全连接层,该结构的前两个全连接层中增加的节点是为了更好地适应横截面和冠状面特征的合并。

同时,为了明确2Views-Net的融合效果,本研究还设计了一种概率融合的方式来综合冠状面和横截面进行分类判断。首先使用训练集的冠状面图像在Single-Net上训练得到分类模型,记为Single-Net-Coronal;使用训练集的横截面图像在Single-Net上训练得到分类模型,记为Single-Net-Transverse。假设测试集中某一病变的冠状面图像在之前训练好的Single-Net-Coronal模型得到的预测概率为Pc,其横截面图像输入Single-Net-Transverse模型得到的预测概率为Pt,将这两个概率进行融合得到最终的概率用于分类预测。该方法记为Probability fusion。该方法的流程如图4所示。

图4 Probability fusion流程Fig.4 The progress of probability fusion

3)Probability fusion。将病变冠状面的预测概率Pc和横截面的预测概率Pt,按照下进行计算得到概率PM,作为最终的分类概率,有

PM=Pc×0.4+Pt×0.6

(3)

因为横截面图像对病变的显示比较清晰,同时也是临床上主要采用的诊断依据,所以使其概率所占比重稍大一些。

标注信息利用文本的形式对于乳腺肿瘤的重要特征进行了描述,这些信息比图像信息更加直接和明确,对于最终的良恶性判断也有非常重要的参考价值。本研究尝试将图像信息和文本信息融合到同一个卷积网络分类模型中。但是标注信息不同于图像信息,不需要进行特征提取的操作,可以直接连接到全连接层用于分类。基于2Views-Net的结构,将降维后的图像信息与标注信息相连接用于最终的分类判断,设计出第3种网络结构,该网络结构称为Multi-Net,具体结构如图5所示。

图5 Multi-Net网络结构Fig.5 The architecture of Multi-Net

4)Multi-Net。结构大致与2Views-Net保持一致,但在fc1层,将fc1层的输出和预处理之后的标注信息进行连接合并,变为512+6的一维向量,然后输入fc2层,最终进行良恶性分类。

对比3个模型可以发现,模型的基本结构保持一致,但输入的信息依次增多,根据增加信息的特点,调整网络结构适应于多信息的融合,通过该种设计,可以研究使用CNN进行信息融合的效果,并分析乳腺肿瘤分类问题中增加不同信息对提高肿瘤良恶性分类性能的影响。

1.4 实验设计

1.4.1数据集划分与平衡

在进行CNN的训练之前,需要将数据集划分为训练集和测试集,其中训练集用于网络的训练,测试集用于评估模型的分类性能。需要注意的是,本研究所用数据集中一个病人通常会包含多幅扫描图像,这些图像之间往往具有一定的相关性。为了避免同一病变不同扫描视图下的图像间的相互影响,在划分数据集的时候,需要以病人为单位进行划分,而非以图像为单位。同时还注意到数据存在良恶性不平衡现象,良性样本的数量小于恶性样本的数量。如果数据非线性可分,则这种不平衡会导致分类结果向数据较多的一方偏移[22],从而影响分类器的性能。所以,在较少的良性病例中随机采样增加数据,使训练集中良恶性图像数量一致,避免数据对模型分类结果造成偏差。

1.4.2训练方法

采用TensorFlow[22]深度学习框架进行模型的搭建和数据的训练。在数据输入时,由于数据量较小,所以对原始图像进行一些变换操作来实现数据增强,以提高网络的鲁棒性和分类性能。本研究主要采用两种数据增强方式:一是对原始图像进行随机裁剪,在140×140的图像中随机截取128×128的图像;二是水平翻转,将图像的左右方向进行翻转。训练时,batch size设为64,初始学习率为0.000 1,每迭代100次进行衰减,衰减率为0.96。loss的计算采用交叉熵(cross entropy)方法,优化器算法使用Adam。训练次数为150个epoch。

将全部参数设置好后,为了避免数据集划分对于实验结果的影响,对全部数据进行5折交叉验证(5-fold cross validation)。先将数据集随机均匀地分成5份,轮流将其中4份作为训练数据,1份作为测试数据,进行实验。每次试验都会得出相应的正确率,5次结果的正确率的平均值作为对算法精度的估计。本研究一共进行了5次5折交叉验证实验,得到25组测试结果。通过计算各项评价指标的平均值和标准差,以便对各个网络模型的性能进行客观准确的评估。

1.4.3评价标准

对于医学图像的分类问题,常用的评价标准有准确率(accuracy)、敏感性(sensitivity)、特异性(specificity)、受试者工作特征曲线(receiver operating characteristic curve,ROC曲线)及AUC (area under ROC curve)。

针对一个二分类问题,将实例分成正类(positive,P)或者负类(negative,N)。但是实际中分类时,会出现4种情况:真正类(true positive,TP),模型预测为正类的正样本;假正类(false positive,FP),模型预测为正类的负样本;假负类(false negative,FN),模型预测为负类的正样本;真负类(true negative,TN),被模型预测为负类的负样本。

基于分类情况可以计算各个评价指标:

1)准确率(accuracy)

accuracy=(TP+TN)/(P+N)

(4)

准确率是测试集中模型正确分类的样本所占的比例,反映了模型的预测分类能力。

2)敏感性(sensitivity)

sensitivity=TP/(TP+FN)

(5)

敏感性是模型正确识别的正例数据在实际正例数据中所占的百分比,反映了模型对于正例数据的识别能力。

3)特异性(specificity)

specificity=TN/(TN+FP)

(6)

模型正确识别的负例数据在实际负例数据中所占的百分比,反映了模型对于负例数据的识别能力。

4)AUC

ROC曲线指受试者工作特征曲线或接收器操作特性曲线,是反映敏感性和特异性连续变量的综合指标。首先定义TPR(true positive rate)和FPR(false positive rate),即

TPR=TP/P

(7)

FPR=FP/N

(8)

ROC曲线以FPR为横轴、TPR为纵轴,最理想的分类情况是TPR=1,FPR=0。AUC(area under curve)被定义为ROC曲线下的面积,由于ROC曲线一般都处于y=x这条直线的上方,所以AUC的取值范围在0.5~1.0之间。使用AUC值作为评价标准,是因为很多时候ROC曲线并不能清晰地说明哪个分类器的效果更好,而AUC作为数值可以直观地评价分类器的好坏,其值越大性能越好。

1.4.4显著性检验

因为实验的随机性和有限性,不能仅仅通过比较准确率和AUC的平均值就做出确切的结论,而是要对数据进行显著性检验,判断差异是由偶然因素或误差引起的,还是两者之间确实存在不同。根据实验的特点,使用配对样本t检验的方法对实验结果做显著性检验,具体步骤如下:

1)建立假设检验,确定检验水准。H0表示两方法的结果不存在显著性差异,H1表示两方法的结果存在显著性差异。双侧检验,检验水准α=0.05。

2)计算统计量为

(9)

3)确定P值,做出统计推断。

查相应的界值表,得到P值。若P>α,则H0假设成立;若P<α,则H1假设成立。

2 结果

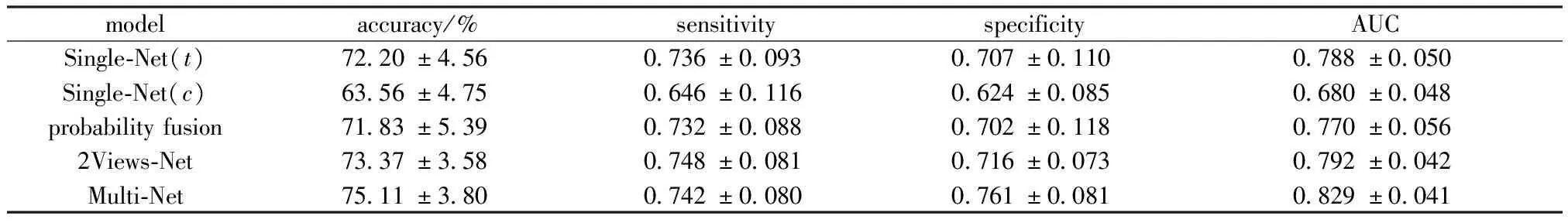

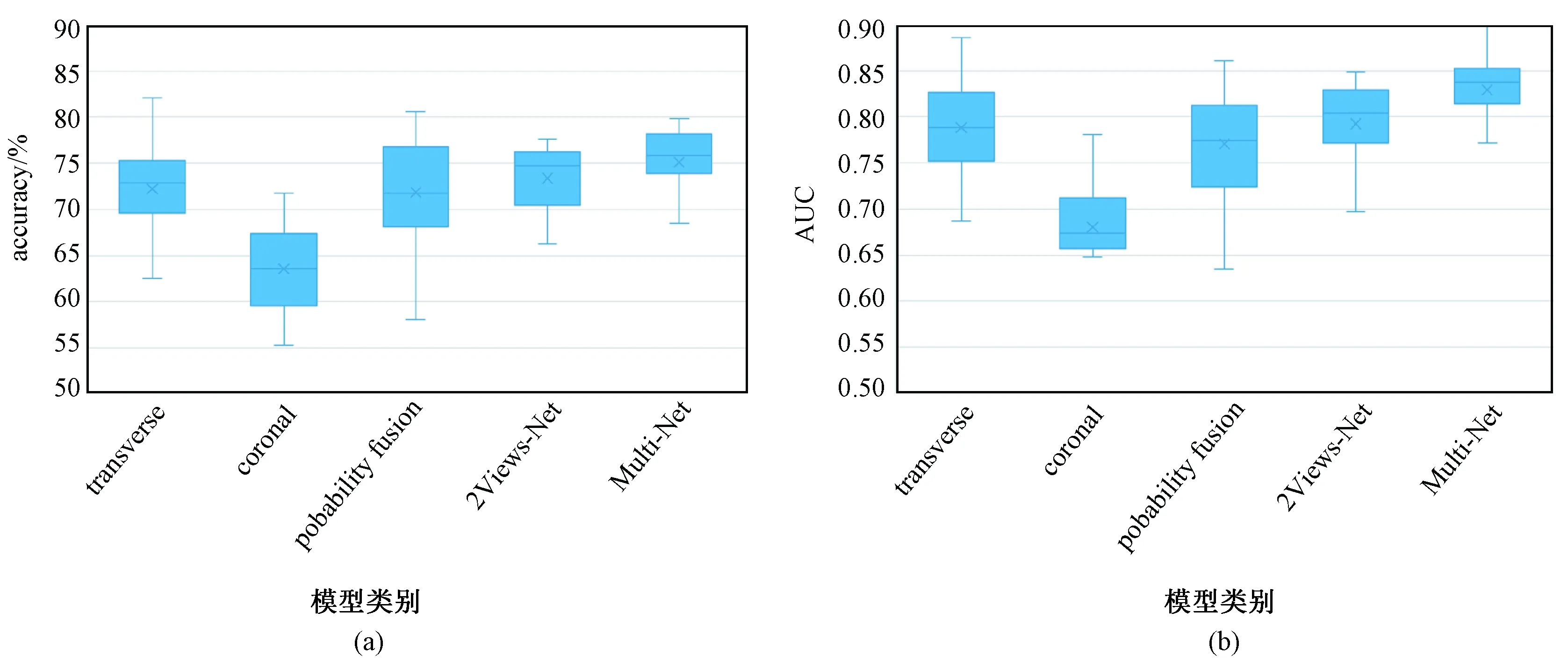

为比较3种模型的分类表现,按照模型要求将相关数据输入进行实验,得到各模型的实验结果如表2所示,其中Single-Net(t)代表使用横截面进行训练,Single-Net(c)代表使用冠状面进行训练。所有的实验结果的数据分布如图6所示,显著性分析的具体结果如表3所示。分析实验数据可知,在Single-Net中,使用横截面的分类准确率和AUC明显高于使用冠状面;同时,通过显著性分析发现二者的分类效果有着极显著的差异。

在probability fusion方法中,虽然进行了概率融合,但准确率和AUC与使用横截面的Single-Net模型相比有所下降,甚至两组的AUC存在显著性差异,说明该种融合方式并不能进一步地提高分类性能。

在2Views-Net中,通过比较准确率和AUC均值,发现冠状面和横截面同时输入的分类表现均优于二者单独输入的表现,同时敏感性和特异性也得到了一定的提升。对2Views-Net模型和使用横截面的Single-Net模型的实验结果做显著性分析,发现两组的准确率和AUC的P值均大于显著性水平。这说明2Views-Net虽然综合了横截面和冠状面的信息,但是在分类效果上与使用横截面的Single-Net模型无显著性差别。与probability fusion方法对比,2Views-Net 的准确率和AUC更高,两组的AUC的P值小于显著性水平,存在非常显著的差异。

在Multi-Net中,标注信息的加入使分类的准确率、特异性和AUC均得到了明显的提升。与使用横截面的Single-Net相比,两组的准确率和AUC的P值均小于显著性水平,说明Multi-Net的分类能力明显优于Single-Net。与2Views-Net的分类结果进行对比,并做显著性分析,两组的准确率和AUC的P值均小于显著性水平,说明Multi-Net模型的分类性能明显优于2Views-Net;同时,两组特异性的P值为0.013,小于显著性水平,说明标注信息的加入使网络对良性病例的识别能力得到了提升。

表2 3种网络模型的实验结果Tab.2 Experimental results of three CNN models

图6 实验结果的箱式图。(a)准确率;(b)AUCFig.6 Box plots of experimental result. (a)Accuracy; (b)AUC

对比分组二者accuracy的P值二者AUC的P值Single-Net (t) & Single-Net (c) 2.51×10-6∗∗∗ 5.47×10-8∗∗∗Single-Net (t) & probability fusion0.6862.40×10-2∗Single-Net (t) & 2Views-Net0.1300.525Single-Net (t) & Multi-Net 3.77×10-3∗∗ 2.65×10-5∗∗∗probability fusion & 2Views-Net6.92×10-2 7.20×10-3∗∗2Views-Net & Multi-Net 1.41×10-3∗∗ 2.20×10-12∗∗∗

注:*P<0.05,**P<0.01,***P<0.001

Note:*P<0.05,**P<0.01,***P<0.001

3 讨论

在Single-Net中,使用冠状面的分类效果最差。通过分析,造成这个结果的原因可能有3个:一是两个视图对病变的表现能力不同,横截面上病变的形状、边缘等特征都十分清晰,同时还具有独特的回声信息,冠状面对于病变的形态特点的表现能力较弱,病变边界较为模糊,脂肪组织等干扰信息较多;二是由于三维乳腺超声设备的成像原理,冠状面的分辨率低于横截面,冠状面上截取的ROI是经过插值之后的结果,图像质量较差;三是网络的层数较少,提取复杂特征的能力有限,不适用于冠状面中一些抽象特征的表达。

对比2Views-Net和probability fusion的实验结果,可以发现,使用2Views-Net进行信息融合具有明显的优势,是一种有效的信息融合方法。2Views-Net的双输入设计,改变了传统CNN网络中单输入的结构,使得同一病灶的2张不同方向下的图像可以同时输入网络进行特征提取,还可以通过训练使其自动学习到横截面和冠状面特征的融合方式,并用于分类判断。该种融合方式代替了probability fusion中概率的简单线性结合,提升了分类性能。与使用横截面的Single-Net模型的实验结果对比,发现2Views-Net对于分类效果的提升比较有限,原因可能是增加的冠状面图像对于提升分类效果的作用比较有限,用于分类的主要有效信息依旧来自于横截面。

Multi-Net的分类性能是所有模型中最好的。它在2Views-Net的基础上进一步将图像信息和文本信息融合到一个卷积神经网络中进行分类判断,显著地提升了分类的准确率和AUC。新增的标注信息虽然只有6项,但对于模型分类性能却有着十分明显的提升作用。

综合上述分析,发现在卷积神经网络用于乳腺肿瘤超声图像分类的应用中,增加冠状面图像和标注信息对于提高分类效果有着积极作用。一般情况下,冠状面信息的分类效果较差,而标注信息的维度较少,相对于横截面来说,这两项都不是最适于单独作为分类依据的信息。所以,如何合理地使用并且综合这些信息的有效部分来提高分类效果就成为了一个难点。本研究通过优化调整卷积神经网络的结构,探究了不同信息的融合对于分类的影响,并使2Views-Net和Multi-Net在多种信息中自动学习到了最有效的部分,充分发挥了多种信息的分类优势,避免了传统方法中人为选取特征进行融合的复杂性和局限性,提高效率的同时也改善了单输入网络的分类效果。实验结果也反映出本研究设计的网络结构与增加的信息特点相适应,使得新增信息在网络中得到了有效的利用。另一方面,这也为乳腺超声图像的分类研究提供了新的思路,在诊断之前为模型输入充分的、多类型的信息将有助于最终的良恶性判别。

目前,本研究所采用的CNN网络结构是比较简单的,对于图像的特征提取能力有限,未来仍需要研究利用深度网络和迁移学习[23]等方法来改进模型的特征提取能力和分类能力,使分类准确率得到进一步的提升。

4 结论

本研究主要基于三维乳腺超声数据进行肿瘤良恶性分类的深度学习算法设计,重点研究了调整卷积神经网络结构来融合多种信息对于分类性能的影响。结合不同信息的特点以及利用CNN模型的灵活性,提出了Single-Net、2Views-Net和Multi-Net共3种模型,并进行了对比。实验结果证明,除了使用传统的横截面之外,增加冠状面和标注信息使得 CNN模型的分类性能得到了明显提升。另外,也证明了使用卷积神经网络进行多信息融合是一种有效的融合方式,省去了人为设计融合方法的步骤,提升了分类效率和准确率。该种方法在解决三维数据分类问题和信息融合问题具有一定的潜力,值得未来做进一步的探索和研究。