基于卷积神经网络的车型颜色综合识别

冯 锦,李玉惠

(昆明理工大学 信息工程与自动化学院,云南 昆明 650500)

交通监管部门常采用车牌[1]进行车辆信息跟踪[2]。但是,辨识车辆的唯一标识不能仅仅应用车牌信息,因为部分车主进行违法活动时为了逃避责任会对车牌进行故意破损、遮挡或套牌。因而,车辆颜色、车辆类型、其他特征(如年检标、车内挂饰等)被视为实现车辆识别的基本特征。车辆类型、车辆颜色因易于区分,且不易改动,便作为车辆识别中重要的特征。

美国California大学的Sayanan Sivaraman等人利用主动学习方法,并将梯度特征、Haar特征结合,再将SVM和Adaboost分类器两者结合进行车型识别[3-6];Lebanese的Bassam Daya等采用一种基于几何参数,并利用神经网络的分类器实现多类车型识别[7-8];根据GA24-8公安车辆颜色代码、GB-T3181-1995漆膜颜色标准结合公安和交通对车辆对象颜色应用的需求,将车辆颜色统一分为:黑色、蓝色、绿色、棕色、白色、黄色、粉色、紫色、红色、灰色和其它共11类。现阶段主要有对车辆全身颜色特征[9]、提取车辆感兴趣区域颜色特征两种对车辆颜色识别的方法。其中涉及的机器学习理论主要有KNN、人工神经网络[10]和SVM[11]。

吴艺塔等人提出的先目标分割去除反光镜、车轮等干扰后得到车辆颜色显著区域,之后对联通区域再分析,使用SVM两层分类器将颜色分为红、黄、蓝、绿、白、黑、银7种的方法,对绿黑银3种颜色的识别率不高[12]。方静等人应用BP神经网络把颜色分了7类[13]。其中经过了为获得车颜色每个像素的微观特性值,利用HSI的3个通道,定义7种颜色彼此关系、阈值范畴的过程。为降低各因素对识别的干扰,缩小车辆检索范围,现有方法多是类似先进行车型识别再颜色识别。[14]的这种分布式多次特征筛选后,缩小检索范围再进一步得出最终目标车辆。

本文采用深度学习Caffe框架中LeNet网络、AlexNet网络、GoogLeNet网络3种卷积神经网络模型,应用提前已做出车型、颜色两种特征标记的车辆图像进行网络训练与验证。再与基于SVM的车型颜色识别方法进行比较验证实验。最终得出应用深度学习Caffe框架下GoogLeNet网络的分类方法对车型颜色的综合识别准确率高,实时性强。

1 车型与颜色识别方法原理与结构

1.1 深度学习框架3种网络模型分析

Caffe的全称应该是Convolutional Architecture for Fast Feature Embedding,它是开源的,核心语言是C++,支持命令行、Python和Matlab接口,既可以在CPU上运行也可以在GPU上运行。

LeNet网络包含了卷基层、Pooling层、全连接层,其构造规模不大,是现今CNN网络的根本组件。LeNet-5共8层,每层有多个参数,蕴含输入层在内。C层为卷积层,S层为下采样层。为使原信号特征增强可通过卷积层操作来实现,同时也可降低噪音。

1.1.2 AlexNet网络模型分析

2012年,Geoffrey和他的学生Alex为了回应质疑,在ILSVRC竞赛中所用的网络结构被称为AlexNet模型。

AlexNet模型的卷积层在前5层,全连接层在后3层,共8层,参数量达60 MB以上。有1 000个输出的softmax是全连接层的最后一个输出。网络最后的优化目标是最大化平均的多项逻辑回归。

1.1.3 GoogLeNet网络模型分析

GoogLeNet网络模型[15],是22层的深度网络模型,输入的原始数据大小为2 242 243。该模型证明,用更多卷积、更深层次能获取到更好的训练验证成果。同时,GoogLeNet应用了Inception结构后,既减少了参数量,也提高了预测分类的成功率。

1.2 SVM网络分类原理

支持向量机完成原理,是将输入向量,经过某个提前选择好的非线性映射(核函数),映射至一个高维,可构建最优分类超平面的特征空间。是针对分类两个数据类别情况而提出的。对于样本集(xi,yi),i=1,2…n,xi∈Rn,yi∈{-1,1},构建的分类面为:wx+b=0,可将两类样本无错且无偏差的分开,使它们间隔最大。w,x为n维的向量,普通线性判别函数,模式为g(x)=wx+b,对w和b采用相同大小的缩放方法,进行归一化。两类全部的样本均满足g(x)≥1,两类总共的样本分类距离为2/‖w‖,距离分类面最近的样本满足|g(x)|=1。

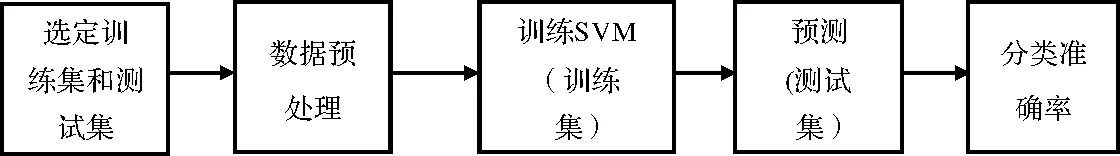

基于SVM网络车型颜色特征数据分类算法流程如图1所示。

天脊集团是中国硝酸磷型复合肥的缔造者。正因为如此,“天脊化肥就要打造中国硝基肥第一品牌”这是天脊集团确定的天脊产品定位、实施的品牌战略目标。

图1 算法流程图

它是一个二类分类学习模型,学习策略是间隔最大化,常被用来做模式的辨认识别、模型的分类工作。

2 实验过程

2.1 数据集准备

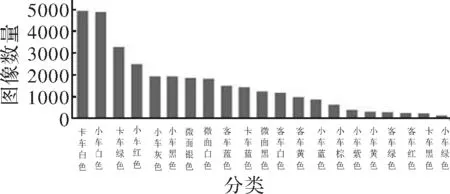

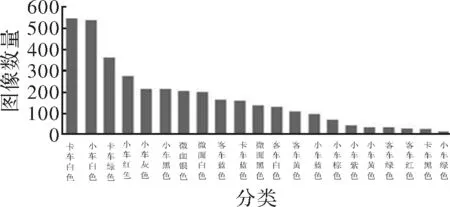

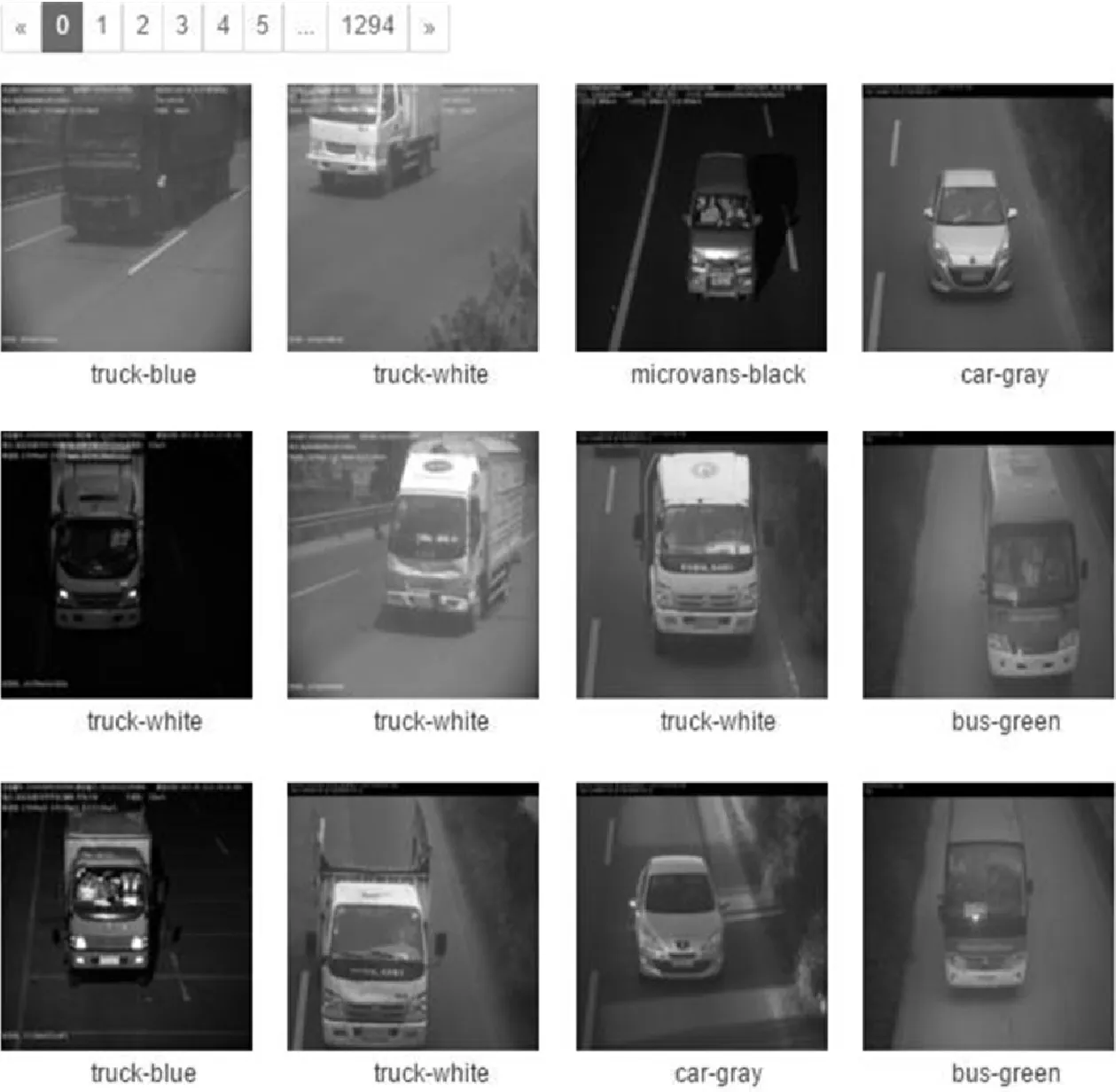

通过交通高速公路主干线各卡口24 h照相设备,采集高速公路过往车辆图片,获取高速公路车辆高清图片数据集。为保证数据的真实可靠性,对该数据集进行人工分类标注,分为了小车-黑色、微面-白色、卡车-蓝色、客车-绿色这样的车型-颜色模式21类。共采集不同尺度、光照、角度的车辆图片35 951张,其中小车分为9种颜色,共14 943张;微面分为3种颜色,共5 425张;卡车分为4种颜色,共10 938张;客车分为5种颜色,共4 645张。通过英伟达(NVIDIA)的digits中制作分类数据的工具将高速公路车辆高清图片数据集制作成深度学习框架能够快速读取的格式,同时将高速公路车辆高清图片数据集划分90%为训练集,10%为验证集,并将彩色图片尺度归一化为统一大小。

图2和图3为训练集和验证集实验数据的具体情况,图4为实验模型中256 256像素的部分车型颜色图片。

图2 训练集

图3 验证集

图4 部分车型与颜色图片

2.2 利用Caffe框架的实验

利用3种网络模型分别进行实验。实验方案如下:将28×28像素数据集输入到LeNet网络、256 256像素数据集输入到AlexNet和GoogLeNet两个网络模型进行训练。将训练好的网络模型用于验证集识别率的验证分析;再以小车图片为例,验证单张车型颜色图片识别准确率,并将每层网络输出结果可视化;得到结果后,先对3个网络模型实验结果进行类内对比分析;之后,再与运用SVM后的识别结果进行类间比较,分析后得出结论。

3 实验结果分析

3.1 3种网络模型类内对比

实验结果显示,3种网络模型训练过程中训练集损失率、验证集损失率随迭代次数的增加而下降,并逐渐趋于平稳;验证集准确率随迭代次数的加大而提高,逐渐趋于平稳。文章实验中共迭代了30次,学习率的

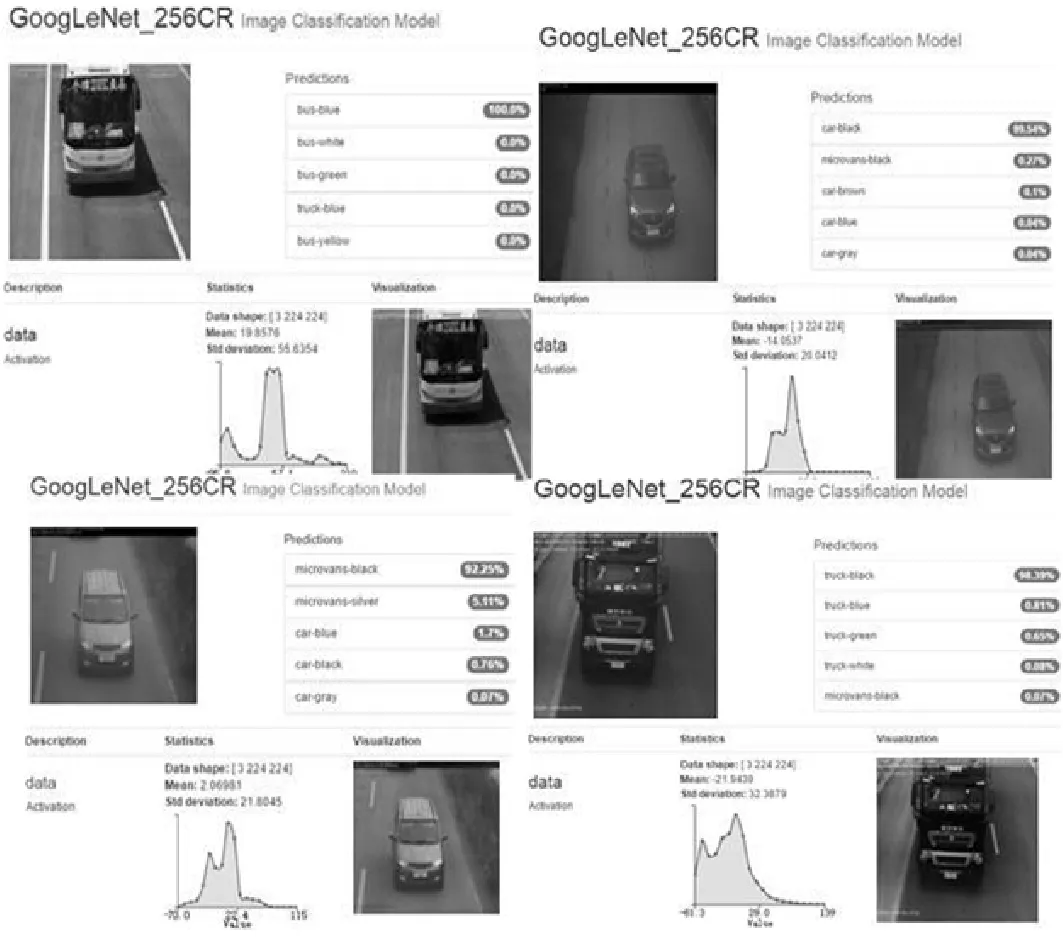

初始值为0.01;迭代10次时,学习率下降至0.001;当迭代20次时,学习率下降至0.000 1。在网络训练的过程中可以看到损失与准确率的跨度随学习率的下降而逐渐变小,渐渐趋于平稳。图5给出3种模型中识别效果较佳的GoogLeNet网络模型对一张图片的车型颜色识别效果图。

图5 GoogLeNet网络模型识别效果图

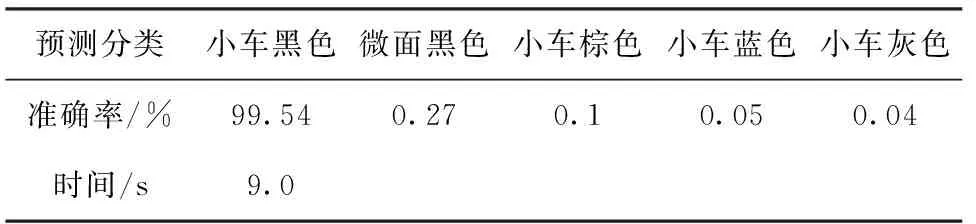

实验中的GoogLeNet模型对一张图片数据分类结果如表1所示。

表1 一张小车-黑色图片预测分类结果

从表1可看出GoogLeNet模型被训练好以后,对于单张图片数据的分类结果很理想,但预测分类所用时间比AlexNet网络模型的长。

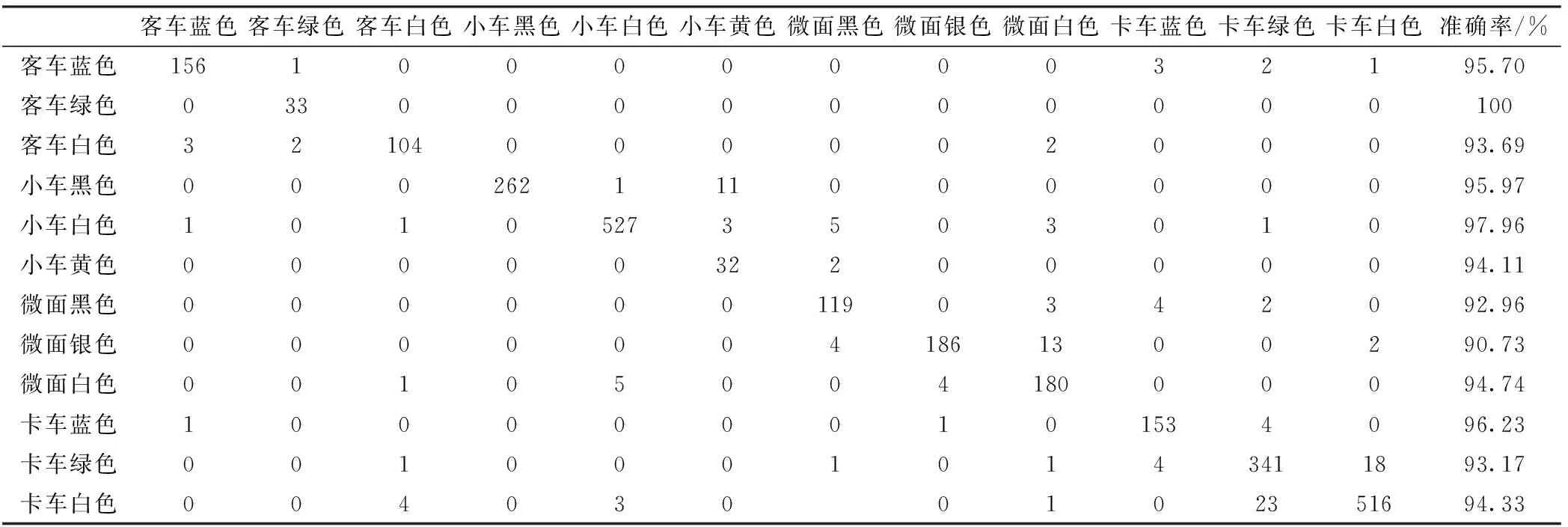

由于分类种类繁多,3种网络模型实验结果的混淆矩阵过大且类似。为合理布局,仅选取训练好的GoogLeNet网络模型,对总数据量10%的验证集里4种车型部分车辆颜色分类结果的混淆矩阵为例来显示实验结果,如表2所示。

表2 GoogLeNet网络模型下部分车型颜色分类结果混淆矩阵

从混淆矩阵中可以看出,Caffe框架下的3种模型对车型颜色综合识别的准确率较传统识别方法有较大提升。

首先,通过对Caffe框架下3种模型的车型颜色识别研究实验结果可知:LeNet网络模型构造简单,对手写数字的辨识率较高,但对大数据量、复杂的物体图片分类还远远不够。本文利用该模型对车型颜色综合分类识别的结果为90.3%,AlexNet网络模型证明,在复杂模型下,CNN具有的有效性。但是,由于AlexNet模型,在回归到全连接层时,参数总量达到60 MB,所需网络参数最多。准确率为92.13%,略高于LeNet。该模型下车型颜色识别中卡车绿色和卡车白色两类的识别率不高,仅达到88%。分析可能的原因:一是两类图片数据量不足,使得本身训练结果不佳导致验证结果偏低;二是采集到的两类图片数据都是正面图,由于采集时各种外界因素使得两类特征过于相似而不易区分。后续将会对此问题做出进一步实验验证分析;GoogLeNet模型表明,用更多卷积、更深层次能获取到更好的训练验证成果,本文利用GoogLeNet模型对车型颜色进行识别后结果可达95.9%,甚至对个别车型颜色综合识别的准确率可达100%,效果较好。

另外,应用GPU后,在LeNet、AlexNet、GoogLeNet3种网络模型下完成的实验消耗GPU显存容量分别为1 GB、3 GB、3 GB依次增加;训练模型与验证结果总共耗时分别为8 min、60 min、110 min。使大数据训练在可接纳时间长短内,获得了较好结果。

3.2 SVM与Caffe框架下3种模型结果对比

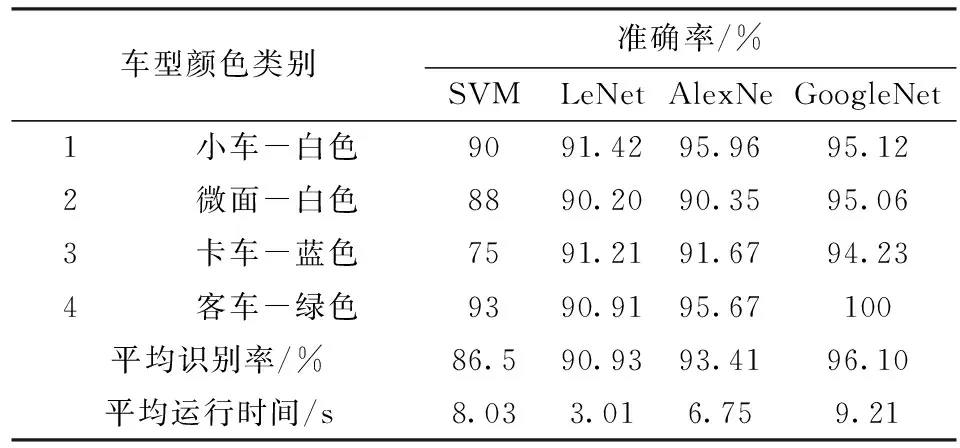

选取SVM与caffe框架下3种模型对车型颜色综合识别准确率较高的实验结果进行对比,数据如表3所示。

表3 4种车型颜色综合识别准确率

4 结束语

针对高速公路复杂环境对车型颜色综合识别的干扰以及常用分布识别步骤繁琐的问题,提出利用Caffe框架下的LeNet、AlexNet、GoogLeNet3种模型进行综合识别的方法,以提高识别准确率,降低因素干扰,节省时间。再与基于SVM的车型颜色识别方法进行实验结果比较分析后表明:Caffe框架中3种模型对车型颜色的综合识别率高于基于SVM方法的识别率;并且其中GoogLeNet的识别率最高效果最好。对于综合识别率,本文方法自动进行网络训练与验证,实现了“提取-识别-分类”全过程的主动进行。避免了常用分布识别的繁杂流程和步骤,大幅降低了高速公路环境中复杂因素对车型颜色识别造成的影响。同时也缩小了车辆搜寻的排查范围,节省了时间,为最终实现车辆检索奠定基础。

[1] 孙阳,王云龙,何文铎.低清晰度车牌识别技术的研究与应用[J].华中科技大学学报,2016,10(44):138-142.

[2] 刘阳,王忠立,蔡伯根.复杂环境基于多特征融合的车辆跟踪方法[J].交通运输系统工程与信息.2015,15(6):74-81.

[3] Sivaraman,Sayanan,Trivedi,et al.Active learning for on-road vehicle detection:acomparative study[J].Machine Vision and Applications,2014,25(3):599-611.

[4] Sivaraman,Sayanan,Trivedi,et al.Looking at vehicles on the road:a survey of vision-based vehicle detection,tracking,and behavior analysis[J].Transactions on Intellgent Transportation Systems,2013,14(4):1773-1795.

[5] Eshed Ohn-Bar,Sayanan Sivaraman,Mohan Trivedi.Partially occluded vehicle recognition and tracking in 3D[C].Orleans:IEEE Intelligent Vehicles Symposium,2013.

[6] Wei W,Zhang Y,Wu Linlin.Application of GA-based AdaBoost algorithm in vehicle identification[J].Journal of Highway&Transportation Research&Development,2010,27(2):114-118.

[7] Bassam Daya,Al Hussain Akoum,Pierre Chauvet.Neural network approach for the identification system of the type of vehicle[C]. Louisiana:International Conference on Computational Intelligence and Communication Network,2010.

[8] Wang L,Zhang N,Du H.Real-time identification of vehicle motion-modes using neural networks[J].Mechanical Systems & Signal Processing,2015(7):632-645.

[9] 赵红波,张涵.车辆颜色识别方法研究[J].电视技术,2013(23):207-209.

[10] 徐博.基于卷积神经网络的车辆属性识别[D].北京:北京理工大学,2016.

[11] 薛丹,孙万荣,李京京.一种基于SVM的改进车牌识别算法[J].电子科技,2013,26(11):22-25.

[12] Wu Y T,Kao J H,Yu M.A vehicle color classification method for video surveillance system concerning model-based background subtraction[C].Shanghai:Proceeding of Pacific Rim Conference on Multimedia,2010.

[13] Fang Jing,Yue Hengjun,Li Xiuzhi.Color identifying of vehicles based on color container and BP network[C].Harbin:Proceeding of IEEE Conference on Business Management and Electronic Information,2011.

[14] 郭艺帆.基于融合特征的车辆识别[D].成都:电子科技大学,2016.

[15] Szegedy C,Liu W,Jia Y,et al.Going deeper with convolutions[C].LA,USA:IEEE Conference on Computer Vision&Pattern Recognition,2014.