自动驾驶环境感知系统研究

郝俊

长春汽车工业高等专科学校 吉林省长春市 130013

1 引言

美国汽车工程师学会SAE将自动驾驶分为6个等级:L0无自动化、L1驾驶支持、L2部分自动化、L3有条件自动化、L4高度自动化和L5完全自动化。

《汽车产业中长期发展规划》中指出,到2020年,汽车DA(驾驶辅助)、PA(部分自动驾驶)、CA(有条件自动驾驶)系统新车装配率超过50%,网联式驾驶辅助系统装配率达到10%,满足智慧交通城市建设需求。到2025年,汽车DA、PA、CA新车装配率达80%,其中PA、CA级新车装配率达25%,高度和完全自动驾驶汽车开始进入市场。

自动驾驶系统主要包含三个部分:感知、决策、控制。其中环境感知系统是实现自动驾驶的基础,它的原理是利用车辆搭载的传感器对周围的行驶环境信息进行数据采集,然后进行数据处理。

2 自动驾驶环境感知系统传感器

目前,现有的车载传感器包含激光雷达、毫米波雷达、摄像头、超声波雷达等。传感器负责采集自动驾驶汽车所需要的信息,比如汽车自身、行驶环境等,为自动驾驶汽车的安全行驶提供可靠的决策依据。

2.1 激光雷达

激光雷达实时感应周边环境信息,形成高清立体图形。激光雷达的工作原理是,激光发射器发射脉冲调制光线,观察反射光线与发射光线间的时间差来计算距离,通过扫描或多股光线同步测量来获得角度信息。速度反应快、探测距离远、精度较高,所以它是目前已知的环境测量方案中测量精度最高的传感器解决方案。

图1 自动驾驶汽车环境感知技术

激光雷达可以用来探测路面场景中的其他车辆和障碍物,其他道路使用者,比如行人和非机动车,还可以探测道路。但是如果在不利的天气下,它的灵敏度也会降低,比较容易受到天气条件的影响。

激光雷达的价格过于昂贵,目前还难以在批量产品上使用。目前潜在的市场有两种趋势。一种是在性能上降低成本,生产制造的激光雷达只能完成特定任务,且探测距离有限;另一种是使用纯固态电子存封工艺降低成本。

2.2 毫米波雷达

毫米波雷达是在自动驾驶中广泛使用的传感器,主要用于对道路车辆的检测,检测速度快、准确,不易受到天气影响,对车道线交通标志等无法检测。毫米波雷达由芯片、天线、算法共同组成,基本原理是发射一束电磁波,观察回波与入射波的差异来计算距离、速度等。成像精度的衡量指标为距离探测精度、角分辨率、速度差分辨率。毫米波频率越高,带宽越宽,成像约精细。

毫米波雷达工作在毫米波频段,是指长度在1~10mm的电磁波,对应的频率范围为30~300GHz。在毫米波雷达的频率选择上,主要由三种波段,24GHz,60GHz,77GHz。

毫米波雷达波长短,频带宽,穿透能力强,探测距离远,可以在雨雪天气等各种恶劣环境中稳定工作,但是精度不高。

毫米波雷达分为长距雷达(LRR)和短距雷达(SRR),由于毫米波在大气中衰减弱,所以可以探测感知到更远的距离,其中长距雷达可以实现超过200m的感知与探测。短距雷达SRR是一种超宽频的脉冲雷达,可以在一个24GHz的载波频率上运行。它主要安装在汽车车身的边缘区域,用来探测靠近汽车的物体,也可以用来监控汽车的后方区域。目前主要应用在停车辅助、盲点检测、并线辅助、防撞系统等。ACC系统中的启停控制功能也会用到。长距雷达LRR的工作频段通常是77GHz,探测范围是150-200m,通常被安装在前保险杠的中间,主要用于正面防撞。有时也被安装在保险杠上,或者两个长距雷达同时安装在前保险杠上。目前主要应用于ACC系统。通常来说,为了满足不同距离范围的探测需求,车辆上会安装多个短距、长距毫米波雷达。

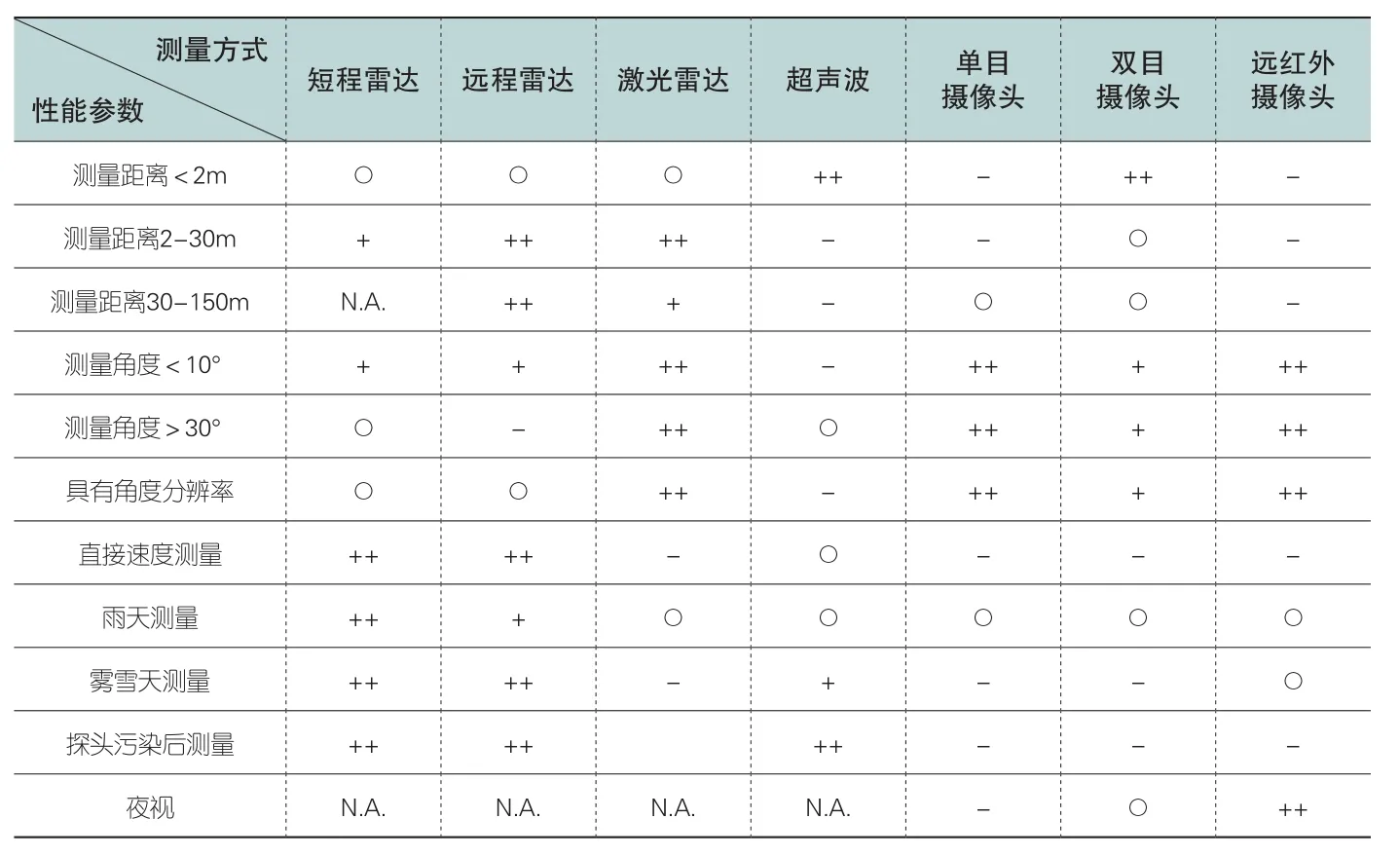

自动驾驶各传感器性能比较

2.3 摄像头

对于既能使用雷达也能使用摄像头的应用场合,摄像头是成本较低的传感解决方案。摄像头的安装位置有前视、侧视、后视和内置。主要用于前向碰撞预警系统、车道偏离警示系统、交通标志识别系统、停车辅助系统、盲点侦测系统。

摄像头通常分为单目摄像头和双目摄像头两种,通常情况下单目车载摄像头的视角为50°-60°,可视距离为100m-200m。而双目摄像头能够通过模拟人类的视觉成像方式进行3D成像,比较两个摄像头获得的不同图像信号,识别物体更可靠,通过算法得出物体的距离、速度信息等。

与激光雷达相比,摄像头能在白天使用自然光;可以识别汽车、交通灯 的颜色;在光照充足的条件下,可以识别很远的物体,有更高的分辨率,而且成本较低。但是它也存在一些缺点,比如容易受到雨雪天气和光照的影响,光照的变化对其识别精度的影响较大,而且目前的摄像头技术对于静态图像中的远方物体难以识别。

摄像头由镜头、镜头模组、滤光片、CMOS/CCD、ISP、数据传输部分组成。光线经过光学镜头和滤光片后聚焦到传感器上,通过CMOS或CCD集成电路将光信号转换成电信号,再由图像处理器ISP转换成标准的RAW等格式的数字图像信号,通过数据传输接口传到计算机端。

摄像头CMOS:是摄像头的感光元件,价值约占摄像头成本的三分之一,是摄像头的核心部件。

摄像头镜头:舜宇光学车载的镜头出货量是全球第一,全球市场占有率达30%左右。已进入BMW、奔驰、奥迪等各大车企的前装市场。

摄像头模组:车载摄像头模组安全等级要求高,工艺也更加复杂,Panasonic、Sony等厂商占据较大市场份额,国内欧菲光、舜宇光学在手机摄像头模组封装领域有明显优势,目前也已全面进入摄像头模组封装制造中。

2.4 超声波雷达

超声波雷达是利用声波的传播来提取环境信息的。首先发出高频声波,并且接收物体反射来的回波,最后计算从发送信号到收到回波的时间间隔,从而确定物体的距离。超声波雷达的成本较低,重量轻,功耗低,但是探测距离很近,适合测量0.2m-4m左右的距离。

从表中可以看出,自动驾驶车辆感知环境的传感器繁多,不同传感器的原理、功能各不相同,在不同的使用场景里可以发挥各自优势,难以互相替代。比如,激光雷达安装在车顶,那么车辆底部是无法测量的圆形区域。未来要实现智能驾驶、无人驾驶,仅靠单一的传感器是无法实现的。一个重要的趋势是将不同的传感器融合在一起,使传感器之间可以优势互补,最终提升精确性。

3 多传感器融合技术

多传感器融合是实现自动驾驶环境感知的必然趋势,它是把车辆上搭载的不同位置、不同种类的多个传感器获取的信息综合在一起,通过计算机技术进行分析,同时要消除传感器信息间的冗余和矛盾,提高系统的可靠性,获得更快速、正确的信息。激光雷达和摄像头都是光学类的传感器,核心部分和处理电路较相似,在传感器的内部实现数据融合,可以降低后端的计算处理过程。

多传感器融合可以看作是人的大脑对周围环境的信息处理过程,人的眼、耳等器官相当于是传感器,将感知到的图像、声音等信息传输至大脑,相当于传感器的信息融合中心,并与原有的经验,相当于数据库进行综合处理,最终做出快速、准确的判断。

多传感器融合,对于硬件和软件都有一定的要求。硬件方面,要求配备不同种类的传感器,才能保证信息获取充分且有冗余;而软件方面,核心是算法,算法要足够优化,数据处理速度要够快,且容错性好,才能保证最终决策的准确和速度。目前,多传感器融合的理论方法有贝叶斯准则法、卡尔曼滤波法、D-S证据理论法等。多传感器融合的重点和难点是算法。

4 结语

自动驾驶环境感知系统的各种传感器各有各的优劣势,难以相互替代,未来要实现自动驾驶,一定是多个传感器相互配合共同构成环境感知系统的。为了保证行车的安全,多传感器融合是大势所趋,也为更高阶的自动驾驶方案提供了必要的技术储备。