基于车载的运动行人区域估计方法

李志慧,胡永利,赵永华,马佳磊,李海涛,钟 涛,杨少辉

(1.吉林大学 交通学院,长春 130022;2.吉林大学 计算机公共教学与研究中心,长春 130022;3.中国城市规划设计研究院 城市交通研究分院,北京100037)

0 引 言

车载行人检测技术利用车辆前方的摄像机等设备检测、定位以及识别行人,为无人驾驶、自动辅助驾驶等技术提供了智能决策支持,从而提高行车安全、减少人车碰撞事故。目前,常用的检查算法有:Haar小波行人检测法[1]、人体形态检测法[2-6]、HOG+SVM行人检测法[7-9]等,这些算法均采用滑动窗口的行人模板匹配方法来识别行人,但由于模板匹配的全局多尺度窗口搜索策略,造成行人检测时大量的盲目搜索,降低了行人检测的实时性。

通过检测行人感兴趣区域(Regions of interest,ROI)可以获得可能存在行人的区域,减少滑动窗口盲目搜索的时间,提高行人检测的实时性。目前行人ROI检测方法可分为两类:①特征估计法,该方法通过图像纹理、颜色、亮度等特征,估算行人形态、概率密度分布等,从而获取行人ROI。如:Itti等[10]利用生物激励注意特性,判断显著性区域,获取行人ROI;Gualdi等[11]采用蒙特卡洛和高斯核函数密度估计行人ROI;Kamijo等[12]利用时空马尔科夫随机场模型估计行人ROI。该类方法虽然能够获取行人ROI,但模型较复杂,增加了行人检测算法的运行时间。②运动检测法,该方法利用光流计算和运动分割方法,获取行人区域。如:Zhang等[4]和Elzein等[13]利用光流计算获取场景的光流场,利用图分割获取行人ROI,该方法从运动分割的角度为行人ROI估计提供了新的视觉,但未考虑运动场景与行人的运动差异性,仍无法降低光流场分割计算的复杂度。

为了快速定位运动行人ROI,减少行人检测滑动窗口的搜索时间,本文根据车载运动场景与行人的运动差异性,提出了一种基于光流聚类的行人ROI快速估计方法。该方法首先计算车载视频图像的光流场,通过光流场聚类和运动场景的背景光流估计,剔除背景光流。然后,利用图分割获取可能的行人前景区域,根据人体形态特征,去除非行人区域,获取行人ROI,减少了行人识别盲目搜索的时间。最后,基于自有车载试验平台JLU-PDS进行试验测试,并与德国奔驰Daimler行人检测基本数据集的测试结果进行对比,结果表明了本文方法的有效性。

1 运动行人ROI估计方法框架

运动行人具有运动突然和随意性强的特点,往往致使驾驶员难以发现而酿成无法挽回的悲剧。从而,运动行人ROI快速估计对车载行人预警等智能车辆技术显得尤为重要。为快速估计行人ROI,本文制定了图1所示的技术框架。该技术框架包括图像获取、光流估计、光流聚类、运动场景背景估计、光流分割、区域判别和感兴趣区域获取等部分。

图1 基于光流聚类的运动行人ROI估计方法框架Fig.1 ROI estimation method of moving pedestrian based on optical flow clustering

图像获取利用装载在车辆前方的摄像机获取车辆前方道路信息;光流估计利用光流计算获取图像的光流场;光流聚类通过统计每个像素点的光流场强度和运动方向,获取其运动场直方图,该处理过程实现了不用运动属性的物体归类;运动场景背景估计根据车载运动场景具有基本相同的运动属性,且这些运动属性明显不同于行人的运动属性以及场景背景区域明显大于行人图像区域等特点,获取直方图的极大值点和分割边界,实现运动场景背景估计;光流分割利用去除背景光流的光流场图像和图分割算法,获取不同的分割区域;区域判断根据人体形态特征,剔除非行人区域,获取行人ROI。

2 感兴趣区域判别模型

2.1 光流算法

光流场表征为图像二维平面内物体表面的运动矢量场,是3D空间物体表面在图像的运动投影,其广泛应用于物体运动检测。经过多年的发展,在估计精度和速度方面取得重要进展,并行环境下运算速度可达到45帧/s[14],其中基于梯度的光流估计方法应用尤为广泛。基于梯度的光流估计方法是在假设光强亮度恒定和物体微小运动的基础上来估计光流矢量场。

令I(x,y,t)为图像I(x,y)的时间序列,假设图像光强亮度恒定和物体微小运动,则有:

I(x,y,t)=I(x+dx,y+dy,t+dt)

(1)

I(x+dx,y+dy,t+dt)的泰勒展开式为:

I(x+dx,y+dy,t+dt)=I(x,y,t)+

(2)

忽略高阶项δ,则有:

(3)

Ixu+Iyv=-It

(4)

其行列式形式为:

(5)

图像光流计算矩阵表示为:

(6)

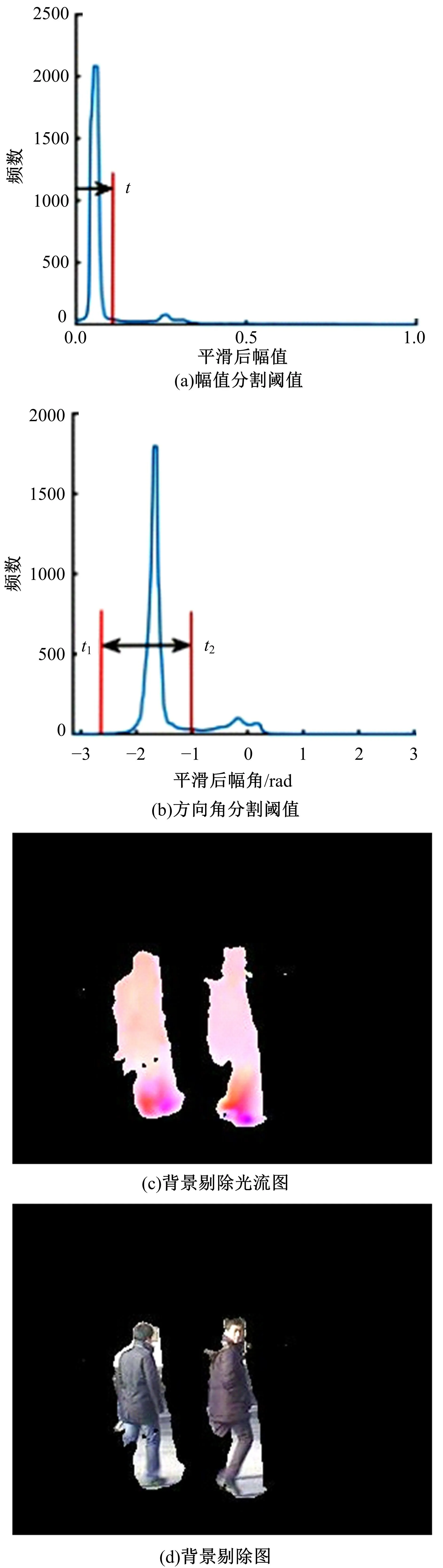

为了计算式(5),Lucas和Kanade[15]假定局部邻域为常数,采用局部光流计算方法,利用最小二乘法计算矩阵方程求解图像光流场;Horn和Schunck[16]采用全局光流计算方法,利用松弛迭代法求解全局能量最小,计算全局光流场。局部光流法对噪声具有较好的鲁棒性,但计算结果为稀疏光流场;全局光流法具有较好的图像结构边缘探测精度,可获取稠密光流,但抗干扰性较差。为满足行人运动区域估计效率和精度的要求以及降低外界干扰的影响,本文采用文献[10]中局部与全局相结合的光流求解方法,该方法利用共轭梯度法快速求解光流矩阵。图2给出连续两帧的光流的孟塞尔颜色可视化系统效果图,其中矢量角度大小表示色相和色度,矢量模表示明度。

图2 车载视频连续帧光流效果图Fig.2 Optical flow rendering of vehicle video continuous frame

2.2 光流聚类

图像光流场反映了物体表面在图像平面的运动投影,因此具有相同运动属性的物体将具有近似相同的光流场。车载相机的移动致使交通场景背景具有近似相同的运动场,从而交通场景图像的背景每个像素点具有近似相同的光流矢量,即背景的光流场具有近似相同的幅值和方向。移动个体作为不同于背景的运动,具有不同于背景的光流场。因此,根据运动差异性,可实现对图像光流场聚类前景与背景的分离。

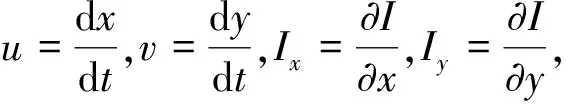

令u和v分别为图像每个像素点光流的x和y方向分量,则图像每个像素点的运动幅值M和运动方向角θ可表示为:

(7)

为快速获取图像背景光流分量,分别统计图像光流场每个像素点的幅值M和方向角θ的直方图,获取图像运动幅值和方向角的聚类直方图。图3为车载视频连续帧及其可视化光流图,其幅值和方向角直方图及聚类对比图如图4所示。

图3 车载视频连续帧及光流图Fig.3 Adjacent frames and optical flow chart

图4 光流幅值和方向角直方图以及聚类对比图Fig.4 Amplitude and angle histogram of optical flow,contrast amplitude and angle graph of foreground and background

图5 双高斯间的最小误分类分割阈值Fig.5 Threshold of minimum misclassification between double Gauss

图6 图3(a)和(b)相邻帧阈值分割后的效果图Fig.6 Rendering of adjacent frame threshold segmentation of figure 3(a) and 3(b)

由图4可以看出,背景和前景的光流直方图统计分布为近似高斯分布,因此图像光流直方图可视为背景、前景、光流场估计误差以及过程噪声等构成的混合高斯分布。

假设图像光流场直方图为f(x),则有:

f(x)=g1(x)+g2(x)+…+gn(x)

(8)

式中:g1(x)、g2(x)、gn(x)分别为背景、前景、噪声干扰等高斯分量;n为高斯个数。

由于车载视频场景中运行物体和行人个数的不确定性,图像光流场直方图的混合高斯分布难以确定高斯的个数,从而通常的期望最大化(Expectation-maximization,EM)算法和K-means等聚类算法难以确定背景的高斯分布。

2.3 背景估计

通常车载视频场景中图像的背景占图像的绝大部分区域,即图像光流聚类直方图的极大值点对应图像背景区域。因此,分别统计幅值和方向角直方图的极大值Mmax和θmax,获取极值点对应的高斯分布作为图像背景区域。

由图5可以看出:两高斯分布的最小误分类阈值T对应两高斯分布的交叉点。为获取背景区域与其它前景高斯分布的最小误分类阈值,本文仍选取两高斯分布交叉点作为其分类阈值。根据摄像机成像投影原理,所有的成像点相交于成像的灭点,即车辆前方距离车载摄像机较远的背景光流强度将趋向于0点,其中图4的光流幅值直方图可以看出,背景部分为从0点开始的极值点对应的高斯分量。因此,图像光流幅值聚类直方图中幅值为M∈[0,T]且T>Mmax对应的区间为背景部分,其中T为分类阈值,如图6所示。此外,由于光流方向角范围为[-π,π]以及前景运动方向的不确定性。为降低背景的误分类,在方向角聚类直方图极值点两侧分别选取阈值作为背景部分,即图像光流方向角位于θ∈[t1,t2]且t1<θmax Bmask(x,y)= (9) 式中:(x,y)为对应图像像素点坐标;Bmask(x,y)=1为背景点。 为了满足背景估计的自适应性要求,需自适应确定背景光流幅值与方向角的分类阈值,即自适应确定阈值T、t1和t2。由于分类阈值为两高斯分布的交叉拐点,其中阈值T为幅值直方图Mmax右侧的第1个拐点;阈值t1和t2分别为方向角直方图θmax左、右两侧第1个拐点。为快速自动获取直方图的分类阈值,本文选取过零点检测方法获取极值点左、右的拐点。 为了降低噪声等对直方图造成的干扰,本文利用平滑窗口函数k(ω)与光流直方图f(x)进行卷积运算,如下式所示: ff(x)=f(x)*k(ω) (10) 由于ff(x)的导数的零点对应函数的拐点,利用差分函数求解ff(x)的导数ff(x),然后利用式(11)判断过零点位置,分别获取直方图左、右两侧的第1个零点位置,作为分类判决阈值,从而自适应确定阈值T、t1和t2,其中图6为图像获取背景后的前景区域效果图。 (11) 通常不同运动物体具有不同的运动属性,同一运动物体同一时刻具有基本相同的运动属性。对图像光流图而言,同一物体光流场具有均一性,不同物体具有不同的光流场。因此,对图像光流场进行光流分割可实现前景物体的分割。为了有效获取前景物体,本文对背景剔除后的光流图采用基于图论[17]的分割算法。 (12) 式中:α和β分别为矢量模m和矢量夹角θ的权重系数。 根据图G的最小生成树,利用判决准则函数D(C1,C2)决定区域C1与C2是否分割。 (13) 式中: MInt(C1,C2)= min(Int(C1)+τ(C1),Int(C1)+τ(C1)) τ(C)=k/|C| 式中:k为阈值参数,根据不同的需求进行调节。 根据上述准则进行光流图分割,得到如图7所示的分割效果图。其中,图7(a)中蓝色点表示前景光流矢量;图7(b)中不同区域颜色不同标识。 图7 图分割效果图Fig.7 Rendering of segmentation 通过图像的前景光流分割获取前景运动物体的有效区域,但由于前景有效分割区域除了包括行人外,还可能包含运动车辆、部分背景等,需进一步剔除非行人区域。由于行人人体形态结构异于其他物体形态的天然特性,本文利用人体形态的相关指标特征进行判断,剔除部分非行人区域。 本文选取人体高度与宽度比Lw、行人区域面积S、分割区域面积与矩形窗口的面积比Sp作为评价标准,来判断是否为可能行人区域,其表示为: (14) 式中:Smin、Smax分别为行人区域可能最大、最小面积;Lmax、Lmin分别为行人区域可能最大、最小的身体高度与宽度比;Spmax、Spmin分别为行人区域可能最大、最小的分割区域面积与矩形窗口面积比。 图8为运动区域判别效果,可见,区域将面积较大和较小的区域剔除。 图8 运动区域提取示意图Fig.8 Schematic diagram of motion region extraction 分别利用本课题组研发的JLU-PDS车载试验平台(见图9)以及国际Daimler[4]车载行人测试视频集对本文算法进行测试。 JLU-PDS试验环境选取吉林大学校园内车辆运行环境,实车测试时长为2 h,其部分测试结果如图10所示。Daimler测试视频集为野外和城市道路上的视频集,其部分测试结果如图11所示。 由图10和11可以看出,本文算法能够较好地满足行人被部分遮挡、野外、街道、人群等复杂环境下的应用,实现不同尺度下行人ROI区域估计,同时能够保证行人ROI区域的检测精度,表明了本文算法具有较好的环境应用性和较好的性能。本文算法对光流分割前进行了预处理,极大地降低了行人检测的搜索空间,为车载环境下的行人识别提供了快速、准确的行人区域估计方法。 图9 JLU-PDS车载试验平台Fig.9 JLU-PDS vehicle test platforme 图11 Daimler数据库试验效果图Fig.11 Experiment results of Daimler database 根据运动行人与车载移动背景的运动差异性,通过光流聚类获取了不同物体的运动表达,建立了基于光流聚类的行人ROI估计方法。通过JLU-PDS和Daimler国际行人共享测试库对本文方法进行实际场景测试,结果表明,本文方法极大地降低行人识别的空间搜索范围,克服了传统行人检测的盲目搜索的问题,能够实现行人的快速检测。该方法可为车载主动行人保障技术、无人驾驶、智能车辆等研究和应用提供技术支持。 参考文献: [1] Papageorgiou C,Poggio T. A trainable system for object detection[J]. International Journal of Computer Vision,2000,38(1):15-33. [2] Dollár P, Wojek C,Schiele B,et al. Pedestrian detection:a benchmark[J/OL].[2017-04-09]. http:∥www-cs.ccny.cuny.edu/~zhu/GC-Spring2010/Papers/PedestrianBenchmark.pdf. [3] Enzweiler M, Gavrila D M. Monocular pedestrian detection:survey and experiments[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2009,31(12):2179-2195. [4] Zhang Shan-shan, Klein D A, Bauckhage C,et al. Fast moving pedestrian detection based on motion segmentation and new motion features[J]. Multimedia Tools and Applications,2016,75(11):6263-6282. [5] Tkarli F,Aghagolzadeh A,Seyedarabi H. Combination of high-level features with low-level features for detection of pedestrian[J]. Signal Image and Video Processing,2016,10(1):93-101. [6] Geronimo D,Lopez A M, Sappa A D,et al. Survey of pedestrian detection for advanced driver assistance systems[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence,2010,32(7):1239-1258. [7] Prioletti A, Mφgelmose A, Grisleri P,et al. Part-based pedestrian detection and feature-based tracking for driver assistance: real-time, robust algorithms, and evaluation[J]. IEEE Transactions on Intelligent Transportation Systems,2013,14(3):1346-1359. [8] Dalal N. Finding people in images and videos[J/OL]. [2017-04-09].https:∥tel.archives-ouvertes.fr/tel-00390303/document. [9] Zhu Q,Yeh M C,Cheng K T,et al. Fast human detection using a cascade of histograms of oriented gradients[C]∥IEEE Computer Society Conference on Computer Vision and Pattern Recognition, New York,USA,2006:1491-1498. [10] Itti L,Koch C,Niebur E. A Model of Saliency—Based Visual Attention for Rapid Scene Analysis[M]. New York:IEEE Computer Society, 1998. [11] Gualdi G, Prati A, Cucchiara R. Multi-stage sampling with boosting cascades for pedestrian detection in images and videos[C]∥European Conference on Computer Vision,Heraklion,Crete,Greece,2010:196-209. [12] Kamijo S,Sakauchi M. Simultaneous tracking of pedestrians and vehicles by the spatio—temporal Markov random field model[J]. Ipsj Sig Notes Cvim,2003,4:3732-3737. [13] Elzein H,Lakshmanan S,Watta P. A motion and shape-based pedestrian detection algorithm[C]∥IEEE Intelligent Vehicles Symposium,Columbus, USA,2003:500-504. [14] Garcia-Dopico A,Pedraza J L,Nieto M,et al. Locating moving objects in car-driving sequences[J/OL]. [2017-04-11].http:∥paperity.org/p/35073989/locating-moving-objects-in-car-driving-sequences. [15] Lucas B D,Kanade T. An iterative image registration technique with an application to stereo vision[C]∥Proceedings of the 7th International Joint Conference on Artificial Intelligence, Vancouver BC, Canada,1981:121-130. [16] Horn B K P, Schunck B G. Determining optical flow[J]. Artificial Intelligence,1981,17(1):185-203. [17] Felzenszwalb P F,Huttenlocher D P. Efficient graph-based image segmentation[J]. International Journal of Computer Vision,2004,59(2):167-181.

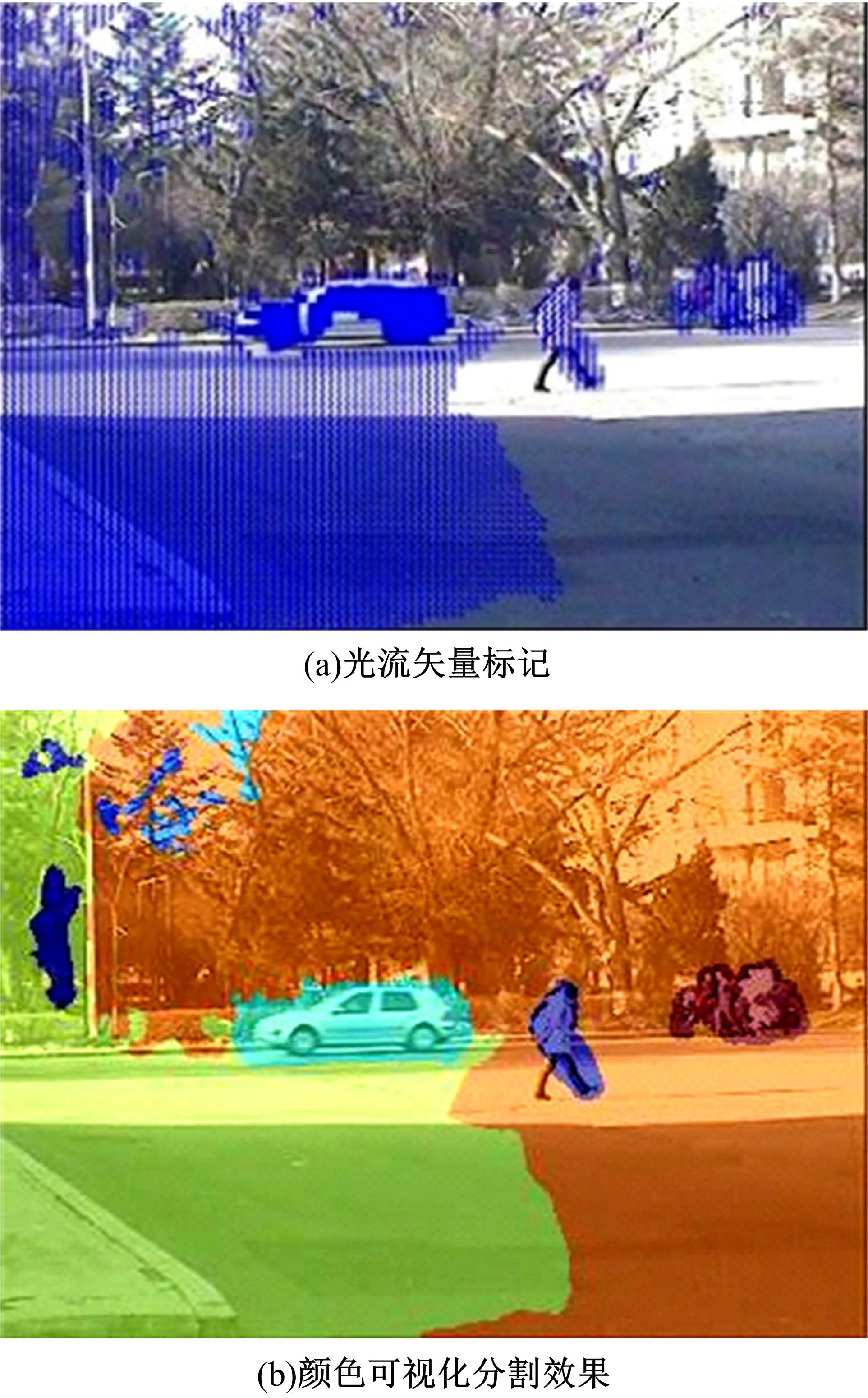

2.4 光流分割

2.5 区域判别

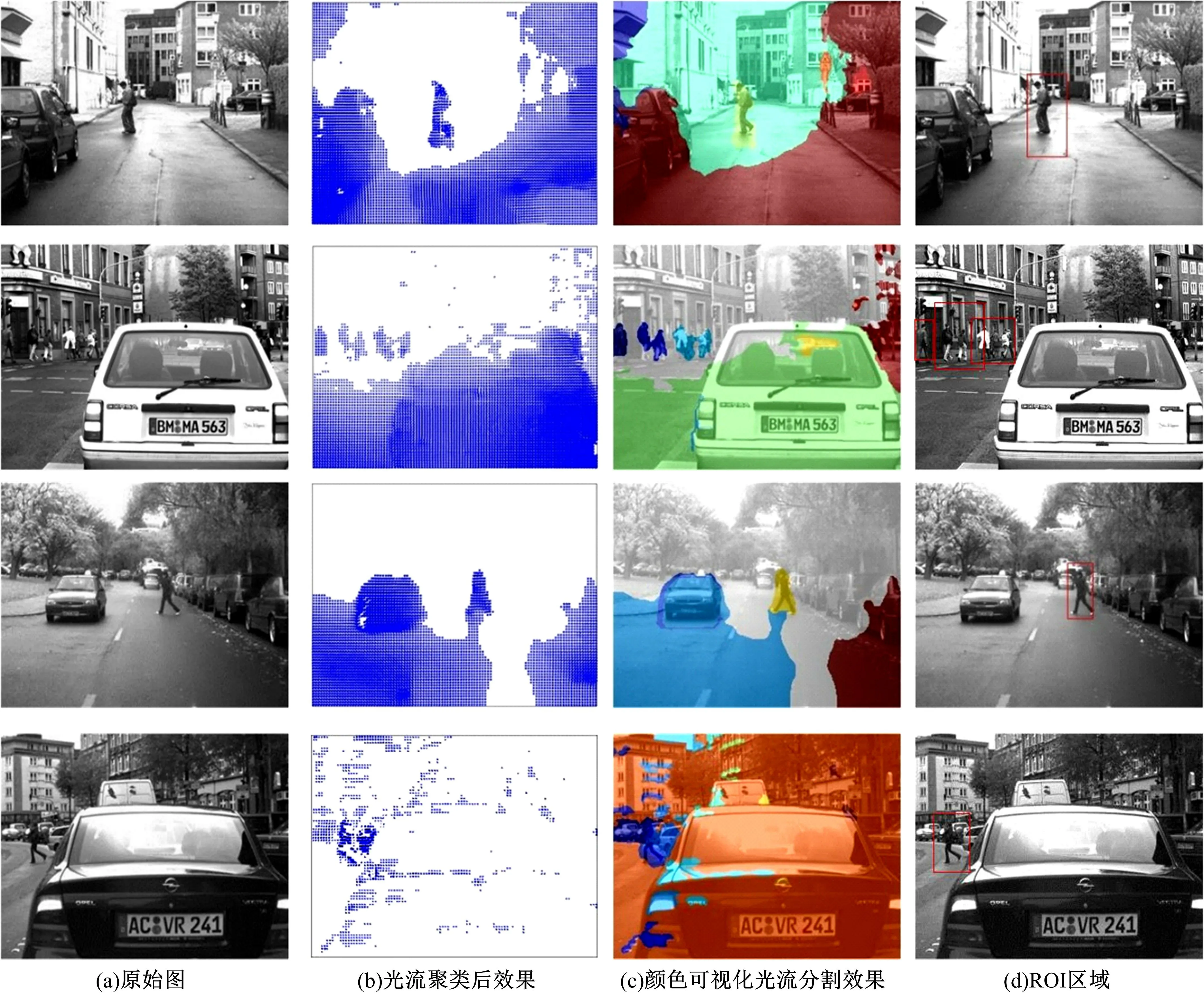

3 试验结果分析

4 结束语