基于泛化深度迁移特征的高分遥感场景分类

罗 畅, 王 洁, 王世强, 史 通, 任卫华

(空军工程大学防空反导学院, 陕西 西安 710051)

0 引 言

近年来,从图像分割等底层任务到图像分类等综合任务,遥感图像处理领域取得了快速的发展[1-7]。然而,从遥感图像中的像素点到具体目标,再到整个遥感场景,随着任务抽象程度的提升,遥感图像处理的难度越来越大。根据语义特征对高分辨率遥感场景进行分类是一项具有挑战性的任务。因为高分辨率遥感场景的类内变化较大,而类间变化有时却很小。不同的物体会以不同的尺度和方向出现在同一类场景中,而同样的物体也可能出现在不同的场景里[5-9]。

深度学习理论通过深度神经网络结构学习高度抽象的特征表达。作为目前较为成功的深度神经网络结构,深度卷积神经网络(deep convolutional neural network,DCNN)被广泛用于图像的识别和检测任务,并在公开数据集上取得了迄今最好的识别和检测效果[10-13]。理论上,DCNN能够通过提取高分辨率遥感图像的高层次特征,表征出遥感场景间的细微差别。然而,目前遥感领域并不具备足够的带标签的高分辨率遥感图像用于训练DCNN中巨量的结构参数。当采用现有的遥感数据集训练DCNN时,会出现严重的过拟合[14]。

ImageNet数据集是目前最庞大的图像数据集之一,包含数百万张超过一千类的日常可见光图像[15]。该数据集上训练得到的DCNN模型在各种计算机视觉任务中均取得了惊人的成绩。最近的研究成果表明,经ImageNet预训练得到的DCNN能够成功迁移至其他计算机视觉任务[16-18]。随着CaffeNet等一系列成功DCNN模型的快速发展[12],将在ImageNet上训练得到的DCNN模型迁移至高分辨率遥感场景的分类任务也成为深度学习理论应用于遥感领域的重要发展方向。在将预训练后的DCNN模型迁移至遥感场景分类任务时,文献[19]评估了DCNN模型的泛化能力。为进一步提升分类效果,文献[14]在将DCNN迁移至遥感场景分类时,使用遥感数据集对DCNN的网络结构参数进行了微调。文献[20]则在将DCNN迁移至高分辨率遥感场景分类时,同时提取DCNN不同特征层中的有效特征用于分类任务,并取得了突出的分类精度。

经ImageNet数据集预训练的DCNN模型能够成功迁移至高分辨率遥感场景分类任务的原因在于,高分辨率遥感图像和日常可见光图像的基本视觉模块(例如:边、角)是相同的,DCNN在迁移过程中体现出一定的泛化能力。因此,本文设计了一种基于线性主成分分析网络(linear principle component analysis network, LPCANet)的网络结构形式,整合了高分辨率遥感图像的空间信息,增强了DCNN在迁移过程中的泛化能力,以进一步提升高分辨率遥感场景的分类精度。

1 用于预训练的DCNN结构

典型的DCNN是由多个级联的不同类型层级结构组成。卷积层通过一系列卷积核对输入特征图进行卷积操作产生新的特征图。更深层的卷积结构能够通过整合浅层特征而获得更加抽象的特征表达。卷积操作之后常常运用非线性激活函数增强特征的泛化性能,常用的非线性激活函数包括sigmoid函数、ReLU函数等。随后,池化层在特征图的局部区域执行下采样操作以降低特征维度,同时使得特征具有局部平移和旋转的不变性。最后,数个全连接层被置于多个级联的卷积层和池化层之后。最后一个全连接层常常是Softmax分类器,用于获取分类后每个类别的权重。DCNN中的结构参数主要采用误差反向传播的思想,通过随机梯度下降算法训练得到。经大量有效样本训练的DCNN能够通过前向传播,将输入的图像转化为高层次抽象特征。

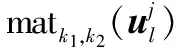

基于典型的DCNN结构,AlexNet采用随机选取神经元的方法进一步减轻网络的过拟合现象[10]。另一方面,CaffeNet则是将非线性激活函数置于池化层之后,在计算机视觉任务中也取得了理想的效果[12]。从以上经典的DCNN模型出发,近年来,DCNN的发展主要在于以下两个方面:

(1) 更深的网络结构。VGG-VD网络采用更深的网络结构获得了2014年ImageNet大规模视觉识别挑战赛(2014 imageNet large scale visual recognition challenge, ILSVRC-2014)的第2名[13]。其16层网络VGG-VD16和19层网络VGG-VD19的成功应用表明更深的网络结构能够在分类和识别等任务中提升准确率。另外,MSRA-Net进一步将VGG-VD网络中的5×5卷积核替换为两个串联的3×3卷积核,在构建更深网络结构的同时降低了计算复杂度并在机器视觉任务中取得了更好的效果[21]。

(2) 更优化的网络结构单元。网中网(network in network, NIN)将典型DCNN中的卷积层替换为多层感知器,同时使用全局平均值池化替代全连接层[22]。受NIN模型的启发,GoogLeNet进一步使用Inception模块,在每一层网络结构中使用不同尺度的卷积核,获得了ILSVRC-2014的最好成绩[23]。此外,Inception V3网络再次优化了GoogLeNet中的inception模块,其用两个串联的3×3卷积核替换5×5卷积核,同时1×n和n×1卷积核被添加到Inception模块中以增加网络的深度[24]。Inception模块在Inception V3网络中的演变过程如图1所示,其中n×n表示n×n的卷积操作。

图1 Inception模块在Inception V3网络结构中的演变Fig.1 Changes of Inception module in the architecture of Inception V3

结合以上两个方面,深度残差网络(deep residuals network,ResNet)采用级联的残差函数作为其基本网络结构单元,赢得了ILSVRC-2015的冠军[25]。不同于传统的卷积单元,ResNet中的残差单元整合了输入信息,使得ResNet中的结构参数更易于优化,并可通过加深网络深度在各类机器视觉任务中取得更好的效果。基于ResNet,恒等映射残差网络进一步对残差学习框架进行了优化,并在分类、识别等任务中证实了其优越性[26]。

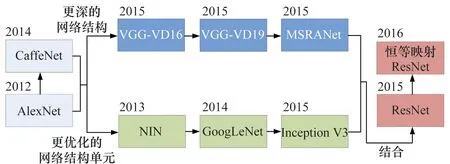

DCNN结构的演化进程可由图2表示。然而,当将以上在机器视觉领域取得巨大成功的DCNN直接应用于遥感场景分类时,取得的效果并不理想。事实上,因为生活中能够轻易获取大量带标签的日常可见光图像,几乎所有的DCNN均是基于日常可见光图像数据集(例如ImageNet)训练得到的。在遥感领域,经有限的遥感图像训练得到的DCNN泛化能力较弱,其结构参数极易产生过拟合现象。

图2 DCNNs结构演化图Fig.2 Evolution of the structure of DCNNs

目前,针对遥感场景分类任务,能够充分利用DCNN性能的有效方案,即将其在ImageNet上预训练得到的高度抽象特征迁移至遥感场景图像[14, 19-20]。此迁移过程的重要原则是:用于预训练DCNN的源数据集(ImageNet数据集)与相应的目标数据集(高分辨率遥感数据集)之间的差异足够小。通过设计LPCANet整合高分辨率遥感图像的空间信息减小两者之间的差异,增强预训练DCNN针对遥感场景分类的泛化能力。

2 线性主成分分析网络

基于主成分分析网络(principal component analysis network,PCANet)[27],LPCANet保留了PCANet中的线性操作,并对其中的非线性结构单元进行了改进。不同于PCANet中使用散列法对卷积特征图进行二进制变换,LPCANet中直接对卷积特征图进行了加权操作。另外,LPCANet中使用线性的平均值池化替换了PCANet中非线性的柱状图池化。以上由非线性运算到线性运算的改变,使得LPCANet在滤除高分遥感图像中的噪声信息的同时不改变其基础结构,不影响其原有的特征分布形式。LPCANet通过整合高分辨率遥感图像的空间信息,提取图像中的主要特征。提取到的主要特征进一步输入经预训练的DCNN用于获取遥感场景的全局特征,并用于遥感场景的分类任务。典型的两层LPCANet如图3所示。

图3 两层LPCANet结构示意图Fig.3 Structure of two-stage LPCANet

I=[I1I2…IN]∈Rm×Nn×3

(1)

2.1 提取遥感场景的主成分分析核

(2)

s.t. (Uj)TUj=IL,j=1,2,3

(3)

式中,IL为L×L的单位矩阵。

;j=1,2,3

(4)

此时,从遥感图像中提取到的PCA核包含了遥感场景的主要空间变化。

2.2 获取卷积特征图

将各个光谱通道中提取到的L个PCA核分别与遥感图像进行卷积操作,获取的卷积特征图为

l=1,2,…,L;j=1,2,3

(5)

式中,符号*表示二维卷积操作;上标1表示第1层卷积特征图。

(6)

2.3 卷积特征图的加权与池化

在获取关于遥感图像的卷积特征图后,需要根据卷积特征图所包含特征的重要程度对其进行加权整合。另外,池化操作被用于进一步增强遥感场景特征的不变性。

卷积特征图的加权过程为

(7)

ri,x′,y′=meansi∈Ri,x′,y′si

(8)

式中,si表示池化域Ri,x′,y′内的加权特征;ri,x′,y′表示计算得到的位置(x′,y′)处的池化特征。由池化域Ri={Ri,1,1,…,Ri,x′,y′,…,Ri,m′,n′}计算得到的池化特征ri={ri,1,1,…,ri,x,y,…,ri,m′,n′}具有一定程度的平移和旋转不变性。

2.4 多层的网络结构

对于特定的遥感数据集及其相关任务,如果更深的LPCANet结构能够取得更好的效果,则可重复以上过程构造多层的LPCANet。如图3所示,两层的LPCANet包含了2个卷积层(C1和C2),2个加权层(W1和W2)和1个池化层。最后一层的输出作为预训练DCNN的输入,用于获取高度抽象的全局语义特征。

第1层卷积层C1中,由遥感图像集合I提取到的L1个PCA核与输入的遥感图像集进行卷积操作后获取卷积特征图集合I1。在第1层加权层W1中,卷积特征图集合I1经加权操作转换为加权特征图集合T1,同时特征图的数量得以减少。第2层卷积层C2中,L2个PCA核由加权特征图集合T1提取得到,C2中的卷积操作进一步产生卷积特征图I2。在第2层加权层W2中,由加权操作进一步获取加权特征图T2。最后对T2进行平均值池化获取池化特征图r。

更多的层级结构可表示为C1-W1-C2-W2-C3…,或由特征图的形式表示为I-I1-T1-I2-T2-…-r。LPCANet中的所有操作过程均是线性的,因此在整合遥感图像空间信息的同时,LPCANet并没有改变原始图像的基础结构。

3 基于LPCANet的预训练DCNN泛化能力的增强

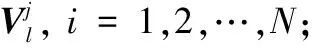

高分辨率遥感图像与日常可见光图像在空间信息上存在一定程度的差异。这两类图像中的机场如图4所示。

图4 两类图像中的机场Fig.4 Airport in two kinds of images

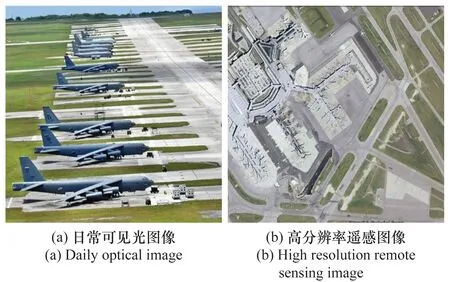

由图4可知,这两张图像从语义上均称为机场,并都包含飞机、跑道和草坪等组成单元。然而,这些组成单元在空间尺度和方向上均存在较大差异。另外,相比于日常可见光图像,高分辨率遥感图像中存在更多的干扰信息,使得遥感场景分类任务变得更加困难。LPCANet通过PCA核与遥感图像的卷积运算尽可能地滤除与遥感场景语义特征无关的干扰信息。同时,其线性结构保留了遥感图像中与遥感场景语义特征相关的特征分布形式。因此,将在日常可见光数据集ImageNet上预训练得到的DCNN迁移至遥感场景分类任务时,需要通过LPCANet减小两类数据集之间的差异,增强预训练DCNN针对遥感场景的泛化能力。本文设计的网络框架如图5所示。由图5可知,在进行高分辨率遥感场景分类时,LPCANet被分别用于处理高分辨率遥感图像3个光谱通道中的“灰度”图像。LPCANet在保留遥感场景主要空间结构的同时过滤掉与场景语义特征无关的细节和噪声。随后,LPCANet输出的关于所有光谱通道的特征图像被进一步整合,并作为预训练DCNN的输入。经日常可见光图像集ImageNet预训练后的DCNN被看做固定的特征提取器,用于进一步获取遥感场景的全局特征。最后,通过线性支持向量机(support vector machine,SVM)分类器完成对遥感场景的分类。

图5 整体网络框架Fig.5 Framework of the whole network

4 高分辨率遥感场景的分类试验

4.1 试验数据集

采用以下两类公开高分辨率遥感场景数据集进行试验,用以验证本文方法的有效性和可靠性。

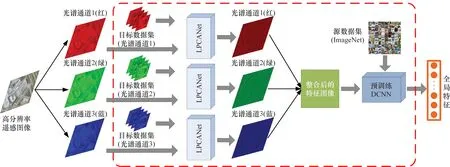

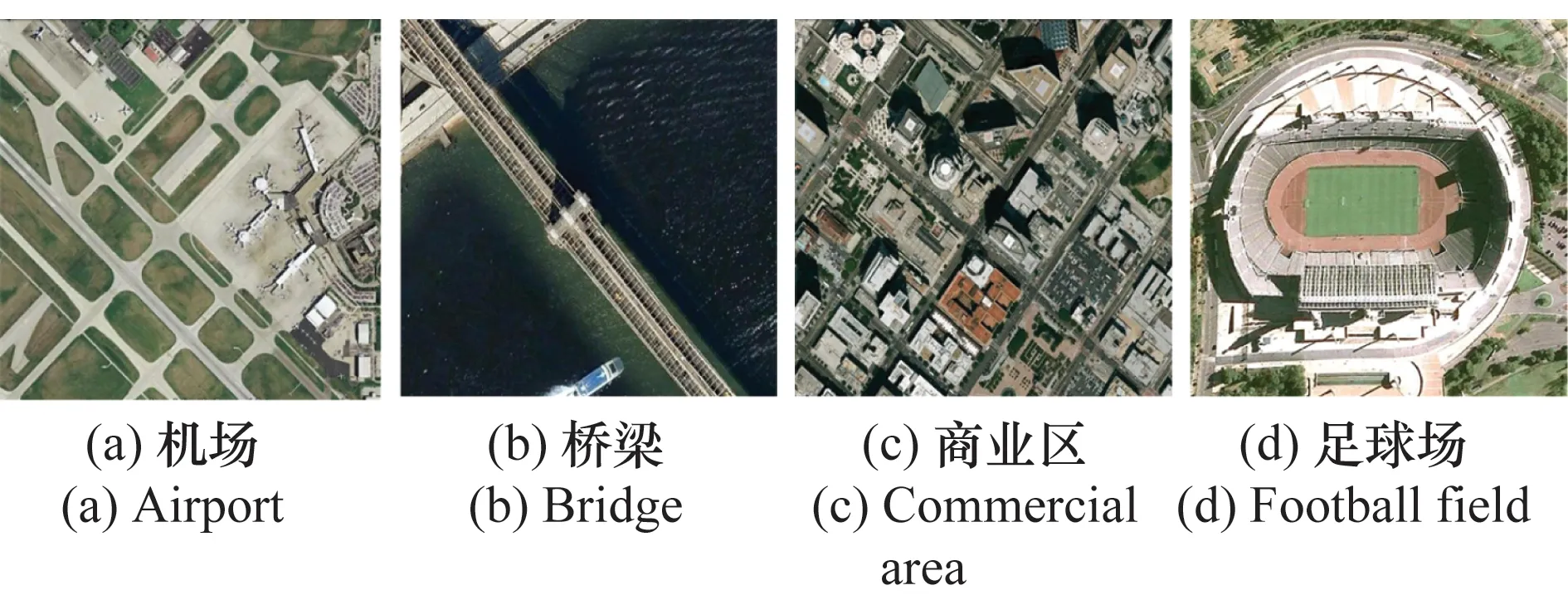

(1) UC Merced数据集。该数据集源自美国地质勘探局国家城市地图图像,共包含21类带标签的高分辨率遥感场景。每个类别包含100张256×256像素的图像,图像分辨率在0.3 m左右。其部分类别场景的示例如图6所示。

图6 UC Merced数据集的部分场景示例Fig.6 Some example scenes of UC Merced dataset

(2) WHU-RS数据集。该数据集源自武汉大学通过Google Earth截取的高分辨率卫星遥感图像,共包含19类带标签的高分辨率遥感场景。每个类别包含约50张600×600像素的图像。其部分类别场景的示例如图7所示。

图7 WHU-RS数据集的部分场景示例Fig.7 Some example scenes of WHU-RS dataset

试验中,以上数据集被均分为5个子部分进行交叉检验。对于UC Merced数据集,每一个子部分包含420张高分辨率遥感场景图像。对于WHU-RS数据集,每一个子部分则包含190张图像。基于5个子部分的交叉检验,试验的主要评价指标为遥感场景分类的平均准确率和分类准确率的标准差。

4.2 试验结果与分析

试验使用第1节介绍的5种经ImageNet数据集预训练的DCNN,即AlexNet[10]、CaffeNet[12]、VGG-VD16[13]、GoogLeNet[23]和ResNet[25],验证该方法在高分辨率遥感场景分类任务中对于增强预训练DCNN泛化能力的效果。除了使用全局特征训练分类器以外,其余试验过程均是在非监督条件下进行的。

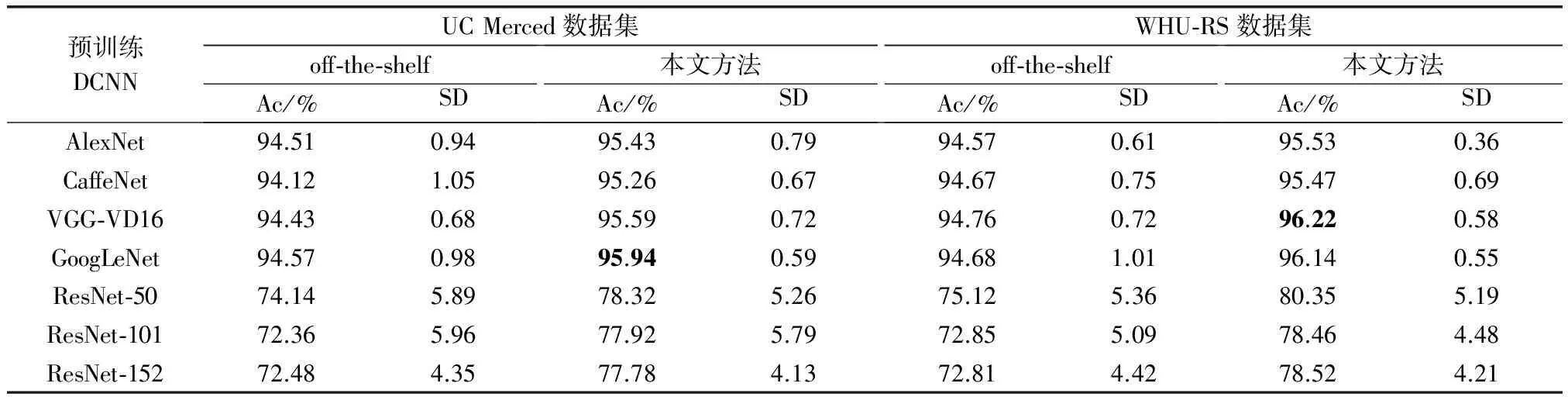

试验中采用单层的LPCANet,其中PCA核的尺寸为k1=k2=8,PCA核的数量设定为L=8。池化层中,池化域为8×8的无重叠区域,且采用平均值池化方法。考虑到不同的预训练DCNN对输入图像尺寸具有不同的要求。针对AlexNet和CaffeNet,需要将LPCANet得到池化特征图r缩放到227×227大小。针对VGG-VD16、GoogLeNet和ResNet,需要将池化特征图r缩放到224×224大小。在不做说明的情况下,试验中的分类器使用线性SVM分类器。在两个高分辨遥感场景数据集上的实验结果如表1所示。表1中,Ac和SD分别表示遥感场景的平均分类准确率及分类准确率的标准差。在off-the-shelf情况下,预训练DCNN被直接用作特征提取器,其提取到的全局特征输入线性SVM分类器实现对遥感场景的分类。事实上,off-the-shelf的试验框架对于高分辨率遥感场景的分类任务已几乎取得了迄今为止最好的分类效果[20]。对比使用遥感数据集训练全新DCNN的方案,直接将预训练后的DCNN迁移至遥感场景分类任务显示出了明显的优势[14]。因为面对DCNN中的巨量参数,有限的遥感数据会造成严重的过拟合现象,不能充分利用DCNN的深度结构。进一步地,遥感场景分类的平均准确率如图8所示。

表1 5种预训练DCNN在两类遥感数据集上的遥感场景分类结果

图8 遥感场景分类的平均准确率Fig.8 Mean accuracy rate of remote scene classification

由表1和图8可知,在off-the-shelf情况下不论使用的预训练DCNN为AlexNet、CaffeNet、VGG-VD16或GoogLeNet,其分类效果差别不大。与直观认为的更深的DCNN结构或更复杂的DCNN单元带来更好的分类效果不同,GoogLeNet取得的效果并不明显优于AlexNet和CaffeNet,VGG-VD16甚至比AlexNet取得的分类效果更差。因此,直接将预训练DCNN迁移至遥感场景分类存在明显的瓶颈。其原因在于,用于预训练DCNN的源数据集(ImageNet数据集)和目标数据集(UC Merced数据集或WHU-RS数据集)存在空间信息上的差异,在将预训练DCNN迁移至遥感场景分类任务时,其缺乏足够的泛化能力。另外,近两年取得巨大成功的DCNN结构ResNet在试验中并没有取得理想的效果,不论其网络深度为50层、101层或是最深的152层。因为ResNet中的残差单元将输入与输出直接关联,在减少了网络结构参数的同时,弱化了参数间的独立性,使得其泛化能力较差,不利于将其迁移至其他任务。

网络框架中,在将预训练DCNN迁移至遥感场景分类之前,使用LPCANet对高分辨率遥感图像进行处理,减小了迁移过程中目标数据集与源数据集之间的差异,增强了预训练DCNN在迁移过程中的泛化能力。如表1和图8所示,本文提出的方法在遥感场景分类任务中突破了off-the-shelf情况下存在的瓶颈,取得了更好的分类准确率。另外,相比于off-the-shelf的情况,该方法对于遥感场景分类准确率的提升程度随着预训练DCNN深度和复杂度的增加而增加。这进一步证实了该网络结构能够增强预训练DCNN针对遥感场景分类的泛化能力,能更好地发挥DCNN深度结构的优势。另一方面,更小的分类准确率标准差也说明,相比off-the-shelf的情况,该方法在进行遥感场景分类时具有更强的稳定性。以预训练CaffeNet为例,针对off-the-shelf及该方法,高分辨率遥感场景在深度网络结构中的详细变化过程如图9所示。由图9可知,采用文献[28]提出的方法进行遥感场景特征的重构显化。CaffeNet中的卷积层保留了遥感场景的基本结构。随着卷积层的加深,遥感场景的空间结构变得更加模糊。另外,全连接层对遥感场景的空间信息进行了重构,并获取到更抽象的特征表达。从全连接层中,仍然可以看到机场跑道的边、角等信息,但其空间布局与原始遥感场景有很大的差异。对比图9(a)和图9(b)中全连接层的重构图像,图9(b)的全连接层中包含更多不同方位和尺度的关于机场组成部分的特征。此外,相比于图9(a),图9(b)全连接层中的特征更加清晰,判别性更好。试验结果进一步说明了本文方法能够获取到关于遥感场景更好的全局特征,证实了该方法对于增强预训练DCNN泛化性能,提升其在遥感场景分类效果方面的作用。

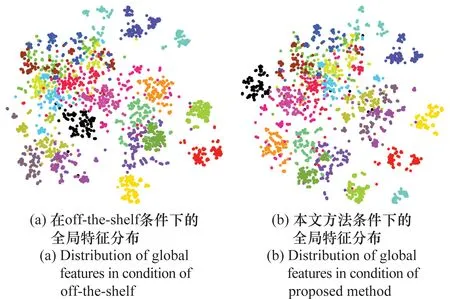

为了更直观地对比off-the-shelf以及本文方法情况下通过预训练CaffeNet提取到的遥感场景的全局特征分布,试验中使用t-SNE算法[29-30]分别将两种情况下从UC Merced数据集中提取到的高维全局特征降维至二维平面。在使用t-SNE算法时,算法复杂度设置为30,训练迭代次数设置为1 000次。两种情况下t-SNE算法在UC Merced数据集上的试验结果如图10所示。

图10 UC Merced数据集中遥感场景的全局特征分布Fig.10 Separability of global features generated from remote scenes on UC Merced dataset

其中,UC Merced数据集中的21类遥感场景用21种不同的颜色表示。如图10所示,两种情况下,由预训练CaffeNet提取到的遥感场景的全局特征经t-SNE算法降维至二维平面后,同类遥感场景自发地聚集在一起。然而,相比于off-the-shelf的情况,本文方法提取到的不同类遥感场景的全局特征具有更好的可分离性。

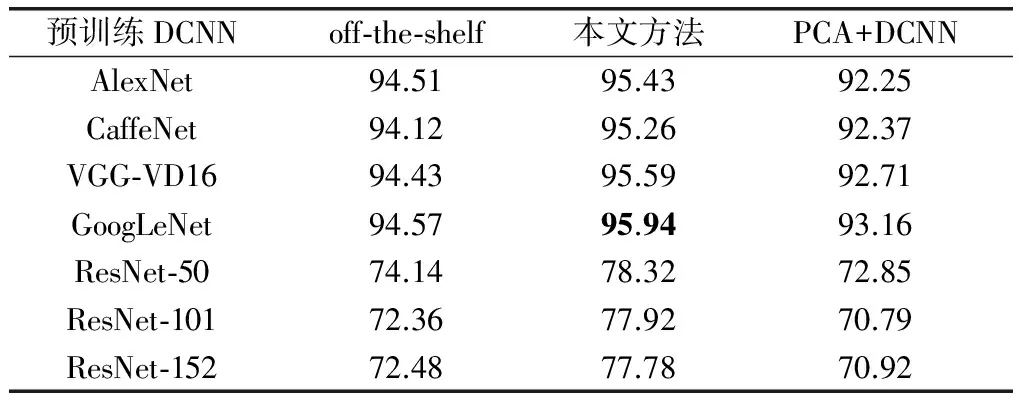

为进一步验证本文所设计网络结构中LPCANet的有效性,如图11所示,PCA算法被直接用于预处理遥感场景数据集中的每张遥感图像,并将预处理后的遥感图像输入DCNN用于遥感场景分类。

图11 PCA算法单独预处理每张遥感图像Fig.11 Pre-processing every single remote sensing image by PCA algorithm

表2显示了各方案在UC Merced数据集上的试验结果。试验结果表明,相比于该方法以及off-the-shelf方案,将PCA算法直接用于预处理遥感图像并不能提升预训练DCNN的泛化能力并取得满意的遥感场景分类效果。不同于LPCANet通过提取PCA核并与遥感图像进行卷积的处理方式,直接使用PCA算法单独处理每张遥感图像会丢失遥感场景具有判别性的空间信息,影响预训练DCNN对遥感场景的分类效果。

对于高分辨率遥感场景分类,近年来已有很多方法取得了令人满意的分类效果。与本文所使用的试验数据集相同,大多数方法均是基于UC Merced数据集进行测试的。因此,表3比较了本文方法与其他方法在UC Merced数据集上取得的遥感场景分类准确率。如表3所示,该方法相比于近年来提出的大多数方法在分类准确率上至少提升了近1%。需要指出的是,本文方法仅仅是在非监督条件下提供了将预训练DCNN迁移至高分辨率遥感场景分类任务的基础框架,并没有使用遥感数据集训练DCNN中的结构参数。因此本文方法在分类准确率上并不优于文献[14]提出的GoogLeNet+Fine-tune方案。然而,对DCNN参数微调(Fine-tune)的效果依赖于遥感数据集的规模,而且相比于该方法也更加费时。此外,在具有足够多的高分辨率遥感图像且遥感场景分类时间允许的前提下,可以在本文提出的网络框架基础上进一步使用遥感数据集微调DCNN的结构参数并取得更好的分类效果。

表2 3种方案对UC Merced数据集的分类准确率

表3 现有方法对UC Merced数据集的分类准确率

5 结 论

针对DCNN迁移至高分辨率遥感场景分类的问题,设计了一种通用的网络框架用于增强DCNN在迁移过程中的泛化能力,以取得更好的遥感场景分类效果。为减小用于训练DCNN的日常可见光数据和用于分类任务的高分辨率遥感数据之间的空间差异,LPCANet被用于整合高分辨率遥感场景中的空间信息,并滤除与遥感场景语义特征不相关的噪声。在UC Merced数据集和WHU-RS数据集上的试验结果表明,相比于直接将各类DCNN迁移至高分辨率遥感场景分类时取得的最好分类效果,本文方法对两类数据集的分类准确率分别提升了1.37%和1.46%,并达到95.95%和96.22%。此外,随着DCNN结构的不断演化,该方法能够为以后各类新的DCNN迁移至遥感任务提供良好的研究基础。

[1] WANG J, QIN Q, LI Z, et al. Deep hierarchical representation and segmentation of high resolution remote sensing images[C]∥Proc.of the IEEE International Geoscience and Remote Sensing Symposium, 2015: 4320-4323.

[2] NIJIM M, CHENNUBOYINA R D, AL AQQAD W. A supervised learning data mining approach for object recognition and classification in high resolution satellite data[J]. World Academy of Science, Engineering and Technology, International Journal of Computer, Electrical, Automation, Control and Information Engineering, 2015, 9(12): 2319-2323.

[3] VAKALOPOULOU M, KARANTZALOS K, KOMODAKIS N, et al. Building detection in very high resolution multispectral data with deep learning features[C]∥Proc.of the IEEE International Geoscience and Remote Sensing Symposium, 2015: 1873-1876.

[4] ZHOU W, SHAO Z, DIAO C, et al. High-resolution remote-sensing imagery retrieval using sparse features by auto-encoder[J]. Remote Sensing Letters, 2015, 6(10): 775-783.

[5] CHERIYADAT A M. Unsupervised feature learning for aerial scene classification[J]. IEEE Trans.on Geoscience and Remote Sensing, 2014, 52(1): 439-451.

[6] XU Y, HUANG B. Spatial and temporal classification of synthetic satellite imagery: land cover mapping and accuracy validation[J]. Geo-spatial Information Science, 2014, 17(1): 1-7.

[7] YANG W, YIN X, XIA G S. Learning high-level features for satellite image classification with limited labeled samples[J]. IEEE Trans.on Geoscience and Remote Sensing,2015,53(8):4472-4482.

[8] SHAO W, YANG W, XIA G S. Extreme value theory-based calibration for the fusion of multiple features in high-resolution satellite scene classification[J]. International Journal of Remote Sensing, 2013, 34(23): 8588-8602.

[9] ROMERO A, GATTA C, CAMPS-VALLS G. Unsupervised deep feature extraction for remote sensing image classification[J]. IEEE Trans.on Geoscience and Remote Sensing, 2016, 54(3): 1349-1362.

[10] KRIZHEVSKY A, SUTSKEVER I, HINTON G E. Imagenet classification with deep convolutional neural networks[C]∥Proc.of the Advances in Neural Information Processing Systems, 2012: 1097-1105.

[11] SERMANET P, EIGEN D, ZHANG X, et al. OverFeat: integrated recognition, localization and detection using convolutional networks[J]. Eprint Arxiv, 2013.

[12] JIA Y, SHELHAMER E, DONAHUE J, et al. Caffe: convolutional architecture for fast feature embedding[C]∥Proc.of the 22nd ACM International Conference on Multimedia, 2014: 675-678.

[13] SIMONYAN K, ZISSERMAN A. Very deep convolutional networks for large-scale image recognition[J]. Computer Science, 2014.

[14] CASTELLUCCIO M, POGGI G, SANSONE C, et al. Land use classification in remote sensing images by convolutional neural networks[J]. Acta Ecologica Sinica, 2015, 28(2): 627-635.

[15] DENG J, DONG W, SOCHER R, et al. Imagenet: a large-scale hierarchical image database[C]∥Proc.of the IEEE Computer Vision and Pattern Recognition, 2009: 248-255.

[16] RAZAVIAN A S, AZIZPOUR H, SULLIVAN J, et al. CNN features off-the-shelf: an astounding baseline for recognition[J]. 2014: 512-519.

[17] GIRSHICK R, DONAHUE J, DARRELL T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 580-587.

[18] HE K, ZHANG X, REN S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE Trans.on Pattern Analysis and Machine Intelligence, 2015, 37(9): 1904-1916.

[19] PENATTI O A B, NOGUEIRA K, DOS SANTOS J A. Do deep features generalize from everyday objects to remote sensing and aerial scenes domains[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition Workshops, 2015: 44-51.

[20] HU F, XIA G S, HU J, et al. Transferring deep convolutional neural networks for the scene classification of high-resolution remote sensing imagery[J]. Remote Sensing, 2015, 7(11): 14680-14707.

[21] HE K, SUN J. Convolutional neural networks at constrained time cost[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5353-5360.

[22] LIN M, CHEN Q, YAN S. Network in network[J]. Computer Science, 2013.

[23] SZEGEDY C, LIU W, JIA Y, et al. Going deeper with convolutions[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1-9.

[24] SZEGEDY C, VANHOUCKE V, IOFFE S, et al. Rethinking the inception architecture for computer vision[J]. ArXiv Preprint ArXiv, 2015:2818-2826.

[25] HE K, ZHANG X, REN S, et al. Deep residual learning for image recognition[C]∥Proc.of the IEEE Computer Vision and Pattern Recognition, 2016: 770-778.

[26] SZEGEDY C, IOFFE S, VANHOUCKE V, et al. Inception-v4, inception-resnet and the impact of residual connections on learning[J]. 2016.

[27] CHAN T H, JIA K, GAO S, et al. PCANet: a simple deep learning baseline for image classification[J]. IEEE Trans.on Image Processing, 2015, 24(12): 5017-5032.

[28] MAHENDRAN A, VEDALDI A. Understanding deep image representations by inverting them[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 5188-5196.

[29] MAATEN L V D, HINTON G. Visualizing data using t-SNE[J]. Journal of Machine Learning Research, 2017, 9(2605): 2579-2605.

[30] LAURENS V D M. Accelerating t-SNE using tree-based algorithms [J].Journal of Machine Learning Research,2014,15(1): 3221-3245.

[31] YANG Y, NEWSAM S. Bag-of-visual-words and spatial extensions for land-use classification[C]∥Proc.of the 18th SIGSPATIAL International Conference on Advances in Geographic Information Systems, 2010: 270-279.

[32] YANG Y, NEWSAM S. Spatial pyramid co-occurrence for image classification[C]∥Proc.of the IEEE International Conference on Computer Vision, 2011: 1465-1472.

[33] JIANG Y, YUAN J, YU G. Randomized spatial partition for scene recognition[C]∥Proc.of the European Conference on Computer Vision, 2012: 730-743.

[34] XIAO Y, WU J, YUAN J. mCENTRIST: a multi-channel feature generation mechanism for scene categorization[J]. IEEE Trans.on Image Processing, 2014, 23(2): 823-836.

[35] AVRAMOVIC A, RISOJEVIC V. Block-based semantic classification of high-resolution multispectral aerial images[J]. Signal, Image and Video Processing, 2016, 10(1): 75-84.

[36] CHENG G, HAN J, ZHOU P, et al. Multi-class geospatial object detection and geographic image classification based on collection of part detectors[J]. Isprs Journal of Photogrammetry and Remote Sensing, 2014, 98(1): 119-132.

[37] KOBAYASHI T. Dirichlet-based histogram feature transform for image classification[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2014: 3278-3285.

[38] NEGREL R, PICARD D, GOSSELIN P H. Evaluation of second-order visual features for land-use classification[C]∥Proc.of the IEEE 12th International Workshop on Content-Based Multimedia Indexing, 2014: 1-5.

[39] REN J, JIANG X, YUAN J. Learning LBP structure by maximizing the conditional mutual information[J].Pattern Recognition, 2015, 48(10): 3180-3190.

[40] CHEN S, TIAN Y L. Pyramid of spatial relatons for scene-level land use classification[J]. IEEE Trans.on Geoscience and Remote Sensing, 2015, 53(4): 1947-1957.

[41] HU F, XIA G S, WANG Z, et al. Unsupervised feature learning via spectral clustering of multidimensional patches for remotely sensed scene classification[J]. IEEE Journal of Selected Topics in Applied Earth Observations and Remote Sensing, 2017, 8(5):2015-2030.

[42] CHENG G, HAN J, GUO L, et al. Effective and efficient midlevel visual elements-oriented land-use classification using VHR remote sensing images[J]. IEEE Trans.on Geoscience and Remote Sensing, 2015, 53(8): 4238-4249.

[43] CHENG G, HAN J, GUO L, et al. Learning coarse-to-fine sparselets for efficient object detection and scene classification[C]∥Proc.of the IEEE Conference on Computer Vision and Pattern Recognition, 2015: 1173-1181.

[44] HU F, XIA G S, HU J, et al. Fast binary coding for the scene classification of high-resolution remote sensing imagery[J].Remote Sensing, 2016, 8(7): 555.

[45] ZHONG Y, FEI F, ZHANG L. Large patch convolutional neural networks for the scene classification of high spatial resolution imagery[J]. Journal of Applied Remote Sensing, 2016, 10(2): 025006.

[46] QI K L, LIU W X, YANG C, et al. High resolution satellite image classification using multi-task joint sparse and low-rank representation[J]. Preprints (www.preprints.org), 7 November 2016, doi:10.20944/preprints201611.0036.v1.

[47] ZHAO B, ZHONG Y, ZHANG L. A spectral-structural bag-of-features scene classifier for very high spatial resolution remote sensing imagery[J]. Isprs Journal of Photogrammetry and Remote Sensing, 2016, 116: 73-85.

[48] YU H, YANG W, XIA G S, et al. A color-texture-structure descriptor for high-resolution satellite image classification[J]. Remote Sensing, 2016, 8(3): 259.

[49] LIU Y, ZHONG Y, FEI F, et al. Scene semantic classification based on random-scale stretched convolutional neural network for high-spatial resolution remote sensing imagery[C]∥Proc.of the IEEE International Geoscience and Remote Sensing Symposium, 2016: 763-766.