基于改进提升模型的视频目标跟踪算法

罗 建 华

(河源职业技术学院 广东 河源 517000)

0 引 言

为了提升视频目标跟踪的鲁棒性,基于机器学习的视频目标跟踪得到了许多研究人员的研究和发展[1-4]。其中半监督学习技术在目标跟踪中得到了广泛使用。使用半监督学习的优点在于可以利用大量的无标签数据信息,这样将减少对目标进行打标签而带来的人工成本,具有较强的实用价值。但是,半监督学习不能完全解决视频跟踪的目标外观变化问题。文献[5]研究表明,当无标签样本信息和有标签样本信息的统计分布不同时,半监督学习的分类预测性能相比有监督学习没有任何优势可言。

因此,根据运动的视频帧具有连续性的特点,并且假定视频目标跟踪中包含较多的先验信息。在此基础上,对获取的目标先验信息进行编码,以作为训练样本的置信度。在视频目标跟踪过程中,视频目标所在的前景和背景信息有时候可能比较相近,而且视频帧的相关内容信息可能有助于目标的检测,虽然这些内容信息不是真实所需要跟踪目标的一部分;如果跟踪器在某些地方没有精准地定位到目标所在位置,这样目标的外观表征模型将基于这些不准确的标签数据进行更新,相应的,跟踪误差将会不断累积,最终导致跟踪失败。

因此,为了减少目标跟踪的累积误差,提升跟踪的鲁棒性能,提出一种基于改进提升学习模型的目标跟踪方法。对有标签数据和无标签数据分别设计基于一种置信度最大化的分类器,然后将分类器进行加权组合,形成一个强分类器,用于目标跟踪。

1 基于改进提升模型的视频跟踪算法

融合有标签数据和无标签数据,基于改进提升学习策略,减轻目标跟踪的误差累积。同时,在样本选择的过程中基于权重配置策略,选择置信度较高的样本用于分类器学习,以减少训练样本的数量,保障目标跟踪方法的效率。

E[C(i)]=p+(i)e-F(xi)+p-(i)eF(xi)

(1)

进一步,基于训练样本数据的损失函数可表示为:

(2)

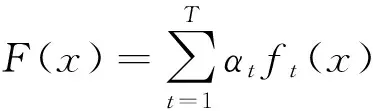

式中:C被称为置信度。为了最小化置信度C,考虑一种两阶段的组合分类器F(x)+αtft(x),其中F(x)是第一阶段的分类器,ft(x)是第二阶段产生的分类器函数,相应的,损失函数可表示为:

(3)

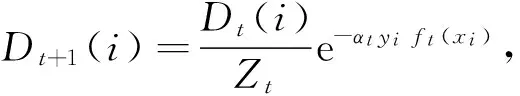

设ft(xi)={1,-1},损失函数对投票权重αt求导,可得:

(4)

(5)

(6)

综合以上分析,ft可重写为:

(7)

2) 结合无标签样本的提升改进算法 在视频跟踪中,无标签样本的数据信息要丰富得多,原因是标签样本需要花费大量的人力、物力去给样本打标签。由于无标签样本没有标签类别信息,所以假设这些无标签数据的标签类别为随机变量,定义为:U=[u1,u2,…]。因此,对所有无标签样本,损失函数可表示为:

(8)

由于无标签样本U=[u1,u2,…]为无观测随机变量,所以采用期望最大化算法EM(Expectation Maximization)来最小化损失函数。主要的步骤如下:

(1) E步Q函数为:

(9)

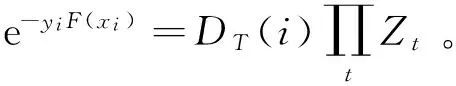

式中:第一项与u不相关,所以有:

(10)

(11)

(12)

综上分析,基于改进提升模型的视频跟踪算法详细步骤为:

步骤1对第一视频帧V1训练弱分类器。

步骤2对接下来的每个视频帧Vj,重复以下步骤:

步骤2.1获取前t个视频帧Vj-1,…,Vj-t,相应的矩形框位置设置为:lj-1,…,lj-t,对在这些矩形框内和外部的图像像素值和相应的标签数据进行整合,形成标签样本集。

步骤2.2提取前t个视频帧Vj-1,…,Vj-t中的局部二值模式LBP(Local Binary Pattern)特征信息,采用最小二乘方法预测出前t个视频帧Vj-1,…,Vj-t中无标签样本的类别标签信息,结合步骤2.1中的有标签数据,形成整个有标签数据。

步骤2.4将步骤2.2和步骤2.3获取的标签样本和无标签样本分别采用自适应提升的改进算法和结合无标签样本的提升改进算法进行分类,然后将两个分类器进行加权组合,获取最终的强分类器。

步骤2.5输出目标跟踪结果,即在视频帧Vj上给出分类器在无标签样本上的分类置信度和相应的矩形框位置lj。

步骤3根据步骤2获得所有视频帧的跟踪结果,输出跟踪结果的矩形框位置l2,…,ln。

2 实验结果及讨论

为了测试视频目标跟踪算法的性能,采用Benchmark测试集[6]中的视频序列数据用于跟踪性能的比较分析,并且与近年来的三种目标跟踪算法进行比较,分别是文献[7]给出的目标跟踪方法[7]TLD(Tracking-Learning Detection)、在线多示例学习跟踪算法[8]MIL(multiple instance learning)、稀疏协同目标跟踪方法SCM(Sparse Collaborative Model)[9]。 实验测试环境为一台普通计算机、CPU为Intel CoreTM i5 处理器、主频3.3 GHz、内存8 GB ,操作系统为64位Windows 7,算法仿真平台为MATLAB2012b。其中测试的对象为Caviar和Car6两组视频序列。

由于每种跟踪算法都具有一定的随机性,所以每种方法在测试集上都运行了10次并取平均结果作为最终的比较数据。在样本数据的选择中,每一个样本均提取了 120个LBP 特征用于分类器学习。

为了度量视频跟踪的性能,采用平均中心点误差和平均重叠率作为衡量准则。其中中心点误差能反映目标跟踪方法的稳定性,一般情况下,如果在一个视频序列中中心点平均误差不超过20个像素就认为跟踪成功。平均重叠率可以体现跟踪性能的鲁棒性,因为它不但考虑了跟踪框的位置还考虑了跟踪框的姿态、面积、旋转等因素。

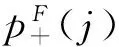

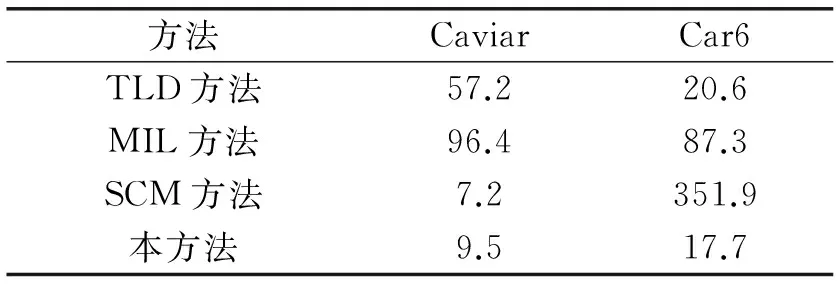

表1和表2分别给出了文中跟踪算法与其他几种跟踪算法的平均中心点误差和平均重叠率结果比较。从表1和表2中可以看出,文中提出的跟踪改进算法性能较好,表明提出的跟踪改进算法具有较强的鲁棒性。

表1 平均中心点误差 像素

表2 平均重叠率 %

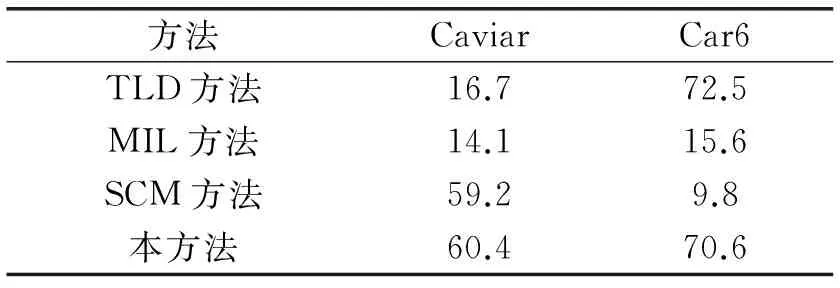

为了更进一步验证上述几种跟踪算法的性能,图1-图4分别给出了文中算法与其他三种跟踪算法的误差对比曲线结果。从图1-图4中也可以看出,文中提出的跟踪改进算法较其他三种算法性能较好,总结起来,原因包括以下两点:

1) 文中提出的跟踪改进算法有效利用了样本的无标签先验信息,将有标签样本和无标签样本结合起来,设计了一种改进提升的强分类器,提高了跟踪的准确率。

2) 在样本采集过程中基于权重策略来选择置信度较大的样本,并利用样本的LBP特征,用于视频跟踪的分类器学习中,有效解决了视频跟踪中随目标外观变化而造成的误差累积问题,提高了目标跟踪的稳定性和鲁棒性。

图1 Caviar视频的中心点误差比较

3 结 语

随着视频目标跟踪技术的发展,为减少跟踪中出现的累积误差问题,本文结合无标签样本和有标签样本数据,提出了一种基于改进提升的视频目标跟踪算法。本文利用选择的样本集来训练分类器,利用了无标签样本的局部二值模式特征信息,有效保留了样本空间的局部几何结构,进一步减少了视频跟踪中随目标外观变化而造成的误差累积问题,提升了视频目标跟踪的鲁棒性能。

[1] Li G,Huang Q,Qin L,et al.SSOCBT:A Robust Semisupervised Online CovBoost Tracker That Uses Samples Differently[J].IEEE Transactions on Circuits and Systems for Video Technology,2013,23(4):695-709.

[2] Zhang T,Liu S,Ahuja N,et al.Robust Visual Tracking Via Consistent Low-Rank Sparse Learning[J].International Journal of Computer Vision,2015,111(2):171-190.

[3] Lee K H,Hwang J N.On-Road Pedestrian Tracking Across Multiple Driving Recorders[J].IEEE Transactions on Multimedia,2015,17(9):1429-1438.

[4] Li A,Lin M,Wu Y,et al.NUS-PRO:A New Visual Tracking Challenge[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2016,38(2):335.

[5] Li Y F,Zhou Z H.Towards making unlabeled data never hurt[C]//International Conference on International Conference on Machine Learning.Omnipress,2011:1081-1088.

[6] Wu Y,Lim J,Yang M H.Online object tracking:A benchmark[C]//IEEE Computer Society Conference on Computer Vision and Pattern Recognition (CVPR),2013:2411-2418.

[7] Kalal Z,Mikolajczyk K,Matas J.Tracking-Learning-Detection[J].IEEE Transactions on Pattern Analysis & Machine Intelligence,2012,34(7):1409-1422.

[8] Babenko B,Yang M H,Belongie S.Robust object tracking with online multiple instance learning[J].IEEE Transactions on Pattern Analysis and Machine Intelligence,2011,33(8):1619-1632.

[9] Zhong W,Lu H,Yang M H.Robust object tracking via sparse collaborative appearance model[J] .IEEE Transactions on Image Processing,2014,23(5):2356-2368.