杂草自动识别除草机器人设计——基于嵌入式Web和ZigBee网关

李碧青,朱 强,郑仕勇,陈科尹

(1.贺州学院 a.机械与电子工程学院; b. 计算机科学与信息工程学院,广西 贺州 452899;2.中原工学院信息商务学院信息技术系,郑州 450007)

杂草自动识别除草机器人设计

——基于嵌入式Web和ZigBee网关

李碧青1a,朱 强2,郑仕勇1b,陈科尹1b

(1.贺州学院 a.机械与电子工程学院; b. 计算机科学与信息工程学院,广西 贺州 452899;2.中原工学院信息商务学院信息技术系,郑州 450007)

为了提高除草机器人自主导航能力和杂草识别率,将嵌入式Web和ZigBee技术引入到了机器人的控制系统中,设计了一种新型杂草自动识别除草机器人。除草器人利用摄像头采集导航图像,利用作物颜色特征在RGB颜色空间对图像进行分割,使用OTSU方法检测作物的中心线,以农作物行中心线为基准线进行自动行走,实现了机器人的自主导航功能。机器人利用杂草识别摄像头识别杂草,使用ARM9处理器对图像进行处理,利用ZigBee发送控制指令,最后由执行末端刀盘去除杂草。为了验证机器人杂草识别和导航性能的可靠性,对机器人的性能进行了测试,结果表明:图像计算和实际机器人测试的位姿结果非常接近,杂草的识别率在99.8%以上,算法的性能可靠,杂草识别精度高,除草机器人的实时性较好。

除草机器人;嵌入式Web;ZigBee网关;ARM9处理器;OTSU方法

0 引言

农业是国民经济中的基础产业,对经济和社会生活起到重要的支撑作用。中国人口多,随着生态环境的恶化,中国的农业面临严峻的考验,为了提高农业资源的利用率及农业的经济效益,发展现代化精准农业是必然选择的途径。精确农业是一个新的农业生产概念,精准农业对化肥、除草剂和水的使用都进行了优化,最大限度地降低了对生态环境的破坏。精准农业的实现需要依赖现代高科技,而机器人的使用可以大大提高生产效率、降低劳动强度、提高生产质量,是精准农业的重要组成部分。目前,对于除草机器人的研究还比较少,在实际生产中的应用更少,因此对除草机器人的研究有重要的现实意义。

1 结构和控制系统

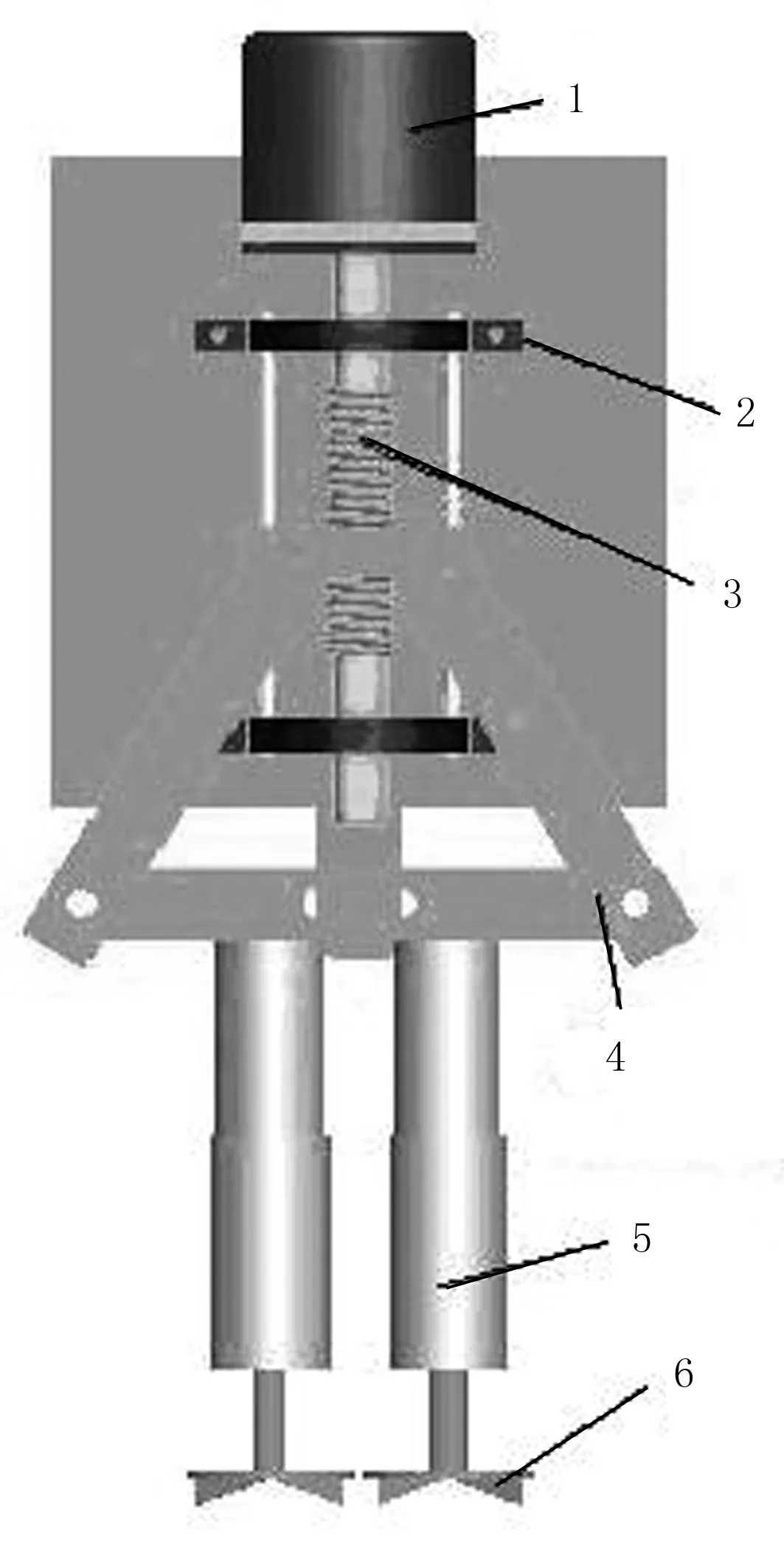

自动识别除草机器人适用于低矮作物的除草,可以定点去除行内的杂草,也可对行间喷施除草剂。机器人在行走过程中利用导航摄像头采集作物环境信息,经过PC机图像处理,得到导航信息,控制自主行走路线。机器人由伺服电机驱动,前轮采用差速转向,后轮采用万向轮,利用杂草识别摄像头对杂草进行识别,实现定点除草。机器人结构如图1所示。

1.高清摄像头 2.杂草识别摄像头 3.作物 4.除草执行器 5.机器人本体 6.机械臂

当机器人识别杂草时,利用刀盘去除杂草,执行末端还可以喷洒除草剂,在清除杂草的同时,还可避免杂草的再次生长,实现了高效除草。机器人的执行末端结构如图2所示。

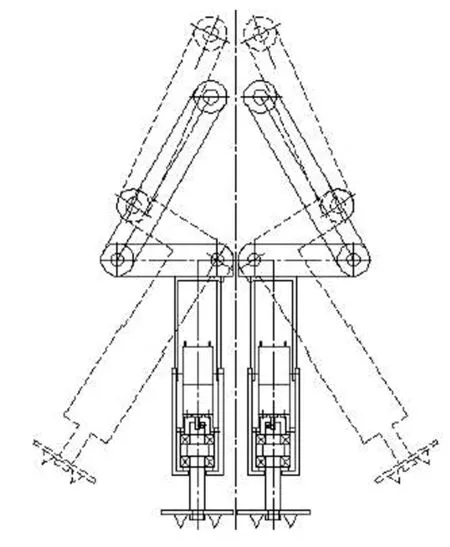

除草机器人执行末端主要由6部分组成,连杆和滑块使用铰链接相连,丝杠由步进电机驱动,滑块沿着丝杠上下运动,带动连杆使除草执行末端张开和闭合,其运动过程如图3所示。

1.步进电机 2.是滑块 3.丝杠 4.连杆 5.除草执行臂 6.刀盘

图3 除草机器人执行末端动作示意图

当机器人识别到杂草时,执行器闭合,刀盘伸进土壤中,通过刀盘的转动将杂草根部搅断,实现杂草的精准去除。控制系统的框架如图4所示。

系统的控制核心是ARM9单片机微处理器。杂草的位置信息通过杂草识别摄像头进行采集,利用ZigBee传感网络传输给处理器,识别杂草的方位;获得杂草的方位后,除草系统控制机器人末端执行器,执行除草动作。

图4 杂草识别及除草控制系统

2 图像灰度化和阈值分割

在除草机器人采集环境图像时,由于采集得到的图像是真彩图像,其色彩比较丰富、信息量较大,处理耗时和难度都较高。为了提高图像分割的效率,实现机器人的自主导航,需要对图像进行灰度处理。在作物采集图像的RGB空间中,作物G的分量比较高,而土壤作为背景值的R和B比较突出,背景的R和B分量值较高。Woebbecke等提出2g-r-b超绿特征对于绿色植物的图像分割效果最好,背景分割最为有效。超绿特征是利用RGB的绿色植物空间像素值R(x,y)、G(x,y)和B(x,y)的不同,根据G(x,y)总是大于R(x,y)和B(x,y)的特征,将G(x,y)加大,来突出植物和杂草区域,便于除草机器人进行识别。超绿色特征因子的计算公式为

ExG(x,y)=2G(x,y)-R(x,y)-B(x,y)

(1)

在机器实际图像采集的过程中,受到光照和天气因素的影响,颜色空间分量值的变化较大。为了改善超绿因子的效果,需要对因子做出一些修正,其公式为

(2)

阈值分割技术是利用图像的灰度值,通过设定不同的阈值,将图像的像素灰度按照特征提取。假设原始图像为f(x,y),按照一定的准则得到特征值T,利用特征阈值T将图像分割为两部分,图像分割完成后的表达式为

(3)

取b0=0为黑,b1=1为白,即为图像的二值化。在本次研究中,采用最大类间OTSU算法对图像进行分割。OTSU算法在灰度直方图的基础上采用最小二乘法原理,在统计意义上具有最佳分割阈值。在一幅图像中一般有L个灰度级,其中第i级像素为ni个,i的值在0~L-i之间,则图像的总像素点个数为

(4)

其中,第i个灰度级出现的概率为

(5)

在OTSU算法中,利用阈值k将像素分为两个区间,其中目标区域为灰度级是0-k-1,背景区域的灰度级为k-L-1,整个图像的平均灰度级为

(6)

目标区域出现的概率为

(7)

背景区域出现的概率为

(8)

目标图像的平均灰度为

(9)

背景类像素的平均灰度为

(10)

类差δ2(k)的表达式为

δ2(k)=p0(μ-μ0)2+p1(μ-μ1)2

(11)

在0~L-i之间对将k进行取值,当k取值δ2(k)的值最大时,可以得到最佳图像分割阈值。利用分割阈值提取作物和杂草的特征图像,便于除草机器人的识别。

3 嵌入式Web和ZigBee网关设计

除草机器人的远程控制采用嵌入式Web和ZigBee网关。机器人在作业过程中,获得的环境信息通过ZigBee传输,并传送控制中心发出的指令;而嵌入式Web可以方便用户进行远程查询和界面操作,并利用互联网传送和储存数据。嵌入式处理器采用Samsung公司的ARM9S3C2410,该处理器性能高,功率损耗少,价格适中,在内部集成了微处理器和一些外围组件,降低了系统额外配置的成本,为嵌入式系统提供了较好的硬件平台。其功能模块的框架结构如图5所示。

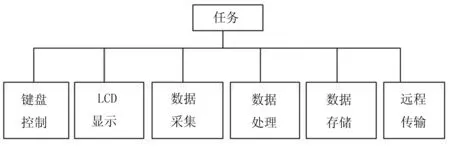

图5中:CPU单元采用ARM9微处理控制器S3C2410,集成度高,可扩展性好;复位电路包括最少4个周期的有效低电平,从而可以保证系统可以稳定复位;存储单元采用64M闪存,由时钟作为操作同步,提高了操作速度和数据的吞吐量;网络控制采用CS8900A太网控制器,可以提供10Mb/s的以太网络通信,满足了用户通过TCP/IP通过以太网进行数据交互。串口包括两个,串口1作为控制台,串口2对嵌入式Web服务器和ZigBee网络进行协同,实现对除草机器人数据的采集;JATG仿真调试接口负责硬件电路的开发和调试。网格节点的设计利用软件来实现,其实现的功能如图6所示。

图5 系统硬件功能模块框图

图6 软件部分任务功能

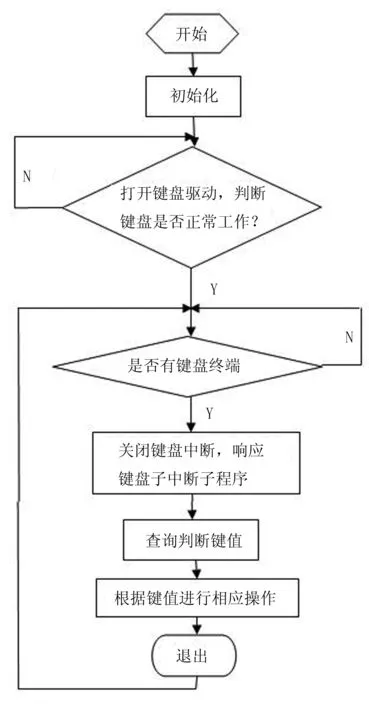

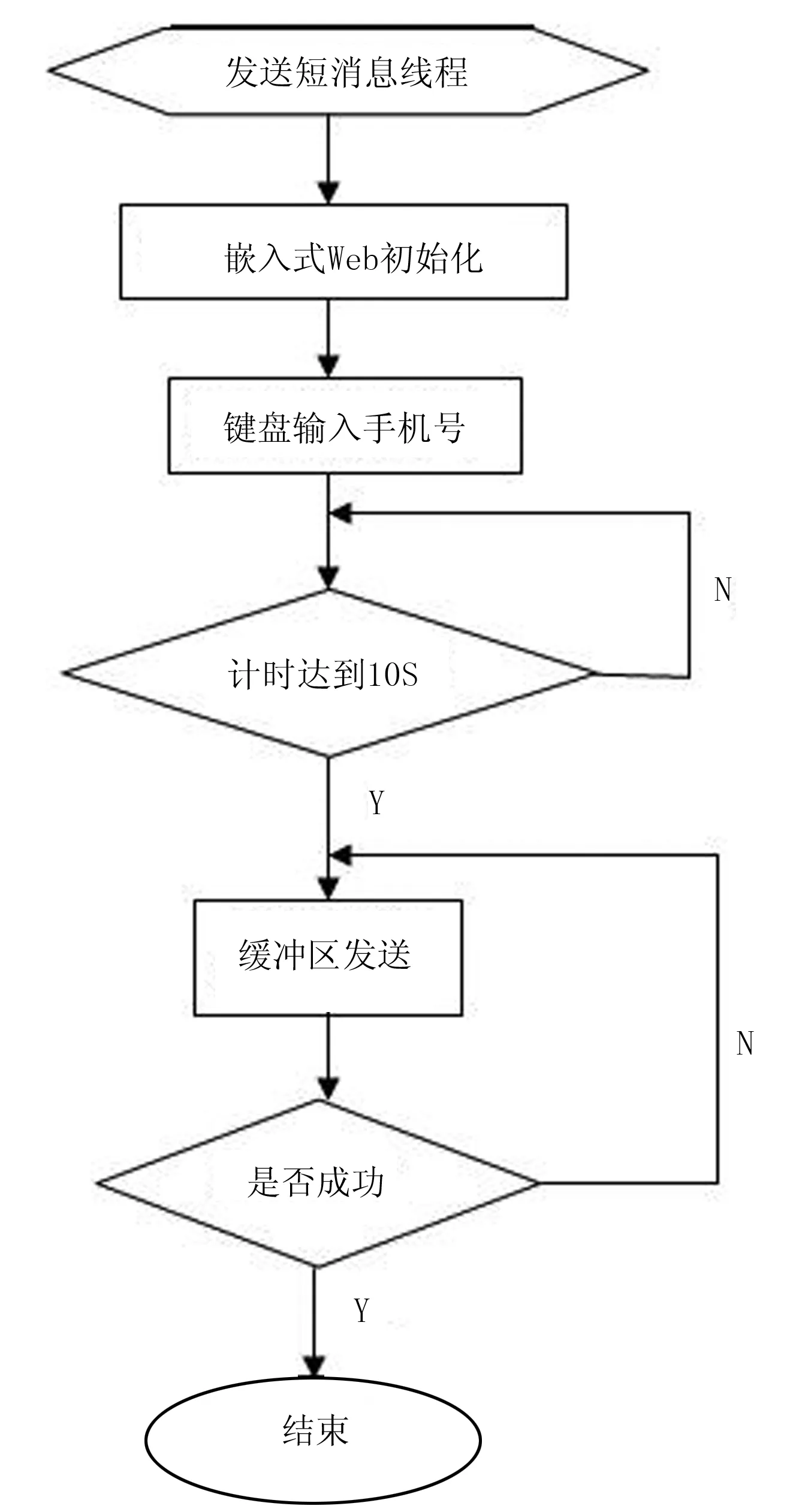

图6表示软件部分的任务功能,通过软件驱动使数据的传输通过ARM9处理器上的路由节点来实现,使液晶显示屏可以显示除草作业环境和传感器的各种参数,使理由节点的数据传送到U盘中,并将路由节点的数据发送给管理人员,使管理人员可以及时做出决策、发出指令。指令可以利用键盘模型输入,其实现过程如图7所示。

键盘采用4×4的矩阵键盘,利用8条引线将键盘和AARM9处理器相连。其中,CPU的GPC7-10端口和键盘的4行连接,GPD0-1、GPD8-9和键盘的4列连接;用户可以通过键盘输入控制指令,控制除草机器人的动作。指令主要利用高低电平来识别,机器人通过查询判断键盘值,根据键盘值做出相应的操作。

信息数据的采集主要通过ZigBee组网实现,而采集的信息数据可以利用GSM系统进行大范围的传送。ZigBee和GSM模块采用嵌入式Web模型进行协调,嵌入式Web确认网络连接后,由ARM9处理器控制键盘模块将参数以短信的形式发送给管理人员,实现了系统的实时监控功能。指令传送和通信模块如图8所示。

图7 键盘模块功能实现

图8 指令传送和通信模块设计

4 除草机器人除草测试

为了验证本次设计的除草机器人的可靠性,对机器人的性能进行了测试,首先在实验室内利用机器人的高清摄像头拍摄了一幅真彩图像,并对图像进行了灰度处理,如图9所示。

图9 室内杂草识别和导航图像

为了提高实验的效率,按照杂草和植株已经成长到一定程度的低矮植株比例,制作了作物和杂草的模型,利用OSTU阈值分割得到了如图10所示的分割结果。

图10 杂草和导航线识别

由图10可以看出:利用阈值分割可以清晰地划分出导航线,并可以清晰地识别杂草;通过图像可以对机器人的位姿进行预测,然后合理的控制机器人位姿。

表1表示利用图像计算和机器人实际测试得到的位姿表。由结果对比可以看出:图像计算和实际机器人测试的位姿结果非常接近,从而验证了杂草和作物图像识别算法的可靠性,可以利用该算法对机器人发出控制指令,精确地完成机器人的杂草自动识别和自主导航。通过对机器人杂草识别率的测试发现,机器人可以有效地识别杂草,其识别率在99.8%以上,识别精度较高,作业效果较好。

5 结论

利用OTSU图像分割算法,结合ARM9处理器,将嵌入式Web和ZigBee技术引入到了机器人的控制系统中,设计了一种新型杂草自动识别除草机器人。为了验证机器人的可靠性,对机器人的性能进行了测试。测试结果表明:利用阈值分割可以清晰地划分出作物导航线,并可清晰地识别杂草,利用图像可以对机器人的位姿进行成功的预测。通过进一步测试发现,机器人通过图像处理计算得到的位姿和实际作业过程中的位姿比较吻合,而且杂草的识别率达到了99.8%以上,机器人的作业精度较高、可靠性和实时性较好,可以在实际生产中推广使用。

[1] 王芳, 满益云.基于模糊中值滤波的椒盐噪声去除方法[J].模糊系统与数学, 2012, 26(1):166-174.

[2] 祁宝英.运用Hough 变换提高直线检测效率[J].计算机系统应用, 2012, 21(6): 228-231.

[3] 周燕红,范红.移动机器人视觉导航中基于Hough 变换的直线检测与跟踪[J].管控一体化,2102,192(2): 129-115.

[4] 肖诚,毛永文,颉方正.基于PWM 装置的直流电机双闭环调速系统[J].设计与制造,2012,23(6): 122-125.

[5] 王春风,李旭春,薛文轩. PWM 直流调速系统实验的教学实践[J].实验室研究与探索,2012,31(8):32-34.

[6] 汪雅楠,谭南林.基于ARM9的工业以太网 EtherCAT从站设计[J].机械工程与自动化, 2011(5): 139-141.

[7] 余前金,李力.基于ARM2440的塔机数据采集系统的研究[J].硅谷,201l(1):49.

[8] 吴健,闫磊,钱桦.自动可视除草机器人系统设计[J]. 湖南农业科学, 2011(21): 129-131.

[9] 张春龙.智能除草机器人系统设计与仿真[J].农业机械学报, 2011, 42(7): 197-201.

[10] 龚尧飞,徐洪波,金静.嵌入式移动Web 服务器系统[J].计算机工程与设计,2010,31(24):5204-5207.

[11] 李长锋,滕国库,常闯.基于 ZigBee 的无线传感网络网关的设计[J].计算机与数字工程,2011,39(7):150- 153.

[12] 胡鸿豪,林程,宋丽平.基于 S3C2410的ZIGBEE 无线传感器网络网关的设计[J].大众科技,2008(12): 67-68.

[13] 李木国,王磊,王静,等.基于EtherCAT的工业以太网数据采集系统[J].计算机工程,2010,36(3):237-239.

[14] 王维健.工业以太网 EtherCAT 的原理及其实现[J].微计算机信息,2010,26(5):51-52.

[15] 崔光照,陈富强,张海霞.基于 ARM9 的无线传感器网络网关节点设计[J].电子技术应用,2008,34(11): 115-118.

[16] 胡国珍,王泉,魏旻.基于ZigBee的工业无线网关研究[J].单片机与嵌入式系统应用,2009(5): 25-28.

[17] 耿军涛,周小佳,张冰洁.基于无线传感器网络的大气环境监测系统设计[J].西华大学学报:自然科学版, 2007,26(4): 44-46.

[18] 匡兴红,邵惠鹤.无线传感器网络网关研究[J].计算机工程,2007,33(6): 228 -230.

[19] 金立生,王荣本,纪寿文,等.智能车辆自主导航神经网络控制器设计[J].农业机械学报,2005,36(10): 30-33.

[20] 袁佐云,毛志怀,魏青.基于计算机视觉的作物行定位技术[J].中国农业大学学报,2005,10(3):69-72.

[21] 孙元义,张绍磊,李伟.棉田喷药农药机器人的导航路径识别[J].清华大学学报,2007,47(2):32-34.

[22] 郭伟斌,陈勇.基于模糊控制的机器人自主导航[J].机器人,2010, 32(2): 204-211.Abstract ID:1003-188X(2017)01-0217-EA

Design for Weeding Robot Based on Embedded Web and ZigBee Gateway

Li Biqing1a, Zhu Qiang2, Zheng Shiyong1b, Chen Keyin1b

(1.a.College of Mechanical and Electronic Engineering; b.College of Computer Science and Information Engineering, Hezhou University,Hezhou 452899,China; 2.Department of Information Technology, College of Information and Business, Zhongyuan University of Technology,Zhengzhou 450007,China)

In order to improve the ability of autonomous navigation and weed recognition, the embedded Web and ZigBee technology are introduced into the control system of the robot. The robot collects navigation uses the color space of RGB images to segment the image, and uses the OTSU method to detect the center line of the crop. Robots use weed recognition to identify the weed, use the ARM9 processor to process the image, use ZigBee to send control commands, and finally by the end of the implementation of the end of the knife to remove the weeds. In order to verify the reliability of the weed identification and navigation performance, the performance of the robot was tested. The results show that the image is very close to the actual robot test. The performance of the algorithm is reliable in that the identification rate of weeds was above 99.8%, the real-time performance is good.

weeding robot; embedded Web; ZigBee gateway; ARM9 processor; OTSU method

2015-11-27

广西自然科学基金项目(2015GXNFBA139264);贺州市科技开发项目(贺科能1506006、贺科攻1506006);贺州学院科研、教改项目(2014YBZK10,2015SHGZ005,2015MTA16,2015ZZZK03,2015kf27,hzxytszy201501,hzxyjg201525)

李碧青(1984-),女,南宁人,讲师,硕士。

朱 强(1985-),男,河南信阳人,讲师,硕士,(E-mail)254034704@qq.com。

S224;TP391.41

A

1003-188X(2017)01-0217-05