面向阅读教学的眼动数据可视化批注方法

,

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

面向阅读教学的眼动数据可视化批注方法

程时伟,孙煜杰

(浙江工业大学 计算机科学与技术学院,浙江 杭州 310023)

学生在论文阅读过程中往往无法把握重点、理解全文结构和段落关系,导致阅读理解水平较低.因此,为了提高学生的阅读理解水平,研究阅读过程中的眼动行为,记录注视点和眼跳等眼动数据,提取相关的阅读特征,在此基础上生成眼动数据可视化批注.主要利用灰色阴影表示段落阅读速度、段落边框表示重复阅读的次数以及段落间连线表示相互之间的转换频率.在具体的阅读教学课堂测试中,记录教师阅读论文时的眼动数据并生成可视化批注,然后分享给学生被试用户,进而对学生阅读理解水平进行客观和主观评价.结果表明:实验组学生的阅读理解客观答题得分和主观小结撰写得分,其平均值分别比控制组学生的平均得分提高了31%和57%,验证了眼动可视化批注能有效提高学生的阅读理解水平.

眼动跟踪;注视点;阅读;社会计算;人机交互

人们在阅读纸质书籍和文档时常做一些批注,批注不仅能帮助人们标记重要的、有趣的或者较难理解的段落,还能在再次阅读时或者他人阅读时,通过强调或提示来提高理解水平[1-2].读者在阅读一篇文档时,如果可以利用以前读者的经验,就能在阅读过程更加集中注意力,从而提高阅读效率.然而,传统的手工批注也有其局限性,例如,通过划线来强调一句话或者添加一段注释,通常会增加体力和认知负荷;而且手工批注也不能揭示读者的视觉注意力行为.另一方面,近年来也出现了一些阅读辅助工具,例如,Markup是一个众包阅读工具,它可以在纸质文档上呈现不同用户标注的数字化批注,使人们可以在协同环境下进行阅读,在一个群体协作的机制下受益[1].然而,这样的批注工具需要特定的硬件配置,限制了其在实际中的应用和推广.相比之下,眼动(Eye movement)数据可以表征人们的视觉注意力以及视觉搜索绩效[3].现代心理学家认为眼动是视觉过程的直接反应,由此发展而来的眼动跟踪技术被广泛应用于阅读研究[4].涉及阅读过程大脑认知加工的眼动主要包括三类:1) 注视点(Fixation),用于获取阅读信息;2) 眼跳(Saccade),从一个注视点运动到另一个注视点,用于阅读过程的持续进行;3) 回视(Regressive eye movement),用于将注视点返回以进一步获取阅读信息[5].在有效的阅读过程中,读者的注视点需要处于恰当位置,同时加长眼跳距离,以及避免不必要的回视和采取有效回视等来提高阅读效率和阅读理解水平[6].

眼动数据的可视化可以用来作为一种新的批注方式.Text2.0框架根据眼动数据实时创建批注,当用户注视相关文字时显示批注[7].利用眼动跟踪技术可以检测读者阅读的文字字数和文档类型[8-9].结合眼动跟踪和光学字符识别(Optical character recognition, OCR)技术,还可以用于判断用户正在阅读哪一行文字,进而自动生成一些简单的批注,例如,显示截止当前位置所耗费的阅读时间[10].然而,尚未有人探索如何利用眼动数据生成的批注来提高阅读理解水平.为此,笔者分析阅读过程中的视觉注意行为特征,基于眼动数据进行可视化表达,生成相应的批注,并在课堂阅读教学过程中,让学生查看教师的眼动数据可视化批注,研究学生的阅读理解水平是否得到提高.

1 基于眼动数据的阅读特征提取

将英文论文作为阅读材料,将论文中的每个标题(或副标题)、段落(包括参考文献),以及插图等作为感兴趣区(Area of interest, AOI).论文的其他地方是空白区域或很少被读者关注的区域,因此不将它们考虑在内.记录阅读过程中读者在AOI中的眼动数据,进而提取相关的阅读特征,用以衡量读者对文本段落的理解程度[11].定义两类阅读特征:1) AOI内特征包括单个AOI的阅读速度和单个AOI的阅读次数;2) AOI间特征是指两个AOI之间的转换频率,用于分析一篇文档不同部分之间的语义关系,可以为主动阅读过程中的导航提供有益的支持[2].下面对各特征做具体描述.

1.1 单个AOI的阅读速度

阅读速度可以反映读者的阅读兴趣,例如,读者可能很快浏览完文档中不感兴趣或者易于理解的部分.单个AOI的阅读速度的计算式为

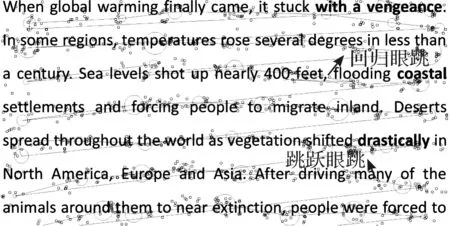

式中:Lk为当前AOIi中的每一段眼跳长度;TAOIi为当前AOIi的驻留时间(Dwell time,表示视线在一个AOI内停留的总时间).如图1所示,这里的一段文本为一个AOI(线条为眼跳,稍大的圆圈为注视点,稍小的圆圈为原始采样点),读者的视线从左到右、从上到下进行逐行阅读,其中眼跳包括回归眼跳(即反向的视线跟踪)和跳跃眼跳(即前向的视线跟踪),它们可以帮助用户更好的理解信息[11-12].

图1 单个AOI内的眼动特征示例Fig.1 Example of eye movement features in a single AOI

定义“AOI内时间阈值”为p(例如1 s),如果TAOIi>p,就记录下这段驻留时间内的阅读速度,因为过短的驻留时间通常意味着仅仅是一瞥而过,对阅读并没有实质帮助.例如,读者常常会上下滚动浏览器,在这个过程中,虽然他们的注视点会在很多AOI内非常短暂的停留,但是没有具体的阅读活动发生.不仅可以使用时间阈值过滤噪声数据,也用它来调整可视化批注.例如,降低阈值p会产生更多的可视化批注,这样会分散读者的注意力,导致读者过多关注不重要的段落.

1.2 单个AOI的阅读次数

对于一个特定的AOI,统计读者视线在该区域的累计阅读次数.如果读者视线从该AOI离开,移动到其他AOI,那么离开的时间应该大于阈值p(即在其他AOI内进行了有效阅读),才能在视线返回原AOI的时候,重新计算为一次新的阅读.阅读次数可以表征段落的理解难易程度或重要程度,因为通常难于理解或重要的段落会被反复阅读[13].

1.3 两个AOI之间的转换频率

如果读者的视线驻留在一个AOI的时间超过阈值p,那么这个AOI就定义为“源AOI”;然后,如果视线移到另外一个AOI,且驻留时间也超过阈值p,那么这个AOI就定义为“目标AOI”.这样就可以过滤数据,排除无效的视线转换.例如,读者的视线会无意识地转移到其他AOI(因为自底向上的视觉认知干扰造成[14],例如,被显著的标题所吸引),并停留短暂时间,然后又转换到原来的AOI.此外,通常两个在内容上有紧密联系的AOI也会相距较近.定义“AOI间时间阈值”为q(例如10 s),如果视线离开源AOI到目标AOI这中间的时间小于q,就认为这些AOI之间是相关的,并将这两个AOI之间的转换频率计数加1.

2 阅读特征的可视化

如图2所示,提出3种具体的可视化形式对上文所述的阅读特征进行可视化编码:1) 灰色阴影表示用户阅读某个AOI的速度,颜色越深表示阅读速度越快;2) 边框宽度表示读者阅读某个AOI的次数,AOI的边框越粗,表示阅读次数越多;3) 连线宽度表示读者在两个不同AOI之间转换频率,连接两个AOI的线条越粗,表示转换频率越高,且不同颜色表示不同AOI对之间的联系.可以动态配置可视化参数,例如:时间阈值(例如p,q)、透明度、隐藏或显示不同的阅读特征等,使之呈现最佳的可视化效果.

图2 阅读特征可视化示例Fig.2 Example of reading feature visualization

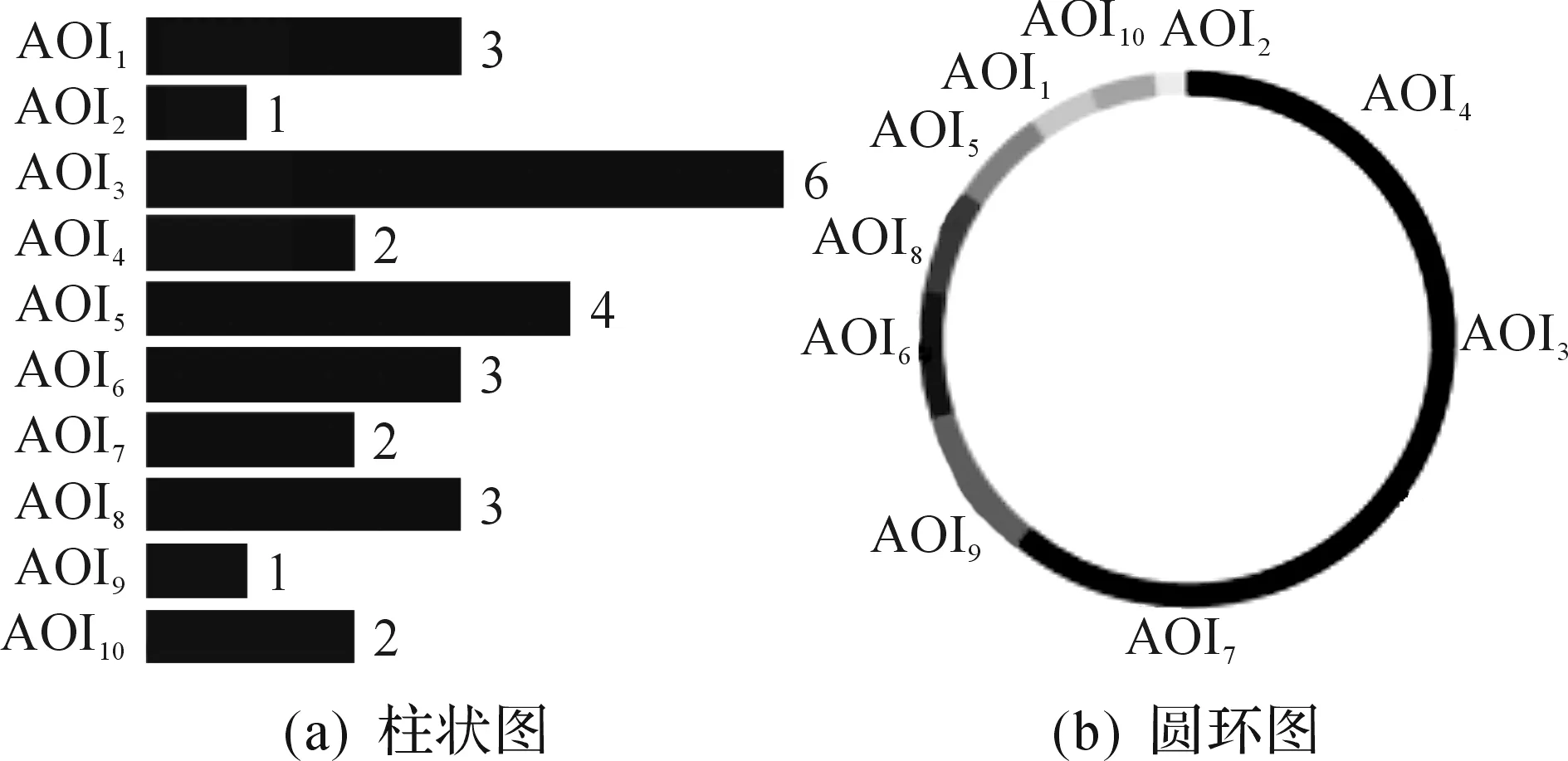

此外,还对用户在主要AOI的驻留时间进行了可视化编码,包括柱状图和圆环图,如图3所示.以圆环图为例,随机用不同颜色在圆环的圆弧上表示每个AOI的驻留时间,每个AOI对应的圆弧圆心角为

式中:TAOIi为当前AOIi的驻留时间;AngleAOIi为AOIi对应的圆心角.在此基础上通过圆心角计算每段圆弧的弧长.

图3 AOI驻留时间可视化示例Fig.3 Example of visualization for dwell time on AOI

3 用户测试

3.1 被试用户

被试用户分为两类:一类是大学教师,包括1名女性和3名男性,年龄在35~40岁,学科背景、专业水平和英文阅读水平相近;另一类是大学生,包括11名女性,25名男性,年龄在18~25岁,平均年龄22.8岁,英文阅读水平相近,均通过大学英语4级考试.所有被试用户都没有任何视力障碍,且均具有计算机相关专业背景,每周至少阅读一篇英文学术论文.

3.2 测试仪器

如图4所示,使用Tobii公司的X2-60型眼动仪(眼动跟踪采样频率设置为60 Hz)记录眼动数据,它的操作距离(用户眼睛与屏幕之间的距离)大约为40~50 cm,支持头部自由运动,对眨眼引起的数据丢失可进行即时补偿,眼动跟踪平均精度为0.4度视角.阅读材料来自计算机专业领域的论文数据库,是一篇4页篇幅的英文论文,该论文有清晰而紧密的逻辑结构和布局,易于进行眼动数据的记录和可视化.这篇论文显示在分辨率为1 366×768的11.6英寸的笔记本电脑显示屏上.

图4 眼动测试场景Fig.4 User study scenario of eye tracking

3.3 测试过程

测试过程分为预测试和正式测试两个阶段.

3.3.1 预测试阶段

每个大学生被试阅读一篇2页长度的英文学术论文(相关内容不在正式测试中出现),然后从其中排除阅读速度过快(例如小于6 min)和过慢(例如大于30 min)的用户.这样做的原因是降低大学生被试用户在阅读经验和阅读能力方面的差异性,从而减少个体差异性对实验结果的影响;此外,还向被试用户介绍各种可视化批注的含义与用途,使其对可视化批注有基本的了解,并获取他们对可视化批注的初步反馈.结果显示:91%的被试用户反馈表示柱状图和圆环图的用处不大,且需要对照各具体AOI(如文章段落)才能理解其含义,使用不方便.针对其他几种可视化批注,都有超过50%的用户反馈表示这些批注形式可以帮助阅读,且易于理解.因此,在正式测试中将柱状图和圆环图删去,不再进行测试.

3.3.2 正式测试阶段

教师被试用户在没有时间限制的情况下首先阅读这篇论文,然后独自写一个论文总结,并回答一份问卷调查,以评估他们的阅读理解水平.同时,记录他们在阅读过程中的眼动数据,并将这些眼动数据转化成可视化批注信息.选择组间测试方法来研究这些批注对学生阅读理解的影响.学生被试用户被随机分成实验组和控制组,然后交换个别学生,以平衡两组成员的年龄和性别.所有学生被试者所阅读的论文与教师被试阅读的相同.测试也没有时间限

制,每个学生按个人的正常速度进行阅读.控制组内的学生阅读的论文没有任何批注,而实验组内的学生阅读的论文会叠加教师眼动数据的可视化批注.学生被试阅读结束后,采用客观和主观两种方法来评价他们的阅读理解水平.首先,学生被试需要回答5个关于这篇论文的阅读理解问题(客观评价);此外,还要针对这篇文章写一段总结,该总结将被教师用于评价阅读理解质量(主观评价).

3.4 测试结果

进行阅读理解水平的客观评价,要求大学生被试用户回答5个关于论文内容方面(多选)的理解问题,其答案包含在论文相关章节.例如,其中一道题是“这篇论文的主要贡献是什么”,这题的答案可以在论文引言部分找到.每题回答正确记1分,全部题目答对可得5分.对实验组和控制组的得分差异性进行分析,设定零假设为“实验组和控制组的平均分数相同”.结果显示,控制组平均得分为2.9分,标准差1.4分;实验组平均得分为3.8分,标准差为0.9分,采用曼-惠特尼U检验,得到U=62.1,p<0.05,因此拒绝零假设,说明实验组和控制组的平均得分存在显著差异,且实验组得分较高.

进行阅读理解水平的主观评价,要求教师用户分别独立地对学生写的总结质量进行评价,以5分制进行评分(1分表示最差,5分表示最好).4位老师对学生总结的评价基本保持一致,计算他们给出的平均分.对实验组和控制组的总结评价得分进行假设检验,设定零假设为“实验组和控制组的平均分数相同”.结果显示,控制组平均得分为2.3分,标准差为1.2分;实验组平均得分3.6分,标准差为1.1分,通过曼-惠特尼U检验,U=57.0,p<0.05,因此,拒绝零假设,说明实验组和控制组的平均得分存在显著差异,且实验组得分较高.上述检验结果说明:老师的眼动数据可视化注释帮助学生提高了他们的阅读理解能力.

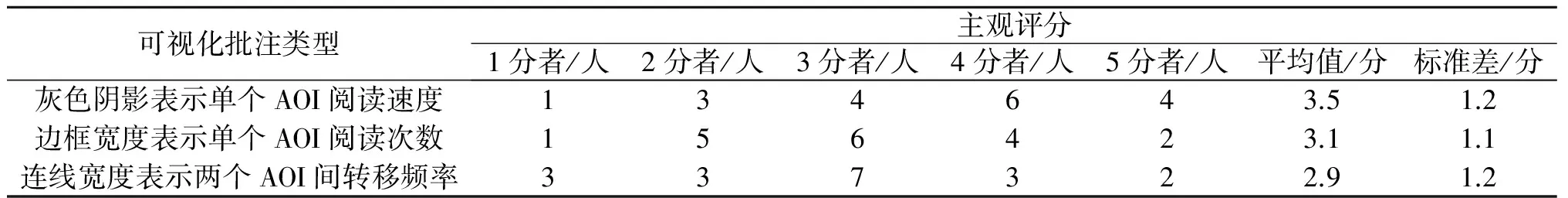

此外,还通过调查问卷分析了学生被试用户的主观反馈.实验组的被试者(18个被试者)对每种类型的可视化批注进行评分(5分制:1分=完全没有帮助;2分=没帮助;3分=不确定是否有帮助;4分=有帮助;5分=非常有帮助),结果如表1所示.

表1 被试学生用户对不同可视化批注的主观评分Table 1 The subjective evaluation from student participants for different annotations

进一步对实验组被试用户进行了访谈.针对表示阅读速的灰色阴影批注,其中一些被试学生用户说“阅读速读可视化批注在视觉上最直观”“灰色阴影区分了不同段落的重要性”“教师的阅读速度对于某个段落是否重要是一个很好的指标,快速阅读的部分代表教师很重视,较慢阅读的部分表示比较重要”.针对利用眼动数据批注撰写总结,一些被试学生用户说“眼动数据批注展示了这篇论文的重点”“如果我和老师都认为某一段是重要的,那么我就会将它写进我的论文总结中”.

3.5 结果讨论

这里讨论笔者方法的一些不足和改进方法.有一位被试学生说“人们重复阅读一段文字,到底是因为它重要呢,还是只是因为这段文字表达不清楚而难以理解?而且有些人也可以快速地阅读一个段落,并不是因为这个段落不重要而是因为读者本身对这段内容很熟悉”.为了处理这种模糊性,将进一步和文档本身的语义分析相结合,从而可以确定哪些段落是难于理解的,例如,有很多专业术语和公式;或者是重要的,例如,包含较多与文档主题相关的关键词.

教师和学生之间阅读行为的差异也可能会降低笔者方法的有效性.正如一位被试学生所言,“教师具有一些专业背景知识,因此他们会跳过一些段落,所以导致学生有时会漏掉一些重要段落”.所以在今后的研究中,会继续探讨学生与学生之间的眼动数据可视化批注的共享,因为学生之间的个体差异通常要相对较小.

当教师通过学生撰写的总结来评价学生的阅读理解水平时,他们是根据自己的经验和标准来判断的,因此会有一些主观判断成分.例如,如果一个学生抓住了文章的重点,但是这个重点并未被教师所重视,那么这个学生的阅读能力所得评分就会较低.下一步,将对阅读理解水平的评价指标进行改进.此外,在实验中,4位教师的的阅读风格比较类似,所以先融合了4位教师的眼动数据可视化批注,然后再展示给学生.所以在后续工作中,将研究如何将多个不同阅读风格的教师眼动数据可视化批注融合在一起,或者将风格差异较大的可视化批注展同时展现给学生,并让学生进行自由选择.

4 结 论

记录用户阅读过程中的眼动数据,并根据相关阅读特征将它们可视化.将教师阅读文章的眼动数据可视化批注分享给阅读这篇文章的学生,结果发现,眼动数据可视化批注有助于提高学生的阅读理解能力,为今后进一步开展阅读教学方法改革提供了一条有益的途径.

本文得到浙江工业大学教学改革项目(JG201620)和浙江工业大学研究生教学改革项目(2016114)的资助.

[1] CHIRCOP L, RADHAKRISHNAN J, SELENER L, et al. Markitup: crowdsourced collaborative reading[C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2013:2567-2572.

[2] TASHMAN C, EDWARDS W. Active reading and its discontents: the situations, problems and ideas of readers[C]// Proceedings of the SIGCHI Conference on Human Factors in Computing Systems. New York: ACM Press,2011:2927-2936.

[3] 汤洪涛,苏丹丹,兰秀菊,等.基于眼动的多目标视觉搜索绩效研究[J].浙江工业大学学报,2017,45(1):108-113.

[4] RAYNER K. Eye movements in reading and information processing[J]. Psychological bulletin,1978,85:618-660.

[5] 范琳,刘振前.阅读理解过程的眼动研究[J].外语与外语教学,2007,217(4):35-40.

[6] DUSSIAS P E. Uses of eye-tracking data in second language sentence processing research [J]. Annual review of applied linguistics,2010,30:149-166.

[7] BIEDERT R, BUSCHER G, SCHWARZ S, et al. Text2.0[C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2010:4003-4008.

[8] KUNZE K, IWAMURA M, KISE K, et al. Activity recognition for the mind: toward a cognitive “quantified self”[J]. Computer,2013,46(10):105-108.

[9] KUNZE K, UTSUMI Y, SHIGAY K, et al. I know what you are reading: recognition of document types using mobile eye tracking [C]//Proceedings of the International Symposium on Wearable Computers. New York: ACM Press,2013:113-116.

[10] BUSCHER G, DENGEL A, ELST L, et al. Generating and using gaze-based document annotations [C]//Extended Abstracts on Human Factors in Computing Systems. New York: ACM Press,2008:3045-3050.

[11] BIEDERT R, DENGEL A, ELSHAMY M, et al. Towards robust gaze-based objective quality measures for text [C]//Proceedings of the Symposium on Eye Tracking Research and Applications. New York: ACM Press,2012:201-204.

[12] VO T, MENDIS B S U, GEDEON T. Gaze pattern and reading comprehension[C]//International Conference on Neural Information Processing. Berlin: Springer-Verlag,2010:124-131.

[13] LENZNER T, KACZMIREK L, GALESIC M. Seeing through the eyes of the respondent: an eye-tracking study on survey question comprehension [J]. International journal of public opinion research,2011,23(3):361-373.

[14] CONNOR C E, EGETH H E, YANTIS S. Visual attention: bottom-up versus top-down [J]. Current biology,2004,14(19):850-852.

Eyemovementdatavisualizationbasedannotationforreadingteaching

CHENG Shiwei, SUN Yujie

(College of Computer Science and Technology, Zhejiang University of Technology, Hangzhou 310023, China)

In the process of reading articles, students often can not grasp the focus, understand the full text structure and paragraph relationship, it results a lower level of reading comprehension. In order to improve students’ reading comprehension, research in this paper focus on eye gaze movement behavior during reading process was conducted, and features related to reading were extracted with eye movement data, such as gaze fixations and saccades. Then the eye movement data was visualized as reading annotations. These annotations mainly included three kinds of visualizations: gray shading to indicate reading speed, borders to indicate frequency of re-reading, and lines to indicate transitions between sections of a document. Through a user study in reading class, we recorded teachers’ eye movement data and generated visual annotations, and then shared the annotations to their students. Finally, the evaluation results showed that, the average scores on reading comprehension quiz and summary from students in experimental group is higher than the students in control group with 31% and 57% respectively, and it validated that the annotations could improve students’ reading comprehension.

eye tracking; fixation; reading; social computing; human-computer interaction

2017-02-14

国家重点研发计划项目(2016YFB1001403);国家自然科学基金资助项目(61272308);浙江省自然科学基金资助项目(LY15F020030)

程时伟(1981—),男,湖北黄石人,副教授,工学博士,研究方向为人机交互技术,E-mail:swc@zjut.edu.cn.

TP391

A

1006-4303(2017)06-0610-05

(责任编辑:陈石平)