基于深度卷积神经网络的水稻穗瘟病检测方法

黄双萍,孙 超,齐 龙,马 旭,汪文娟

基于深度卷积神经网络的水稻穗瘟病检测方法

黄双萍1,孙 超2,齐 龙2※,马 旭2,汪文娟3

(1. 华南理工大学电子与信息学院,广州510641;2. 华南农业大学工程学院,广州 510642; 3. 广东省农业科学院植物保护研究所,广州 510640)

穗瘟是一种严重影响水稻产量及品质的多发病害,有效地检测穗瘟是水稻病害防治的重要任务。该文提出基于深度卷积神经网络GoogLeNet模型的水稻穗瘟病检测方法,该方法利用Inception基本模块重复堆叠构建主体网络。Inception模块利用多尺度卷积核提取不同尺度穗瘟病斑分布式特征并进行级联融合。GoogLeNet利用其结构深度和宽度,学习复杂噪声高光谱图像的隐高维特征表达,并在统一框架中训练Softmax分类器,实现穗瘟病害预测建模。为验证该研究所提方法的有效性,以1 467株田间采集的穗株为试验对象,采用便携式户外高光谱成像仪GaiaField-F-V10在自然光照条件下拍摄穗株高光谱图像,并由植保专家根据穗瘟病害描述确定其穗瘟标签。所有高光谱图像-标签数据对构成GoogLeNet模型训练和验证的原始数据集。该文采用随机梯度下降算法(SGD, stochastic gradient descent)优化GoogLeNet模型,提出随机扔弃1个波段图像和随机平移平均谱图像亮度的2种数据增强策略,增加训练数据规模,防止模型过拟合并改善其泛化性能。经测试,验证集上穗瘟病害预测最高准确率为92.0%。试验结果表明,利用GoogLeNet建立的深度卷积模型,可以很好地实现水稻穗瘟病害的精准检测,克服室外自然光条件下利用光谱图像进行病害预测面临的困难,将该类研究往实际生产应用推进一大步。

病害;模型;图像处理;高光谱成像;穗瘟病检测;深度卷积神经网络;GoogLeNet

0 引 言

稻瘟病是中国南北稻作区危害最严重的病害之一,其年平均发生面积达380×104hm2,稻谷年损失数亿公斤。如果遭遇病害流行年份,一般减产10%~20%,严重时达40%~50%,甚至绝收[1]。穗瘟发生在穗颈、穗轴、枝梗或穗粒上,病害直接影响水稻产量和质量,因而加强对穗瘟病防治是水稻安全生产的重要环节。准确地检测穗瘟病害,对评估水稻品种的穗瘟抗性,以及生产过程中水肥或农药等农资资源的合理精量施用管理等具有指导性作用。

目前,穗瘟病害检测主要由人工完成,因穗瘟病判定有严格技术规范,普通人很难进行可靠病害判定。由植保专家和农技人员分析评判, 则需要花费大量时间和精力。现代农业生产对穗瘟病害预测预报的准确率要求越来越高,这对水稻病害诊断技术提出了新的要求[2-6]。

穗瘟病害由真菌病原侵入引发,导致穗株发生一系列形态、生理和生化方面的变化。这些变化因处于不同病害侵入阶段而呈现非视觉可见的隐性症状,或视觉可见显性症状,甚至导致外部形态发生明显变化。高光谱成像基于水稻穗瘟病害胁迫下表现出的光谱特性差异,利用扫描式成像传感器获取水稻三维光谱图像,既包含连续光谱信息,又提供植物病害空间分布信息;既能获得病害显症,又能获得病害隐症。因此,高光谱成像成为穗瘟病害定量信息获取的重要手段。

基于光谱成像的植物病害检测研究工作在过去的20多年间从未间断过。基于篇幅考虑,仅对利用光谱成像进行稻瘟病检测的研究工作进行综述。冯雷等[7]应用多光谱成像技术对水稻叶瘟病检测分级方法进行了研究。张浩等[8]研究了水稻穗颈瘟,并利用多光谱图像分割结果估测穗颈瘟发病程度。Qi等[9-10]对水稻单株感病样本和健康样本多光谱图像特征进行分析,建立了叶瘟病分级检测模型;对单株样本接种病菌后的各波段图像灰度随时间的变化规律进行分析,建立了单株样本早期检测模型,实现对稻瘟病害分级和早期识别,在实验室条件下取得良好精度。这些研究工作基于多光谱成像,获取3~5个波段的离散图谱信息,且局限于实验室固定光照条件下病害信息获取和分析。许多科研工作者直接利用高光谱图像进行稻瘟病害分析的研究工作[11-16]。杨燕[11]用近红外高光谱图像检测水稻苗瘟。Kobayashi等[12]用机载高光谱系统拍摄大面积田间稻穗,评价穗瘟分布及严重程度。郑志雄等[13]利用HyperSIS高光谱成像系统采集不同病害等级的水稻叶片高光谱图像,通过分析叶瘟病斑区域与正常叶片区域的光谱特征,对差异较大的550和680 nm波段进行二维散点图分析,提取只含病斑的高光谱图像;在此图像上提取延伸率和受害率2个参数,据此对水稻叶瘟病害进行分级。黄双萍等[14-15]提出光谱词袋(bag of spectrum words, BoSW)模型分析稻穗高光谱图像,这种基于词典学习的特征建模方法,引入数据驱动的学习机制,使得基于光箱操作采集高光谱图像的穗瘟检测方法取得良好效果。然而,这些研究工作仍局限于数十或百数量级的样本规模,并局限于固定光源光箱操作获取高光谱图像的应用场景,与实际生产仍有一定距离。

自20世纪90年代,Lecun等在论文中确定卷积神经网络(CNNs, convolutional neural networks)基本架构[17]后,CNNs就成为最流行的深度学习算法。最近,CNNs在图像识别,语音识别和自然语言处理等模式识别领域取得显著成果[18-28]。CNNs能够直接从原始数据中,通过深度网络参数不断学习优化,提取数据隐含语义概念的分布式特征。Krizhevsky等[18]提出AlexNet深度卷积神经网络经典结构,克服CNNs难以训练的困难,并在图像识别任务上取得重大突破。自AlexNet取得成功后,研究人员先后提出许多著名的CNNs变种网络模型[19-21,29]。其中GoogLeNet[21]是一个22层的深度网络,相比只有8层的AlexNet却少了12倍模型参数,其核心思想是增加大量Inception模块,找出最优局部稀疏结构并稠密化。同时,在需要大量计算核卷积运算前灵活运用1×1卷积进行合理降维,并调整不同层的线性程度。

本文提出用深度卷积神经网络GoogLeNet进行穗瘟特征学习,建立穗瘟病害检测模型,并验证模型有效性,以期解决因便携高光谱成像带来更为复杂的数据噪声引致的建模困难问题。

1 试验材料及样本采集

1.1 试验材料

广东省广州市从化吕田镇莲麻村地处23°53′N, 113°59′E位置,海拔高度350~400 m,年均降水量1 800~2 200 mm,年平均温度19.5~21.4 ℃。该地湿度较大,雨量充沛,气候温暖,成为稻瘟病自然诱发的天然病区。广东省农业科学院在面积约为3 133 m2的试验田种植了71个水稻品种。水稻种植采取灌溉圃移栽法,每份水稻插植30丛(每份水稻6行,每行水稻分属5科),2次重复。每列各品种每行两边插植1~2棵诱发品种,诱发品种为感病品种CO39。病圃材料进入黄熟初期后进行穗瘟样本采集。这种自然环境下大田样本采集的试验研究方式,有利于研究本文方法在大田环境下的有效性。2015年11月13日,从吕田试验田采集1 467株稻穗样本,这些样本覆盖全部71个水稻品种。在进行简单泥水清理后即进行连续3日的光谱图像采集。采集过程白天在自然光环境下完成,晚上在白炽灯照明条件下完成。在3 d持续拍摄和穗瘟定标过程中,先后出现部分穗株发霉,水分损失的现象。为了模拟真实生产场景的差异性和复杂性,只扔弃了发霉严重的穗株,对不同干湿程度和略有发霉的样本继续进行样本采集和标定,这种无过多约束的光谱图像采集过程等同于在数据中混入了因含水量或霉变引发样本外观及生化变化而带来的复杂噪声,引起数据较为严重的降质。因此,后续病害建模将面临更大挑战,但也是实际生产应用必须面对的困难。本文希望通过这种更加接近实际应用场景的研究方式寻找更为鲁棒的穗瘟检测方法,以期向实际生产应用跨进一步。

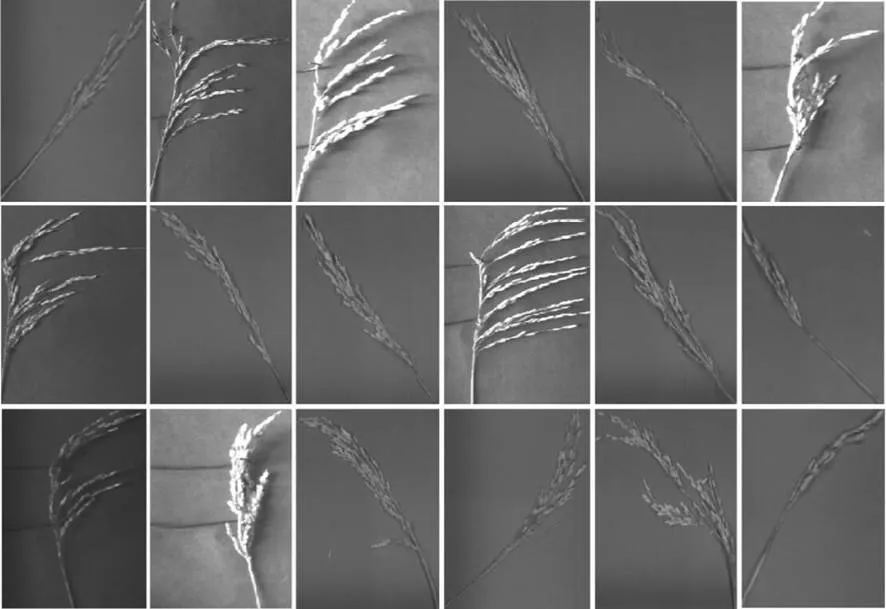

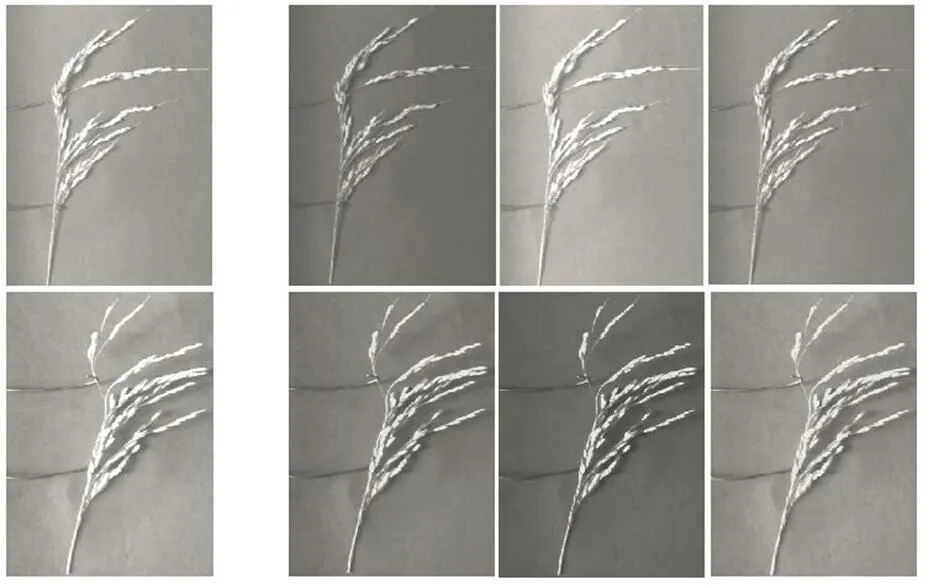

由于样本采摘的随意性、品种的多样性,采集的1 467个穗株样本外观尺寸差异较大。图像尺寸宽度为600~900像素,高度为700~1 000像素。图1列出了部分穗株样本的高光谱平均谱图像,该图像是沿着三维光谱图像的波段轴对空间像素点求算术平均获得。从图中可以看出,稻穗样本的颗粒密度、侧枝及主轴形态、相对分布位置等均呈现较大差异。这些外观差异导致样本在高光谱图像空间维度内的多样性。从图1可看出,在变化的自然光照条件下高光谱图像样本呈现明显差异性。这些因素均会给高光谱图像穗瘟病害建模带来困难。

图1 平均高光谱图像外观及亮度多样性示例

1.2 光谱图像测定

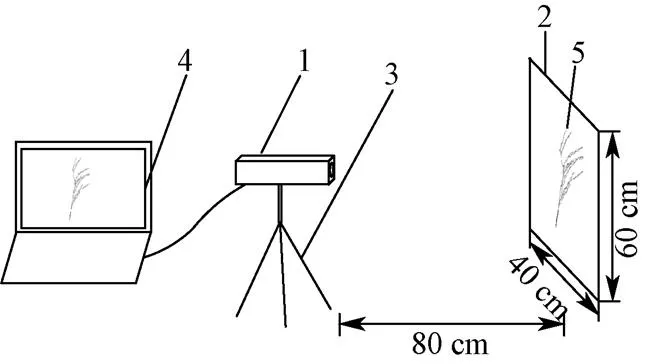

穗株高光谱图像测定采用四川双利合谱科技有限公司的GaiaField-F-V10便携式户外高光谱成像系统,其核心器件采自芬兰Specim透射式光栅成像光谱仪,覆盖从可见光到近红外光的波段区域(400~1 000 nm),光谱分辨率为4 nm,光谱波段数达260个。试验搭建的测试平台如图2所示。从图2中看出,该测试平台包括三脚架支撑的高光谱相机,安装光谱分析软件的笔记本电脑和反射白板上挂着的穗株,测试过程在自然光源条件下完成。测试过程用自动调焦实现对物距的测量,自动调焦模组15 s内自动完成对焦,只需一键单击即可全自动完成测试过程。从测试过程看,样本测试光照条件不可控,太阳光照因时段和天气均可发生变化;白天太阳光源和晚上白炽灯光环境也引起拍摄条件的巨大差异。

1.高光谱相机 2.反射板 3.三角架 4.笔记本 5.穗株样本

高光谱图像数据处理在ENVI 5.1(Research System Inc,Boulder,Co.,USA)和Matlab 2016a(The Math Works,Natick,USA)软件平台完成。每棵穗株高光谱图像是260个波段重叠起来的图像,可以看成有3个轴的立方体数据,包括表示图像像素位置的、轴以及谱方向轴。不同病害程度的稻穗样本平均光谱有差异,需要合适的数据分析方法进行区分。本文试验总共采集1 467个样本,分成染病和无染病2个病级,其中染病样本1 220个,无染病样本247个。

1.3 穗瘟病害定义和描述

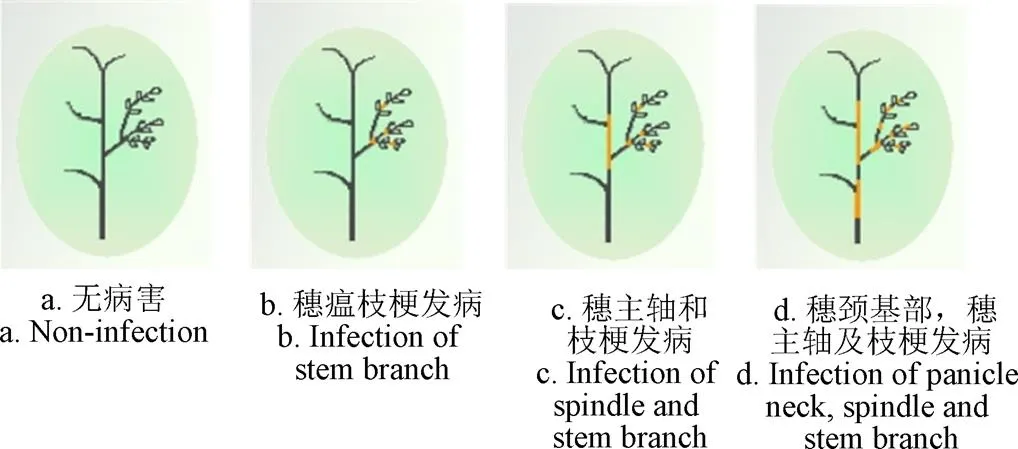

穗瘟病害标定以国际水稻所关于水稻穗瘟抗性定级标准[30]为基础,凡是有发病症状、无论枝梗,穗主轴、穗颈基部等位置有病斑,或者水稻颗粒有感染,都标定为病害样本。病斑位置和感染颗粒比率的差异性,组合出病害样本的极大多样性。无病害样本因稻穗颗粒丰满程度,枝梗等不同分布也呈现较大多样性。这些多样决定样本空间的复杂性,用固定规则的手工特征将高光谱图像抽象成特征数据会面临较大挑战。为了更加形象地描述病害和非病害样本差异及因此而呈现的多样性,图3给出了1种无病害和3种不同病斑分布的示意图。图中黄色表示病害侵染部位。病害标签由植保专家根据上述描述标定,作为预测目标真实值。

图3 穗瘟标定示意图

2 试验方法

2.1 数据预处理

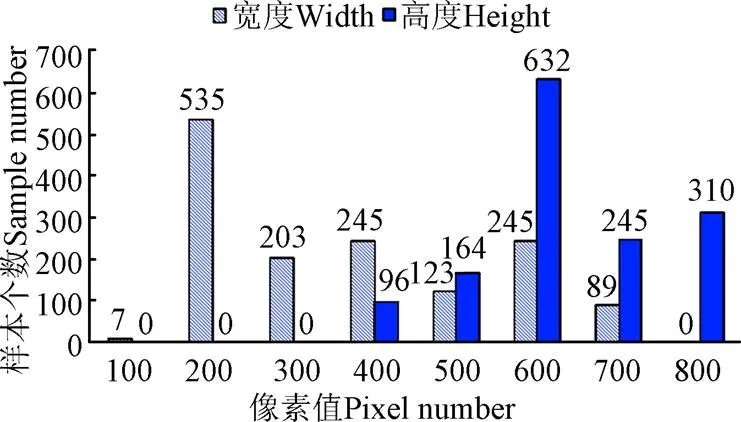

试验中以光谱维度方向计算高光谱图像的平均谱图像,作为深度卷积神经网络的建模输入。考虑到原始高光谱图像空间分辨率较大,在进行数据建模之前,对原始图像进行简单粗裁切,去除无稻穗的背景部分。切割处理后,光谱图像的空间分辨率降低为宽度400~900像素,高度200~800像素。粗切割后光谱图像空间分辨率直方图见图4。根据直方图,光谱图像宽度主要集中于200像素附近,高度集中于600像素附近,故确定将平均高光谱图像尺寸归一化为200×600像素,以取得分类效果和速度的平衡。

图4 粗切割后平均高光谱图像宽高尺寸直方图

2.2 数据增强

本文试验包括1 467个高光谱图像-穗瘟病害标定数据对,构成论文试验数据集。其中247个未染病样本,其标签为0;1 220个不同程度的穗瘟染病样本,其标签为1。从2类样本中各随机选取100个样本构成测试集,剩余部分构成训练集。因此,训练集包括147个0类样本(亦称“负样本”)和1 120个1类样本(亦称“正样本”)。对于采用GoogLeNet建模的2分类问题,有如下要点需要考虑:第一,GoogLeNet是一个深度卷积神经网络模型,需基于大数据和标定监督机制进行模型训练,充分的训练数据是该方法发挥知识挖掘能力的前提。由于原始穗株高光谱数据采集过程耗时,耗力且高成本,仅仅依靠原始数据采集保证充足的数据量不太现实。本研究现有数据规模相对深度网络尚显不够;第二,两类问题模型训练过程正负样本均衡对无偏模型训练并取得较好预测效果影响明显。本文试验1 120和147的正负训练样本比将近8,容易引发模型训练失偏。本文将在数据增强过程中弥补训练数据不平衡的状况,达到正负样本基本平衡。

针对训练样本数量不够,本文提出了2个数据增强策略:随机扔弃波段图像和随机平移平均高光谱图像亮度。随机扔弃波段的数据增强策略是从高光谱图像260个波段中随机扔弃1个波段信息,再计算平均谱图像。这种数据增强策略提出依据是高光谱成像仪具有超高光谱维度上的分辨率,例如,本研究使用的GaiaField-F-V10光谱仪分辨率最高达2.8 nm。因此,穗株高光谱立方体图像中,包括大量数据冗余。随机扔弃某个单一波段信息,对这种超多维光谱立方体图像而言,导致的信息损失可通过邻近波段携带的相关信息进行一定程度弥补,不会引起数据点“质”的变化。从数据的角度,这种随机扔弃某个单一波段的策略可理解为引进随机数据噪声,这对于本研究采用的数据驱动深度卷积神经网络而言,适度数据噪声和因此带来的数据多样性,会使训练的模型具有更强的泛化能力。在后续试验中,随机扔弃波段图像信息形成样本副本,其穗瘟病害标签不变,与副本数据构成一个独立数据对。

根据随机扔弃单一波段的数据增强操作模式,147个未染病穗瘟样本通过一轮随机扔弃波段操作可增强为294个。1 120个染病穗株样本则可增强为2 240个。考虑到2分类对正负样本平衡性的要求,本文试验对负样本进行15轮随机操作,这样总共得到2 352个负样本;正样本进行1轮随机操作,总共得到2 240个正样本。这样,正负样本基本达到平衡。

本文提出的第2个数据增强策略是随机平移平均光谱图像亮度。便携户外高光谱仪采集穗株高光谱图像在动态变化的自然光条件下进行,因此,平均谱图像呈现明显亮度差异,如图1所示。为增强GoogLeNet模型对光照变化的适应性,随机平移光谱图像亮度增强数据,增加数据在光照亮度维方面的多样性。图5 给出平均光谱图像3次随机平移亮度后的效果示意图。利用这种增强策略,可以增加成倍训练数据量,增加样本多样性,提升模型泛化能力。

a. 原始平均谱图像a. Original average spectrum imageb. 随机亮度平移衍生谱图像b. Derivative spectrum image after random light shifting

本文试验将随机扔弃波段得到的增强训练数据集再做一次随机亮度平移操作,得到本文实际训练数据集,即:负样本4 704,正样本4 480,总样本9 184。

图6给出了GoogLeNet模型训练所用的增强数据集形成流程图。图中实线框及实线箭头表示数据处理相关操作及信息流向,虚线框及虚线箭头表示深度模型相关信息及数据处理流向。

2.3 GoogLeNet网络结构及优化训练

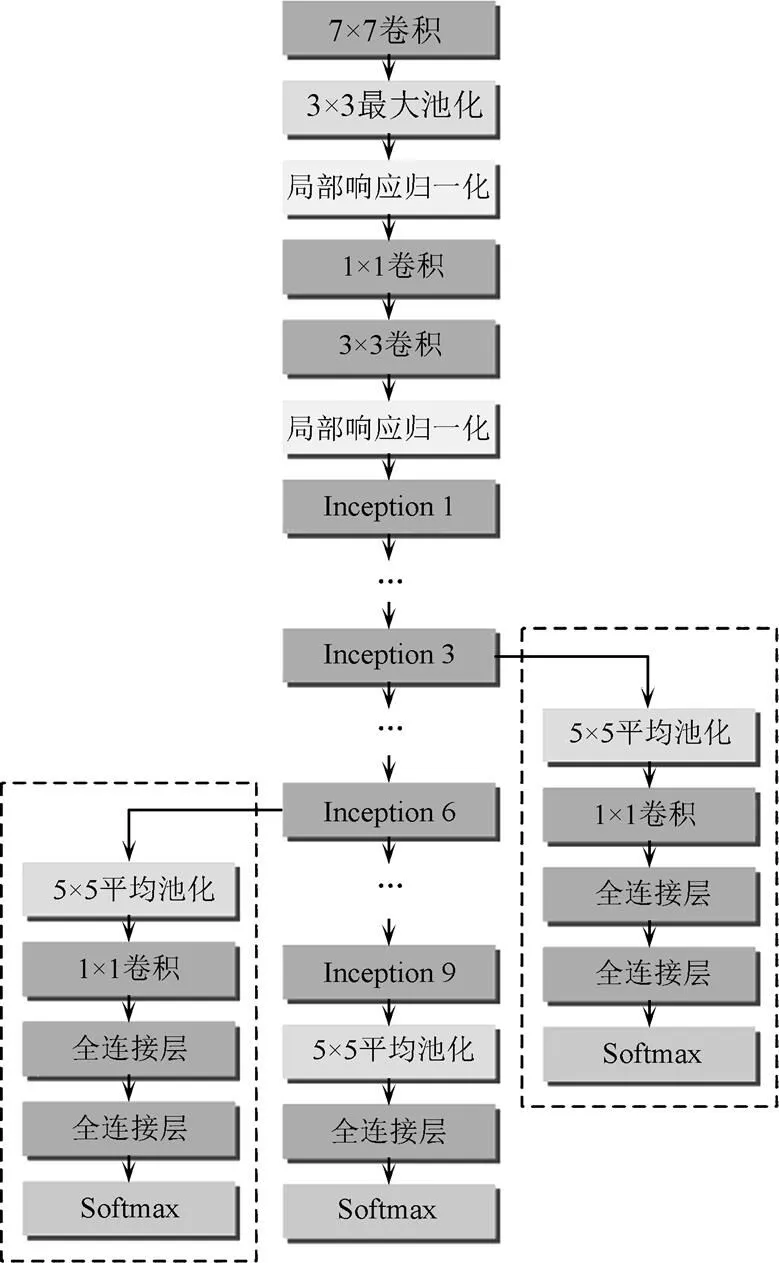

GoogLeNet在经典卷积神经网络LeNet-5[17]的基础上,增加网络宽度和深度,克服因深度和宽度增加带来的参数量爆炸和优化计算量剧增问题,提高深度网络模型质量。GoogLeNet通过设计Inception模块,引入多尺度卷积提取多尺度局部特征。本文所使用的Inception模块结构如图7。Inception模块在整个深度网络结构中多次重复堆叠出22层深度的网络结构。Inception结构模块中所有参数都经过优化训练得到。

图6 用于GoogLeNet优化的增强数据集形成过程

图7 Inception模块结构示意图

从图7中看出,Inception模块设计1×1、3×3和5×5卷积核分支,对穗瘟在不同部位的不同尺度病斑结构进行特征提取和学习。由此可知Inception模块的多尺度设计非常适合这种穗瘟病害在稻穗图像空间上的分散式、多形态、多尺度分布特点。图7中显示 Inception模块3×3,5×5卷积和3×3最大池化分支中均额外设计1个1×1卷积核,构成级联关系。这种1×1卷积核一方面用来增加网络深度,改善网络非线性程度;另一方面用以减少大卷积核(例如3×3,5×5)卷积对象的维度,降低运算量。这是本文GoogLeNet网络模型在深度和宽度上得以拓展,但参数总量比经典VGG网络成倍少的重要原因。Inception模块接受前一层输入,通过不同尺度和功能分支的并行处理后级联形成该Inception模块输出,实现多尺度特征融合。

GoogLeNet主体部分由多个Inception模块堆叠而成,随着层次越靠近输出预测,其学习得到的特征抽象程度越高,与标定语义间关联性越发突出。GoogLeNet总体网络结构如图8所示。从图8中看出,在靠近平均光谱图像输入层,采用传统卷积神经网络基本模块,即卷积和池化层。考虑到GoogLeNet网络层次比较深,该网络增加局部归一化层,规避因网络深度导致的配准漂移。考虑到中间层次的特征已经具备一定程度的鉴别能力,同时考虑到因网络层次过深易导致随机梯度下降算法优化过程中的梯度消失问题,GoogLeNet在主干网络的旁侧增加2条额外的全连接Softmax分类器(图8中虚线框所示)。模型优化过程中,用主干与分支分类器损失函数梯度之和更新网络模型参数。测试过程中,则去掉相应分支分类器,只用主干分类器进行穗瘟病害预测。

图8 GoogLeNet网络结构图

3 结果与分析

由前述章节知,参与GoogLeNet模型训练的数据集包括4 480个穗瘟病害样本,4 704个无穗瘟病害样本。其中包括2种数据增强策略获得的衍生样本。测试数据集包括穗瘟病害正负样本各100个,用以评估模型穗瘟病害预测性能,验证方法的有效性。

试验选定“分类准确率”作为评价指标。训练GoogLeNet模型时,采用随机梯度下降(SGD, stochastic gradient descent)算法进行优化。根据测试精度最优原则,设定动量参数momentum为0.9,初始学习率为 (1e-5),学习率采取步进阶梯调节策略step,即每隔3 000个训练迭代调整一次学习率,学习率调整因子为0.96。梯度下降每次迭代更新样本批包含样本数量设为32,epoch数设为14。试验分析了模型优化过程中随着迭代次数增加,测试准确率和损失函数的变化趋势,同时比较了本文方法和词袋模型方法的穗瘟识别精度[14-15]。

3.1 SGD优化过程GoogLeNet模型性能变化趋势

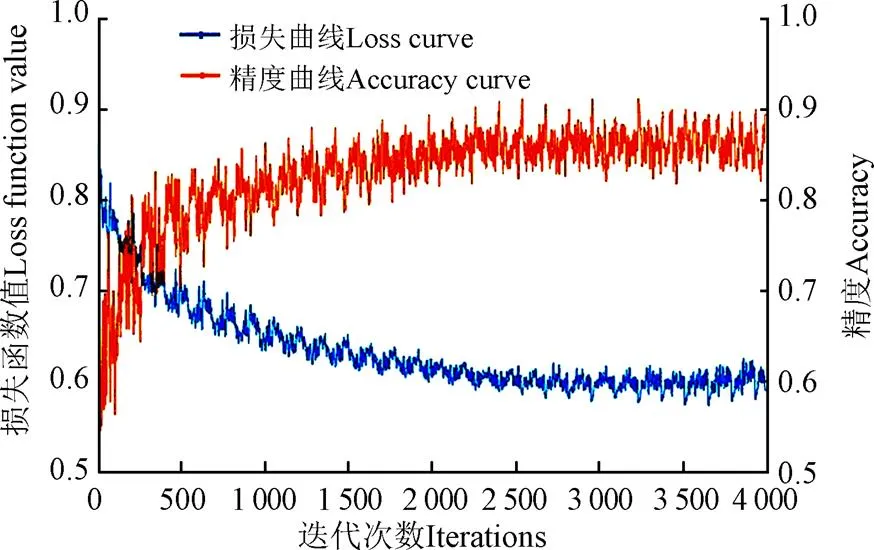

采用SGD算法优化GoogLeNet模型,对迭代过程中损失函数值的变化进行趋势分析,对中间模型在测试数据集上进行穗瘟预测精度测试,以分析训练过程模型性能的变化。图9中蓝色和橙色曲线分别表示迭代次数-损失函数值(Iterations-Loss)和迭代次数-测试准确率(Iterations-Accuracy)曲线。

图9 损失函数值及精度随迭代次数的变化

从图9中看出,训练过程中训练损失函数呈下降趋势,反应模型在优化过程中通过小批次样本损失函数梯度的更新,其预测损失偏差逐步变小。同时,随着迭代次数增加,模型在测试集上的预测准确率呈整体上升趋势。训练损失函数下降与测试集上预测精度的上升,反应模型在不断迭代更新参数过程中性能得以优化。通过数据增强技术增加大量伪样本,数据规模增加,数据多样性突出等减少了深度GoogLeNet模型的过拟合,训练出的模型具有较好泛化性能,因此对原始测试数据有很好的预测性能。当迭代次数达到4000时,其测试集上的最高准确率达到92.0%,根据Loss变化和测试精度变化趋势,基本达到收敛状态。

3.2 模型验证

为验证论文方法的有效性,进行GoogLeNet模型与词袋模型方法的精度比较分析。词袋模型的主要思想见参考文献[9-10],本试验中的参数设置与文献[9]相同,即词典大小为450,微结构方格大小为16×16,金字塔层选择1,SVM分类器采用卡方核函数等。词袋模型参数基于最佳测试结果原则设定。将2种方法的试验比较结果列于表1中。

为验证论文方法的有效性,在本文采集的1 467对高光谱图像-标签数据集上进行GoogLeNet模型与词袋模型的穗瘟预测精度比较。词袋模型的主要思想见参考文献[14-15],试验设置与文献[15]相同,即词典大小为450,微结构方格大小为16×16,金字塔层选择1,SVM分类器采用卡方核函数等。试验结果表明,GoogLeNet模型精度为92.0%,BoSW模型精度为78.3%。本论文提出的方法取得比BoSW高将近14个百分点的穗瘟预测准确率。

词袋模型通过均匀划分穗株空间位置上的病斑微结构高光谱曲线,利用-means聚类算法学习得到表征典型微结构的光谱词集合,计算二维图像空间中典型词的直方图分布,来表达穗株高光谱图像。词袋方法中嵌入基于数据的学习思路获得词典,但高光谱图像的最终特征表达采用无学习机制的简单直方图统计。这种方法在室内光环境条件下的高光谱成像穗瘟检测精度达96.4%[15],但在室外任意动态自然光环境下高光谱图像穗瘟检测精度仅为78.3%,表明室外便携式高光谱成像数据噪声更强,多样性更突出,带来穗瘟检测困难。本论文提出深度卷积GoogLeNet网络模型,并基于平均高光谱图像进行模型参数学习。平均谱图像由沿着波段轴计算三维高光谱图像的算术平均得到。该过程一定程度上降低了数据信噪比,且削弱了图像可用性。但是,若不采用平滑处理,具有密集波段的光谱图像中将含有大量冗余信息,带来数据表达的降质。同时,三维高光谱数据量过大,不利于后续建模分析。本论文采用波段方向平均的高光谱图像数据简约处理,考虑了穗瘟病斑在植株上分散分布的特点,保留了像素空间分布。为弥补波段方向平滑操作导致的数据信噪比降低,本论文进一步采用建模能力强的深度卷积学习方法,强化后端模型学习能力并提升对噪声的处理能力。试验结果表明,数据驱动的CNN模型结合数据增强策略获得足量样本的方法更好地克服了户外拍摄高光谱图像进行穗瘟检测面临的挑战,取得较好的穗瘟预测精准度。

4 结 论

1)本研究利用GoogLeNet模型进行穗瘟病害检测。该方法着重解决一种更加贴近实际应用场景的穗瘟病害检测问题,即:室外任意光照条件下便携拍摄穗株高光谱图像、样本规模达千级、样本因数据采集条件和水稻品种多样等因素呈现突出多样性。试验结果表明,本文方法取得高达92.0%的穗瘟病害检测精度,相比最新词袋模型穗瘟检测方法提高14个百分点。

2)本研究提出随机扔弃1个波段图像和随机平移平均谱图像亮度的高光谱数据增强技术。前者充分利用高光谱图像连续波段间的信息冗余;后者则契合户外高光谱采集数据的光环境动态特点,增强模型对光照条件的自适应性。2种数据增强策略共同解决高光谱标注图像采集昂贵、费时而带来的样本规模不够的问题。

本文虽然开创性地将通用视觉领域的深度卷积神经网络用于穗瘟病害检测并结合领域知识提出数据增强策略,取得较好结果,但有如下问题需要在后续研究中解决:第一,考虑到高光谱图像的三维立体结构,应考虑用三维卷积和池化操作代替GoogLeNet中二维图像卷积和池化操作,在波段维逐层提取高层抽象特征,充分利用波段细节信息进行穗瘟病害检测;第二,考虑到穗瘟抗性鉴定的需要,应将此方法扩展应用于更加精细的定级分析当中。

[1] 吴降星. 水稻病虫识别与防治图谱[M]. 杭州:浙江科学技术出版社,2006:1-104.

[2] 吴迪,曹芳,张浩,等. 基于可见-近红外光谱技术的水稻穗颈瘟染病程度分级方法研究[J]. 光谱学与光谱分析,2009,29(12):3295-3299.

Wu Di, Cao Fang, Zhang Hao, et al. Study on disease level classification of rice panicle blast based on visible and near infrared spectroscopy [J]. Spectroscopy and Spectral Analysis, 2009, 29(12): 3295-3299. (in Chinese with English abstract)

[3] 刘立波. 基于图像的水稻叶部病害诊断技术研究[D]. 北京:中国农业科学院,2010.

Liu Libo. Research of Diagnostic Technologies for Rice Leaf Diseases Based on Image[D]. Beijing: Chinese Academy of Agricultural Sciences, 2010. (in Chinese with English abstract)

[4] 刘立波,周国民. 基于多层感知神经网络的水稻叶瘟病识别方法[J]. 农业工程学报,2009,25(13):213-217.

Liu Libo, Zhou Guomin. Identification method of rice leaf blast using multilayer perception neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2009, 25(13): 213-217. (in Chinese with English abstract)

[5] 邱靖,吴瑞武,黄雁鸿,等. 混沌理论与BP网络融合的稻瘟病预测模型[J]. 农业工程学报,2010,26(14):88-93.

Qiu Jing, Wu Ruiwu, Huang Yanhong, et al. Forecasting model on rice blast based on BP neural network and chaos theory[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2010, 26(14): 88-93. (in Chinese with English abstract)

[6] 谭峰,才巧玲,孙雪成,等. 基于拉曼光谱分析寒地水稻叶瘟病害植株特征[J]. 农业工程学报,2015,31(4):191-196.

Tan Feng, Cai Qiaoling, Sun Xuecheng, et al. Analyzing plant characteristics of rice suffering leaf blast in cold area based on Raman spectrum[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(4): 191-196. (in Chinese with English abstract)

[7] 冯雷,柴荣耀,孙光明,等. 基于多光谱成像技术的水稻叶瘟检测分级方法研究[J]. 光谱学与光谱分析,2009,29(10):2730-2733.

Feng Lei, Chai Rongyao, Sun Guangming, et al. Identification and classification of rice leaf blast based on multi spectral imaging sensor[J]. Spectroscopy and Spectral Analysis, 2009, 29(10): 2730-2733. (in Chinese with English abstract)

[8] 张浩,姚旭国,毛雪琴,等. 基于多光谱图像的水稻穗颈瘟严重度识别研究[J]. 湖南农业科学,2009(1):65-68. Zhang Hao, Yao Xuguo, Mao Xueqin, et al. Measurement of Rice Neck Blasts Severity by Using Multi-spectral Imagine[J]. Hunan Agricultural Sciences, 2009(1): 65-68. (in Chinese with English abstract)

[9] Qi Long, Ma Xu. Rice Blast Detection Using multispectral imaging sensor and Support Vector Machine[C]// American Society of Agricultural and Biological Engineers Annual International Meeting, 2009: 1489-1496.

[10] 齐龙,马旭,梁柏,等. 稻瘟病监测预测方法研究现状及流行风险评估体系构建初探[J]. 中国农学通报,2011,27(33):213-216.

Qi Long, Ma Xu, Liang Bai, et al. Research on present status of rice blast monitoring and prediction methods and preliminary establishment of disease epidemic Risk Assessment System[J]. Chinese Agricultural Science Bulletin, 2011, 27(33): 213-216. (in Chinese with English abstract)

[11] 杨燕. 基于高光谱成像技术的水稻稻瘟病诊断关键技术研究[D]. 杭州:浙江大学,2012.

Yang Yan. The Key Diagnosis Technology of Rice Blast Based on Hyper-spectral Image[D]. Hangzhou: Zhejiang University, 2012. (in Chinese with English abstract)

[12] Kobayashi T, Sasahara M, Kanda E, et al. Assessment of rice panicle blast disease using airborne hyperspectral imagery[J]. The Open Agriculture Journal, 2016, 10: 28-34.

[13] 郑志雄,齐龙,马旭,等. 基于高光谱成像技术的水稻叶瘟病病害程度分级方法[J]. 农业工程学报,2013,29(19):138-144.

Zheng Zhixiong, Qi Long, Ma Xu, et al. Grading method of rice leaf blast using hyperspectral imaging technology[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2013, 29(19): 138-144. (in Chinese with English abstract)

[14] 黄双萍,齐龙,马旭,等. 基于高光谱成像的水稻穗瘟病害程度分级方法[J]. 农业工程学报,2015,31(1):212-219.

Huang Shuangping, Qi Long, Ma Xu, et al. Grading method of rice panicle blast severity based on hyperspectral image[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2015, 31(1): 212-219. (in Chinese with English abstract)

[15] Huang Shuangping, Qi Long, Ma Xu, et al. Hyperspectral image analysis based on BoSW model for rice panicle blast grading[J]. Computers and Electronics in Agriculture, 2015, 118: 167-178.

[16] 袁建清,苏中滨,贾银江,等. 基于高光谱成像的寒地水稻叶瘟病与缺氮识别[J]. 农业工程学报,2016,32(13):155-160.

Yuan Jianqing, Su Zhongbin, Jia Yinjiang, et al. Identification of rice leaf blast and nitrogen deficiency in cold region using hyperspectral imaging[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2016, 32(13): 155-160. (in Chinese with English abstract)

[17] Lecun Y, Bottou L, Bengio Y, et al. Gradient-based learning applied to document recognition[J]. Proceedings of the IEEE, 1998, 86(11): 2278-2324.

[18] Krizhevsky A, Sutskever I, Hinton G E. Imagenet classification with deep convolutional neural networks[C]// Proceedings of the 25th International Conference on Neural Information Processing Systems, 2012: 1097-1105.

[19] Zeiler M D, Fergus R. Visualizing and understanding convolutional networks[C]. European Conference on Computer Vision, 2014.

[20] Simonyan K, Zisserman A. Very deep convolutional networks for large-scale image recognition[C]. International conference on learning representations, 2015.

[21] Szegedy C, Liu W, Jia Y Q, et al. Going deeper with convolutions[C]// IEEE Conference on Computer Vision and Pattern Recognition, 2015.

[22] Kalchbrenner N, Grefenstette E, Blunsom P A convolutional neural network for modeling sentences[C]//Association for Computational Linguistics, 2014, 1: 655-665.

[23] Kim Y. Convolutional neural networks for sentence classification[C]. Conference on Empirical Methods on Natural Language Processing, 2014.

[24] Palaz D, Magimai M, Collobert R. Analysis of CNN-based speech recognition system using raw speech as input[C]// Proceedings of Interspeech, 2015: 11-15.

[25] Qian Y, Bi M, Tan T. Very deep convolutional neural networks for noise robust speech recognition[J]. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2016, 24(12): 2263-2276.

[26] He K, Wang Y, Hopcroft J. A powerful generative model using random weights for the deep image representation[C]. Advances in Neural Information Processing Systems, 2015.

[27] Li D, Huang J, Li Y, et al. Weakly supervised object localization with progressive domain adaptation[C]//IEEE Conference on Computer Vision and Pattern Recognition, 2016: 3512-3520.

[28] Shen W, Liu R. Learning residual images for face attribute manipulation[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2016.

[29] He K, Zhang X, Ren S, et al. Deep residual learning for image recognition[C]. IEEE Conference on Computer Vision and Pattern Recognition, 2015.

[30] International Rice Research Institute (IRRI), Standard Evaluation System for Rice (SES)[Z]. Philippines: Rice Science for a better world, 2002.

Rice panicle blast identification method based on deep convolution neural network

Huang Shuangping1, Sun Chao2, Qi Long2※, Ma Xu2, Wang Wenjuan3

(1.510641,; 2.510642,; 3.510640,)

Rice panicle blast is one of the most serious diseases in the period of rice growth.To effectively identify the rice panicle blast is one of the important prerequisites for rice disease controlling. In this study, a novel identification method for panicle blast based on hyperspectral imaging technology is proposed. The method applies a deep convolutional neural network model GoogLeNet to learn the representation of hyperspectral image data and the binary panicle blast/non-blast classifier is trained as well in a unified framework. The GoogLeNet is 22-layer deep convolutional neural network, which repeatedly stacks basic Inception module to deepen and widen the network to enhance its representation power. The core Inception architecture uses a series of kernel filters of different sizes in order to handle multiple scales macro structure and all of filter parameters are learned. In our GoogLeNet model for the panicle blast identification, the filter sizes are set to 1×1, 3×3 and 5×5 based on the consideration of lesion microstructure size rendered on the rice spike. In order to reduce the expensive computing cost of 3×3 and 5×5 convolutions, an extra 1×1 convolution is used to reduce the map dimension in each branch of Inception module before 3×3 and 5×5 convolutions. Further, all the output filter banks are concatenated into a single output vector forming the input of the next stage. As these Inception modules are stacked on top of each other, features of higher abstraction are captured by higher layers. Finally, an average pooling layer plus a fully connected layer is stacked on the last Inception module and a softmax based classifier is used to predict the panicle blast. From the statement, feature and classifier learning are seamlessly integrated in a unified framework and both of them are trained jointly under the supervision of blast label, which makes the two reach the harmoniously optimal state and helps to improve the blast prediction performance. To verify the acclaim of the proposed GoogLeNet method, a total of 1 467 fresh rice panicles covering more than 71 cultivars are collected from an experimental field for the performance evaluation. The experimental field is located in regional testing area for the evaluation of rice cultivars in Guangdong Province. Therefore, all the rice plants in this area are naturally inoculated as the area is a typical source of rice blast fungus. The hyperspectral images of all the rice panicles are acquired using outdoor portable GaiaField-F-V10 imaging spectrometer. In consideration that the spatial resolution is large, we coarsely crop the background area. Then the average spectrum images are computed, acting as the original input of the deep GoogleNet network. Two-class label of hyperspectral image sample is determined by plant protection expert according to the description of blast infection. In our experiments, totally 200 samples are randomly selected for test, with 100 for infected and non-infected class respectively. The rest are for training. When the training samples are scarce, deep GoogLeNet model is easily trapped in the overfitting, worsening the panicle blast prediction performance. To this end, we proposed 2 data augmentation methods, i.e., the method of randomly abandoning single band and the method of randomly translating luminance of average hyperspectral image. The combination of 2 methods can produce hundreds of thousands of data sample pairs. The rich and diverse samples are used to train the deep convolutional model to reduce the overfitting and improve the prediction results. Experimental results show that the proposed GoogLeNet based method achieves a high classification accuracy of 92.0%. This result is much better than the recent state-of-art BoSW (bag of spectra words) method, demonstrating the proposed GoogLeNet method together with the 2 data augmentation techniques solves the panicle blast identification problem under the situation of outdoor hyperspectral image collection. Moreover, the proposed GoogleNet BoSW based method demonstrates strong robustness to rice cultivars, which is vital for the wide and practical application. This research improves the classification accuracy of rice panicle blast identification and overcomes the difficulty caused by the hyperspectral image collection under the natural light outdoor. This work will advance the research of panicle blast identification to the practical application of production with a big step.

diseases; models; image processing; hyperspectral image; panicle blast identification; deep convolutional neural networks; GoogLeNet

10.11975/j.issn.1002-6819.2017.20.021

S24

A

1002-6819(2017)-20-0169-08

2017-05-02

2017-09-15

广东省科技计划公益研究与能力建设专项(2014A020208112);现代农业产业技术体系建设专项资金资助(CASRS-01-33)资助

黄双萍,女,湖南邵阳人,副教授,博士,主要从事农业智能信息处理和数据挖掘、计算机视觉等方面的研究。Email:eehsp@scut.edu.cn。中国农业工程学会高级会员:黄双萍(E041200596S)。

※通信作者:齐龙,男,黑龙江哈尔滨人,研究员,博士,主要从事现代农业技术与智能装备的研究。Email:qilong@scau.edu.cn

黄双萍,孙 超,齐 龙,马 旭,汪文娟. 基于深度卷积神经网络的水稻穗瘟病检测方法[J]. 农业工程学报,2017,33(20):169-176. doi:10.11975/j.issn.1002-6819.2017.20.021 http://www.tcsae.org

Huang Shuangping, Sun Chao, Qi Long, Ma Xu, Wang Wenjuan. Rice panicle blast identification method based on deep convolution neural network[J]. Transactions of the Chinese Society of Agricultural Engineering (Transactions of the CSAE), 2017, 33(20): 169-176. (in Chinese with English abstract) doi:10.11975/j.issn.1002-6819.2017.20.021 http://www.tcsae.org